Testy ATI Radeon X1900TX i X1900XTX (HIS)

Autor: Kris | Data: 31/01/06

|

Dopiero co udało mi się wypluć z siebie artykuł o nowej generacji ATI, reprezentowanej przez Radeona X1800XT, a tu zamiast zasłużonego odpoczynku trzeba opisać kolejną premierę na rynku kart graficznych. Zgodnie z tym, co sugerowałem, pomimo spóźnienia w dostarczeniu na rynek układu R520, kanadyjski producent pokazał swój kolejny produkt z górnej półki wydajności, zachowując wcześniej ustalony harmonogram prezentacji nowych układów graficznych. Do sprzedaży wchodzą karty reprezentujące serię X1900. Dzięki uprzejmości firmy HIS miałem chwilę czasu na wykonanie podstawowych testów kart Radeon X1900XTX oraz X1900XT, z których wynikami chciałbym się podzielić z czytelnikami. Długość recenzji będzie proporcjonalna do wielkości zmiany numeru w nazwie kart oraz czasu testów, więc może zainteresowani nie zdążą się znudzić prezentowaną "numerologią" framerate. Zapraszam... Dopiero co udało mi się wypluć z siebie artykuł o nowej generacji ATI, reprezentowanej przez Radeona X1800XT, a tu zamiast zasłużonego odpoczynku trzeba opisać kolejną premierę na rynku kart graficznych. Zgodnie z tym, co sugerowałem, pomimo spóźnienia w dostarczeniu na rynek układu R520, kanadyjski producent pokazał swój kolejny produkt z górnej półki wydajności, zachowując wcześniej ustalony harmonogram prezentacji nowych układów graficznych. Do sprzedaży wchodzą karty reprezentujące serię X1900. Dzięki uprzejmości firmy HIS miałem chwilę czasu na wykonanie podstawowych testów kart Radeon X1900XTX oraz X1900XT, z których wynikami chciałbym się podzielić z czytelnikami. Długość recenzji będzie proporcjonalna do wielkości zmiany numeru w nazwie kart oraz czasu testów, więc może zainteresowani nie zdążą się znudzić prezentowaną "numerologią" framerate. Zapraszam...

| |

|

Zmiany

Oficjalny pokaz Radeonów serii X1900 nastąpił 24 stycznia 2006 roku. Rodzina obejmuje karty X1900XTX, X1900XT, X1900 CrossFire oraz All-In-Wonder X1900. Wszystkie karty są niemal natychmiast dostępne w sprzedaży. Przynajmniej w nieco bardziej cywilizowanej części świata. Seria X1900 jest rozwinięciem koncepcji architektury, która narodziła się wraz z X1800, opartym na rdzeniu ATI R520. Zmiany mają tym razem charakter ściśle związany z wydajnością i nie oczekujmy pojawienia się jakiś nowych technologii, czy pojęć z dziedziny przetwarzania 3D. Dla mnie jest to o tyle wygodne, że bez cienia skrupułów mogę zamiast rozpisywania się na temat konstrukcji wewnętrznej, skierować czytelnika do poprzedniego artykułu, w którym zagadnienia techniczne zostały opisane nieco szerzej. Traktując go jako bazę do przedstawienia kolejnego produktu, mogę skoncentrować się na samych zmianach, które odróżniają najmłodsze dziecko ATI od swojego poprzednika.

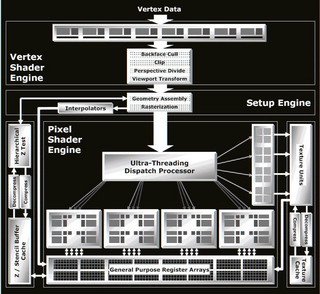

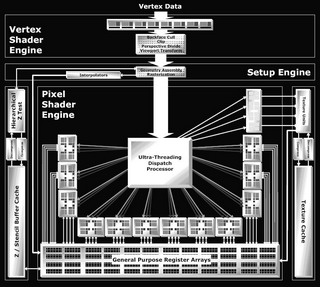

Jedynym konkretnym wyróżnikiem Radeonów X1900 od serii X1800 jest zwiększenie ilości procesorów cieniowana pikseli oraz buforów, które są przez nie wykorzystywane. Pociągnęło to wzrost ilości tranzystorów w rdzeniu z ok. 320 na 380 mln, co oznacza kolejny rekord w tej dyscyplinie. Tu od razu chciałbym zaznaczyć, że nie chodzi o ilość klasycznych potoków, które w moim rozumieniu ich definicji, przestały istnieć już w R520. Wprowadzenie elektronicznego przełącznika (Ultra-Threaded Dispatch Processor) i wyrwanie TMU (Texture Mapping Unit) z potoku pikseli, degraduje to pojęcie w stopniu uniemożliwiającym jakiekolwiek rozważania ilościowe w stosunku do innych GPU. W związku z degeneracją znaczenia tego parametru najsensowniejszym wyjściem jest zaprzestanie wykorzystywania go w celach porównawczych. Radeon X1900 ma trzy razy więcej procesorów cieniowania pikseli, przy zachowaniu tej samej ilości TMU, co jego poprzednik. Schemat blokowy rdzenia nie pozostawia wątpliwości.

Architektura układu R520 i R580 (kliknij, aby powiększyć)

Jest to drugi układ graficzny ATI (po RX1600), który realizuje koncepcję przetwarzania nazwaną umownie 3:1. Chodzi o stosunek ilości tych dwóch modułów. Konsekwencją tego faktu jest przesunięcie kierunku wykorzystania mocy silnika 3D z ilości przetwarzanych jednocześnie pikseli na ilość jednoczesnych operacji arytmetycznych, które ich dotyczą. Innymi słowy, "idziemy" w kierunku mocy przetwarzania kodu programu shadera, kosztem teksturowania. Jest to w zasadzie o tyle istotna sprawa, że w tym momencie zaczynają się rozchodzić drogi możliwości osiągania efektów 3D układów ATI i nVidia. ATI jest przekonana, że taki kierunek zmian jest zgodny z aktualnymi trendami rozwoju silników gier, a shadery będą w najbliższym czasie stanowiły podstawę budowania ich obrazu, stając się największym generatorem obciążenia dla przyszłych kart graficznych. Z drugiej strony następuje wycofywanie się z klasycznej metody zwiększania realizmu generowanej sceny, poprzez zwiększanie trybu graficznego i odpowiadające mu "pompowanie" wielkości tekstur. Ma to zresztą uzasadnienie związane z kwestią ograniczeń rozdzielczości wynikających z globalnego przejścia użytkowników na cyfrowe wyświetlacze obrazu. Nowy Radeon ma 48 procesorów cieniowania pikseli. Dodając do tego fakt implementacji w każdym procesorze dedykowanej jednostki obsługującej rozgałęzienia kodu shadera, mamy do czynienia z zupełnie nową generacją wydajności przetwarzania PS3.0. Zwracam uwagę na to, że chodzi o tą konkretną część obciążenia układu, a nie całość przetwarzania 3D.

Shadery teoretycznie powinny pięknie "dopalić" nam grafikę gier, ale tu dochodzimy do sedna sprawy. Aby to nastąpiło, najpierw programiści muszą nam te efekty w nich zaimplementować. Od pierwszych kart Dx8 następuje stopniowe wprowadzenie, a następnie wydłużanie kodu shadera operującego na pikselach. Jednak wobec potrzeby dostosowania jego złożoności do możliwości przetwarzania przez dominujące na rynku karty oraz w celu zachowania kompatybilności ze starszymi produktami, rozwój idzie stosunkowo powoli. Być może ATI R580 stanie się pożądaną przez programistów bazą sprzętową do tworzenia i "oblatywania" nowych gier, ale potencjalny klient, który decyduje się wydać konkretną gotówkę na nową kartę graficzną chce uzyskać natychmiastową korzyść już dziś lub przynajmniej konkretne przesłanki ku temu, że trend zmian w oprogramowaniu nastąpił w kierunku przez niego pożądanym i na efekty nie przyjdzie mu długo czekać. Na szczęście tym razem nie kupujemy kota w zupełnie nieprzezroczystym worku. Na rynku mamy już wiele zaawansowanych gier, w których bariera wydajności oparta jest na shaderach, co powinno pozwolić na rozwinięcie skrzydeł nowego Radeona.

Drugim poważnym dowodem w sprawie są najnowsze konsole do gier. Pewnie niejeden z czytelników zauważył jak wielki miały one wpływ na gry, które pojawiły się w ubiegłym roku. Rozwinięcie efektów poprzez "oprogramowanie" pikseli jest naturalnym kierunkiem dla ich silników z uwagi na sztywność stosunkowo niskiego trybu wyświetlaczy. Z drugiej strony podbój rynku rozpoczął Xbox360, którego sercem jest układ ATI wyposażony w 48 procesorów do przetwarzania shaderów. Każde ujednolicenie platformy jest mile widziane przez programistów, a produkt sprzętowy Microsoftu zapowiada się na niezły przebój. Z resztą wspólnych z Xbox'em cech najnowszy układ ATI ma znacznie więcej. Sądzę, że daje to wystarczające zabezpieczenie inwestycyjne.

Ostatnia kwestia, na którą chciałbym zwrócić uwagę, to fakt stosunkowo dużych wymagań ATI w odniesieniu do własnych procesorów cieniowania pikseli. Radeony nie tylko mają mniej TMU niż konkurencja, ale i ich możliwości są znacznie skromniejsze. GeForce jest w stanie uzyskać na nich m.in. sprzętowe filtrowanie tekstur FP (Floating Point), czego żaden produkt ATI nie jest w stanie zrobić. Wynika to koncepcji realizowania tej funkcjonalności w oparciu o PixelShader co dodatkowo zwiększa głód ATI w kwestii jego wydajności. Wszystko to powoduje, że z pewną nieśmiałością, ale bez większych oporów skłonny jestem ocenić rozwój architektury 3D bardzo pozytywnie, a wręcz z pewną nutką euforii.

Pchnięcie rozwoju silników gier w pożądanym dla siebie kierunku wymaga dobrej pozycji wyjściowej. Aby produkt ATI sprzedał się dobrze i posłużył do jakichkolwiek "wyższych" celów, musi najpierw dobrze sprawdzić się w aktualnie eksploatowanych, często obrzydliwie starych, klasycznych testach wydajności w grach, w których kod shadera jest jedynie dodatkowym obciążnikiem grafiki lub co najwyżej tylko jednym z kilku podstawowych jej elementów. Jednym słowem, musi zostać przepuszczony przez moją standardową maszynkę testową. Przyszedł czas na przedstawienie bohaterów recenzji.

HIS Radeon X1900XTX i X1900XT

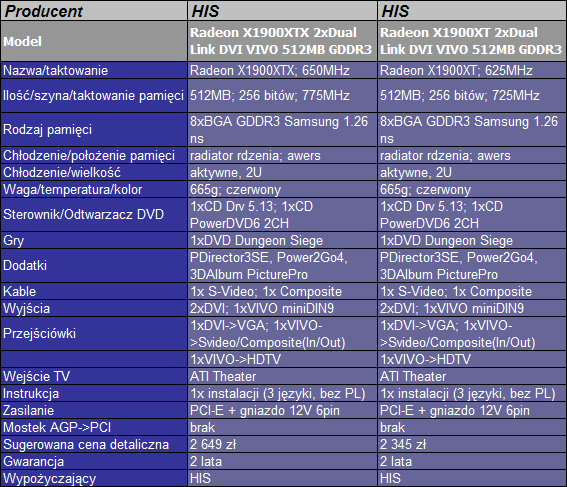

Karty Radeon serii X1900 HIS zapakował w średniej wielkości pudełko z charakterystycznym motywem miecza. Silniejszy model wyróżnia czerwona, a słabszy niebieska tonacja barw. Karty są kopią referencyjnych modeli ATI, a jedynym dodatkiem producenta są nalepki z nazwą modeli i logo na chłodzeniu. Zarówno wyposażenie jak i wygląd jest taki sam dla obu testowanych kart wobec czego zdecydowałem się na wspólny opis. Różnica (oprócz ceny), która dzieli te dwa produkty tkwi w taktowaniu. W przypadku XTX mamy 650/775MHz (rdzeń/pamięć) natomiast dla XT 625/725MHz.

W zasadzie Radeony X1900XTX i X1900XT wyglądają niemal identycznie jak poprzednio testowany model X1800XT. To samo chłodzenie, pamięci, wyjścia. Wygląda również na to, że gigantycznych rozmiarów czerwony laminat również niewiele się zmienił. Na awersie osiem kości GDDR3 Samsung 1.26ns o łącznej pojemności 512MB. Na śledziu dwa wyjścia Dual Link DVI oraz gniazdo VIVO (miniDIN 9pin, wejście obsługiwane przez układ ATI Theater). W tylnej części płytki gniazdo zasilania PCI-E (6 pinów).

Pudełko HIS X1900XT i X1900XTX(kliknij, aby powiększyć)

Karty HIS X1900XT i X1900XTX są identyczne (kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Wygląda na to, że konstrukcja chłodzenia została przejęta od X1800XT bez zmian. Zaraz po włączeniu peceta wentylator rusza na pełnych obrotach (ok. 5000 rpm) wyjąc niemiłosiernie i za chwilę zdecydowanie cichnie (ok. 1900 rpm). Da się go usłyszeć w cichszych pecetach, ale nie powinien specjalnie nikomu przeszkadzać. Niestety nie mogę powiedzieć, że w 3D działa tak samo cicho jak poprzednik. Zwiększenie o 25W mocy układu (15W w przypadku XT) owocuje stosunkowo szybkim choć niewielkim zwiększeniem obrotów, a po dłuższym czasie następuje kolejny wzrost. Pomimo, że daleko do maksymalnych możliwości wentylatora to jednak operując na granicy słyszalności w 2D wyraźnie odczuć można wejścia na kolejne stopnie prędkości obrotowej. Nadal karty należą do stosunkowo cichych, ale z pewnością znajdą się tacy, co będą się rozglądali za lepszych chłodzeniem. Zresztą regulator obrotów daje się sterować od strony oprogramowania i być może da się ustalić stałe, niższe obroty o mniejszym natężeniu dźwięku. Szczególnie w przypadku słabszego modelu XT. Sporo jednak zależy od konkretnego peceta, ponieważ powietrze jest zasysane z wewnątrz obudowy i jego temperatura wpływa na układ graficzny.

W zestawach znajdziemy niemal kompletne okablowanie przyzwoitej jakości. Tym razem mamy też dwie przejściówki DVI-VGA, więc każda konfiguracja ekranów jest możliwa do natychmiastowej obsługi. Zabrakło natomiast innego elementu. I to moim zdaniem bardziej istotnego. Chodzi o przejściówkę z zasilania PCI-E na molex. Wiele osób ma dobrej klasy zasilacze nieco starszego typu i po zakupie karty może się okazać, że szczęśliwy nabywca nie jest w stanie od razu uruchomić swojej nowej zabawki. Co do oprogramowania to nic specjalnego nie da się wytknąć. Jest pełna wersja uznanej gry, odtwarzacz DVD oraz edytor filmów obsługujący wejście wizyjne. Zestaw kompletny, ale niczym charakterystycznym się nie wyróżniający.

Karty HIS RX1900XTX oraz HIS RX1900XT, pod względem konstrukcji oraz wyposażenia oceniam dobrze, a powielenie referencyjnego standardu gwarantuje znakomitą jakość. W zasadzie, aby karty zwracały uwagę klienta wśród innych ofert obejmujących te same modele, przydałby się jakiś dodatkowy, spektakularny wyróżnik (jak na przykład bardzo dobrze oceniane przez klientów karty HIS IceQ z chłodzeniem Silencer) lub choćby drobny upust cenowy w stosunku do innych producentów. Biorąc pod uwagę możliwości i wyposażenie kart w stosunku do proponowanej ceny, przygotowanie gotowej oferty na dzień oficjalnej premiery układów graficznych oraz fakt umożliwienia mi testów modeli, które dopiero znajdą się w sklepach uznałem, że warto nagrodzić go za te produkty wyróżnieniem. Karty HIS RX1900XTX oraz HIS RX1900XT, pod względem konstrukcji oraz wyposażenia oceniam dobrze, a powielenie referencyjnego standardu gwarantuje znakomitą jakość. W zasadzie, aby karty zwracały uwagę klienta wśród innych ofert obejmujących te same modele, przydałby się jakiś dodatkowy, spektakularny wyróżnik (jak na przykład bardzo dobrze oceniane przez klientów karty HIS IceQ z chłodzeniem Silencer) lub choćby drobny upust cenowy w stosunku do innych producentów. Biorąc pod uwagę możliwości i wyposażenie kart w stosunku do proponowanej ceny, przygotowanie gotowej oferty na dzień oficjalnej premiery układów graficznych oraz fakt umożliwienia mi testów modeli, które dopiero znajdą się w sklepach uznałem, że warto nagrodzić go za te produkty wyróżnieniem.

|

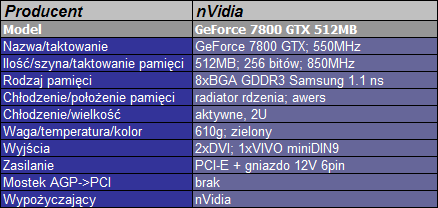

nVidia GeForce 7800GTX 512MB

Na temat tej mutacji GTX'a większość z nas raczej jedynie słyszała, bo w sklepach był praktycznie nieosiągalny. Produkt miał za zadanie zneutralizować wpływ premiery kart Radeon X1800XT na sprzedaż kart z najwyższej półki. GeForce 7800GTX 512MB w sensie technologicznym nie jest niczym nowym. Model powstał przez obsadzenie płytki z GTX'em najwydajniejszymi (i najdroższymi) na rynku pamięciami Samsung GDDR3 1.1ns, o dwukrotnie większej pojemności. Jak do tego dodamy ekstremalne podkręcenie wyselekcjonowanych pod kątem taktowania rdzeni działających przy napięciu wyższym niż specyfikacja procesu technologicznego oraz jeden z najwydajniejszych systemów chłodzących powietrzem, jakie znaleźć można na rynku to kształtuje się obraz tego monstrum. Karta jest zdecydowanie wydajniejsza od najmocniejszych GF7800GTX 256MB na rynku, bo udało się wycisnąć z niej 550/850MHz (rdzeń/pamięć).

Głównym problemem, z którym borykał się ten model jest to, że dotychczas występował w sklepach w ilościach śladowych. nVidia chętnie rozdawała sample testowe recenzentom, co spowodowało, że trafił do świadomości potencjalnych klientów, ale jak ktoś chciał go kupić to zaczynał się problem. Nieliczne egzemplarze najczęściej trafiały do wybranych sklepów poza oficjalną siecią dystrybucji największych producentów kart. Pomimo moich prób żaden z dystrybutorów nie był mi w stanie znaleźć gotowego do sprzedaży produktu, więc zmuszony byłem poprosić o pomoc nVidia i zapisać się na wypożyczenie referencyjnego egzemplarza przeznaczonego do testów. Brak dostępności spowodował, że jeśli już udało się kartę znaleźć w sklepie, to jej cena okazywała się znacznie wyższa niż sugerowana wcześniej przez producenta, co oczywiście związane było z wielkością podaży. W ten sposób można było u nas znaleźć ją w niektórych ofertach internetowych, w cenie sięgającej 3200 zł pomimo tego, że miała w założeniach kosztować tyle samo, co testowany dziś Radeon X1900XTX. Nieoficjalnie dowiedziałem się, że w końcu sprzedaż tych kart ma wreszcie szansę ruszyć na szerszą skalę, więc tym bardziej zależało mi na jego przetestowaniu. A oto i on.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Zielony, długi laminat, dwa porty DVI, gniazdo VIVO, zasilanie PCI-E, możliwość łączenia w SLI no i to niesamowite chłodzenie pokrywające niemal całą powierzchnie płytki. Centralnie umieszczony, gigantyczny (jak na karty graficzne) wentylator 9cm i dwa wysoko żebrowane radiatory "zasilane" czterema ciepłowodami po jego obu stronach. W odróżnieniu od wersji 256MB wszystkie osiem kości pamięci zainstalowano na awersie, dzięki czemu mogą korzystać z dobrodziejstw wspólnego z GPU chłodzenia.

Karta startuje bezszmerowo i jedynie po chwili, krótkim "warknięciem" obrotami sygnalizuje swoją obecność. Od tego momentu działa w zakresie hałasu zarezerwowanym dla najcichszych kart jakie miałem okazję słyszeć (oczywiście oprócz rozwiązań pasywnych). W czasie intensywnych testów obroty nie wzrastały na tyle, aby można to było zauważyć. Bez dwóch zdań mamy do czynienia z rewelacyjnym układem chłodzenia. Sukces jest tym większy, że karta pobiera w "stresie" ponad 20W więcej niż klasyczny GTX.

W związku z tym, że jest to referencyjna karta testowa to oczywiście nie można nic konkretnego powiedzieć o wyposażeniu, okablowaniu czy oprogramowaniu. To już leży w gestii konkretnego producenta, który będzie markował produkt.

Testy

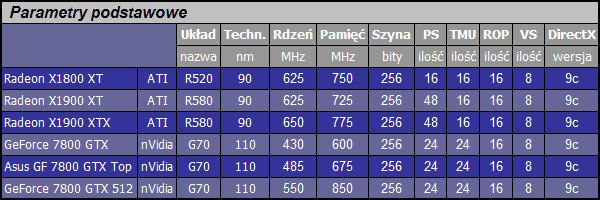

W porównaniu bierze udział pięć kart. Oprócz opisanych powyżej produktów w tabelach wystąpią również wcześniej przetestowane karty Sapphire RX1800XT oraz Asus GF7800GTX Top.

Sprzęt testowy oparty był na platformie, której trzon wydajności tworzyły: procesor AMD Athlon 64 S939 @2.4GHz, płyta Asrock 939Dual-SATA2, 1GB DDR-400. Sterowniki ATI v5.13 i nVidia v81.98. Ustawienie sterowników domyślne oprócz wyłączenia vsynch. Zestaw testów ten sam, co w poprzednim porównaniu, z którego zresztą zapożyczyłem sobie wyniki dla dwóch dodatkowych kart. Zanim przejdę do nich, najpierw kilka słów wprowadzenia.

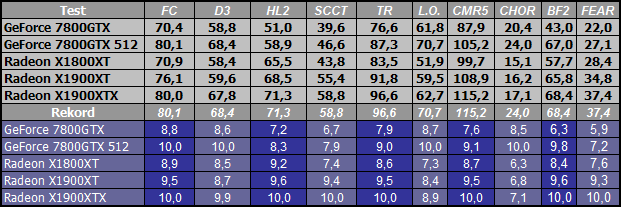

Nie będę ukrywał, że już sam jestem wysoce zniesmaczony swoimi aktualnymi procedurami testowymi. W jaki sposób można najlepiej zdyskredytować najnowszy produkt ATI? To proste. Wystarczy wziąć nieco starszy, jednordzeniowy procesor, starsze sterowniki, zestaw leciwych gier, które w mniejszym stopniu wykorzystują shadery i testować w niższych trybach bez FSAA/Anizo. Jednym słowem zrobić niemal to, co sam zrobiłem. No może nie do końca, bo podstawowy tryb testowy to 1600x1200 AF (FSAA 4x/ Anizo 8x), a wśród gier testowych znajdą się również pozycje oparte na nowych silnikach 3D. Tym nie mniej testy dowiodły, że szereg wykorzystywanych benchmarków nie nadaje się już do dalszej eksploatacji i trzeba je wymienić. Nie chodzi tu tylko o kwestię wydajności samych shaderów, ale globalne możliwości nowych kart z najwyższych półek cenowych. Jako, że nie miałem czasu na przygotowanie nowych testów to efekty są takie, a nie inne. Postaram się za to tym razem nieco szerzej je zinterpretować. Proszę o zwrócenie większej uwagi również na wykresy uzależnione od trybu. Można z nich sporo wyciągnąć informacji również w kwestii przydatności samego benchmarka.

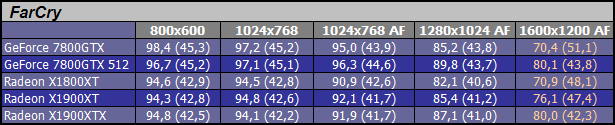

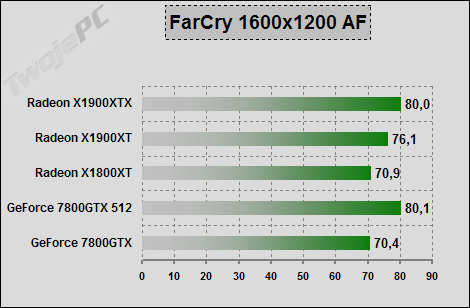

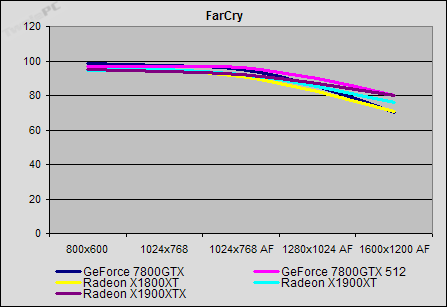

FarCry: Chętnie wykorzystywana gra testowa zaopatrzona w szereg nowych rozwiązań generacji efektów 3D. Demo testowe obejmuje większą część mapki Research. Mamy zarówno otwarte przestrzenie jak i wzbogacone shaderami jaskinie. Pomiar wbudowaną procedurą testową, która niestety nie zawiera wszystkich elementów pojawiających się w czasie gry, co powoduje zawyżanie wyników. Gra ma unikalną możliwość uruchomienia HDR w oparciu o zapis FP16. Niestety jak na razie tylko dla kart nVidia (ma się to niedługo zmienić), więc takie ustawienie nie było aktywne.

W zasadzie dopiero powyżej 1280x1024AF coś się zaczyna dziać. Na nieznacznym prowadzeniu XTX oraz GTX512. Płaska charakterystyka wykresu liniowego oznaczająca niewielką reakcję na tryb wskazuje na brak prawidłowego dociążenia samych kart. W takich przypadkach framerate w mniejszym stopniu opiera się na wydajności GPU, co może prowadzić do błędnych wniosków. W przypadku FarCry można "pompować" różnice pomiędzy kartami zwiększając moc procesora, co nie poprawi faktycznej płynności tylko sam wynik średni lub wejść na jeszcze wyższe tryby testowe co z kolei oderwie wyniki od rzeczywistości sprzętowej typowych monitorów. Gra zbyt ważna, aby z niej zrezygnować, ale w przypadku testowanych kart specjalnie dobrym "obciążnikiem" nie jest. Jeśli pojawi się uniwersalny (dla kart SM3.0) patch z HDR, to pewnie przejdę na testy w tym ustawieniu.

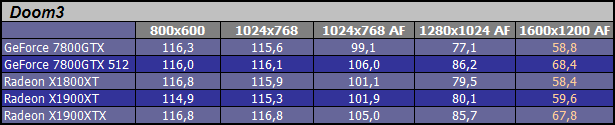

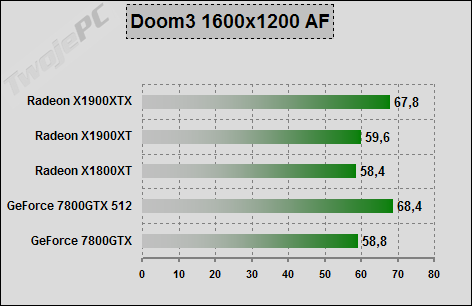

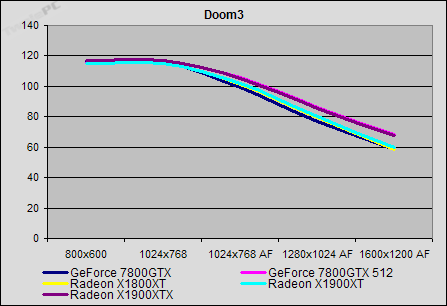

Doom3: Podstawowy benchmark OpenGL. Pomiar za pomocą wbudowanego narzędzia i demka testowego (timedemo demo1). Bardzo dobre dopasowanie do możliwości kart GeForce (m.in. wykorzystanie umiejętności generowania 32 wartości Z bez koloru w jednym takcie zegara, czy sprzętowa realizacja efektu "dynamic stencil shadow").

Również i ta gra nie stanowi większego problemu dla nowych GPU. Wewnętrzny ogranicznik framerate silnika nieco scala wyniki różnych kart. Szczególnie w niższych trybach. W 1600x1200AF zarysowuje się pewna przewaga RX1900XTX oraz GF7800GTX512 nad pozostałymi kartami. Z tej gry, ze względów politycznych również nie mam na razie zamiaru rezygnować. Tym bardziej, że przejście na Quake 4 niewiele wnosi nowego do porównań kart, choć jest to pewna alternatywa.

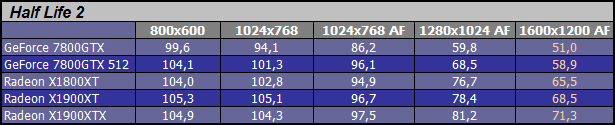

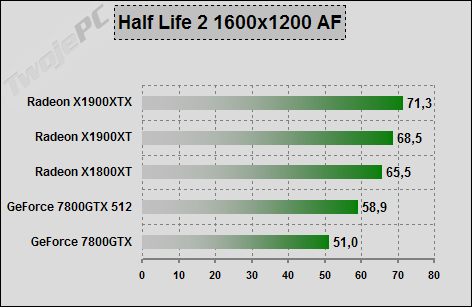

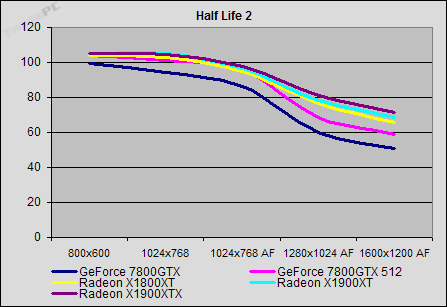

Half-Life 2: Gra dobrze wykorzystuje hardware Radeonów. Pomiar narzędziem wbudowanym w grę przy wykorzystaniu własnego demka nagranego na mapie Cannals. Spora ilość nowych efektów Dx.

Ładne efekty, ale niewielki problem z ich uzyskaniem na najsilniejszych obecnie kartach graficznych. W przypadku tej gry najchętniej przeszedłbym z testami na bardziej zaawansowany graficznie dodatek Lost Coast (wyposażony m.in. w możliwe do uzyskania na różnych kartach HDR z FSAA). Tym razem mamy nieco większe zróżnicowanie wyników pomiędzy ATI i nVidia. Radeony wyraźnie na prowadzeniu.

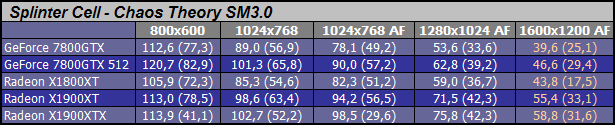

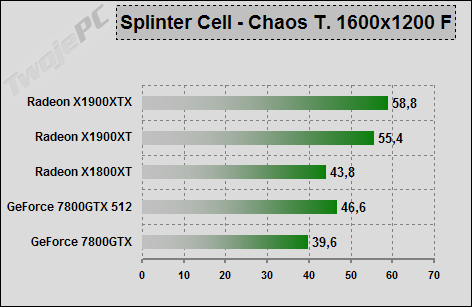

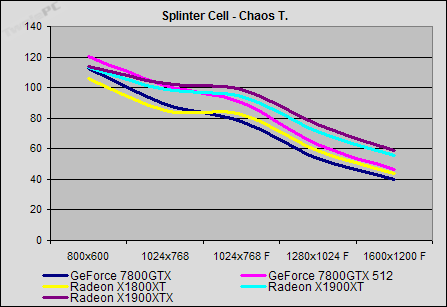

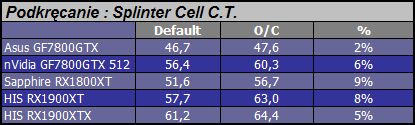

Splinter Cell - Chaos Theory: Ta gra zdecydowanie kieruje się w stronę nowych trendów 3D. Sporo efektów PS3.0. Jest również HDR choć jeszcze bez możliwości łączenia z FSAA. Pomiar za pomocą wbudowanego w grę benchmarka.

W końcu udało się prawidłowo dociążyć grafikę i wyniki są w stanie podzielić karty. W obliczu sporego wykorzystania shaderów seria X1900 pokazuje pazury. GF7800GTX512 zdołał wyprzedzić jedynie RX1800XT. Ten test powinien jeszcze przeżyć kilka kolejnych porównań kart i chyba warto na nim sprawdzać zysk z podkręcania.

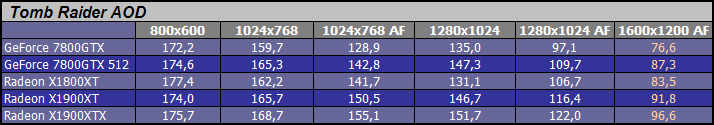

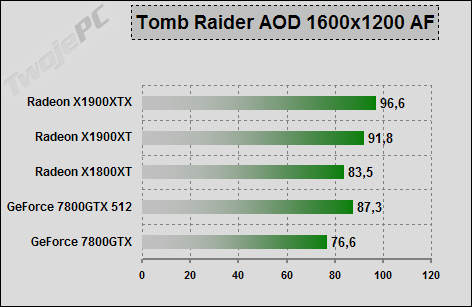

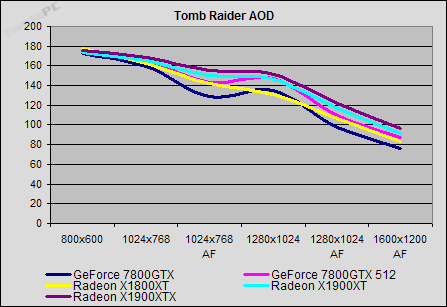

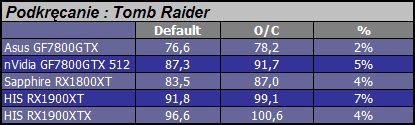

Tomb Raider - The Angel of Darkness: Gra, pomimo sponsorowania przez nVidia nie "leży" dobrze kartom GeForce. Sporo faktycznie unikalnych funkcji 3D (szczególne wykorzystanie silnika vertex), które jak na razie nie doczekały się powielenia (no może oprócz 3dmarka '05). Benchmark zawarty jest w grze w wersji 0.49.

Pomimo upływu czasu gra wciąż dobrze reaguje na same karty graficzne, choć aktualna wielkość średniego framerate jest już na tyle duża, że pewnie niedługo pomyślę o jej wymianie. Nie jest to jednak natychmiast niezbędne, bo w związku z prawidłową reakcją na podkręcanie mogę przypuszczać, że GPU jest prawidłowo dociążone. Kolejność kart taka jak w poprzednim teście.

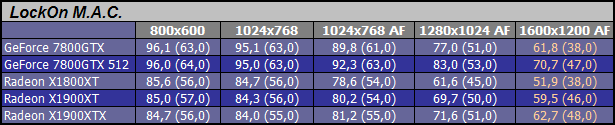

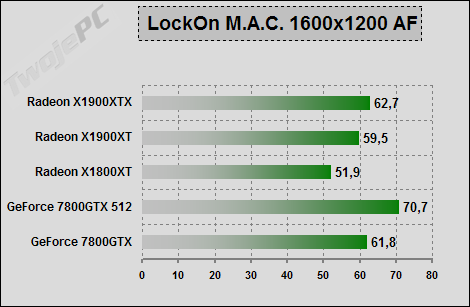

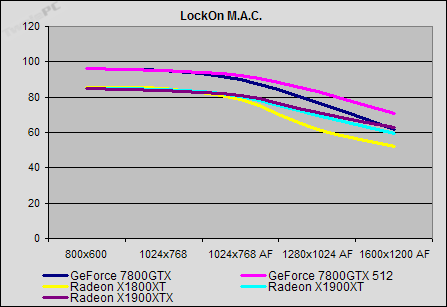

LockOn - Modern Air Combat: Wciąż jedna z najlepszych gier "lotnictwa wojskowego". Pomimo upływu lat nadal straszy słabsze karty. Pomiar wykonywany za pomocą programu fraps w czasie demonstracji lotu F15 na małej wysokości.

W końcu po latach znalazły się na rynku karty, które pomimo ustawienia w grze jakości High umożliwiają płynną grę nawet w wyższych trybach. W związku z dobrym dociążeniem samych kart jeszcze pewnie trochę potrwa u mnie eksploatacja tego testu, choć trudno doszukiwać się w nim ambitnych shaderów, czy najnowszej generacji efektów 3D. Tym razem na czele GF7800GTX512. Słabszy GTX oraz Radeony X1900 notują podobne wyniki. RX1800XT spada na ostatnią pozycję.

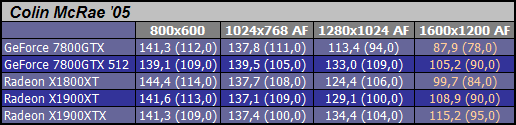

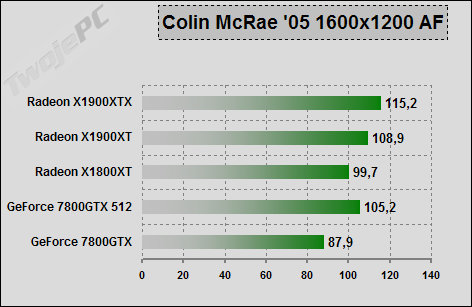

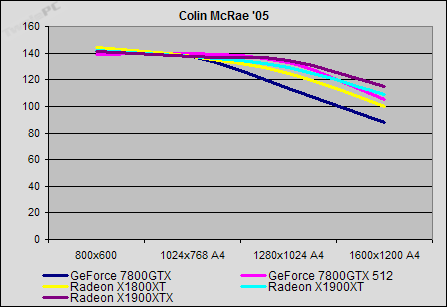

Colin McRae '05: W moim zestawie testowym nie może nigdy zabraknąć gry "samochodowej". To chyba już ostatni test wykorzystujący tą grę. Pomiar za pomocą fraps.

Rozwarstwienie wyników od 1280x1024AF. Seria X1900 przed GTX512 oraz RX1800XT. Nieco gorzej wypadł jedynie słabszy z GTX'ów. Zdecydowanie za duży framerate, aby dalej eksploatować ten test. Spróbuję go wymienić na NFS Most Wanted wykorzystujący znacznie więcej efektów i lepiej dociążający karty graficzne.

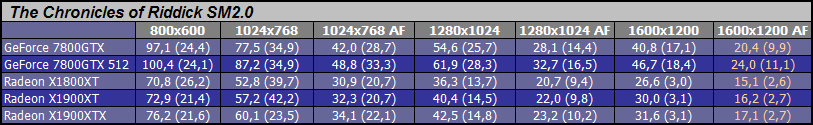

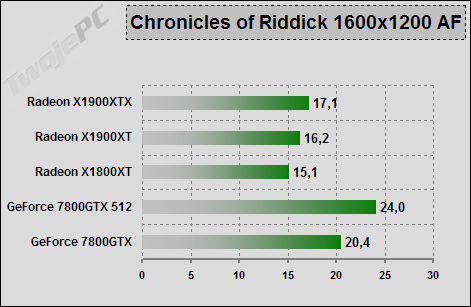

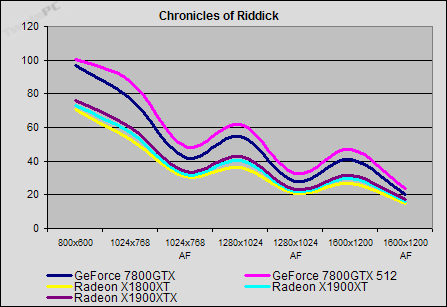

The Chronicles of Riddick: Drugi z testów opartych na grze OpenGL. Również i w tym wypadku mamy do czynienia z silnikiem 3D bardzo dobrze osadzonym na kartach GeForce (pełne wsparcie technologii nVidia Ultra Shadow). Dla Radeonów zdecydowanie trudny orzech do zgryzienia, choć z uwagi na spore wykorzystanie arytmetycznych operacji na pikselach jest szansa, że X1900 zabłyśnie. Pomiar za pomocą specjalnego programu testowego opartego na grze. Tak dobrane miejsce testu, aby rzucić karty na kolana.

Ten benchmark również jeszcze nie raz się przyda. Framerate bardzo niski, a FSAA ma na niego dodatkowo mocny wpływ. Spodziewałem się większych różnic pomiędzy Radeonami. Karty GeForce zdecydowanie na czele.

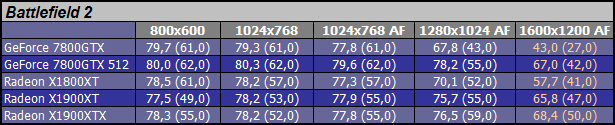

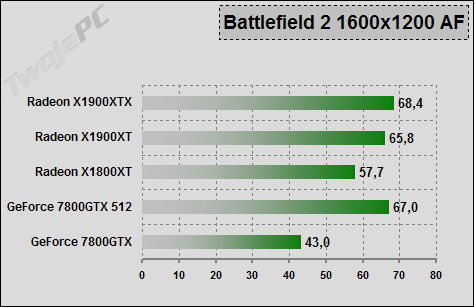

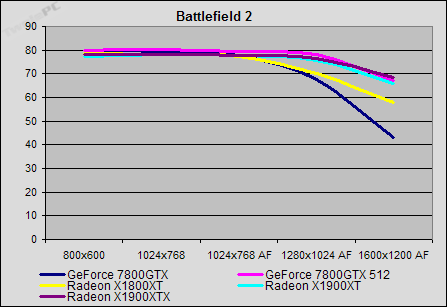

Battlefield 2: Jedna z moich nowszych gier testowych. Duża ilość nowych efektów. Znaczące wykorzystanie shaderów. Pomiar za pomocą fraps na wbudowanym benchmarku.

Od 1280x1024AF następuje dociążenie kart i można wyłonić zwycięzców oraz przegranych. RX1900XTX minimalnie przed GTX512 oraz RX1900XT. Za nimi RX1800XT a GF7800GTX ląduje na zdecydowanie straconej pozycji.

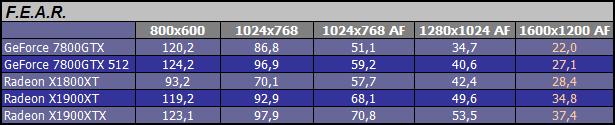

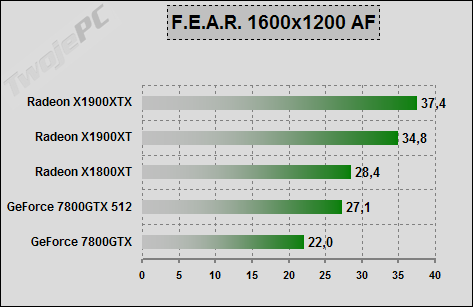

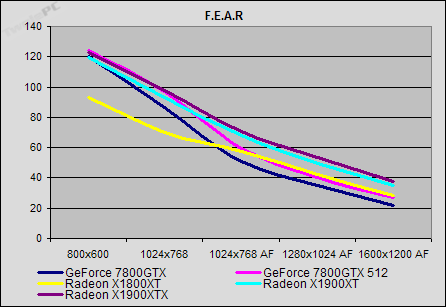

F.E.A.R.: Tak się składa, że na końcu znalazła się gra, która w największych stopniu opiera efekty 3D na wykorzystaniu programów cieniujących piksele. Pomiar za pomocą fraps przejścia przez wybrany fragment gry.

Już po włączeniu FSAA/Anizo w 1024x768 karty zmuszone są do ciężkiej pracy. Spektakularne zwycięstwo Radeonów X1900. Zarówno nad swoim poprzednikiem jak i kartami konkurencji. Wydaje się, że te 48 procesorów cieniowania pikseli w końcu miało odrobinę roboty.

Muszę przyznać, że nawet biorąc pod uwagę zbyt "staroświecki" charakter niektórych testów to i tak Radeony serii X1900 radziły sobie zupełnie nieźle. W kolejnych artykułach spróbuję wykorzystać nowsze gry. Mam szczery zamiar zastąpienia niektórych testów przez benchmarki oparte na takich tytułach jak: HL2 LC, NFS MW, CoD2, X3 (skróty niewątpliwie znane miłośnikom gier).

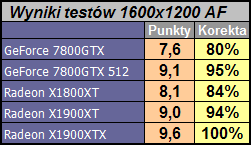

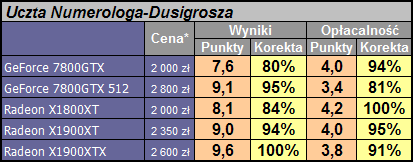

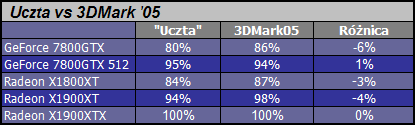

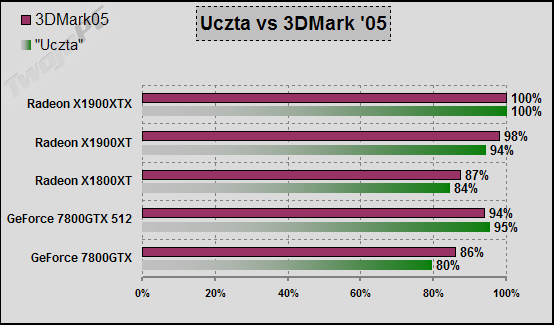

Otwarte pozostaje pytanie, kto wygrał w tym pojedynku. Zarówno RX1900XTX jak i GF7800GTX512 miały swoje zwycięstwa cząstkowe. Trzeba więc wyłonić mistrza za pomocą uśrednienia różnic wyników (licząc od zera) poszczególnych konkurencji. Od wielu testów robię to w ten sam sposób i nazywam "ucztą numerologa". Zestawienie wygląda następująco.

Panie i Panowie. Zwycięzcą dzisiejszego porównania został ... Radeon X1900XTX. Na drugim miejscu uplasował się GeForce 7800GTX 512MB z wynikiem niemal identycznym jak RX1900XT. Czwarty jest RX1800XT, a na końcu znalazł się GF7800GTX.

Natychmiast nasuwa mi się kilka dodatkowych spostrzeżeń. Po pierwsze zwycięstwo najnowszej karty ATI jest bardziej spektakularne niż wynikałoby to z powyższeg wykresu, ponieważ zestaw testowy był dobrany w niezbyt sensowny sposób. Kilka gier oparło framerate na ograniczeniu ze strony platformy co spowodowało, że różnica pomiędzy kartami sztucznie się pomniejszyła. Po drugie wiele z testów nie odpowiada już aktualnym trendom budowy silników 3D, co naturalnie ograniczyło możliwość "wykazania" się kartom Radeon serii X1900. Po trzecie obraz generowany przez karty GeForce odbiegał jakością filtrowania od kart ATI. Rezygnując z domyślnego ustawienia sterowników nVidia można doprowadzić do zbliżenia jakości obrazu 3D, ale kosztem zmniejszenia wyników osiąganych przez te karty (konkrety można znaleźć w poprzednich recenzjach). Przypomnę również, że użyty w porównaniu GeForce 7800GTX 512MB jest dosyć ekstremalną mutacją G70, czego nie mogę powiedzieć o nowych Radeonach. Również okupujący ostatnie miejsce GTX nie jest tym samym produktem, który pokazano wiele miesięcy temu, ale jego wzmocnioną odmianą. Szczególnie istotny jest problem doboru testów. Nie chodzi tylko o porównanie rywali wystawionych przez różnych producentów układów graficznych, ale i realną różnicę pomiędzy dwoma seriami kart ATI. Może więcej napiszę o tym w podsumowaniu.

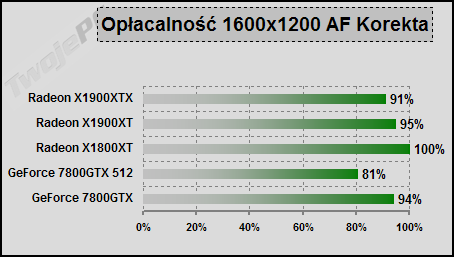

Z reguły, wobec różnic w cenie robię dodatkowe zestawienie związane z przeliczeniem punktów uzyskanych w testach na koszt zakupu kart. Tym razem jest to niezbyt trafiony pomysł, ponieważ trudno wycenić GF7800GTX512. Jedyna znana mi (w trakcie pisania recenzji) konkretna oferta opiewała na ok. 3200 zł ale sądzę, że cena powinna znacząco spaść w przypadku lepszej dostępności produktów. W związku z tym, nieco ugodowo dałem w tabeli kwotę 2800 zł. Takie i niższe oferty również pojawiają się w sklepach (np. w sklepie TwojePC jest Asus za 2400 zł), ale bez dostępności kart. Oczywiście każdy może użyć do porównań dowolnej ceny.

Powyższy wykres należy traktować z dużym przymrużeniem oka. Nie tylko ceny są jeszcze mało stabilne, ale i wyniki średniego framerate w dużym stopniu zmienią się wraz z przejściem na nowsze testy.

Dodatkowe testy

W tym rozdziale najczęściej umieszczam te testy, które opierają się na syntetycznych benchmarkach lub służą do wyciągania dodatkowych wniosków. Możemy tu znaleźć 3Dmarka, testy podkręcania czy ocenę jakości obrazu.

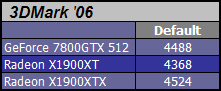

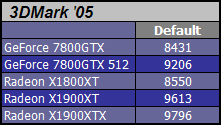

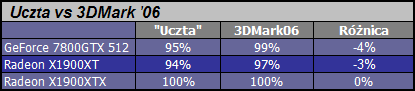

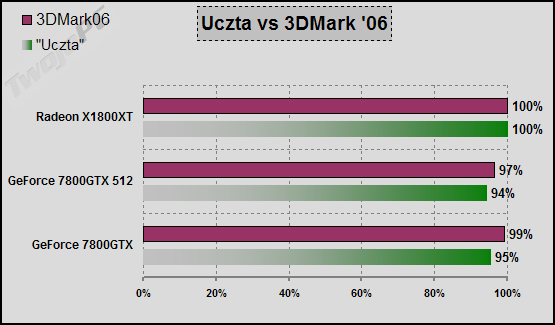

Najpierw dwie tabelki zasilone wynikami z oprogramowania testującego firmy Futuremark. Podobnie jak w poprzednich recenzjach zrobiłem porównanie 3DMarka z "ucztą numerologa". W związku z tym, że w sieci pojawił się nowy test, to niektóre z kart udało mi się nim przetestować.

Wyniki dosyć zbliżone mimo faktu braku FSAA/Anizo w teście domyślnym 3DMarka.

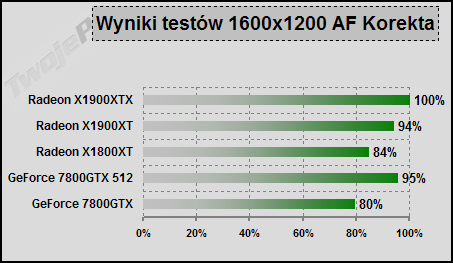

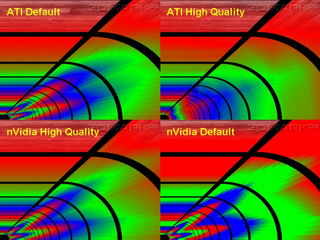

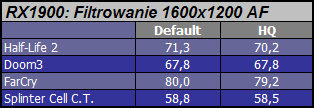

Drugi dodatkowy test dotyczy jakości filtrowania anizotropowego nowych kart ATI. Pisałem w poprzednim artykule o wprowadzeniu w seriach Radeon X1k udoskonalonego algorytmu, a teraz przyszedł czas na konkrety. Model filtrowania o nazwie HQ (High Quality) włącza się w sterowniku (domyślnie wyłączony).

Filtrowanie (kliknij, aby powiększyć)

W zasadzie ten obrazek mówi wszystko. Oczywiście pod warunkiem, że ktoś potrafi interpretować te "słoneczka". Domyślne ustawienie sterownika powoduje wyraźne pogorszenie jakości filtrowania kart GeForce. Po przesunięciu suwaka jakości na HQ, uzyskujemy obraz zbliżony do domyślnego ustawienia ATI. Jak wykazałem wcześniej "kosztuje" to ponad 5% średniego framerate. Natomiast włączenie trybu HQ na kartach Radeon w dużym stopniu uniezależnia jakość filtrowania od kąta pod jakim widzimy tekstury. Sprawdźmy jak mocno ta poprawa obrazu obciąża GPU.

Wstępnie wygląda na to, że ATI opracowało bardzo dobry algorytm filtrowania. Przy okazji kolejnych testów sprawdzę jego realny wpływ na testowane gry. Jeśli potwierdzi się jego działanie, to koszt jest na tyle mały, że praktycznie nie będziemy go w stanie wyczuć. Sądzę, że spokojnie można będzie wtedy włączyć na stałe ustawienie HQ w sterowniku.

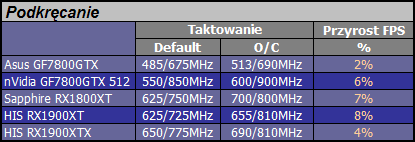

Na koniec testów dodatkowych zostawiam kwestię nadtaktowania kart. Oprócz wyznaczenia granicznych wartości częstotliwości rdzenia i pamięci sprawdzam jaki jest faktyczny zysk framerate w wyniku podkręcania. Do podkręcania ATI użyłem programu WinClk, natomiast w przypadku GeForce był to RivaTuner. Wyniki przedstawiają się następująco.

Jak widać możliwe do uzyskania wzrosty średniego framerate są na stosunkowo niskim poziomie (poniżej 10%). W zasadzie nie widzę sensu nadtaktowywania tych kart. No chyba, że ktoś ma typowo sportowe podejście do tego tematu.

Podsumowanie

No i to byłoby na tyle w temacie opisu mojego pierwszego spotkania z kartami ATI serii X1900. Osobiście nie mam wątpliwości, że Radeon X1900XTX jest aktualnie najmocniejszą kartą graficzną dla graczy na rynku. Do jego poprzednika (Radeon X1800XT), który pojawił się na rynku parę miesięcy wcześniej, ATI wprowadziła cały szereg poważnych zmian w architekturze oraz skutecznie opanowała technologię wytwarzania 90nm. Najnowszy produkt dodaje do zestawu nowych możliwości niespotykany wcześniej wzrost mocy cieniowania pikseli. 48 procesorów PixelShader stało się pecetowym faktem.

ATI udało się zniwelować opóźnienie i po raz pierwszy od dłuższego czasu pokazała kartę, która nie jest mniej lub bardziej udanym dostosowaniem do możliwości, jakie wcześniej stworzyła konkurencja, ale w niewielki, choć zauważalny sposób wyprzedza ją zarówno technologicznie, jak i wydajnościowo. Analizując schemat architektury nowych rdzeni widać, że wyraźnie nastawiona jest w kierunku silników gier, których w zasadzie jeszcze nie ma. Nie chodzi tu nawet o samą kwestię długości i złożoności kodu shadera, ale i faktyczną różnicę wprowadzoną przez PS3.0, a dotyczącą implementacji dynamicznych rozgałęzień. Można się spierać o to, w jakim tempie wzrastać będzie zapotrzebowanie na moc obliczeń arytmetycznych procesorów pikseli, ale kierunek zmian nie pozostawia wątpliwości. Jedynym nurtującym mnie pytaniem było to, czy aktualne wykorzystanie procesorów cieniowania pikseli pozwoli karcie wyposażonej w jedynie 16 jednostek teksturujących uzyskać przewagę nad 24-potokowym i do tego ekstremalnie podkręconym produktem konkurencji. Pomimo faktu użycia przeze mnie części zdecydowanie leciwych testów oraz platformy i trybów, które w wielu przypadkach powodowały brak pełnego obciążenia układów graficznych, średni wynik wypadł na korzyść nowej karty Radeon. ATI udało się dokonać jeszcze jednego trudnego wyczynu. Dzień po oficjalnej prezentacji karty serii X1900 były dostępne w sklepach.

Otwarte pozostaje pytanie o przyszłość kart serii X1800. Na zestawieniach cenowych ATI zostały one zastąpione nową serią produktów. Trudno powiedzieć, czy po prostu znikną, aby po czasie, pod nową nazwą odrodzić się w jakichś słabszych, blokowanych wersjach, czy po prostu zostaną znacząco przecenione (!).

Wśród dwóch opisanych przedstawicieli nowej serii na szczególną uwagę zasługuje minimalnie słabszy Radeon X1900XT. Od XTX'a różni się w niewielkim stopniu częstotliwościami taktowania rdzenia i pamięci. W związku z tym, że wydajność obu kart jest zbliżona to osobiście pozostawiłbym droższy model RX1900XTX jedynie dla miłośników sportowego okładania się wynikami testów.

ATI Radeon X1900XT

|

W związku z osiągnięciem pewnej przewagi ATI nad konkurencją teraz należałoby poczekać na ruch ze strony nVidia. Nieoficjalnie mówi się o prezentacji nowych produktów GeForce w marcu, w czasie targów CeBIT. Podobnie jak w zeszłym roku wolałem się nie wypowiadać na temat plotek związanych z R520, tak i teraz nie chciałbym komentować informacji (lub dezinformacji) na temat G71. Szum medialny w takich przypadkach działa na korzyść producentów, którzy dopiero przygotowują nowe produkty i może być przez nich sztucznie podniecany. Logicznym ruchem ze strony nVidia byłoby wzmocnienie (być może ostatnie) aktualnej architektury, co jeszcze na pewien czas utrwaliłoby pewien umowny podział kierunków przetwarzania na bardziej lub mniej "shaderolubne". Wciąż jednak najwięcej do powiedzenia będzie miała kwestia taktowania rdzenia i opanowania przez nVidia technologii 90nm. Mam nadzieję, że w ciągu paru miesięcy przestanie to być tajemnicą i zacznie się kolejny bój o klienta, na co zawsze liczę z nieukrywaną radością.

Teraz jednak umowne berło powędrowało na stronę Radeonów i tym wszystkim, którzy planują kosztowny zakup, mocnej karty graficznej, bez cienia wątpliwości chciałbym polecić karty serii X1900, a w szczególności model Radeon X1900XT. Dziś brawa należą się firmie ATI. Udało im się stworzyć bardzo zaawansowany technologicznie produkt, który nie tylko wygrywa aktualne porównania wydajności, ale również pozwala z nieco większym optymizmem oczekiwać nowych, wspaniałych silników gier 3D, których sobie i czytelnikom życzę niezmiennie od lat.

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | NVIDIA |

|  | HIS Polska |

|