Karty GeForceFX 5200 kontra rywale z przedziału 250-400 zł

Autor: Kris | Data: 05/11/03

|

Schodząc w dół naszych półek cenowych zawalonych różnorakimi kartami graficznymi w końcu szczęśliwie dobrnęliśmy do dna. Oczywiście radość związana jest z minimum kosztów, jakie ponieść musi miłośnik gier komputerowych, aby nacieszyć nimi domowego peceta. W przedziale cenowym 250-400 zł w zasadzie mamy tylko jedną, prawdziwą premierę w postaci GeForceFX 5200. To właśnie ta karta będzie głównym bohaterem recenzji. Aby prawidłowo osadzić jej walory użytkowe zostanie porównana z kilkoma wybranymi kartami należącymi to tej samej "ligi" cenowej. Za pomoc w zorganizowaniu testu dziękujemy firmie Sirius.Pl. Z oferty tego sklepu internetowego pochodzą wszystkie karty biorące udział w niniejszym opracowaniu. Zapraszam. Schodząc w dół naszych półek cenowych zawalonych różnorakimi kartami graficznymi w końcu szczęśliwie dobrnęliśmy do dna. Oczywiście radość związana jest z minimum kosztów, jakie ponieść musi miłośnik gier komputerowych, aby nacieszyć nimi domowego peceta. W przedziale cenowym 250-400 zł w zasadzie mamy tylko jedną, prawdziwą premierę w postaci GeForceFX 5200. To właśnie ta karta będzie głównym bohaterem recenzji. Aby prawidłowo osadzić jej walory użytkowe zostanie porównana z kilkoma wybranymi kartami należącymi to tej samej "ligi" cenowej. Za pomoc w zorganizowaniu testu dziękujemy firmie Sirius.Pl. Z oferty tego sklepu internetowego pochodzą wszystkie karty biorące udział w niniejszym opracowaniu. Zapraszam. | |

|

Wstęp

Czytając specyfikację NV34 stanowiącego bazę kart GeForceFX 5200 nie sposób oprzeć się wrażeniu, że układ jest w pewnym sensie odreagowaniem producenta na krytykę, jaka dotknęło go po wypuszczeniu serii GeForce4MX. nVidia dokonała wtedy cięć, które spowodowały, że karty w kwestii obsługi API 3D musiały zostać zakwalifikowane do generacji niższej niż konkurencja i straciły podstawowy impet marketingowy. Tym razem mamy sytuację zupełnie odmienną. Nowy GeForce chwali się światu tymi samymi możliwościami jak jego starsi bracia pomimo zejścia do najniższych przedziałów cenowych. Czy to możliwe? Karta Dx9 za ok. 300 zł, czyli niemal połowę kwoty, jaką musimy przeznaczyć za najtańszą kartę konkurencji oferującą te same efekty. Z czym mamy do czynienia? Chwyt marketingowy czy prawdziwa radość dla portfela? Za chwilę się o tym przekonany. Zacznijmy jednak od odrobiny teorii.

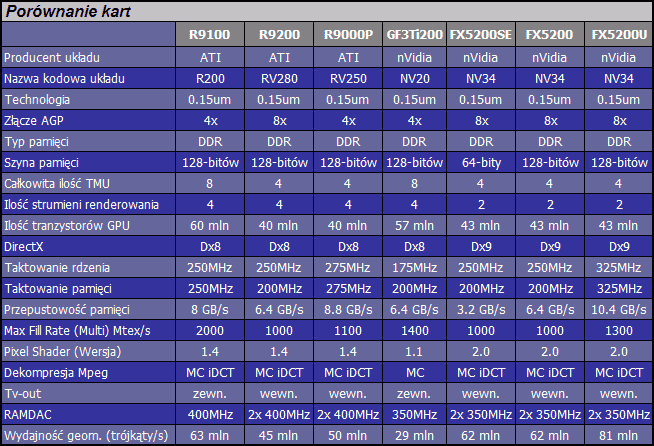

Różnice techniczne testowanych układów

nVidia przygotowała dwie referencyjne konstrukcje oparte o NV34. Karty nazwano GeForceFX 5200 oraz 5200 Ultra. Różnica sprowadza się jedynie do taktowania. Dodatkowo w sprzedaży dostępne są wersje FX5200 wyposażone w 64-bitową szynę pamięci, które w tabeli oznaczyłem wyróżnikiem SE. W związku z tym, że cena wersji Ultra (>700zł) kwalifikuje ten produkt do średniej półki cenowej i powoduje, że teoretycznie stanowi on konkurencję dla FX5600, nie będzie on uczestnikiem tego testu. Jak dla mnie jest to wytwór marketingowy, dzięki któremu na stronie producenta i w materiałach reklamowych można lepiej przedstawiać całą linię 200-tek w myśl hasła: FX5200 to np. przepustowość pamięci "do" 10.4GB/s za cenę "od" 250 zł. Chyba wiadomo, o co chodzi. Skoncentrujmy się na wersji "klasycznie" taktowanej, bo właśnie ta karta wzbudza największe zainteresowanie potencjalnych nabywców. Nie ukrywam, że również i moje.

Czym jest NV34? Podobnie jak NV31 (FX5600) powstał on w wyniku modyfikacji architektury NV30 (FX5800), choć w tym przypadku "cięcia" są tak znaczące, że w zasadzie można pisać o niemal zupełnie nowym projekcie układu graficznego nVidia. Podobnie jak w przypadku FX5600 bazą renderingu są cztery jednostki teksturowania będące w stanie operować na danych zmiennoprzecinkowych (Dx9) jednak w wyniku uproszczenia architektury znikły charakterystyczne dla NV31 obszary wykorzystania silnika, w których zachowanie układu przypomina karty z działającymi równolegle czterema potokami pikseli. Praktycznie w każdym zastosowaniu FX5200 zachowuje się jak układ 2/2 (dwa strumienie z dwoma TMU) w odróżnieniu od FX5600, który w zależności od wykonywanych funkcji potrafił w konkretnych przypadkach realizować funkcjonalność 4/1. W związku z tym, że 600-tka i tak w niewielkim stopniu korzystała z tego trybu to strata nie wydaje się zbyt dotkliwa. Mniej wtajemniczonym przypomnę, że GeForceFX nie ma wydzielonych potoków ze sztywno przyporządkowanymi jednostkami teksturowania. Stąd odniesienia do zachowaniu układu zamiast teorii działania poszczególnych bloków architektury.

Nieoficjalne dane o NV34 mówią o 43 mln tranzystorów w stosunku do 80 mln w NV31. Co jeszcze wycięto? Największe odchudzenie rdzenia wynika z rezygnacji z modułu multisamplingowej realizacji procesu antyaliasingu (FSAA). FX5200 likwiduje "schodki" na krawędziach ukośnych obiektów prostą metodą supersamplingu (niejawny rendering w wyższym trybie, na podstawie którego obliczane są dane pośrednie dla docelowej rozdzielczości). Może i jest to konkretna strata, ale biorąc pod uwagę zysk na wielkości rdzenia, segment rynku, dla którego układ jest przeznaczony oraz fakt, że konkurencja w tej samej cenie również nie oferuje multisamplingu to działanie producenta wydaje się sensownym posunięciem.

Kolejne cięcia dotykają modułów oszczędzania pasma. FX5200 traci kompresję tekstur, koloru oraz Z-Bufora. To już może się skończyć wpadką wydajności przy pamięciach typowych dla niższej klasy kart. Na szczęście współpracę z nimi zapewnia wydajny kontroler krzyżowy. Niestety zrezygnowano również z nowych układów Ramdac 2x 400MHz na rzecz starszej generacji 2x 350MHz. Szkoda, bo wyjście monitorowe droższych FX'ów zbliżyło się w końcu do klasy rozwiązań konkurencji. Ostatnia modyfikacja, na którą chciałbym zwrócić uwagę to fakt, że NV34 jest jedynym GeForceFX wykonywanym w technologii krzemowej 0.15um zamiast nowszej 0.13um. Pomimo tego, dzięki odchudzeniu rdzenia i wobec taktowania 250MHz karty te mogą być chłodzone pasywnie i wykorzystują tanie technologie produkcji laminatu. Spowodowało to kolejne obniżenie kosztów ich produkcji.

Odpowiadając na pierwotne pytanie można bez zastrzeżeń uznać, że w sensie zgodności z API FX5200 jest "prawdziwą" kartą Dx9. Silnik graficzny CineFX w wersji pierwotnej jest w stanie uzyskać te same efekty, którymi dysponują inne układy bezpośrednio wspierające ten standard. Aby jednak prawidłowo ocenić wynikające z tego korzyści trzeba przyjrzeć się jak w świecie realnych gier przekłada się to na wydajność. Jest to o tyle ważne, że przecież wszelkie cięcia dokonane w celu ograniczenia kosztów kart dotykają właśnie tej kwestii.

W tym miejscu mógłby się teoretycznie znaleźć obszerny opis nowych rozwiązań ze stajni ATI, ale tym razem producent Radeonów zdecydował się jedynie na drobną, techniczną „korektę” układu RV250, na temat której nie będę się specjalnie rozpisywał. Jedyna różnica sprowadza się do zmiany interfejsu na AGP 8x. W kwestii marketingowej „nowy” rdzeń RV280 lepiej pokrywa się z aktualną ofertą płyt głównych. Natomiast, jak już niejednokrotnie pokazywałem, nie ma to większego znaczenia dla walorów funkcjonalnych. Nie należy spodziewać się żadnych konkretnych zmian wydajności związanych z samym trybem pracy złącza, a nic nie stoi na przeszkodzie, aby do nowych płyt zastosować karty AGP 4x poprzedniej generacji (dopiero przy kartach opartych na specyfikacji 1.0, pojawia się problem kompatybilności). Niestety spece od reklamy nie ograniczyli się do wypunktowania teoretycznych zalet nowego interfejsu, ale sprzedali „minę” w postaci nazwy Radeon 9200 zamiast zgodnie z wcześniejszą doktryną pozycjonowania wydajności układów z tego samego „wysypu” właściwie go sklasyfikować. R9200 z punktu widzenia nabywcy powinien być traktowany niemal tak samo jak jego poprzednik R9000 tym bardziej, że taktowanie 250/200MHz pozostało niezmienione. Oczywiście będzie słabszy zarówno od R9000Pro jak i kończącego swój żywot R9100 (to z kolei nowa nazwa leciwego R8500LE). Otwarta pozostaje kwestia tego, czy aktualne karty są wystarczającym orężem do walki z nowym układem nVidia? Mam nadzieję, że niniejszy artykuł przybliży nas do odpowiedzi na to pytanie.

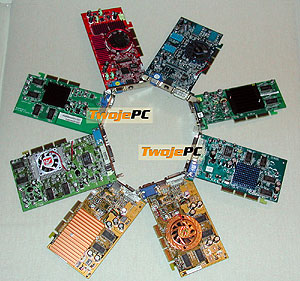

Karty

Dzięki uprzejmości firmy Sirius www.sirius.pl udało mi się zgromadzić zestaw kart na tyle kompletny, że niniejsza recenzja FX5200 staje się faktycznym przeglądem aktualnie dostępnych układów graficznych Dx8 i Dx9 z przedziału cenowego 250-400 zł. Niestety "wielkim" nieobecnym będzie Radeon 9100/8500LE. Przynajmniej w części opisowej i dotyczącej podkręcania. Te karty występują w "przyrodzie" w ilościach śladowych i pożyczenie jednej do testów nie jest już proste. W końcu udało mi się złapać SuperGrace'a VIVO w wersji 230/200MHz z uszkodzonym wentylatorem, który przetestowałem po podkręceniu do 250/230MHz chłodząc zewnętrznym wiatrakiem (takie taktowanie miał np. Sapphire R9100 64MB). W zasadzie powinienem odpuścić testy tego układu z uwagi na braki w sklepach, ale skoro obiecałem, że wystąpi w porównaniu to jego wyniki zasilą tabele wydajności. W związku z tym, że podstawowym zadaniem tej recenzji jest globalne pozycjonowanie układów a element porównawczy konkretnych modeli kart ma charakter jedynie pomocniczy to proszę wybaczyć moje parcie w kierunku maksymalnego skrócenia części opisowej. Najchętniej zamieniłbym ją na prostą tabelkę wyposażenia i ocen punktowych wybranych parametrów użytkowych. Może w kolejnym artykule opartym na większej ilości egzemplarzy testowych zdecyduję się na taką kompilację. Czas na przedstawienie bohaterów recenzji. Kolejność alfabetyczna.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Asus V9520 Magic/T

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Średniej wielkości pudełko z grubej tektury w barwach Asusa z czymś, co dla mnie jest puszczającym mechaniczne oko robotem. Pewnie kwestia interpretacji. Wnętrze kryje kartę FX5200 128MB oraz:

- CD ze sterownikami (Detonator v44.03) oraz oprogramowaniem narzędziowym.

- Pokaźna instrukcja instalacji karty i sterownika. Niestety grubość wynika z użycia 13 języków. Na szczęście jest wśród nich nasz rodzimy (8 stron).

Niskoprofilowa karta oparta na zielonym laminacie. Pasywne chłodzenie zapewnia czarny, gęsto żebrowany radiator zamocowany na kołkach. 128MB pamięci DDR Infineon 6ns w czterech modułach (po dwa z każdej strony). Na śledziu wyjście VGA oraz dwa wyjścia TV w standardach S-Video i Composite (miniDIN i Cinch).

Oczywiście słodka dla ucha, „pasywna” cisza. Taktowanie rdzenia 250MHz. Taktowanie pamięci 166MHz, czyli znacznie poniżej standardu. Mało tego. Pomimo, że nigdzie tego nie napisano to pamięci oparte są na szynie 64-bitowej. Niestety to nie może dobrze rokować w kwestii wydajności. Natomiast w kwestii jakości obrazu Asus nie zawiódł. Wprawdzie w tym względzie układ NV34 nie może poszczycić się możliwościami takimi jak droższe mutacje FX’ów, ale na pewno nie ustępuje markowym kartom GF4Ti. Karta generowała najlepszy obraz wśród biorących udział w teście kart opartych na układach nVidia i jedynie Radeony były w stanie ją pokonać. Należy jednak pamiętać, że aby właściwie wykorzystać tą przewagę trzeba dysponować monitorem z ergonomicznym trybem na pulpicie w klasie od 1280x1024 @ 85Hz. Kartę udało mi się podkręcić do wartości 270/215MHz.

Produkt dostępny jest w sklepie Sirius za 373 zł wraz z 3-letnią gwarancją.

Gainward GF3 PowerPack! Ti/450 TV "GS"

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Spore pudełko, z którego patrzy na nas jakby nieco zagubiony łysy osobnik. Ze środka oprócz karty GF3Ti200 wyjąłem:

- Obszerna instrukcja instalacji oraz użytkowania karty wraz z opisem ustawień sterownika. Całość w języku polskim (40 stron). Brawo.

- Przejściówka miniDIN-Cinch

- CD z programowym odtwarzaczem InterVideo WinDVD 4

- Instrukcja instalacji i użytkowania w języku angielskim

- CD ze sterownikami (Detonator v28.32) oraz oprogramowaniem narzędziowym

- 2x CD z pełną wersją gry Chrome (język polski)

Największa karta wśród testowanych. Czerwony laminat. Bliżej nieznane pamięci (wg. dystrybutora 3.5ns) szczelnie zakryte niewielkimi radiatorami występują tylko na awersie. Orbopodobne chłodzenie zamocowane na kołkach. Na śledziu wyjście VGA oraz TV-Out (miniDIN 4-piny). Wyjście telewizyjne zasila układ Philips SAA7104E.

Karta taktowana jest częstotliwościami 200/225MHz (rdzeń, pamięć), czyli powyżej oficjalnej specyfikacji nVidia dla GF3Ti200. Dodatek „Golden Sample” w nazwie modelu jest więc uzasadniony. Wentylator dosyć głośny, ale muszę przyznać, że mniej dokuczliwy od egzemplarza tej samej karty, który kiedyś testowałem. Tak czy inaczej odradzam maniakom ciszy. Obraz, choć jeden z najlepszych wśród GF3, to jednak ustępuje nowym produktom. Wśród zestawu testowego jeden z najsłabszych. Pewne „rozmydlenie” pojawia dosyć szybko, choć po przyzwyczajeniu da się oswoić w 1280x1024 @ 75Hz. Powyżej podstawowej klasy 19-stki lub może nawet dla topowej 17-stki raczej szukałbym innego rozwiązania. Kartę udało mi się podkręcić do 240/260MHz.

Produkt dostępny w sklepie Sirius za 364 zł. Gwarancja 3-lata w systemie S.O.S. (serwis odbiera sprzęt).

HIS Radeon 9200 64MB VIVO

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Spore pudełko w ładnej kolorystyce z motywem przewodnim w postaci miecza (Excalibur). W środku oprócz karty znalazłem:

- CD ze sterownikami (Catalyst 3.6)

- CD z programowym odtwarzaczem CyberLink PowerDVD XP 4.0

- CD z programem do edycji filmów CyberLink PowerDirector Pro 2.5 VE

- CD z grą Ballistics

- Niewielka instrukcja instalacji karty i sterownika w trzech językach. Niestety bez polskiego.

- Przejściówka DVI-VGA

- Kabel S-Video. Przyzwoitej jakości.

- Rozgałęźnik VIVO. Wejście i wyjście wizyjne zarówno w standardzie Cinch (Composite) jak i miniDIN (S-Video)

Niebieski laminat. 64MB pamięci DDR Hynix 3.6ns w ośmiu kostkach rozmieszczonych po obu stronach płytki. Niebieski radiator ze sporym ożebrowaniem zamocowany na kołkach. Na śledziu VGA, TV-In/Out (miniDIN 9-pinów) oraz DVI. Funkcję capture zapewnia układ ATI Rage Theater.

Oczywiście cisza typowa dla rozwiązań pasywnie chłodzonych. Bardzo dobra jakość obrazu. Nie ma wątpliwości, że lepsza od dowolnej karty konkurencji ze stajni nVidia wśród występujących w teście. 1280x1024@100Hz nie stanowiło problemu choć możliwe, że dla tego trybu już bym się rozglądał za czymś innym. Praktycznie większość 19-calówek powinna polubić tą kartę. Taktowanie zgodne z specyfikacją ATI, czyli 250/200MHz (rdzeń/pamięć). Kartę udało się podkręcić do wartości 290/230MHz.

Produkt dostępny w sklepie Sirius za 366 zł. 2-lata gwarancji.

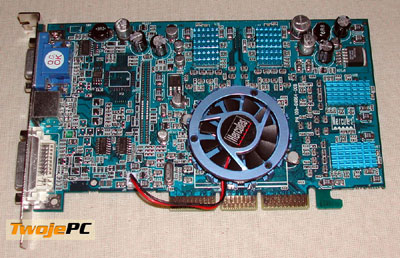

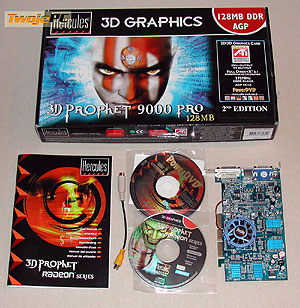

Hercules 3D Prophet 9000 Pro 128MB

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Typowe, duże pudełko Herculesa z jakimś wkurzonym kibicem w barwach meczowych. W środku oprócz karty:

- Pokaźna instrukcja instalacji i użytkowania karty. Grubość wynika z siedmiu języków. Niestety bez polskiego.

- Przejściówka miniDIN-Cinch

- CD ze sterownikami (Catalyst 3.0) oraz oprogramowaniem narzędziowym (w tym tweaker do podkręcania)

- CD z programowym odtwarzaczem CyberLink PowerDVD XP 4.0 w wersji 2-kanałowej.

Niebieski laminat. 128MB bliżej nieznanej pamięci DDR w ośmiu kostkach przykrytych radiatorami rozmieszczonymi po obu stronach płytki. Oczywiście w kolorze niebieskim. Orbopodobne (również niebieskie) chłodzenie mocowane na kołkach. Na śledziu złącza VGA, TV-Out (miniDIN 7-pinów) oraz DVI.

Wentylator po włączeniu komputera wydaje się bardzo cichy, ale po wygrzaniu jego odgłos jakby przybierał na sile. Nadal hałas niewielki, ale wdziera się dosyć nieprzyjemny ton. Przynajmniej ja go słyszę. Tym nie mniej należał do cichszych wśród testowanych kart. Jakość obrazu znakomita. Najlepsza z wszystkich kart biorących udział w porównaniu. Zaczynał lekko „puchnąć” dopiero >1280x1024@100Hz i wcale nie twierdzę, że nie mógłbym się przyzwyczaić i do wyższych trybów. W każdym razie, jeśli miałbym dobierać kartę do 1600x1200@85Hz to wśród zestawu testowego Hercules najlepiej by się do tego nadawał. Na pudełku nalepiono znaczek z napisem "druga edycja". Stąd pewnie taktowanie 275/250MHz. Pierwsze wersje były zgodne z zaleceniami referencyjnymi ATI (275/275MHz). Karta dała się podkręcić do 330/275MHz.

W sklepie Sirius wersja OEM dostępna jest za 349 zł. Gwarancja 3-lata.

Prolink PixelView GeForceFX 5200 128MB Ultimate

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Niewielkie pudełko w barwach Prolinka z wizerunkiem rusałki znanej z demonstracji nVidia opisane w języku polskim. W środku oprócz karty:

- CD ze sterownikami (Detonator v44.03)

- Krótka (8 stron) instrukcja instalacji karty i sterownika w języku polskim

- Przejściówka miniDIN-Cinch

- Kabel Cinch-Cinch. Jakość podstawowa.

Żółty laminat. Duże, orbopodobne chłodzenie mocowane na kołkach. 128MB pamięci Samsung 4ns w ośmiu modułach po obu stronach płytki. Na śledziu złącza VGA, TV-out (miniDIN 4-piny) oraz DVI.

Wentylator dosyć cichy. Jak dla mnie odgłos całkowicie akceptowalny. Obraz generowany na monitorze poprawny, choć ustępujący zarówno Radeonom jak i Asusowi. Może ciut lepszy od GF3 Gainwarda, choć nie do końca jestem o tym przekonany. Również potrzebowałem pewnej asymilacji nawet w stosunkowo niskich trybach. 17-sto calowy analog to chyba najlepszy obszar współpracy. Ewentualnie tańsze 19-stki. Można pracować i z lepszym wyświetlaczem, ale moim zdaniem nie będzie to już idealne dopasowanie. Karta taktowana jest domyślnie częstotliwościami 250/250MHz, czyli w stosunku do referencyjnych konstrukcji podniesiono zegar pamięci. Stąd w nazwie słowo Ultimate. Kartę udało się podkręcić do 350/305MHz.

W sklepie Sirius produkt dostępny jest za 365 zł. Gwarancja 2-lata.

Prolink PixelView GeForceFX 5200 64MB

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Takie same pudełko jak dla karty Ultimate zawierało oprócz karty:

- CD ze sterownikami (Detonator v44.03)

- Krótka (8 stron) instrukcja instalacji karty i sterownika w języku polskim

- Przejściówka miniDIN-Cinch

- Kabel Cinch-Cinch. Jakość podstawowa.

Karta różni się od wersji Ultimate pamięciami oraz chłodzeniem. Zastosowano sam radiator. Duży, asymetrycznie mocowany kawał blachy przytwierdzony do laminatu dwoma kołkami. Muszę przyznać, że nie zrobił najlepszego wrażenia. Przy lekkim ściśnięciu za brzeg (np. przy zakładaniu), odlepia się od rdzenia. Na śledziu podobnie jak w wersji Ultimate złącze VGA, TV-Out oraz DVI. Pamięć w ośmiu, rozmieszczonych po obu stronach płytki pamięciach Samsung 4ns ma łączną pojemność 64MB.

Cisza pasywnego chłodzenia. Jakość niemal bliźniacza w stosunku do odmiany Ultimate tego samego producenta. Generalnie było najsłabiej wśród zestawu testowego. Na początku wydawało mi się, że obraz jest minimalnie słabszy od wersji wyżej taktowanej oraz GF3 Gainwarda, ale różnica jest na tyle mała, że może być związana z konkretnym egzemplarzem. Tym nie mniej oczywiście nie ma problemu ze współpracą ze średniej klasy 17-stką czy nawet czymś nieco lepszym, jeśli ktoś nie jest przewrażliwiony w tym zakresie. Taktowanie domyślne 250/250MHz. Niestety wbrew opisowi na pudełku pamięć działa na szynie 64-bity. Kartę udało się podkręcić do wartości 260/315MHz.

W sklepie Sirius produkt dostępny jest za 300 zł. Gwarancja 2-lata.

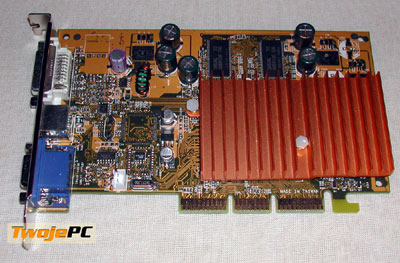

Sapphire Radeon 9000 64MB TV Bulk

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Karta zapakowana w sam worek foliowy wraz z:

- CD ze sterownikami (Catalyst 3.6)

- Przejściówka miniDIN-Cinch

Małe zaskoczenie. Po raz pierwszy spotkałem się z faktem sprzedaży od nazwą Sapphire karty, która nie wyszła z ich fabryki. Jest to produkt OEM wyprodukowany przez Asusa jeszcze w czasie, kiedy oficjalnie nie przyznawali się do wykorzystywania układów ATI. Słyszałem wcześniej o tych kartach, ale dopiero teraz mam okazję przyjrzeć im się bliżej. Zielony laminat. Osiem kostek Mosel Vitelic 4ns rozmieszczonych po obu stronach płytki. Czarny, dobrze ożebrowany radiator mocowany na kołkach nie dawał się poruszyć nawet o 1mm. Prawdopodobnie zastosowano dodatkowo klej. Na śledziu wyjścia VGA oraz TV-Out (miniDIN 7-pinów).

Pasywne chłodzenie oczywiście oznacza ciszę w czasie pracy. Obraz bardzo dobry, choć moim zdaniem minimalnie ustępujący Szafirom a tym bardziej Herculesowi. Sądzę, że zbliżony do HIS'a i na pewno znacząco lepszy niż w dowolnym FX5200 z testowanych. Większość 19-stek powinno prawidłowo zgrać się z jakością karty, ale powyżej tego poziomu już bym nie wychodził bez własnych testów. W końcu każdy ma swoje preferencje. Wprawdzie pamięci działały na szynie 128-bitowej, ale taktowanie karty ustawione było znacznie poniżej oczekiwań: 230/183MHz. Podkręcenie dało rezultat 235/195MHz. Prawdę mówiąc trudno to w ogóle nazwać podkręceniem.

Karta jest dostępna w sklepie Sirius za 266 zł. Gwarancja 2-lata.

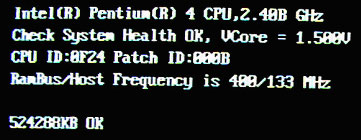

Sterowniki

Do przeprowadzenia testów używam tego samego zestawu komputerowego, którego trzon stanowi P4 2.4/533, 512MB PC800, GA-8IHXP, Windows XP SP1. Karty ATI działały na sterownikach Catalyst 3.8. W przypadku nVidia były to Detonator 52.13 (Beta) oraz 52.16 (WHQL). Ustawienia sterowników domyślne + wyłączenie VSynch.

W stosunku do starszych driverów nVidia serii 4x.xx odnotowałem konkretne różnice. W kwestii funkcjonalnej zmienił się układ zakładek, wprowadzono profilowanie, w pełni zintegrowano z nView. Co do zmian wydajności to uczucia mam mieszane. Największym sukcesem jest niewątpliwie zwiększenie szybkości działania Pixel Shadera 2.0 o ok. 20%. Biorąc pod uwagę różnice w stosunku do nowych Radeonów nie jest to element, który może wpłynąć na zmianę mojej opinii w kwestii FX5600 ale jest to wyraźna poprawa. Oprócz tego sterowniki te wprowadzają szereg dedykowanych optymalizacji na poziomie konkretnych aplikacji wykorzystujących funkcjonalność Dx9 oraz poprawki kilku drobniejszych błędów czy niekompatybilności. W związku z tym, że jedynym uniwersalnym "pewniakiem" jest ta 20-procentowa globalna poprawa działania shaderów to niektórzy mogą czuć się zawiedzeni, bo oczekiwania były znacznie większe. Innym może się wydawać, że poprawa wydajności sięga znacznie wyżej w uwagi na to, że "trafia" w niektóre gry i programy, które zwykle wykorzystuje się do testów 3D. W kilku przypadkach odnotowałem również pewne różnice w obrazie. Niestety należy liczyć się z tym, że w przypadku każdej gry Dx9 potrzebne będzie indywidualne wsparcie sterownika z uwagi na odmienność schematu działania hardware w stosunku do API.

Jeśli chodzi o nowe sterowniki ATI to oprócz pewnych zmian funkcjonalnych najciekawszym dodatkiem wydaje się VPU Recover. Funkcja jest zgodna z nowym zaleceniem MS, które będzie obowiązywało w przyszłym systemie, polegająca na resetowaniu przez sterownik hardware, który przestaje odpowiadać na jego zapytania. Dzięki temu w przypadku Catalyst 3.8, w żadnej sytuacji nie następuje zawieszenie całego peceta z winy samej karty graficznej. W kwestii wydajności większych różnic nie odnotowałem. Oczywiście przy okazji nowego "numerka" wyeliminowano kilka mniejszych błędów i niekompatybilności z oprogramowaniem. Dla niektórych użytkowników zespolenie w jedną zakładkę ustawień 3D oraz wprowadzenie dodatkowego przycisku dla zaawansowanych parametrów wydaje się sprawiać więcej problemów, ale po przyzwyczajeniu się i dzięki wprowadzeniu profili ustawień poprawa ergonomii wydaje się namacalna.

Testy cz. I - Serious Sam, CodeCreatures, Gun Metal 2

Zanim przejdę do wyników testów poszczególnych kart, które wezmą udział w porównaniu chciałbym przedstawić kilka informacji o charakterze bardziej ogólnym. Pierwsza kwestia dotyczy sprawy taktowania. W przypadku najtańszych kart producent niejednokrotnie sam opracowuje schemat laminatu karty oraz wprowadza pewną dowolność w doborze zarówno układów pamięci jak i systemu chłodzenia rdzenia. Rezultatem tych działań jest odejście od referencyjnych częstotliwości pracy karty. Oczywiście ma to bezpośredni wpływ na wyniki, jakie osiąga dany egzemplarz w testach. Jak już wiemy z części opisowej niemal wszyscy uczestnicy testu wykazywali w tym zakresie sporą niezależność. W związku z powyższym karty potraktowałem niezależnie a dodatkowo w tabelach uwzględniłem FX5200 z taktowaniem referencyjnym uzyskanym przez obniżenie częstotliwości pracy pamięci w modelu Ultimate Prolinka. Aby nie zaciemniać obrazu wydajności do porównań użyłem tylko wybranych przedstawicieli "gatunków".

Do porównania wydajności kart użyłem takiego samego zestawu testów, jakim potraktowałem karty FX5600/R9600 w poprzednim artykule. Dzięki temu możliwe jest bezpośrednie porównanie kart biorących udział w obydwu opracowaniach. Jeśli będzie zapotrzebowanie czytelników na zbiorcze wykresy będące kompilacją tych recenzji to postaram się je przygotować.

Stosunkowo niskie bezwzględne wartości średnich fps w testach nie powinny nikogo dziwić, bo użyłem tych samych nowych programów i maksymalnych dla jakości ustawień eliminujących wpływ procesora, które w założeniach "katować" miały mocniejsze karty a co dopiero najniższy segment rynku. W czasie realnej gry każdy dobierze sobie takie ustawienia, aby otrzymać płynność ruchu obiektów. Oczywiście kosztem jakości wyświetlanego obrazu. Czas przejść do konkretów.

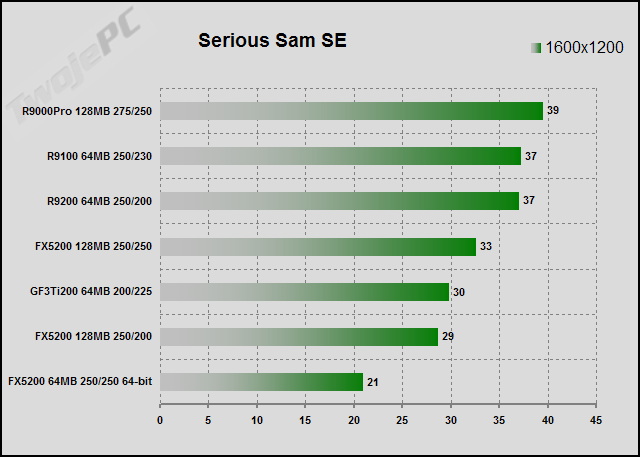

Serious Sam SE

Serious Sam SE. Gra wykorzystuje zarówno porty OpenGL jak i Direct3D, ale test dotyczy tylko OpenGL, na którym z resztą gra działa lepiej. W opcjach gry włączyłem zbiorcze ustawienie Quality a zliczaniem fps zajmuje się sama gra po komendzie konsoli: „/dem_bprofile=1”. Karty potraktowałem oryginalnym demem „The Grand Cathedral”. W nawiasach zawarłem wartości minimalne fps. Gra wprowadza dedykowane optymalizacje, oddzielne dla Radeonów, GeForce oraz specjalną dla GeForce3. W związku z tym, że generowany obraz różni się w zależności od użytej karty (np. GeForce ma w każdym teście niższy stopień filtrowania anizotropowego) to wyniki nie są do końca porównywalne. W 1024x768 w zasadzie nic się nie dzieje. Wynik opiera się na wydajności procesora oraz optymalizacji sterowników. Jedynie FX5200 z 64-bitową szyną odstaje od pozostałych. Podstawą porównań był dla mnie tryb 1600x1200. Oczywiście w znacznym stopniu związany z przepustowością szyny pamięci. Na prowadzeniu Radeony, choć różnice do kart nVidia nie są miażdżące. Oprócz "nieszczęsnego" 64-bitowca. Po dodaniu FSAA "odskakuje" najmocniejszy FX oraz GF3. Pozostałe karty działają podobnie. Z małym wyjątkiem. Wiadomo jakim. Moim zdaniem test nie wskazuje jednoznacznych zwycięzców natomiast niewątpliwie jest jeden pokonany.

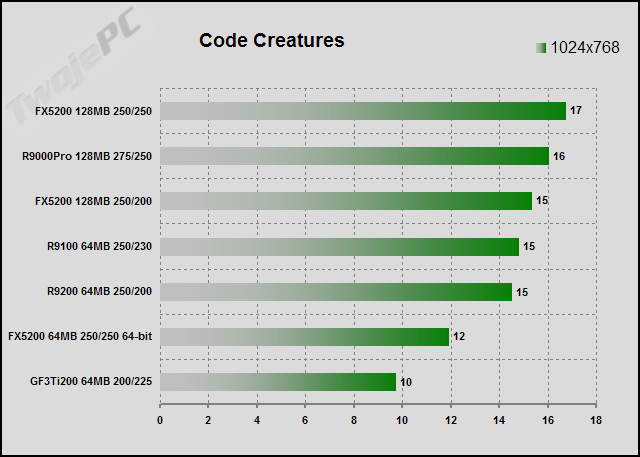

CodeCreatures

Zabójczy test CodeCreatures (Dx8). Jest to w zasadzie benchmark syntetyczny i testujący niewiele ma do zrobienia poza uruchomieniem dema i spisaniem wyników. W ustawieniach wyłączam jedynie dźwięk i podaję wymaganą rozdzielczość. Choć optymalizowany dla nVidia (również sterownik podstawia własny shader) nigdy nie waham się go użyć. Test preferuje karty 128MB i nie można wyników porównywać z wersjami 64MB. Liczby opierają się głównie na Fill Rate, i moim zdaniem nikt specjalnie się nie wyróżnia. No może oprócz GF3 i FX5200SE, które nie jest w stanie sprostać konkurentom. Również i w tym wypadku żadna z pozostałych kart nie może się pochwalić spektakularnym zwycięstwem. Jeszcze raz zwracam uwagę na poprawkę na wielkość pamięci lokalnej testowanych kart.

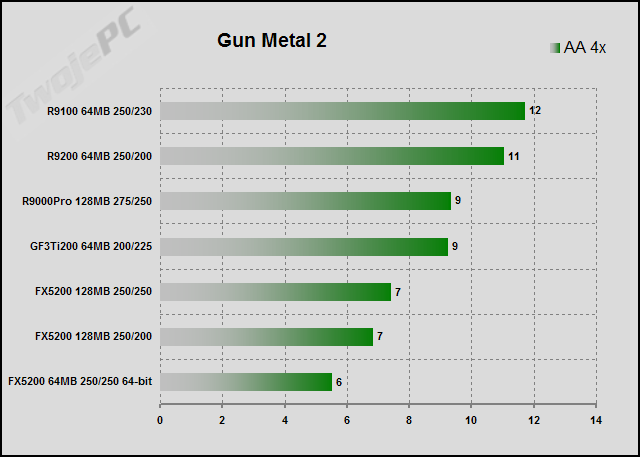

Gun Metal 2 Benchmark

Gun Metal 2 Benchmark. Dedykowany program testowy powstały na silniku tej gry. Z bliżej nieznanych mi przyczyn również proklamowany przez nVidia na jeden z ich oficjalnych testów wydajności. Teoretycznie nie da się go przeprowadzić bez włączonego antyaliasingu, choć oczywiście sterownik ma w tym względzie decydujący głos. Ustawienia FSAA w grze nie zawsze dobrze współgrały z driverami i w przypadku Radeonów bezpieczniej jest wymuszać je w zakładce sterownika. W końcu mamy test, który zróżnicował karty pod względem wydajności. Gra intensywnie wykorzystuje Vertex Shader 2.0. W nawiasach wartości minimalne fps. Demo działało na kartach testowych z zawziętością przesuszonego ślimaka. Między innymi problemem jest brak multisamplingu przy eliminacji „schodków”, choć to pewnie nie jest jedyna z przyczyn. Zwycięzcą testu zostaje Radeon 9100, choć o dziwo, po piętach depcze mu „poczciwina” 9200 zostawiając w tyle wersję Pro wraz z GF3. Niezbadane są wyroki sterowników. Podejrzewam jakąś „optymalizację” ATI, choć obraz wygląda normalnie. Dalsze miejsca okupują FX'y z SE na końcu. Ten benchmark jakoś wybitnie im nie pasuje pomimo, że nVidia zapewniła im niezłe turbodoładowanie zmniejszając jakość detali podłoża. Trudno tego nie zauważyć. Mam nadzieję, że wytłumaczyłem dobrze, dlaczego nie lubię dedykowanych programów testujących lub tzw. „uznanych benchmarków”. Bagno.

ATI NVIDIA

Testy cz. II - X2, Sprinter Cell, UT 2003

X2 - The Threat

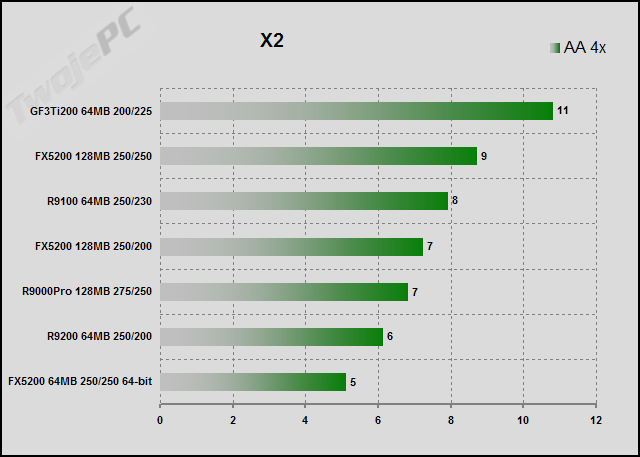

X2 - The Threat. Zapowiedź przyszłej gry Dx9 w postaci testu fps. Podobnie jak przy Gun Metal2 bez efektów Pixel Shadera 2.0. W stosunku do ustawień domyślnych włączyłem jedynie cienie. Ich realizacja dokonana jest technikami stencil shadow, ale tylko FX’y wywodzące się z NV35 mogą w tym względzie zabłysnąć, więc 5200 „męczył się” na równi z innymi. W ustawieniach testu dostępna jest opcja FSAA, ale oznacza tryb 2x wobec czego wolałem jej nie ruszać a w zakładkach sterownika wymusić 4x. Niby punktowo wygrał GF3Ti200, ale niestety wyniki niewiele dają, bo w tych ustawieniach wszystkie testowane karty padły na kolana. Niby dwukrotna różnica wyników pomiędzy najsłabszym a najmocniejszym, ale z drugiej strony to tylko 6 fps. Masakra. Znowu obraz generowany przez karty z układami ATI wygląda lepiej. Co ciekawe w tej grze wyraźnie widać różnice w jakości kolorów. Kiedyś o tym wspominałem, ale niedowiarkom proponuję porównanie właśnie przy wykorzystaniu tego testu. Niestety nie można tego powiedzieć o jakości filtrowania schodków. Na wszystkich testowanych kartach była daleka od „doskonałości”, którą moim zdaniem, na dzień dzisiejszy dają w tej grze tylko karty z układem R(V)3xx.

Sprinter Cell

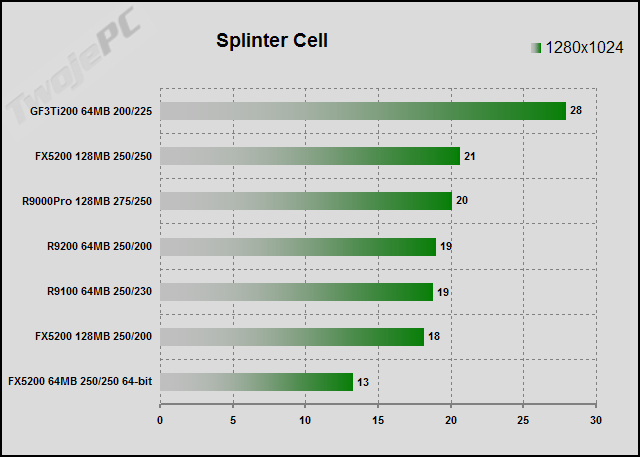

Sprinter Cell. Nowa gra na silniku Epic’a (Unreal), ciekawe efekty, tryb testowy dostępny w najnowszym patch. Wystarczy ustawić grę na najlepszą jakość obrazu i odpalić jeden z plików „*.bat” uruchamiających benchmarki. Wyniki pojawiają się w oddzielnym pliku arkusza kalkulacyjnego. Wziąłem pierwsze alfabetycznie „TbilisiDemo”. Ważne jest, aby odpowiednio wyrównać poziomy realizacji cieni poprzez ręczną modyfikację pliku konfiguracyjnego (ustaliłem: „Class 1 Hardware”). W nawiasie minimalny poziom fps. W tej grze w końcu GF3Ti pokazał prawdziwe, ostre pazury. Tak jakby była pisana dla niego. Wyraźna przewaga. Reszta niczym specjalnym się nie wyróżniła. Oprócz FX SE, który jak zwykle wlecze się na końcu stawki.

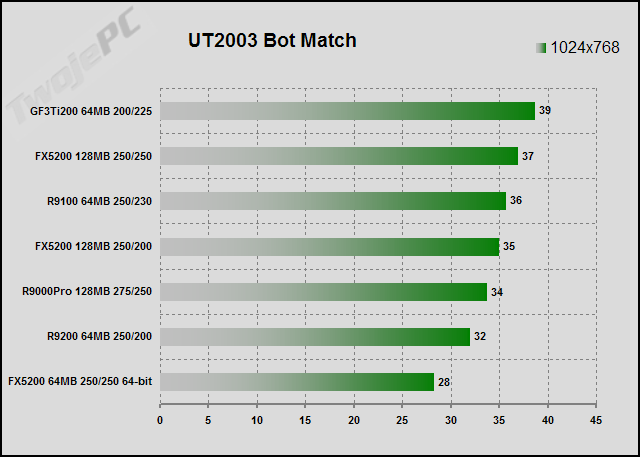

Unreal Tournament 2003

Unreal Tournament 2003. Botmatch. Trochę niebezpieczny test, bo trzeba brać poprawkę na różne "optymalizacje". Jest to jeden z ulubionych benchmarków, wręcz przymus, co od razu wzbudza niezdrowe zainteresowanie producentów. Z lenistwa użyłem jednego ze spec narzędzi stworzonych przez niezależnych programistów, aby pomóc umęczonym testerom. Oczywiście programik odwołuje się bezpośrednio do procedur zawartych w samej grze i głównie pilnuje niezmienności plików konfiguracyjnych oraz ustala parametry obrazu. Test wykonany został w oparciu o dosyć wymagającą mapę Antalus. Dźwięk wyłączony. W 1024x768 zwyciężył GF3, ale zróżnicowanie wyników nie jest duże i co ważniejsze nie do końca pokrywają się one z moimi odczuciami w czasie samej gry. Do obrazu też można i pewnie należy się czepiać. Jakość filtrowania anizotropowego nVidia słabiutka a FSAA w wydaniu ATI wygląda tak jakby nie istniał, choć zżera sporą część mocy. W ogóle testu Anizo/Fsaa sugeruję nie brać pod uwagę. W zasadzie powinienem przejść na porównania w Unreal2, bo moim zdaniem wyniki są wtedy bardziej wiarygodne.

Testy cz. III - Moto GP2, Chameleon, AquaMark 3

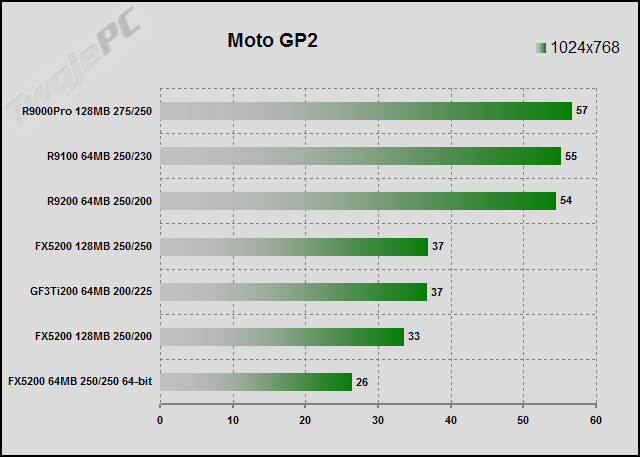

Moto GP2

Moto GP2. Jedna z moich ulubionych "motocyklówek". Znakomity, realistyczny obraz. Zachowanie pojazdów może nie spodobałoby się purystom od GP500, ale jak dla mnie gra jest topowa. Na nowych sterownikach nVidia tym razem również posiadacze FX mogą cieszyć się kompletem efektów 3D (w ostatniej recenzji narzekałem na brak jednego). Aby jednak wyniki były porównywalne z poprzednimi to wyłączyłem go na wszystkich testowanych kartach. Pozostałe ustawienia na najwyższą jakość obrazu. Do przeprowadzenia benchmarka użyłem programu Fraps. W nawiasie wartości minimalne fps. Testy potwierdzają odczucia grającego. Ta gra zdecydowanie preferuje Radeony. Dopiero po nich plasuje się FX Ultimate oraz GF3. Stawkę zamykają pozostałe karty FX z mocno sponiewieraną wersją SE.

Chameleon Mark

Chameleon Mark. Test wydajności Pixel Shader 1.1 przygotowany przez nVidia. Do porównania wykorzystałem model „Shiny”. W zasadzie wyniki nie są zbyt mocno „rozstrzelone”, ale o dziwo zdecydowanie słabiej wypada Radeon 9100. Niestety w wyniku błędu sterowników obraz na wszystkich kartach ATI wyświetlany był źle i bezpieczniej jest wykluczyć ten test z porównań. Błąd powinien być poprawiony w kolejnej wersji Catalyst.

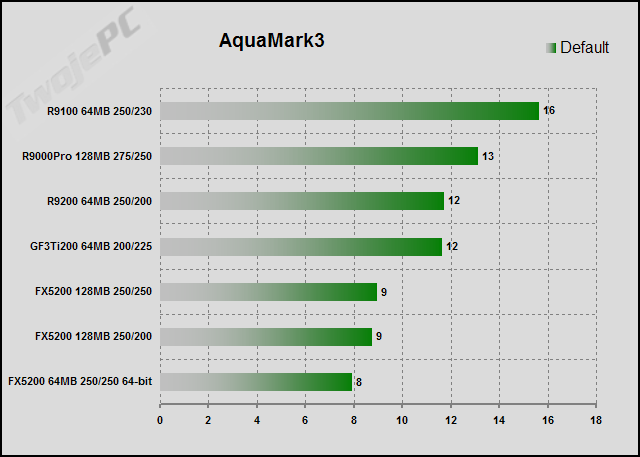

AquaMark 3

AquaMark 3. Jeden z najnowszych dedykowanych, syntetycznych testów Dx9. Łatwy do przeprowadzenia, pozornie prosty w interpretacji. Strach przed „optymalizacją” jest u mnie niemal namacalny. Taki benchmark musi przyciągać zainteresowanie producentów kart. Nic to. Nie będę wybrzydzał. Benchmark używa tylko kilkunastu shaderów 2.0 ale łączna ich liczba jest dosyć pokaźna. Tym razem zwycięża R9100 z konkretną przewagą. Po nim R9000Pro, R9200 i GF3. Na końcu karty FX. Nieco dziwi słabe zachowanie najnowszych kart nVidia. Czyżby straciły na tym, że mogą zostać zmuszone do realizacji nowych efektów Dx9? Przy następnych porównaniach spróbuję zgłębić ten temat.

Testy cz. IV - Final Fantasy, Halo, Tomb Raider, HL2

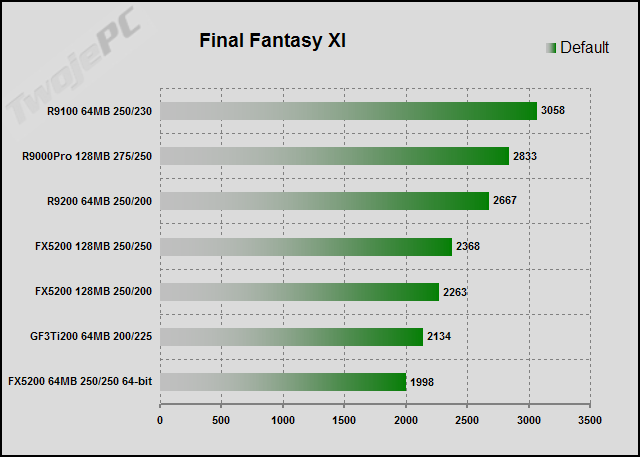

Final Fantasy

Oficjalny benchmark najnowszej gry z serii Final Fantasy. Uruchamiam, ustawiam podstawowe parametry, wciskam przycisk „startowy”. W dolnym rogu ekranu ukazuje się licznik. Zapamiętuję ostatnią wartość przed zakończeniem dema. Trochę dziwne, ale taka jest zasada pomiaru. To nie jest mój ulubiony gatunek gier, ale w sam raz chciałem wykazać się pewną elastycznością w zakresie doboru nowych testów. Znowu na pierwszym miejscu Radeon 9100. Drugi jest R9000Pro a trzeci R9200. Potem FX'y zaraz przed GF3. Stawkę zamyka FX z szyną 64-bitową. Generalnie mogę uznać zwycięstwo Radeonów. Proszę jednak pamiętać, że to tylko liczby.

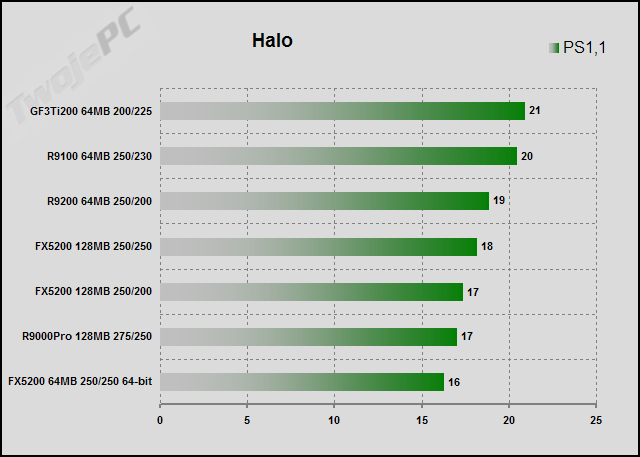

Halo

Halo. Jedna z najnowszych gier Dx9. Zawarty w grze benchmark umożliwia wymuszenie wersji Pixel Shader. Test przeprowadziłem w trybie 1024x768. Można więc porównywać różne karty oraz ocenić najlepszy tryb dla danego układu. Przy PS1.1 wielkich różnic nie ma. Na prowadzeniu GF3 i R9100. PS1.4 (Dx8.1) zdecydowanie lepiej działa na kartach ATI niż na FX’ach (GF3 nie ma obsługi tej wersji PS). Komplet efektów mogą zobaczyć jedynie posiadacze kart FX, ale trzeba przyznać, że we wszystkich trybach gra chodzi dosyć ospale. Niezbędne są ograniczenia rozdzielczości i efektów. To chyba nie tylko moje zdanie, ale sądzę, że Microsoft mógłby się nieco lepiej przyłożyć do tej produkcji. Również na jednej z map daje się zauważyć błąd wyświetlania tła na kartach Radeon. Jednak poziom kompatybilności nowszych konstrukcji ATI jest znacznie lepszy niż starszej generacji. W poprzednim teście, w którym występowały Radeony 9600 nie było żadnych problemów z obrazem.

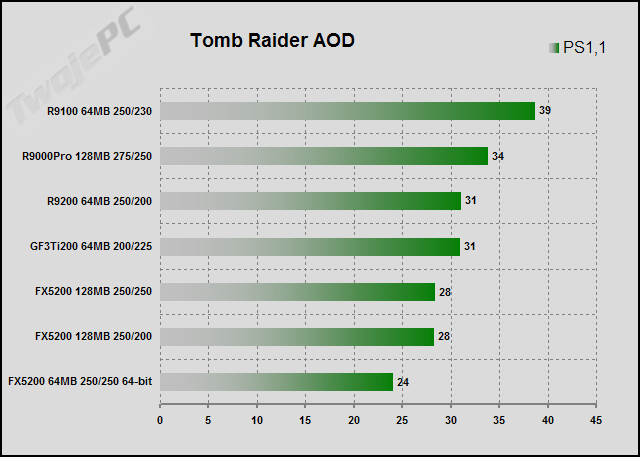

Tomb Raider

Tomb Raider: Angel of Darkness. Kolejna gra Dx9 wykorzystująca nowy Pixel Shader 2.0. Benchmark jest możliwy dzięki odpowiedniej funkcji wbudowanej w patch 49. Niestety łatka krótko cieszyła się radością oficjalnego pobytu w Internecie, bo ponoć na skutek interwencji nVidia (jeden ze sponsorów gry) została „zdjęta”. Teraz pojawił się patch 52, który w zasadzie nic nie wnosi nowego oprócz skasowania możliwości robienia porównań. Aby sprowadzić wszystkie karty do wspólnego "mianownika" musiałem wyłączyć jeden z efektów w stosunku do ustawień, które użyłem w poprzednim artykule a konkretnie, zmniejszyć poziom detali obiektów, bo gra przestała startować na starszych kartach ATI. Pozostałe ustawienia są wręcz mordercze dla układów. W zasadzie skopiowane zostały z ustawień „max quality” zaproponowanych przez serwis Beyond3D łącznie z filtrowaniem anizotropowym. Na prowadzeniu Radeon 9100, po nim Radeon 9000Pro a na trzecim miejscu R9200 wraz z GF3. Karty FX dopiero na końcu stawki. Dla zainteresowanych dodam, że w ustawieniach PS1.1 takich jak w teście 600-tek FX5200 Ultimate miał 22.5 fps a w PS2.0 9.5 fps. Oczywiście w przypadku tej gry, specyfikacja Dx9 pozostaje tylko pustym hasłem, bo spadek wydajności jest kolosalny.

HL2 Beta

Miałem również okazję przeprowadzić porównanie, o które prosiło wiele osób w listach. Daleka od doskonałości wersja HL2, która "wyciekła" do sieci. Test przeprowadzony nagranym przez Digit-Life demem Coast w trybie 1024x768. Radeony przed FX5200 i to ze sporą różnicą. Nie jest to wersja finalna, więc nie należy się nią specjalnie przejmować. Chyba jednak warto zwrócić uwagę na dwie rzeczy. Zdecydowanie wydajniejsze działania FX na porcie Dx8 niż Dx9 oraz stosunkowo wysoki poziom fps jak na karty z najniższej półki cenowej. Może niepotrzebnie niektórzy straszą właścicieli tańszych kart tą grą? Niestety tego dowiemy się dopiero w przyszłym roku. Na razie jest to tylko ciekawostka "przyrodnicza" i mam nadzieję, że jej upublicznienie nie skończy się dla mnie linczem.

Uczta numerologa

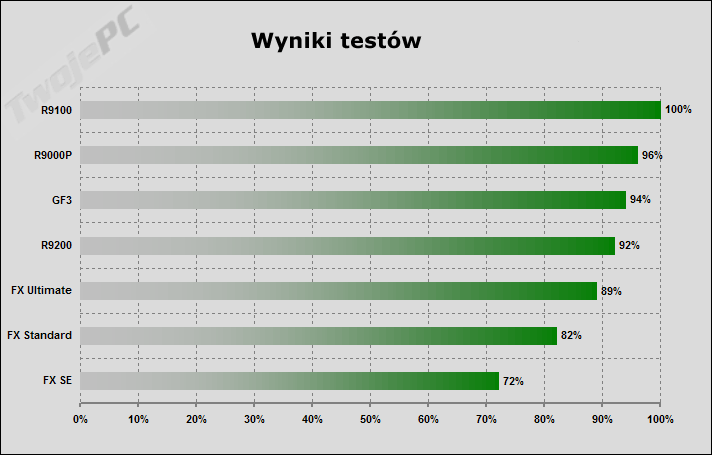

W celu zbiorczego podsumowania wyników proponuję zabawę z liczbami. Mam nadzieję, że wielbiciele przeróżnych punktacji powinni zostać w ten sposób zaspokojeni. W związku z tym, że w zależności od testu kolejność kart jest różna to postanowiłem wprowadzić dodatkową tabelę w celu łatwiejszej klasyfikacji wydajnościowej na podstawie uśrednionych wyników poszczególnych testów.

Jak powstała tabela? Wszystkie wyniki testów (oprócz Chameleon Mark, w którym Radeony wyświetlały błędne tło), które były poprzednio zobrazowane w postaci wykresów sprowadziłem do punktacji. Najlepszy wynik dostał 10 punktów a pozostałe odpowiednio mniej (w skali liniowej) przyjmując, że za teoretyczną średnią 0 fps należy się 1 punkt. Po zsumowaniu poszczególny punktacji za kolejne testy otrzymałem punktacje łączną. Końcowa wartość procentowa oznacza średni spadek wyników wszystkich testów w stosunku do najlepszej karty.

W ten sposób udało się wyznaczyć kolejność kart na "mecie" testów. Warto dodatkowo zwrócić uwagę na wielkość różnic. Przenosząc liczby testowe na realne odczucia w czasie gry mogę powiedzieć, że moim zdaniem do 10% mamy do czynienia z kartami o zbliżonych możliwościach uzyskania danych wyników. Konkretna zmiana pojawia się przy różnicach >15% a przy ok. 30% możemy już mówić o innej klasie kart. Wszystkich zainteresowanych zapraszam do "konsumpcji" liczb.

Jeśli czytający ten artykuł uznają eksperyment "tabelkowy" za przydatny, to będę go kontynuował w kolejnych testach, a na specjalne życzenie, mogę tabelę rozszerzyć o karty biorące udział w poprzednim teście (FX5600/R9600/GF4Ti).

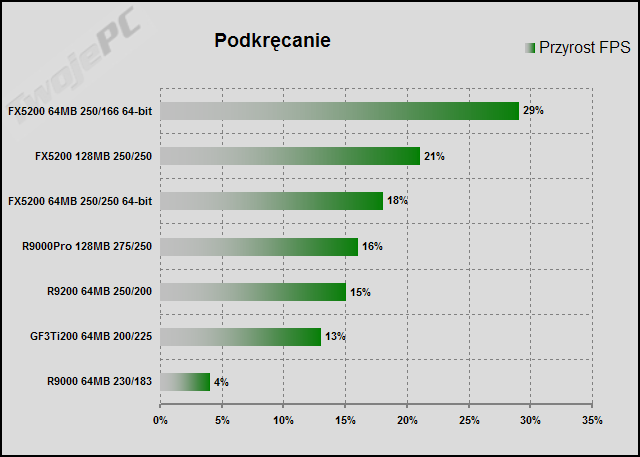

Podkręcanie

Oczywiście nie może zabraknąć porównania możliwości kart w zakresie nadtaktowania. Karty z układami nVidia podkręcałem korzystając z możliwości, jakie daje sam sterownik po odpowiednim wpisie do rejestrów (zmienna CoolBits) oprócz FX5200 64-bity Prolinka, w przypadku, którego skończyła się skala "suwaka" i musiałem użyć PowerStripa. Z Radeonami jest znacznie więcej problemów w tej kwestii. Podkręcaniem zajął się program RadClocker, ale przy kartach R9000 sprawa może być znacznie bardziej skomplikowana. Kiedyś w ogóle nie udało mi się tych kart podkręcić, ale czas zrobił swoje. Utrudnienia są w zasadzie dwa i ściśle zależą od konkretnego modelu. Jednym jest blokada podkręcania na poziomie sterownika a drugim częściowy brak zgodności z tweakerami. W pierwszym przypadku należy przed wgraniem sterowników potraktować plik ati2mtag.sys nowym skryptem ATIOverclockingAntiprotection RivaTunera a w drugim przypadku ustawić (zaawansowane opcje) w RadClocker skok taktowania na 3MHz. Oczywiście to dotyczy tylko niektórych kart, bo np. Hercules nie dosyć, że nie był w żaden sposób blokowany, to nawet producent załączył na CD odpowiedni program do podkręcania.

Do wyznaczenia średniego wzrostu fps po podkręceniu użyłem trzech, szczególnie podatnych testów. Sprinter Cell najlepiej wyznaczał graniczne wartości taktowania pamięci natomiast rdzeń doskonale obciążał nowy Tomb Raider. Dzięki nowej funkcji VPU Recover wprowadzonej do sterowników Catalyst 3.8 testowanie możliwości rdzenia było znacznie prostsze bo przy zbyt dużych wartościach taktowania układu nie następował zwis systemu tylko reset samej karty wraz z odpowiednim komunikatem. To może się podobać nałogowym podkręcaczom.

Końcową wartość zbiorczą możliwości nadtaktowania obliczyłem biorąc średnią z powyższych wzrostów testowych wartości fps. Tabela przedstawia się następująco:

Na prowadzeniu FX’y. Szczególnie model 64-bitowy Asusa zdeklasował wszystkich. Potem dopiero R9000Pro Herculesa oraz R9200 HIS’a. GF3Ti200 Gainwarda nieco rozczarował, bo kiedyś trafiłem na lepszy w tym zakresie egzemplarz. Nie wiem czy to kwestia trochę cichszego wentylatora czy gorszych pamięci, ale wśród zestawu testowego nie błyszczy. Na końcu Asus vel Sapphire, który w zasadzie w ogóle się nie podkręcił.

Podsumowanie

Zanim napisałem podsumowanie postanowiłem, z ciekawości, zerknąć na kilka grup dyskusyjnych, aby sprawdzić, które karty z tego zakresu cenowego polecają inni. Okazało się, że zdania były podzielone. Większość wskazuje na R9100 natomiast inni zarówno na GF3 jak i FX5200. Niewielu natomiast poleca R9000Pro. Przeprowadzone testy pokazują, że wszystkie te cztery karty mają podobną wydajność. Minimalnie mocniejsze okazały się Radeony 9100 i 9000Pro mimo, że w sam raz w teście występowały mutacje o obniżonej częstotliwości pamięci. GF3Ti uplasował się zaraz za nimi. Klasycznie taktowany FX5200 jest już słabszy, ale pomysł Prolinka z podniesieniem zegarów pamięci był strzałem w dziesiątkę i dzięki temu częściowo wyrównały się różnicę do konkurentów. I tu moim zdaniem jest główny problem z FX5200. Ultimate Prolinka ma dobry współczynnik cena/wydajność, ale czy w pewnym sensie karta ta nie jest osamotniona wśród całej rodziny tych produktów? Czy uda nam się znaleźć inne FX5200 128-bitów 250/250MHz w zbliżonej cenie? Obawiam się, że łatwo nie będzie.

W zależności od przeprowadzonego testu oczywiście może się okazać, że konkretna karta ma dużą przewagę nad innymi i może stąd niektórzy uparcie deklarują, że właśnie ona jest najwydajniejsza. Na przykład ktoś może się sugerować wynikami 3DMarków, które w sam raz nawet nie brałem pod uwagę. Średnia z testów nie pozostawia jednak wątpliwości. Żadna z tych czterech kart nie może być traktowana jak jakiś parias wydajnościowy. Ba. Nawet R9200 250/200MHz nie pozostaje daleko w tyle. Dopiero FX5200 klasycznie taktowany odstaje od czołówki. Natomiast wersje 64-bitowe to już zupełnie inna "bajka". Niezależnie od tego czy chodzi o Radeony czy o GeForce'y to zdecydowanie odradzam zakup. Są niewiele tańsze a ich przeznaczeniem jest raczej segment kart służących do zastosowań biurowych niż gier 3D. Niestety jak pokazują opisy to wcale nie jest łatwo stwierdzić szerokość szyny pamięci bez wcześniejszych testów. To jest realne zagrożenie i nie ma wątpliwości, że niejeden się na taką kartę "naciął". Zalecam daleko idącą ostrożność w wyborze kart z cennika, jeśli nie mamy pewności w tej kwestii. Tak jak w przypadku droższych kart niewiele jest mutacji zegarów tak w najniższym segmencie mamy nieprawdopodobny wręcz pokaz niezależności producentów. Różnice są tak duże a opis na tyle mało czytelny, że wręcz powinno się pisać o konkretnych kartach a nie całych rodzinach opartych na tym samym układzie graficznym.

W związku z tym, że większość testowanych kart dysponuje zbliżoną mocą służącą obsłudze gier (wciąż powtarzam: średnio licząc) to o decyzji w wyborze powinny raczej zadecydować inne walory użytkowe. Możemy brać pod uwagę konkretny rodzaj gry, jakość obrazu wyjścia monitorowego lub telewizyjnego, dodatki sprzętowe w postaci wyjścia DVI, okablowania, przejściówek czy chłodzenia, podkręcalność, dołączone oprogramowanie czy wręcz kolor laminatu. Wszystko według konkretnych potrzeb. Część zalet i wad ma charakter globalny. Jeśli wymogiem jest lepsza jakość obrazu związana ze współpracą np. z topową 19-stką to warto skierować się w kierunku ATI. W tym segmencie nie ma kart GeForce wyposażonych w nowe układy wyjściowe z Ramdac 2x 400MHz (FX5600 i droższe), więc Radeony pozostają bez konkurencji. Jeszcze słabiej w tym zakresie wypada GF3Ti, choć moim zdaniem nie gorzej niż słabsze odmiany FX5200. Piętą achillesową GF3 jest również wyjście telewizyjne. Obraz jest względnie słaby i co gorsza układ nie ma możliwości pracy w trybie niezależnych wyjść. Zaletą kart nVidia jest natomiast lepsza zgodność z grami. W tym przedziale cenowym są tylko karty Radeon należące do starszej generacji i czasem może wystąpić jakaś niekompatybilność lub będziemy zmuszeni do wyłączenia konkretnego efektu. W tym względzie nowsze układy ATI serii R(V)3xx są znacznie lepsze. Obraz 3D w zasadzie jest zbliżony. Żadna z kart nie ma sensownie działającego FSAA a w kwestii filtrowania anizotropowego oraz kolorów osobiście preferowałbym Radeony. Spadek mocy "anizo" jest zbliżony do kart FX, ale sterowniki nVidia powodują zmniejszenie klasy filtrowania. Takie przynajmniej mam wrażenie. Z resztą w przypadku kart do 400 zł spokojnie można przymknąć oko na drobniejsze kiksy. Jeśli ktoś jest zainteresowany moim własnym zdaniem w kwestii wyboru karty, to w tym zakresie cenowym poszukałbym rozwiązania wśród kart R9000Pro 275/275MHz. I to niekoniecznie w wersji 128MB. Jak widać na przykładach nowych gier układy te są w stanie osiągać stosunkowo stabilne, wysokie wyniki, niezależnie od testu, dysponując przy tym ponadprzeciętną jakością obrazu a dodatkowo przyciągają wysokiej klasy, funkcjonalnym wyjściem telewizyjnym.

Przejdę teraz do "wypunktowania" poszczególnych uczestników testu. Wszystkie karty zachowały się poprawnie natomiast trzy z nich chciałbym specjalnie wyróżnić. Uzasadnienia dałem w podsumowaniach.

Asus V9520 Magic/T: bardzo dobra jakość obrazu, świetna podkręcalność, bardzo słaba wydajność, pasywne chłodzenie, bardzo ubogie wyposażenie.

Asus V9520 Magic/T: bardzo dobra jakość obrazu, świetna podkręcalność, bardzo słaba wydajność, pasywne chłodzenie, bardzo ubogie wyposażenie.

|

Gainward GF3 PowerPack! Ti/450 TV: akceptowalna jakość obrazu, przeciętna podkręcalność, bardzo dobra wydajność, średni hałas wentylatora, bardzo dobre wyposażenie, słabe wyjście telewizyjne. Wyróżnienie przyznałem za niezłą wydajność w tej klasie cenowej, ale przede wszystkim za dodatki programowe. Jest to jedyna z tanich kart, która może się pochwalić załącznikiem w postaci pełnej gry nowej generacji, za którą w sklepie musielibyśmy zapłacić 100 zł. Dodatkowo mamy obszerną instrukcję w języku polskim, znakomite warunki gwarancji oraz WinDVD do odtwarzania filmów.

Gainward GF3 PowerPack! Ti/450 TV: akceptowalna jakość obrazu, przeciętna podkręcalność, bardzo dobra wydajność, średni hałas wentylatora, bardzo dobre wyposażenie, słabe wyjście telewizyjne. Wyróżnienie przyznałem za niezłą wydajność w tej klasie cenowej, ale przede wszystkim za dodatki programowe. Jest to jedyna z tanich kart, która może się pochwalić załącznikiem w postaci pełnej gry nowej generacji, za którą w sklepie musielibyśmy zapłacić 100 zł. Dodatkowo mamy obszerną instrukcję w języku polskim, znakomite warunki gwarancji oraz WinDVD do odtwarzania filmów.

|

HIS Radeon 9200 64MB VIVO: świetna jakość obrazu, przeciętna podkręcalność, dobra wydajność, pasywne chłodzenie, wejście wizyjne, dobre wyposażenie.

HIS Radeon 9200 64MB VIVO: świetna jakość obrazu, przeciętna podkręcalność, dobra wydajność, pasywne chłodzenie, wejście wizyjne, dobre wyposażenie.

|

Hercules 3D Prophet 9000 Pro 128MB: rewelacyjna jakość obrazu, przeciętna podkręcalność, bardzo dobra wydajność, dosyć ciche chłodzenie, minimalne wyposażenie. Wyróżnienie przyznałem za bardzo dobre połączenie wydajności z jakością oraz przyzwoitą cenę. W tym zakresie karta jest bezkompromisowa wobec konkurencji. Jeśli ktoś szuka taniej karty z niezłą obsługą gier do współpracy z topowym monitorem to warto na nią zwrócić uwagę. Tym bardziej, że jak na Herculesa cena jest bardzo przystępna. Z ostatniej chwili: Mam nadzieję, że wyróżnienie Hercules'a nie zostało nadane "pośmiertnie", bo dostałem informację, że Sirius nie może już zagwarantować kolejnych dostaw tego produktu.

Hercules 3D Prophet 9000 Pro 128MB: rewelacyjna jakość obrazu, przeciętna podkręcalność, bardzo dobra wydajność, dosyć ciche chłodzenie, minimalne wyposażenie. Wyróżnienie przyznałem za bardzo dobre połączenie wydajności z jakością oraz przyzwoitą cenę. W tym zakresie karta jest bezkompromisowa wobec konkurencji. Jeśli ktoś szuka taniej karty z niezłą obsługą gier do współpracy z topowym monitorem to warto na nią zwrócić uwagę. Tym bardziej, że jak na Herculesa cena jest bardzo przystępna. Z ostatniej chwili: Mam nadzieję, że wyróżnienie Hercules'a nie zostało nadane "pośmiertnie", bo dostałem informację, że Sirius nie może już zagwarantować kolejnych dostaw tego produktu.

|

Prolink PixelView GeForceFX 5200 128MB Ultimate: akceptowalna jakość obrazu, niezła podkręcalność, niezła wydajność, dosyć ciche chłodzenie, ubogie wyposażenie. Wyróżnienie przyznałem za najlepszy wśród kart FX5200 stosunek wydajności do ceny. Dzięki lepszym pamięciom możliwe było zbliżenie mocy do tego, czym dysponuje konkurencja bez znaczącego pompowania ceny. Choć wciąż w niektórych testach karta wypada nieco słabiej niż np. Radeony czy GF3 to jednak nie jest to duża różnica a pamiętać należy o tym, że dostaliśmy "za darmo" obsługę efektów Dx9. W grach raczej tego nie wykorzystamy ze względu na zbyt duży spadek mocy, ale możemy nacieszyć oczy przynajmniej demonstracjami nowego API albo, choć zobaczyć różnicę w obrazie.

Prolink PixelView GeForceFX 5200 128MB Ultimate: akceptowalna jakość obrazu, niezła podkręcalność, niezła wydajność, dosyć ciche chłodzenie, ubogie wyposażenie. Wyróżnienie przyznałem za najlepszy wśród kart FX5200 stosunek wydajności do ceny. Dzięki lepszym pamięciom możliwe było zbliżenie mocy do tego, czym dysponuje konkurencja bez znaczącego pompowania ceny. Choć wciąż w niektórych testach karta wypada nieco słabiej niż np. Radeony czy GF3 to jednak nie jest to duża różnica a pamiętać należy o tym, że dostaliśmy "za darmo" obsługę efektów Dx9. W grach raczej tego nie wykorzystamy ze względu na zbyt duży spadek mocy, ale możemy nacieszyć oczy przynajmniej demonstracjami nowego API albo, choć zobaczyć różnicę w obrazie.

|

Prolink PixelView GeForceFX 5200 64MB: akceptowalna jakość obrazu, niezła podkręcalność, bardzo słaba wydajność, pasywne chłodzenie, ubogie wyposażenie.

Prolink PixelView GeForceFX 5200 64MB: akceptowalna jakość obrazu, niezła podkręcalność, bardzo słaba wydajność, pasywne chłodzenie, ubogie wyposażenie.

|

Sapphire Radeon 9000 64MB TV Bulk: świetna jakość obrazu, w zasadzie brak możliwości podkręcenia, w miarę dobra wydajność, pasywne chłodzenie, brak wyposażenia.

Sapphire Radeon 9000 64MB TV Bulk: świetna jakość obrazu, w zasadzie brak możliwości podkręcenia, w miarę dobra wydajność, pasywne chłodzenie, brak wyposażenia.

|

Wśród produktów należących do dolnej półki cenowej trzeba się liczyć z tym, że nie ma wśród nich kart idealnych. Wybór zawsze jest w pewnym stopniu oparty na kompromisie parametrów użytkowych. Kart 64-bitowych w ogóle nie ma, co brać pod uwagę i jedynie należy skoncentrować się na tym, aby przez przypadek lub niedoinformowanie nie stać się właścicielem takiego "wynalazku". FX5200 rewelacją trudno mi nazwać. Obsługa efektów Dx9 jest dodatkiem miłym, choć w tym przypadku niezbyt użytecznym ze względu na ograniczenie mocy. Klasycznie taktowany FX5200 128-bitów przegrywa w porównaniu zarówno z Radeonami jak i GF3Ti200, ale moim zdaniem błąd popełniają Ci, którzy od razu chcą go skazać na całkowitą klęskę. Jak pokazuje test, odpowiednio taktowany FX5200 przy założeniu ceny < 400 zł jest w stanie skutecznie się bronić i choć według mnie nie jest w stanie zdominować rynku to bez problemu powinni znaleźć się amatorzy tego rozwiązania. Niestety wśród zestawu testowego miałem wybór, który można uprościć do: ciut słabsza wydajność + dx9 + większa kompatybilność w stosunku do: znacząco lepsza jakość + nieco wyższa wydajność. Oczywiście przy zachowaniu zbliżonej ceny.

Rozważając całą linię produktów FX muszę przyznać, że choć dla mnie (może subiektywnie czy może ze względu na skoncentrowanie się na nowych grach) w niemal każdej klasie cenowej Radeony osiągały mniejszą lub większą przewagę nad produktami GeForce to tylko w przypadku kart FX5600 odradzam ten produkt każdemu, niezależnie od preferencji. Po prostu w 600-tkach stosunek wydajności do ceny jest jak dla mnie fatalny. Z resztą zgodnie z tym, co sugerowałem, produkt ten znikł z www.nvidia.com podobnie jak wcześniej FX5800. Został zastąpiony przez FX5700, który pewnie niedługo trafi do testów wraz z kartą Radeon 9600XT. Mam nadzieję, że ostatni szereg artykułów pozwolił zainteresowanym lepiej dobrać odpowiedni dla siebie produkt w badanych zakresach cenowych oraz, że właściwie przekazałem własne odczucia wynikające z testów serii kart GeForceFX.

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | Sklep Internetowy Sirius Computers |

|