PCI Express - Nowe złącze graficzne

Autor: Kris | Data: 13/09/04

|

Przed PCI Express nie uciekniemy. Wcześniej czy później dopadnie nas i zadomowi się w naszym blaszaku. Aktualna oferta sklepowa to tylko forpoczta nowego standardu złącza. Być może niewielu z nas, w tej chwili, zechce z niej skorzystać, ale nie mam wątpliwości, że podstawy wiedzy, przynajmniej praktycznej, powinny zainteresować każdego, kto ma w planach, niekoniecznie najbliższych, zakup nowego sprzętu komputerowego. Mam nadzieję, że za pomocą tego niewielkiego artykułu uda mi się przekazać przynajmniej najważniejsze zagadnienia związane z PCI Express oraz sklasyfikować sprzęt, który właśnie pojawił się na półkach sklepowych. Przed PCI Express nie uciekniemy. Wcześniej czy później dopadnie nas i zadomowi się w naszym blaszaku. Aktualna oferta sklepowa to tylko forpoczta nowego standardu złącza. Być może niewielu z nas, w tej chwili, zechce z niej skorzystać, ale nie mam wątpliwości, że podstawy wiedzy, przynajmniej praktycznej, powinny zainteresować każdego, kto ma w planach, niekoniecznie najbliższych, zakup nowego sprzętu komputerowego. Mam nadzieję, że za pomocą tego niewielkiego artykułu uda mi się przekazać przynajmniej najważniejsze zagadnienia związane z PCI Express oraz sklasyfikować sprzęt, który właśnie pojawił się na półkach sklepowych.

Oprócz teorii, w artykule znaleźć można wyniki badań płyty Gigabyte GA-8GPNXP Duo oraz trzech kart opartych na nowym złączu graficznym. | |

|

Rys historyczny

Modularna konstrukcja była jednym z głównych przyczyn sukcesu rynkowego peceta, już od chwili jego narodzin, na początku lat 80-tych. Wprawdzie w dzisiejszych czasach słowo "upgrade" coraz bardziej staje się narzędziem w rękach marketingu producenta, to jednak wciąż mamy pewne możliwości znalezienia dodatkowych oszczędności w procesie niezmordowanego podążania, za coraz nowszym sprzętem. Jednym z podstawowych elementów składowych "blaszaka" jest karta graficzna. Jako, że jej wydajność i możliwości stanowią podstawę obsługi aplikacji graficznych (w tym oczywiście gier), to dzięki jej niezależności konstrukcyjnej możemy wpływać zarówno na ukierunkowanie możliwości konkretnego komputera, jak i pozostawić sobie furtkę rozwoju. Karty funkcjonalne łączą się z płytą bazową za pomocą odpowiednich złącz. Dla zapewnienia prawidłowej współpracy niezbędna jest ich standaryzacja zarówno w odniesieniu do wymiarów zewnętrznych, jak i na poziomie sygnałowym. Jednym z podstawowych parametrów określających możliwości złącza jest jego przepustowość. Jest to maksymalna ilość danych, jakie możemy przez nie przekazać, w ciągu jednej sekundy. Nieprzerwany wzrost mocy procesorów powoduje konieczność okresowych zmian standardów złączy w celu dopasowania ich możliwości przekazywania danych urządzeniom peryferyjnym.

Przykładowa karta na złączu ISA

Pierwsze komputery IBM PC wyposażone były w 8-bitowe (osiem równoległych linii przekazujących sygnał cyfrowy) złącza ISA (Industry Standard Architecture). Maksymalne taktowanie magistrali wynosiło 8MHz, więc umożliwiały uzyskanie przepustowości 8MB/s (przyjmijmy umownie, że MB/s oznacza 10^6 bajtów/s). Wraz z pojawieniem się IBM PC/AT zadebiutowała 16-bitowa wersja ISA, o tym samym taktowaniu. Zdublowanie ilości linii sygnałowych zaowocowało transferem 16MB/s. Odpowiedzią na opracowany przez IBM (model PS/2) i zastrzeżony dla własnych konstrukcji standard MCA (Micro-Channel Architecture, 32-bity, 10MHz, 40MB/s) było 32-bitowe złącze EISA (Extended ISA). W związku z tym, że taktowanie szyny nadal wynosiło tylko 8MHz to przepustowość osiągnęła 32MB/s. Czterokrotny wzrost możliwości przekazywania danych przez kolejne mutacje ISA był niewspółmiernie mały, w stosunku do rozwoju procesorów. Niezbędne było podjęcie bardziej radykalnych kroków. Najpierw wprowadzono VESA (Video Electronics Standards Association) Local Bus, zwany w skrócie VLB. Warto zwrócić uwagę na pierwsze pojawienie się słowa "Video" przy nazwie standardu. To właśnie karty graficzne stają się główną siłą sprawczą zmian, choć w przypadku VLB nie były one jedynymi jego odbiorcami. VLB bezpośrednio łączył się z szyną procesora, co w połączeniu z taktowaniem do 33MHz i 32-bitami umożliwiało transfer do 132MB/s. Podstawową wadą rozwiązania była możliwości uzyskania w ten sposób jedynie trzech złączy działających w tym standardzie. Nie mogło to wyeliminować ISA, a apetyty kart peryferyjnych wciąż rosły.

Przedstawiciel złącza PCI

Wraz z premierą pierwszego chipsetu firmy Intel (430HX) zadebiutowało złącze, które jest dzielnie wykorzystywane przez karty rozszerzeń również i dziś. Chodzi oczywiście o PCI (Peripheral Component Interconnect). Wprawdzie złącza ISA jeszcze przez kilka lat pojawiały się w kolejnych płytach głównych, ale ich istnienie miało już jedynie charakter związany z zapewnieniem wstecznej kompatybilności. PCI był rewolucyjnym interfejsem umożliwiającym dynamiczną konfigurację urządzeń peryferyjnych. 32-bitowa szyna taktowana 33MHz zapewniała przepustowość 132MB/s, a specyfikacja chipsetów pozwalała na implementację takiej ilości gniazd, która pokrywała zapotrzebowanie typowego peceta. W początkowej fazie złącze PCI stało się również podstawowym standardem komunikacji dla kart graficznych, W tym okresie pojawiły się pierwsze sprzętowe akceleratory 3D, a "blaszak" stał się podstawą domowej rozrywki multimedialnej. Gwałtowny rozwój układów graficznych, wraz z lawinowym wzrostem ilości przetwarzanych przez nie danych oraz popularność tego zastosowania, stała się podstawą do stworzenia kolejnego standardu złącza. Tym razem, dedykowanego dla samych kart graficznych.

Pierwsze złącze AGP (Accelerated Graphics Port) ujrzało światło dzienne wraz z pojawieniem się chipsetu Intel 440LX. Przeznaczone było do podłączenia pojedynczej karty graficznej i zgodnie z nazwą zapewniało jej dodatkową funkcjonalność. Po raz pierwszy pojawiła się możliwość dynamicznego przydzielania i bezpośredniego wykorzystania przez układ graficzny podstawowej pamięci RAM płyty głównej. Z jednej strony mamy możliwość obsługi oprogramowania wykorzystującego dane graficzne przekraczające wielkość pamięci lokalnej, umieszczonej na karcie graficznej, a z drugiej strony możliwe stało się skonstruowanie tanich płyt opartych na chipsetach zintegrowanych z układem graficznym. Pierwszy port AGP (teraz zwany AGP 1x) był 32-bitowym złączem taktowanym częstotliwością 66MHz i osiągającym przepustowość 264MB/s. Rok później wraz z chipsetem Intel 440BX pojawił się AGP 2x. Przepustowość 528MB/s osiągnięta została dzięki technologii DDR (dwa transfery danych na jeden impuls zegara taktującego). Pierwsze płyty oparte na chipsecie Intel 815P wprowadziły AGP 4x (133MHz taktowania + DDR) o przepustowości 1056MB/s. Ostatnim z serii jest złącze AGP 8x wykorzystane po raz pierwszy w chipsecie Intel E7205. Transfer 2112MB/s to efekt kolejnego wzrostu taktowania (266MHz + DDR).

Tak, w dużym skrócie, można opisać historię złączy, które karmiły danymi karty graficzne naszego domowego komputera klasy PC. Rok 2004 przynosi wprowadzenie kolejnego standardu. Z technicznego punktu widzenia charakter wprowadzonych zmian można uznać za rewolucyjny. Na rynek trafiają pierwsze płyty wyposażone w gniazda PCI Express.

Idzie nowe

W przeciwieństwie do wszystkich opisanych wcześniej złączy, po raz pierwszy interfejs równoległy zastąpiony został szeregowym. Sygnał przekazywany jest za pomocą dwóch linii, po jednej w każdym kierunku. Częstotliwość taktowania wynosi 2.5GHz. Protokół transmisji wprowadza dwa dodatkowe bity, do każdych ośmiu bitów danych. Łatwo więc wyliczyć, że przepustowość jednej linii wynosi 250MB/s. W związku z tym, że urządzenia mogą jednocześnie przekazywać sygnał w obydwu kierunkach (full-duplex) to można ewentualnie przyjąć, że w przypadku takiego wykorzystania złącza, transfer może sięgać 500MB/s. Należy również zwrócić uwagę na fakt, że w odróżnieniu od wcześniejszych szyn, odbiorniki danych nie muszą się dzielić pasmem. Każdy ma całą przepustowość tylko dla siebie.

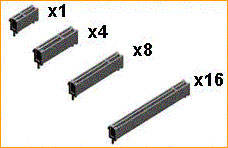

To nie koniec niespodzianek. Jedną z najważniejszych zalet nowej magistrali jest jej skalowalność. W związku z niezależnością pasma, w jednym slocie możemy jednocześnie wykorzystać więcej dwukierunkowych złączy PCI Express (proponuję skrótową nazwę PCI-E), dzięki czemu możemy zwielokrotnić przepustowość dla pojedynczego urządzenia (karty). Ze względu na to, w oznaczeniach nazw gniazd pojawiły się dodatkowe wyróżniki cyfrowe. Na przykład PCI Express x2 to pojedyncze złącze zawierające po dwa kanały 250MB/s w każdym kierunku. Uwzględniając urządzenia w pełni wykorzystujące full-duplex można więc, dla takiego gniazda, pisać o łącznej przepustowości 1GB/s. Dodatkowo, konstrukcja złączy została opracowana w ten sposób, aby umożliwić stosowanie kart wykorzystujących mniejszą ilość kanałów w gniazdach zawierających wyższy "indeks" linii (możliwe będzie zastosowanie np. karty x1 w gnieździe x4).

Wbrew temu co niektórym mogłoby się wydawać, wejście nowego standardu nie wydaje się falstartem. Wprawdzie zdecydowana większość urządzeń peryferyjnych zadowala się znacznie skromniejszym zapotrzebowaniem na transfer danych, ale są zastosowania gdzie, od pewnego czasu, aktualne złącze i jego model działania stanowią już ograniczenie ich możliwości. Są to przede wszystkim sterowniki dysków oraz układy sieciowe. Obecnie, już nawet w przypadku kontrolerów IDE notujemy zysk z natywnej obsługi przez mostek południowy chipsetu, natomiast Gigabit LAN czy SCSI Ultra 320 wyraźnie się "duszą". Zintegrowane rozwiązanie sieciowe Intel CSA, znane z niektórych płyt i875, jest właśnie próbą rozwiązania problemu przepustowości urządzeń mostka południowego. Wprowadzanie takich dedykowanych rozwiązań, będących w zasadzie pewną formą protezy, wyraźnie wskazuje na zmierzch standardu i otwiera drogę dla PCI Express.

Złącze graficzne

Urządzeniem, które od dłuższego czasu zdecydowanie prowadzi w rankingach zapotrzebowania na pasmo transmisji danych jest karta graficzna. Podstawowym pytaniem jakie nasuwało się przy recenzjach kolejnych złączy dla układów grafiki to kwestia tego, jakiej przepustowości tak naprawdę wymaga karta i dlaczego. Testy w realnych zastosowaniach wykazały jedynie niewielkie różnice wydajności przy przejściu z AGP 2x na 4x i w zasadzie pomijalne pomiędzy 8x a 4x. Dlaczego tak się dzieje?

Karta wykorzystuje złącze graficzne do dwóch podstawowych działań. Pierwszym jest przekazanie informacji, za pomocą której procesor zleca układowi przygotowanie obrazu, a drugą transfer danych bezpośrednio pomiędzy układem a pamięcią podstawową płyty głównej, w celu ominięcia ograniczeń związanych z wielkością pamięci lokalnej na karcie graficznej. W pierwszym przypadku brak różnic wydajności związany jest z możliwościami układów graficznych w zakresie przetwarzania tego typu danych. Jeśli wydajność układu nie wzrośnie na tyle, aby programiści znacząco zwiększyli zakres wykorzystania łącza, to nie mamy do czynienia z "zapychaniem" się magistrali i dalsze rozszerzanie jej możliwości nie przyniesie wymiernego efektu. Można to porównać do wielopasmowej drogi, po której od czasu do czasu przejedzie pojedynczy pojazd.

AGP vs PCI Express (kliknij, aby powiększyć)

Drugi przypadek to nic innego, jak szeroko kiedyś reklamowane "teksturowanie przez AGP". W zasadzie, analizując rozwój aplikacji od pojawienia się złącza AGP, należy przyjąć do wiadomości fakt, że pomysł nie "chwycił". Po prostu ilość pamięci lokalnej na karcie graficznej jest wystarczająca dla pokrycia zapotrzebowania układu. Co ważne charakter działań układu graficznego w połączeniu z jego wydajnością doprowadził do tak dużej różnicy pomiędzy możliwościami lokalnej pamięci w stosunku do tej, którą udostępnia złącze, że jego wykorzystanie w procesie teksturowania ma fatalny wpływ na jakość obsługi programu. Użytkownik tak dobiera parametry programu, aby dane mieściły się w pamięci karty, a programista oczywiście daje mu taką możliwość. Jednym słowem sytuacja zmusza, a jednocześnie umożliwia rezygnację z tej funkcjonalności złącza. Aby sobie lepiej to uzmysłowić wystarczy porównać dwie liczby. Przepustowość pamięci lokalnej najnowszych kart graficznych przekracza 30GB/s natomiast AGP 8x to "tylko" 2GB/s. Otwarte pozostaje więc pytanie, po co nam nowy standard złącza graficznego?

No cóż. Niewątpliwie wprowadzenie nowych technologii wpływa ożywczo na rynek. Należy rzucić w klienta kilkoma wizjami, które sprowadzą techniczny bełkot do bardziej zrozumiałych pojęć. PCI Express jest w stanie stworzyć karcie graficznej większe możliwości wykorzystania jej potencjału wymaga to jednak dłuższego czasu adaptacji strony aplikacyjnej. Najczęściej jest tak, że w sferze grafiki decydujemy się na konkretne rozwiązania techniczne skuszeni marketingiem po to, aby je praktycznie wykorzystać dopiero w sprzęcie następnej generacji. Bez znaczącego pokrycia rynku daną technologią programiści nie zaryzykują wprowadzenia produktu, który może z niego korzystać. Prostym przykładem jest wielkość pamięci lokalnej karty graficznej. Najpierw większość klientów musiała się "uzbroić" w 128MB, aby mogły się pojawić gry, które z niej skorzystają. Ktoś jednak musiał kupować ten sprzęt dla samej obietnicy takich produktów, bo inaczej by się one nie pojawiły.

Jako, że wyraziłem swoje wątpliwości w kwestii sukcesu wykorzystania złącza w procesie teksturowania oraz nie stwierdziłem presji aplikacji w kierunku wykorzystaniu przepustowości AGP 8x to czy w ogóle użytkownik może liczyć na jakąś korzyść, nawet w dłuższym okresie czasu? Wydaje mi się, że są pewne przesłanki dla minimalnego optymizmu. Najważniejszą z nich jest zapowiedź opracowania płyt wyposażonych w dwa gniazda graficzne PCI Express, przeznaczonych dla masowego, choć pewnie bardziej zamożnego odbiorcy.

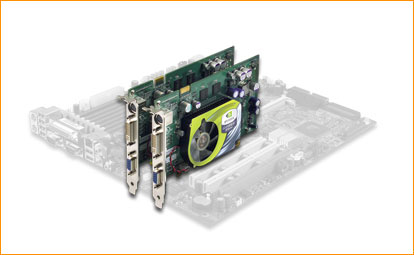

Implementacja dwóch gniazd AGP na jednej płycie jest technicznie możliwa, ale ze względu na prawdopodobne problemy konstrukcyjne lub nikłe zainteresowanie rynku, z tego co wiem, nikt się na to nie zdecydował. Nieco inaczej wygląda sprawa przy nowym standardzie. Szeregowy, "modułowy" interfejs znacznie łatwiej klonować, standard umożliwia różne tryby pracy poszczególnych linii, a przepustowość jest w zasadzie nadmiarowa. Najważniejsze jednak jest to, że pojawiła się wizja realnego wykorzystania takich konstrukcji w "domowych" pecetach, dzięki sprzedaży przez nVidia kart przystosowanych do równoległej pracy w parach. Taki tandem umożliwia konkretne zwiększenie wydajności, w stosunku do możliwości pojedynczej karty.

SLI w wykonaniu GF 6600 GT PCI Express

Technologia ta została nazwana Scalable Link Interface tak, aby w skrócie brzmiało to SLI. Tak samo jak dobrze kojarzący się, historyczny system dwóch kart 3dfx Voodoo2 (Scan Line Interleave). Oczywiście inni producenci również mogą "podpiąć się" do tego rozwiązania. W zasadzie jest to głównie kwestia odpowiednich sterowników. Również można sobie wyobrazić wykorzystanie dwóch kart związane z kwestią uzupełnienia ich możliwości, czy zwielokrotnienia konkretnej funkcjonalności (np. graficzna + VIVO, obsługa czterech monitorów itd.).

Kolejną z różnic PCI Express w stosunku do AGP jest kwestia przepustowości w kierunku płyty głównej. W przypadku poprzedniego złącza, które było dostosowane do typowego wykorzystania przez karty graficzne, mieliśmy do czynienia ze znaczną asymetrią. Karta mogła pobierać 2GB/s danych natomiast oddawać je z prędkością odgraniczoną do ok. 130MB/s. W przypadku znaczącego zwiększenia przepustowości w drugim kierunku można sobie wyobrazić zastosowanie układów graficznych do przetwarzania strumienia wizyjnego wysokiej rozdzielczości. Spece od marketingu faszerują nas wizjami obróbki HDTV w czasie rzeczywistym natomiast niezależnie od tego, czy będzie to możliwe sądzę, że w najbliższym czasie nie należy spodziewać się podobnych rozwiązań. Być może jeszcze dłużej będzie trwało dojście do klasycznego wykorzystania zwiększonej przepustowości, w postaci zwiększenia ilości danych przesyłanych przez gry. Są to na tyle mgliste obietnice, że raczej nie powinny one kierować uwagi klientów na PCI Express.

Najważniejszym bodźcem do przejścia na nowy standard będzie jednak najprawdopodobniej, podobnie jak w przeszłości, najzwyklejszy przymus standaryzacyjny. Po prostu wcześniej czy później trafi nas konieczność zmiany płyty lub karty graficznej i w pewnym momencie zauważymy, że najciekawsze rozwiązania sprzętowe wymagają od nas zmiany standardu złącza graficznego. W tej chwili nic nas nie zmusza do takich działań oprócz zachęty ze strony marketingu producentów, roztaczających przed nami wizję zalet nowych rozwiązań technologicznych, ale trzeba się liczyć z tym, że w przyszłości będzie już inaczej.

Chipsety

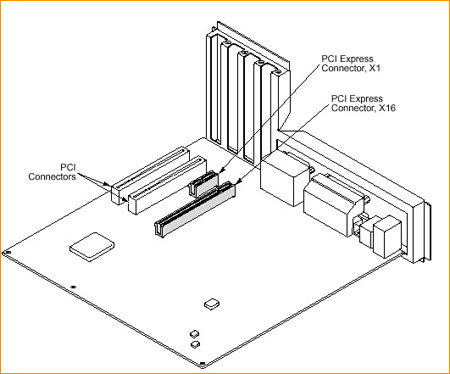

Przychodzi moment, w którym specyfikacja złącza musi zostać sprowadzona na konkretną konstrukcję chipsetu płyty głównej. Przyjęto, że przynajmniej w początkowym etapie wprowadzania standardu, płyty przeznaczone dla masowego odbiorcy zadowolą się złączami x1 oraz x16. Można więc stwierdzić, że PCI Express atakuje nas dwoma gniazdami. Jak można się łatwo domyśleć PCI-E x1 ma w założeniu spełniać zadania PCI, natomiast PCI-E x16 zastąpi AGP. W przyszłości prawdopodobnie ujrzymy również złącza o przepustowości pośredniej.

PCI Express x16, tak jak sugeruje nazwa, niejako "złożony" jest z szesnastu, równolegle działających, pojedynczych złączy x1, co daje przepustowość 4GB/s w każdym z kierunków. Oczywiście marketing skwapliwie podaje liczbę 8GB/s, jako łączny transfer w obie strony, co przy typowym wykorzystaniu w kartach graficznych jest ewidentnym naciągactwem, bo niemal cała transmisja idzie od płyty głównej w kierunku karty. Biorąc pod uwagę to, że aktualny standard AGP x8 dysponuje transferem 2GB/s i jak już wcześniej wspominałem wciąż nie jeszcze wykorzystywany przez aplikacje, to wydaje się, że będziemy mieli zapas pasma wystarczający na dłuższy czas. Natomiast w przypadku złącz PCI, które zdecydowanie bardziej potrzebują zmian, wprowadzenie PCI-E x1 daje blisko czterokrotnie większą prędkość transmisji danych.

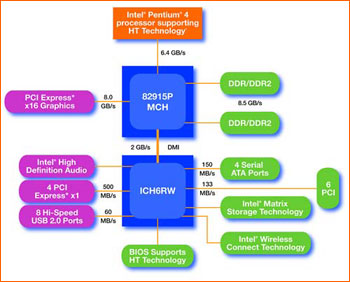

Typowy chipset płyty głównej składa się z dwóch podstawowych układów. Mostek północny, dysponujący wysoką przepustowością, służy do organizacji przepływu danych pomiędzy procesorem, pamięcią i kartą graficzną, natomiast mostek południowy obsługuje mniejszy ruch danych, dostarczanych przez pozostałe urządzenia peryferyjne. Oba układy łączy specjalna magistrala, której przepustowość powinna pokrywać zapotrzebowanie całego mostka południowego. Z powyższego układu wynika przynależność poszczególnych rodzajów złączy PCI Express. W klasycznych konstrukcjach chipsetów złącze graficzne wyprowadzone będzie z mostka północnego, natomiast PCI-E x1 zasilą mostek południowy.

Ciężar wprowadzenia nowego standardu, podobnie jak w poprzednich latach, wzięła na siebie firma Intel Corporation. Mostek północny chipsetów i915/i925 zawiera jedno złącze graficzne PCI-E x16, natomiast mostek południowy może obsługiwać do czterech gniazd PCI-E x1. Mostki łączy nowa magistrala 2GB/s (po 1GB/s w każdą stronę). Oprócz nowych gniazd chipset obsługuje również do sześciu klasycznych złączy PCI. Oczywiście ze względu na ograniczenia związane ze standardami wymiarów ATX oraz typowych wyprowadzeń kart w obudowach, producenci płyt sami zadecydują o proporcjach ilości PCI-E x1 oraz PCI. Niestety nie znajdziemy w nowych chipsetach obsługi AGP. Po raz pierwszy, wraz z wymianą płyty, skazani jesteśmy na zakup nowej karty graficznej. Nie ukrywam, że dla miłośników gier komputerowych jest to bolesna uciążliwość. Od lat zmieniają się proporcje cen poszczególnych podzespołów, a karta graficzna zaczyna mieć wśród nich dominującą pozycję. Wprawdzie niektórzy producenci zapowiedzieli wprowadzenie na rynek płyt opartych na i9xx wyposażonych w gniazdo AGP, ale jest to proteza w postaci przystosowania do obsługi kart graficznych w tym standardzie interfejsu PCI mostka południowego. Takie rozwiązanie nie będzie ani wydajne, ani specjalnie kompatybilne i wszystkim miłośnikom gier wyposażonym w silne karty graficzne zdecydowanie odradzam opieranie na nich pomysłów upgrade'owych. Nowe chipsety wprowadzają znacznie więcej nowości, ale w tym artykule chciałbym skoncentrować się jedynie na PCI Express. Ciężar wprowadzenia nowego standardu, podobnie jak w poprzednich latach, wzięła na siebie firma Intel Corporation. Mostek północny chipsetów i915/i925 zawiera jedno złącze graficzne PCI-E x16, natomiast mostek południowy może obsługiwać do czterech gniazd PCI-E x1. Mostki łączy nowa magistrala 2GB/s (po 1GB/s w każdą stronę). Oprócz nowych gniazd chipset obsługuje również do sześciu klasycznych złączy PCI. Oczywiście ze względu na ograniczenia związane ze standardami wymiarów ATX oraz typowych wyprowadzeń kart w obudowach, producenci płyt sami zadecydują o proporcjach ilości PCI-E x1 oraz PCI. Niestety nie znajdziemy w nowych chipsetach obsługi AGP. Po raz pierwszy, wraz z wymianą płyty, skazani jesteśmy na zakup nowej karty graficznej. Nie ukrywam, że dla miłośników gier komputerowych jest to bolesna uciążliwość. Od lat zmieniają się proporcje cen poszczególnych podzespołów, a karta graficzna zaczyna mieć wśród nich dominującą pozycję. Wprawdzie niektórzy producenci zapowiedzieli wprowadzenie na rynek płyt opartych na i9xx wyposażonych w gniazdo AGP, ale jest to proteza w postaci przystosowania do obsługi kart graficznych w tym standardzie interfejsu PCI mostka południowego. Takie rozwiązanie nie będzie ani wydajne, ani specjalnie kompatybilne i wszystkim miłośnikom gier wyposażonym w silne karty graficzne zdecydowanie odradzam opieranie na nich pomysłów upgrade'owych. Nowe chipsety wprowadzają znacznie więcej nowości, ale w tym artykule chciałbym skoncentrować się jedynie na PCI Express. |

W związku z tym, że aktualnie PCI Express możemy znaleźć jedynie w płytach dla procesorów Pentium 4 to być może niektórym wydaje się, że jest to jakiś lokalny standard firmy Intel i w zasadzie nie ma się czym przejmować. Nic z tych rzeczy. Nie ma aktualnie takiego producenta chipsetów zarówno dla procesorów firmy Intel, jak i AMD, który nie planuje wdrożenia tego standardu w swoich przyszłych produktach a PCI-SIG (www.pcisig.com), forum skupiające firmy zainteresowane we wzajemnym dopasowaniu swoich produktów m.in. interfejsem PCI Express, skupia już ponad 900 członków.

VIA Technologies zapowiedziała już chipsety oparte na mostkach północnych PT890 (Intel Pentium 4) oraz K8T890 (AMD Athlon64) zawierające jeden port graficzny PCI-E x16 oraz dodatkowe cztery kanały PCI-E. Uwagę potencjalnych nabywców przykuła informacja, podana na targach CeBIT, o wyposażeniu nowych produktów również w port AGP 8x. Mam nadzieję, że VIA zechce spełnić tą obietnicę, bo jak na razie nikt inny nie zasugerował takiego rozwiązania, a byłoby to bardzo korzystne dla zainteresowanych upgrade'em, miłośników gier komputerowych. Mostek południowy VT8251 zawiera dodatkowe dwa złącza PCI-E x1. Wydaje się to w chwili obecnej zupełnie wystarczające, tym bardziej, że szyna Ultra V-Link łącząca mostki ma przepustowość ok. 1GB/s i byłaby elementem ograniczającym dla dodatkowych portów. VIA Technologies zapowiedziała już chipsety oparte na mostkach północnych PT890 (Intel Pentium 4) oraz K8T890 (AMD Athlon64) zawierające jeden port graficzny PCI-E x16 oraz dodatkowe cztery kanały PCI-E. Uwagę potencjalnych nabywców przykuła informacja, podana na targach CeBIT, o wyposażeniu nowych produktów również w port AGP 8x. Mam nadzieję, że VIA zechce spełnić tą obietnicę, bo jak na razie nikt inny nie zasugerował takiego rozwiązania, a byłoby to bardzo korzystne dla zainteresowanych upgrade'em, miłośników gier komputerowych. Mostek południowy VT8251 zawiera dodatkowe dwa złącza PCI-E x1. Wydaje się to w chwili obecnej zupełnie wystarczające, tym bardziej, że szyna Ultra V-Link łącząca mostki ma przepustowość ok. 1GB/s i byłaby elementem ograniczającym dla dodatkowych portów. |

SiS Corp. (Silicon Integrated System) również przedstawił produkty PCI Express. Najważniejsze mostki północne to SiS656 (Intel Pentium 4) oraz SiS756 (AMD Athlon64). Oba zawierają port PCI-E x16 i łączą się z układem SiS965 magistralą MuTIOL 1GB/s. Podobnie jak w chipsecie VIA, umożliwiło to implementację dwóch portów PCI-E x1 w mostku południowym. SiS Corp. (Silicon Integrated System) również przedstawił produkty PCI Express. Najważniejsze mostki północne to SiS656 (Intel Pentium 4) oraz SiS756 (AMD Athlon64). Oba zawierają port PCI-E x16 i łączą się z układem SiS965 magistralą MuTIOL 1GB/s. Podobnie jak w chipsecie VIA, umożliwiło to implementację dwóch portów PCI-E x1 w mostku południowym. |

ALi Corporation zaprezentował chipset dla Intel Pentium 4 oparty na układzie M1685 z jednym portem graficznym PCI Express x16. Bardziej interesujący wydaje się mostek południowy M1566, który wyposażono w dwa porty PCI-E x1 oraz jeden port PCI-E x4. Aby zapewnić wymianę tak dużej ilości danych (w sumie sześć linii PCI-E), mostki łączy magistrala HyperTransport o przepustowości 4GB/s. ALi Corporation zaprezentował chipset dla Intel Pentium 4 oparty na układzie M1685 z jednym portem graficznym PCI Express x16. Bardziej interesujący wydaje się mostek południowy M1566, który wyposażono w dwa porty PCI-E x1 oraz jeden port PCI-E x4. Aby zapewnić wymianę tak dużej ilości danych (w sumie sześć linii PCI-E), mostki łączy magistrala HyperTransport o przepustowości 4GB/s. |

Ze strony nVidia Corporation spodziewane jest rychłe zaanonsowanie chipsetu nForce4 dla AMD Athlon64. Wprawdzie szczegóły objęte są wciąż tajemnicą, ale w związku z technologią SLI dla kart graficznych opartych na układach tego producenta, wszyscy spodziewają się przedstawienia rozwiązania wspierającego je od strony płyt głównych. Najnowsze informacje mówią o płytach wyposażonych w dwa gniazda PCI-E x16, które mogą obsłużyć jedną kartę z pełną przepustowością lub dwie w trybie PCI-E x8. Otwarte pozostaje pytanie czy posiadacze procesorów Intel również będą mogli cieszyć się rozwiązaniem SLI. Ze strony nVidia Corporation spodziewane jest rychłe zaanonsowanie chipsetu nForce4 dla AMD Athlon64. Wprawdzie szczegóły objęte są wciąż tajemnicą, ale w związku z technologią SLI dla kart graficznych opartych na układach tego producenta, wszyscy spodziewają się przedstawienia rozwiązania wspierającego je od strony płyt głównych. Najnowsze informacje mówią o płytach wyposażonych w dwa gniazda PCI-E x16, które mogą obsłużyć jedną kartę z pełną przepustowością lub dwie w trybie PCI-E x8. Otwarte pozostaje pytanie czy posiadacze procesorów Intel również będą mogli cieszyć się rozwiązaniem SLI. |

Również i ATI Technologies pichci chipset PCI Express dla Intel Pentium 4. Nieoficjalnie mówi się o mostkach północnych serii Rx400 wyposażonych w jeden PCI-E x16, cztery PCI-E x1 oraz dwa dodatkowe kanały PCI-E służące za magistralę do połączenia z mostkiem południowym SB400 (już bez dodatkowych PCI-E x1). Również i ATI Technologies pichci chipset PCI Express dla Intel Pentium 4. Nieoficjalnie mówi się o mostkach północnych serii Rx400 wyposażonych w jeden PCI-E x16, cztery PCI-E x1 oraz dwa dodatkowe kanały PCI-E służące za magistralę do połączenia z mostkiem południowym SB400 (już bez dodatkowych PCI-E x1). |

Niestety nikt oficjalnie nie przyznaje się do chęci przygotowania chipsetu PCI Express dla procesorów serii Athlon XP bo byłoby to sprzeczne z interesem firmy AMD. Być może VIA nie ugnie się pod naciskiem producenta procesorów i chipset KT890 ujrzy światło dzienne. Byłaby to szansa na faktycznie tani system oparty na nowym standardzie.

Oferta kart

Skoro mamy nowe złącze graficzne to producenci muszą nam przygotować serię zgodnych z nim kart. W chwili obecnej rynek kart dla graczy komputerowych, w zdecydowanej części, opanowały firmy ATI i nVidia i to właśnie na nich chciałbym się skoncentrować. Już w chwili wejścia na rynek pierwszych płyt wyposażonych w PCI-E x16 obie firmy miały przygotowany zestaw kompatybilnych kart, adaptując dla potrzeb nowej magistrali istniejące już układy graficzne.

nVidia zdecydowała się na wykorzystanie istniejącej już grupy układów, przystosowanych do współpracy z AGP. Aby możliwe było połączenie ich z PCI-E x16 opracowała dodatkowy układ o charakterze mostkowym, o nazwie HSI (High Speed Interconnect). Wprawdzie w ten sposób karty nie są w stanie wykorzystać większości dodatkowych zalet nowego złącza, ale w istotny sposób ogranicza to koszty związane z przygotowaniem nowych rdzeni. Co ciekawsze, w oparciu o podobny mostek, można w przyszłości dostosować dedykowane rozwiązania PCI-E x16, do potrzeb starszych płyt AGP x8. Dodatkowy układ niestety grzeje się tak, że niezbędne jest stosowanie radiatora, co oprócz pogorszenia bilansu energetycznego prowadzi do większego komplikowania konstrukcji karty i oczywiście podraża jej koszt. Stąd też pomysł nVidia nie został specjalnie ciepło przyjęty przez producentów. Oczywiście nVidia przygotowała całą "nadbudowę" marketingową, mającą na celu przekonanie potencjalnych klientów, że HSI z AGP daje niemal to samo co PCI Express, co jest oczywistym naciąganiem faktów technicznych. Wprowadzone rozwiązanie faktycznie zachowuje się w operacjach na złączu nieco lepiej, niż klasyczna karta AGP x8, ale resztę pozostawmy już specom od sprzedaży. Dla mnie, z praktycznego punktu widzenia gracza, nie ma to większego znaczenia. W najbliższym czasie w ogóle nie spodziewam się zysku wydajnościowego związanego z samym gniazdem, więc nie powinno nikomu przeszkadzać rozwiązanie z HSI.

Tańsze karty nVidia PCI-E x16 oparte zostały na rodzinie GeForceFX i dostały w nazwie wyróżnik PCX. Wykorzystano układy z serii FX5200, FX5700 oraz FX5900, przygotowano nowe konstrukcje płytek, czasem nieznacznie zmieniono taktowania rdzenia i pamięci. Układ graficzny oddalono od złącza i w tym miejscu umieszczono, chłodzony dodatkowym radiatorkiem, mostek HSI. W droższych modelach wykorzystano rdzenie NV40 o taktowaniu i ilości potoków identycznych z kartami GF6800U oraz GF6800. HSI udało się umieścić we wspólnej obudowie, wraz z układem graficznym. Pierwsze karty z pełną obsługą PCI Express to GF6600/6600GT. Nowy będzie też proces technologiczny 0.11um. Jeśli pojawią się wersje AGP tych kart, to będą wyposażone w mostek (tym razem tłumaczenie sygnałów dla AGP).

ATI, w odróżnieniu od nVidia, od razu przygotowało serię kart z "natywną" obsługą PCI-E x16. Marketing wsparł to odpowiednim tekstem o "prawdziwym PCI Express". Oczywiście, że jest to bardziej "eleganckie" podejście, choć jak wspominałem, oprócz uproszczenia konstrukcji karty i zmniejszenia ilości wydzielanego ciepła, nie mamy na co więcej liczyć. Przynajmniej na razie. Podobnie jak w przypadku nVidia, wszystkie karty ATI PCI-E wspierają Dx9. Segment najtańszych kart otwiera seria X300 oparta na rdzeniu wywodzącym się z układu wykorzystywanego w Radeonach 9600. Podobnie jak wyżej taktowane X600. Najdroższe karty z grupy X800 to odpowiedniki tych samych konstrukcji dla AGP. Jeszcze w tym miesiącu dojdą do nich karty X700, których architektura wywodzi się z X800, natomiast ilość potoków została ograniczona do ośmiu. X700 będą pierwszymi kartami ATI, wykonanymi w technologii 0.11um.

Warto zwrócić uwagę na kwestię możliwości dostarczenia karcie energii przez gniazdo graficzne PCI Express x16. Złącze AGP było w stanie przekazać ok. 25W co powodowało, że mocniejsze karty miały dodatkowe gniazda zasilania. W przypadku GF6800U nawet dwa, z uwagi na możliwość przekroczenia specyfikacji pojedynczej wtyczki Molex. Karta PCI-E x16 będzie miała do dyspozycji 75W. Prawdopodobnie, dzięki temu nie będzie potrzebna dodatkowa energia prosto z zasilacza. Jeśli byłoby to jednak wymagane, to opracowano również nowy standard gniazda 12V, które może karta wykorzystać. Jako, że nie spodziewam się gwałtownego rozwoju zasilaczy wyposażonych w odpowiednie wtyczki, to warto zadbać, aby w zestawie z wymagającą kartą znalazł się odpowiedni kabelek przejściowy. Miłośników modyfikacji chłodzenia może zainteresować fakt zwiększenia możliwości obciążania złącza masą karty. W stosunku do AGP nastąpił wzrost z 250g na 450g.

Aby łatwiej przyswoić sobie zaoferowany przez ATI i nVidia zestaw kart PCI Express x16 pozwoliłem sobie wykonać tabelkę zbiorczą (świadomie pominąłem wersje z 64-bitowymi pamięciami) z najważniejszymi parametrami i teoretyczną wydajnością. Kolejność wg. FillRate.

(kliknij, aby powiększyć)

Niektóre z tych informacji mają charakter nieoficjalny więc proszę je traktować z pewną dozą krytycyzmu (prosiłbym o weryfikację na e-mail, jeśli ktoś znajdzie nieścisłość). Należy również pamiętać, że konkretne konstrukcje kart mogą różnić się od ustalonej wcześniej specyfikacji. Zwłaszcza w kwestii pamięci lokalnej. W większości przypadków wydajność kart powinna być znana, dzięki testom ich odpowiedników na złącze AGP. Najwięcej niewiadomych kryją najnowsze serie GF6600 oraz X700. Niestety na ich testy trzeba będzie jeszcze poczekać.

Gigabyte GA-8GPNXP Duo

Platforma testowa

Przyszedł czas aby sprawdzić jak to działa w praktyce. Test umożliwiła mi firma Gigabyte, która podesłała niemal całą platformę PCI Express do testów. W jej skład wchodziła płyta Gigabyte GA-8GPNXP Duo, procesor Intel Pentium 4 3.2GHz LGA775, 2x256MB DDR2 533MHz CL4 na kościach Samsunga oraz wentylator Gigabyte GH-PCU31-VH (3DCooler-UltraGT) wraz z firmową przejściówką umożliwiającą jego montaż na Socket 775. Wprawdzie nie piszę recenzji płyt głównych, ale w tym przypadku nie mogę się powstrzymać przed krótkim opisem wraz z kilkoma subiektywnymi przemyśleniami.

Niektóre elementy testowe...

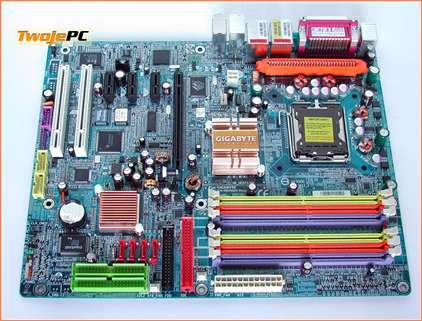

Gigabyte GA-8GPNXP Duo

Gigabyte GA-8GPNXP Duo to dosyć szczególna propozycja. Producent postanowił wprowadzić na rynek bardzo bogato wyposażony model, oparty na chipsecie i915P, który miał stanowić bazę tańszych płyt PCI Express. Dla najbardziej wymagających klientów przeznaczono chipset i925X. Należy jednak pamiętać, że i925X nie obsługuje pamięci DDR i prawdopodobnie jest to właśnie jedna z przyczyn skierowania na nią uwagi niektórych klientów. Co tworzy dodatkową wartość tej płyty?

Spore pudło (kliknij, aby powiększyć)

Wyposażenie (kliknij, aby powiększyć)

Dodatek "Duo" przy nazwie płyty oznacza, że oprócz czterech slotów DDR mamy również dwa dodatkowe, przystosowane do obsługi DDR-2 (bez możliwości jednoczesnego użycia obydwu typów pamięci). Oprócz kontrolera IDE zawartego w droższej, macierzowej wersji mostka południowego ICH6R mamy dodatkowy układ ITE IT8212F, z dwoma kanałami Raid PATA (razem do czterech urządzeń, a w zasadzie dysków, bo kontroler nie "widzi" napędów optycznych). Są trzy porty FireWire nowszego standardu IEEE 1394b 800Mbps, wyprowadzone z układu Texas Instruments oraz karta PCI z kontrolerem wydajnej sieci bezprzewodowej IEEE 802.11g 54Mbps. Mamy również na płycie aż dwa układy sieciowe 10/100/1000Mbps (Marvell 8001 oraz Broadcom 5751 PCI-E x1). Warto też pamiętać o zestawie oprogramowanie, z pełną wersją Norton Internet Security 2004 na czele. Są również dwa autorskie rozwiązania Gigabyte'a. Jednym z nich jest bios oparty na podwójnych, niezależnie programowanych układach (DualBIOS) zabezpieczający użytkownika przed uszkodzeniem lub celowym bądź przypadkowym skasowaniem jego zawartości. Drugi to najnowsza wersja, równolegle działającego modułu, zawierającego bardzo wydajny stabilizator napięcia dla procesora (U-Plus D.P.S). Proszę zwrócić uwagę, że wymieniłem tylko elementy wyposażenia, których możemy nie znaleźć w tańszych wersjach płyt i915P.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Jeśli chodzi o rozkład elementów na płycie to specjalnego zachwytu nie odczułem. Nagromadzona ilość dodatków z reguły wymusza pewne kompromisy, na etapie projektowania laminatu. Mojego entuzjazmu na pewno nie wzbudziło poziome ułożenie gniazd FDD i PATA, a do tego umieszczenie ich na wysokości gniazda graficznego. Jeśli mamy kartę długości typowej dla mocniejszych produktów nVidia, to od razu odradzam pomysł z wciskaniem taśm bez wcześniejszego wyjęcia grafiki. Do tego musiałem je mocno wygiąć, aby nie zaczepiały o elementy karty przy montażu. Prawdę powiedziawszy i tak niektóre elementy stabilizatora na karcie "leżały" na nich, co raczej nie pomaga w chłodzeniu. Życzyłbym sobie również położenia gniazda ATX12V tak, aby kabel z zasilacza nie musiał omijać procesora, choć zdaję sobie sprawę, że tak jest ono tak umieszczone w większości płyt głównych. Wydaje się również, że na decyzję ograniczenia ilości PCI do dwóch złączy, jest nieco za wcześnie. Co ważne, dołączona karta sieci bezprzewodowej zajmie jeden z nich i na rozszerzenia pozostanie tylko jeden port PCI. Pomimo bogactwa zintegrowanych dodatków może się okazać, że jest to za mało. Dobrym pomysłem jest za to umieszczenie pod złączem graficznym gniazd PCI-E x1 a nie PCI, jak w wielu innych konstrukcjach.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Moduł zasilania DPS oraz DualBIOS to przede wszystkim elementy przyciągania klienta. Z jednej strony niektórzy mogą powątpiewać w ich realną przydatność, ale chyba nikt nie zaprzeczy, że są to elementy wskazujące na możliwości producenta, w zakresie wdrażania autorskich rozwiązań w sprzęcie dla masowego odbiorcy, a to już niewątpliwie świadczy o jego rozwiniętym zapleczu technicznym. Nowa wersja DPS (Dual Power System) Gigabyte'a wprowadza w zasadzie jedną, choć bardzo istotną zmianę. Przemyślne, miedziane, pasywne chłodzenie, oparte na technologii heat-pipe, z dodatkowym efektem wizualnym w postaci niebieskich diod, pokazujących stan pracy stabilizatora. Biorąc pod uwagę moją niechęć do przerostu wentylatorów (element zawodny i hałaśliwy) muszę przyznać, że jestem pod wrażeniem. Bardzo pozytywnie oceniam również kwestię chłodzenia mostka północnego. Jest duży radiator, który w typowych warunkach pracy wystarcza do schłodzenia układu, ale jest również, dla bardziej wymagających, dodatkowy, mocowany na zatrzask, podświetlany na niebiesko wentylator.

Instalacja systemu oraz wszystkie testy kart graficznych przeszły bez zacięć. Mogłem odnotować bardzo wysoką "kulturę" pracy płyty. Jak na nowy chipset i pierwszą wersję BIOS'a, system działał znakomicie. Pulpit nie "dusił się" po wymuszeniu kilku różnych działań, nowy kontroler IDE jest (moim zdaniem) najlepszy w swojej klasie, nie odnotowałem też żadnych przykrych niespodzianek związanych ze współpracą sprzętu z oprogramowaniem. Oczywiście trzeba pamiętać, że aby powiedzieć coś konkretnego na temat kompatybilności softu, trzeba wielu tygodni wnikliwych testów. Ja miałem niewiele czasu. Współpraca z posiadanymi kartami PCI oraz sterownikami do opartych na nich urządzeń przebiegła bez zakłóceń. Nie było również problemu po "powieszeniu" na portach USB wszystkich moich "zabawek" w tym standardzie (nie mogę tego powiedzieć np. o żadnej płycie nForce2 jaką miałem okazję sprawdzać). Jedyne zgrzyty wystąpiły w kwestii kompatybilności z pamięciami. Wprawdzie wielogodzinne testy w grach niczego nie wykazały, ale zapuszczenie na noc przekodowania plików z filmami wymusiło problem. Diagnoza wskazała na kwestię współpracy z pamięciami. Po obniżeniu taktowania testowanych Samsungów DDR2-533 CL4 poniżej specyfikacji, system odzyskał 100% stabilności. Podobne problemy miałem z Hynix'ami DDR-400 CL3, które na płytach i865/875 potrafiły działać przy 250MHz, a na GA-8IGPNXP Duo musiałem je ręcznie ograniczać. Muszę przyznać, że w zasadzie byłem na to przygotowany, bo to stała bolączka nowych płyt, a w szczególności ich BIOS'ów. Mam nadzieję, że wraz z nowym BIOS'em, który ukazał się w sierpniu (nie zdążyłem go użyć) sytuacja uległa poprawie (tym bardziej, że wprowadza on kilka istotnych zmian związanych z obsługą pamięci).

GA-8GPNXP Duo nie jest moim zdaniem przeznaczona dla nałogowych "overclockerów", ale i nie można mu odmówić kilku ważnych umiejętności. W przypadku płyt opartych na chipsetach i915/925, do takiego grona można zaliczyć jedynie konstrukcje ze "sztywnym" taktowaniem PCI oraz możliwością zmiany napięcia mostka północnego (>1.8V). W testowanym systemie udało się podkręcić procesor do wartości 3.85GHz. W przypadku rdzenia D0, w które wyposażone są wszystkie Prescott'y LGA775, nie jest to żaden wyczyn. W konkretnym przypadku, na przeszkodzie stanęła pamięć, a w zasadzie jej częściowa niekompatybilność z aktualnym Biosem. Mostek północny dostaje wystarczające napięcie do przełamania blokady przed podkręcaniem (grzejąc się przy tym niesamowicie). Dzięki temu może pracować przy ok. 250MHz taktowania. Niestety ze względu na brak blokady częstotliwości PCI można się spodziewać problemów już przy niższym zegarze. Pierwszy przestaje działać kontroler Serial ATA. W zasadzie na przekroczenie 240MHz nie co liczyć. Ta ostatnia wartość mogę uznać za wyznacznik możliwości tej płyty w zakresie podkręcania.

W zasadzie to byłoby na tyle w kwestii płyty. Sądzę, że zasługuje ona na oddzielny, dedykowany artykuł, ale nie należy to już do kręgu moich zainteresowań. Tym bardziej, że zbyt często, czytając inne testy, mam obawy, że stawiam płytom głównym zbyt wysoką poprzeczkę i być może moja opinia po drobiazgowym teście, mogłaby być trochę zbyt krzywdzące. Łaknącym większej wiedzy na temat płyt i915/i925 polecam recenzję Lancera.

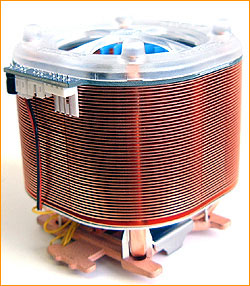

Na koniec parę słów na temat chłodzenia procesora. Gigabyte 3DCooler-Ultra GT to potężna konstrukcja (780g), która nie miała najmniejszych problemów z odprowadzaniem ciepła z testowanego Prescott'a. Przemyślna konstrukcja turbinowa, wsparcie różnych rodzajów procesorów, miedź, heat-pipe, prosta instalacja, brak specjalnych wymogów w stosunku do miejsca na płycie głównej, duża efektywność, regulacja obrotów z wyprowadzeniem zarówno na śledzia, jak i na panel przedni peceta, niezależne zasilanie, odczyt obrotów przez płytę, czy podświetlanie niebieskimi diodami należą do niewątpliwych zalet tego chłodzenia. Podstawową wadą jest dla mnie kwestia hałasu, związanego z pracą wentylatora. Nigdy nie ukrywałem, że należę do grupy preferujących ciszę kosztem wydajności.

Testowany 3Dcooler-Ultra był w wersji GT, która wskazuje na przynależność do grupy o nieco innych preferencjach. Przy maksymalnych obrotach (ok. 4500 rpm) bez wątpliwości mógłby odprowadzić ciepło z Prescott'a >4GHz, ale i spokojnie nagłaśniał nawet duże pomieszczenie (dla mnie to był wręcz ryk). Natomiast przy minimalnych (ok. 2000 rpm) mógłbym uznać, że jest co najwyżej akceptowalny (w głośniejszych pecetach być może nie byłoby go słychać, a do konstrukcji cichych, moim zdaniem się nie nadaje). Przy minimalnych obrotach nie miał problemu z 3.2GHz, ale po podniesieniu taktowania procesora do 3.8GHz, musiałem je nieco zwiększyć. Cooler dopasował się świetnie, zarówno konstrukcyjnie (dmucha również na radiator DPS'a) jak i wzorniczo (niebieskie diody), do testowanej płyty. Przypominam, że Gigabyte ma w ofercie również cichsze wersje chłodzenia, oparte na tej samej konstrukcji.

W związku z tym, że Gigabyte 3DCooler-Ultra GT nie jest "natywnie" przystosowany do współpracy z płytami Socket 775, to wraz z nim dostałem specjalną ramkę, która jest "koszykiem" zgodnym z konstrukcjami S478, natomiast przygotowanym do instalacji w nowych płytach. Gigabyte LGA775RM (G-RM775) jest, jak twierdzi producent, pierwszym tego typu rozwiązaniem. W związku ze słabą dostępnością dobrych wentylatorów dla LGA775 jest to, moim zdaniem, pomysł trafiony w dziesiątkę. Oczywiście pod warunkiem, że ramka będzie pasowała nie tylko do chłodzenia firmy Gigabyte, produkt stosunkowo szybko pojawi się w sprzedaży, a cena będzie umiarkowana. Zwracam jednak uwagę na fakt, że przebicie możliwości oryginalnego chłodzenia Intel "Box" dla Socket 775, nie jest łatwe.

nVidia GeForce 6800 GT 256MB

Mój pierwszy kontakt z PCI Express x16 ograniczył się do trzech kart, które udało się wypożyczyć. Wszystkie karty były egzemplarzami testowymi, pozbawionymi wyposażenia. Każdej jednak, oczywiście należy się krótki opis.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Z firmy nVidia przyjechał do mnie referencyjny egzemplarz karty GF6800GT, w wersji PCI-E x16. W związku z tym, że testowałem już wersję AGP tej karty to ograniczę się do opisania różnic. Trzy najważniejsze to:

- Złącze PCI Express x16 zamiast AGP 8x.

- Złącze SLI w górnej części laminatu.

- 2x DVI zamiast VGA + DVI. Tak jak w wersji Ultra.

- Stabilizator napięcia wyposażony w specjalne gniazdo. Wraz z kartą dostałem przejściówkę na 2x Molex co umożliwiło bezpośrednie podłączenie do zasilacza.

Z domyślnych 350/500MHz udało się uzyskać przetaktowanie do wartości 425/590MHz. Różnic w kwestii jakości obrazu, pracy chłodzenia czy poboru energii nie było. Stosunkowo głośny wentylator (nawet po zmniejszeniu obrotów przez sterownik), znakomita jakość obrazu w testowanym zakresie (do 1600x1200@85Hz), temperatura pracy do 55-60 stopni w zależności od miejsca pomiaru, max. ok. 80W. Mostek HSI umieszczono w jednej obudowie wraz z rdzeniem graficznym.

(kliknij, aby powiększyć)

Trudno powiedzieć, czy karta trafi do sprzedaży detalicznej (pierwsze informacje mówiły jedynie o 6800 i 6800U w wersji PCI-E), ale nie spodziewam się, aby mogła być tańsza od wersji AGP.

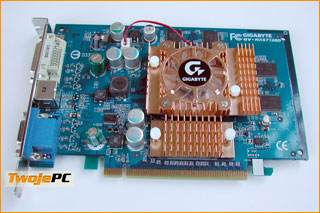

Gigabyte GeForce PCX-5750

Pełna nazwa Gigabyte GeForce PCX-5750 128MB (GV-NX57128D). Wraz z platformą testową PCI Express, firma Gigabyte zapewniła również kompatybilną z tym złączem kartę. GeForce PCX-5750 to nic innego, jak znany z wcześniejszych testów GeForceFX 5700, w wersji dla PCI-E. Kompatybilność z nowym złączem zapewnia, opisany wcześniej mostek HSI, umieszczony pomiędzy złączem a układem graficznym, wyposażony w dedykowany radiator.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Niebieski laminat klasycznych rozmiarów, osiem kości DDR TSOP Samsung 3,6ns (łącznie 128MB) po obu stronach płytki bez dodatkowego chłodzenia, niewielki radiator wraz z 2-pinowym wentylatorem, mocowany na dwóch kołkach. Na śledziu VGA, TV-Out (miniDIN 4-piny) oraz DVI. Karta waży 175g, a w czasie intensywnej eksploatacji rozgrzewa się do 55-60 stopni (najcieplejsze są pamięci). Obraz 2D bez zarzutów, wentylator średnio-głośny (akceptowalny, ale w cichych pecetach będzie go dobrze słychać). Karta w czasie pracy pobierała ok. 25W mocy z sieci. Kartę udało się przetaktować się z 425/275MHz (wartości referencyjne dla tych kart) do 550/350MHz. Moim zdaniem to znakomity wynik.

W wersji sklepowej, wraz z kartą powinna znaleźć się gra SpellForce - Order of Dawn oraz PowerDVD 5.0. Cena ok. 800 zł. Gwarancja 3-lata.

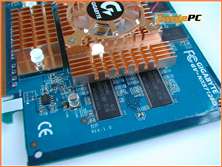

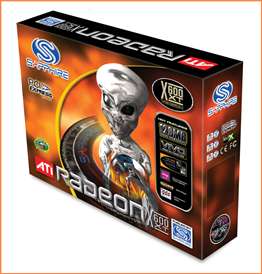

Sapphire Radeon X600 XT

Pełna nazwa Sapphire Radeon X600 XT 128MB VIVO. Firma Sapphire dostarczyła do testów kartę Radeon X600XT w wersji VIVO 128MB. Jest to odpowiednik Radeona 9600XT. Różnice to "natywna" obsługa interfejsu PCI Express oraz wyższe taktowanie pamięci.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Czerwony laminat klasycznych rozmiarów, osiem kości DDR BGA Hynix 2.8ns (łącznie 128MB) po obu stronach płytki bez dodatkowego chłodzenia, niewielki "orbopodobny" radiator wraz z 2-pinowym wentylatorem mocowany na dwóch kołkach. Na śledziu VGA, VIVO (miniDIN 9-pinów) oraz DVI. Karta waży 160g, a w czasie eksploatacji rozgrzewa się do 50-55 stopni (najcieplejsze są pamięci). Obraz 2D znakomity (sprawdzane do 1600x1200@85Hz), wentylator średnio głośny, nieco cichszy niż testowanego Gigabyte'a na PCX-5750. Poziom akceptowalny choć sam bym jeszcze starał się go dodatkowo wyciszyć. Pobór mocy z sieci to ok. 35W. W stosunku do referencyjnych wartości 500/370MHz, karta miała niedotaktowane pamięci (2.8ns to niecałe 360MHz). Z domyślnych 500/350MHz uzyskałem jedynie 565/360MHz.

Wersja X600XT 128MB VIVO spodziewana jest w sklepach za ok. 950 zł. Gwarancja 2 lata.

Testy

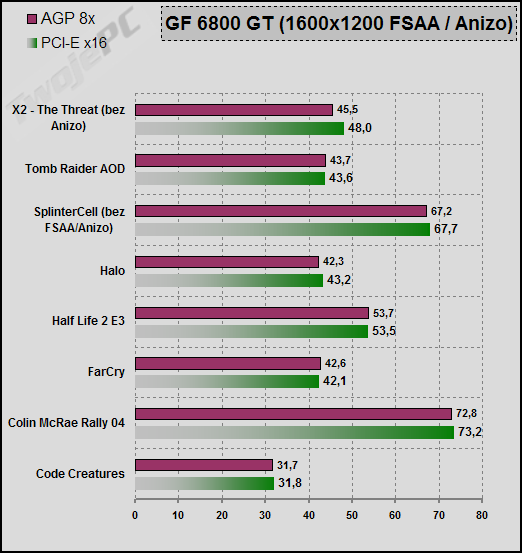

Tak się złożyło, że testy PCI Express zbiegły się z przygotowaniem materiału do recenzji kart nowej generacji, opartych na AGP. Korzystając z okazji mogłem bezpośrednio porównać np. wyniki kart nVidia GeForce 6800 GT, w wersjach na oba złącza. W chwili obecnej nie da się wyeliminować problemu różnic w testowych platformach sprzętowych z uwagi na brak na rynku chipsetu, który umożliwia uruchomienie kart zarówno AGP, jak i PCI Express. Karty AGP aktualnie testuję na systemie Asus A7N8X, 1GB DDR-400, AMD XP (Barton) 2500MHz. Jednak ze względu na takie dobranie parametrów gier testowych, aby zminimalizować różnice związane z wydajnością np. procesorów miałem nadzieję, że ich wpływ faktycznie będzie pomijalny. Ustawienia gier testowych były zgodne z wcześniejszymi recenzjami. Maksymalna jakość obrazu i FSAA 4x/Anizo 8x (ustawienie w grach lub wymuszenie w sterowniku tam, gdzie było to niemożliwe). Sterowniki nVidia 65.77 oraz ATI 4.8. Windows XP SP1.

Jeśli ktoś się spodziewał deszczu wyników fps, w odniesieniu do nowych kart, to raczej będzie zawiedziony. Ta recenzja przede wszystkim dotyczy kwestii związanych z wprowadzeniem nowego standardu. Interesowało mnie zachowanie się nowego rodzaju kart, w odniesieniu do nowej platformy. W zasadzie kwestia samej wydajności miała drugorzędne znaczenie, bo szczerze powiedziawszy nie była dla mnie niewiadomą. Nie spodziewałem się uzyskać konkretnych różnic w realnych zastosowaniach, w związku z samym zwiększeniem przepustowości złącza, o czym napisałem wcześniej, w części teoretycznej. Również znając wydajność danego modelu karty można łatwo wywnioskować kwestię różnic, przy niewielkich zmianach taktowania rdzenia czy pamięci.

Niestety w związku z tym, że spośród trzech kart PCI Express jakie miałem do dyspozycji, jedna z nich należała do zupełnie innej kategorii, zarówno cenowej, jak i wydajnościowej, bo niezależnie od ustawień testowych gier, zawsze któraś z nich była w jakiś sposób "pokrzywdzona" wynikami. Ograniczając tryb testowy powoduję odciążenie najmocniejszej karty w stopniu, który uniezależnia wyniki jej testów, od jej realnej mocy (brak przełożenia wyników na wydajność). Natomiast ustawienia, które ją dociążają, omijają kwestię optymalizacji słabszych kart, dla danego typu zastosowań. Podobne zastrzeżenia miałem w poprzednim teście, przy bezpośrednim porównaniu, w najwyższych trybach, kart o różnej ilości pamięci lokalnej. GF6800 tracił w porównaniu do kart 256MB więcej niż powinien. W przypadku kart średniej i niższej klasy zawsze są konkretne kompromisy, związane z wydajnością. Typowym posunięciem jest zwiększenie asymetrii przepustowości pamięci lokalnej w stosunku do FillRate. Po prostu zakłada się, że tańsza karta przeznaczona jest do pracy w niższych trybach i kwestia zapychania magistrali jest mniej uciążliwa, niż możliwości wykonania programu shaderów. Tyle dygresji.

Pierwsza tabelka przedstawia porównanie dwóch kart GF6800GT, działających na zupełnie różnych platformach sprzętowych, w trybie maksymalnie je obciążającym.

W zasadzie niemal we wszystkich testach rozbieżności wyników mieściły się w granicach błędu pomiarowego. Jedynym wyjątkiem był X2 (ok. 5%). Jednak przy różnych platformach testowych (inne procesory) jest to za mało, na choćby cień nadziei zysku, na samym złączu.

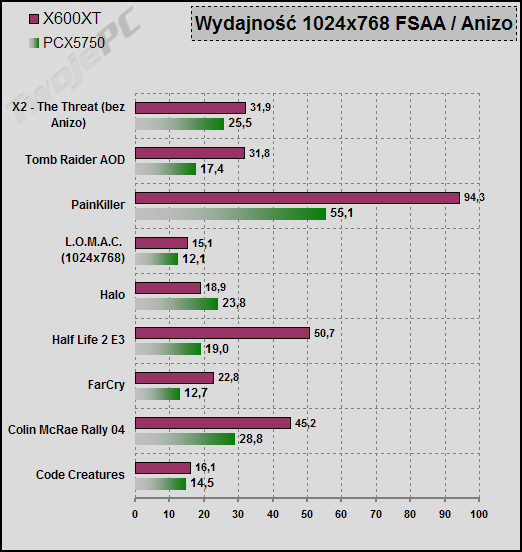

Z punktu widzenia użytkownika systemu PCI Express (lub chętnego na jego zakup) najciekawsze może być porównanie wyników dwóch kart, konkurujących w zbliżonej kategorii cenowej. Chodzi oczywiście o PCX5750 oraz RX600XT. W związku z ich możliwościami, zdecydowałem się na tryb 1024x768 Fsaa/Anizo. Chyba najlepiej odpowiada on wymaganiom potencjalnego klienta, w stosunku do tych kart.

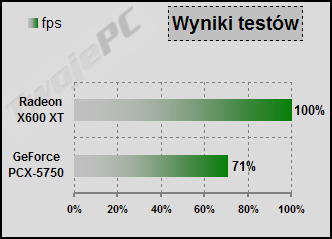

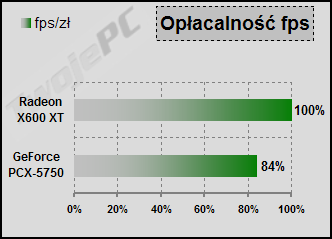

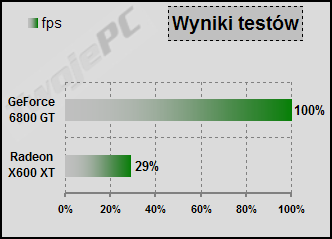

Sądzę, że znając wcześniejsze wyniki testów kart FX5700 oraz R9600XT, większość przewidziała rezultat tego porównania. Żaden specjalny cud się nie wydarzył. Z wyjątkiem gry Halo (jest to niewątpliwa ciekawostka) przewaga X600XT nad konkurentem była bardzo duża. Mając większy FillRate, lepszą przepustowość pamięci i znając ogólną słabość FX'ów w PS2.0 trudno o inny obraz wydajności. W części "uczta numerologa" postaram się uśrednić te różnice i odnieść do cen zakupu. To w zasadzie jest najważniejsze.

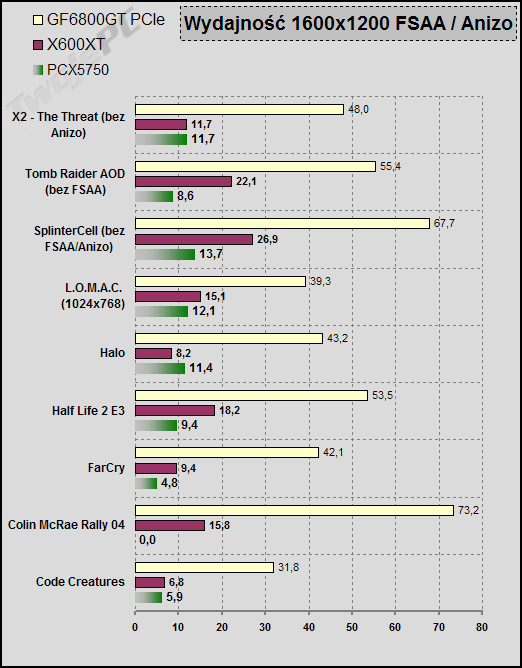

Na koniec dokonałem masakry, w postaci zestawienia ze sobą wszystkich kart w 1600x1200.

Zastrzeżenia co do takiego porównania podałem już wcześniej. Niewątpliwie tabelka może mieć negatywny wpływ na samopoczucie posiadaczy tańszych kart, a uszczęśliwiać tych, którzy zdecydowali się wydać na kartę sumę, przekraczającą 2000 zł. Przypominam, że słabsze karty po prostu się nie nadają do tych trybów, a w niższych lub przy mniej agresywnych ustawieniach, mogą dać z gry niewiele słabszą frajdę. Natomiast jeśli ktoś ma apetyt na tak wysokie rozdzielczości to po prostu, musi być go na to stać.

Oczywiście nie zapomniałem również o miłośnikach podkręcania. Testy w 1600x1200 bez dodatków FSAA/Anizo. Tomb Raider ze względu na dobre oddawanie zmian częstotliwości rdzenia, a Splinter Cell ze względu na reakcję na przepustowość kanału pamięci. Sumaryczny wynik podkręcania to średnia arytmetyczna z tych dwóch testów.

Najkorzystniej wypada na tym polu Gigabyte PCX-5750. 20% jest w stanie przynieść odczuwalną poprawę w przypadku wielu gier. 13% referencyjnej karty nVidia już nie nastraja takim optymizmem choć jest to wartość, która powinna przypaść do gustu przynajmniej ze względu na wpływ na wyniki testów fps. Natomiast Sapphire X600XT stawia zbyt wyraźny opór przez podkręcaniem i osobiście w ogóle nie widzę sensu, aby go do tego zmuszać.

Uczta numerologa

W związku z tym, że wielkość różnic pomiędzy wynikami nie jest stała to, aby usystematyzować rezultaty testu, już w poprzednich recenzjach wprowadziłem konkretną metodę ich zestawienia. Mogę jedynie powtórzyć, że w skrócie, jest to przeliczenie różnic wyników na skalę punktową 0-10 (najlepszy wynik dostaje 10 punktów, a reszta proporcjonalnie), wyciągnięcie średniej i porównanie jej w skali procentowej. Przypominam, że jest to konkurs wyników, a nie wydajności.

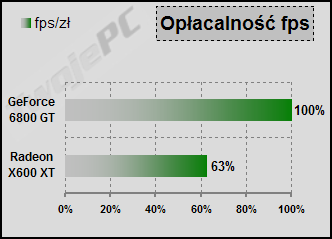

W konkursie pomiędzy PCX-5750 a X600XT wygrał Radeon, notując niemal 30% wyższe wyniki. Dodatkowo, w związku z tym, że jego cena różni się w mniejszym procencie niż zwyżka fps w testach, to i w tabeli opłacalności stoi przed swoim konkurentem.

Z ciekawości zrobiłem również zestawienie pomiędzy 6800GT a X600XT.

Wyniki są oczywiście druzgocące dla tańszej karty. Chciałem jednak zwrócić uwagę na coś ważniejszego. Wprawdzie GF6800GT w wersji PCI-E nie jest obecny na rynku i nie znam jego ceny, to biorąc pod uwagę wersję AGP łatwo można przekonać się o zbyt dużej cenie tańszych kart na to złącze. Oczywiście nie trzeba do tego jakiegoś specjalnego porównania. Te karty mają swoich odpowiedników AGP, od których praktycznie nie różnią się wydajnością, natomiast mają przy tym znacznie wyższą cenę.

Co dalej?

W związku z tym, że cały ten artykuł nawet i mnie wydaje się nieco chaotyczny, spróbuje podsumować najważniejsze tezy oraz wyciągnąć z niego w skrócie to, co moim zdaniem ma podstawowe znaczenie.

Na wstępie chciałbym powtórzyć to, co napisałem w pierwszym akapicie. Przed PCI Express nie uciekniemy. Pozostaje jedynie kwestia kiedy nas dopadnie, co na nim zyskamy, a co stracimy. W kwestii wydajności kart graficznych, samo złącze ma drugorzędne znaczenie. Podobnie taktowana karta, oparta na tym samym rdzeniu, będzie zachowywać się tak samo zarówno na PCI-E, jak i na AGP. Ewentualne różnice związane są z samymi układami i ich możliwościami. PCI Express może nam, w przewidywalnej przyszłości (chipset nForce4), dać szansę na zwiększenie mocy przez równoległą pracę dwóch kart (SLI). Możemy się również liczyć z różnicami w ofercie kart, przystosowanych do różnych złączy. Aktualnie mamy sytuację pojawienia się w sklepach nielicznych kart PCI-E taniego i średniego segmentu i do tego w zdecydowanie wyżej cenie, niż odpowiedniki dla AGP. Równie dobrze może jednak nastąpić odwrócenie tego trendu. W dalekiej przyszłości wydaje się to dosyć oczywiste, a co z najbliższymi miesiącami? Też muszę przyznać, że istnieje taka możliwość. Przynajmniej teoretycznie.

Pewnie wielu jest pod wrażeniem ostatniej prezentacji GF6600GT. I słusznie, bo karta zapowiada się bardzo smakowicie. Być może dla części, czytających recenzje, miłośników gier komputerowych fakt, że prezentacja dotyczy jedynie wersji PCI Express, pozostał bez echa. Słyszę zewsząd opinie: oczywiście, że zaraz będzie i AGP, nVidia nieoficjalnie potwierdza, dobrze poinformowane źródła również, mają mostek do konwersji trybów itd. Osobiście sugerowałbym pewną ostrożność w takich opiniach. Znamienny wydaje się fakt, że wraz z prezentacją nie dostaliśmy do ręki żadnej informacji na temat terminu ukazania się takiej karty. Być może nVidia nie podjęła jeszcze ostatecznej decyzji i po prostu czeka na rozwój sytuacji na rynku. Z drugiej strony "barykady" mamy jeszcze czytelniejszy sygnał. ATI jak na razie nawet nie ukrywa, że nie ma zamiaru przygotowywać odpowiednika AGP, dla kart serii X700, których premiery możemy się spodziewać w najbliższym czasie. Jeśli rozwój sytuacji przebiegałby według takiego scenariusza, to równie dobrze za dwa, trzy miesiące możemy mieć w segmencie średnim ciekawsze karty na PCI Express, niż na AGP. Być może jest to mało prawdopodobne, ale na pewno możliwe.

Przyjrzyjmy się bliżej, aktualnej ofercie kart graficznych. Nie będę ukrywał, że jak na razie sytuacja jest raczej fatalna. Zacznijmy od najwyższego pułapu cenowego. W związku z tym, że pierwsze systemy PCI Express oparte są na stosunkowo drogich zestawach z Pentium 4, to oferta w tym segmencie powinna wręcz wylewać się w stronę bogatego klienta. A tu mamy pustą półkę sklepową. W niektórych krajach rozpoczęła się sprzedaż RX800XT, ale to w zasadzie byłoby na tyle. Przejdźmy na średnicę cenową. Pojawiły się karty RX600Pro/XT oraz PCX-5900/5750. Miło. Tylko co z tego skoro cena tych pierwszych jest ok. 200 zł wyższa niż odpowiedników AGP i można za nią kupić znacznie mocniejszego Radeona 9800 Pro. A może PCX-5900? Cena ok. 150 zł wyższa niż FX5900XT, a do tego niższe taktowanie (wbrew temu, na co wskazuje brak dodatkowych liter w nazwie). Również nie widzę przeboju. Na temat PCX5750 chyba nawet nie muszę się wypowiadać. Wystarczy spojrzeć na tabelki z "uczty numerologa". No to wejdźmy w najniższy segment. Karty z szyną 64-bitową ominę, bo równie dobrze w grach można korzystać z grafiki wbudowanej w chipset. Co pozostaje? Waleczne, 128-bitowe wersje RX300 oraz PCX-5300. Ten pierwszy to dokładny odpowiednik Radeona 9550, a drugi to FX5200. Karty oczywiście nie rzucają na kolana wydajnością, ale powinny robić to ceną. Niestety znowu mamy magiczny narzut ok. 200 zł, co w przypadku kart low-end zupełnie zmienia ich charakter. Mam nadzieje, że po tym krótkim przeglądzie rodzimego rynku jasna staje się odpowiedź, dlaczego w chwili obecnej nie ma co liczyć na większą sprzedaż.

Pozostaje pytanie kiedy w takim razie PCI Express może zapukać do drzwi przeciętnego Kowalskiego, który właśnie postanowił sprawić sobie nową maszynkę do gier, spod znaku peceta? Oczywiście kluczem do odpowiedzi na to pytanie jest cena oraz dostępność. Po pierwsze, musi być przedstawiona oferta taniej platformy PCI Express. Najwcześniej prawdopodobnie będzie to jednak Intel. W przyszłym miesiącu spodziewana jest premiera Celerona D LGA775 (rdzeń E0, odpowiedniki technologii SpeedStep, NX-bit itd.). Biorąc pod uwagę znakomity kontroler IDE i lepszy "dźwięk" z i915, czy choćby bardzo dobry wentylator "Box" dla Socket-775, to być może wystarczy, aby nawet w tym segmencie zdecydować się na ok. 150 zł droższą (na razie nie zakładam zmian relacji cen) płytę dla PCI Express. Być może również VIA "postawi" się AMD i wprowadzi na rynek KT890, dla tanich Sempronów Socket-A. Nie można tego przecież wykluczyć. Zanim to jednak nastąpi to przede wszystkim musi pojawić się ciekawsza oferta kart (stosunek możliwości do ceny). Dzięki ostatnim prezentacjom nVidia, i spodziewanym ATI, są jednak pewne przesłanki dla umiarkowanego optymizmu. Powiedzmy, że planujemy zakup komputera za dwa miesiące i mamy dostępny następujący, przykładowy system: tańsza wersja i915, najmniejszy nowy Celeron D Box, którego nie omieszkamy nadtaktować oraz GeForce 6600/6600GT z podstawowym wyposażeniem. Czy jest to odległy w czasie, i tak bardzo zły przykład, że nie potrafimy go sobie wyobrazić, czy zaakceptować, w kwestii wydajności w grach lub ceny? A czy jest to bardzo odległy termin? To pytanie chciałbym zadedykować wszystkim tym, którzy są święcie przekonani, że PCI Express to jakaś bardzo odległa dla nich wizja jakiegoś mało interesującego sprzętu. Wariant niewątpliwie bardzo optymistyczny, ale niczego nie można dziś wykluczyć, bo to dopiero początek.

W tym miejscu powinienem przemyśleć przyznanie laurek dla testowanego sprzętu. W związku z tym, że karty PCI Express były testowymi egzemplarzami producenta i trafiły do mnie bez wyposażenia, a do tego przed pojawieniem się w sklepach, to nawet nie muszę rozważać przyznania im specjalnych wyróżnień. Jednak w związku z tym, że dwie z nich są już dostępne i wyposażenie jest zgodne z opisem producentów, to chyba mogę potwierdzić ich wysoką jakość oraz akceptowalne walory użytkowe. Zdecydowanie najlepsze wrażenie zrobiła na mnie wersja PCI-E karty GF6800GT ale ona z kolei nie może być brana pod uwagę, ze względu na nieobecność w sklepach. Kompletnym produktem detalicznym była natomiast płyta Gigabyte, która oczywiście również zasłużyła na dobrą ocenę.

Gigabyte GeForce PCX-5750 128MB

Znakomita jakość obrazu, akceptowalny hałas chłodzenia, bardzo dobre możliwości podkręcania, bardzo niska wydajność w stosunku do ceny.

|

Gigabyte GA-8GPNXP Duo

Bogactwo wyposażenia, ograniczenia w zakresie podkręcania, dobra kompatybilność z kartami i urządzeniami USB, dobrze rozwiązane kwestie chłodzenia, zastrzeżenia do obsługi pamięci przez bios

|

Sapphire Radeon X600XT 128MB VIVO

Znakomita jakość obrazu, umiarkowany hałas chłodzenia, bardzo słaba podkręcalność, stosunkowo niska wydajność w stosunku do ceny.

|

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | GIGABYTE Polska |

|  | Sapphire, Inc. |

|  | NVIDIA |

|