Radeon X1800 XT - nowa architektura ATI

Autor: Kris | Data: 17/01/06

|

Cierpliwość miłośników kart opartych na układach kanadyjskiej firmy ATI została wystawiona na ciężką próbę. Przez niemal pół roku w sklepach nie można było znaleźć żadnej karty Radeon, która byłaby w stanie konkurować z najmocniejszą kartą nVidia, znaną pod nazwą GeForce 7800GTX. Najpierw kilka miesięcy trzeba było czekać na oficjalną premierę nowej architektury ATI, a potem kolejne miesiące upłynęły zanim karty pojawiły się z sklepach. Czy układ R520 faktycznie tworzy nową jakość? Czy udało się osiągnąć konkurencyjną wydajność? Cierpliwość miłośników kart opartych na układach kanadyjskiej firmy ATI została wystawiona na ciężką próbę. Przez niemal pół roku w sklepach nie można było znaleźć żadnej karty Radeon, która byłaby w stanie konkurować z najmocniejszą kartą nVidia, znaną pod nazwą GeForce 7800GTX. Najpierw kilka miesięcy trzeba było czekać na oficjalną premierę nowej architektury ATI, a potem kolejne miesiące upłynęły zanim karty pojawiły się z sklepach. Czy układ R520 faktycznie tworzy nową jakość? Czy udało się osiągnąć konkurencyjną wydajność?

Mam nadzieję, że za pomocą tego artykułu uda mi się odpowiedzieć na najważniejsze pytania, dotyczące Radeona X1800XT. W tytułowej roli wystąpi karta wypożyczona przez firmę Sapphire, natomiast konkurenta wystawiła firma Asus. Zapraszam ... | |

|

Rys historyczny

Z reguły, przy testach nowej generacji układów, zaczynam od rysu historycznego i tym razem również nie będę tego unikać. W przypadku produktów ATI ostatnia premiera, którą mogłem z całkowitym spokojem sumienia nazwać rewolucyjną, miała miejsce 3 i 1/2 roku temu, kiedy to w lecie 2002 roku pojawił się Radeon 9700 Pro. Była to pierwsza na rynku karta zgodna z Dx9. W stosunku do poprzednich serii produktów zaoferowano faktycznie nową jakość technologiczną. Wstrząs związany z tą premierą był o tyle większy, że oprócz nowych możliwości układ również i w kwestii wydajności zmiażdżył konkurencję, stając się lokomotywą, która przerwała monopolistyczną pozycję nVidia w zakresie sprzedaży układów dla kart graficznych domowego przeznaczenia. Pojawił się układ dwóch, walczących o klienta, liderów rynku. Nie będę ukrywał, że z naszego punktu widzenia jest to oczywiście bardzo korzystne.

Radeon 9700 Pro vs Radeon 1800XT (kliknij, aby powiększyć)

Pół roku później nVidia przedstawiła własną kartę Dx9. Debiutujący w styczniu 2003 roku GeForce FX5800 oferował nieco większe od konkurencji możliwości w zakresie 3D przy zbliżonej do nowych Radeonów wydajności. Niestety stosunkowo słaba efektywność działania nowej architektury wymusiła na projektantach konieczność zastosowania szeregu ustępstw związanych z funkcjonalnością kart. Monstrualny (na owe czasy) laminat oraz głośne (pierwsza "suszarka") i ciężkie chłodzenie skutecznie wyhamowały możliwość osiągnięcia sukcesu handlowego. Kolejne półtora roku minęło bez specjalnych wstrząsów technologicznych. Podnoszono zegary, dopieszczano architekturę, zmieniano nazewnictwo. W zasadzie przerost marketingu nad produktem. Pojawiły się serie Radeon 9800 oraz GeForceFX 5900.

Dopiero kwiecień i maj 2004 roku przyniosły konkretny powiew świeżości. Przede wszystkim znacząco wzrosła wydajność dzięki podwojeniu ilości jednostek obliczeniowych w samych rdzeniach. Dodatkowy szum medialny zapewniła zmiana standardu złącza graficznego płyt głównych (PCI-Express). Niemal w tym samym czasie na rynek weszły karty serii Radeon X800 oraz GeForce 6800. ATI udało się zachować zbliżony do konkurencji poziom mocy przetwarzania 3D (niewielka przewaga Radeonów), ale w kwestii technologii nVidia wysunęła się na prowadzenie. Wprawdzie z punktu widzenia gracza nie przekładało się to na spektakularne korzyści, a wydajność związana z użyciem nowszych mechanizmów 3D była żenująco niska, to jednak umiejętnie podsycana przez marketing producenta wizja nowych możliwości została skutecznie zaszczepiona potencjalnym klientom. ATI zaczyna powoli odczuwać brak nowej architektury. Kropkę nad "i" postawiła w czerwcu 2005 karta GeForce 7800GTX. Do przewagi technologiczno-marketingowej dorzucono znaczący skok wydajności związany z dalszym zwiększeniem ilości jednostek obliczeniowych rdzenia.

Znajdująca się w defensywie firma ATI, aby wrócić na pozycję, którą wypracowała dwa lata wcześniej musi skończyć z dalszą eksploatacją architektury, której podstawa sięga Radeona 9700 Pro. Plotki i pogłoski na temat układu R520 docierały do uszu zainteresowanych miłośników gier już od dwóch lat. Nowa architektura ATI była przygotowywana od dawna, a dodatkową presję czasową stanowił kontrakt z Microsoft na część graficzną nowej konsoli do gier Xbox360. Informacje te w znaczący sposób osłabiły znaczenie wejścia na rynek GeForce 7800GTX i spowodowały, że część z tych klientów, którzy co pół roku wymieniają karty graficzne wstrzymała "inwestycję" do czasu prezentacji nowego Radeona. Nie wiedzieli jednak, że ich cierpliwość zostanie wystawiona na nieco cięższą próbę, niż się wcześniej spodziewali. ATI podjęła słuszną choć ryzykowną decyzję upchnięcia architektury R5xx w zupełnie nową technologię krzemową 0.09um. Wcześniej szlak nowych technologii produkcji układów przecierany był za pomocą tańszych mutacji układów o sprawdzonej architekturze, ale tym razem ATI zagrała "va-bank". Wprawdzie prototypy R520 ujrzały światło dzienne już pod koniec 2004 roku ale przygotowanie finalnego produktu pochłonęło następne pół roku. Nowy Radeon miał się ukazać niedługo po premierze GF7800GTX, ale kolejne "daty" były przesuwane. Dopiero 5 października nastąpiła oficjalna prezentacja serii X1000 (zwanej inaczej X1K) wraz z "flagową" kartą Radeon X1800XT, opartą na bazowym dla całej rodziny rdzeniu o nazwie kodowej R520. Niestety najmocniejsza karta serii nie pojawiła się na rynku zaraz po "papierowej" premierze. Potencjalni klienci musieli czekać na nią kolejne 2 miesiące z uwagi na problemy z uzyskiem odpowiedniej ilości rdzeni działających z wcześniej zakładaną częstotliwością. W końcu, niemal pół roku po premierze GF7800GTX karty RX1800XT trafiły na rynek i nadszedł upragniony czas na to, aby przyjrzeć się im nieco bliżej no i oczywiście skonfrontować z konkurencją.

Co w krzemie piszczy?

W zasadzie każda kolejna generacja kart reklamowana jest przez producentów układów jako rewolucyjna w zakresie technologii 3D. Niestety rzeczywistość wygląda nieco inaczej. Ostatni konkretny wkład w przetwarzanie 3D pojawił się półtora roku temu wraz z GF6800U, choć i jego trudno nazwać rewolucyjnym. Taką łatkę można natomiast z pewnością przylepić kartom Radeon 9700 Pro oraz GeForceFX 5800 Ultra. Inne premiery zdecydowanie niosły ze sobą jedynie aspekt wydajnościowy. Niezależnie od kwestii głębokości zmian mogę zaryzykować twierdzenie, że w dziedzinie premier architektury 3D w grupie kart Dx9 mieliśmy 2:1 dla nVidia i oczekiwałem od ATI wyrównania tego bilansu. No i z całą odpowiedzialności za słowa muszę przyznać, że się nie zawiodłem. Radeon X1800XT zdecydowanie pokazuje coś nowego kończąc tym samym ponad trzyletnią serie kart opartych na bardziej lub mniej "podpompowanym" rdzeniu R300.

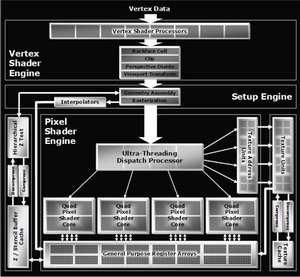

(kliknij, aby powiększyć)

W tym miejscu niestety (dla mnie) muszę poświęcić trochę czasu na udowodnienie tej tezy. Najpierw jednak kilka słów o samym układzie. ATI R520 zawiera 321 mln tranzystorów, które upchano w krzemie 90 nm (+low-k). Mamy więc światowego rekordzistę wśród GPU w ilości tranzystorów oraz pierwszy układ graficzny wykonany w tej technologii. Przyjrzyjmy się mu bliżej.

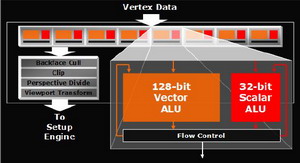

Silnik wierzchołków

Podstawową zmianą jest dostosowanie jednostek arytmetycznych bloku obliczeń geometrii i oświetlenia do wymogów specyfikacji shaderów modelu 3 (SM3). W przypadku R520 kwestia dotyczy dodania dynamicznej kontroli przebiegu oraz możliwości operowania na teksturach. Każdy z procesorów Vertex może wykonać jednocześnie jedną instrukcję skalarną i jedną wektorową. Łącznie układ wyposażono w osiem takich procesorów dzięki czemu jest w stanie w jednym takcie zegara przetworzyć dwa wierzchołki. ATI chwali się możliwością wykonywania 10 miliardów instrukcji Vertex Shadera na sekundę.

(kliknij, aby powiększyć)

Silnik Vertex w znacznym stopniu upodobnił się do konstrukcji nVidia, choć różnice oczywiście są. Jednostka arytmetyczna ATI może przetwarzać 128-bitowe instrukcje wektorowe natomiast GeForce operuje na "klasycznych", 32-bitowych. Ideą tego pomysłu była możliwość emulowania procesora na układzie graficznym. Z resztą rozwiązanie zastosowano również we wcześniejszych konstrukcjach. Muszę przyznać, że choć zmiany w tym bloku rdzenia są znacznie większe, niż w przypadku przejścia nVidia z serii FX na serię 6, to innowacji, które nazwałbym rewolucją osobiście nie dostrzegam. Z resztą to nie Vertex jest aktualnie najwęższym gardłem procesu przetwarzania grafiki aktualnych gier.

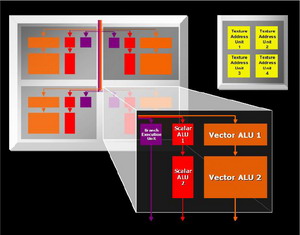

Silnik pikseli

Najważniejsza z punktu widzenia procesu przetwarzania 3D jest część odpowiedzialna za obliczenia pikseli. Już krótkie spojrzenie na schemat rdzenia może u znawców architektury GPU wywołać pewne zdziwienie. Wcześniej sprawa była klarowna. Klasyczny potok pikseli oparty na przynajmniej jednej jednostce teksturowania (TMU), procesorze Shaderów i ROP (Raster Operation) rozwijano przez dokładanie kolejnych modułów. Pierwsze zakłócenie w tym schemacie pojawiło się wraz z GeForceFX, który wprowadził elementy współdzielone dla potoków. GF6 posuwa się jeszcze dalej przez wyprowadzenie z potoków jednostek ROP i zmniejszanie ich ilości w stosunku do pozostałych modułów przetwarzania pikseli. Oczywiście ideą rozwiązania była z jednej strony oszczędność wielkości rdzenia, a z drugiej lepsze wykorzystanie mniejszej ilości bloków. Jeśli potok zawiera szereg modułów, które sekwencyjnie wykonują operacje to naturalnym jest fakt blokowania przez przetwarzany piksel również tej części jego zasobów, które nie uczestniczą w danym procesie. Prowadzi to do zmniejszenia efektywności działania rdzenia, a jego stopień jest ściśle powiązany z rodzajem wykonywanych operacji na pikselu.

(kliknij, aby powiększyć)

Bardziej spektakularną metodą na wyeliminowanie tego zjawiska jest uniezależnienie od siebie poszczególnych modułów potoku tak, aby każdy z nich po wykonaniu operacji mógł być wykorzystany przez inny piksel. Proces przetwarzania miałby wtedy do dyspozycji zestaw jednostek wykonawczych bez przyporządkowania do konkretnego piksela i wykorzystywał je niezależnie od innych. Takie zarządzenie zasobami wymaga zastosowania dodatkowej jednostki nadrzędnej zajmującej się ich dystrybucją, działającej na zasadzie elektronicznego przełącznika. Oczywiście wprowadzenie nowego modułu, przez który przekazywane są informacje o każdym obliczanym pikselu ma negatywny wpływ na wydajność (opóźnienia synchronizacji) ale uwzględniając różnicę efektywności wykorzystania modułów można spodziewać się konkretnego zysku w całym procesie przetwarzania. Drugą zaletą jest możliwość uzyskania asymetrii w ilości poszczególnych modułów i projektowania rdzenia tak, aby lepiej wykorzystać jego powierzchnię. Układ ATI R520 jest pierwszym na rynku rdzeniem, którym w praktyce próbuje realizować taką wizję architektury. Jednostkę odpowiedzialną za dystrybucję zasobów nazwano Ultra-Threaded Dispatch Processor. Powiązane czwórkami (Quad) procesory shaderów zajmujące się operacjami arytmetycznymi na pikselach odseparowano od TMU i jednostek adresujących tekstury. Proces przetwarzania dzielony jest na wątki (thread) związane z identycznymi obliczeniami stosowanymi do grupy pikseli. Radeon X1800XT jest w stanie przetwarzać jednocześnie 512 takich wątków. Informacje o bieżącym stanie każdego piksela przechowywana jest w dedykowanej pamięci podręcznej.

Zmiany dotyczą nie tylko wzajemnych zależności pomiędzy modułami bloku przetwarzania pikseli, ale dotykają również samych jednostek arytmetycznych shadera. Do czterech ALU znanych z wcześniejszych układów ATI dodano jednostkę odpowiedzialną za przetwarzanie instrukcji sterowania przepływem, a dodatkowo w związku z wymogami SM3.0 zwiększono precyzję obliczeń z 24 na 32 bity (bez możliwości stosowania "częściowej" precyzji 16bitowej, jak w układach nVidia). Jeśli do tego dodamy fakt niezależnej pracy modułów operujących na teksturach to mamy teoretyczną możliwość wykonania do 6 instrukcji na piksel w jednym takcie zegara. Oczywiście wynikowa efektywność działania nowej architektury zależy od wielu czynników i nawet pomijając kwestię optymalnego dostosowania do niej sterowników trudno wyrokować cokolwiek bez praktycznych testów w grach. Na dwie kwestie chciałbym zwrócić dodatkową uwagę. Po pierwsze uniezależnienie modułów przetwarzania i wprowadzenie jednostki do ich dystrybucji wydaje się być konkretnym krokiem w jednym z kierunków wyznaczonych przez Windows Graphic Foundation (następca DirectX), w postaci idei "uniwersalnych" shaderów (brak podziału na jednostki vertex i pixel). Po drugie odseparowanie modułów związanych z teksturowaniem od shaderów praktycznie pozbawiło nowy rdzeń potoków pikseli. Przynajmniej w klasycznym tego słowa znaczeniu. Możemy od biedy napisać, że rdzeń zachowuje się jak 16-stopotokowiec z uwagi na fakt tego, że jednocześnie może przygotować do szesnastu pikseli. Problem w tym, że efektywność może mieć zupełnie inną niż układ z typowymi "długimi" potokami. Jeśli do tego wprowadzić asymetrię ilości modułów (shader vs TMU) to w przypadku kodu obciążającego piksele zaawansowani shaderami sumaryczna wydajność będzie zupełnie z innej (niż szesnastopotokowa) bajki.

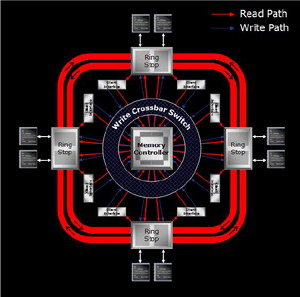

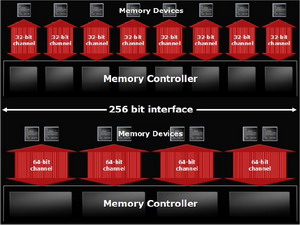

Kontroler pamięci

Jednym z ważniejszych bloków funkcjonalnych rdzenia jest kontroler pamięci. Ten niedoceniany element ma bezpośredni wpływ na wydajność i jako, że funkcjonuje niezależnie od rdzenia architektury 3D najczęściej jest eksploatowany przez kilka generacji układów, w niemal niezmienionej formie (różnice związane a obsługą konkretnych typów pamięci i adresowaniem).

Kontroler pamięci (kliknij, aby powiększyć)

Kontroler pamięci X1800 vs X800 (kliknij, aby powiększyć)

Wraz z R520 debiutuje nowy kontroler pamięci. W związku z tym, że ATI bardzo się nim chwali wygląda na to, że jego projekt pożarł sporo roboczogodzin, a stopień zaawansowania wskazuje na zajęcie sporego procenta powierzchni rdzenia. Wewnętrzną szynę dostępu do pamięci zaprojektowano w topologii okręgu położonego w zewnętrznej części struktury rdzenia. Składa się z dwóch, dwukierunkowych, 256-bitowych magistral podzielonych na cztery odcinki. Każdy z fragmentów kończy się punktem styku z pamięciami wyposażonym w dwa 32-bitowe kanały (łącznie 256 bitów). Mamy więc z jednej strony optymalizację tras danych umożliwiającą zwiększenie stabilności przy wysokim taktowaniu, a z drugiej zwiększenie efektywności wykorzystania zewnętrznej szyny (układ 8x32 vs 4x64). Będzie to szczególnie ważne przy zastosowaniu przyszłych pamięci GDDR4. Nowy model obsługi pamięci podręcznej (cache) umożliwia przechowywanie w dowolnym miejscu każdego fragmentu zawartości pamięci zewnętrznej. Kontroler jest programowalny i sterownik może dynamicznie zmieniać algorytmy jego działania. Między innymi związane jest to z możliwością ustalania priorytetów dla pakietów danych. Można sobie wyobrazić zmuszenie kontrolera do faworyzowania tych danych, których sprawne dostarczenie ma największy wpływ na wydajność w danym momencie.

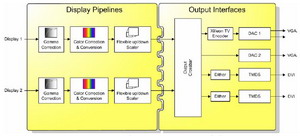

Przetwarzanie obrazu

Podobnie jak w przypadku kontrolera pamięci układy przetwarzania obrazu na gotowy sygnał sterujący ekranem nie należą do elementów, które zmieniają się w takim samym tempie jak architektura związana z generowaniem obrazu 3D. W przypadku nowej generacji ATI również i ten element został w znaczącym stopniu przebudowany. Układ R520 wyposażono w dwa nowe procesory obrazu umożliwiające niezależne przetwarzanie dwóch strumieni z 10-bitową rozdzielczością, czym wcześniej pochwalić się mógł jedynie Matrox. Przypomnę, że w poprzednich kartach ATI 10-bitowe były jedynie układy RAMDAC, a obróbki dokonywano na ośmiu bitach. Procesory obrazu zajmują się skalowaniem, korekcją gamma i koloru, usuwaniem przeplotu itd. Po przetworzeniu strumień obrazu trafia na zestaw interfejsów wyjściowych. Tu mamy dwie nowości.

Przetwarzanie obrazu (kliknij, aby powiększyć)

Pierwsza to dwa wbudowane w rdzeń układy TMDS działające w trybie dual-link, umożliwiające generowanie obrazu na dwóch niezależnych panelach cyfrowych działających z rozdzielczością do 2560x1600 każdy. Drugą stanowi układ Xilleon zajmujący się kodowaniem obrazu do postaci strawnej dla telwizorów, obsługujący wyjścia analogowe (Composite, S-Video, Component). Ten sam, który udało się firmie ATI zaimplementować w serii domowych urządzeń HDTV różnych producentów.

Bajery technologiczne

Zmiany w strukturze krzemowej powinny pociągać za sobą konkretne korzyści dla użytkownika. Zdecydowaną większość z nich stanowi od dawna stosunkowo słabo "sprzedająca" się sucha informacja o zwiększeniu wydajności. W związku z tym producenci bombardują nas materiałami reklamującymi szereg bardziej lub mniej innowacyjnych technologii o wysoce chwytliwych nazwach. Niektóre z tych informacji są istotne natomiast inne zdecydowanie zaliczam do przerostu formy nad treścią. Najważniejsze słowa w nowym słowniczku ATI brzmią następująco (w oryginale):

Ultra-Threaded Shader Engine

Nowa architektura 3D musi mieć swoją nazwę. Nasuwają się skojarzenia z HT Intela i być może w jakimś stopniu mają pokrycie w funkcjonalności. Nie można się pochwalić ani ilością TMU, ani ilością shaderów bo konkurencja ma ich więcej (o potokach, które w zasadzie przestały istnieć, nawet nie wspominam) więc naturalnie eksponowana jest nowa zasada dystrybucji zasobów "silnika" pikseli. Oczywiście sukces zależy od realnych możliwości lepszego ich wykorzystania, czyli faktycznej różnicy wydajności w stosunku do poprzednika. Tym nie mniej jest to realna nowość i niezła baza w procesie tworzenia kolejnych produktów.

Shader Model 3.0

Pieśn przyszłości, którą już dziś wyśpiewuje nam marketing. Do znudzenia. Kilka realnie mało istotnych (z punktu widzenia użytkownika) dodatków do poprzednich modeli shaderów, ale za to szum medialny godny stadionu olimpijskiego. W związku z tym, że poprzednie produkty ATI nie wspierały tej specyfikacji stał się on najważniejszym orężem reklamowym poprzednich produktów nVidia. Niestety producentom chyba udało się zrobić nam wodę z mózgu, bo faktycznie przynajmniej część klientów zaczęła głośno dopominać się o SM3.0. Najważniejszą różnicą jest możliwość implementacji dynamicznej kontroli przebiegu programu shadera i eliminacja zbędnego powtarzania tych samych fragmentów kodu. Problem w tym, że aby to miało realne znaczenie dla sprawności procesu to trzeba chcieć wykorzystać faktycznie duży program operujący na pikselach. Do tego potrzeba mieć odpowiednią moc układu bo kogo ucieszy np. dwukrotnie większy framerate skoro wciąż nie ma płynnej grafiki. Do tego testy wykazały, że obsługa dynamicznych rozgałęzień shadera idzie GeForce'om wyjątkowo niesprawnie i potrafi zjeść cały zysk z ich zastosowania. Być może w przypadku RX1800XT, dzięki dedykowanym jednostkom arytmetycznym procesora shaderów, stosowanie SM3.0 nabierze większego sensu ale osobiście specjalnie bym się na tym nie koncentrował. Jak dla mnie główną zaletą wprowadzenia przez ATI SM3.0 do nowych układów jest kwestia ujednolicenia standardu. Skoro główni gracze na rynku dysponują zgodnym hardware, i to zarówno w postaci kart do pecetów, jak i konsol do gier, to już nic nie powinno przeszkodzić programistom w przystosowaniu się do nowych warunków.

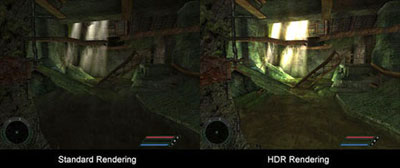

HDR (High Dynamic Range)

Rewelacją tego skądinąd ładnego efektu wizualnego jest fakt udanego ogłupienia przez marketing nieświadomych użytkowników, w stopniu przekraczającym moje możliwości wytłumaczenia tego zjawiska. HDR to techniki obliczeń kolorów pikseli pozwalające na symulowania reakcji ludzkiego oka na zmiany natężenia oświetlenia. Sprzętowy HDR może być realizowany wieloma metodami związanymi z możliwościami konkretnych układów graficznych, prowadzącymi do zróżnicowania jakości obrazu wynikowego w zależności od modelu implementacji efektu. Nieźle wyglądające i całkiem sprawnie obliczane efekty HDR można już było oglądać na starszych kartach ATI, ale programiści specjalnie się nie kwapili do ich realizacji w silnikach gier. Zainteresowanie efektem wróciło wraz pojawieniem się układu NV40. nVidia postanowiła sprzętowo wesprzeć znany z produkcji najnowszych filmów format zapisu obrazów HDR o nazwie OpenEXR, opracowany przez firmę ILM (Industrial Light & Magic). A konkretnie jeden z formatów OpenEXR wykorzystujący 16-bitową zmiennoprzecinkową reprezentację koloru (są również formaty stałoprzecinkowe oraz FP32).

Bez tradycyjnej dygresji chyba się tym razem nie obejdzie. Jako, że jest to poważny slogan marketingowy nowszych kart GeForce to wokół tematu namnożyło się wiele przedziwnych tez. Można usłyszeć m.in. o konieczności wsparcia SM3.0 dla HDR, braku HDR na Radeonach czy o podziałach na "pseudo" i "prawdziwy" HDR. Nic z tych rzeczy. Oczywiście można w tym miejscu dać rozbudowany opis możliwych do implementacji metod HDR w zależności od hardware, ale chciałbym zwrócić uwagę na nieco inny aspekt. Kwestia HDR faktycznie pomogła w sprzedaży GF6, a najprostszym dowodem na to jest właśnie R520. Z mojego (mam nadzieję, że nie tylko ja mam takie odczucia) punktu widzienia wygląda to nieco dziwnie. Mam aktualnie zainstalowane w domu trzy gry umożliwiające HDR rendering: FarCry, HL2 i SCCT. Z tego jedynie ta pierwsza wykorzystuje format OpenEXR, oczywiście w trybie zgodnym z metodą nVidia i do tego wsparcie jest w stadium beta. W efekcie jego działania nie można włączyć FSAA, framerate "siada" w sposób uniemożliwiający użycie wyższych trybów graficznych a bywa, że i obraz kompletnie mi się "rozjeżdża" po kilku minutach grania (jakby ktoś mi wlał różowego budyniu do monitora). Dla przeciwwagi jest SCCT i HL2 z implementacją działającą również na Radeonach, z mniejszym spadkiem framerate, a w przypadku HL2 również z działającym FSAA. Można oczywiście wnikać w kwestie techniczne realnych możliwości skojarzenia obsługi FP framebuffera z multisamplingiem, różnic wydajności pomiędzy filtrowaniem tekstur FP w TMU i PS, zastąpienia FP framebuffera przez renderowanie do tekstur FP, czy posiłkować się całą serią podobnie trudnych wyrażeń. Tylko po co? Z mojego punktu widzienia wygląda to na wielkie zamieszanie wprowadzone przez jedną grę i do tego w wysoce nieefektywny sposób. Jak mam uwierzyć, że format HDR FP16 (nie tylko w zapisie OpenEXR) zostanie przyjęty i do tego jeszcze nie spowoduje takich strat ubocznych (framerate, FSAA) jak w FarCry?

Sam HDR jest bardzo interesującym efektem, ale nie chcę dać się zwariować. W kwestii implementacji interesowałoby mnie mnie jaka jest realna różnica w obrazie w zależności od rodzaju reprezentacji koloru i odpowiadający mu koszt framerate, wielkość wparcia w ciągu roku, możliwość ujednolicenia formatu zapisu itp. Tego niestety nie wiem, ale za to mam agresywny marketing związany z wejściem kolejnej karty, który sprzedaje mi informacje o tym, że nie tylko wspiera HDR z formatem koloru FP16, ale jeszcze dopali do tego multisampling. Czy mam to rozumieć, że muszę ją mieć bo za pół roku pojawi się kolejny beta-paczyk do FarCry, który da równie ślamazarną implementację, którą jeszcze z sukcesem obłożę wygładzaniem krawędzi? Albo będzie jeszcze gorzej, bo w zasadzie nie wiem jak poradzi sobie R520 z filtrowaniem FP i tone mappingiem na shaderach (nie ma filtrowania FP w TMU, ani przeliczania na format RGBA w RAMDAC jak GeForce). Być może się mylę (chciałbym), ale dla mnie to brzmi tak samo pusto i marketingowo jak osławiony HDR w NV40. nVidia na tym zyskała, to i ATI idzie tą ścieżką. Oni nam HDR OpenEXR FP16 to my im tym samym, ale z multisamplingiem. Na forach wrze, sprzedaż idzie, a ja bym tylko nieśmiało prosił o realniejszy płynny obraz w grach. Wiem. Za dużo wymagam. A może to wszystko tylko ściema, aby odwrócić uwagę od być może cenniejszej realnie informacji o wsparciu HDR na INT32 (10:10:10:2)? Specyfikacja OpenEXR zawiera i taki format. Dobra. Wystarczy tych dygresji. Oczywiście sam fakt możliwości jednoczesnego stosowania multisamplingu i blendingu na teksturach FP należy odnotować aczkolwiek bez konkretów wydajnościowych specjalnie bym go nie uwypuklał.

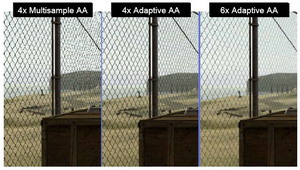

Adaptive Antyaliasing / HQ Anisotropic Filtering / 3Dc+ / CrossFire / Catalyst

Adaptive Antyaliasing to metoda pozwalająca na poprawienie obrazu częściowo przezroczystych tekstur, poddanych działaniu pełnoekranowego antyaliasingu. W przypadkach przeróżnych siatek ogrodzeń i tym podobnych obiektów obraz faktycznie zyskuje przy akceptowalnym spadku framerate. Problem w tym, że pokazywałem go już wcześniej przy wykorzystaniu starszych generacji ATI, więc bajer nieco sztucznie przylepiono do nowych Radeonów. Generalnie rzecz miła aczkolwiek o mniejszym znaczeniu "strategicznym". Głównie chodzi o zneutralizowanie konkurencja, która dysponuje podobnymi, wcześniej szeroko nagłośnionymi technologiami.

Adaptive Antyaliasing (kliknij, aby powiększyć)

Pod jak zwykle obiecującą nazwą High Quality Anisotropic Filtering zawarto informację o kolejnych ulepszeniach algorytmów filtrowania anizotropowego. Wprowadzono w sterowniku dodatkową opcję High Quality do wcześniejszych trybów. Tryb HQ minimalizuje wpływ kąta obrotu tekstury na jakość filtrowania. W związku z tym, że już w przypadku starszych kart trudno dostrzec różnicę pomiędzy najwyższymi trybami w czasie gry, to nie sądzę, aby dalsze wzbogacanie obrazu łatwo będzie dostrzec.

Kolejnym elementem, który może mieć wpływ na jakość obrazu jest 3Dc+. W poprzedniej generacji ATI zaimplementował techniki kompresji map normalnych o nazwie 3Dc. R520 rozszerza zakres stosowania tego standardu do innych typów tekstur mapowania (HDR, lighting & shadow itd.). Zysk zależy oczywiście od chęci wsparcia tej technologii przez programistów gier. Przy okazji warto dodać, że R520 przechowuje wszystkie dane związane z procesem przetwarzania 3D w pamięciach podręcznych, w postaci skompresowanej.

CrossFire to technologia łączenia kart ATI w jednym pececie, w celu uzyskania większej mocy przetwarzania wraz z dodatkiem w postaci dedykowanych trybów antyaliasingu. Wprawdzie możliwość łączenia kart występuje już w poprzednich produktach ATI, ale w związku z metodą jej implementacji w najsilniejszych produktach (dedykowana karta łączona przez DVI) występowały dosyć uciążliwe problemy (np. ograniczenie trybu) spowodowane słabą przepustowością układów TMDS. W R520 zastosowano standard Dual-Link dzięki czemu możliwe było ich wyeliminowanie.

Do podstawowych "ficzerów" swoich kart ATI zalicza zestaw sterowników i oprogramowania o nazwie Catalyst. W zasadzie nie ma się z czego śmiać. Szczerze mówiąc klasa sterowników jest elementem zdecydowanie istotniejszym niż wypunktowane wyżej bajery. Choć oczywiście jest to moje własne, subiektywne zdanie, ale jak dla mnie faktycznie jest się czym chwalić, bo skok jaki się dokonał w jakości sterowników ATI może budzić respekt i dawna daleki jestem od stwierdzeń, że ustępują one w tym względzie produktom nVidia. Tym nie mniej optymalne oprogramowanie nowej architektury 3D musi trochę potrwać i nie będę specjalnie zdziwiony, jeśli stopień jej dostosowania do aktualnych silników gier nie osiągnął jeszcze najwyższych poziomów.

AVIVO

Pod marketingową nazwą AVIVO kryje się cały szereg technologii związanych z obróbką obrazu, obsługą ekranów, kompresją plików multimedialnych i wieloma innymi aspektami przetwarzania i wyświetlania multimediów, zaimplementowanymi w nowej generacji kart ATI. O konkretnych usprawnieniach związanych z modyfikacją hardware już wcześniej wspominałem. Teraz chciałbym zwrócić uwagę na technologie które się na nich opierają oraz spróbować ogarnąć zakres, który nazwa AVIVO obejmuje. Sprawa jest na tyle interesująca, że w zasadzie od R9700Pro niewiele się zmieniało wraz z kolejnymi produktami ATI. Dopiero R520 wprowadza cały szereg zmian, z których przynajmniej niektóre wydają się mieć wymierne znaczenie dla użytkownika.

Capture: W zasadzie kwestii przetworzenia analogowego sygnału na postać cyfrową nie można od strony sprzętowej bezpośrednio łączyć z samym układem graficznym, bo ATI wykorzystuje w tym procesie oddzielny hardware. Występuje natomiast powiązanie z samą nazwą handlową AVIVO. Możliwości najnowszych, dedykowanych układów ATI są faktycznie niezłe (12-bitowe przetworniki, automatyczna korekta mocy sygnału, filtry grzebieniowe 3D, redukcja szumów itd.) natomiast w przypadku konkretnych kart graficznych wyposażonych w wejście wizyjne (VIVO) możemy spotkać starsze układy ATI Theater, których możliwości w tym zakresie są znacznie skromniejsze. ATI najczęściej stosuje najlepsze układy w kartach tunerów lub ewentualnie w niektórych produktach All-In-Wonder (połączenie karty graficznej z tunerem TV).

Kodowanie: W najnowszej generacji układów ATI umożliwiło zaprzęgnięcie do dodatkowej pracy jednostek arytmetyczno-logicznych rdzenia architektury 3D. Korzystając bezpośrednio z ich mocy obliczeniowej możemy kodować i przekodowywać formaty kompresji obrazu. Wystarczy zainstalować odpowiednie oprogramowanie, które ATI postanowiło bez dodatkowych opłat udostępnić użytkownikom nowych kart. Sprawa jest na tyle interesująca, że teoretyczna moc przetwarzania konkretnych zestawów instrukcji jest wielokrotnie wyższa niż możliwości, jakie oferują procesory stosowanie w domowych pecetach. Kwestia dotyczy kodowania formatów mpeg1/2/4, wmv9 i H.264 wykorzystywanych m.in. w zapisie nośników DVD, VCD, Sony PSP, iPod czy nowych standardów HDTV (Blu-ray i HD-DVD). Jako, że jestem tym osobiście zainteresowany, to postaram się sprawdzić czy i jak to działa, bo brzmi zachęcająco.

Dekodowanie: Poprzednie generacje produktów ATI wspierały dekodowanie formatów mpeg-1/2, natomiast w nowych produktach doszły formaty związane z HDTV (H.264 i WMV9/VC-1). Jest to o tyle ważne, że formaty te nie dosyć, że wymagają większej mocy obliczeniowej do procesu dekompresji tych samych trybów, ale mają w założeniach przenosić znacznie wyższe rozdzielczości. Dekodowanie filmu 1080p (1920x1080 progressive scan) zapisanego w H.264 potrafi "zajechać" najmocniejsze aktualnie procesory. Aby łatwiej zrozumieć problem wystarczy zdać sobie sprawę, że klasyczne filmy DVD mają 720x480 i do tego 2-3 razy mniejszy stopień kompresji. Rewolucja w zakresie jakości przenoszenia obrazu video czai się już za rogiem więc zainteresowanie tematem będzie rosło.

Przetwarzanie: Chodzi mi konkretnie o tzw. "post processing" obrazu, który następuje po jego rozkodowaniu i ma niebanalny wpływ na końcową jakość wyświetlanego filmu. Najczęściej dotyczy to kwestii de-interlace (potrzebne w sytuacji gdy próbujemy wyświetlić film zapisany z przeplotem na wyświetlaczu progressive scan) oraz skalowania (zmiana trybu pomiędzy źródłem o wyświetlaczem), redukcji zakłóceń, korekcji koloru itp. Większość funkcji działa automatycznie, a niektóre (jak na przykład nowy, bardziej zaawansowany algorytm de-interlace) możemy włączyć z poziomu sterownika. Oprócz zmiany algorytmów przypominam, że w kwestii jakości obrazu trzeba również brać pod uwagę to, że R520 ma nowe silniki przetwarzania obrazu, działające z 10-bitową rozdzielczością.

Wyświetlanie: Chodzi o różnice jakości obrazu związane ze zmianą od strony sprzętowej interfejsów wyjściowych. Tak jak wcześniej pisałem mamy dwa nowe układy dual-link TMDS i nowy kodek TV Xilleon wbudowane bezpośrednio w rdzeń układu graficznego. 10-bitowe układy RAMDAC (współpraca z analogowymi monitorami) występowały już we wcześniejszych konstrukcjach. Szczerze mówiąc, w kwestii RAMDAC mam coraz mniej do powiedzenia. Od lat jakość obrazu na wyjściach VGA jest lepsza niż monitory, które podłączam do kart.

Zawodnicy

Próbę oszacowania możliwości Radeona X1800XT w kwestii wydajności 3D sprowadziłem do pojedynku z kartą GeForce 7800GTX 256MB. Nowe karty ATI można znaleźć w sklepach w cenach od ok. 2000 zł. Wprawdzie dostępne na rynku GF7800GTX 256MB kosztują od ok. 1850 zł, ale ja postanowiłem użyć do porównań kartę o taktowaniu wyższym od referencyjnego. Wiele firm zaoferowało takie modele, a ich cena jest najbardziej zbliżona do ceny RX1800XT. Oczywiście pamiętam o istnieniu GF7800GTX wyposażonego w 512MB pamięci i taktowanego jeszcze wyżej. Nie udało mi się na czas pożyczyć takiego egzemplarza i szczerze mówiąc specjalnie mi z tego powodu nie jest przykro. W stosunku do testowanego GTX'a mamy wprawdzie wyższe o kilkanaście % taktowanie rdzenia i co ważniejsze 512MB pamięci działającej 25% szybciej, ale koszt jaki musimy za to zapłacić jest gigantyczny. Za pierwsze egzemplarze, które fizycznie pojawiły się na rynku trzeba wydać niemal 50% więcej pieniędzy wchodząc w zakres cenowy zestawu SLI na dwóch GF7800GT. O to czy jest on warty swojej ceny spytam przy okazji innej recenzji. Oczywiście jeśli będę miał taką możliwość.

Sapphire Radeon X1800 XT vs Asus Extreme N7800GTX TOP

(kliknij, aby powiększyć)

Dziś bój z sobą stoczą dwie karty, które zdecydowanie można zaliczyć do tej samej ligi cenowej. Z wypożyczonym od Sapphire bohaterem recenzji zmierzy się zawodnik wystawiony przez firmę Asus.

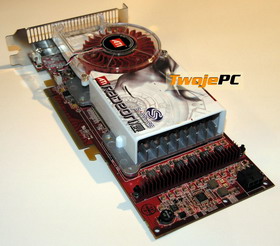

Sapphire Radeon X1800 XT

Flagowy produkt Sapphire zapakowano w średniej wielkości pudełko. Na białym tle wyrysowano, znanego z aktualnej stylistyki tego producenta "obcego", który jak dla mnie leniwie przeciąga się zamiast stawać do walki z konkurencją. Widać specjalnie się nie przejmuje zbliżającą się konfrontacją.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Radeon X1800XT oparty jest na czerwonym laminacie o długości niemal identycznej jak 7800GTX. W odróżnieniu od konkurenta, wszystkie osiem modułów pamięci Samsung GDDR3 1.26ns o łącznej pojemności 512MB umieszczono na awersie. Na śledziu dwa gniazda DVI oraz port VIVO (miniDIN 9pin). Wejście wizyjne realizuje układ ATI Theater. Po drugiej stronie płytki znajdziemy gniazdo zasilania. GPU oraz pamięci przykrywa monstrualny układ chłodzenia, który na pierwszy rzut oka wygląda jak podpompowana wersja tego, który zastosowano w X850XTPE. Karta jest duża, ciężka i szeroka na dwa sloty. Nie ma wątpliwości, że mamy do czynienia z wyczynowcem.

w czasie testów nie rozkręcił się do poziomu

Wentylator zaraz po włączeniu peceta rusza ochoczo na pełnych obrotach waląc po uszach huraganem. Na szczęście po chwili cichnie tak, że jedynie w niemal bezgłośnych pecetach da się go usłyszeć. Jako, że w czasie testów nie rozkręcił się do poziomu, który przekraczałby moją granicę akceptowalności, to wygląda na to, że ma jeszcze spory zapas mocy. Dodatkową zaletą jest to, że wyciąga on ciepłe powietrze z obudowy stając się dodatkowym elementem cyrkulacji wnętrza peceta. Generalnie oceniam go zdecydowanie pozytywnie pomimo jego gabarytów.

Zestaw okablowania jest typowy dla Sapphire. Mamy przejściówki zasilania, DVI-VGA, VIVO (Composite i S-Video) oraz wyjście Component (3x Cinch). Podobnie jak w poprzednio testowanych zestawach nie zabrakło przyzwoitej jakości kabli Cinch i S-Video (miniDIN 4piny). Minusem jest brak drugiej przelotki DVI-VGA. Moim zdaniem pewnym mankamentem jest również oddzielenie wyjścia Component od pozostałych sygnałów VIVO, bo wolałbym zminimalizować ilość rozłączeń niewielkiego gniazda wizyjnego na śledziu.

Na oprogramowanie składają się (oprócz sterowników) odtwarzacz DVD, edytor obsługujący wejście wizyjne, oraz jedna gra w pełnej wersji. Innowacją jest wprowadzenie możliwości wyboru gry przez użytkownika. Mamy do dyspozycji cztery uznane gry, które możemy najpierw wypróbować, a następnie jedną z nich aktywować, korzystając z połączenia internetowego. Takie rozwiązanie wydaje się interesujące, bo znacznie zwiększa możliwość realnego wykorzystania gry, którą zakupiliśmy wraz z kartą. Przy zakupie sprzętu bardzo często okazuje się, że dodana w zestawie gra jest już w naszym posiadaniu, albo po prostu nam się nie podoba. W przypadku Sapphire mamy szansę dostać coś, co nas faktycznie zainteresuje. Tym samym mogę napisać, że choć w kwestii ilościowej wyposażenie jest kompletne, to jednak jakościowo stanowi pewne odejście od standardu.

Kartę Sapphire Radeon X1800XT oceniam bardzo dobrze. Wyposażenie jest kompletne, jakość bez zarzutu, pełny asortyment wejść i wyjść zewnętrznych oraz chłodzenie, które nie zdominuje peceta hałasem. Konkretnym plusem jest również fakt, że jest to na rynku jedna z najtańszych kart opartych na topowym układzie graficznym ATI. Moim zdaniem zdecydowanie zasługuje na wyróżnienie.

|

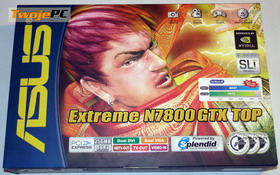

Asus Extreme N7800GTX TOP

Ekstremalny produkt Asus'a zapakowano w duże, pokryte dodatkowymi informacjami pudełko. Jako, że praktycznie niemal wszystkie GTX'y na rynku oparte są na testowanej (i opisanej) wcześniej referencyjnej konstrukcji nVidia, to najprościej wypunktować same różnice. Testowana karta wyróżnia się spośród innych modeli na rynku trzema podstawowymi elementami. Po pierwsze zastosowano efektywniejsze chłodzenie firmy Arctic Cooling, po drugie wyselekcjonowano modele działające na zwiększonej częstotliwości taktowania, po trzecie dołączono bardzo bogate oprogramowanie. Oczywiście dodatki mają swoją cenę, ale biorąc pod uwagę fakt, że jest to produkt z najwyższej półki, to taka oferta wydaje się jak najbardziej celowa.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Układ graficzny oraz połowę modułów pamięci chłodzi Silencer 5 (rev. 3) firmy Arctic Cooling. Chłodzenie działa efektywnie i cicho pomimo zwiększonego taktowania. Moim zdaniem strzał w dziesiątkę. Problem jego wysokości czy wagi jest raczej mało istotny. Ewentualne mankamenty związane są jedynie z kwestią chłodzenia pamięci. Połowa modułów (rewers) przykręcona jest jedynie do wspólnego kawałka blachy, a druga (awers) styka się z Silencerem poprzez podkładkę przewodzącą ciepło. Wydaje się jednak, że nie ma to większego znaczenia z uwagi na fakt ich podkręcenia "firmowego" z 600 na 675MHz (kości nominalnie dostosowane są do 625MHz). Natomiast rdzeń przetaktowano z referencyjnych 432 na 486MHz. Problemów ze stabilnością termiczną nie miałem. Testy poboru mocy wykazują, że karta pobiera ok. 20W mniej niż konkurent ATI.

(kliknij, aby powiększyć)

Oprogramowaniem jakie znajdziemy w zestawie można spokojnie obdzielić kilka kart graficznych. Pięć pełnych gier, odtwarzacz DVD, edytor obsługujący wejście wizyjne, FarStone VirtualDrive 9 oraz cała seria dodatkowych programów Asus'a (SmartDoctor, Video Security Online, GameFace Live, GameLiveShow). Narządzia te umożliwiają m.in. nagrywanie i udostępnianie w Internecie obrazu z gry, dodają w grach możliwość porozumiewania się z innymi graczami (obraz i dźwięk), pozwalają na wygodną regulacją parametrów obrazu z poziomu gry i umożliwiają podkręcanie karty. Do zestawu nośników dodano skóropodobny pokrowiec, który choć nie jest niczym specjalnym to moim zdaniem prezentuje się lepiej niż pomarańczowe pudełko z półprzezroczystego tworzywa, które producent dodawał do poprzednich zestawów.

Z dodatkowego okablowania i przejściówek na pierwszy plan wysuwa się zespolony panel VIVO. Osobiście wolę takie rozwiązanie, bo przynajmniej wszystko mamy w jednej "puszcze", która po odsunięciu od peceta zmniejsza ilość otaczających go przewodów wizyjnych. Przejściówka z dedykowanego zasilania PCI-E na dwa gniazda molex pozwoli zasilić kartę przez starsze typy zasilaczy. Pewnym niedostatkiem zestawu jest obecność tylko jednej przejściówki DVI-VGA.

Asus Extreme N7800GTX TOP bez najmniejszych wątpliwości zasługuje na dobrą ocenę. W zalewie niemal identycznych produktów opartych na referencyjnej konstrukcji nVidia wyróżnia się zarówno od strony wydajności, jak i walorów użytkowych oraz oprogramowania.

|

Pojedynek

Opisane w poprzednim rozdziale karty przebadałem za pomocą serii wykonywanych wcześniej testów. Pomiary dokonywane były na komputerze którego trzon wydajności stanowiły: procesor Athlon 64 @ 2.4GHz, 2x 512MB DDR, płyta AsRock 939Dual-SATA2. Karty działały w oparciu o referencyjne sterowniki ATI w wersji 5.13 oraz nVidia v81.98. Ustawienia pozostały domyślne oprócz wyłączenia vsync. Jest to ważna informacja z uwagi na fakt zwiększenia wydajności karty GeForce kosztem jakości filtrowania (pisałem o tym we wcześniejszych testach). Gry testowe starałem się ustawić na najwyższą jakość obrazu. FSAA/Anizo ustawiony był z poziomu gry, a jeśli nie było to możliwe to w sterowniku. Podstawowym trybem do porównań jest 1600x1200 z FSAA x4 oraz Anizo x8. Zarówno konfiguracja sprzętowa platformy testowej, jak i ustawienia gier są takie same, jak we poprzednich testach. Brak tabeli z X2 - The Threat wynika z faktu problemów związanych z GTX'em działającym na najnowszych sterownikach. W nawiasach podawane są wartości minimalne framerate uzyskane w demku testowym. Pomiar przy drugim przejściu demka testowego. Komentarze starałem się ograniczyć do minimum. Niech przemówią liczby.

FarCry

Demo obejmuje większą część mapy Research. Pomiar wbudowanym benchmarkiem (nie odzwierciedla realnego framerate).

Remis.

Doom 3

Wbudowany benchmark (timedemo demo1). Poziom jakości tekstur: High.

Kolejny Remis. Biorąc pod uwagę fakt lepszego dostosowania gry do architektury GeForce, nowy Radeon poradził sobie zupełnie nieźle.

Half-Life 2

Wbudowany benchmark. Demo na mapie Cannals.

W tej grze nowy Radeon wypada wyraźnie lepiej. W wyższych trybach różnica jest odczuwalna.

Splinter Cell - Chaos Theory

Wbudowany benchmark. Ustawienie SM 3.0.

Niewielka przewaga ATI. Wynik o tyle ważny, że gra w znaczącym stopniu wykorzystuje PixelShader.

Tomb Raider - A.O.D.

Benchmark wbudowany w patch 0.49.

Niewielka przewaga ATI.

LockOn - M.A.C.

Pomiar za pomocą Fraps. Demko przelotu F-15 na niskiej wysokości.

Tym razem przewaga karty GeForce.

Colin McRae '05

Pomiar za pomocą Fraps.

W tej konkurencji wygrywa Radeon.

The Chronicles of Riddick

Dedykowany program testujący zawierający własne demko nagrane w bardzo nieprzyjemnym dla kart miejscu.

Wreszcie konkretne zwycięstwo GTX'a. W obliczu wsparcia dla UltraShadow Radeon nie jest mu w stanie sprostać.

Battlefield 2

Pomiar za pomocą Fraps na wbudowanym demie testowym.

Konkretne zwycięstwo Radeona. Sporo shaderów w użyciu. GeForce "puchnie" powyżej 1280x1024.

F.E.A.R.

Pomiar za pomocą Fraps.

Po dodaniu FSAA/Anizo GeForce nie jest w stanie sprostać nowej karcie ATI. Radeon notuje kolejne zwycięstwo.

Uczta numerologa

Zgodnie z tradycją przyszedł czas na zestawienie wyników i sprowadzenie ich do jednej liczby, proporcjonalnej do przewagi średniego framerate w najwyższym trybie testowym.

W związku z powyższym wynikiem ogłaszam, że RX1800XT został zwycięzcą tego pojedynku. Różnica nie jest duża i w zasadzie nic nie stoi na przeszkodzie, aby pisać o zbliżonej wydajności tych dwóch kart. Tym nie mniej chciałbym zaznaczyć, że po pierwsze nie jest to porównanie referencyjnych produktów, a po drugie jakość filtrowania karty GeForce na domyślnych ustawieniach sterownika jest mniejsza. Kryterium porównawczym była przede wszystkim zbliżona cena.

Jeśli jednak ktoś chciałby porównać referencyjne taktowania i do tego sprowadzić obraz do zbliżonej jakości to zrobiłem również dodatkowe porównanie.

Dzięki tej tabeli można dowiedzieć się ile zyskuje GTX na wyższych zegarach, a ile dzięki obniżeniu jakości filtrowania.

Tradycyjnie przeprowadziłem również test za pomocą 3Dmark '05 wraz z porównaniem do uczty numerologa.

W domyślnym teście 3Dmark '05 GeForce wypadł nieco lepiej niż w "uczcie" ale przypominam, że w grach stosowane było ustawienie FSAA/Anizo, z którym nieco lepiej radzą sobie Radeony.

Podkręcanie

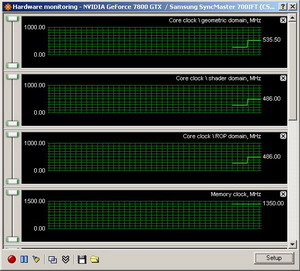

Asus 7800 GTX (kliknij, aby powiększyć)

Najpierw kilka informacji wprowadzających. Zacznę od GTX'a. Konstrukcja układu umożliwia stosowanie kilku zegarów taktujących poszczególne części rdzenia. Podawane w specyfikacji taktowanie dotyczy bloku shaderów oraz modułów ROP, które z reguły mają ustaloną tą samą częstotliwość. Nie może ona przyjmować dowolnych wartości tylko zmieniać się o 27MHz (mnożniki zegara bazowego). Taktowanie referencyjne shaderów/ROP rdzenia wynosi 432MHz. Kolejne stopnie to 459, 486, 513, 540 itd. Testowany Asus ma domyślnie ustawione taktowanie o dwa "oczka" wyżej, czyli 486MHz. Za pomocą RivaTuner'a udało mi się je podnieść o kolejny stopień, czyli 513MHz. Natomiast blok geometrii może być taktowany dowolną częstotliwością choć typowo jest to ok. 50MHz więcej niż taktowanie pozostałych części rdzenia. Podniesienie podstawowego zegara z 486 na 513MHz zmieniło taktowanie tej części z 536 na 563MHz. Nie ma to specjalnego znaczenia skoro oprogramowanie (jak na razie) nie pozwala na niezależną zmianę taktowania różnych części układu, ale chciałem tą sprawę wyjaśnić. W minimalnym stopniu udało mi się również podkręcić pamięć.

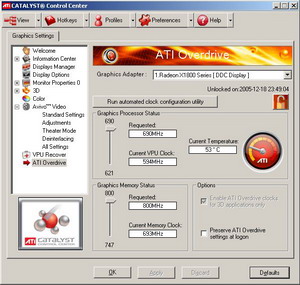

Sapphire Radeon X1800XT (kliknij, aby powiększyć)

Z Radeonem X1800XT miałem nieco więcej problemów. Wprowadzono zewnętrzną różnicę na zegarach pomiędzy trybami 2D i 3D co rozkładało na łopatki aktualne wersje najczęściej stosowanego oprogramowania do podkręcania ATI. Prawidłowo zachowywały się jedynie programy WinClk w wersjach 3.7 oraz 3.8, z czego oczywiście skorzystałem. Wprawdzie w zakładce sterownika Catalyst pojawia się odpowiednia opcja, ale możliwości wzrostu taktowania są ograniczone do poziomu 690/800MHz. Oczywiście sama różnica taktowania to za mało, aby prawidłowo ocenić możliwości kart w tym zakresie. Trzeba wykonać testy i sprawdzić co nam to realnie daje w grach.

Wartości wzrostu framerate testowanych kart zdecydowanie nie rzucają na kolana. W zasadzie osobiście nie widzę większego sensu przeprowadzania na nich tego procederu. Jedynym konkretnym wnioskiem może być informacja, że nadtaktowanie dodatkowo zwiększyło niewielką przewagę jaką Radeon osiągnął nad konkurentem przy domyślnie ustawionych zegarach.

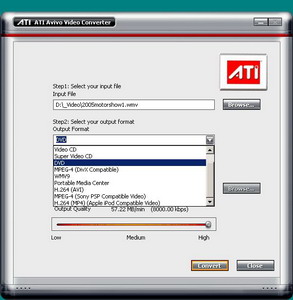

Przekodowanie filmów

W związku z tym, że miałem dostęp do oprogramowania ATI wykorzystującego funkcjonalność AVIVO w zakresie przekodowywania plików video to oczywiście musiałem go wypróbować. ATI Avivo Video Converter jest banalny w obsłudze. Podajemy ścieżkę do pliku źródłowego oraz format wyjściowy i przyciskamy przycisk "Convert". Jedynym możliwym do ustawienia parametrem jest wielkość strumienia mająca bezpośredni wpływ na balans pomiędzy objętością i jakością pliku wyjściowego.

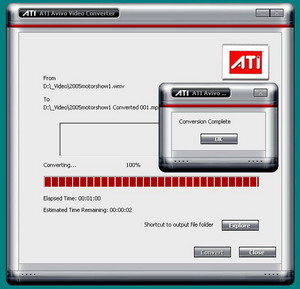

(kliknij, aby powiększyć)

Jak widać na powyższych zrzutach udało mi się uzyskać przykładowy plik wynikowy w formacie DVD w czasie 1 min. Aby ten czas miał jakiekolwiek znaczenie zrobiłem porównanie z Xpress'em, który oczywiście wykorzystuje tylko CPU (w tym przypadku Athlon 64 @ 2.4GHz). Ustawiłem go tak, aby wykonał transkodowanie jednoprzebiegowe na stałym strumieniu co umożliwi bezpośrednią ocenę wydajności kodeka sprzętowego ATI. Procesor poradził sobie z zadaniem w czasie ok. 3 min. czyli zajęło mu to 3x więcej czasu (!) i do tego w czasie konwersji komputer był praktycznie bezużyteczny. W przypadku kodowania filmów różnice rzędu 30% można uznać za duży sukces, a jak skomentować te 300%? Analiza plików wynikowych nie przyniosła nic nadzwyczajnego. Jakość obrazu była bardzo zbliżona. Oczywiście mógłbym na CPU uzyskać wyższą jakość (np. wprowadzić dwa przebiegi kodowania), ale chciałem mieć wspólny mianownik do porównań.

Wygląda na to, że pomysł wykorzystania silnego GPU w procesie przekodowania plików multimedialnych jest strzałem w dziesiątkę. Wprawdzie to co zaprezentowało oprogramowanie ATI w zasadzie jeszcze nie nadaje się do celów profesjonalnych z uwagi na brak parametryzacji samego procesu, ale zdecydowanie powinno zainteresować programistów. Oczywiście sam programik oprócz faktycznego waloru demonstracji możliwości nowych układów może być z powodzeniem stosowany przez użytkownika, ale wszystko wskazuje na to, że jest to tylko wierzchołek góry lodowej.

Muszę przyznać, że próbowałem również przyjrzeć się procesowi wsparcia dekodowania obrazu 1080p (H.264 i WMV9/AC-1), ale z uwagi na brak precyzyjnych procedur testowych temat przeniosę na inne recenzje. Sądzę, że będzie jeszcze wiele okazji aby o tym napisać.

Podsumowanie

Jedna z mądrości ludzkich głosi, że lepiej późno niż wcale. Z kilkumiesięcznym poślizgiem ląduje w sklepach kolejna generacja kart ATI wraz z jej flagowym modelem Radeon X1800XT. Mam nadzieję, że choć specjalnie się nie rozpisałem to jednak udało mi się przekazać najważniejsze informacje, pozwalające na prawidłową definicję zmian zaimplementowanych w nowych układach graficznych. Aby nie było wątpliwości to powiem wprost: Radeon X1800XT kończy linię produktów wywodzących się wprost z R9700Pro. Przebudowa dotknęła nie tylko rdzenia architektury 3D, ale również modułów towarzyszących. Nowy kontroler pamięci pozwalający na skorzystanie z zalet GDDR4, nowe procesory obrazu działające z 10-ciobitową rozdzielczością, szereg rozwiązań zbliżających nas do nadchodzącej ery HDTV i jej nowych nośników zapisu (Blu-ray/HD-DVD), wsparcie kodowania multimediów o zaskakującej wydajności itd. W kwestii przetwarzania 3D doszło przejście na 32bitową precyzję obliczeń i w zasadzie niemal przy okazji dostosowanie do SM3.0. Zmieniła się również zasada funkcjonowania silnika pikseli będąca z jednej strony próbą optymalniejszego wykorzystania istniejących zasobów, a z drugiej krokiem w kierunku nowej specyfikacji 3D API (WGF). Wszystko to sprawia, że układ ATI R520 jest bez wątpienia najbardziej zaawansowanym technologicznie procesorem graficznym na rynku. Projekt ATI był bardzo ryzykowny bo jednocześnie z opisanymi zmianami postanowiono po raz pierwszy wykorzystać krzem przetwarzany w nowym procesie technologicznym 90nm. Tym nie mniej, choć to wszystko brzmi pięknie, to jednak samo w sobie jeszcze nie wystarcza do odniesienia sukcesu rynkowego.

Radeon X1800XT jest niewątpliwie spóźniony. Od wielu miesięcy na rynku najwydajniejszych kart królują produkty nVidia, które doczekały się dalszego zwiększenia wydajności zarówno przez działania od strony sterowników jak i podwyższenia taktowania związanego z pojawieniem się nowszych wersji rdzenia. W zasadzie zbliża się czas, w którym według wcześniejszych planów ukazać się miały produkty oparte na rekonstrukcji rdzenia, obliczonej na kolejne zwiększenie mocy przetwarzania 3D. Jeśli ATI wypadnie z ustalonego wcześniej cyklu wdrażania nowych układów i kolejne karty będą jedynie bardziej lub mniej udanym osiągnięciem tego, co wcześniej pokazała konkurencja to wracamy do pozycji dominacji nVidia z wszystkimi nieprzyjemnościami, które się z tym wiążą. Na szczęście wygląda na to, że niezależnie od faktu poślizgu przy R520 jego następca zostanie zaprezentowany zgodnie z wcześniejszym harmonogramem. Jako, że Radeon X1800XT zawiera już potężny ładunek nowych technologii to koszt związany z jego opracowaniem choć częściowo przeniesiony zostanie na kolejny produkt i strata ATI nie będzie tak dotkliwa.

Przy całym swoim stopniu zaawansowania konstrukcyjnego Radeon X1800XT ma paskudną z marketingowego punktu widzenia wadę. Wcale nie jest łatwo go "sprzedać". Uznanie można zdobyć przez wdeptanie przeciwnika w ziemię wydajnością lub konkretnymi walorami w generowanym obrazie lub choćby widocznie lepszymi walorami eksploatacyjnymi. Według przeprowadzonych testów karta jest (średnio licząc) wydajniejsza od swojego głównego rywala, ale nie jest to różnica która kogokolwiek mogłaby rzucić na kolana. No chyba, że będziemy ją zestawiać z referencyjnie taktowanym GTX'em sprzed niemal pół roku i do tego na sterownikach, które ustawimy tak, aby mieć tą samą jakość filtrowania. Aktualnie sytuacja jest już jednak nieco inna więc ten aspekt można raczej odsunąć na drugi plan. No to czym skusić klienta? Od strony oprogramowania 3D mamy raczej dostosowanie do możliwości nVidia niż wyjście z czymś nowym. AVIVO w pełni rozkręci się dopiero wraz z ekspansją nowych standardów zapisu filmów, nowy kontroler wyprzedza możliwości zainstalowanych pamięci, 90um specjalnie nie widać, transkodowanie multimediów jest tylko dodatkiem i do tego wymaga bardziej dopracowanego softu, dzisiejsze gry specjalnie nie wykorzystają zysku na wydajniejszym przetwarzaniu dynamicznych rozgałęzień kodu shadera, a zwiększenie efektywności wykorzystania procesorów pikseli brzmi zupełnie pusto. Do tego nie ma żadnego przeboju na ich ilości. Wręcz przeciwnie. Klient przyzwyczaił się do zwracania uwagi na ilość potoków pikseli i łatwo nie da się przekonać do zmiany orientacji. nVidia degradowała klasyczny potok pikseli małymi kroczkami i w zasadzie niemal wszyscy są przekonani, że GTX'ma ich więcej, choć w zasadzie to już ani ATI ani nVidia nie ma potoków. Przynajmniej takich które dadzą się wprost porównywać. Skoro trudno się sprzedaje to, co jest najbardziej wartościowe to spece postanowili pójść za przykładem swoich znakomitych kolegów z obozu przeciwnika. Powoduje to, że dalej eksploatuje się wypromowany przez nich wcześniej gniot w postaci HDR w zapisie FP16, który wciąż pozostaje efektem niemal wirtualnym, ale tym razem również wirtualnie wygładzonym. Nic to, że można uzyskać bardzo ładny efekt HDR ze znacznie mniejszym spadkiem framerate i z FSAA na dowolnej karcie Dx9.

Na mnie osobiście Radeon X1800XT sprawił bardzo dobre wrażenie i jeśli miałbym dziś kupować kartę z tej półki cenowej, to bez wahania sięgnąłbym właśnie po tą kartę, a nie po GF7800GTX. Nawet w tak znakomitym jak testowanego Asusa wydaniu. Po prostu jest bardziej zaawansowana technologicznie co może (nie musi) przynieść konkretne korzyści w przetwarzaniu gier w dłuższym okresie czasu, ma więcej pamięci co może chcieć wykorzystać jakiś szalony programista, ma szansę skrócić mi czas kodowania filmów czy ułatwić wejście w świat HDTV, a przy tym wcale nie jest słabsza od produktów konkurencji dostępnych w zbliżonej cenie. Muszę również pochwalić ATI za sterowniki. Biorąc pod uwagę nową architekturę układu działają zaskakująco stabilnie, a w kwestii optymalizacji ich wydajności pewnie nie wszystko jeszcze zostało powiedziane. Natomiast dla tych wszystkich, którzy nie są przyciśnięci nieodpartą chęcią natychmiastowego wydania sporej gotówki mam nieco inną radę. Sugeruję poczekać na pojawienie się nowej serii kart ATI z najwyższej półki, a przynajmniej na kolejną recenzję, do pisania której już niedługo przystąpię. Dużo wskazuje na to, że największym zagrożeniem dla Radeona X1800XT może wcale nie być GeForce 7800 GTX, ale kolejny produkt przygotowany przez ATI.

|~| Sprawdź ceny Kart Graficznych w naszym sklepie: TwojePC.Emarket.pl |~|

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | Sapphire, Inc. |

|  | ASUS Polska |

|