|

TwojePC.pl © 2001 - 2025

|

|

S P R Z Ę T |

|

| |

|

SuperGrace 8500LE vs GeForce3 Titanium 500 SuperGrace 8500LE vs GeForce3 Titanium 500

Autor: Lancer

Data: 18/12/01

|

Kilkanaście dni temu Kris przedstawił recenzję karty Mint Radeon 8500LE. Kilka dni przed ukazaniem się jego recenzji, dzięki uprzejmości firmy Komputronik zdołałem i ja się przekonać co jest wart nowy układ ATI. W moje ręce wpadła karta firmowana przez SuperGrace, oparta również na układzie Radeon 8500LE. Niniejszy artykuł niech stanowi uzupełnienie wymienionej wyżej recenzji kolegi. Zapraszam więc wszystkich, którzy nie czytali pierwowzoru do zapoznania się z nim w pierwszej kolejności, a dopiero następnie do przeczytania moich spostrzeżeń. Ci którzy już to uczynili mogą czytać dalej ;) Moje wszelkie spostrzeżenia opieram na dotychczasowym punkcie widzenia wieloletniego posiadacza kart z chipsetami NVIDII, do których to będę się odwoływał. Przez ostanie 3 lata przewinęło się przez moje ręce kilkanaście kart na kilku chipsetach - TNT, TNT2, GeForce256, GeForce2 GTS, GeForce2 Pro, GeForce3 i GeForce3 Ti500 - jest więc do czego się odwoływać. Kilkanaście dni temu Kris przedstawił recenzję karty Mint Radeon 8500LE. Kilka dni przed ukazaniem się jego recenzji, dzięki uprzejmości firmy Komputronik zdołałem i ja się przekonać co jest wart nowy układ ATI. W moje ręce wpadła karta firmowana przez SuperGrace, oparta również na układzie Radeon 8500LE. Niniejszy artykuł niech stanowi uzupełnienie wymienionej wyżej recenzji kolegi. Zapraszam więc wszystkich, którzy nie czytali pierwowzoru do zapoznania się z nim w pierwszej kolejności, a dopiero następnie do przeczytania moich spostrzeżeń. Ci którzy już to uczynili mogą czytać dalej ;) Moje wszelkie spostrzeżenia opieram na dotychczasowym punkcie widzenia wieloletniego posiadacza kart z chipsetami NVIDII, do których to będę się odwoływał. Przez ostanie 3 lata przewinęło się przez moje ręce kilkanaście kart na kilku chipsetach - TNT, TNT2, GeForce256, GeForce2 GTS, GeForce2 Pro, GeForce3 i GeForce3 Ti500 - jest więc do czego się odwoływać. |

O KARCIE SUPERGRACE 8500LE

Zacznijmy od samego wyglądu karty. SuperGrace jest tak naprawdę tym samym co recenzowana przez Krisa karta Mint. Wyprodukowana przez ATI karta w wersji Radeon 8500LE - czyli jest taktowana domyślnie 250MHz rdzeń i 250MHz pamięć (DDR-500MHz), identyczna fizycznie w każdym milimetrze z Mintem. Te same pamięci 3,6ns Hynix, te same wyjścia, taki sam radiator z wentylatorem. Zawartość pudełka nie odbiega od tego co reprezentuje produkt Mint. Wszystko dosłownie jest tym samym. Tylko pudełko inaczej wygląda.

Jeśli chodzi o samą kartę to jest ona z punktu widzenia kolekcjonera kart NVIDII zupełnie czymś innym. O ile karty GeForce posiadają układy zasilające ułożone mniej więcej w jeden-dwa bloki, czyli są jako tako uporządkowane (przynajmniej w produktach opartych na wyrobie referencyjnym), to śmiało mogę powiedzieć, że na ATI panuje chaos. Duża liczba kondensatorów rozrzucona po całej płytce. Często rezystory i kondensatory są tak ułożone, że mocno utrudniają ewentualne założenie radiatorów na pamięci (o czym za chwilę). Karta jednak jest wymiarowo zbliżona do i tak stosunkowo dużej karty GeForce3, więc na niektórych płytach głównych może sprawić kłopot "tamując" pierwszy slot pamięci.

W listach do mnie dziwiliście się, dlaczego tak wysoko taktowana karta posiada tak słabe chłodzenie (w stosunku do GeForce3) - mamy tutaj zaledwie wentylator ze śladowo istniejącym radiatorem. Czyżby celowe obniżanie kosztów? Ja też się dziwiłem jak to może działać bez problemów, aż sam nie sprawdziłem tego własnym "paluchem". Tu mnie spotkał szok. Karta jest zimna jak żaden produkt NVIDII. Podobna temperaturę jak ATI mają karty GeForce, ale przy wyłączonym zasilaniu! Naprawdę przyłożenie palca po przeciwnej stronie chipu graficznego nie powoduje poparzenia - co więcej można, odnieść wrażenie, że Radeon wcale nie działa. Jak na mój palec (opatentuj ten miernik temperatury - przyp. Dyda) to w czasie mocnego obciążenia temperatura na powierzchni chipsetu wynosi około 30 stopni. Karta jest zimniejsza od GeFoprce2 MX. Co więcej, pamięci się również mało grzeją. Wspomnę tu, że w przypadku GeForców, pamięci są gorące częściowo, ze względu na przebicia termiczne z rdzenia. Właśnie ze względu na temperaturę karta jest tak "słabo" chłodzona. Śmiem nawet twierdzić, że pracowałaby stabilnie bez aktywnego chłodzenia, jedynie z samym radiatorem (oczywiście większym niż ten obecny w tej chwili). Wspaniała robota panowie! Teraz już wiem dlaczego między pamięciami są utrudniające założenie radiatorów rezystory i kondensatory. Bo radiatory są zupełnie zbędne. Pod znakiem zapytania staje także chęć własnoręcznego zakładania na kartę mocniejszego chłodzenia dla wyższego overclockingu - po co skoro karta jest zimna i się mało grzeje?

Pamięci na karcie

Skoro już o overclockingu mowa to niestety, ale karta posiada stosunkowo małe zapasy mocy. Z domyślnej wartości 250MHz rdzeń i 500MHz pamięć, rdzeń wykręciłem na 288MHz, ale pamięci ledwie na 540MHz. To niewiele biorąc pod uwagę, że na GeForce 3 Ti500 z 3,8ns pamięciami EliteMT wycisnąłem 573MHz. Niby pamięci o krótszym czasie dostępu, ale jednak słabe. Niestety, ale firma Hynix posiada jedne z najstarszych linii technologicznych pośród producentów układów DRAM i dlatego pewnie tak słaby rezultat. Z innej strony ATI od wielu lat współpracuje z Hyundaiem (czyli teraz Hynixem) i często takie właśnie moduły znajdziemy na kartach ATI. Po trzecie nie można bezpośrednio porównać pamięci na ATI i GeForce. Wszak obydwie są z zupełnie innej beczki, inaczej te dwie karty używają RAMu i posiadają inne timingi. Ale żal pozostaje, że tak mało z tych 3,6ns się wyciągnęło... choć z kolej po czwarte należy wspomnieć, że identycznych układów używa karta Radeon 8500 Retail taktowana standardowo na 550MHz, czyli wniosek stąd taki, że pamięć pamięci nie równa i na "pełne" Radeony trafiają te wybrane, wyżej chodzące układy.

JAKOŚĆ OBRAZU

Kolejną sprawą jest jakość obrazu podawanego na monitor. Jest ona wyśmienita i minimalnie (według mojego mocno subiektywnego odczucia), ale jednak lepsza od tej dawanej przez mojego GeForce. Różnica marginalna i ujawniająca się przy wyższych rozdzielczościach (1280x1024), ale jest. Jednak z tego co zauważyłem wraz z przejściem z GeForce2 na 3 karty NVIDII mają nieco lepszy obraz i są już bliższe temu co pokazują wyroby ATI i Matroxa, ale cały czas to trzecie miejsce.

Inna sprawa tyczy się wyjść obecnych na śledziu karty i ich roli. Obok zwykłego D-sub mamy TVout oparty na układzie konstrukcji samego ATI nazwanym Rage Theater. Nie zabrakło również popularnego ostatnio wyjścia DVI na monitory cyfrowe. Ponieważ karta posiada zintegrowane dwa układy RAMDAC, więc możemy posłużyć się dwoma zwykłymi monitorami CRT. No tak, ale gdzie ten drugi podłączyć? W pudełku znajdziemy przejściówkę DVI-D-sub. Dwa wyjścia monitorowe to rozwiązanie zbliżone do pioniera multimonitoringu - Matroxa. Powielone zostało ono przez NVIDIĘ w GeForce2 MX (chodzi o samą ogólną ideę), a wprowadzone dopiero przez ATI dopiero niedawno w karcie Radeon VE pod zapewne znaną już nazwą HydraVision. Warto zaznaczyć, że o ile pod szybkiego Radeona 8500 można podłączyć aż trzy wyświetlacze, to w produktach NVIDII potrafi to jedynie jak na razie już stara rodzina GeForce2 MX. Najprawdopodobniej zmieni się to już wkrótce i więcej niż jeden monitor będą obsługiwały nadchodzące NV17 i NV25.

Inna sprawa dotyczy samego DACa (konwerter cyfrowo-analogowy). O ile jest on zdublowany (po jednym na jedno wyjście monitorowe) to problem tyczy się jego samego taktowania. O ile część źródeł notorycznie pisze o taktowaniu 400MHz, to kilka innych (ponoć zbliżonych do ATI) przeczy temu i pojawia się wartość 350MHz - identyczna jak w GeForce3. Ale spór dotyczy raczej marginesu, gdyż tak wysokie taktowanie przyda się jedynie, jeśli nasz monitor może wyświetlić obraz powyżej rozdzielczości 2048x1536 czyli zarezerwowanej dla wysokiej klasy wyświetlaczy 21" i więcej. Decyduje to czy będziemy mieli odświeżanie 75Hz (350MHz RAMDAC), czy powyżej tej wartości (400MHz). Mój monitor przy 2048x1536 wyciąga tylko 60Hz...

STEROWNIKI

Już w driverach starego Radeona 256 zauważyłem pewną ciekawą rzecz. Podobnie jak oficjalne sterowniki NVIDII tak i te od ATI są spolszczone. Ale chyba trochę zbyt daleko idąca jest to polonizacja. O ile bowiem NVIDIA stosuje nazewnictwo tradycyjne - czyli np. Direct3D i OpenGL, to ATI posiada Bezpośrednie3D i OtwarteGL. Brzmi to kuriozalnie i powoduje salwy śmiechu u osób pierwszy raz to widzących. Jednak przetłumaczone są tylko zakładki w sterownikach przeznaczonych pod Windows9x w wersji do 4.13.7189. Wersja 7206 ma już standardowe nazwy - są bowiem w całości po angielsku :)

Zakładki sterowników

Niewątpliwie drivery posiadają więcej możliwości ustawień od DetonatorówXP, szczególnie dotyczących opcji wyświetlania samego obrazu (nie chodzi mi o jakość renderingu 3D). Bardzo spodobała mi się jedna z opcji. Ustawiamy w niej rozdzielczość i odświeżanie na stałe - ustawienie bazowe. Jakiekolwiek przestawienie rozdzielczości innej niż bazowa powoduje "symulację" nowo ustawionej. Jeśli powiedzmy ustawimy bazowo 1280x1024, a przestawimy pulpit na 1600x1200, to faktycznie jest to nadal 1280x1024, tyle że rozciągnięty pulpit ma wymiary identyczne z 1600x1200. Nie widać więc całego pulpitu ale jedynie te ustawione 1280x1024, reszta jest poza widzialną na kineskopie częścią pulpitu. Do niewidocznej części możemy się dostać przesuwając mysz do krawędzi ekranu (przewijanie). Rozwiązanie wydaje się początkowo mało poręczne i praktyczne, ale trochę praktyki powoduje, że staje się bardzo przydatne bo mamy większy pulpit, na którym zmieści się więcej niż jest faktycznie widoczne.

Niestety sam sterownik wymaga jeszcze sporo poprawek. Gdzieniegdzie w grach zdarzają się małe wpadki - pojawiają się załamania tekstur, czy też...ich brak. Momentami jest niezwykle denerwujące, lecz widać i tak spory postęp w stosunku do starszych wersji, gdzie liczba błędów była znacznie większa. Jedyną grą jaka cały czas sprawia kłopoty to Operation Flashpoint, gdzie notorycznie nie są wyświetlane niektóre tekstury żołnierzy. Może następna wersja będzie już lepsza, bo biorąc pod uwagę postęp jaki dokonał się z wersji driverów 7189 na 7206 można mieć niemal pewność, że będzie dobrze.

Braki w teksturach (kliknij)

Warto tu jeszcze wspomnieć o sławnej już optymalizacji sterowników pod Quake3, Sterowniki te pogarszały jakość tekstur celem podniesienia wydajności karty. Po fali krytyki jaka się przewinęła ATI odpuściła sobie i nowe drivery działają już "normalnie".

Ciekawostkę stanowią natomiast szybkie wpisy - FastWrite. Na mojej płycie głównej (ENMIC 8TCX2+) wersja sterowników 7189 posiadała włączone FastWrite, natomiast najnowsze już wyłączają tą opcję. Co ciekawe ręczne ich włączenie nie spowodowało dosłownie nic, ani wzrostu wydajności, ani spadku, ani nie zmieniła się jakość wyświetlanej grafiki. Karta bez problemu zniosła AGP taktowane zegarem 85MHz w trybie AGP 4x. Więcej nie próbowałem. Domyślnie włączony jest SBA - niezależnie od wersji driverów.

Małe słówko należy jeszcze się kwestii Truform. Jest. I tyle. Czy działa? Nie wiem. Poza demkami ATI nie udało mi się zauważyć różnicy w kształcie obiektów. W chwili obecnej posiadam 3 gry które "używają" tego gadżetu: Serius Sam, RTC Wolfenstein i Myth3. Niestety uaktywnienie opcji Truform czy to z linii poleceń, czy z opcji samej gry nie powoduje wcale zauważalnych od razu różnic w kształtach obiektów. Nachodziłem się długo szukając tych "truformów" i wielkich różnic nie zaobserwowałem (nic dosłownie nie widać w SS i Wolfenstein). Albo jest on tak marny, że go nie widać, albo producenci nie nauczyli się jeszcze go wykorzystywać (co wydaje się bardziej realne). Samo działanie tej opcji jest bardzo proste. Każdy obiekt 3D zbudowany jest z trójkątów. Im jest ich więcej, tym obiekt dokładniejszy, mniej kanciasty. Ale czasami ten trójkąt jest tak wielki i paskudny że obiekt wygląda nieznośnie. Dlatego też ATI (przy wsparciu programu) dzieli sobie go na kilka mniejszych trójkącików i w odpowiedni sposób modeluje - część kawałków podnosi, a cześć obniża dla nadania bardziej rzeczywistego kształtu,i aby na krawędzi obiektu część z tego podzielonego dużego trójkąta była na czubku głowy, a cześć przy podstawie czaszki. Właśnie obliczenie gdzie ma być dół, środek i góra tej rozkawałkowanej tekstury może sprawić problem. Sama metoda nie jest więc skomplikowana i czekamy na jej standaryzację i obsługę sprzętową nie tylko przez ATI (może by tak wprowadzić ja w DirectX 9?). Poniżej zamieszczam zrzut ekranu z Myth3 (OpenGL). Nie widać zasadniczych różnic w jakości postaci, ale przyjrzyjcie się bliżej otoczce i głowie postaci na pierwszym planie - czubek trochę bardziej okrągły.

Myth 3 z Truform...

|

...i bez Truform

|

Od zamierzchłych czasów Voodoo1 widoczna jest optymalizacja oprogramowania pod jakiś konkretny produkt. Wówczas był to Glide. Bardzo na tym cierpieli użytkownicy Rivy 128, która pracowała tylko z DirectX i OpenGL (wersja pełna). Dla Voodoo pisano tzw. miniporty OpenGL - obecne chociażby w Quake2. Pełnego OpenGL doczekano się dopiero z czasem nadejścia Quake3. Obecnie dominuje DirectX i OpenGL. Są obsługiwane przez niemal wszystkie karty 3D i skończyły się czasy dedykowanych API. Ale czy na pewno? Jak wiadomo NVIDIA ma największy kawałek w torcie rynku kart 3D. Od jakiegoś czasu chodzą plotki, że NVIDIA tworzy własny standard na kształt Glide. Oficjalnie zaprzecza, ale coś tam jednak chodzi. Jak może wiecie, Glide powstał na bazie OpenGL, tyle że mocno zmodyfikowanego i pociętego. Podobną sprawę widzimy obecnie. NVIDIA, dodaje do OpenGL swoje własne wpisy, obsługiwane tylko przez jej karty. Jak nietrudno się domyśleć, karty innych producentów nie bardzo zechcą z czymś takim gadać. Nie trzeba daleko szukać by znaleźć. Dwa programy testowe / gry - DrodeZ i GLmark na karcie ATI nie udostępniają części funkcji, które włączą się dopiero na GeForfce3. Obydwa zresztą są programami działającymi w OpenGL. Mam nadzieję, że wraz z rozpowszechnieniem się kart ATI proceder ten zniknie i developerzy będą stosować standardowe biblioteki, a nie optymalizowane.

GLmark

|

DrodeZ

|

W kwestiach technicznych warto wspomnieć o tym, że karta Radeon potrafi obliczać położenie obiektu w osi "Z" z dokładnością 32 bitów. GeForce robi to najwyżej w 24 bitach. Ale można też ustawić bufor Z na obecnie najbardziej rozpowszechnione (właśnie przez NVIDIA) 24 bity. Tyle mojego "marudzenia". Czas na testy...

TESTY

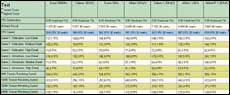

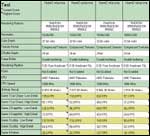

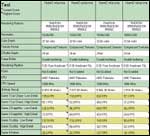

- elementy porównawcze - elementy porównawcze

- elementy wspólne platformy testowej - elementy wspólne platformy testowej

Widoczna ciekawa zmiana. O ile w standardowym teście demo001 i 16bitach szybszy jest produkt ATI to w pozostałych trzech mocy ubywa i daje się wyprzedzić. Być może ma to związek ze zdolnością Radeona do nakładania 6textur na obiekt w jednym przejściu, podczas gdy GeForce w tym samym czasie (1cykl) może nałożyć tylko 4 textury. W bardziej skomplikowanym demie Pureexce i demo001 ale przy 32bit liczyć zaczyna się już wydajność podsystemu pamięci. Wydajność może limitować lepiej zoptymalizowana współpraca z pamięcią lokalną. Jeśli tak to widoczna jest przewaga technologii Lighspeed nad HyperZ II, ale warto zaznaczyć, że taktowanie pamięci w obydwu kartach jest identyczne-500MHz.

3D Mark 2001

3D Mark2001 (kliknij)

W 3DMarku 2001 widać stopniowe pogorszenie się osiągów Radeona. O w 1026x768 przy 16bitach z łatwością pokonuje on GeForce, to w najwyższej rozdzielczości szybsza i to dość znacznie okazuje się być NVIDIA. Warto zauważyć stosunkowo niskie wyniki Radeona w teście Nature. Tu liderem i to zdecydowanym jest GeForce.

Stary już MDK2 wykazuje znaczącą przewagę najszybszego chipu graficznego ze stajni NVIDII

AvP wykazuje iluzoryczną przewagę ATI w 16 bitach i równie marginalną NVIDII w 32bitach. Jest to zachowanie podobne z Quake3 (gdy wydajność pamięci bardziej się liczy wówczas ATI mocniej traci na wydajności). Zadziwiają natomiast słabe wyniki Radeona przy rozdzielczości 800. Tu bezkonkurencyjny jest GeForce.

GeForce prowadzi. ATI o klasę za nim. Proszę zauważyć jak dotkliwie ATI przegrywa w 32bitach i rozdzielczościach 1024 i 1280. W 16bitach przewaga nie jest aż tak wysoka, ale jak niewiele stracił na wydajności produkt NVIDII przy zwiększeniu głębi kolorów.

Ghost Recon ma niedorobiony silnik 3D. Detalami nie powala, a wymagania ma spore. Niemniej w każdym teście (za wyjątkiem jednego) szybszym okazuje się być główny bohater opracowania. Warto zwrócić uwagę na minimalną liczbę klatek, która jest bardzo niska dla GeForce!

Najnowszy symulator Ubisoft nie jest mocną strona Radeona. Nie jest on w stanie dotrzymać kroku konkurentowi, który gna jak głupi.

Niewielka wygrana GeForce. ATI krok z tyłu.

Ten dosyć już leciwy symulator F/A18E faworyzuje raczej Radeona. Nie pracuje on niestety w 32bitach stąd tak skąpy pomiar

Niewielka wygrana GeForce w najwyższej dostępnej rozdzielczości tej strzelanki. Gunship! był tworzony jako następca sławnej gry z sprzed wielu lat, lecz został całkowicie skopany, stąd to raczej strzelanka niż symulator.

W 16bitach prowadzi ATI, lecz w 32bitach sytuacja się odwraca. Tylko 800x600 przy 32bitach jest łaskawe dlań, pozostałe parametry są już domena GeForce

Radeon o długość śledzia przegania GeForce. Jak zwykle rozdzielczość 800 jest tak samo trudna dla Radeona jak i GeForce.. Natomiast wraz ze wzrostem rozdzielczości i ilości kolorów GeForce coraz mocniej spada w notowaniach, podczas gdy ATI znacznie krócej sobie liczy scenę 3D.

No tym razem w 800x600 jest już nieco łaskawsze dla Radeona, ale i tak sumarycznie wygrał tytanowy GeForce.

Trzecia część przygód Mytha ;) faworyzuje produkt kanadyjczyków. O ile 16bit należy do NVIDII, to 32 już lepiej działa na Radeonie.

Większość testów należy do GeForce, ale w dwóch dzieją się ciekawe rzeczy. O ile w teście MedMCAD GeForce niemal o 100% okazało się szybsze od Radeona 8500LE, to z kolei ponad 2,5 raza szybszy był "radek" w ProCDRS! Ogólnie o pół grubości śledzia wygrał Radeon 8500LE zdobywając 229,14pkt (sumarycznie), podczas gdy GeForce3 Ti500 uzyskał 229,108.

HyperZ

Ponad rok temu, gdy na rynku pojawił się pierwszy Radeon (256) ATI wprowadziło nim metodę optymalizacji pracy pamięci, a konkretnie pamięcio-żernego bufora Z. Zbiór sztuczek pod nazwą HyperZ spowodował, że w wysokich rozdzielczościach Redeon był wyraźnie szybszy od GeForce2 GTS używającego pamięci w tradycyjny sposób. Nie inaczej jest z nowym produktem. ATI cofnęła się rezygnując z optymalizacji pamięci, a wprowadziła udoskonaloną jednostkę w postaci HyperZ II.

Sam kontroler pamięci posiada magistralę o szerokości 256 bitów. Radeon 8500 za każdym powtarzanym taktem zegara pobiera więc 256 bitową paczkę danych (dla porównania GeForce3 pobiera 32 bitowe paczki dla każdego z czterech kontrolerów. Widać tu już przewagę rozwiązania NVIDII. W chwili gdy dane mają owe 32bity to już mogą być przekazane dalej. Radeon musi czekać na pełne 256bitów. Poza tym GeForce ma małe, ale aż cztery niezależne podkontrolery, a Radeon jeden). Ale sam kontroler posiada wiele ciekawych rozwiązań. O ile podstawowa przepustowość jest na poziomie 7,45GB/s to faktyczna może dojść do 10,5GB/s. Jest to możliwe dzięki trzem metodom optymalizacji: Hierarchical, Z-Compression, Z-Clear.

Hierarchical Z-piksel zostaje usunięty z pamięci RAM karty jak tylko procesor graficzny dojdzie do wniosku, że według danych zawartych w buforze Z wynika, że jest on zasłonięty przez inny piksel. Podobną w zamyśle metodę stosuje NVIDIA w GeForce3. Nazwana jest ona HiddenSurfaceRemoval, a taka motoda kożystanoia z buforaZ ma swój początek w kartach PowerVR i jej renderingu kafelkowym.

HyperZ w 3D Mark2001 (kliknij)

Dalej jest jest Z Compression. Chyba tłumaczyć nie trzeba? Nazwa mówi sama za siebie Dodam tylko, że podobno jest to kompresja bezstratna. Podobny patent stosuje NVIDIA. Ostatni jest Fast Z-Clear czyli też wiele mówiące z nazwy czyszczenie bufora Z po zakończeniu budowy każdej klatki animacji. Aby się przekonać jak działa w praktyce HyperZ II w zakładce programu Radeon3D Tweak wyłączyłem HyperZ. Wyniki macie powyżej. Nietrudno zauważyć jak osiągi drastycznie spadły. Szczególnie duża jest strata w rozdzielczości 1600x1200.

Overclocking

O pułapkach overclockingowych była mowa już wcześniej, a teraz pora na kilka wyników.

Overclocking w 3D Mark2001 (kliknij)

Kartę STABILNIE (tj. komputer działał 6 godzin Quake3 w pętli) udało mi się co prawda wykręcić aż do 290/279, lecz ogromna ilość artefaktów uniemożliwia jakiekolwiek użytkowanie tak taktowanego wyrobu. W sieci jakiś czas temu pojawiły się BIOSy do karty Retail rozprowadzanej przez samą ATI (taktowanej częstotliwością 275/275). Tak więc kto odważny niechaj spróbuje przerobić wersje LE na Retail. Ja nie omieszkałem sprawdzić czy to w jakikolwiek sposób pozwoli zmusić kartę do pracy z taktowaniem pamięci 275MHz (550MHz DDR), bowiem pojawiły się plotki, jakoby po zaaplikowaniu BIOSu Retail niektórym udało się kartę znacznie lepiej podkręcić. Ja jednak w cuda nie wierzę i faktycznie karta podkręcała się identycznie jak przed moim zabiegiem. A taktowanie pamięci na 275MHz (DDR) powodowało błędy w grafice 3D.

Jak widać po wynikach podkręcona karta, mimo niewielkiego procentowo zysku jednak parę fpsów więcej wyświetliła. Największy zysk mamy jednak przy wysokich rozdzielczościach, co jednak nie dziwi.

Antyaliasing

Antyaliasing - wygładzanie ząbków na obiektach 3D nazwany przez ATI marketingowo SmoothVision działa w dwóch trybach. Tryb Performance polega na znanym już od dawna procesie przeskalowani, czyli wygenerowaniu sceny3D w rozdzielczości wyższej od ustawionej, a następnie uśrednieniu owej wyższej do docelowo ustawionej. Metoda druga-Quality to coś odmiennego. Polega ona na ułożeniu punktów do przeskalowania nie na sztywno, ale dowolnie tzn. ich rozłożenie daję się programować, układać według odpowiedniego schematu - tablicy. Suwakiem w sterownikach można regulować ilość tzw. próbek na każdy pixel do którego nastąpi uśrednianie (od 2 do 6).

Widoczny konsekwentny spadek wydajności zarówno karty ATI jak i NVIDII. Nieco dziwne jest zachowanie akceleratora GeForce w rozdzielczości 1280x1024 i 1600x1200. W trybie 2x i 4x wydajność jest niemal identyczna. Inna sprawa to że grafika strasznie skakała, a mimo to średni wynik to ponad 50fps. Czyżby ktoś tu oszukiwał?

PODSUMOWANIE

Produkt ATI niewątpliwie narobił zamieszania w branży 3D. Zapowiadany od wielu miesięcy pojawił się wreszcie w sklepach i na piedestale wydajności GeForce3 nie stoi sam. Mimo z pozoru nierównej walki (najszybszy GeForce3 kontra najwolniejszy Radeon 8500), Radeon jest w stanie nie tylko podjąć równą walkę, ale również powalić chwilami pewnego siebie GeForce - w niektórych testach jego wygrana jest zdecydowana, ale w innych przegrywa. Niewątpliwie minie jeszcze nieco czasu, zanim będzie do końca dojrzałym produktem. Sterowniki jeszcze "kuleją" i wymagają dopracowania, ale nic nie zmieni sytuacji, że w końcu pojawił się godny rywal dla obecnego od ponad pół roku na rynku GeForce3.

W naszych krajowych warunkach Radeon jest szczególnie wart uwagi ze względu na cenę podobną do GeForce3 Ti200, a wydajnościowo jest w stanie podjąć równoważną walkę ze znacznie silniejszym GeForce3 Ti500. Za nowym układem przemawia bardziej zaawansowana konstrukcja, choć obiektywnie rzecz ujmując, na dzień dzisiejszy nie ma oprogramowania zdolnego pokazać jaka moc drzemie nawet w półrocznym GeForce3, a co dopiero mówić o Radeonie. ATI posiada również doskonałą jakość obrazu, którą jednak doświadczą posiadacze monitorów co najmniej 19". Wszyscy, którzy pracują na systemach wielomonitorowych również dostaną to czego potrzebują. Bardzo wydajna karta z możliwością użycia dwóch wyświetlaczy jednocześnie. Z kolei po stronie produktów NVIDII przemawia długa obecność na rynku, doskonale dopracowane sterowniki i oprogramowanie, które nie całkowicie, ale choć częściowo potrafi pokazać niektóre funkcje 3D. A paradoksalnie właśnie w jakości oprogramowania drzemie główna moc kart graficznych.

Ale świat nie stoi w miejscu i mimo braków w oprogramowaniu operującym na całej masie nowinek technicznych zaszytych w akceleratorach, obydwaj giganci już przygotowują nowe układy z nowymi "bajerami" graficznymi. Świat jest asymetryczny. Jeszcze nie w pełni zaczęliśmy cieszyć się tym co mamy a już na horyzoncie pojawia się nowe Już za kilka miesięcy do nowego wyścigu, po nieukończonej jeszcze drodze wyjadą z boksu NVIDII NV25, a ATI R250. Wyścigu, który nieprędko się skończy, a który napędzamy my sami - kibice i klienci w jednym. Dopingujemy ich mimo że droga jest pełna kolein...

Zobacz także:

Kartę do testów dostarczyła firma: Kartę do testów dostarczyła firma:

|

|

|

Komputronik

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- Kilka uwag ... (autor: Kris-Redakcja | data: 18/12/01 | godz.: 01:22)

1) Wybrałeś konkurenta ... 50% droższego :-)

2) Pojawiły się już SuperGrace z Hynix 4ns.

3) Szkoda, że nie dałeś skalowania z CPU.

- Kilka odpowiedzi... (autor: Lancer-Redakcja | data: 18/12/01 | godz.: 08:23)

1. Akurat to mialem pod reka. Dopiero wczoraj dotarl do mnie GF3 Ti200 wiec uzupelnie wyniki o ta karte, choc jak nietrudno sie domyslec radek skopie mu tylek.

2. Moze i tak. Jaka roznica jak i tak niewiele sie pamieci chca o/c

3. Po co? Wystarczy zobzczyc na wyniki z Twojej recki by zobaczyc roznice :)

- Fee... (autor: Irek-brak rejestracji | data: 18/12/01 | godz.: 09:02)

Mimo wszystko niezly przekret - Ti500 zamiast Ti200.

- Fee... (autor: Irek-brak rejestracji | data: 18/12/01 | godz.: 09:03)

Mimo wszystko niezly przekret - Ti500 zamiast Ti200.

- A może by tak karty o porównywalnej cenie ... (autor: Andys74-brak rejestracji | data: 18/12/01 | godz.: 12:20)

Zgadzam się z moimi przedmówcami, że porównywanie Radka LE z Ti500 to chyba drobna przesada, myślę że wszyscy chętnie zobaczylibyśmy go w starciu z Ti200

- test radeona - streowniki (autor: fighter-brak rejestracji | data: 18/12/01 | godz.: 13:21)

użyjcie nowych sterow do ATI

6.13.10.3286 .... to zobaczycie jak skopią

Ti500 w teście NATURE

- ODP (autor: wasq-brak rejestracji | data: 18/12/01 | godz.: 13:32)

W tym tescie ATI jest z gory skazane na przegrana, to jest model LE czyli slabszy a jest porownywany z najmocniejszym Geforcem3Ti500. Nalezy poczekac na pelna wersje 8500 i dopiero wtedy porownac.

- Radeon ma nie dopracowane sterowniki (autor: Aro | data: 18/12/01 | godz.: 15:23)

Zobaczymy jak ATI wypuście nowe stery.

- GFORCE 3 to zwykle voodoo 1 (autor: TRUFORM-brak rejestracji | data: 18/12/01 | godz.: 16:10)

Juz dawno przestalem sie podniecac predkosciami, przyszlosc to lepsza grafika teksturowa jak widac ATI juz wyprzedzila

wszystkich swoim TRUFORM teraz pewnie NVIDIA ich wykupi bojac sie porazki jak z 3dfx

- Pochwała (autor: Czakuś-brak rejestracji | data: 18/12/01 | godz.: 17:02)

W końcu ktoś przeprowadził testy na AVP2

Ciesze się :>>

- Spoko spoko (autor: Lancer-Redakcja | data: 18/12/01 | godz.: 17:31)

Bedzie tuz po swietach (2 dzien swiat, moze dzien pozniej, zobacze jak mocno bede zywy wo swietowaniu :) dorzucone dodatkowe wyniki z GeForce3 Ti200 i pelnego Radeona 8500. Ti200 juz mam (zajebiscie sie podkreca!) a Radeon dojedzie do mnie jutro. Wiec juz niedlugo...

- radeon vs Geforce (autor: m.r-brak rejestracji | data: 18/12/01 | godz.: 19:07)

Pozdrawiam

Test ciekawy, w miarę obiektywny (wyraźnie zaznaczone, że do boju stanęły słabszy Radeon i maxymalny GF. Ja głosuję na Radeona. Czekam niecierpliwie na nowe testy. Wesołych Świąt M.R.

- radeon vs Geforce (autor: m.r-brak rejestracji | data: 18/12/01 | godz.: 19:07)

Pozdrawiam

Test ciekawy, w miarę obiektywny (wyraźnie zaznaczone, że do boju stanęły słabszy Radeon i maxymalny GF. Ja głosuję na Radeona. Czekam niecierpliwie na nowe testy. Wesołych Świąt M.R.

- radeon vs Geforce (autor: m.r-brak rejestracji | data: 18/12/01 | godz.: 19:07)

Pozdrawiam

Test ciekawy, w miarę obiektywny (wyraźnie zaznaczone, że do boju stanęły słabszy Radeon i maxymalny GF. Ja głosuję na Radeona. Czekam niecierpliwie na nowe testy. Wesołych Świąt M.R.

- do Lancera (autor: Combi_Nator | data: 18/12/01 | godz.: 19:31)

Możesz uchylić rąbka tajemnicy - jaki Tit200 i na ile sie kręci ?

- Dziwny ten test... (autor: Adie-brak rejestracji | data: 18/12/01 | godz.: 19:57)

Zamiast testować G3 Ti200 z R8500LE

albo G3 Ti500 z R8500

testujecie najsłabszego radeona8500 z najszybszym geforce'm 3 (to tak jak by porownywac G2 MX z G2 ultra) ...wyniki jednak są dużo lepsze niż myślałem ;-)

- Kilka ... (autor: Kris-Redakcja | data: 19/12/01 | godz.: 00:35)

Lancer: . Wystarczyło u/c do poziomu Ti200. Różnica ns faktycznie niewielka. Nie widzę potrzeby podkręcania 8500. Nie porównuj wyników na różnych systemach.

Fighter: stery 3286 nie są nowe i też wypada LE słabiej. I nic w tym złego.

Adie: Wyniki to nie wszystko. Radek jest wart kasy jeśli spojrzeć na kilka innych aspektów.

- Do Combi_Nator`a (autor: Lancer-Redakcja | data: 19/12/01 | godz.: 08:35)

Mam karte Gainwarda GF3 Ti200. Kreci sie na 255/560. Nawazie do tylu dojechalem, dalej jeszcze nie krecilem.

- TruForm ... (autor: Kris-Redakcja | data: 19/12/01 | godz.: 11:58)

W Serious Sam TruForm działa ... można "nadmuchać" nawet dubeltówkę :-)

- Video IN/OUT (autor: Netman-brak rejestracji | data: 19/12/01 | godz.: 13:05)

Gdzie testy ??????????? Bo się zdenerwowałem .........................................

- Aquanox (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:08)

Taka mala prosba. Nie wiem czy wykonalna :( Nie dalo by sie przetestowac na tych dwoch maszynkach Aquanoxa? To baardo mnie interesuje a nie widzialem jednoznacznej odpowiedzi co jest szybsze w tak nowej gierce. Pamietam jeszcze zachodnie testy w ktorych Radek wypadal baaardzo slabo. Prawdopodobnie bylo to przez to ze stery byly jeszcze stare. Dlatego fajne bylo by zobaczyc jak radzi sobie teraz.

- A tak wogole :) (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:20)

http://www.theinquirer.net/18120114.htm a tak wogole to sie szykuja nowe drivy :) podejzewam ze Ati cos przez ostatnie kilka tygodni przygotuje cos milego :0 tzn wzrost wydajnosci :) To zapewne. Skoro Nvidia moze co drivy optymalizowac to i Ati pewno ta trasa poleci. Szkoda tylko ze drivery nie wychodza szybciej jak detki.

- A tak wogole :) (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:21)

http://www.theinquirer.net/18120114.htm a tak wogole to sie szykuja nowe drivy :) podejzewam ze Ati cos przez ostatnie kilka tygodni przygotuje cos milego :0 tzn wzrost wydajnosci :) To zapewne. Skoro Nvidia moze co drivy optymalizowac to i Ati pewno ta trasa poleci. Szkoda tylko ze drivery nie wychodza szybciej jak detki.

- A tak wogole :) (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:22)

http://www.theinquirer.net/18120114.htm a tak wogole to sie szykuja nowe drivy :) podejzewam ze Ati cos przez ostatnie kilka tygodni przygotuje cos milego :0 tzn wzrost wydajnosci :) To zapewne. Skoro Nvidia moze co drivy optymalizowac to i Ati pewno ta trasa poleci. Szkoda tylko ze drivery nie wychodza szybciej jak detki.

- A tak wogole :) (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:23)

http://www.theinquirer.net/18120114.htm a tak wogole to sie szykuja nowe drivy :) podejzewam ze Ati cos przez ostatnie kilka tygodni przygotuje cos milego :0 tzn wzrost wydajnosci :) To zapewne. Skoro Nvidia moze co drivy optymalizowac to i Ati pewno ta trasa poleci. Szkoda tylko ze drivery nie wychodza szybciej jak detki.

- ??? (autor: Lancer-Redakcja | data: 19/12/01 | godz.: 13:27)

Jak mam zrobic test TVin skoro karta go nie po posiada? Testow TVout nie robilem bo po co? Jesli czytales uwznie text to wiesz dlaczego...

- o cholera (autor: Ducek-brak rejestracji | data: 19/12/01 | godz.: 13:32)

Co do diabla. Klikalem to nie dzialalo a nagle x4. Usuncie to bo kiepsko to wyglada :) i sory!

p.s Lancer - jak z tym Aquanox :)?

- strey (autor: fighter-brak rejestracji | data: 19/12/01 | godz.: 17:24)

Kris:

tak sie zagalopowałem z tymi sterami ......

ale mam radeona 8500 (ATI) i wyniki

są naprawdę wieksze w tescie NATURE

- podkrecanie (autor: klopsik18-brak rejestracji | data: 19/12/01 | godz.: 18:42)

Mam ta karte od 4 dni i chodyi przetaktowana na 275/275 bez zgrzytw, ogolnie jest git tylko pamiec wydaje mi sie zbyt goraca

- T&L (autor: mechl!n-brak rejestracji | data: 19/12/01 | godz.: 19:45)

Może wyjdę na ignoranta, ale czy Radeon posiada jednostkę T&L? Merry Xmas 4 all.

- Kilka ... (autor: Kris-Redakcja | data: 19/12/01 | godz.: 23:55)

fighter: Kwestia procka i/lub ustawień. U mnie zawsze R8500 za GF3.

mechl!n: Posiada. I co ważne pracującą równolegle z PixelShaderem (GF3 emuluje T&L na PS stąd te spore różnice w niektórych testach 3DM2K1).

- odp (autor: Lancer-Redakcja | data: 20/12/01 | godz.: 08:56)

1. fighter-na jakim o/sjedziesz i jaka wersja sterow?

2. klopsik18 jakiego producenta karta?

3. machl!n-tak posiada takie ATIowe T&L tylko marketingowo ATI inaczej go nazywa

- hmm ... (autor: pachus | data: 20/12/01 | godz.: 09:27)

posiada jakas T&L drugiej generacji .

Nie widzialem tego w akcji , ale na moim R7500 przy starym T&Lu Colin2 wyglada o wiele paskudniej niz na GTS...

Nie to zebym odrazu twierdzil , ze nVidia jest the best :))

- Pewnie! (autor: Ducek-brak rejestracji | data: 20/12/01 | godz.: 11:53)

Pewnie ze ma! Do tego sprawuje sie lepiej niz T&L Nvidia popatrz se na glupia sprawe w 3dmkar2001 w 1light wyniku i 8 light. W przypadku ATI jest to prawie 3 krotnie wiecej. Geforce to bardzo przestazala konstrukcja w porownaniu z Radkiem. I cos widze ze Nvidia nadal nic nie rusza. Bo Nv25 ma miec chyba z jeden tylko wiecej silnik text. I dodadza najwyzej pixel shader 1.4

- kupuje Gf 3 t500 (autor: lunatyk-brak rejestracji | data: 21/12/01 | godz.: 21:30)

nic dodać nic ujonć

- ATI roxx (autor: NICK/Darth-brak rejestracji | data: 22/12/01 | godz.: 14:39)

Cos we mnie weszlo i kupilem 8,5K

Niestety wlasnie z 4ns RAM pomimo ze to OEM

Nie krecilem ale pamiec tab bardzo goraca nie jest.Zamisat TnL HARDWARE w 3dm.2k1 jest PURE TnL.Jak idzie ojakosc 2D to obecnie faworyetm moim jest Prophet4500 oraz(w duzysz rozdzileczosciach)ATI

- Podkręcanie (autor: Misiu777-brak rejestracji | data: 25/12/01 | godz.: 14:12)

Pamieci w oryginalnym pudelkowym ATI nie sa jakos selekcjonowane one po prostu pracuja z napieciem 3,5V a na wersjach innych producentow mimo ze te same moduly to sa zasilane napieciem 3,2 V przez co nie da sie wycisnac z nich wiecej niz 540 MHz. szczegoly tutaj: http://www.rage3d.com/...page=20&pagenumber=16

- Stery i testy (autor: ChrisG-brak rejestracji | data: 26/12/01 | godz.: 00:15)

Sciagnijcie stery do Win98 versja beta w9x_9005 to dopiero zobaczycie co Radeon potrafi np.w Nature skok jest poterzny bo podskoczyl o 10 klatek.

- ATi Radeon 8500 (autor: DJ Paul-brak rejestracji | data: 15/01/02 | godz.: 19:31)

Mam problem, niektore gierki (Comanche 4) nie chca chodzic, pelen hamulec! pod XP, zmieniam karte na ASUS GeForce2 GTS Pro - kein problem, wszystko lata...Probowalem roznych driverow dla Radeon 8500 pod XPka, nic... Kto wie, w czym problem. Dzieki:)

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

All rights reserved ® Copyright and Design 2001-2025, TwojePC.PL |

|

|

|