nVidia GeForceFX 5800 Ultra - pierwszy kontakt

Autor: Kris | Data: 15/04/03

| |

|

Testy podstawowe w trzecim wymiarze

(kliknij, aby powiększyć)

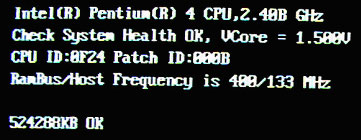

Najpierw parę słów na temat sprzętu testowego oraz sterowników. Wyniki zbierane były na zestawie P4 2.4/533, 512MB PC800, GA-8IHXP dźwięk CT5880, Sirtec 300W, Windows XP Pro SP1, Detonator 43.45. W porównaniach uczestniczył GF4Ti4600 (Gainward, sterownik 40.42) oraz Radeon 9700Pro (ATI OEM, sterownik 3.1). Gry testowe starałem się ustawić na jak najlepszą jakość obrazu i tak gdzie to było możliwe wyłączałem dźwięk. Sterowniki działały w na domyślnych ustawieniach + vsynch Off.

(kliknij, aby powiększyć)

Zacznę od tego, że zagadnienie określenia wydajności GFFX nie jest zadaniem trywialnym. Nie ulega najmniejszej wątpliwości, że najnowsze karty graficzne nie mają żadnych problemów z "rozprawieniem" się z klasycznymi grami testowymi. Uzyskiwane w testach średnich fps wyniki często prowadzą na manowce. Różnice bardziej związane są z optymalizacją działania na prostych ramkach czy wykorzystaniem procesora. Jeśli są one duże to również należy przyczyn upatrywać bardziej w kwestii błędu sterownika czy optymalizacji kodu pod dany układ graficzny. Dopiero po uniezależnieniu wyników od procesora i zmuszeniu karty do potężnego wysiłku wychodzą rzeczywiste różnice, które możemy odnieść do potencjalnych możliwości karty w przyszłych, wymagających grach.

W przypadku GeForceFX i sterownika 43.45 najciekawszym elementem jego ustawień był dla mnie suwak optymalizacji wydajności. Domyślnie był on ustawiony w położeniu środkowym, oznaczającym optimum, natomiast przesuwając go na lewo zmuszamy kartę do postępowania zgodnie z tym, czego wymaga od niej aplikacja. Nasuwa się pytanie, co i jak jest optymalizowane oraz jaki to ma realnie wpływ zarówno na wydajność jak i jakość obrazu. Możliwości, jakie daje architektura NV30 są bardzo duże. Badając wpływ optymalizacji wydaje mi się, że udało się programistom zachować jakość obrazu w zasadzie niezmienioną w stosunku do oryginalnej. Dopiero dokładna analiza szeregu następujących zrzutów ekranu wykazuje minimalne różnice, które głównie sprowadzają się do palety barw. W trakcie gry nie sądzę, aby ktokolwiek to zobaczył. W związku z tym nie widzę przeciwwskazań, aby testować kartę na domyślnych ustawieniach zoptymalizowanych. Jedynie, co niepokoi to fakt, że ta optymalizacja głównie wpływa na wyniki testów 3DMarka 2003 i 2001 SE. W grach różnice w wynikach są zdecydowanie mniej spektakularne. Miło, że producent stara się, aby gry chodziły lepiej, ale wygląda na to, że jak na razie nVidia głównie "bawi się" w nabijanie punktów w syntetycznych testach. Szczególnie smuci mnie fakt, że obiektem badań programistów stał się 3DMark 2003, bo jak na razie nie ma dostępnych innych testów Dx9, a kupujący taki sprzęt chciałby wiedzieć, co może się po karcie spodziewać w momencie pojawienia się odpowiednich gier na rynku. Trudno. Pozostawiam optymalizację, wyłączam vsynch i przystępuję do testów, co od razu boleśnie uderza w uszy wszystkich domowników.

Oczywiście nie może zabraknąć mojego typowego "garnituru" testów, którego wyniki są wprost porównywalne z wszystkimi innymi testami przeprowadzonymi na tej platformie testowej. Czas rozpocząć numerologię dydaktyczną. W większości przypadków, w zasadzie komentarz jest zbyteczny.

Bez 1024x768 trudno w ogóle wyczuć w grze różnicę pomiędzy wszystkimi trzema kartami pomimo różnic w wynikach. W 1600x1200 zaznacza się przewaga nowych kart. GFFX i R9700P działają w zasadzie tak samo. Remis.

Ta gra nie stanowi problemu dla żadnej z kart, ale GFFX w 1600x1200 niepokojąco słabnie. Stawiam na błąd sterownika. Punkt dla Radeona.

Sytuacja zbliżona do testu Aquanox. Remis.

Wszystkie karty bez problemów "rozprawiają" się z JK2. Nie czuć różnicy na żadnej z kart. GFFX ma parę punktów więcej z uwagi na lepszą optymalizację wykorzystania procesora, który w obu przypadkach jest barierą dla wyników. Może przy 5GHz można by było stwierdzić, która karta jest mocniejsza. Z konieczności jak dla mnie remis.

Również i Giants nie sprawia kłopotów "gigantom". Następny remis. Wydaje mi się jednak, że przy mocniejszym procesorze GFFX położyłby konkurencję.

W końcu można się wykazać mocą. Karty mają, co robić i GFFX spokojnie zdobywa punkt.

Tym razem punkt dla Radeona. Moim zdaniem nie jest to kwestia słabości sterownika, ale właściwość samej gry, która ma procedury dostosowania się do sprzętu i nie znając GFFX nie dała mu typowej optymalizacji dla GeForce.

Mój specyficzny test chwilowego fps w konkretnym, mocno nieprzyjemnym dla kart miejscu. GFFX górą. Oczywiście nie należy z tego wyciągać wniosków, co do zachowania się kart w grze. W 1024x767 żadna nie ma problemów.

Oj widać różnicę do starszej generacji kart. Na nowych kartach gra się podobnie, ale proponuję punkt dla GFFX.

W tej rozdzielczości niewiele można wyciągnąć sensownych wniosków. Wszystkie trzy karty "chodzą" podobnie a jedyne różnice w testach gier znaleźć można w demie Nature. Jak dla mnie remis. Analizując testy dodatkowe GFFX, przyciąga uwagę słaby (w stosunku do taktowania) Fill-Rate w pojedynczym teksturowaniu i Advanced Pixel Shader. Natomiast niespodziewanie wysoki jest wynik jaki osiąga karta w teście High Poly Count (8 źródeł światła). Z jednej strony jest to zaleta wysokiego taktowania rdzenia ale z drugiej strony wynik optymalizacji w sterowniku. Porównajmy z ustawieniami "aplikacyjnymi" (wyłączenie optymalizacji).

Jak widać oprócz ogólnego, niewielkiego osłabienia właśnie "wylazła" duża różnica w teście HPC8.

|

|

|

Rozdziały: nVidia GeForceFX 5800 Ultra - pierwszy kontakt |

|

| |

|

|

|

|

|

|

|

|