Nowe ośmiopotokowce: GeForce 6600GT / GeForce 6800LE

Autor: Kris | Data: 04/10/04

|

Po kilku miesiącach od premiery nowej generacji układów graficznych doczekaliśmy się zejścia tych samych technologii w obszary bliższe naszym portfelom. Okazją do napisania tego artykułu było udostępnienie przez nVidia referencyjnego egzemplarza karty, opartej na nowym rdzeniu NV43, który ma spore szanse na przejęcie znacznej części rynku PCI Express. Jego odpowiednikiem cenowym dla AGP jest aktualnie GeForce 6800LE, którego pierwsze egzemplarze pojawiły się w sprzedaży. Aby porównanie było pełniejsze, nowe karty wystąpią na tle trzech innych produktów. Będą to GeForce 6800, GeForceFX 5900 XT oraz Radeon 9800 Pro. Sądzę, że taki właśnie dobór kontrkandydatów jest najciekawszy. Tym bardziej, że wszystkie karty mają po 128MB pamięci lokalnej, co jest ważne dla prawidłowej oceny wyników przeprowadzonych testów. W artykule spróbuję również odpowiedzieć na pytanie, jakie znaczenie ma, w świetle aktualnych gier, posiadanie karty 256MB. Test umożliwiły firmy Gigabyte, Multimedia Vision oraz Nvidia, którym niniejszym dziękuję za udostępnienie odpowiedniego sprzętu. Tym razem część teoretyczną ograniczyłem do minimum w związku z większą ilością testów fps. Zapraszam do porównania. Po kilku miesiącach od premiery nowej generacji układów graficznych doczekaliśmy się zejścia tych samych technologii w obszary bliższe naszym portfelom. Okazją do napisania tego artykułu było udostępnienie przez nVidia referencyjnego egzemplarza karty, opartej na nowym rdzeniu NV43, który ma spore szanse na przejęcie znacznej części rynku PCI Express. Jego odpowiednikiem cenowym dla AGP jest aktualnie GeForce 6800LE, którego pierwsze egzemplarze pojawiły się w sprzedaży. Aby porównanie było pełniejsze, nowe karty wystąpią na tle trzech innych produktów. Będą to GeForce 6800, GeForceFX 5900 XT oraz Radeon 9800 Pro. Sądzę, że taki właśnie dobór kontrkandydatów jest najciekawszy. Tym bardziej, że wszystkie karty mają po 128MB pamięci lokalnej, co jest ważne dla prawidłowej oceny wyników przeprowadzonych testów. W artykule spróbuję również odpowiedzieć na pytanie, jakie znaczenie ma, w świetle aktualnych gier, posiadanie karty 256MB. Test umożliwiły firmy Gigabyte, Multimedia Vision oraz Nvidia, którym niniejszym dziękuję za udostępnienie odpowiedniego sprzętu. Tym razem część teoretyczną ograniczyłem do minimum w związku z większą ilością testów fps. Zapraszam do porównania. | |

|

Teoria i sprzęt testowy

7 września nVidia zaprezentowała światu swoje najnowsze dziecko. Układ o nazwie kodowej NV43 ujrzał światło dzienne, zasilając karty serii GeForce 6600. Jest to pierwszy rdzeń nVidia wyposażony w natywną obsługę szyny PCI Express x16 i pierwszy wykonany w nowej technologii 0.11um, opracowanej przez firmę TSMC (Taiwan Semiconductor Manufacturing Company). W związku z tym, że wywodzi się bezpośrednio z architektury NV40, charakteryzuje się tą samą funkcjonalnością w zakresie obsługi efektów 3D, jaką szczycą się karty serii GeForce 6800. Między innymi chodzi o Pixel i Vertex Shader w specyfikacji 3.0, technologię Ultra Shadow II, Intellisample 3.0 czy na przykład High-Precision Dynamic Range. Szerszy opis nowych możliwości nVidia zainteresowany znajdzie w teście "Nowa Generacja".

Układ NV43 składa się z 143 mln tranzystorów. Dla porównania NV40, który był jego bazą, ma ich aż 220 mln. O połowę zmniejszono ilość potoków pikseli, werteksów oraz kontrolerów pamięci. W oparciu o NV43 przedstawiono dwie karty, różniące się taktowaniem oraz klasą zastosowanych układów pamięci: GeForce 6600 oraz GeForce 6600 GT. Dla mocniejszej wersji GT przewidziano zastosowanie 128MB pamięci GDDR3 taktowanej 500MHz, natomiast dla słabszej 128/256MB, w klasycznych modułach DDR (250-300MHz). Taktowanie rdzeni odpowiednio 500 i 300MHz. Wersja GT ma dodatkowo gniazdo SLI (łączenie dwóch kart w celu uzyskania większej wydajności). W związku z tym, że w tej recenzji nacisk chciałem położyć na kwestię wydajności, to część teoretyczną ograniczam do minimum. Ewentualnie kilka dodatkowych informacji postaram się przemycić w podsumowaniu.

W przypadku platform PCI Express GeForce 6600 GT będzie walczył z Radeonem X700 XT (jeszcze nie miałem okazji testować), natomiast w obszarze AGP nVidia wystawiła GeForce 6800LE. Jest to nic innego jak, poznany wcześniej, GeForce 6800 z minimalnie niższym taktowaniem rdzenia, zablokowanym kolejnym Quadem (łącznie ma 8 potoków pikseli) i jednostką Vertex (łącznie ma ich 4).

Kartę GeForce 6600 GT testowałem przy pomocy platformy sprzętowej pożyczonej przez firmę Gigabyte. Płyta Gigabyte GA-8GPNXP Duo, procesor Intel Pentium 4 3.2GHz, 2x 512MB DDR-400. Więcej informacji można znaleźć w teście PCI Express. Firma Gigabyte wypożyczyła również do testów porównawczych, znaną z wcześniejszej recenzji, kartę Gigabyte GeForceFX 5900 XT. Wszystkie karty AGP testowane były na zestawie Asus A7N8X, Barton 2400MHz, 2x 512MB DDR-400. System Microsoft Windows XP SP2. Sterowniki ATI Catalyst 4.9 oraz nVidia Detonator v66.32 (beta). Ustawienia domyślne oprócz wyłączenia vsynch.

Gainward PowerPack! Ultra/2100 TV-DVI Golden Sample

(kliknij, aby powiększyć)

Pod tą tajemniczą nazwą kryje się GeForce 6800 128MB w wydaniu firmy Gainward. 12 potoków, pamięci DDR na szynie 256-bitowej. Karta pożyczona została przez firmę Multimedia Vision - dystrybutora Gainward w Polsce. Średniej wielkości pudełko w typowej dla tego producenta szacie graficznej zawierało oprócz karty:

- 2x płyta CD z pełną wersją gry Chrome

- Obszerna, kolorowa instrukcja instalacji i obsługi karty w języku polskim. 64 strony z opisem instalacji, podłączeń ekranów, ustawień sterownika, dodatkowego oprogramowania i słowniczkiem pojęć. Wzór do naśladowania dla innych dystrybutorów.

- Uproszczona instrukcja instalacji w języku angielskim

- Płyta CD z oprogramowaniem WinDVD 4 w wersji wielokanałowej

- Płyta CD z oprogramowaniem muvee autoProducer 3 do automatycznego tworzenia filmów

- Voucher uprawniający do zakupu wybranych elementów wyposażenia peceta po preferencyjnych cenach

- Rozgałęźnik zasilania Molex

- Przejściówka S-Video (miniDIN 4-piny) -> Composite (Cinch)

- Przejściówka DVI -> VGA

- Płyta CD ze sterownikami (v60.85) i oprogramowaniem narzędziowym EXPERTool (v3.16)

- Firmowy znaczek na obudowę peceta

Do wyposażenia trudno mieć zastrzeżenia. Pełna wersja gry, odtwarzacz DVD, komplet przejściówek. Z pewnym zdziwieniem powitałem jedynie program autoProducer, bo karta nie ma wejścia wizyjnego. Sam chętnie zamieniłbym go na drugą grę, ale może wymagam za dużo. Dwupłytowa gra Chrome w opakowaniu typu DVD nie zmieściła się do pudełka. Dołączana jest zewnętrznie i przytwierdzona folią.

(kliknij, aby powiększyć)

Karta opiera się na czerwonym laminacie o referencyjnym schemacie. Nadruk z napisem Gainward nie pozostawia wątpliwości, kto jest jej producentem. Osiem kości BGA DDR 2.2ns rozmieszono parami wokół rdzenia na awersie. Chłodzenie, choć w pierwszej chwili wydaje się zbliżone do konstrukcji referencyjnych nVidia to, po dokładniejszym badaniu, wygląda na projekt Gainwarda. Jest to miks rozwiązań znanych z innych kart serii 6800. Główne różnice polegają na chłodzeniu pamięci. Zastosowano rozwiązanie niemal identyczne jak w wersji Ultra, ale po zmniejszeniu wysokości listków tak, aby nie były wyższe od radiatora rdzenia, którego chłodzenie zapewnia klasyczna turbinka o działaniu odśrodkowym. Duża liczba łopatek, wysokość tak dobrana, aby nie przesłaniać slota PCI znajdującego się obok złącza AGP. Zarówno obudowa jak i wentylator wykonano z przezroczystego tworzywa. Daje to dodatkowy efekt wizualny w połączeniu z czerwonym podświetleniem wirnika. Obudowę przesłania starannie wykonana blaszka z wytłoczką i wycięciem znaku producenta, w kolorze dobrze komponującym się z laminatem. Muszę przyznać, że tak jak niezbyt zachwyciły mnie brzęczące, blaszane "ognie" serii FX, tak teraz jestem pod wrażeniem działań stylistów Gainwarda. Na śledziu gniazda VGA, DVI oraz TV-Out (miniDIN 4-piny). Karta wymaga dodatkowego zasilania, w postaci pojedynczego gniazda Molex. Jest też brzęczyk informujący nas o braku podłączenia karty do zasilacza. Całość waży 365g.

(kliknij, aby powiększyć)

Po włączeniu wentylator generuje spory hałas. Nie jest to poziom znany z głośnych Gainward'ów 16-stopotokowych, ale jest dosyć dokuczliwy. Na szczęście, po instalacji sterowników, zmniejsza się do zupełnie akceptowalnego. Mógłbym go określić jako średni. Pewnie większości użytkowników nie będzie przeszkadzał, choć do konstrukcji cichych pecetów wymagałby dalszych modyfikacji. Jakość obrazu bez zastrzeżeń do 1600x1200@85Hz włącznie. W czasie intensywnego wysiłku karta rozgrzała się do temperatury ok. 50-55 stopni. Jedynie elementy stabilizatora dochodziły do 60 stopni. Pobór mocy z sieci energetycznej sięgał 65W.

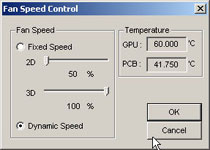

Po uruchomieniu firmowego tweakera Gainward EXPERTool taktowanie zmieniło się z domyślnego 325/350MHz na 350/400MHz. Tyle gwarantuje nam producent w przypadku wersji "Golden Sample". Oprogramowanie ma możliwość sterowania obrotami wentylatora, ale w stosunku do wyciszenia samymi sterownikami znacząco większego efektu już nie uzyskałem. Nie było natomiast problemu z większym podkręcaniem. Końcowy wynik badań to 390/430MHz.

Sugerowana przez dystrybutora cena detaliczna wynosi 1695 zł. Gwarancja 3 lata w systemie S.O.S. (serwis odbiera sprzęt).

Gainward PowerPack! Ultra/2100LE TV-DVI OEM

(kliknij, aby powiększyć)

Muszę przyznać, że to zdecydowanie najbardziej tajemniczy model w ofercie tego producenta. Karta pożyczona została przez firmę Multimedia Vision - dystrybutora Gainward w Polsce. Jest to najtańsza odmiana rdzenia NV40 zwana GeForce 6800 LE. Teoretycznie nie występuje w sprzedaży detalicznej. 8 potoków (dwa zablokowane Quady), 128MB pamięci DDR na szynie 256-bitowej. Karta występuje w postaci OEM. Czym jest OEM dla Gainwarda zaraz się przekonamy. Po pierwsze rzuca się w oczy zupełnie białe pudełko, bez oznaczeń producenta. Jedynie niewielka nalepka z zagadkowym dla niewtajemniczonych oznaczeniem "PP! Ultra/2100LE TV-DVI OEM" wskazuje na jego zawartość. W środku, oprócz karty znajdziemy:

- Obszerna, czarno-biała instrukcja instalacji i obsługi karty w języku polskim. 64 strony z opisem instalacji, podłączeń ekranów, ustawień sterownika, dodatkowego oprogramowania i słowniczkiem pojęć. Wzór do naśladowania dla innych dystrybutorów.

- Uproszczona instrukcja instalacji w języku angielskim

- Płyta CD z oprogramowaniem muvee autoProducer 3 do automatycznego tworzenia filmów

- Rozgałęźnik zasilania Molex

- Przejściówka S-Video (miniDIN 4-piny) -> Composite (Cinch)

- Przejściówka DVI -> VGA

- Płyta CD ze sterownikami (v61.76) i oprogramowaniem narzędziowym EXPERTool (v3.18)

(kliknij, aby powiększyć)

Na instrukcji przykuwa wzrok napis: "Wersja OEM - sprzęt przeznaczony do dystrybucji TYLKO w zestawach komputerowych". W odróżnieniu od innych kart Gainward, nie ma w zestawie gry Chrome. Jest za to komplet dodatków sprzętowych i autoProducer, który już poprzednio wywoływał moje zdziwienie, z uwagi na brak wejścia wizyjnego. Jako, że jest to dodatkowy "gadżet", to oczywiście cieszy. W zestawie nie znalazłem również programowego odtwarzacza WinDVD. Szkoda.

Oznaczenia "OEM" i przeznaczenie karty do sprzedaży w zestawach ma głównie charakter oficjalny. Związane jest z aktualnym wymogiem nVidia w stosunku do 8-potokowców. Nie jest to jednak specjalnie uciążliwe dla potencjalnego klienta, bo oprócz tych ostrzegawczych napisów i braku możliwości zakupu detalicznego bezpośrednio u dystrybutora, nie ma problemów ze zdobyciem tej karty "luzem". Większość sklepów nie robi z tym żadnego problemu. W sumie sytuacja jest nieco zabawna, ale sam zestaw wcale nie jest gorszy od niektórych produktów, w ładnych kolorowych pudełkach.

Karta oparta jest na czerwonym laminacie wersji 12-potokowej. Oczywiście produkcja własna Gainwarda. Osiem kości BGA 2.2ns (według informacji producenta) umieszczono parami wokół rdzenia na awersie. Każda para ma dodatkowe chłodzenie w postaci aluminiowych radiatorków mocowanych klejem przewodzącym ciepło. Na śledziu gniazda VGA, DVI oraz TV-Out (miniDIN 4-piny). Pojedyncze gniazdo Molex niezbędne jest do zapewnienia karcie odpowiedniej mocy z zasilacza. Brzęczyk informuje o jej braku. Podstawowa różnica konstrukcyjna w stosunku do 6800 polega na zmianie chłodzenia rdzenia. Zastosowano średniej wielkości "bocznowydmuchowiec" z asymetrycznie położonym, niewielkim wentylatorem (podłączenie dwupinowe). Mocowanie dwupunktowe na kołkach powoduje odklejanie się radiatora od układu graficznego przy ściśnięciu jednej ze stron. Sugeruję, aby przy wkładaniu karty trzymać palce z daleka od radiatora. Karta waży 250g.

(kliknij, aby powiększyć)

Po włączeniu zasilania chłodzenie wita nas umiarkowanym hałasem. Poziom akceptowalny choć do cichych nie należy. Po wgraniu firmowego tweakera EXPERTool mamy możliwość sterowania obrotami wentylatora. W położeniu minimalnym robi się bardzo sympatycznie. Nadal słyszę go wyraźnie, ale już większości użytkowników nie powinien przeszkadzać. Poziom średni-cichszy. Nie ukrywam, że karta od razu "zapunktowała" u mnie dodatkowo. Jakość obrazu bardzo dobra, choć wydaje mi się, że w średnich trybach ma minimalnie mniejszą ostrość, niż wersja 12-potokowa. Jeśli nie jest to przywidzenie to raczej wynika z działania konkretnego egzemplarza, bo moim zdaniem filtry wyjściowe obie karty mają takie same. Po chwili użytkowania nastąpiło dostosowanie i nic już nie przeszkadzało w odbiorze obrazu do 1600x1200@85Hz włącznie. W zasadzie brak uwag. Po dłuższym czasie intensywnej eksploatacji karta rozgrzała się do temperatury 45-50 stopni, a pobór mocy z sieci energetycznej sięgał 50W.

Sugerowana przez dystrybutora cena detaliczna wynosi 1275 zł. Gwarancja 3 lata w systemie S.O.S. (serwis odbiera sprzęt).

nVidia GeForce 6600 GT 128MB PCI Express x16

(kliknij, aby powiększyć)

Dzięki uprzejmości firmy nVidia miałem również okazję sprawdzenia możliwości ich najnowszego "dziecka". Był to produkt referencyjny bez żadnych dodatków sprzętowych i opakowania. Do wyposażenia mogłem jedynie zaliczyć woreczek foliowy, w którym karta była transportowana.

Zielony laminat "klasycznych" rozmiarów. Tak. To nie pomyłka. Po raz pierwszy od dłuższego czasu trafia się nowa karta oparta na układzie nVidia, która nie różni się wielkością od kart konkurencji. Leżąc obok serii 6800 wręcz wydaje się maleństwem. Cztery kości BGA GDDR3 Samsung 2.0ns umieszczono na awersie. Łącznie 128MB. Układy pamięci nie mają żadnego dodatkowego chłodzenia, co specjalnie nie dziwi biorąc pod uwagę niski pobór mocy kości tej generacji. Oczywiście szyna pamięci jest 128-bitowa. Średniej wielkości "bocznowydmuchowy" radiator zintegrowano z asymetrycznie położonym wentylatorem. Podłączenie dwupinowe. Mocowanie na dwóch kołkach z tendencją do odklejania się od rdzenia po ściśnięciu palcami. Na rewersie układ Philips SAA7115HL odpowiedzialny za wejście wizyjne. Górna część laminatu tworzy gniazdo SLI umożliwiające spięcie dwóch kart 6600GT przy wykorzystaniu płyt wyposażonych w dwa złącza PCI-E x16. Na śledziu gniazda VGA, DVI oraz VIVO (miniDIN 9-pinów). Karta nie jest wyposażona w dodatkowe gniazdo zasilania, ale należy pamiętać, że w przypadku złączy graficznych PCI Express, może ona czerpać, bezpośrednio z płyty, do 75W mocy. Całość waży 210g. Oczywiście jest to rekord wśród całej testowanej grupy kart GeForce serii 6.

(kliknij, aby powiększyć)

W związku z tym, że na testowej platformie PCI Express wentylator na procesorze skutecznie zagłuszał wszystkie pozostałe wiatraki to trudno o jednoznaczne określenie głośności karty. Zatrzymując go na krótko mogę stwierdzić, że generowany przez kartę hałas należy od średnich i na pewno mieści się w granicach akceptowalnych przez większość użytkowników. Oczywiście trzeba pamiętać, że jest to konstrukcja referencyjna i każdy producent może pokusić się o zastosowanie własnych rozwiązań. Ważne jest to, że według moich wyliczeń, karta pobierała z sieci energetycznej jedynie 25W co jest kolejnym rekordem dla kart nVidia. Tak niski pobór mocy charakteryzował na przykład karty Radeon 9600Pro, które jak pamiętamy, w wersji AGP nie potrzebowały dodatkowego zasilania. Sądzę, że nie powinno być najmniejszego problemu ze stworzeniem pasywnego chłodzenia dla tych kart, a przynajmniej niemal całkowicie bezgłośnego. W czasie intensywnej eksploatacji karta rozgrzała się do temperatury 50 - 55 stopni. Najcieplejszy był stabilizator napięcia.

Taktowanie domyślne wynosiło 500/500MHz (rdzeń/pamięć). Karcie udało się podkręcić zegary do wartości 570/575MHz.

Produkt nie trafił jeszcze do sprzedaży detalicznej. Sugerowana cena na rynek amerykański określona została na poziomie $200. Na naszym rynku pojawiły się pierwsze informacje handlowe, z ceną od ok. 1050 zł. Oczywiście dużo będzie zależało od producenta i dodatków.

Wydajność

Przechodzimy do głównej części artykułu. Zacznę od pomiarów dokonywanych na silnikach konkretnych gier. Kolejność alfabetyczna.

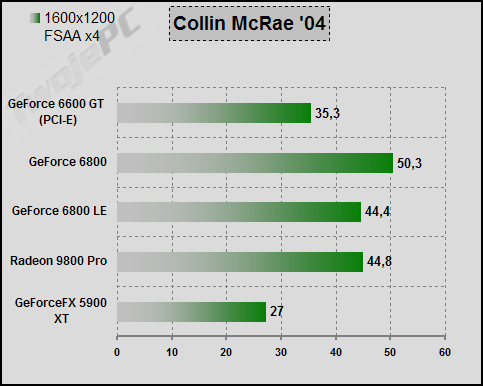

Collin McRae '04 to przykład typowej "samochodówki" D3D. Test polegający na pomiarze, za pomocą Fraps, framerate z pierwszego odcinka toru w Hiszpanii. W związku ze zmiennością warunków testowych wartość minimalną można traktować jedynie orientacyjnie (średnia była stabilna). Ustawienia w grze na najwyższą jakość + FSAA x4. Sterownik pozostał na wartościach domyślnych.

W tym trybie GF6600GT specjalnie nie zabłysł, najsłabiej wypadł GF5900XT, GF6800LE oraz R9800P notowały podobne "osiągi" natomiast konkurencję wygrał GF6800. Pomimo pozornie bezpiecznego minimum fps, na wszystkich kartach grało się w tych ustawieniach dosyć opornie. Nie miałem najmniejszych szans na rekordowe czasy przejazdu, a bez pomocy Fraps mógłbym jedynie stwierdzić, że FX odstawał od reszty stawki.

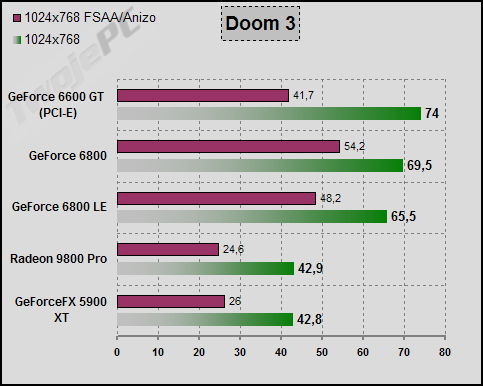

Doom3 to przebój wszystkich nowszych recenzji oraz materiałów reklamowych nVidia. Nowiutka gra OpenGL, jeden z najsłynniejszych produktów 2004, zdecydowanie lepsze zachowanie się kart GeForce (szczególnie tych nowej generacji) niż Radeonów, potężne obciążenie nawet dla najsilniejszych kart na rynku. Ustawienie High, wszystkie efekty włączone, parametry FSAA x4 oraz Anizo x8 ustawiane z poziomu pliku konfiguracyjnego. Warto zwrócić uwagę, że aby wykonać test bez FSAA/Anizo trzeba "ręcznie" wyłączyć filtrowanie anizotropowe, bo ustawienie High włącza je domyślnie. Pomiar wykonany procedurą "timedemo demo1". Wynik odczytywany po drugim przejściu testu.

Jak widać GeForce serii 6 nie miały żadnych problemów ze zdeklasowaniem pozostałych kart. Zbliżony wynik GF5900XT oraz Radeona 9800Pro (na nowych sterownikach ATI 4.10 beta wynik R9800P bez FSAA/Anizo przekracza 50 fps). W trybie bez "ulepszaczy" GF6600GT odnotował zwycięstwo punktowe, ale już z FSAA/Anizo został wyprzedzony przez karty z większą przepustowością szyny pamięci. Dla pokonanych kart starszej generacji, ustawienie 1024x768 bez dodatków jest najwyższym trybem pozwalającym na względną frajdę, natomiast "szóstki" pozwalają na dodanie FSAA/Anizo, co dodatkowo wzbogaca obraz.

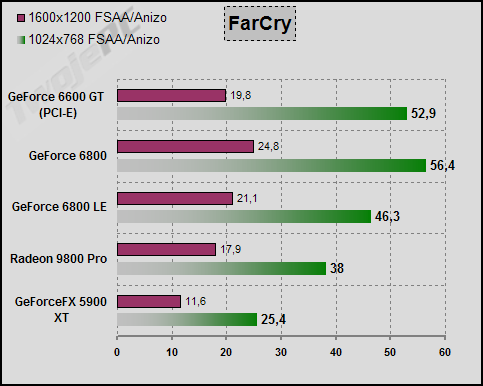

Kolejna znakomitość wydana w tym roku. FarCry jest niewątpliwie jedną z najładniej wyglądających gier D3D, z jakimi miałem do czynienia. Do pomiaru posłużyło nagrane własnoręcznie demo zawierające sporą część układu Research (zejście z góry i wejście do podziemi) oraz procedury testowe udostępniane przez samą grę. Gra w wersji 1.2 SM2.0. Zainteresowanych różnicami przy włączeniu SM3.0/SM2.0b odsyłam do recenzji "Nowa Generacja". FSAA x4 oraz filtrowanie anizotropowe x8 dostępne w konfiguracji gry. Pozostałe parametry ustawione na najwyższą jakość obrazu.

GeForceFX nie wytrzymuje konkurencji przy konieczności obsługi tej samej klasy shaderów co przeciwnicy (gra w wersji 1.2). W 1024x768 najlepiej zachowują się GF6800 oraz GF6600GT. Ten drugi nieco słabnie w wyższym trybie, ale podobnie jak 6800LE wciąż utrzymuje przewagę nad R9800P. Sądzę, że jest to wyraźny sygnał świadczący o dobrej efektywności działania ośmiu potoków nVidia.

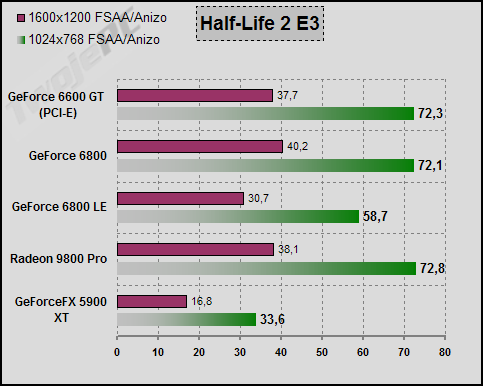

Half-Life 2 to głośna gra D3D, na wydanie której czeka spora rzesza miłośników gier oraz łaknące spektakularnego sukcesu, materiały reklamowe ATI. Wersja silnika pokazana na targach Expo 2003 próbuje przybliżyć zachowanie kart za pomocą własnych procedur timedemo. Do testów wykorzystuję demo "coast" przygotowane przez serwis IXBT. Ustawienia FSAA x4/Anizo x8 wymuszam z poziomu sterownika.

Oprócz FX'a wszystkie karty działają bez zarzutu w 1024x768. W tym trybie R9800P, GF6800 oraz GF6600GT mają niemal identyczne wyniki. Nieco słabiej wypada GF6800LE. Sytuacja w zasadzie powtarza się w 1600x1200 z minimalną przewagą GF6800.

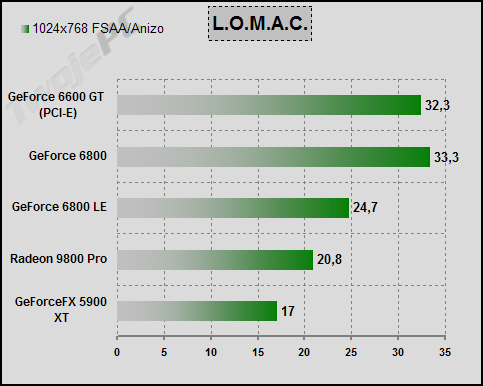

Mocno dający "w kość" kartom symulator lotniczy D3D - LockOn Modern Air Combat. Ustawienia predefiniowane High. FSAA x4 / Anizo x8 wymuszane z poziomu sterownika. Pomiar za pomocą Fraps w trakcie odtwarzanie Demo-F15-low pomiędzy przelotem pod pierwszym mostem, a rozbiciem samolotu.

Zdecydowanie na czele GF6800 oraz GF6600GT. Potem GF6800LE przez R9800P. FX zamyka stawkę. Pomimo stosunkowo niskiego trybu żadna z kart nie zapewnia odpowiedniego wsparcia. W tej grze FSAA jest na tyle istotnym elementem tworzenia jakości obrazu, że lepiej zapewnić wyższy framerate przez obniżenie ilości detali.

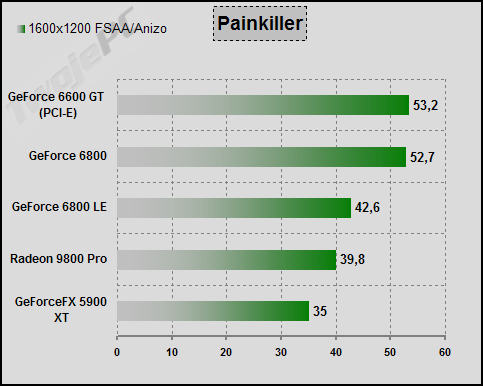

Painkiller to stosunkowo łatwa do pokonania, przez testowane karty, gra D3D rodzimej produkcji. Ustawienia FSAA x4/ Anizo z poziomu gry. Pomiar "flyby" benchmarkiem zawartym w poprawce do wersji 1.15. Demo testowe "c5l1".

W zasadzie powtórka kolejności wyników z poprzedniego testu tylko wyższy jest zarówno framerate, jak i tryb testowy. Warto pamiętać, że test typu "flyby" nie oddaje zachowania gry, gdzie często pojawiają się hordy jednocześnie atakujących wrogów. W związku z tym, że zawsze miałem wrażenie, że w tym teście przede wszystkim liczy się "goły" Fill-Rate, to fakt osiągnięcia przez R9800Pro wyników słabszych niż GF6800LE najprawdopodobniej świadczy o stosunkowo słabej optymalizacji ATI w tej grze.

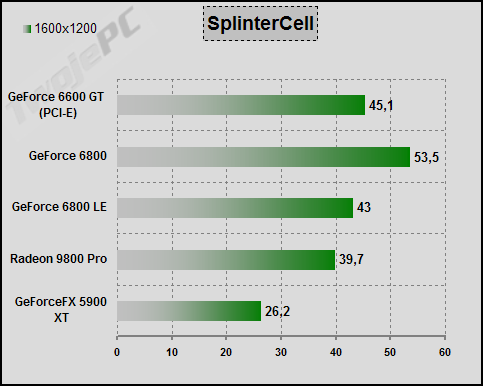

Splinter Cell to jedna z ciekawszych mutacji silnika firmy Epic. Niektóre z zastosowanych efektów oparte są na technikach próbkowania co uniemożliwia sensowne stosowanie FSAA/Anizo. Benchmark zawarty w poprawce do wersji 1.2. Demo testowe "1_1_1Tbilisi".

Bezsprzeczne zwycięstwo GF6800 i równie bezsprzeczna porażka FX5900XT. Jako, że gra w dużym stopniu wykorzystuje przepustowość pamięci, wysoki wynik GF6600GT jest pewną niespodzianką.

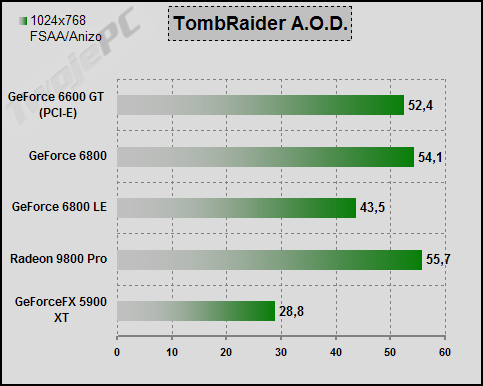

Tomb Raider Angel of Darkness to gra, która jako pierwsza wykorzystała wiele dotychczas nie stosowanych efektów D3D Dx9, choć jak dla mnie sam obraz specjalnie na nich nie skorzystał. Ustawienia wysokiej jakości obrazu zaczerpnięte z artykułu serwisu Beyond3D. FSAA x4/Anizo należą do parametrów gry. Zarówno sam benchmark, jak i demo testowe "paris", zawarte są w dodatku do gry o numerze .49 (w nowszych już ich nie ma).

Czołowe lokaty zajmują w kolejności R9800P, GF6800 oraz GF6600GT. Nieco słabiej GF6800LE natomiast FX5900XT zdecydowanie z tyłu stawki.

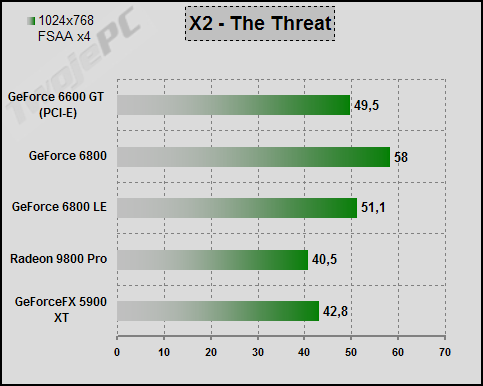

Dedykowany benchmark wykorzystujący kosmiczną symulację X2 - The Threat wspiera VS2.0 oraz technologię UltraShadow GeForce'ów. W stosunku do ustawień domyślnych włączyłem cienie oraz wymusiłem w sterowniku FSAA x4.

GF6800 nie miał problemów z osiągnięciem pierwszej lokaty. Na drugim miejscu GF6800LE zaraz przed GF6600GT. Na końcu karty FX5900XT oraz R9800P.

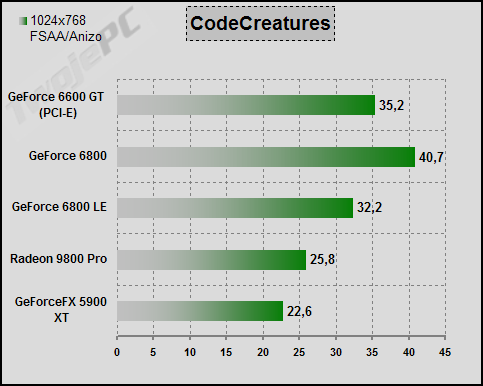

Oprócz testów na silnikach realnych gier przeprowadziłem kilka dodatkowych porównań. "Przyrodniczy" benchmark CodeCreatures od dawna wykorzystywany jest do sprawdzania wydajności kart i wciąż dobrze oddaje ich możliwości. Jednak w związku z tym, że jest to tylko program testowy, to warto pamiętać o fakcie podstawiania przez sterownik nVidia własnego shadera w celu dodatkowej optymalizacji dla własnych kart.

W zasadzie nie ma się nad czym rozwodzić.

Aby mieć lepszy obraz możliwości kart w zakresie przetwarzania shaderów 2.0 wykonałem dodatkowe testy za pomocą syntetycznego benchmarka 3DRightMark. W poniższej tabelce wyniki przykładowych testów. Starałem się wybrać takie, które najbardziej obciążają układ graficzny.

W przypadku kart GeForce, w teście PS2.0 podałem wyniki zarówno pełnej precyzji jak i 16-bitowej. Warto je brać pod uwagę ze względu na to, że możliwość obniżenia precyzji obliczeń jest często wykorzystywana przez sterownik nVidia, a jak już wcześniej pokazywałem, nie ma to większego wpływu na jakość obrazu. W zasadzie najważniejsze wnioski można wyciągnąć przez porównanie FX5900XT z nowymi kartami. W przypadku Pixel Shadera różnica jest miażdżąca.

W związku z tym, że miałem kartę GF6600 jedynie w wersji GT, to za pomocą obniżenia taktowania zasymulowałem zachowanie tańszych wersji. Przyjąłem częstotliwość taktowania pamięci na poziomie 250MHz. Z aktualnych informacji wynika, że będzie to prawdopodobnie najczęściej 275MHz więc można się liczyć z tym, że wyniki trochę wzrosną.

Sądzę, że nawet przyjmując, że są one zaniżone to prawdopodobnie GF6600 będzie dużo słabszy od GF6600GT. Z resztą wynika to wprost z teoretycznego porównania fillrate i przepustowości pamięci. W związku z tym, że jest to ten sam rdzeń to prawdopodobnie można będzie liczyć na jego znaczące możliwości w zakresie podkręcania.

Na koniec chciałbym się podzielić wynikami syntetycznych testów Fill-Rate.

Muszę przyznać, że wartość "single" dla GF6600GT jest zaskakująco niska. Układ swoim zachowaniem bardziej przypomina architekturę 4x2 niż 8x1.

Wpływ ilości pamięci lokalnej

Recenzja opisuje karty, których wspólną cechą jest posiadanie 128MB pamięci lokalnej. Dzięki temu wpływ jej ilości nie ma znaczenia w ich wzajemnym porównaniu. Ciekawe natomiast wydaje się pytanie, jak dużo tracimy nie decydując się na droższe karty 256MB. W poprzednim takim teście w zasadzie specjalnych różnic nie było. Jednak należy pamiętać, że zmienia się klasa gier wykorzystywanych do recenzji i postanowiłem zrobić dodatkowe porównanie.

Aby prawidłowo ocenić wpływ pamięci lokalnej "stworzyłem" nieistniejącą kartę GF6800 256MB. W tym celu, za pomocą programu RivaTuner, wyłączyłem w karcie GF6800GT (Gainward wypożyczony przez firmę MMV, opis już wkrótce) jeden Quad (4 potoki) oraz jeden Vertex Shader i obniżyłem taktowanie do poziomu GF6800 (325/350MHz).

(kliknij, aby powiększyć)

Wyniki porównania zawiera powyższa tabelka. Specjalną uwagę czytelnika chciałbym zwrócić na zaznaczone innym kolorem testy. W tych przypadkach wpływ większej pamięci lokalnej jest na tyle duży, że można go łatwo odczuć w grze. W pozostałych przypadkach specjalnie nie przeszkadzał albo wręcz nie istniał.

Wpływ pamięci w HL2 był w zasadzie stały w obu testowanych trybach i nie miał znaczenia w czasie gry. Wyniki Doom3 również nie wskazują na znaczenie jej ilości, ale w czasie gry można ją jednak "wyczuć", w postaci nieco krótszych czasów ładowania kolejnych poziomów tekstur. Pewnym obrazem tego zjawiska są wyniki zbierane po pierwszym przejściu demka testowego. W tabeli opisałem je jako [1pass]. W FarCry wpływ jest duży i łatwy do zaobserwowania, ale dopiero w trybie 1600x1200 z FSAA/Anizo. Nie ma to jednak znaczenia praktycznego, bo karta GF6800 jest za słaba do gry, w tej rozdzielczości. W SplinterCell różnic w ogóle nie odnotowałem natomiast w Tomb Raider AOD, w 1024x768 FSAA/Anizo, były niewielkie i nie zmieniały jakości obsługi samej gry. Przypominam, że najwyższe tryby w tej grze w ogóle nie dały się uruchomić na kartach 128MB. Duża różnica występowała natomiast w L.O.M.A.C., ale też dopiero w 1600x1200 FSAA/Anizo (+ustawienie High). Tym nie mniej, podobnie jak w przypadku FarCry, framerate był za niski, aby umożliwić sensowną grę. W CMR4 różnica w 1600x1200 FSAA jest istotna i dobrze odczuwalna. Jednak zdecydowanie najmocniej wśród gier testowych zareagował na 256MB pamięci lokalnej Painkiller. W obu trybach różnica była duża i odczuwalna w czasie gry (test flyby nie oddaje realnego framerate).

Aktualnie mamy do czynienie z sytuacją, że najmocniejsze karty wyposażone są jednocześnie w 256MB pamięci. Pojawiają się gry, które są w stanie to wykorzystać, natomiast głównie sprawa dotyczy najwyższych trybów i w związku z tym, że są to również bardzo wydajne układy, to wydaje się, że ma to sens dla użytkownika. W przypadku nieco słabszego sprzętu, zbliżonego do tego, który stanowi treść niniejszego artykułu, 128MB nie wydaje się złym rozwiązaniem, bo w niższych trybach, dla których zostały one przeznaczone, wymóg 256MB praktycznie nie istnieje. W niższej półce cenowej sytuacja jest jeszcze prostsza. Moc kart nie umożliwia uzyskanie dużych rozdzielczości, a ograniczenia budżetu nabywcy powinny zdecydowanie kierować go w stronę rozwiązań 128MB. Tym bardziej, że w tych przedziałach cenowych, za tą samą kwotę, mamy albo 256MB słabszej pamięci lokalnej, albo 128MB mocniejszej lub ewentualnie wersja z mniejszą ilością pamięci jest tańsza. To drugie rozwiązanie powinno być zdecydowanie preferowane.

Podkręcanie

Oczywiście nie może zabraknąć testów wyznaczających maksymalne możliwości nadtaktowania badanych kart. Do pomiarów wpływu częstotliwości pracy rdzenia i pamięci na framerate wykorzystałem testy Tomb Raider AOD 1280x1024 oraz Splinter Cell 1600x1200. Oba bez FSAA/Anizo. Pierwszy lepiej reaguje na taktowanie rdzenia, a drugi na przepustowość pamięci. Wynik końcowy jest średnią wzrostu wyników tych dwóch testów.

W przypadku nVidia GF6600GT, możliwości w zakresie nadtaktowania są słabe, co wprost wynika z faktu, że są to najmocniejsze karty serii 6600 i sam producent sięgnął kresu ich możliwości. Nie widzę specjalnego sensu stosowania o/c. Może jedynie w celu poprawienia sobie humoru wynikami testów. W grze praktycznie nie ma wpływu, który moglibyśmy odczuć. Do tego jest to produkt referencyjny, który najczęściej ma większe możliwości w tym zakresie, niż wersje sklepowe. Lepiej natomiast zachowują się przy o/c karty Gainward, a szczególnie GF6800LE. 15-18% może już w konkretnych sytuacjach wpłynąć na zachowanie gier tak, że będziemy mieli korzyści choć jak dla mnie będą to pojedyncze przypadki.

W temacie nadtaktowania warto zwrócić również uwagę na wciąż otwartą możliwość odblokowania potoków pikseli słabszych kart GeForce serii 6800. Na razie nie ma dostępnego narzędzia umożliwiającego wykonanie testu sprawności Quadów zablokowanych na poziomie rdzenia (możemy jedynie ominąć blokadę producenta karty), ale wszystko wskazuje na to, że za sprawą nowej wersji tweakera RivaTuner, niedługo się taka możliwość pojawi. Sprawa będzie dotyczyła tylko części układów, a ich procent na razie pozostaje tajemnicą. Możliwość odblokowania oczywiście nie dotyczy serii 6600 opartych na nowym, okrojonym rdzeniu.

Uczta numerologa

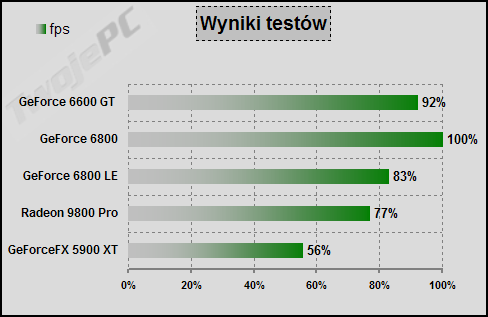

Aby możliwe było bardziej jednoznaczne określenie różnic pomiędzy kartami wprowadziłem dodatkowe wyliczenie pojedynczej liczby, stanowiącej o możliwościach danej karty, w osiąganiu konkretnych wyników w testach. Jest to przeliczenie różnic wyników na skalę punktową 0-10 (najlepszy wynik dostaje 10 punktów, a reszta proporcjonalnie), wyciągnięcie średniej i porównanie jej w skali procentowej. Przypominam, że jest to konkurs wyników, a nie wydajności.

Sam muszę przyznać, ze wynik tej "uczty" jest interesujący. Na punkty wygrał oczywiście GF6800, co chyba nikogo specjalnie nie dziwi. Mnie najbardziej interesował pojedynek GF6600GT z GF6800LE. Okazało się, że wygrał go GF6600GT. Ważne jest również to, że jego wyniki mocno nie odbiegają od lidera klasyfikacji. GF6800LE wylądował przed R9800Pro, a na końcu uplasował się FX5900XT. Warto zwrócić uwagę, że im nowsze testy, tym jego strata do Radeona jest większa.

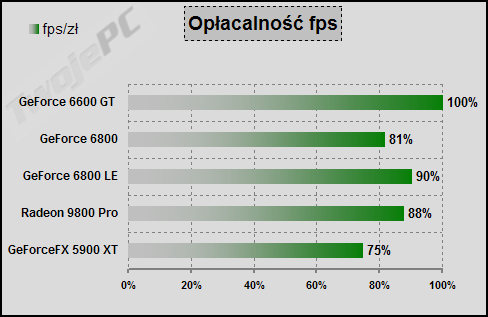

W związku z tym, że karty różnią się ceną to można spróbować odnieść wyniki testów do kosztów ich zakupu. Szperając po sklepach internetowych starałem się znaleźć najniższe ceny testowanych modeli kart (niezależnie od producenta).

Przy założeniu podanych cen, największą opłacalnością zabłysł GF6600GT. Należy jednak pamiętać, że wymaga platformy PCI-E, która jest aktualnie nieco droższa, niż system AGP. Dopiero za nimi "wylądował" GF6800LE przed R9800Pro, który jeszcze niedawno prowadził w tej konkurencji. Wygląda na to, że podobnie jak i GF6800 powinien zostać trochę przeceniony, aby mógł sprostać nowym wyzwaniom rynku. Wciąż najmniejsza jest opłacalność FX5900XT, który pomimo tego, że jest najtańszą karta w tym zestawie testowym, to nadal wydaje się za drogi.

Podsumowanie

Mam nadzieję, że po tym artykule nikt już nie ma wątpliwości na temat różnic pomiędzy starą a nową generacją nVidia. Jak napisałem we wcześniejszych recenzjach, kwestia shaderów w modelu 3.0 jest dla mnie sprawą drugorzędną i związaną głównie z działaniem marketingowym. Tak samo jak koncentrowanie uwagi potencjalnego klienta na różnicy w obsłudze jednej gry (Doom3/HL2). Przede wszystkim po prostu nVidia "wyszła" w końcu z mało wydajnej architektury 4x2, która charakteryzowała serię FX oraz nastąpiła zdecydowana poprawa efektywności działania pojedynczego potoku pikseli. Dzięki testom nowych, ośmiopotokowych kart GeForce znikły również wątpliwości porównawcze w stosunku do starszej generacji ATI. Wszystko wskazuje na to, że przynajmniej w najbliższym półroczu nVidia nie powinna mieć problemów z odzyskaniem części straconego na rzecz konkurencji rynku w segmencie wydajniejszych kart. Tym bardziej, że ATI ustąpiła pola przeciwnikowi decyzją o przesunięciu wprowadzenia nowych technologii 3D na przyszły rok, a w segmencie kart AGP wykazuje daleko idącą powściągliwość marketingową.

Nie będę ukrywał, że GeForce 6600GT bardzo mi się spodobał. Dzięki zastosowaniu niskonapięciowych pamięci GDDR3 oraz przejściu na technologię 0.11um udało się stworzyć kartę o znakomitych walorach funkcjonalnych, przy zachowaniu wydajności konkurencyjnej do najmocniejszych kart poprzedniej generacji. Dawno w tym segmencie nie było niewielkiej, 25W karty, opartej na układzie nVidia. Nie widzę żadnych problemów, aby zastosować pasywne chłodzenie wykorzystujące technologię heat-pipe, a i referencyjny cooler nie niszczy słuchu. Zastosowanie 128-bitowej magistrali nie powinno być postrzegane jako błąd, czy krok w tył. Bardzo wysokie taktowanie (niektórzy producenci chcą je dodatkowo zwiększyć) w dużym stopniu rekompensuje niedostatki przepustowości, a trzeba również pamiętać, że i efektywność wykorzystania węższej szyny jest zawsze większa. Dodatkowo, dzięki temu można było zastosować tańsze rozwiązania w konstrukcji samego laminatu. Optymalne jest również ograniczenie ilości pamięci lokalnej do 128MB, bo w tym zakresie wydajności układu i przy aktualnym jej wykorzystaniu przez gry, zastosowanie 256MB drogich kości GDDR3 zniszczyłoby efekt cenowy. Kwestia SLI (możliwość łączenia dwóch kart na płycie z dwoma gniazdami PCI-E), w przypadku tańszych kart, ma dla mnie znaczenie jedynie marketingowe. Rozumiem, że zasobny w środki finansowe hobbysta od razu kupuje odpowiednią płytę, mocniejszy zasilacz i dwie drogie, 16-potokowe karty, aby za 250% ceny uzyskać 150% topowej wydajności. Natomiast lansowanie SLI, jako możliwości przyszłego upgrade jest, delikatnie mówiąc, pomysłem mocno naciąganym (za rok wejdzie kolejna generacja kart), a w przypadku 2x GF6600GT dodatkowo zupełnie nieefektywnym (system z jedną mocniejszą kartą będzie tańszy, wydajniejszy i o większych walorach funkcjonalnych).

GeForce 6600GT ma jedną, rzekłbym funkcjonalną wadę. Jest kartą natywnie przystosowana do obsługi PCI Express x16. Wprawdzie nVidia informuje o możliwości zastosowania układu mostkowego do translacji sygnałów i sugeruje wprowadzenie takiego mutanta na rynek, ale w związku z tym, że producenci nie mają jeszcze nawet projektu referencyjnego nie można mieć pewności, kiedy takie rozwiązanie może trafić do sprzedaży. Kwestia ceny czy wydajności ma tutaj drugorzędne znaczenie. Przede wszystkim jednak, na podstawie tego artykułu, mogę pokusić się o stwierdzenie, że w zasadzie nVidia nie jest zmuszona do pośpiechu we wprowadzeniu serii GF6600 w wersji AGP. Po pierwsze, w tym przedziale cenowym, ma juz kartę o niewiele mniejszej wydajności 3D. Chodzi o GeForce 6800LE. W związku z tym, że ma on zupełnie inny stosunek fillrate do przepustowości pamięci to oczywiście zachowuje się nieco inaczej niż 6600GT, ale jak testy dowiodły, po uśrednieniu wyników, różnica nie jest duża. Jest to duża karta o znacznie większym poborze mocy, ale to w zasadzie jedyny mankament. Tandem układu mostkowego z NV43 również wprowadzi dodatkowe obciążenie i niewątpliwie skomplikuje konstrukcję laminatu, a poza tym jego szybkie wprowadzenie nie jest również na rękę i nVidia, która ostatnio stara się poprawić jakość swoich kontaktów z producentami OEM, których zainteresowanie skupia się wokół PCI-E i możliwości jego promowania.

To wszystko brzmi bardzo zachęcająco, ale podstawowym ograniczeniem ekspansji nowych kart GeForce w naturalny sposób powinny stać się prewencyjne działania konkurencji. Co na to wszystko ATI? W przedziale PCI Express mamy sporą dawkę bardzo konkretnych ruchów rynkowych. Niedawno zaprezentowana seria Radeon X700 wydaje się właściwą i raczej skuteczną odpowiedzią na linię 6600 i jeśli tylko pojawi się taka możliwość, to postaram się napisać dedykowane porównanie tych dwóch produktów. Jednak w związku z tym, że nowy standard złącza dopiero zaczyna walkę o rynek, to wciąż jeszcze zainteresowanie potencjalnych klientów kieruje się głównie w stronę AGP. Szczególnie, że w wyniku pojawienia się nowej generacji gier, znaczna część użytkowników przede wszystkim koncentruje się na kwestii wymiany samej karty, z zachowaniem istniejącej platformy wraz ze starszym standardem złącza graficznego. Tu jednak mamy aktualnie do czynienia z czymś, co można nazwać jesiennym snem kanadyjskiego niedźwiedzia. Pomimo nieśmiałych zapowiedzi ośmiopotokowego X800SE wciąż nie ma na rynku żadnej karty Radeon, wypełniającej lukę pomiędzy najmocniejszymi kartami, a starszą generacją, w którą jak nóż w masło wchodzą 12-potokowe karty GF6800. X800Pro pomimo znakomitych walorów użytkowych (45W, niemal bezgłośne chłodzenie) przegrywa rynkową konkurencję z GF6800GT, a pojawienie się GF6800LE w cenie <1100 zł bezpośrednio zagraża przebojowi ostatnich miesięcy, czyli karcie Radeon 9800 Pro. Jest to tym ważniejsze, że ATI wcale nie planuje wycofania tego produktu, a serwisy donoszą o dużych zamówieniach na układy zasilające te karty. Tak jak w chwili obecnej doskonale sprzedają się tańsze karty Radeon ze wsparciem Dx9, tak z całej serii droższych kart jedynie szesnastopotokowy X800XT wydaje się być stosunkowo dobrze osadzony na rynku.

Co powinno wydarzyć się w rodzinie Radeonów po "obudzeniu" się ATI? Po pierwsze niezbędna jest obniżka cen kart Radeon 9800Pro. Pomimo, że karta jest już na rynku bardzo długo to nic nie wskazuje, że traci swoje zdolności w zakresie przetwarzania aktualnych gier. Wprawdzie w Doom3 notuje ponad 33% spadek framerate (20% na nowym sterowniku) w stosunku do ośmiopotokowych konkurentów GeForce serii 6, ale w pozostałych grach radzi sobie dobrze, a czasem wręcz nawet lepiej. Bilans średni nie pozostawia jednak wątpliwości. Karta uzyskuje wyniki niższe od konkurencji w stopniu większym, niż znikoma różnica w cenie. Jeśli nie zostanie ona obniżona to spora cześć potencjalnych klientów sięgnie po karty nVidia. Do tego powinno dojść wprowadzenie kart X800LE i obniżka ceny X800Pro, aby wypełnić dużą lukę w ofercie. W chwili obecnej sytuacja Radeonów w tym segmencie nie wygląda dobrze, natomiast działania nVidia wydają się bardzo dobrze przemyślane.

Natomiast mój stosunek do serii GeForce FX jest niezmiennie negatywny. Nie jest to specjalnie udany produkt nVidia i wraz z pojawieniem się gier, które w większym stopniu wykorzystują efekty Dx9 jego skuteczność maleje. Im nowsze testy i ustawienia wyższej jakości obrazu tym GeForceFX 5900XT, choć jest jednym z najlepszych przedstawicieli gatunku FX, wyraźnie słabiej daje sobie z nimi radę. Na razie, dzięki kolejnym obniżkom i utrzymywaniu się stosunkowo wysokich cen R9800Pro wzbudza jeszcze zainteresowanie części mniej zasobnej w gotówkę grupy sympatyków rozwiązań nVidia, ale obawiam się, że nie jest to trend długotrwały.

Na koniec kilka podsumowujących słów należy się testowanym kartom. W związku z tym, że laurki przyznaję jedynie konkretnym kartom znajdującym się w sprzedaży detalicznej, to tym razem rzecz dotyczy dwóch produktów firmy Gainward. Obie karty zaprezentowały się znakomicie. Oprócz wydajności cechował je również wysoki poziom zarówno w kwestii jakości obrazu, jak i wykonania. Szczególnie atrakcyjna wydaje mi się oferta GF6800LE. Wprawdzie wobec pojawienia się na rynku tańszych wersji kart na tym układzie obawiam się, że niezbędna będzie kolejna obniżka ceny Gainwarda, ale i tak uważam, że produkt zasługuje na specjalne wyróżnienie.

Nie mam również najmniejszych wątpliwości co do sukcesu GF6600GT na rynku PCI-E. Nie będę ukrywał, że dawno żadna karta GeForce nie zrobiła na mnie tak dobrego wrażenia. Pozostaje tylko nadzieja, że producenci szybko przedstawią atrakcyjną ofertę na ten produkt, zarówno pod względem wyposażenia, jak i walorów funkcjonalnych. W poprzednim artykule opisującym zagadnienia związane z wprowadzeniem platformy PCI Express zwracałem uwagę na niedostatki związane z kwestią kart graficznych w tym standardzie. Z przyjemnością informuje, że dzięki GF6600GT zdecydowanie zyskuje ona na atrakcyjności.

Gainward PowerPack! Ultra/2100 TV-DVI Golden Sample

Gainward PowerPack! Ultra/2100 TV-DVI Golden Sample

+ Znakomita wydajność w swojej klasie

+ Świetna jakość obrazu

+ Stosunkowo dobre możliwości w zakresie o/c

+ Zapewniane przez producenta wyższe taktowanie

+ Regulacja obrotów wentylatora z poziomu oprogramowania

+ Doskonałe warunki gwarancji i serwisu

- Znacząco wyższa cena, w porównaniu do konkurencji

|

Gainward PowerPack! Ultra/2100LE TV-DVI OEM

Gainward PowerPack! Ultra/2100LE TV-DVI OEM

+ Bardzo dobra wydajność

+ Stosunkowo niski hałas

+ Spore możliwości w zakresie o/c

+ Regulacja obrotów wentylatora z poziomu oprogramowania

+ Doskonałe warunki gwarancji i serwisu

- Ograniczenia w zakresie dołączonego oprogramowania

|

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | Multimedia Vision |

|  | GIGABYTE Polska |

|  | NVIDIA |

|