Conroe - niebieska kontra, czyli test procesora Intel Core 2 Duo

Autor: Lancer | Data: 11/09/06

|

Core 2 Duo to największe objawienie pośród elementów platformy PC w tym roku. Gorąca atmosfera panująca przed długo oczekiwaną premierą, która miała miejsce w lipcu, była umiejętnie podsycana pojawiającymi się co jakiś czas informacjami o ogromnym przyroście mocy jaki miał oferować nowy procesor w porównaniu do konkurentów. Odchodząc od lansowanej przez ostatnie kilka lat mody na gigaherce, Core 2 Duo charakteryzuje się wysoką wydajnością przy niskim zegarze, umiarkowanym zapotrzebowaniem energetycznym i doskonałymi możliwości przyspieszania. Procesor jednak nie wziął się z nikąd. Powstał na bazie doskonale znanych układów, które podlegały systematycznym doskonaleniom wiele lat. I właśnie poznanie historii rdzenia Conroe jest kluczem do zrozumienia przyczyn jego sukcesu. Core 2 Duo to największe objawienie pośród elementów platformy PC w tym roku. Gorąca atmosfera panująca przed długo oczekiwaną premierą, która miała miejsce w lipcu, była umiejętnie podsycana pojawiającymi się co jakiś czas informacjami o ogromnym przyroście mocy jaki miał oferować nowy procesor w porównaniu do konkurentów. Odchodząc od lansowanej przez ostatnie kilka lat mody na gigaherce, Core 2 Duo charakteryzuje się wysoką wydajnością przy niskim zegarze, umiarkowanym zapotrzebowaniem energetycznym i doskonałymi możliwości przyspieszania. Procesor jednak nie wziął się z nikąd. Powstał na bazie doskonale znanych układów, które podlegały systematycznym doskonaleniom wiele lat. I właśnie poznanie historii rdzenia Conroe jest kluczem do zrozumienia przyczyn jego sukcesu.

Emocje związane z premierą mamy już dawno za sobą. Możemy więc ze spokojem podejść do tegorocznego hitu Intela i kompleksowo przeanalizować czynniki, które wpłynęły na kształt procesora i dowiedzieć się w jakich zastosowaniach jest dobry, a gdzie podwija mu się noga. | |

|

Wstęp...

Czwarty kwartał roku 2000 miał w zamierzeniu Intela stanowić początek ostatecznej rozgrywki. Na rynek wszedł najnowszy układ mikroprocesorowego giganta, procesor Pentium 4 zbudowany według śmiałego projektu, który miał stanowić zarazem kulminację i schyłek w rozwoju architektury IA-32. Procesor miał dać początek nowej rodzinie, która rozpoczęła karierę od układu taktowanego zegarem 1,5GHz, a dobrnąć według Intela miała aż w okolice kosmicznych 10GHz. Intel swą megahercową rewolucją chciał zgnieść wyrastającego pod bokiem rywala, który wraz z procesorami K7 coraz śmielej sobie poczynał...

Minęło 6 lat, IA-32 jak było, tak trwa nadal. NetBurst wyczerpał się już przy niecałych 4GHz, a konkurent nie dość, że nie dał się rozdeptać to jeszcze zdążył dorosnąć i prztyczkiem w nos, dzięki architekturze K8 odebrał Intelowi kawał rynku. Już niektórzy wróżyli upadek Chipzilli, ale ta pokazała że nie podda się łatwo.

Tak oto nastał rok 2006 - rok paradoksu. Intel w obliczu niepowodzenia swojej rewolucji milenijnej sięgnął po historyczny oręż, który gdzieś tam pałętał się u boku od wielu lat i choć był pucowany od czasu do czasu by rdza go nie pochłonęła, to jednak w głównych pojedynkach pozostawał na drugim planie. Jako że dotychczasowe metody walki z gibkim AMD przy użyciu NetBursta okazały się mało skuteczne, Intel porzucił dotychczasową strategię. Sięgnął do pasa, dobył traktowaną po macoszemu broń, wypolerował na błysk i uderzył. Cios okazała się nadspodziewanie mocny.

Tak oto po sześciu latach w zapomnienie odeszło dziecko nieudanej rewolucji zwane Pentium 4, a triumfy święci prastara architektura, która po pewnych przebudowach okazała się nadspodziewanie dobra i ponadczasowa paradoksalnie bijąc na głowę swego następcę! Przewyższyła także produkty spod znaku młota - rodzinę K8, która walnie przyczyniła się do załamania niebieskiej ofensywy z 2000 r.

Nadeszła nowa era. Era procesorów Core 2 Duo zwanych Conroe.

Historia ważna rzecz

Nie jest tajemnicą, że rdzeń Conroe, który zadebiutował niemal dwa miesiące temu nie powstał na skutek nagłego przebłysku geniuszu inżynierów Intela. Procesory nie powstają bowiem z dnia na dzień. Rodzą się latami, kosztem wielkiego nakładu włożonego pracy włożonego przez całe zastępy grup inżynierskich. Powstanie architektury Core, do której należy właśnie Conroe to jednak nadzwyczajna historia, która była pisana wiele lat. Zalążki dzisiejszego układu sięgają bowiem aż 10-ciu lat wstecz.

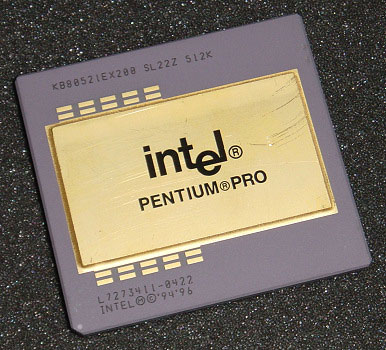

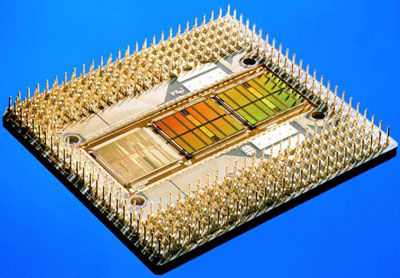

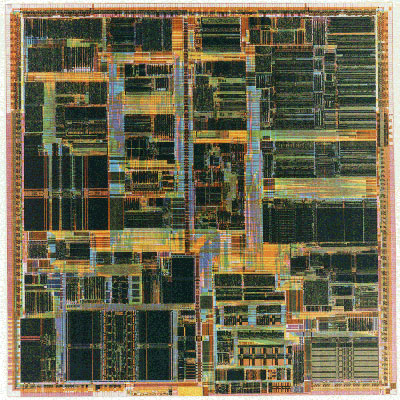

W listopadzie 1995 r. na półki sklepowe trafił rewelacyjny projekt, który mimo iż początkowo sukcesu nie odniósł, dał podstawę do stworzenia licznej rodziny procesorów. Mowa o rdzeniu P6, który na rynku zaistniał jako Pentium Pro. Cechą, dzięki której zostanie on zapamiętany po wsze czasy jest coś, co dziś niczym nie dziwi – pamięć podręczna cache L2 pracowała z pełną prędkością rdzenia i znajdowała się w jego pobliżu, umieszczona na jednaj podstawce. Dotychczas procesor musiał komunikować się cache przez szynę systemową. Pentium Pro mógł mieć 256, 512 lub aż 1024KB owej bliskiej i bardzo szybkiej pamięci. Ale to nie wszystko. Czteropotokowa architektura Pentium Pro mogła przetwarzać trzy instrukcje x86 w jednym cyklu zegara, miała możliwość nie kolejnego wykonywania instrukcji (Out of Order Execution), tj. przetwarzania instrukcji bez trzymania się kolejności przewidzianej przez wykonywany program. Przetworzone zawczasu wyniki gromadzono w rejestrach do chwili gdy są potrzebne. Kolejną ważną nowością była funkcja Speculative Execution, czyli zdolność przetwarzania kolejnego polecenia w czasie oczekiwania na wynik niezrealizowanej instrukcji skoku. Milowym krokiem było umożliwienie przekolejkowania operacji typu Load (odczytu) z pamięci operacyjnej, pozwalając tym samym uporządkować i przyspieszyć proces odczytu priorytetowych z punktu widzenia wykonywanej właśnie operacji danych. Dodatkowo rozbudowie w stosunku do poprzednika piątej generacji uległa jednostka przewidywania rozgałęzień.

Schemat blokowy P6

struktura P6 pod mikroskopem

Pentium Pro mimo początkowych przewidywań Intela, z uwagi na wysokie koszty platformy z nową podstawką Socket 8 dla 60 lub 66MHz systemowej szyny GTL+ i z raczej mierną wydajnością w królującym wówczas 16-bitowym środowisku nie zyskał popularności.. Jak się okazało bowiem, Pentium Pro bardzo wolno wykonuje operacje zapisu w rejestrach segmentowych, a konieczność częstej aktualizacji zawartości rejestrów segmentowych występuje nad wyraz często w 16-bitowych programach.

Tym samym P6 nie trafił pod strzechy i znalazł zastosowanie niemal tylko w serwerach. Sam procesor był drogi i kosztowny w produkcji. O ile 350nm rdzeń P54C procesorów Pentium zajmował powierzchnię 83mm^2, to P6 miał prawie 200mm^2 i to bez pamięci podręcznej cacheL2 ! Wytwarzany był w dwóch procesach technologicznych - 500nm i 350nm.

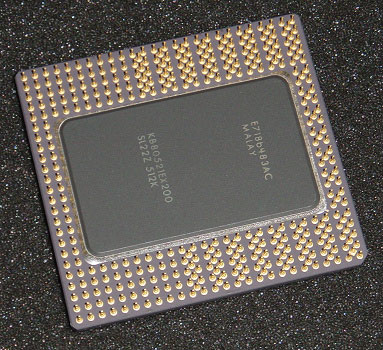

Charakterystyczne, podłużne gniazdo Socket 8

Pentium Pro z góry...

... i z dołu

200MHz Pentium Pro bez obudowy z 1MB cache L2 w postaci dobrze widocznych dwóch 512KB modułów.

Kolejnymi krokami ewolucji naszego jądra P6 była rodzina procesorów Pentium II i Pentium !!! opartych o lekko zmodyfikowany rdzeń Pentium Pro.

W stronę sukcesu

Ponieważ rozwijane równolegle z P6 jądro P5 wyczerpało możliwości dalszej ewolucji, Intel kolejne swe projekty oparł właśnie o rdzeń P6, który ciągle miał wielkie możliwości rozwoju.

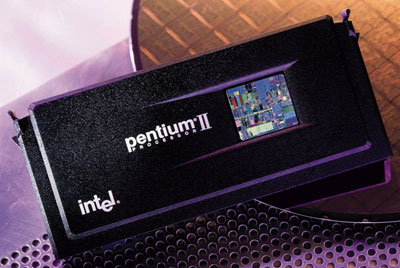

Pentium II oparty na architekturze Pentium Pro i używał zewnętrznego cache L2, Nie był on zintegrowany jak poprzednio, ale umieszczony na zewnątrz rdzenia, choć wciąż na wspólnej z rdzeniem płytce drukowanej łączonej z płytą główną złączem krawędziowym Slot 1. Do tego moduły pamięci pracowały już tylko z połową prędkości rdzenia i miały pojemność 512KB. Pozwalało to uzyskiwać procesory niższym kosztem, jednocześnie zachowując stosunkowo wysoką prędkość komunikacji jądra z pamięcią podręczną. Układ nie musiał bowiem do tego celu używać szyny FSB jak miało to miejsce w procesorach Pentium (także Pentium MMX), korzystających z pamięci umieszczonej na płycie głównej, a używał do tego dedykowanej szyny BSB służącej tylko do komunikacji z cache drugiego poziomu. Podwojono wielkość pamięci cache L1, na którą składały się dwa 16KB bloki (jeden na dane i jeden na instrukcje) zmniejszając tym samym częstość odwołań do wolniejszej niż w Pentium Pro cache L2. Uczyniono też kroki mające wyeliminować podstawową wadę Pentium Pro - poprawić zdolność przetwarzania 16-bitowego kodu przez dodanie pamięci podręcznej rejestrów segmentowych. Pentium II odziedziczył też co nieco z rdzenia P55C - 57 instrukcji SIMD MMX. To tyle nowości.

Struktura krzemowa rdzenia Klamath

Wielkich zmian w czasie swojej trzyletniej produkcji procesor nie zaznał. Zmieniono tylko proces technologiczny z początkowego 350nm na 250nm. Przyspieszeniu uległa także szyna GTL+ odziedziczona po Pentium Pro z 66 do 100MHz.

Pentium II w obudowie SEC

Pentium II z rdzeniem Klamath bez obudowy. Widoczne 4 moduły pamięci podręcznej SRAM i bufor znaczników TagRAM

Ten sam procesor od przodu

W takiej formie rdzeń P6 przetrwał dosyć długo. Na poważniejszy lifting przyszło czekać aż do trzeciej generacji układów Pentium. Najpierw wraz z 250nm rdzeniem Katmai procesor doczekał się rozszerzenia SIMD w postaci 70 instrukcji SSE realizowanych przez dwa kanały z ośmioma 128-bitowymi rejestrami operującymi na liczbach zmiennoprzecinkowych pojedynczej precyzji. Pojawiło się także 12 kolejnych instrukcji starszego typu - MMX. Co ważne nowe rejestry SSE umożliwiły równoległe używanie jednostek stałoprzecinkowych FP (na których operuje MMX) i jednostki zmiennoprzecinkowej podwójnej precyzji. Pomniejsze zmiany dotyczyły usprawnień w przepływie danych w procesorze i usprawnień w zarządzaniu podręczną pamięcią cache.

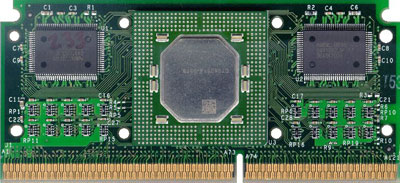

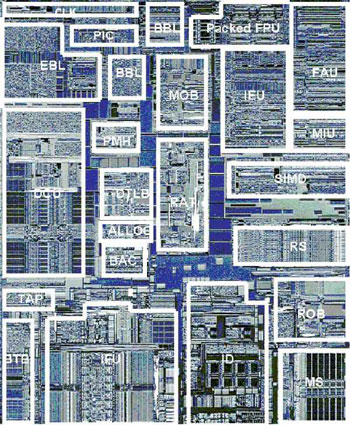

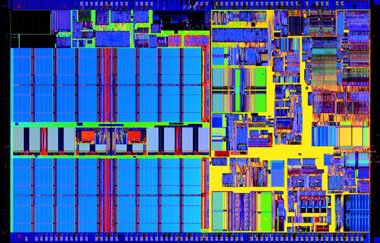

Struktura rdzenia Katmai

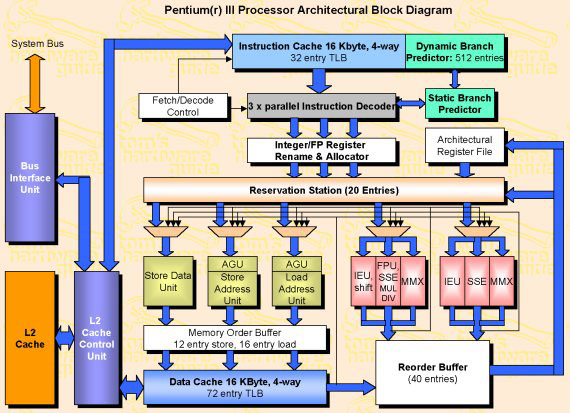

Schemat działania Pentium !!!

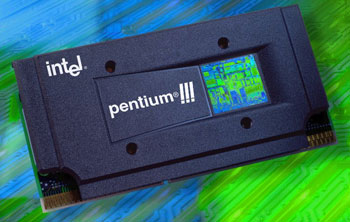

Pentium!!! Slot 1 w obudowie typu SEC2

W późniejszym okresie, wraz z 180nm jądrem Coppermine cache L2 powrócił powrotem do rdzenia. Intel walcząc z istotną nowinką na rynku, procesorami K7 powrócił więc do idei, która stanowiła ważną cechę pierwotnej wersji architektury P6. Cache jakkolwiek mający tylko 256KB pojemności pracował z pełną prędkością rdzenia i stanowił jedność z krzemową strukturą rdzenia. Co więcej komunikacja z pamięcią odbywała się szeroką 256-bitową, ośmiodrożną szyną. Szybka, oferująca nie tylko wysoką przepustowość, ale i niskie opóźnienia pamięć nazwano Advanced Transfer Cache. Do rdzenia wprowadzono też kilka pomniejszych zmian jak choćby powiększenie o połowę liczby buforów szyny FSB (fill buffers) i zwielokrotnienie buforów zapisu (typu write back).

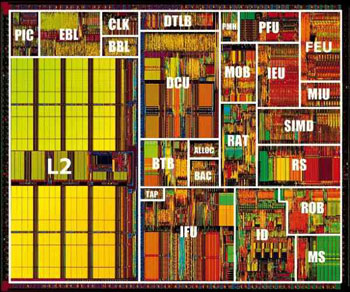

Rdzeń Coppermine z wyszczególnionymi blokami jednostek wykonawczych

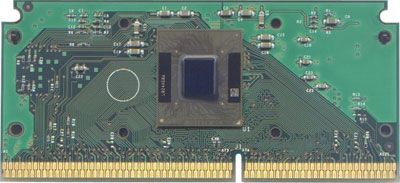

P!!! Coppermine w wersji na gniazdo Slot1...

... i w obudowie FCPGA dla gniazda Socket 370

Ostatnim rodowitym procesorem Pentium !!! był Tualatin - wyposażony w 256 lub 512kb cacheL2 układ wykonany w 130nm procesie technologicznym, używający miedzianych ścieżek. Jedyną innowacją było dodanie systemu pobrań wyprzedzających (Data Cache Prefetch).

Rdzeń Tualatin – widoczny z lewej strony duży, 512KB blok pamięci podręcznej

Pentium !!! S z rdzeniem Tualatin

W cieniu Pentium 4

Wbrew obawom, jądro P6 wcale nie zakończyło życia wraz z procesorami Pentium 4 używającymi zupełnie nowej architektury - NetBurst. P6 odrodził się w mobilnych procesorach Intela i to w dosyć mocno zmodyfikowanej postaci, którego to gorącym zwolennikiem był Paul Otellini. Banias – to pierwszy z rodu układów Pentium M będących wersją rozwojową Pentium !!!, a stanowiący podstawę pierwszej generacji intelowskiej mobilnej platformy Centrino.

Łudząco podobny do Coppermine – Pentum M z rdzeniem Banias

Banias zadebiutował w marcu 2003r. Poczynione zmiany konstrukcyjne miały przede wszystkim ograniczyć zapotrzebowanie energetyczne procesora – jest to zagadnienie mającego fundamentalne znaczenie dla urządzeń przenośnych. Już ostatnie Pentium !!! miały znacznie wyższą sprawność energetyczną w porównaniu do Pentium 4. Jednak to było mało. W Baniasie wprowadzono agresywne bramkowanie zegara, dając możliwość wyłączania nieaktywnych bloków wykonawczych i to w ciągu zaledwie jednego cyklu zegara. Pamięć cache L2 podzielono na 32 bloki z możliwością przełączenia w tryb uśpienia tych nieaktywnych. Bufory szyny systemowej procesora aktywowane są teraz dynamicznie w zależności od potrzeb i nie pracują jednocześnie cały czas. Technologia Enhanced SpeedStep umożliwiła dynamiczną zmianę zegara w zależności od bieżącego obciążenia mikroprocesora, a niezbędne do danego poziomu zegara napięcie zasilające jest regulowane dzięki technologii Mobile Voltage Positioning. Procesor był wykonany w tym samym 130nm procesie technologicznym co Tualatin jednak przedsięwzięte, opisane powyżej kroki mające poprawić bilans energetyczny procesora dały znakomite rezultaty. O ile TDP 1,4GHz Tualatina wynosiło 32W, to tak samo taktowany Pentium M Banias zadowalał się 22W będąc przy tym znacznie wydajniejszym.

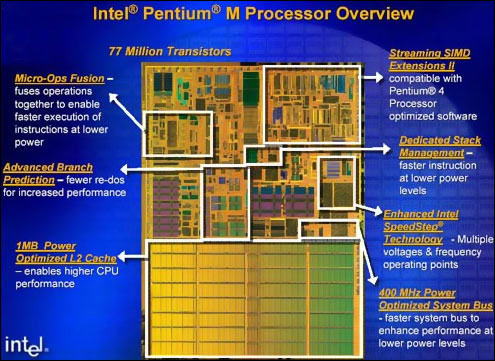

Slajd ukazujący zakres najpoważniejszych modyfikacji Baniasa

Ale wysoka efektywność energetyczna to nie wszystko. Zaszły też zmiany mające podnieść wydajność samego procesora. Modyfikacji uległa pamięć podręczna – podwojono jej pojemność. Rozrosła się zarówno ta poziomu pierwszego, jak i drugiego (odpowiednio 64 i 1024KB), dodatkowo wprowadzono ośmiokrotny układ śledzący wraz z zaawansowanym systemem zarządzającym pozwalającym na czyszczenie i zapisywanie konkretnych bloków cache L2 bez modyfikacji innych danych – możliwość ta ma ścisły związek ze wspomnianą funkcję wyłączania zbędnych bloków cache. Pamięć podręczna poziomu pierwszego ma też szerszą ścieżkę dostępu o takiej samej liczbie wejść jak pamięć poziomu drugiego (jest teraz nie cztero, a ośmiodrożna). Zwiększono pojemność buforów TLB (i to zarówno danych jak i instrukcji) do 128 wpisów. Z procesorów Pentium 4, układ P6 otrzymał szybką, 100MHz szynę AGTL+ działającą w trybie Quad Pumped Bus (potrafiącą przesłać cztery 64-bitowe słowa na takt, a nie jedno jak do tej pory) i rozszerzenia SSE2.

To nie były jednak najważniejsze z punktu widzenia dzisiejszego Conroe zmiany. We wcześniejszych rdzeniach P6 potok wykonawczy miał 10 etapów. Teraz uległ wydłużeniu do 12 kroków. Było to działanie związane z implementacją bardzo ważnej umiejętności. Dodano bowiem funkcję Micro Operation Fusion. Pozwala ona na redukcję instrukcji na odcinku poprzedzającym jednostki wykonawcze, a polega na procesie analizy zdekodowanych mikrooperacji, a następnie wprowadzenia dwóch niezależnych od siebie mikroinstrukcji do jednego potoku wykonawczego CPU i ich jednoczesne, równoległe wykonanie. Technologia ta umożliwia zmniejszenie o około 10% liczby wykonywanych mikrooperacji, a przyniosła średni zysk wydajności procesora w operacjach zmiennoprzecinkowych o 9 i stałoprzecinkowych o 5%. Rozszerzono znaną z P6 umiejętności niekolejnego wykonywania mikrooperacji (Out of Order Execution) powiększając głębokość bufora, zwiększając ilość przechowywanych pozycji aż do 80 (z wcześniejszych 40). Ale to nie koniec zmian. Wprowadzono niezależną, sprzętową jednostkę DSM (menadżera stosu) zajmującą się tylko instrukcjami stosu. Jej wydzielenie pozwala m.in. zmniejszyć liczbę wykonywanych mikrooperacji (o około 5%) i ułatwia wykonywanie zasadniczego programu bez konieczności dzielenia zasobów przez procesor. Udoskonalono też jednostkę prognozowania, zwiększając jej skuteczność o około 20% względem tej znanej z Pentium !!!. Advanced Branch Prediction analizuje wykonywany kod, stara się przewidzieć nadchodzące instrukcje skoków jakie będą wykonane przez jednostkę by zminimalizować prawdopodobieństwo wykonania niepotrzebnych obliczeń i konieczność czyszczenia potoku. Czyni to dzięki użyciu mechanizmów znanych z procesora Pentium 4 i korzysta z połączeniu aż trzech algorytmów: analizy lokalnej, bimodalnej i globalnej zwiększając tym samym zakres przeszukiwanego fragmentu programu. Nie zapomniano też o module Data pre-fetch (pobrań wyprzedzających) współpracującym z jednostką predykcji rozgałęzień dostosowując jego możliwości do powiększonej w stosunku do Tualatina pamięci cache L2. Samo tylko udoskonalenie tych dwóch mechanizmów (przewidywania rozgałęzień i pobrań wyprzedzających) szacunkowo podniosło wydajność Baniasa względem tak samo taktowanego Tualatina o około 7%.

Banias pod mikroskopem

Dość znacznie poprawiony P6 nie trafił do komputerów biurkowych. Intel nie chcąc ustanawiać konkurencji dla promowanego NetBursta skierował go tylko na rynek mobilny. Z czasem zaczęły się pojawiać niewielkie ilości dedykowanych płyt głównych przeznaczonych pod desktopowe komputery PC i umożliwiające obsługę Pentium M w zwykłych komputerach biurkowych. Wysoka cena awangardowych płyt i nieprzychylność Intela uniemożliwiły szersze rozpowszechnienie się takich rozwiązań.

Z drugiej strony był to czas wejścia na rynek dosyć kontrowersyjnego Pentium 4 pod postacią 90nm rdzenia Prescott. Procesora bardzo energochłonnego, potrafiącego pożreć niemal 100W energii, co niezręcznie korespondowało z wręcz zimnym, mobilnym Baniasem, który niejednokrotnie okazywał się wydajniejszy od biurkowych Pentium 4. Intel jednak nie chciał słyszeć o szerszym wykorzystaniu Pentium M. Układ był przeznaczony tylko dla rozwiązań mobilnych... do czasu.

Następcą Prescotta miał być 65nm Tejas. Procesor kontynuujący linię NetBurst. Nigdy jednak nie ujrzał on światła dziennego. Plotki mówiły o jeszcze większym zapotrzebowaniu na prąd w stosunku do Prescotta i niezadowalającej wydajności. Rdzeń nie był w stanie osiągnąć zakładanych częstotliwości. I tu na scenę wkracza P6. W obliczu niepowodzenia rozwoju “wysokozegarowej” architektury NetBurst, pojawiają się pierwsze plotki o pracach Intela zmierzających do połączenia cech układów NetBurst i Banias w jeden procesor mający zastąpić Pentium 4. Na szczegóły tych prac musieliśmy jednak czekać...

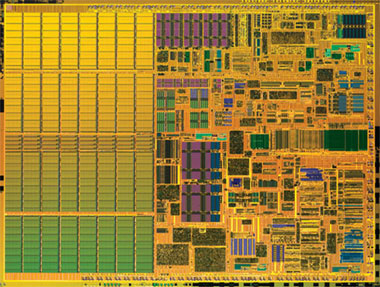

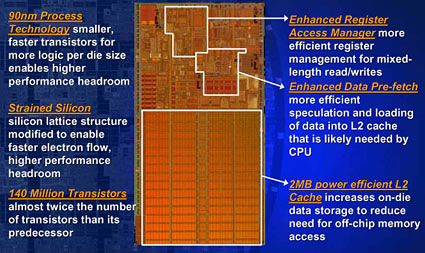

90nm Dothan. Widoczny olbrzymi blok z 2MB chache L2

Banias oparty o rdzeń P6 ewoluował jednak dalej. Nie zatrzymał się w miejscu, debiutując w maju 2004r w nowej postaci rdzenia Dothan. Odświeżona architektura nie przyniosła już tak wielu zmian jak jego starszy brat. Wykonany w wymiarze 90nm z technologią rozciągniętego krzemu (Strained Silicon) układ wyposażono w powiększoną pamięć podręczna. Teraz mamy do czynienia z 2MB cache L2. W związku z powiększeniem pamięci przeprojektowano jednostkę pobrań wyprzedzających (Ehanced Data Prefetch Unit) zwiększając jej trafność, dostosowując do pracy z powiększonym cache. Nowe funkcje w Dothanie obejmują poprawiony system zarządzania rejestrami, który lepiej radzi sobie z zapisem i odczytem danych zmiennej długości. W 2005 roku Dothan doczekał się niewielkiej modernizacji. Podniesiono taktowanie szyny systemowej do 133MHz (efektywnie 533MHz QPB) i dodano znany z Prescotta i K8 bit NX zwany przez Intela EDB (Execute Disable Bit) utrudniający wykonanie złośliwego kodu.

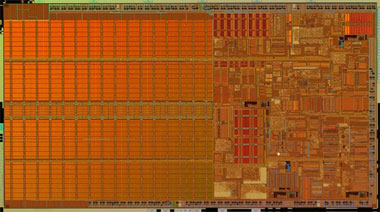

Struktura krzemowa Dothana - Pentium M drugiej genercji

Pentium M z rdzeniem Dothan

Banias do kwadratu

Ostatnim etapem ewolucji P6 przed pojawieniem się Conroe jest rdzeń 65nm Yonah, który na rynku występuje pod nazwą handlową Core Duo i jest pierwszym od wielu lat masowym procesorem Intela x86, który nie używa zarzuconej nazwy Pentium. Nowy układ nie mógł bowiem kojarzyć się z energochłonnym Pentium 4 NetBurst i miał stanowić zapowiedź kolejnych procesorów odchodzących od tej architektury i dających początek czemuś nowemu. Mimo to Yonah wciąż jest procesorem mobilnym, ale dzieli go już tylko krok do Conroe.

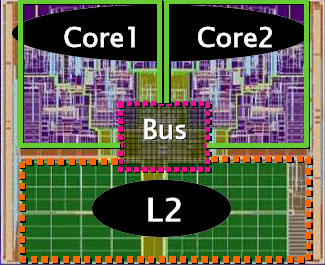

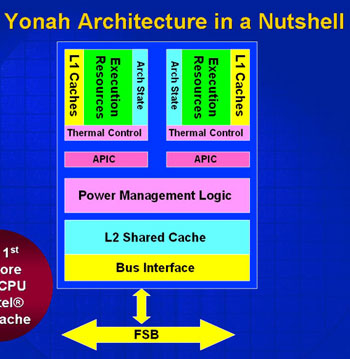

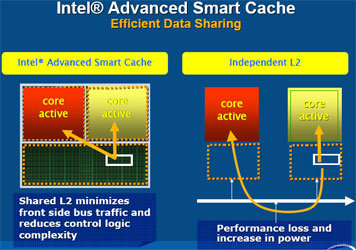

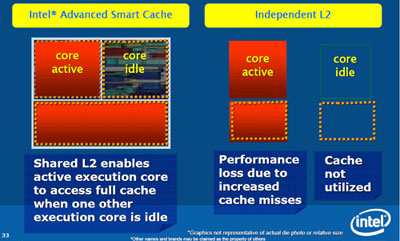

Podstawową różnicą między dotychczasowymi produktami serii Pentium M, a Yonahem jest wielordzeniowość. Procesor posiada dwa rdzenie korzystające ze wspólnej, integralnej 2MB pamięci podręcznej (Smart Cache). Jest to rozwiązanie dokładnie odwrotne w stosunku do spotykanej powszechnie architektury dwurdzeniowych układów Athlon 64 X2 i Pentium D.

Schemat logiczny dwurdzeniowego procesora z niezależnym cache L2 dla każdego rdzenia

Architektura rdzenia Yonah i ze współdzielonym cache L2

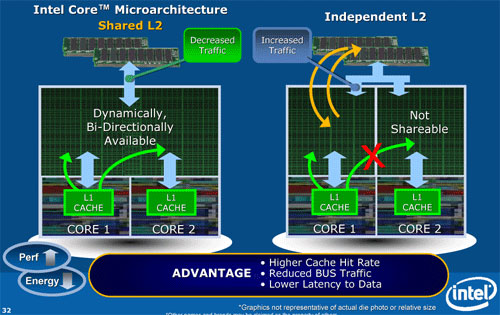

Wspólna pamięć podręczna daje wiele korzyści. Przede wszystkim rozwiązuje problem od wielu lat trapiący rozwiązania wieloprocesorowe – spójności danych cache L2. Dlaczego to zagadnienie jest tak ważne? Układy korzystające z niezależnych pamięci podręcznych muszą uzgadniać zawartość cache, stosując system zachowania spójności cache. Rdzeń (procesor), który wykonał operację musi przesłać odpowiednią informację do drugiego rdzenia (procesora) podejmującego kolejne działanie informując o tym, że dane na których operował uległy modyfikacji. Drugi rdzeń musi po prostu operować na zmodyfikowanych przez pierwszy rdzeń danych. Procedura taka wymaga przesłania zawartości pamięci pomiędzy układami. Blokuje to na pewien czas dostęp do szyny FSB, aż do czasu zakończenia transmisji. Traconych jest na to kilkanaście cykli procesora. Yonah nie musi marnować czasu na uzgadnianie zawartości cache pomiędzy rdzeniami, jako że oba mają dostęp do tych samych danych umieszczonych we wspólnej pamięci. To oczywiście nie koniec zalet. W zadaniach jednowątkowych, gdy obliczeniami zajęty jest tylko jeden z rdzeni - drugi pozostaje bezczynny, aktywny układ może korzystać z pełnej pojemności pamięci cache przydzielając dla swoich potrzeb całe 2MB cache. Jedna, wspólna pamięć upraszcza konstrukcje procesora, ogranicza ilość pobieranej i wydzielanej energii - co dla układu mobilnego jest bardzo ważne. Znacznie obciążona w chipach wielordzeniowych szyna FSB nie musi już tracić cennej przepustowości na uzgadnianie spójności pamięci podręcznej rdzeni, a procesor również nie musi czekać na wynik tego działania. Strata wynikająca z konieczności uzgodnienia zawartości cache w przypadku dwurdzeniowych Athlonów 64 X2 wynosi 110ns, podczas gdy dla Pentium D jest to aż 200ns.

Niestety nic nie jest idealne. Znacznemu wydłużeniu w stosunku do wcześniejszych mutacji P6 uległ czas dostępu do pamięci podręcznej. Dzieje się tak m.in. dlatego, że w tym samym czasie dostęp do pamięci ma tylko jeden z rdzeni. Komunikacja z cache L2 odbywa się więc w sposób naprzemienny. Jednak wadę tą w znacznym stopniu niweluje szeroka ścieżka dostępowa do pamięci, znacząco skracająca czas potrzebny na przesłanie danych i unieruchamiająca jedno z jąder. W przypadku rdzenia Coopermine latencja pomięci podręcznej wynosiła około 7 cykli, Baniasa 9, a Dothana 10 cykli, to w przypadku Yonaha mamy już 14-15 cykli.

Kolejny raz w Yonahu przeprojektowano jednostkę pre-odczytu (Prefetch). Jej rola jest bardzo ważna, bowiem odpowiada teraz za dostarczanie do pamięci podręcznej danych wykorzystywanych już nie przez jeden, a dwa rdzenie. Trafność tego mechanizmu musi być więc wyjątkowo wysoka. Niejako przy okazji przeglądowi poddano bufory zapisu, które mają teraz większą głębokość.

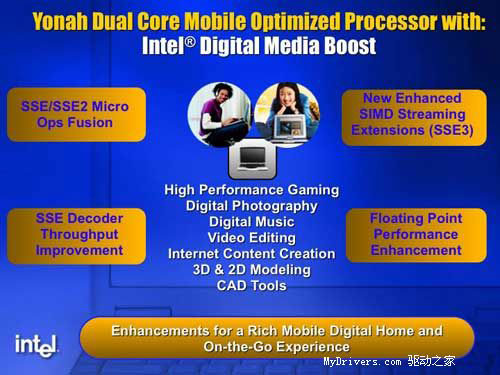

Dodanie drugiego jądra i zmiana roli pamięci cache L2 to ważne cechy wyróżniające procesor na tle Dothana, ale nie jedyne. Yonah wzbogacił się o 13 znanych z Prescotta instrukcji SSE3, ale jednocześnie przyspieszeniu uległy operacje na instrukcjach SSE. Znacznie wyższą wydajność pracy uzyskano dzięki zaprzęgnięciu wszystkich trzech dekoderów instrukcji. Operacje SIMD na rozszerzeniach SSE mogą być łączone dzięki mechanizmowi Micro Ops Fusion. Przyspieszeniu uległy też operacje przeprowadzane na jednostkach zmiennoprzecinkowych (Floating Point Unit), które od czasu pierwszych procesorów Pentium nie uległy poważniejszym modernizacjom. Wszelkie zmiany wokół mechanizmów odpowiedzialnych za jednostki FP i SSE zostały nazwane Intel Digital Media Boost ze względu na ich główną przydatność w szeroko rozumianych zastosowaniach multimedialnych.

Funkcjonalność procesora powiększyła obsługa wirtualizacji Intel Virtualization Technology skrywana pod kodową nazwą Vanderpool. Z wydajnościowego punktu widzenia warte nadmienienia jest kolejne podniesienie taktowania szyny FSB do 166MHz (667MHz QPB).

W Yonahu Znacznej rozbudowie uległy mechanizmy oszczędzania energii. Podstawą działania funkcji jest zmiana stanu pracy procesora. Normalnym trybem pracy jest stan wyłączenia jednostek chyba, że są potrzebne do pracy i dopiero wtedy są one aktywowane. Dzieje się to w zgodności z protokołem „Normaly Off”. W dotychczasowych rdzeniach trybem podstawowym był stan dokładnie odwrotny tj. „Normaly On” - gdy niepotrzebne jednostki były dopiero specjalnie wyłączane dla oszczędzania energii. Samo tylko odwrócenie trybu pracy bloków wykonawczych pozwala zmniejszyć zapotrzebowanie energetyczne o około 7%.

Yonah i jego 6 stanów aktywności

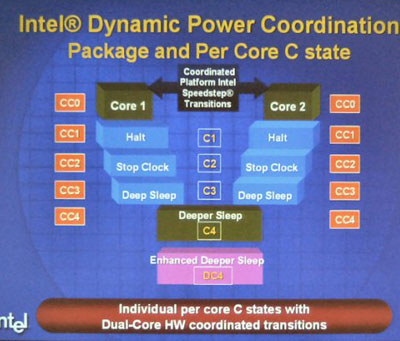

Na tym nie koniec. Yonah udostępnia znacznie bardziej rozbudowane niż Banias/Dothan stany aktywności. Istniejące już wcześniej, a oznaczone C0, C1, C2, C3, C4 tryby zostały wzbogacone o kolejny stan - DC4, w którym to, poza wyłączeniem bloków procesora, obniżeniem zegara i napięcia zasilającym (stan głębokiego uśpienia) następuje całkowite wyczyszczenie i wyłączenie cache L2 z przeniesieniem jej zawartości do wydzielonego obszaru pamięci operacyjnej. Kolejny zysk dało uniezależnienie od siebie pracy każdego z dwóch rdzeni. Dano możliwość zmiany trybu aktywności każdego z nich osobno w zależności od obciążenia. W chwili wykonywania zadań jednowątkowych drugi rdzeń przechodzi do niższego stanu aktywności jeśli tylko nie jest potrzebny w danej chwili. Kiedy aktywny jest jeden tylko rdzeń (stan CC0), drugi może uzyskać stan C3 Deep Sleep. Dwa najbardziej oszczędne tryby (CC4 Deeper Sleep i DC4 Enhanced Deeper Sleep) mogą być ustanowione tylko dla dwóch rdzeni jednocześnie, a więc w chwili braku obciążenia dla całego procesora. Oczywiście dalej istnieje możliwość selektywnego wyłączania poszczególnych bloków pamięci cache L2 w zależności od aktualnych potrzeb wykonywanej aplikacji, jeśli ta nie wymaga zajęcia całej dostępnej przestrzeni pamięci podręcznej. Mechanizm nadzorujący i realizujący wszystkie poszczególne stany energetyczne rdzeni zyskał nazwę DPC (Dynamic Power Coordination).

Procesor Core Duo Yonah. Widoczny zmieniony w stosunku do Dothana kształtu rdzenia

Czym jest Conroe ?

Wbrew przewidywaniom Intela, NetBurst, pochłaniający ogromne ilości energii, nie bardzo nadawał się do notebooków. Co prawda istniała na rynku mobilna wersja Pentium 4 (Pentium 4-M), ale dosyć szybko straciła ona znaczenie na rzecz platformy Centrino z procesorami Pentium M. Argument możności zastosowania energooszczędnego, wydajnego procesora zbudowanego na bazie P6 Baniasa w maszynach biurkowych początkowo nie trafiał do świadomości decydentów Intela, bowiem do czasu Prescotta i niespodziewanych problemów z jego następcą – Tejasem, oszczędzanie nie było sprawą ważną. Niestety szybko okazało się, że dalej w gorącą ścieżkę brnąć się nie da, zwłaszcza że NetBurst nie potrafi spełnić pokładanych weń nadziei. Głośno ogłaszane w chwili debiutu tej architektury 10GHz Pentiumy wypaliły się już w okolicach 3,8GHz, a wydajności nie da się podnosić już tylko windowaniem zegara taktującego... Jak nie siłą to finezją i Intel w końcu zdecydował się na zmianę podejścia do swoich wyrobów ogłaszając, że najważniejszy dla niego będzie teraz stosunek wydajności do ilości pobieranej mocy. Zakończyła się pogoń za gigahercami.

Słabość NetBursta oczywiście nie była jedynym impulsem do poczynienia zmian. Zdaje się że najważniejszym były śmiałe poczynania AMD i procesorów K8, które popędziły kota Pentium 4 uwydatniając wszelkie jego wady. Układy AMD, nie dość że były bardzo wydajne, to jeszcze znacznie mniej energochłonne.

Reagować trzeba było szybko. Intela nie stać było na opracowanie nowej architektury od podstaw (nie w sensie bezpośrednio finansowym, a czasowym... choć jak wiadomo czas to pieniądz), wiec zabrał się za przegląd tego co miał. A miał co prawda już z pozoru leciwą, ale dzięki ciągłemu rozwoju niejako na uboczu wciąż wystarczająco wydajną i co ważniejsze umiarkowanie pazerną na prąd architekturę P6, a dokładniej mocno zmodernizowaną jej postać - czyli Baniasa. Prace nad dalszymi udoskonaleniami Baniasa/Dothana szły w dwóch, ale dosyć mocno ze sobą związanych kierunkach – modernizacji Baniasa, który zmaterializował się jako dwurdzeniowy Yonah i układu bardzo podobnego do niego, ale idącego w zmianach jeszcze o krok dalej - dzisiejszego Conroe.

Intel chcąc zastąpić architekturę NetBurst nie mógł po prostu wprowadzić Yonaha do desktopów. Jakkolwiek rdzeń był szybki i gospodarny, to nie dawał wystarczającej przewagi nad układami konkurencji. Należało jeszcze popracować nad wydajnością samego procesora i popchnąć zmiany poczynione w Yonahu jeszcze o krok dalej.

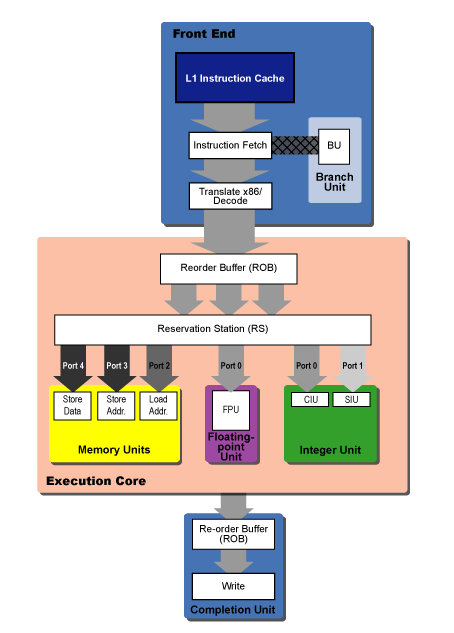

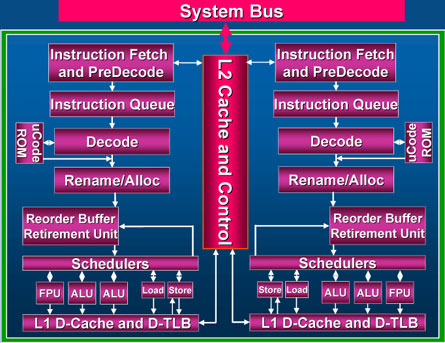

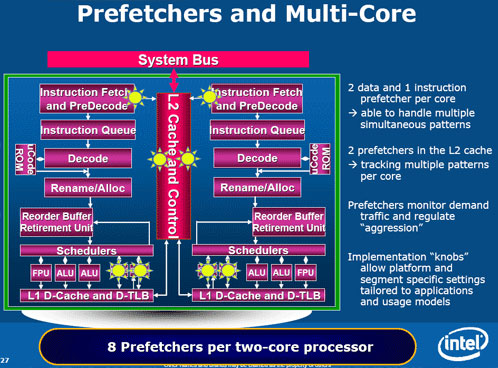

Schemat blokowy procesora Conroe...

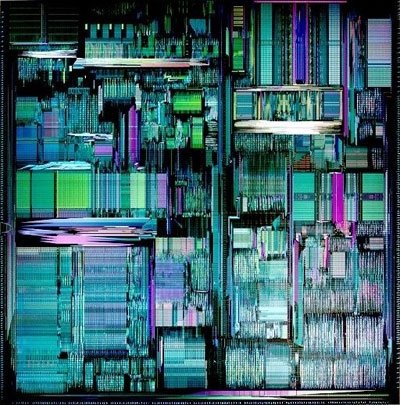

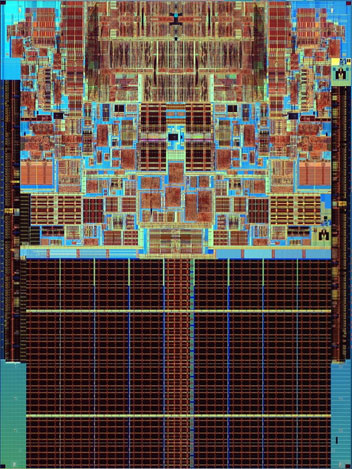

... i jego struktura krzemowa

Podstawowymi dwoma czynnikami wpływającymi na wydajność mikroprocesora jest ilość instrukcji możliwych do wykonania przez układ w czasie jednej fazy zegarowej zwanej z angielska wskaźnikiem IPC (Instructions Per Cycle) i wysoka częstotliwość pracy samego rdzenia. Tu postanowiono połączyć cechy superskalarnej architektury P6 (o dosyć wysokim współczynniku IPC - w okolicach 3) i NetBurst - czyli umożliwić układowi osiąganie wyższych zegarów niż potrafił do tej pory Yonah. By spełnić pierwszy warunek zabrano się za podnoszenie sprawności działania istniejących już jednostek wzbogacając je o nowe mechanizmy i dodanie nowych, niespotykanych dotychczas funkcji.

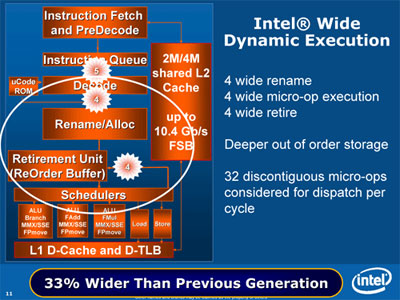

Czteropotokowa architektura P6/Banias posiadała potrójny dekoder instrukcji i trójdrożny Sheduler. Taka kombinacja umożliwiała jednoczesne wykonanie do trzech 3 instrukcji na cykl. To dużo, ale jednak za mało by mieć pewność sukcesu i zyskać bezpieczną przewagę nad konkurentem. By zwiększyć wydajność nowego rdzenia i podnieść wskaźnik IPC podjęto szereg kroków.

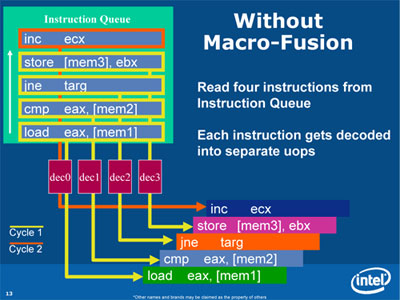

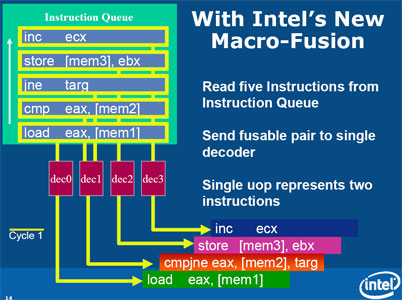

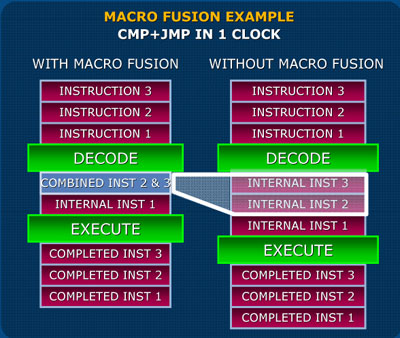

Do znanej już z Baniasa Micro Ops Fusion dodano Macro Ops Fusion. Działa ona podobnie do pisanej wcześniej mikro fuzja, z tą różnicą, że tym razem dekoder analizuje niezdekodowane makroinstrukcje, łączy dwie z nich w fazie dekodowania i wprowadza do potoku w celu równoległego wykonania. Łącznie więc do fazy potoku trafiają cztery instrukcje, a połączenie dwóch technologii fuzji (mikro i makro) pozwala ograniczyć o 15% ilość przetwarzanych instrukcji i przeznaczyć zaoszczędzony w ten sposób czas na obróbkę danych.

By wykorzystać potencjał drzemiący w możliwości szybkiego przetworzenia instrukcji przekazywanych dalej do jednostek wykonawczych należało mieć pewność, że nie będą one zalegały czekając na swoją kolej. Dlatego Conroe wzbogacił się o kolejne jednostki logiczne: arytmetyczno – logiczną i zmiennoprzecinkową mogące wspomóc dotychczasowe w obróbce napływających instrukcji. Dodano po jednej jednostce obu typów co zwiększyło ich liczbę w stosunku do wcześniejszych mutacji P6 do 3 (3 ALU i 3 FPU).

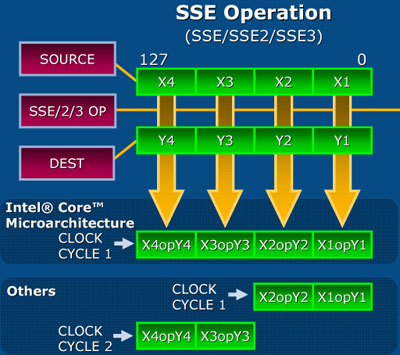

Na tym się jednak nie skończyło. Znacznej przebudowie uległy same jednostki zmiennoprzecinkowe, które teraz zyskały możliwość wykonywania operacji na instrukcjach SIMD SSE/SSE2/SSE3. To znaczna innowacja dająca wyraźny wzrost prędkości obliczeń, w Conroe operacje SSE ze 128 bitową precyzją wykonywane są teraz w czasie jednego cyklu zegarowego. W porównaniu do Conroe Yonah dysponował dwiema niezależnymi jednostkami FPU i dodatkową dedykowaną tylko do instrukcji SIMD. Warto nadmienić również fakt rozszerzenia listy rozkazów SIMD Conroe o kolejne 16 instrukcji SSE czwartej generacji, które to odziedziczone zostały po skasowanym projekcie procesora Tejas. Modyfikacje mające na celu podniesienie wydajności w zakresie operacji na multimedialnych operacjach SSE nazwano Advanced Digital Media Boost.

By osiągnąć wyższy wskaźnik IPC należało przyjrzeć się dekoderowi instrukcji odpowiedzialnemu za przekształcanie instrukcji x86 w mikrooperacje wewnętrzne procesora. Dotychczas istniejący potrójny dekoder praktycznie uniemożliwiał wykonania więcej niż 3 instrukcji na takt. Dlatego też Conroe dodano trzecią jednostkę dekodującą typu simple (P6 posiadał jeden dekoder główny ogólnego przeznaczenia typu complex i dwa proste typu simple dla krótkich instrukcji jak choćby przesłania międzyrejestrowe). Podobnie uczyniono z Schedulerem, czyli układem odpowiedzialnym za przydział instrukcji do poszczególnych jednostek wykonawczych. Dotychczas potrójną jednostkę rozbudowano tak, by móc zarządzać i kierować jednocześnie cztery niezależne instrukcje do jednostek wykonawczych rozszerzając zakres oczekujących mikroinstrukcji wejściowych z 24 do 32 (oryginalnie Pentium Pro obsługiwał 20 instrukcji). Znaną już z Pentium Pro jednostkę odpowiedzialną za przekolejkowanie instrukcji, która ułatwia zapełnienie potoków równolegle wykonywanymi instrukcjami, modernizowano już w Baniasie, ale teraz jeszcze nieco ją pogłębiono. Bufor Out of Order Execution może teraz zawierać 96 pozycji. Jest to szczególnie istotne w obliczu powiększonej liczby jednostek wykonawczych ponieważ daje większe pole wyboru dla Shedulera, które może ustalać w szerszym zakresie, jakie z instrukcji przydzielić do wykonania. Opisane wyżej ulepszenia uzyskały marketingową nazwę Wide Dynamic Execution. Od teraz procesor uzyskał bardzo wysoki współczynnik IPC oscylujący powyżej wartości 3,5. Daje to nie tylko znaczącą przewagę nad raczej mało gospodarnym Pentium 4, ale nade wszystko procesorami K8 ze współczynnikiem poniżej 3.

Yonah, by się stać pełnoprawnym procesorem biurkowym w ewolucji do Conroe, musiał wzbogacić się o cechę stosunkowo mało istotną z punktu widzenia komputerów przenośnych, ale mającą coraz większe znaczenie w maszynach biurkowych, a będący fundamentem dla stacji roboczych i serwerów (do których to maszyn Intel nowy procesor skierować też chciał). Mowa o możliwości wykonywania 64-bitowego kodu, a dokładniej o intelowskiej implementacji znanego z procesorów AMD rozszerzenia x86-64 występującego pod oznaczeniem EM64T.

Intel nigdy nie przykładał większej uwagi do zapewnienia swym procesorom zgodnym z modelem IA-32 możliwości wykonywania 64-bitowego kodu i swoją wersję 64-bitowych rozwiązań przewrotnie nazywa Extended Memory 64-bit Technology wskazując na fakt, że głównym celem tej technologii jest powiększenie zakresu adresowania pamięci ponad 4GB. Jednak nadchodzący nowy system operacyjny Microsoftu, znany jako Vista będzie od początku występował z natywnym wsparciem dla architektury AMD64 i EM64T. Brak możliwości pracy w nowym, 64-bitowym środowisku byłby sporym niedopatrzeniem. Migracja do 64-bitów to nie tylko możliwość adresowania większych obszarów pamięci operacyjnej, ale nade wszystko środek na osiągnięcia sporego przyrostu wydajności.

Obsługa technologii EM64T w Conroe jest możliwa dzięki szesnastu rejestrom ogólnego przeznaczenia operującym na 64-bitowych słowach. Niestety są pewne ograniczenia przy pracy w tym trybie. Procesor nie wspiera technologii makrofuzji przy pracy w 64-bitowym środowisku z uwagi długość instrukcji w tym trybie, które wykraczają poza obszar szczególnej efektywności makrofuzji wykazywaną przy długości instrukcji do 4B. W chwili gdy przeciętna długość instrukcji jest większa niż 4B, Conroe może utracić zdolność do jednoczesnego wykonania 4 instrukcji na takt, a takie prawdopodobieństwo jest wysokie dla 64-bitowego słowa. W standardowym kodzie x86 długość instrukcji mieści się w przedziale 2,5-3,5B. Prefiks REX charakterystyczny dla środowiska x86-64 zwiększa ten rozmiar.

EM64T i zdolność do pracy z nowym kodem zdejmuje jedno z podstawowych ograniczeń systemów 32-bitowych – rozszerza zakres adresowanej pamięci operacyjnej poza krytyczną już dziś granicę 4GB. Conroe oferuje obsługę 36 bitowego adresowania fizycznego i 48 bitowego adresowania wirtualnego.

Także system pamięci zyskał pewne ulepszenia. O ile rozmiar cache L1 nie uległ zmianom (podwojono jedynie pojemność bufora adresów danych tablicy TLB ze 128 do 256 wpisów), to w stosunku do Yonaha podwojono wielkość wspólnej dla dwu rdzeni pamięci podręcznej poziomu drugiego. Ogólny model pracy współdzielonej pamięci nie uległ zmianie od czasu rdzenia Yonah i posiada ten sam zestaw zalet, z czego najpoważniejszą jest znaczne odciążenie szyny FSB od obowiązku uzgadniania spójności danych cache L2. Jeśli obciążony jest tylko jeden rdzeń, zyskuje on dostęp do całej pojemności pamięci. Jeśli oba pracują jednocześnie nad różnymi danymi pamięć jest dzielona proporcjonalnie w zależności do ilości wywołań każdego rdzenia do pamięci. Jeśli rdzenie pracują na tych samych danych, są one do pamięci przesyłane tylko raz i oba rdzenie korzystają z tej samej paczki informacji. Poprawiono nieco sam mechanizm pracy pamięci mając na celu podniesienie wydajności przy odwołaniach do cache L2 poprzez wprowadzenie dla 4MB rdzenia Conroe szesnastodrożnego śledzenia w miejsce wcześniejszego, znanego jeszcze z Coppermine ośmiokrotnego.

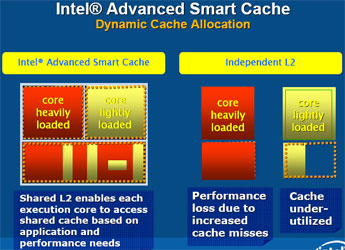

Powiększonemu cache towarzyszy rozbudowany układ pobrań wyprzedzających i predykcji. Ten, mimo iż ulegał już kilku modyfikacjom w czasie dotychczasowej historii rozwoju rodziny procesorów P6/Banias, to teraz jest jeszcze lepszy. Każdy rdzeń posiada potrójny układ pobrań, z czego dwa przeznaczono na dane i jeden na instrukcje. Do tego cache L2 posiada dodatkowo własny, podwójny system. Rozbudowany układ przewidywania rozgałęzień kodu ma skuteczność znacznie przewyższającą dotychczasowe wzorcowe konstrukcje znane z procesorów K6 firmy AMD i Pentium 4 eliminujący ponad 99% wszystkich skoków zapewniając tym samym minimalny poziom błędów predykcji.

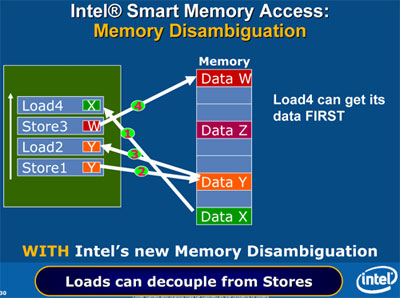

Rozbudowany układ pobrań i predykcji rozgałęzień w połączeniu z bardzo dużą i co ważniejsze bardzo szybką, dobrze zarządzaną wspólną pamięcią podręczną cache L2 ma zniwelować jedną z nielicznych wad nowego dzieła inżynierów Intela w rywalizacji z konkurencyjnym K8. Chodzi o brak wbudowanego kontrolera pamięci RAM, który to jest obecny w ósmej generacji procesorów AMD i znacząco podnosi wydajność wymiany informacji procesora z pamięcią operacyjną. By zminimalizować straty wynikające z konieczności korzystania przez Conroe z zewnętrznego kontrolera RAM sięgnięto po dwie techniki zaradcze.

Najprostszym krokiem było podniesienie taktowania szyny FSB przyspieszając komunikację na poziomie kontroler pamięci <=> procesor. Ta jest obecnie taktowana zegarem 266MHz (1066MHz QPB). To znaczny skok nie tylko w porównaniu do Yonaha, gdzie mieliśmy zaledwie 166MHz zegar (667MHz QPB), ale nawet dwurdzeniowego Pentium D, w którego przypadku było to przeważnie 200MHz (800MHz QPB), ale tu dodatkowo szyna systemowa była odpowiedzialna za stanowiącą swego rodzaju hamulec ręczny konieczność zapewnienia spójności pamięci podręcznej. Na tym polu Conroe ma sporą przewagę nad oboma poprzednikami. Ale to nie wszystko co uczyniono dla poprawy wydajności pracy podsystemu pamięci. W Conroe zastosowano bardzo istotną innowację - technikę Memory Disambiguation. W klasycznych rozwiązaniach operacji Load i Store (odczytu i zapisu) - za które odpowiada jedna, wspólna dla obu typu operacji jednostka - nie da się wykonać równocześnie. Konieczność przeprowadzenia najpierw odczytu z pamięci, a dopiero w następnej kolejności operacji zapisu danych nie jest korzystna z punktu widzenia procesora, który ma przecież częstotliwość kilkukrotnie wyższą niż pamięć operacyjna. To wprowadza bardzo niekorzystne przestoje. Conroe otrzymał więc dwa osobne układy - jeden odpowiada tylko za operacje Load, drugi Store. Dzięki temu możliwe jest przekolejkowanie i optymalizacja obu typu operacji zapewniając większą elastyczność w odwołaniach do pamięci RAM, przyspieszając transfer i skracając czas oczekiwania na paczkę danych. Teraz możliwe jest ustalenie priorytetu przeprowadzanych operacji - wykonanie niektórych z nich poza ogólną kolejnością z uwagi na ich ważność pozwalając tym samym unikać przypadków konieczności długotrwałego oczekiwania przez procesor na zakończenie jednego typu działania.

Same optymalizacje jednostek wykonawczych to jednak nie wszystko co uczyniono by zapewnić Core 2 Duo sukces wydajnościowy. Ostatnie mutacje P6/Baniasa miały pewne trudności z rozpędzaniem się do częstotliwości ponad 2,5GHz (z uwagi na ograniczenia energetyczne rozwiązań mobilnych najszybszy mobilny Yonah oznaczony Core Duo T2700 ma taktowanie na poziomie 2,33GHz). Conroe wykonany z użyciem tej samej technologii 65nm rozciągnięto krzemu (Strained Silicon) co Yonah musiał mieć możliwość pracy z wyższymi zegarami. By to ułatwić uczyniono to samo co przydarzyło się Prescottowi. Wydłużono potok wykonawczy. Nie była to jednak różnica tak duża jak po przejściu z Northwooda do Prescotta (wtedy wydłużono potok z 20 do 31 etapów). Teraz zamiast 12, potok składa się z 14 faz. Pozwala to na bezproblemowe pokonanie granicy 3GHz i daje wizję dalszego przyspieszania procesora w miarę dopracowania technologii procesu produkcji rdzenia i ukazywania się jego nowych steppingów.

Conroe bez "pokrywki"

Procesory Conroe przeznaczone na rynek komputerów desktop korzystają ze znanej już dobrze zadomowionej na rynku podstawki LGA 775. Nie oznacza to jednak, że procesor potrafi pracować z każdą płytą posiadającą to gniazdo. Ograniczeniem nie jest bynajmniej sam chipset, na bazie którego powstała płyta, a jej zgodność ze schematem zasilania VRM 11 (Voltage Regulator on the Motherboard). Praktycznie żadna ze starszych płyt głównych nie obsługuje nowego standardu i tylko najnowsze wersje potrafią zapewnić procesorom Conroe odpowiednie prądy.

Wbrew początkowym opiniom, to czy najnowszy procesor Intela potrafi pracować z daną płytą jest praktycznie niezależne od chipsetu. Ważne jest by wspierał on szynę AGTL+ i posiadał układ zasilający zgodny ze standardem VRM 11. Obsługę Conroe zapewnić może nawet dosyć stary i865PE. Problemem dla niektórych chipsetów może być tylko zdolność do osiągnięcia 266MHz FSB.

Chipsetem specjalnie dedykowanym dla Core 2 Duo jest rodzina intelowskiech układów „965”. Wybierając płytę główną opartą o ten chipset możemy mieć 100% pewność, że poradzi sobie ona z naszym bohaterem, ponieważ każda z nich jest zgodna ze standardem VRM11. Niestety wszystko, co powstało wcześniej może być problematyczne i przed zakupem należy się upewnić, czy płyta którą mamy na oku na pewno pracuje z Conroe. Zdarza się bowiem, że starsze wersje płyt powstały już w nowych rewizjach, które radzą już sobie z nowym schematem zasilania i bez problemów dogadają się z Conroe.

Ideą przyświecającą twórcom najnowszej mutacji rdzenia P6 było zapewnienie najlepszego stosunku „wydajności na wat”. Stanowić to miało wyraźne przeciwieństwo do dotychczasowej pogoni wydajnościowej za wszelką cenę, efektem czego był gorący Prescott, który notabene w starciu z K8 już taki wydajny nie był... Do realizacji założonej polityki zmodyfikowany rdzeń P6 nadawał się doskonale, a stawiając na oszczędnego Banias'a Intel lepszego kandydata na swój przyszły przebój lepiej wybrać nie mógł.

Jądro Conroe po swych poprzednikach odziedziczyło cały szereg zalet. Wysoką efektywność jednostek wykonawczych, zaawansowane technologie oszczędzania energii i konkurencyjną wydajność. Jest to o tyle ważne, że Conroe pod nazwą Merom przeznaczono nie tylko do napędu komputerów klasy PC. Ten sam rdzeń stać się miał kolejnym sukcesorem układów mobilnych, mając w bliskiej przyszłości zastąpić stosunkowo świeży jeszcze rdzeń Yonah.

Pierwsze próby oszczędzenia energii i ograniczenia emisji ciepła w procesorach komputerów stacjonarnych Intel podjął jeszcze za czasów Prescotta, wprowadzając w rdzeniach ze steppingiem N0 dwie technologie, które są obecne również w układach Core i ... zostały zapożyczone z mobilnych Pentiumów. Mowa o EIST (Enanced Intel SpeedStep Technology) i Enhanced Halt Mode C1E.

W czasie niskiego obciążenia Conroe redukuje zegar końcowy poprzez obniżenie mnożnika do 6 (osiągając tym samym taktowanie 1,6GHz). Jest to najniższy możliwy do osiągnięcia poziom i jest on jednakowy zarówno dla najszybszego układu taktowanego zegarem 2,93GHz (mnożnik nominalny 11, minimalny przy niskim obciążeniu 6) jak i najwolniejszego modelu taktowanego 1,83GHz (obniżenie mnożnika z 7 do 6). Niestety biurkowy Core 2 ciągle w zakresie możliwości obniżania zegara ustępuje znanej z procesorów AMD technologii Cool&Quiet, która to potrafi zwolnić procesor nawet do 1GHz, co w stanach niskiej aktywności mogłoby dać jeszcze pewne oszczędności. Niestety tak niskie możliwe do osiągnięcia wartości Intel zarezerwował dla mobilnych wersji swych procesorów. No ale nie warto drzeć szat z tego powodu. W końcu komputery biurkowe nie korzystają z tak deficytowych źródeł energii elektrycznej jak laptopy.

Po mobilnych Pentiumach zachowano system Ultra Fine Grained Power Control – czyli możliwość wyłączenia obszarów procesora, które nie są potrzebne do wykonania określonego zadania.

Ale oszczędzanie energii nie ogranicza się jedynie do samego procesora. Cała platforma powinna szanować prąd. Ciekawa jest technologia PSI-2 mająca zwiększyć efektywność układów zasilających procesor. Specjalny kontroler monitoruje poziom prądów zasilających CPU i może wysyłać do regulatora napięcia nakaz wyłączenia niektórych bloków regulatora zapięcia w chwili gdy zapotrzebowanie energetyczne procesora jest niskie. Chodzi po prostu o jak najefektywniejsze wykorzystanie bloku zasilającego procesor w zależności od jego stopnia obciążenia. Niestety nie każda płyta główna posiada moduł zdolny współpracować z tą technologią, która zasadniczo jest przeznaczona dla mobilnych układów Merom.

Digital Thermal Sensors (DTS) to układ odpowiedzialny za kontrolę ciepłoty rdzenia. Składa się on z kontrolera połączonego z czterema cyfrowymi sensorami termicznymi (w miejsce wcześniejszych analogowych), które po dwa na rdzeń umieszczono w newralgicznych w punktach procesora.

Ostatnim elementem kontroli termicznej jest technologia Platform Environment Control Interface (PECI). Akurat nie jest to żadna wielka nowość i mamy z nią do czynienia już jakiś czas. Opiera się ona o układ monitorujący poziom temperatury wewnątrz komputera, a sprzęgająca również technologię DTS do utrzymania odpowiedniego poziomu termicznego peceta. Zarządza poziomem przepływu powietrza w obudowie kontrolując prędkość obrotową wentylatorów.

Jeszcze na długo przed ujawnieniem procesora o kodowej nazwie Conroe Intel postanowił porzucić tradycyjną dla swoich układów nazwę Pentium by zerwać z coraz gorzej kojarzącymi się procesorami, które nie dość że są mało efektywne energetycznie, to jeszcze wydajnością też już nie grzeszą. Ostatnimi Pentiumami były dwurdzeniowe układy NetBurst - Pentium D oparte o rdzeń Presler i mobilne, jednordzeniowe Dothany.

Następca Dothana, Yonah porzucił nazwę Pentium M. Od tej chwili Intel swoje nowo prezentowane układ nazywa...Core. Dwurdzeniowy Yonah to układ występujący pod nazwą handlową Intel Core Duo, a jego wersja z jednym rdzeniem to Intel Core Solo.

Rzecz jasna Conroe nie można było nazwać Pentium 5. Rzeczownik Pentium stracił bowiem u Intela pracę i odszedł na emeryturę. Sukcesor Yonaha nazywa się więc Core 2 Duo, jako że stanowi drugą generację mikroprocesorów Core.

Podobny los - tj. konieczność odejścia na emeryturę spotkał system wyróżniający wydajnościowo modele należące do tej samej linii, ale różniące się zegarem. Wraz z debiutem podstawki LGA775 2 lata temu Intel przestał wyróżniać swoje procesory ze względu na szybkość taktowania. Zamiast tego pojawił się model oznaczeń numerycznych. I tak mieliśmy do czynienia z Pentium 4 serii 5xx (np. Pentium 4 530) dla Prescotta, Pentium 4 630 dla Prescotta z 2MB cache L2 czy też układami serii Pentium D oznaczonymi jako 8xx (dwurdzeniowy Smithfield) i Pentium D 9xx (dla dwurdzeniowych Preserów). Było to swego rodzaju preludium przed tym w jaki sposób Intel obecnie oznacza swoje procesory.

Obecnie istniejący system, z którego korzysta także Conroe opiera się o wspomniany już stosunek „wydajności na wat” i odchodzi zarówno od modelu numerycznego znanego z ostatnich Pentiumów jak i wyróżniania wydajności ze względu na zegar taktujący.

Na rynku spotkać możemy modele oznaczone choćby tak: Intel Core Duo T2600

Klasyfikacja jest prosta. Mamy do czynienia z pierwszą generacją układów Core, czyli - z Yonahem. Pierwsza litera oznaczenia literowo-cyfrowego określa klasę energetyczną rdzenia. Jest ich pięć:

- U - procesor o bardzo niskim poziomie mocy – do 15W

- L - układ z niskim poborze mocy - między 15, a 24W

- T - pobór w zakresie 25 - 55W

- E - pobór w przedziale 55 - 75W

- X - klasa energetyczna powyżej 75W

Układy przedziału U do T przeznaczono przeważnie są do urządzeń mobilnych. Ponieważ układy biurkowe nie muszą spełniać tak ostrych kryteriów energetycznych, mieszczą się w klasie E i X.

Symbole cyfrowe pojawiające się po oznaczeniu literowym to oznaczenie modelu. Im jest ono wyższe, tym procesor jest wydajniejszy.

- Seria 1xxx - mobilne procesory Core Solo oparte o jednordzeniowe Yonahy

- Seria 2xxx – mobilne procesory Core Duo zbudowane na dwurdzeniowym jądrze Yonah

- Seria 4xxx i 6xxx – biurkowe procesory Core 2 Duo oparte o rdzeń Conroe

- Seria 5xxx i 7xxx – mobilne procesory Core 2 Duo na rdzeniu Merom

Zgodnie z powyższym schematem obecnie do czynienia mamy z następującymi procesorami korzystającymi z rdzenia Conroe:

*) model jeszcze niedostępny w sprzedaży

Warto zauważyć subtelne różnice między modelami z 2 i 4MB cache. Te z mniejszą ilością pamięci nazwano Allendale. Obcięcie (zablokownie) pamięci podręcznej cache L2 spowodowało znaczne skurczenie rdzenia. Co za tym idzie jest on tańszy w produkcji. Funkcjonalnie Allendale i Conroe niczym się nie różnią. Konsekwencją zmniejszenia pojemności cache jest obcięcie szerokości ścieżki dostępu z szesnasto do ośmiodrożnej.

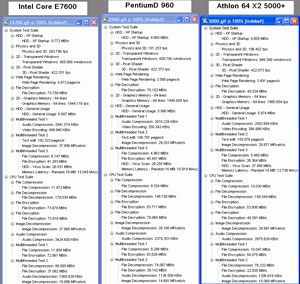

Przyjrzyjmy się jeszcze tabeli sumującej. Zbiorczo umieszczone zostały w niej wszystkie układy z których wywodzi się Conroe oraz dwóch ważnych konkurentów tego układu na rynku, a które to zostały użyte przez nas w dalszych testach.

(kliknij, aby powiększyć)

Platforma testowa

Użyte do testów procesory, to na chwilę obecną niemal najszybsze pośród modeli będących w ofercie producentów. Szybsze już są tylko wersje ekstremalne, czyli Core 2 Extreme X6800, Pentium XE 965 i Athlon 64 FX62. Zobaczymy dzięki temu jak 2,6GHz wyrób Intela ma się w zestawieniu do identycznego zegarowo Athlona 64 X2 i taktowanego o 1GHz wyżej Pentium D 960.

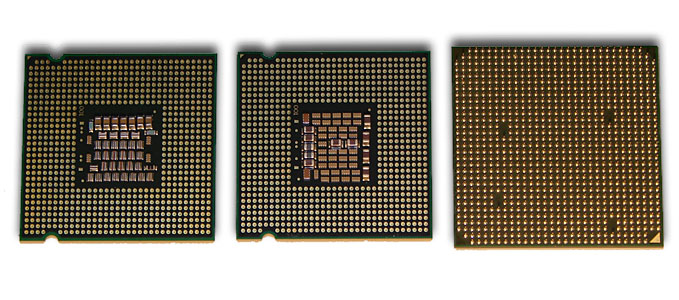

Core 2 Duo E6700 z kolegami. Conroe bliźniaczo podobny do Pentium D. Faktycznie to jednak drastycznie różne układy

Bohaterowie od spodu. Conroe to ten z lewej

Testy - Gry

Gra w wersji 1.2 z dodaną funkcją SMP. Zdecydowana przewaga Conroe w teście średnich detali. W wysokim trybie graficznym brak szczególnych różnic.

Niewielka przewaga Core 2 Duo nad Athlonem i spora, bo 10% strata do najlepszych procesora Pentium D w teście z wysokimi detalami. Minimalny FPS na podobnym poziomie u wszystkich zawodników.

Core 2 Duo ponownie na prowadzeniu, tu jednak nie pełni on decydującej roli i widać ograniczenie nakładane przez kartę graficzną, ponieważ różnice między poszczególnymi procesorami są względnie małe.

Oblivion należy do grupy najcięższych dla sprzętu gier. Widoczna słabość Pentiuma, który daleko w tyle za Conroe. Athlon też sobie nieźle radzi.

Ghost Recon okazuje się niemal niewzruszony i nie za bardzo wykazuje różnicę miedzy różnymi CPU.

Ciekawa rzecz dzieje się z Pentium D. Procesor okazuje się zbyt wolny dla karty graficznej i nawet pomimo obniżenia poziomu detali telepie się gdzieś z tyłu. Pozostali dwaj zawodnicy wystrzelili do przodu, ale Conroe zdecydowanie prowadzi.

Lock On, mimo iż należy do grona najbardziej wymagających aplikacji, opiera się na starym silniku, który większość obliczeń przerzuca na procesor. Doskonale to widać na przykładzie ustawienia w wysokim trybie graficznym, gdzie Conroe radzi sobie znakomicie. We wcześniejszych testach, w rozdzielczości 1280x1024 procesor nie miał wiele “do gadania”. Tu jest inaczej. Nawet poziom minimalnego FPS jest przyjemnie wyższy, niż w przypadku pozostałych procesorów.

Pierwszy z testów syntetycznych. Wysoka wygrana Conroe nie dziwi. Athlon w środku stawki. Pentium D wyraźnie niedomaga, co widać po poziomie różnic dla trybu graficznego ze średnim poziomem detali.

W starym 3D Marku Conroe wręcz masakruje rywali wyprzedzając Athlona, dotychczasowego lidera tego testu o ponad 10000 punktów! Różnica procentowa dla trybu programowego jest jeszcze wyższa, gdzie Conroe odskakuje o 50%!

Nowsze wydanie popularnego benchmarka. W teście podstawowym, z uwagi na ograniczenia karty graficznej różnic dużych nie ma. Wyraźniej robi się dopiero w teście procesora.

Sytuacja jak w przykładzie powyżej. Conroe wyprzedza nieznacznie Athlona, Pentium D kolejny raz pokazuje, że aplikacje 3D nie są jego mocną stroną.

Benchmarki syntetyczne

Czas na testy typowo teoretyczne. Widać ogromną przewagę Conroe w testach jednostki stało i zmiennoprzecinkowej. Z pewnością wpływ na takie zachowanie w pewnym zakresie wykorzystanie przez benchmark instrukcji SSE4, których to nie posiadają procesory Pentium D i Athlon 64 X2. Czyżby dawały one aż takiego kopa wydajnościowego? Na praktyczną odpowiedź musimy poczekać do chwili ukazania się innych programów korzystających z tego rozszerzenia.

Dzięki badaniu aplikacją Cachemem widzimy doskonale, jak krańcowo odmiennie potrafią się zachować procesory korzystające z tego samego typu szyny systemowej czy kontrolera pamięci. Conroe dzięki licznym udoskonaleniom bije swojego kuzyna o imieniu Pentium . Widzimy lepszą wydajność komunikacji z podsystemem pamięci. Może ona co prawda wynikać z wyżej taktowanej szyny systemowej, ale dramatycznie niższe opóźnienia to już zasługa doskonałych mechanizmów zarządzających pamięcią. Warto pokusić się też o porównanie z Athlonem. Ten też według Cachemem oferuje niskie opóźnienia, nieco wyższe niż Conroe, ale znacznie mniej traci na tym polu niż Pentium. Zasługą zintegrowanego kontrolera pamięci są zaś znacznie bardziej zrównoważone operacje zapisu i odczytu.

Cpu-Z to przede wszystkim dokonały program ułatwiający rozpoznanie procesora, ale dodatkowy moduł pozwala także zbadać poziom opóźnień pamięci podręcznej. Widać, że najszybszy w tym względzie jest Athlon. Co prawda dostęp do pamięci podręcznej pierwszego poziomu jest podobnym poziomie co w przypadku Conroe, ale dostęp do cacheL2 odbywa się z mniejszą stratą. Podziw należy się tu bardziej inżynierom Intela. W ich procesorze, wyposażonym w aż 4MB współdzielonego cacheL2 dostęp odbywa się niewiele mniej sprawnie. Widać, że nie na darmo Conroe ma tak rozbudowaną magistralę komunikacyjną. Najszybciej "tykającą" pamięć podręczną ma na pewno Pentium. Pracuje ona z zegarem 3,6GHz, jednak by możliwe stało się osiągnięcie tego zegara, należało mocno wydłużyć czas oczekiwania. Dostęp do pamięci wymaga bowiem aż 30 cykli! To grubo dwukrotnie dłużej niż oferują o 1GHz wolniejsi rywale.

Testy aplikacyjne

PC Mark 2005 szczegóły (kliknij, aby powiększyć)

Aplikacja wyjątkowo polubiła procesory Intela. W teście CPU Score Athlon sromotnie przegrywa w starciu z Pentium D. Conroe z dystansu spogląda na rywali. W testach szczegółowych widać zachowanie procesorów w przypadku jednoczesnego uruchomiania kilku aplikacji jednocześnie.

Aplikacja wyjątkowo przypadła do gustu Athlonowi i co prawda nie wygrywa on sumarycznie z Core 2 Duo, to jednak w przeciwieństwie do wcześniejszych testów nie ustępuje wiele pola rywalowi, w kilku testach wygrywając. Ciekawy jest wynik rywalizacji w teście pamięci. Potwierdza on wyniki z Sandry. Conroe szybciej odwołuje się do pamięci, ale przepływ danych odbywa się wolniej niż w przypadku Athlona z podstawką AM2. Zupełnie słabo wypada Pentium.

SuperPi to aplikacja licząca sobie już niemal tyle lat, ile ma jądro P6. I ten duet czuje się doskonale.

AiBench symuluje zachowanie sztucznej inteligencji. Cóż - korzystać ona powinna z procesora Conroe :)

Standardowy rozkład zawodników w peletonie. Pierwszy Conroe, z tyłu ze sporą stratą Athlon i Pentium zamyka stawkę. Takie zestawienie występuje we wszystkich kategoriach.

Duża przewaga Conroe. Athlon traci do układu Intela niemal 1,5 minuty.

20 sekundowa przewaga Conroe nad Athlonem wydaje się może niewielka, ale jeśli użyjemy skomplikowanej sceny czas ten liniowo może się przedłużyć i sięgnąć poważnych wartości. Widać jak dużo NetBurst traci do przebudowanego P6, którego przecież miał być następcą.

Bez rewolucji – Conroe ciągle w przedzie, choć kilka razy Athlon okazuje się tracić wcale nie tak wiele.

Wracamy do aplikacji, z którymi mamy do czynienia niemal codziennie. Proces kompresji 750MB danych przebiegał sprawniej na komputerze korzystającym z procesora Conroe. Przy dekompresji różnic już brak. Winny jest dysk twardy – to on stanowi tu główną przeszkodę.

7zip mimo iż pracował na tym samym zbiorze danych co WinRAR, to jednak z zadaniem nie radził sobie już tak sprawnie. Niemniej jednak i tak wykazał zdecydowaną przewagę Conroe. Między Pentiumem, a Athlonem nie ma tak drastycznych różnic.

Conroe o 20 sekund przegonił Pentium 4. Athlon jak zwykle poradził sobie lepiej od NetBursta, ale nie dał rady naszemu bohaterowi.

Już mogę zdradzić, że Photoshop to jedyny program, w którym Pentium D przegania Athlona. Jednak jest to raczej subtelna różnica, bo Conroe i tak dużo szybciej sobie poradził z renderingiem. Pentium wolniejszy o 27%.

Kolejna aplikacja graficzna. Z zadania jak zwykle najszybciej wywiązał się Conroe. Athlon traci aż 30%.

Tłumaczenie tekstu wyraźnie nie szło Pentiumowi. 40s strata jest bardzo duża.

Aplikacja zajmująca się rozpoznawaniem teksu zaszytego choćby w plikach graficznych. Rozbudowane mechanizmy mocno obciążają procesory. Przyspieszenie operacji przynosi jednak umiejętność korzystania z dwóch rdzeni.

BitDefender to jeden z wielu programów antywirusowych. Test polegał na skanowaniu folderu z 2GB różnych plików. Najszybciej z zadaniem poradził sobie Core 2 Duo.

Przechodzimy do testów na programach kompresujących materiały audio-wideo. Już na starcie Conroe jest bezkonkurencyjny kończąc zadanie 2 minuty przed drugim w kolejce Athlonem.

Sytuacja podobna. Zdaje się że to bardziej ucieczka Athlon przed Pentium D, niż gonitwa za Conroe.

Tym razem przekonwertujemy 7GB film DVD tak, aby zmieścił się na prawie 5GB płytce DVD-R. Kto jest najszybszy, mówić nie trzeba...

Teraz kompresja z użyciem kodeka H264. Bardzo słabo radzi sobie NetBurst, a przecież projektowano go tak, aby doskonale radził sobie z danymi strumieniowymi.

Na koniec popularny program do konwersji mp3. Wynik : 34% strata Athlona do Core 2 Duo. Pentium wolniejszy o ponad 55%.

Wydajność w środowisku x86-64

Testy w ciągle bardzo popularnym środowisku 32-bitowym mamy już za sobą. Sprawdźmy teraz jak nasi rywale radzą sobie podczas pracy z programami 64-bitowymi. Niestety tych ciągle jest mało i ze względu na brak szerokiego zainteresowania często są niedopracowane. Szczególnie doskwiera brak aplikacji dedykowanych tylko pod nowe środowisko. Przeważnie mamy bowiem styczność z przekompilowanym wersjami 32-bitowych programów. Z dużą dozą prawdopodobieństwa można natomiast powiedzieć, że rynek programów 64-bitowych dopiero rozkwitnie. Motorem do tego stanie się nowy system operacyjny Microsoftu, który od początku jest planowany w dwóch wersjach: 32 i 64-bitowej. Co ważniejsze wersja 64-bit ma posiadać szereg cech nieobecnych w wersji 32-bitowej. Czy tym działaniem Microsoft spowoduje rychłą migrację do nowego środowiska? To się okaże.

Platforma testowa nie uległa zmianom. Różnicą jest tylko zmiana Windowsa XP Prof. SP2 na jego odmianę Professional x64 Edition. Popatrzmy więc jak się mają 32-bity do 64 w wykonaniu naszych bohaterów.

Powyższy program testowy to najnowsza beta POV-Ray'a z możliwością pracy w 64-bitach i wsparciem dla procesorów dwurdzeniowych. Niestety aplikacja nie działała wcale lepiej pod kontrolą ostatniej odmiany Windowsa XP. Minimalnie przyspieszył jedynie Athlon 64. Stracił nieznacznie Pentium. Conroe niemal nie odczuł różnicy, niemniej jednak i tak jest daleko szybszy od rywali.

Cinebench również niezbyt dobrze zareagował na zmianę systemu operacyjnego. Większość podtestów procesory wykonały szybciej w 32-bitach. Jedynie rendering odbywał się sprawniej w 64-bitach. Tu najwięcej zyskał Athlon, prawie 13%, który niemal zbliżył się tym samym wydajnościowo do Conroe pracującego w 32-bitach. Ten zyskał jedynie 5% lepszy wynik. Pentium D uzyskał wynik lepszy o niecałe 8%.

Kolejny przykład aplikacji, która nie zawsze entuzjastycznie podchodzi do środowiska 64-bitowego. Najbardziej widoczny jest spadek w pierwszym teście. Conroe traci aż 690%, Pentium D 580%, Athlon stracił jedynie 290% dzięki czemu wygrał... pyrrusowe zwycięstwo. Dopiero ostatni test daje wzrost wydajności o jakim każdy myśli mając na uwadze 64-bitowe środowisko. Conroe zyskuje dwukrotnie, 50% przyrost notuje Pentium. Za to prawie trzykrotnie przyspiesza Athlon 64 X2 deklasując tym samym rywali, zdecydowanie przeganiając Conroe.

Ten program ponownie lepiej działał na Athlonie. Tylko on minimalnie, ale zyskał na zmianie systemu operacyjnego, choć i to nie pozwoliło mu przegonić procesora Intela. Stracił za to (aż 13 sekund) Pentium D.

Niewielkie przyrosty wydajności serwuje nam 64-bitowa wersja tego darmowego programu kompresującego.

Paint.NET to kolejna, choć niestety jedna z nielicznych aplikacji wykazujących przewagę 64-bitowowych rozszerzeń. Zyskują wszyscy. Core 2 Duo 44%, Pentium D i Athlon po 33%.

Wyraźne wzrosty notują wszystkie procesory. Szczególnie istotny jest on w przypadku Pentium D, który w trybie 32-bitowym nieco kulał. W 64-bitach poziom minimalnego FPS wzrósł znacznie. W 64-bitach najszybciej radził sobie Athlon wyprzedzając Conroe.

Komentarz do testów 32 vs 64-bit.

Garść testów pozostawia pewien niesmak. Spodziewać się można było wzrostów wydajności w każdym przypadku – okazało się być inaczej. Niektóre programy zwalniają, a te które składają się z kilku podtestów potrafią zarówno gwałtownie zahamować, ale niespodziewanie ruszyć z kopyta. Nie ma co jednak płakać. Dobrze skompilowana, dopracowana aplikacja potrafi sporo zyskać.

Różnie też potrafią się zachować procesory. Widać odmienne podejście inżynierów konstrukcji rozwiązań mających zapewnić poprawność pracy w 64-bitowym środowisku. Przeważnie najwięcej zyskuje Athlon 64, nieco mniej Conroe i Pantium D. Co ważne, Conroe mimo że nie jest takim entuzjastą Windowsa XP x64, to jednak i tak w większości przypadków bez trudności konkuruje z Athlonem, niejednokrotnie osiągając przewagę niewiele mniejszą niż ta, jaką obserwujemy w testach 32-bitowych.

Teraz już tylko pozostaje nam czekać na pojawienie się Visty, od której oczekiwać możemy jeszcze wyższej, a przede wszystkim konsekwentnej przewagi wydajnościowej w większej ilości aplikacji zgodnych z rozszerzeniem x86-64.

Procesor vs szyna systemowa

Szereg usprawnień w architekturze pozwoliło znacząco odciążyć szynę FSB platformy Core. A właśnie szyna systemowa była jednym z wąskich gardeł maszyn zbudowanych na dwurdzeniowej architekturze NetBurst. Mimo że szyna AGTL+, a dokładniej sposób komunikacji procesora z pamięcią (poprzez zewnętrzny kontroler pamięci) może uchodzić za przestarzałą w porównaniu do rozwiązania AMD w procesorach K8, to w praktyce może się okazać, że dzięki zdjęciu z jej garbu szeregu czynności jakimi obłożył ją Pentium D może ona jeszcze trochę pożyć i ma się całkiem nieźle.

Wszystkie procesory Core 2 Duo na chwilę obecną korzystają z magistrali taktowanej zegarem 266MHz i potrafiącej przesłać 4 słowa na takt. Według słów panów od marketingu ma ona więc zegar 1066MHz. Do tej pory tak szybka szyna była dedykowana dla procesorów Pentium serii Extreme Edition. Teraz Intel zdjął to sztuczne ograniczenie i każdy z nowych procesorów Core 2 Duo pracuje z tak taktowaną magistralą. To oznacza 33% przyspieszenie w stosunku to powszechnie stosowanej magistrali 200MHz (800MHz QDR) w procesorach Intela od czasów układu Pentium 4 E.

Znamienne jednak jest, że układy mobilne dalej korzystają najwyżej z szyny 166MHz (667MHz QDR). Działanie takie spowodowane jest chęcią ograniczenia ilości pobieranej energii, a w dodatku w typowych dla notebooków zadań taki zegar nie limituje znacząco ogólnej wydajności komputera gdzie topowe procesory przeważnie i tak mają niższe taktowania końcowe w stosunku do maszyn biurkowych, dla których to stosunek zegar procesora: zegar szyny komunikacyjnej musi być wyższy.

Niestety szybka szyna to mniejszy zakres tolerancji dla komponentów płyty głównej. To może być główną przeszkodą utrudniającą jej dalsze przyspieszanie w przyszłości, choć jak się okazuje w praktyce najnowsze konstrukcji płyty główne dedykowane pod procesory C2D potrafią sobie radzić nawet z magistralą taktowaną zegarem 400MHz i więcej!

Mając duszę eksperymentatora postanowiłem jednak sprawdzić jak mocno w praktyce nowy rdzeń jest zależny od szyny systemowej. W tym celu posłużyłem się najszybszą wersja rdzenia Conroe w wersji Extremalnej - X6800. Ma ona odblokowany mnożnik nie tylko w dół (do 6) jak każdy inny procesor tej rodziny, ale także w górę. Dzięki temu odpowiednio ustawiając mnożnik i zegar FSB mogłem zbadać jak mocno zależny od wydajności szyny systemowej jest 2,6GHz Conroe. W tym teście dodatkowo występowała inna karta graficzna – GeForce 7900GTX w następstwie Radeona. Pamięci taktowane były stałym zegarem 800MHz (DDR).

Nie jest niespodzianką, że Conroe pracujący z 333MHz FSB (1333MHz QDR) jest szybszy od standardowo ustawionego układu. Różnice w stosunku do procesora z 266MHz FSB (1066MHz QPB) są jednak raczej marginalne. Co prawda dość znacznie wzrosła wydajność operacji na pamięciach i to ta wykazana przez Sandre jak i Science Marka, ale w praktyce nie przedłożyło się to na osiągi innych aplikacji.

W przeciwną stronę za to działało obniżenie taktowania szyny. Tu strata do referencyjnego zegara jest już widoczna. Należy jednak wziąć poprawkę na dwa fakty. Po pierwszy przy FSB 200MHz i mnożniku 13 procesora końcowo daje tylko 2600MHz, czyli o 66MHz mniej niż dla FSB 266MHz. Drugi fakt stanowi procentowa różnica między FSB oryginalnym, a tym które badamy. Podniesienie zegara szyny systemowej z 200 do 266MHz oznacza możliwość wykonania w ciągu tego samego czasu o 33% więcej operacji. Przyspieszenie z 266 na 333MHz to już tylko 25% szybciej. Skumulowanie tych dwóch okoliczności w jakiejś części tłumaczy różnice w testach.

Pole do przyspieszania FSB jednak jest i trudno oczekiwać, by w najbliższej przyszłości Intel zrezygnował z tej możliwości. Wraz z rosnącym zegarem CPU należy przyspieszyć szynę, aby utrzymać korzystny stosunek taktowań magistrali systemowej do samego procesora. W końcu przyspieszenia wymagać będzie też wprowadzenie czterordzeniowego Kensfielda. Procesora składającego się z dwóch rdzeni Conroe, przy obecności którego szyna FSB ponownie będzie musiała rozwiązać problem spójności cache... Tak samo jak to robił Presler.

Grzanie i podkręcanie

Oparcie projektu nowego flagowego procesora o rdzeń z umiarkowanym apetytem na prąd mogło gwarantować uzyskanie wyjątkowo satysfakcjonujących wyników termicznych. Układy Core 2 Duo stanowią znaczący postęp w stosunku do żarłocznego i nie lubiącego oszczędzać procesora Pentium 4. Poniższe zestawienie prezentuje porównanie rdzenia Allendale/Conroe do historycznych odpowiedników opartych o architekturę NetBurst. Oczywiście jest to rzut bardzo ogólny i zupełnie nie uwzględniający stopnia skomplikowania architektury jak i wskaźnika wydajność na Wat. Przytoczone w tabelce własności termiczne poszczególnych rdzeni należy porównywać z bardzo dużym marginesem błędu. Według specyfikacji Intela wszystkie procesory Core 2 Duo z przedziału 1,86 – 2,66GHz mają tak samo wysokie TDP - 65W. TDP nie jest jednak mocą szczytową pobieraną w krytycznych warunkach. Warto napomnieć, że wartość TDP w ramach samego modelu może się zmieniać np. wraz ze zmianą steppingu rdzenia.

Teraz zobaczmy jak wyglądają oficjalne wskaźniki TDP dla testowanych procesorów. Niestety traktować należy je z pewnym dystansem z uwagi na inne metody pomiaru tych parametrów przez obu producentów mikroprocesorów.

Dodatkowo chciałbym zwrócić uwagę na fakt posiadania przez AMD w swojej ofercie procesorów Athlon 64 X2 do maszyn biurkowych o obniżonym poborze mocy. Testowany przez nas X2 5000+ należał do linii procesorów o standardowym poborze energii, ale są na rynku dostępne układy zadowalające się ledwie 35W.

Powyższe zestawienie jest jednak czysto teoretyczne. Nas interesuje praktyka. Co prawda nie posiadaliśmy narzędzi do pomiaru pobieranej mocy przez sam procesor, więc musieliśmy użyć tradycyjnej metody pomiaru temperatury.

By maksymalnie ujednolicić i uczynić porównywalnymi wyniki, do chłodzenia procesorów użyliśmy jednego i tego samego coolera w postaci radiatora Scythe Ninja SCNJ-1000 z wentylatorem Akasa Amber Quiet 120mm kręcący się z prędkością około 1000 obrotów. Użyta pasta to popularny Arctic Ceramique. Pewien problem stanowiło użycie Ninji w zestawieniu z płytą Socket AM2, ale zastosowana autorska zapinka poradziła sobie z zadaniem wystarczająco dobrze.

Największą trudność sprawiło uczynienie wyników pomiaru termicznego zdjętych z drastycznie różnych platform, ale tak by były kompatybilnymi ze sobą. W grę nie wchodziło odczytanie temperatur podanych przez płyty główne, jako że te podane przez zupełnie inne produkty nie mogły być traktowane jako prawdziwe. W tym celu pomiar był dokonywany ze stopki radiatora przy użyciu pirometru CHY 314. Powinno pozwolić to z pewnym marginesem błędu ukazanie różnic w ilości wydzielanego ciepła przez interesujące nas procesory.

Pomiar dokonywany był w trzech trybach:

-obciążenie - zapewniały dwie próbki program StressPrime obciążające każdy z rdzeni. Wygrzewanie trwało 30 minut i po takim czasie dokonywano pomiaru temperatury

-spoczynek - pomiar wykonany po półgodzinnym czasie bezczynności liczonym od chwili zamknięcia StressPrime.

Oba testy odbywały się przy nominalnym zegarze procesora.

-idle - kolejny pomiar wykonany jednak w trybie oszczędzania energii po uaktywnieniu mechanizmów obniżających taktowanie procesora w przypadku niskiego obciążenia (Cool∓Quiet dla AMD i EIST+C1E dla Intela). W przypadku procesora Athlon 64 X2 5000 + zegar miał wartość 1,0GHz, a napięcie 1,1V. Pentium D redukował zegar do 2,4GHz i 1,12V, Core 2 Duo 1,6GHz i 1,11V.

Nie jest niespodzianką dobry wynik 2,66GHz procesora Intela. Nie na darmo poszedł cały wysiłek zmierzający do obniżenia konsumpcji energetycznej. W dodatku, nie dość że Core 2 Duo nokautuje swojego poprzednika – Pentium D w kwestii wydajności, to jeszcze jest znacznie mniej łakomy na prąd. Nie zanotowano natomiast poważniejszych różnic w odniesieniu do konkurencyjnego procesora AMD. Radiator w czasie pełnego obciążenia nie był wcale wiele cieplejszy przy zestawieniu go z Conroe, a w czasie spoczynku różnica była wręcz marginalna.

Oczywiście nie należy tych pomiarów brać bardzo serio. Dużo bardziej reprezentatywne by było porównanie różnic w poborze mocy przez oba procesory, lub też zdanie się na raport wbudowanych w rdzeń układów monitorujących temperaturę, ale ograniczenia sprzętowe utrudniły wykonanie obiektywnego badania.

Podkręcanie

Już wykonany w 65nm procesie technologicznym poprzednik Conroe - Yonah miał sporo ukrytych megaherców. Jego potencjał bez większych trudności umożliwia osiągnięcie zegara okolic 3GHz. Tylko ze względu na specyfikę maszyn przenośnych nie spotykamy seryjnych procesorów taktowanych szybciej niż 2,3GHz, a więc poczynione przez Intela kroki mające umożliwić Conroe osiąganie jeszcze wyższych zegarów nie mogły być bezowocne. Najszybszy na chwilę obecną procesor tej rodziny osiąga taktowanie 2,93GHz. Można śmiało więc przypuszczać, że przekroczenie 3,5GHz nie powinno czynić wielkich problemów dla większości procesorów Core 2 Duo.

Tak jest w praktyce. Badany przez nas procesor chłodzony wspomnianym wyżej coolerem, bez podnoszenia napięcia zasilającego (1,25V) pracował poprawnie z zegarem 3,10GHz. Podniesienie napięcia do 1,35V dało 250MHz więcej. Przy napięciu 1,45V można było osiągnąć stabilne 3,66GHz. Wyniki co najmniej przyzwoite :) Przesiadka na zestaw WC z blokiem wodnym X2P pozwoliła osiągnąć zegar o 40MHz wyższy.

Niestety podkręcanie Conroe nie jest aż tak proste, jak by się mogło wydawać. Głównym ograniczeniem jest wysoka, oryginalna szyna systemowa i niski mnożnik procesorów. Bardzo łatwo policzyć, że najtańszy model E6300 potrzebuje FSB aż 400MHz dla osiągnięcia zegara 2,8GHz. Ale to nie jest aż tak bardzo już dziś problematyczne. Jak pokazują wyniki podkręcania najnowszych płyt głównych opartych o chipset serii 975X, dobicie do 400MHz nie jest trudne. Z kolei najnowszy chipset i965 potrafi osiągnąć kosmiczną jeszcze kilka miesięcy temu wartość 500MHz. Niestety płyty zbudowane nawet na „masowym” chipsecie i965 nie należą jeszcze nawet do średniej półki cenowej, a ich cena często znacznie przekracza 600zł. Są oczywiście tańsze modele oparte o alternatywne chipsety ATI, nVidia, VIA, czy też starsze układy Intela jak choćby i945, ale nie potrafią one tyle, co modele z układem 975, a tym bardziej 965. Ale jest jeszcze jedno ograniczenie w podkręcaniu Core 2 Duo... Słona cena wyczynowych modeli pamięci potrafiących osiągać odpowiednio wysokie zegary. W końcu ponad 400MHz FSB trzeba czymś nakarmić i to najlepiej nie mniej niż w stosunku 1:1. A skoro o tym mowa...

Co na to RAM ?

Cel badania jest jasny – sprawdzić wpływ wydajności różnie taktowanych pamięci na wydajność procesora. Czy Conroe tak samo lubi wysoko taktowane pamięci jak Pentium D? Sprawdźmy. Procesor taktowany domyślnie na 2,66GHz. Manipulowałem jedynie ustawieniami pamięci.

Skoro o nich mowa. Użyte w teście pamięci to znany i opisywany już na łamach serwisu 2GB komplet marki Patriot, model PC2-8000 XBL.

O ile w powyższych testach pracowały one z zegarem 800MHz i nominalnymi dla tej częstotliwości timingami 3-3-4-8, to tym razem posłużyły one za królika doświadczalnego i ustawiane one były zgodnie z danymi zamieszczonymi w poniższej tabeli.

Patrząc zbiorczo na wyniki testów widzimy dwa zachowania komputera. Są aplikacje, które żywo reagują na taktowanie pamięci i wykazują całkiem duży przyrost mocy. Przykładowo pomiędzy najwolniej, a najostrzej ustawionymi pamięciami w teście WinRara widzimy aż 11% różnicę w końcowym wyniku rzeczywistego czasu kompresji. Warto sobie tą różnicę uzmysłowić, bo zmiana samych ustawień pamięci mniej więcej odpowiada przypadkowi zestawienia procesora taktowanego zegarem 2,7GHz i 3GHz.

Ale nie zawsze jest tak dobrze. Spora część aplikacji reaguje raczej niemrawo na zmianę ustawień pamięci. Przykładów mamy sporo, a najbardziej drastycznym jest TMPGEnc służący do konwersji materiałów wideo. Nie reaguje wcale na zmianę timingów. Także testy 3D nie wykazały poważniejszych różnic.

Ogólnie jednak można przyjąć założenie, że lepiej mieć pamięci taktowane nieco wyższym zgarem i mające średniej długości timingi niż obsadzać Conroe pamięciami z krótkimi timingami, ale niskim zegarem. Najbardziej pożądane było by oczywiście użycie modułów zdolnych pracować z zegarem w okolicach 1GHz (DDR). W wszystkich testach właśnie one okazały się bezkonkurencyjne mimo raczej długich timingów. Tu wysoki zegar zapewnia nie tylko wysoki transfer do/z modułów, ale także gwarantuje utrzymanie niskich timingów względnych. Dzięki wysokiemu zegarowi w tej samej jednostce czasu pamięci mogą wykonać znacznie więcej wywołań, niż pamięci o krótkich timingach, ale również niskim zegarze. Widać to doskonale w teście pamięci ScienceMarka, kiedy to moduły ustawione na 800MHz (DDR) 4-4-4 i 1066MHz (DDR) 5-5-5 oferowały najwyższy transfer i niską latencję.

Podsumowując - biorąc pod uwagę dostępne na rynku moduły pamięci i ich ceny, najbardziej korzystne wydaje się dobranie modułów zdolnych pracować z zegarem 800MHz i timingami 4-4-4. Oczywiście im będą one potrafiły osiągnąć wyższy zegar przy relatywnie krótkich timingach, tym lepiej. Pamięci warto bowiem wybierać w taki sposób, by nie stały się one hamulcem przy podkręcaniu procesora i potrafiły pracować synchronicznie z FSB procesora. Pamiętajmy bowiem, że Conroe ma niski mnożnik i wysoką magistralę. Słowa te są szczególnie ważne dla tych, którzy podkręcają model E6300 dla którego osiągnięcie zegara 2,8GHz przy FSB 400MHz nie jest niczym szczególnym, ale to wymaga posiadania pomięci co najmniej zdolnych pracować z zegarem 800MHz (DDR).

Płyta Asus P5W HD Deluxe

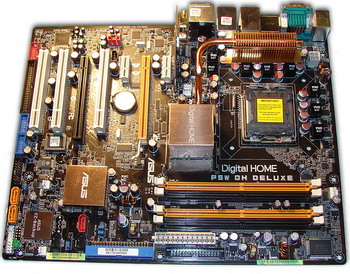

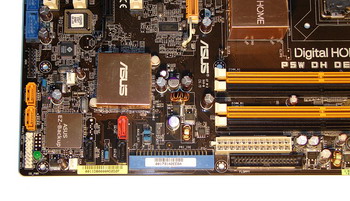

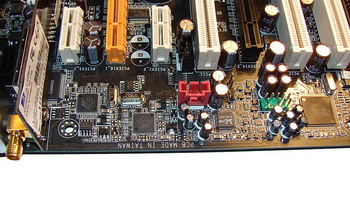

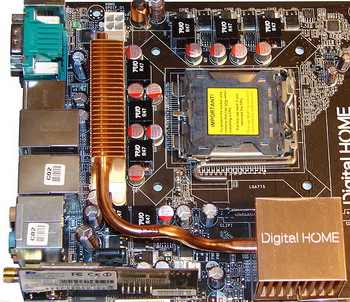

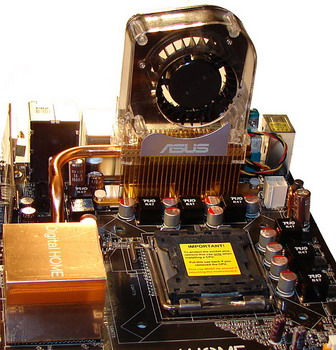

Wyrób Asusa stanowił drugą po Intelu D975XBX szerzej dostępną płytę główną obsługującą procesory rodziny Core 2 Duo. Zbudowany na duecie układów i975X jako mostek północny i południowy ICH7R produkt wspiera wszystkie procesory Intela na podstawkę LGA775, w tym także te pracujące z FSB 133MHz (533MHz QDR) jak Celeron D czy Pentium D 805, czego oficjalnie i975X nie umie.

Obecnie dostępny model jest sukcesorem wcześniejszych wyrobów zbudowanych na układach i955X (rodzina P5WD2) i i975X (model P5WD2-E), które ze względu na niezgodność ze schematem zasilania VRM11 nie oferują obsługi rdzenia Conroe.

Interesujący nas model, jako że zbudowany na topowym chipie Intela obsługuje systemy zbudowane z wielu procesorów graficznych. Na chwilę obecną oficjalne wsparcie oferuje jednak tylko dla technologii ATI CrossFire. Płyta wyposażona jest w dwa gniazda elektrycznie zgodne ze standardem PCIe 16x. W przypadku obsadzenia slotów jedną kartą mamy do czynienia z portem o pełnej wydajności (PCIe 16x). Dla konfiguracji składających się z wielu GPU, każde z gniazd działa w trybie PCIe 8x. Oprócz tego są też krótkie porty PCIe 1x dla mniej wymagających urządzeń jak np. tunery TV, oraz stare sloty PCI. Mostek północny oficjalnie wspiera pamięci DDR w standardach DDR2-533/667. W praktyce jak już się przekonaliśmy we wcześniejszych testach, nie ma problemów z użyciem szybszych modułów, aż do DDR2-1066 włącznie. Maksymalna pojemność możliwych do obsadzenia modułów to 4 x 2GB w tym także układów ECC.

Mostek południowy ICH7R zapewnia obsługę 1 złącza PATA i 4 SATA o przepustowości 3Gb/s z możliwością tworzenia macierzy RAID 0, 1, 5.

Asus P5W HD Deluxe w całej okazałości (kliknij, aby powiększyć)

Płyta bazuje na ciemno-brązowym PCB, na którym umieszczono szereg kolorowych gniazd. Wszystko przedstawia się dosyć estetycznie, a zarazem płyta nie jest pstrokata.

Ogólny układ złącz płyty Asusa przedstawia się następująco: 2 wspomniane już porty PCI Express 16x, 2 sloty PCIe 1x i 3 tradycyjne gniazda PCI. Pamięć DDR2 wkładamy w 4 banki dla 240-pinowych modułów RAM.

Przyjrzyjmy się teraz obsłudze różnego rodzaju urządzeń. Płyta zapewnia wsparcie dla 1 kanału ATA100 i 3 SATA 3Gb/s z funkcjami RAID przez mostek południowy ICH7R. Ten ostatni odpowiada też za wsparcie dla standardu USB2.0 w postaci 8 portów (z czego 4 na panelu tylnym płyty). Oprócz tego mamy całą masę innych dóbr:

- Kontroler TI 1394 ze wsparciem dla 2 portów standardu IEEE1394a FireWire.

- 1 port ATA133 dla napędów PATA133 i dodatkowe 2 kanały SATA 3Gb/s z RAIDem 0 i 1 dzięki obecności chipu JMicron JMB363.

- 2 kolejne porty SATA 3Gb/s są obsługiwane przez układ Silicon Image SiI 4723 Steel Vinez z opcją tworzenia macierzy RAID 0, 1 i JBOD.

- 2 gigabitowe kontrolery sieciowe Marvell 88E8053-1 na tylnym panelu płyty