Nowa Generacja - II odsłona: MSI GeForce 6800 Ultra

Autor: Kris | Data: 22/06/04

|

Po długim czasie oczekiwania, nadszedł doniosły moment prezentacji praktycznych możliwości najsilniejszej karty nVidia, należącej do nowej generacji. GeForce 6800 Ultra jest 16-potokowym monstrum, pretendującym do korony wydajności kart graficznych. Wprawdzie, chwilowo nie ma dostępu do jego głównego konkurenta, w postaci RX800XT PE, ale recenzja ma charakter otwarty i w kolejnych odsłonach przyjdzie czas na bezpośrednie starcie. Na razie, honoru ATI bronić będzie 12-potokowy RX800Pro, któremu przy okazji testów GF6800U zapewniłem dodatkowego, wirtualnego konkurenta, który być może niedługo pojawi się w zbliżonej cenie. Chodzi oczywiście o GF6800GT (16-potoków, niższe taktowanie), który (jeśli spełnią się prognozy cenowe) zapowiada się znakomicie. Pierwszoplanową postacią drugiej odsłony recenzji zatytułowanej "Nowa Generacja" będzie karta MSI GeForce 6800 Ultra, udostępniona przez MSI-Polska, na wręcz sprinterski odcinek czasu. Tym nie mniej, w miarę swoich ograniczonych możliwości, postarałem się wycisnąć z niej jak najwięcej informacji, czego efektem jest dzisiejszy, spory "update" artykułu. Oprócz wprowadzenia nowej karty (w postaci opisu oraz wyników testów) chciałbym zwrócić również uwagę na pojawienie się pierwszego rozdziału omawiającego jakość obrazu. Tym razem spróbuję przybliżyć kwestię antyaliasingu. Po długim czasie oczekiwania, nadszedł doniosły moment prezentacji praktycznych możliwości najsilniejszej karty nVidia, należącej do nowej generacji. GeForce 6800 Ultra jest 16-potokowym monstrum, pretendującym do korony wydajności kart graficznych. Wprawdzie, chwilowo nie ma dostępu do jego głównego konkurenta, w postaci RX800XT PE, ale recenzja ma charakter otwarty i w kolejnych odsłonach przyjdzie czas na bezpośrednie starcie. Na razie, honoru ATI bronić będzie 12-potokowy RX800Pro, któremu przy okazji testów GF6800U zapewniłem dodatkowego, wirtualnego konkurenta, który być może niedługo pojawi się w zbliżonej cenie. Chodzi oczywiście o GF6800GT (16-potoków, niższe taktowanie), który (jeśli spełnią się prognozy cenowe) zapowiada się znakomicie. Pierwszoplanową postacią drugiej odsłony recenzji zatytułowanej "Nowa Generacja" będzie karta MSI GeForce 6800 Ultra, udostępniona przez MSI-Polska, na wręcz sprinterski odcinek czasu. Tym nie mniej, w miarę swoich ograniczonych możliwości, postarałem się wycisnąć z niej jak najwięcej informacji, czego efektem jest dzisiejszy, spory "update" artykułu. Oprócz wprowadzenia nowej karty (w postaci opisu oraz wyników testów) chciałbym zwrócić również uwagę na pojawienie się pierwszego rozdziału omawiającego jakość obrazu. Tym razem spróbuję przybliżyć kwestię antyaliasingu.

Aby nie zmuszać czytelnika, który już wcześniej zapoznał się z pierwszą odsłoną recenzji, do poszukiwania wprowadzonych zmian, już w zapowiedzi podaję pełną listę poprawek:Zgodnie z przyjętą konwencją, w kolejnych odsłonach, do minimum ograniczam zakres własnych komentarzy o charakterze globalnym. Jak na razie, wnioski końcowe (bez przetestowania pełnego asortymentu nowych kart, mogą mieć charakter jedynie cząstkowy) pozostawiam w rękach czytelnika. O tym, co sądzę (to tylko przykład) na temat faktycznej przydatności nowych funkcji układów NV40, czy realnym wykorzystaniu mocy kart nowej generacji oraz wskazanie własnych preferencji w danych kategoriach cenowych, pozostawię na chwilę ukończenia całej recenzji. Tym bardziej, że w chwili obecnej zarówno brakuje kompletu danych jak i ceny (czy ich sugestie) są wciąż niestabilne. Zapraszam do lektury. | |

|

Wstęp

Czym jest nowa generacja kart graficznych? Kolejną pierwszą cyfrą liczby kodowej serii układów? Znaczącym zwiększeniem wydajności w dziedzinie przetwarzania 3D w czasie rzeczywistym? Serią nowych technologii, wprowadzających rozszerzony zestaw efektów, tworzących wirtualny obraz? Wsparciem kolejnej wersji DirectX'a? A może wszystkim po trochu? Oczywiście to producenci lansują odpowiednie hasła marketingowe, a recenzenci oraz użytkownicy próbują je zweryfikować w aktualnych grach, czy kusić się o prognozę ich działania w przyszłych silnikach 3D. W tym roku producenci postanowili dać nam układy, które mają stworzyć karty graficzne, umożliwiające osiągnięcie nowej klasy jakości obrazu w grach.

Cyfrą przewodnią nowej generacji jest "4". Linię produktów rozpoczynają układy ATI R420 oraz nVidia NV40. Proponuję małe spojrzenie wstecz. Pierwszym przedstawicielem "trójek" był ATI R300 (Radeon 9700 Pro), mający swoją premierę w lipcu 2002 roku, czyli prawie dwa lata temu. W styczniu 2003 dołączył do niego układ nVidia NV30 (GeForceFX 5800 Ultra). W czasie panowania "trójek" wyszły układy ATI R350 (Radeon 9800 Pro) i R360 (Radeon 9800 XT) oraz nVidia NV35 (GeForce 5900 Ultra) i NV38 (GeForce 5950 Ultra). Oczywiście ograniczam się jedynie do topowych modeli, opartych na pełnej wersji architektury. Ostatnie premiery, zgodnie z niewielkim skokiem numeracji, faktycznie były już tylko drobnym szlifem swoich poprzedników i w zasadzie dalszy rozwój tej linii nie byłby mile widziany przez klientów. Po dwóch latach nadszedł czas na wprowadzenie faktycznych nowości. Pewną różnicą jest fakt, że tym razem, wraz z premierą układów graficznych nie zmienia się cyferka DirectX'a. Microsoft zamierza jedynie wprowadzić rozszerzoną o nowe efekty wersję, której wyróżnikiem będzie dodatkowa literka.

Modeliki: nVidia (Nalu) i ATI (Ruby)

14-stego kwietnia 2004 ujrzała światło dzienne karta nVidia GeForce 6800 Ultra, a niecałe trzy tygodnie później ATI Radeon X800 XT Platinium Edition. Oprócz najmocniejszych kart zaanonsowano nieco słabsze wersje GF 6800 oraz R X800 Pro. Z nieoficjalnych przecieków można się również dowiedzieć o przygotowaniu kart GF 6800GT oraz R X800 XT. Pewnym dodatkowym zamieszaniem była próba wprowadzenia przez nVidia karty GF 6800 Ultra Extreme, której chyba jedynym celem było osłabienie efektu premiery nowych kart ATI. Pojawiła się w recenzjach w postaci przetaktowanej Ultry niemal w dniu prezentacji X800 i niedługo potem została oficjalnie wycofana, z uwagi na brak możliwości osiągnięcia zamierzonej częstotliwości pracy przez większą ilość próbek układu NV40. Wygląda na to, że w segmencie "wydajnościowym" będzie to walka trzech kart, choć w dużej mierze będzie to zależało od stosunku ceny do możliwości tych produktów.

W docelowej formie, niniejsze opracowanie zawierać ma porównanie i dokładny opis wszystkich sześciu modeli kart, choć w tej chwili nie mogę wykluczyć tego, że którejś z nich zabraknie. Wszystko zależy od tego co, w najbliższym czasie, faktycznie pojawi się w sklepach.

Teoria (technologia, pamięć, wierzchołki)

Tym razem, w zasadzie po raz pierwszy, postanowiłem odejść od unikania opisów tego, co dzieje się wewnątrz układu. Nadal stoję na stanowisku, że najważniejsze jest to, co układ wypracowuje swoim działaniem, a nie to, jak on działa. Prawdą jest jednak również to, że aktualne karty graficzne wyprzedziły technologicznie, możliwości obecnych silników gier, co powoduje, że na decyzję o zakupie, może również wpływać, przynajmniej częściowo, próba projekcji ich zachowania w najbliższej przyszłości. Niestety, aby choć spróbować to zrobić, trzeba się "wgryźć" w ich architekturę wewnętrzną i spróbować odrobiny działań prognozowych. Z natury, są one przynajmniej częściowo, oparte na czymś, co mogę nazwać: "wróżenie z niewielkiej ilości fusów". Warto o tym pamiętać.

Wprawdzie najważniejszy jest dla mnie potok pikseli, ale i o innych blokach funkcjonalnych rdzenia, postaram się również napisać parę słów. Mogę natomiast obiecać, że spróbuję (niekoniecznie się to uda) to przedstawić w jak najbardziej "strawnej" formie, zdając sobie sprawę z tego, że i tak zainteresuje to tylko niektórych.

a) Technologia wytwarzania

Na NV40 składa się gigantyczna liczba 220 mln tranzystorów. Jego poprzednik (NV38) miał ich "tylko" 125 mln. Możemy odnotować przyrost 75%. Nowy układ produkowany jest w fabryce IBM'a, w procesie technologicznym 0.13um. Takim samym jak i poprzednik. Na NV40 składa się gigantyczna liczba 220 mln tranzystorów. Jego poprzednik (NV38) miał ich "tylko" 125 mln. Możemy odnotować przyrost 75%. Nowy układ produkowany jest w fabryce IBM'a, w procesie technologicznym 0.13um. Takim samym jak i poprzednik. |

R420 zawiera 160 mln tranzystorów. W stosunku do R360, składającego się z 110 mln, nastąpił wzrost o 45%. Jednak w przypadku ATI nastąpiła jednocześnie zmiana procesu technologicznego z 0.15 na 0.13um. Dodatkowo, układ produkowany jest przez fabrykę TSMC, z wykorzystaniem materiału o obniżonej stałej dielektrycznej (low-k). Dzięki temu można osiągnąć wyższe taktowanie przy jednoczesnym zmniejszeniu ilości oddawanego ciepła. R420 zawiera 160 mln tranzystorów. W stosunku do R360, składającego się z 110 mln, nastąpił wzrost o 45%. Jednak w przypadku ATI nastąpiła jednocześnie zmiana procesu technologicznego z 0.15 na 0.13um. Dodatkowo, układ produkowany jest przez fabrykę TSMC, z wykorzystaniem materiału o obniżonej stałej dielektrycznej (low-k). Dzięki temu można osiągnąć wyższe taktowanie przy jednoczesnym zmniejszeniu ilości oddawanego ciepła. |

Jako, że niewiele rzeczy w "przyrodzie" daje przychód bez kosztów, to i technologia wykorzystywana przez ATI też oczywiście ma swoje wady. Po pierwsze, ma mniejsze upakowanie tranzystorów (mniej układów da się wykroić z "plastra" krzemu), a po drugie jest droższa. W związku z tym koszt ponoszony przez obie firmy jest prawdopodobnie zbliżony, pomimo niemal 40-sto procentowej różnicy w ilości tranzystorów rdzenia. Natomiast duże zainteresowanie Radeonami ze strony producentów kart wskazuje wyraźnie, gdzie leży źródło zysku (ew. z możliwością zamiany na obniżkę ceny). Tańsza jest produkcja kart (kwestia chłodzenia, laminat, układy stabilizujące itd.). W zasadzie to właśnie dodatkowe aspekty technologii wytwarzania stanowią jeden z dwóch, potencjalnie najmocniejszych punktów nowych Radeonów. Z drugiej strony, różnica w ilości tranzystorów wyraźnie wskazuje na możliwość wystąpienia sporych rozbieżności w funkcjonalności układów. Oczywiście z korzyścią dla nVidia.

b) Kontroler pamięci

Oba układy cechuje podobny kontroler pamięci składający się z czterech, krzyżowo połączonych 64-bitowych bloków (kanałów) obsługujących poprzez 256-bitową magistralę do 512MB pamięci DDR, DDR2 lub GDDR3. W zasadzie wielkich zmian technologicznych w stosunku do poprzedników trudno się doszukać. Główna różnica to kwestia obsługi GDDR3 i ewentualna, dodatkowa optymalizacja ich działania. Oba układy cechuje podobny kontroler pamięci składający się z czterech, krzyżowo połączonych 64-bitowych bloków (kanałów) obsługujących poprzez 256-bitową magistralę do 512MB pamięci DDR, DDR2 lub GDDR3. W zasadzie wielkich zmian technologicznych w stosunku do poprzedników trudno się doszukać. Główna różnica to kwestia obsługi GDDR3 i ewentualna, dodatkowa optymalizacja ich działania. |

Pamięci GDDR3, dzięki zintegrowanym obwodom zapobiegającym degradacji sygnałów oraz dzięki mniejszemu napięciu zasilania (z 2.5 na 1.8V), mogą działać ze znacznie wyższym taktowaniem, mniej się grzeją (w stosunku do taktowania) i upraszczają konstrukcję płytki. Kosztem (zawsze musi być jakieś "ale") są znacznie większe opóźnienia odczytu CAS (nieco mniejsza wydajność przy tym samym taktowaniu) oraz oczywiście cena. Jako ciekawostkę dodam tylko, że specyfikacja GDDR3 została zaprezentowana (jako otwarty standard) w październiku 2002 roku, przez firmę ATI Technologies Inc.

c) Przetwarzanie wierzchołków

W NV40, w stosunku do poprzednika, dwukrotnie zwiększono ilość procesorów do przetwarzania wierzchołków. Z trzech do sześciu. Dodatkowo nastąpiły zmiany w samych procesorach. Dwie najistotniejsze to: zwiększenie z 13 do 32 ilości rejestrów tymczasowych oraz dodanie do każdego procesora jednostki operującej na teksturach (TMU). Przypomnę, że dynamiczna i statyczna kontrola przebiegu była już zaimplementowana w NV38 (wersja silnika 2.a), więc właśnie możliwość odwołania do tekstur, pozwala na przypisanie silnikowi wierzchołków NV40 wersji 3.0. Kod shadera może być w zasadzie dowolnej długości (specyfikacja 2.x ma ograniczenie maksymalnej ilości do 256-ciu instrukcji). W NV40, w stosunku do poprzednika, dwukrotnie zwiększono ilość procesorów do przetwarzania wierzchołków. Z trzech do sześciu. Dodatkowo nastąpiły zmiany w samych procesorach. Dwie najistotniejsze to: zwiększenie z 13 do 32 ilości rejestrów tymczasowych oraz dodanie do każdego procesora jednostki operującej na teksturach (TMU). Przypomnę, że dynamiczna i statyczna kontrola przebiegu była już zaimplementowana w NV38 (wersja silnika 2.a), więc właśnie możliwość odwołania do tekstur, pozwala na przypisanie silnikowi wierzchołków NV40 wersji 3.0. Kod shadera może być w zasadzie dowolnej długości (specyfikacja 2.x ma ograniczenie maksymalnej ilości do 256-ciu instrukcji). |

Silnik przetwarzania wierzchołków R420 oparty jest na specyfikacji 2.0 (w odróżnieniu od 2.a z NV38 brak jest, na przykład, dynamicznej kontroli przebiegu). Tej samej co poprzednika. Może więc wykonywać shader opisany 256-instrukcjami. ATI zwiększyło i nieznacznie przebudowało (pojawiły się instrukcje trygonometryczne) ilość procesorów. Z czterech do sześciu. W związku z tym, że wraz z ilością (i częściowo wydajnością pojedynczego procesora) znacząco wzrosło również taktowanie samego rdzenia to również i w przypadku nowego Radeona można liczyć się z niemal dwukrotnym przyrostem mocy przetwarzania wierzchołków. Silnik przetwarzania wierzchołków R420 oparty jest na specyfikacji 2.0 (w odróżnieniu od 2.a z NV38 brak jest, na przykład, dynamicznej kontroli przebiegu). Tej samej co poprzednika. Może więc wykonywać shader opisany 256-instrukcjami. ATI zwiększyło i nieznacznie przebudowało (pojawiły się instrukcje trygonometryczne) ilość procesorów. Z czterech do sześciu. W związku z tym, że wraz z ilością (i częściowo wydajnością pojedynczego procesora) znacząco wzrosło również taktowanie samego rdzenia to również i w przypadku nowego Radeona można liczyć się z niemal dwukrotnym przyrostem mocy przetwarzania wierzchołków. |

Całkowitą nowością w NV40 jest obecność TMU w strumieniu wierzchołków. Jako, że jest to element, za pomocą którego układ jest w stanie stworzyć jedyny efekt (mapowanie przemieszczeń), który nie jest dostępny dla kart z obsługą SM2.0 (model shaderów 2.0), to zainteresował mnie najbardziej. Niestety wszystko wskazuje na to, że praktyczne jego wykorzystanie w grach szybko nie nastąpi. Tym niemniej, dzięki niemu, programiści dostali już dziś do ręki funkcje, które niewątpliwie zdominują kiedyś gry, a dla nVidia jest to element niezbędny w celu uzyskania specyfikacji shaderów w wersji 3.0.

Przyglądając się nowej jednostce operującej na teksturach nietrudno zauważyć, że projektanci uprościli do maksimum konstrukcję, w celu minimalizacji jej wielkości, a tym samym powodując zapewnienie jedynie podstawowej funkcjonalności. Efekty realizowane za jej pomocą będą dla układu bardzo kosztowne. Wystarczy sobie uświadomić, że samo mapowanie przemieszczeń (displacement mapping) bez zaawansowanego filtrowania (point sampling) realizowane jest za pomocą dwóch taktów zegara. Każdy dodatkowy efekt filtrowania wymaga kolejnych obliczeń Vertex Shadera. Prawdopodobnie dopiero pojawienie się w przyszłych układach, w potoku wierzchołków, TMU z możliwościami zbliżonymi do tych, które od dawna stosowane są w potokach pikseli (przynajmniej sprzętowe filtrowanie), da nam praktyczną korzyść w grach. Z drugiej strony, dzięki temu, że pojawiła się karta SM3.0 ruszył zegar odmierzający czas do nadejścia nowych silników gier, o zupełnie nowych możliwościach, a nVidia uzyskała w ten sposób wyraźną przewagę nad konkurencją w specyfikacji produktów.

Teoria (piksele)

Przetwarzanie pikseli

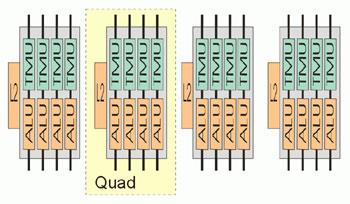

NV40 jest w stanie przetwarzać jednocześnie 16 pikseli (architektura szesnastopotokowa) lub 32 wartości "Z" (współrzędne bez parametru koloru), czyli 4x więcej niż jego poprzednik. Cztery potoki tworzą jeden blok funkcjonalny (tzw. Quad) ze wspólną pamięcią podręczną tekstur (L2). Każdy potok zawiera procesor pikseli składający się z dwóch jednostek arytmetyczno-logicznych (ALU) realizujących program shadera i odpowiadających za teksturowanie. Taki sam schemat znajdziemy również w poprzednich układach nVidia, ale możliwości wykonywania operacji na ALU są różne. W NV30 i NV35 jeden ALU był dedykowany do wykonywania operacji odwołania do tekstur (TMU), natomiast drugi przetwarzał instrukcje matematyczne (NV30 wykonywał jedną a NV35 dwie takie instrukcje w takcie zegara). NV40 natomiast, przy braku operacji związanych z teksturami może wykorzystać również i drugi ALU do obliczeń arytmetycznych. Zwiększeniu uległa również ilość rejestrów. Stałych, z 32 do 224, a tymczasowych, z 22 do 32. Oprócz zmian o charakterze wydajnościowym mamy również pokaźną listę nowych funkcji. TMU zyskał precyzją zmiennoprzecinkową FP16 (filtrowanie tekstur), wprowadzono możliwość obsługi wielu obszarów renderowania (Multiple Render Targets) oraz dynamiczną i statyczną kontrolę przebiegu. Dzięki temu silnik pikseli NV40 uzyskał zgodność ze specyfikacją 3.0, a ilość instrukcji pojedynczego shadera może być nieograniczona (NV3.x wspierały wersję 2.a z limitem 512 instrukcji). 32-bitowa precyzja obliczeń została odziedziczona po poprzednikach. NV40 jest w stanie przetwarzać jednocześnie 16 pikseli (architektura szesnastopotokowa) lub 32 wartości "Z" (współrzędne bez parametru koloru), czyli 4x więcej niż jego poprzednik. Cztery potoki tworzą jeden blok funkcjonalny (tzw. Quad) ze wspólną pamięcią podręczną tekstur (L2). Każdy potok zawiera procesor pikseli składający się z dwóch jednostek arytmetyczno-logicznych (ALU) realizujących program shadera i odpowiadających za teksturowanie. Taki sam schemat znajdziemy również w poprzednich układach nVidia, ale możliwości wykonywania operacji na ALU są różne. W NV30 i NV35 jeden ALU był dedykowany do wykonywania operacji odwołania do tekstur (TMU), natomiast drugi przetwarzał instrukcje matematyczne (NV30 wykonywał jedną a NV35 dwie takie instrukcje w takcie zegara). NV40 natomiast, przy braku operacji związanych z teksturami może wykorzystać również i drugi ALU do obliczeń arytmetycznych. Zwiększeniu uległa również ilość rejestrów. Stałych, z 32 do 224, a tymczasowych, z 22 do 32. Oprócz zmian o charakterze wydajnościowym mamy również pokaźną listę nowych funkcji. TMU zyskał precyzją zmiennoprzecinkową FP16 (filtrowanie tekstur), wprowadzono możliwość obsługi wielu obszarów renderowania (Multiple Render Targets) oraz dynamiczną i statyczną kontrolę przebiegu. Dzięki temu silnik pikseli NV40 uzyskał zgodność ze specyfikacją 3.0, a ilość instrukcji pojedynczego shadera może być nieograniczona (NV3.x wspierały wersję 2.a z limitem 512 instrukcji). 32-bitowa precyzja obliczeń została odziedziczona po poprzednikach. |

R420 przetwarza jednocześnie 16 pikseli (lub wartości "Z"), czyli 2x więcej niż jego poprzednik. Zwiększono również ilość rejestrów tymczasowych, z 12 do 32 i wprowadzono statyczną kontrolę przebiegu programu shadera. Silnik pikseli jest zgodny z wersją 2.b. R3xx mógł wykonywać program shadera składający się z 32 operacji na teksturach oraz 64 instrukcji matematycznych (silnik w wersji 2.0). R420 jest w stanie przetworzyć po 512 instrukcji każdego typu, co łącznie daje 1024, ale specyfikacja DirectX dla PS wersji 2.b nie pozwala na przekroczenie łącznej ilości 512 operacji na shader. Podobnie jak w NV40 cztery potoki powiązane są w jeden Quad. Do zwiększenia efektywności przetwarzania dłuższych programów służy F-Bufor, który w przypadku R420 uzyskał możliwość dynamicznej zmiany swojej wielkości. Obsługa wielu obszarów renderowania oraz zmiennoprzecinkowe filtrowanie przez TMU było już dostępne we wcześniejszych układach. Nie zmieniła się również 24-bitowa precyzja obliczeń oraz układ trzech ALU (z których jeden odpowiada za operacje na teksturach), umożliwiający przetworzenie do pięciu instrukcji w pojedynczym takcie zegara. Wprowadzono również możliwość sprzętowej dekompresji tekstur spakowanych w nowym, bezstratnym standardzie 3Dc. R420 przetwarza jednocześnie 16 pikseli (lub wartości "Z"), czyli 2x więcej niż jego poprzednik. Zwiększono również ilość rejestrów tymczasowych, z 12 do 32 i wprowadzono statyczną kontrolę przebiegu programu shadera. Silnik pikseli jest zgodny z wersją 2.b. R3xx mógł wykonywać program shadera składający się z 32 operacji na teksturach oraz 64 instrukcji matematycznych (silnik w wersji 2.0). R420 jest w stanie przetworzyć po 512 instrukcji każdego typu, co łącznie daje 1024, ale specyfikacja DirectX dla PS wersji 2.b nie pozwala na przekroczenie łącznej ilości 512 operacji na shader. Podobnie jak w NV40 cztery potoki powiązane są w jeden Quad. Do zwiększenia efektywności przetwarzania dłuższych programów służy F-Bufor, który w przypadku R420 uzyskał możliwość dynamicznej zmiany swojej wielkości. Obsługa wielu obszarów renderowania oraz zmiennoprzecinkowe filtrowanie przez TMU było już dostępne we wcześniejszych układach. Nie zmieniła się również 24-bitowa precyzja obliczeń oraz układ trzech ALU (z których jeden odpowiada za operacje na teksturach), umożliwiający przetworzenie do pięciu instrukcji w pojedynczym takcie zegara. Wprowadzono również możliwość sprzętowej dekompresji tekstur spakowanych w nowym, bezstratnym standardzie 3Dc. |

Wbrew temu, co niektórzy sądzą, NV40 nie jest oparty na nowej architekturze. Bazą silnika jest model przetwarzania NV30, który nieznacznie (głównie kontroler pamięci i jeden ALU) zmodyfikowano, najpierw do postaci NV35, a teraz, w końcu, doczekał się poważnej i nie ma co ukrywać, wysoce pożądanej rekonstrukcji. Od pierwszego układu Dx9, przygotowanego przez nVidia (pomimo początkowych problemów z interpretacją, związanych z utajnieniem szczegółów konstrukcyjnych), rzuca się w oczy odmienność podejścia do metody przetwarzania operacji 3D, w stosunku do ATI. Rdzeń Radeonów cechuje minimalizacja ilości rozkazów jednostek matematycznych ALU, przy względnie dużej liczbie, możliwych do wykonania, prostych operacji, w jednym takcie zegara (stąd wynika również łatwość implementacji przeróżnych innych efektów, niekoniecznie 3D, korzystając ze wsparcia silnika pikseli). GeForce natomiast, dysponował pokaźną listą, zaawansowanych instrukcji, dedykowanych ściśle określonym zadaniom przetwarzania 3D (pewną analogię znajdziemy w zasadzie działania procesorów RISC i CISC). Jeśli układ nVidia miałby szansę na osiągnięcie tej samej liczby dowolnych operacji w jednym takcie, to przy zbliżonej częstotliwości działania oczywiście zmasakrowałby produkt ATI wydajnością.

Nie jest to jednak możliwe w związku z niezbędnym działaniem projektantów, borykających się z próbą zniwelowania podstawowej wady tego modelu przetwarzania. Chodzi mianowicie o wielkość i skomplikowanie rdzenia, z którym bezpośrednio wiążą się kwestie kosztów produkcji oraz wydatku energetycznego, i co za tym idzie, taktowania. Idea minimalizacji ilości tranzystorów polegała na powiązaniu części zasobów i bloków poszczególnych jednostek ALU. Pojedynczy potok NV3x/4x jest w stanie wykonywać kilka instrukcji jednocześnie, ale tylko wtedy, gdy są one różne (oprócz kilku wyjątków). W takim przypadku mamy do czynienie z największą wydajnością oraz efektywnym wykorzystaniem, niemal każdego "tranzystora", tworzącego bloki wykonawcze potoku pikseli. Problem w tym, że konkretny shader może w sam raz "złośliwie" powielać, w kolejnych rozkazach, te same polecenia i układ natychmiast straci efektywność działania. W ten sposób doszliśmy do jednej z podstawowych wad architektury nowych GeForce'ów. Niestety skuteczność ich działania jest w znacznej mierze oparta na optymalizacji kodu. Niektórym wydajne się, że program współpracy nVidia z programistami gier ma charakter głównie marketingowy. To też, ale przede wszystkim chodzi o maksymalne dostosowanie struktury instrukcji do możliwości układu, bo jest to w stanie przynieść wymierny efekt wydajnościowy. Programistom, wbrew kolejnym plotkom, wcale nie zależy aby ich dzieło działało dobrze tylko na części sprzętu obecnego na rynku. W ich interesie jest również to, aby gra wyglądała i działała dobrze na każdej karcie. Korzystnie na wydajność wpływa sam kompilator, który analizując program shadera jest w stanie zmienić kolejność instrukcji, ale pełnię wydajności karty można jedynie osiągnąć przy dedykowanym kodzie. ATI również wprowadza swój program współpracy z twórcami gier, ale w przypadku Radeonów, zarówno potrzeba, jak i sam efekt optymalizacji, ma niewielkie znaczenie. Chodzi głównie o stronę reklamową i stanowi próbę zbilansowania działań konkurencji, w oczach potencjalnego klienta. Wróćmy do opisu nowych układów.

NV40 vs R420

W zasadzie o R420 niewiele można napisać. Działania projektantów miały na celu efektywne wprowadzenie dwukrotnie większej ilości potoków wraz z nieznacznym usprawnieniem przetwarzania dłuższych shaderów. I pewnie im się to udało. Do nowości zaliczyć można 3Dc. Jest to model kompresji bezstratnej mający zastosowanie dla tekstur odwzorowujących wypukłości metodą map "normalnych". Użycie dużej tekstury pozwala na lepszą implementację efektu, a metody stratne kompresji prowadzą do zniekształceń obrazu (tekstura w tym wypadku "tworzy" geometrię) znacznie łatwiejszych do wychwycenia niż w przypadku klasycznego teksturowania (zakłócenia w samej palecie koloru). Jednak w związku z tym, że R420 potrafi sprzętowo jedynie dekompresować, to aby mógł wykorzystać tekstury w tym formacie, muszą być one, w formie skompresowanej, zawarte w samej grze. ATI nieodpłatnie udostępnia zarówno narzędzia do kompresji jak i nie ogranicza dostępu do samego algorytmu licząc na to, że stanie się to standardem również dla innych producentów hardware a programiści gier wprowadzą format 3Dc zarówno w nowych silnikach jak i w postaci łaty do starych. Dopiero czas pokaże w jakim stopniu 3Dc przyjmie się w grach. Osobiście jestem raczej umiarkowanym entuzjastą.

NV40 natomiast, wręcz zalewa nas powodzią modyfikacji. Oprócz zwiększenia ilości potoków, przebudowano lub przynajmniej rozszerzono, instrukcję większości ALU. Nareszcie GeForce dostał TMU (nakładanie i filtrowanie tekstur) na miarę generacji Dx9 (z ograniczeniem do precyzji 16-bitowej). W powiązaniu z kilkoma efektami (co ważniejsze od dawna dostępnymi u konkurencji) będzie można (mam nadzieję, że nVidia doprowadzi do tego) zrezygnować z kilku uproszczeń w obrazie. Choć teoretycznie, mogły być one realizowane przez układ, to koszt ich wykonania był za duży. Wprawdzie realna ilość jednostek wykonawczych w potoku nie zwiększyła się (niektóre ulotki reklamowych stosują naciąganą formę przedstawienia ich działania), ale dzięki wprowadzeniu "dwufunkcyjnego" ALU (tekstury LUB arytmetyka), potok powinien znacznie lepiej dostosować się do nowych wymagań gier, w których następuje tendencja do zwiększania ilości obliczeń matematycznych kosztem bezpośrednich operacji na teksturach. Pojawienie się instrukcji umożliwiających kontrolę przebiegu programu jest, z jednej strony, krokiem milowym do powstania silników gier, zawierających skomplikowane efekty shaderów, a z drugiej strony, może stanowić dodatkowy zastrzyk wydajności w grach aktualnych oraz tych, które pojawią się jeszcze w tym roku. Jest to możliwe, między innymi, dzięki możliwości dodatkowej optymalizacji procesu nakładania efektu. Można sobie wyobrazić logiczną konstrukcję programu uzależniającego zastosowanie polecania dla piksela od faktu, czy w danych warunkach efekt może być na nim w ogóle widoczny. Chodzi głównie o statyczną kontrolę przebiegu bo w przypadku dynamicznej koszt jest już znacznie większy (3x więcej cykli zegara).

W odróżnieniu od kwestii wydajności nie należy natomiast dać się ponieść marketingowi i uwierzyć, że dzięki zakupie NV40, w sposób spektakularny, skorzystamy na jakości obrazu w stosunku do kart konkurencji. Jako, że niedawny "król shaderów", Radeon 9800 XT, "padał" przy próbie obrobienia programów zawierających kilkadziesiąt prostych instrukcji, to układ, który ma moc nawet i parę razy większą (nawet teoretycznie), nie jest w stanie zbliżyć się do granic specyfikacji 2.x, a tym bardziej osiągać korzyść z braku ograniczenia ilości instrukcji. W kwestii wydajności można, w nieco uproszczony sposób, znaleźć analogię do realnego porównania PS1.4 z PS1.1 z ewentualnym, dodatkowym kosztem w postaci konieczności użycia 32-bitowej precyzji. PS3.0 nie jest żadną metodą bezpośrednią na dodatkowe efekty 3D. Jest to pewien certyfikat, którego zdobycie gwarantuje programistom osiągnięcie konkretnej "kultury" pracy, a producentowi układu ewentualną możliwość dodatkowego zysku wydajnościowego. Trzeba również podkreślić, że to właśnie nVidia zdecydowała się na ten krok (kosztem zarówno inwestycyjnym w pionach R&D, jak i wielkości samego rdzenia) i tak, jak aktualne gry SM2.0 zaczęły pierwotnie powstawać na kartach ATI, tak pichcenie kolejnej generacji silników 3D zacznie się dokonywać na "palnikach" nowych GeForce'ów.

Teoria (fsaa, inne)

a) Pełnoekranowy antyaliasing

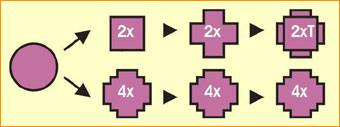

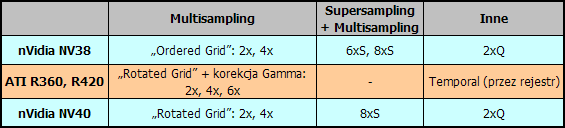

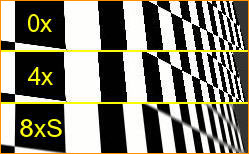

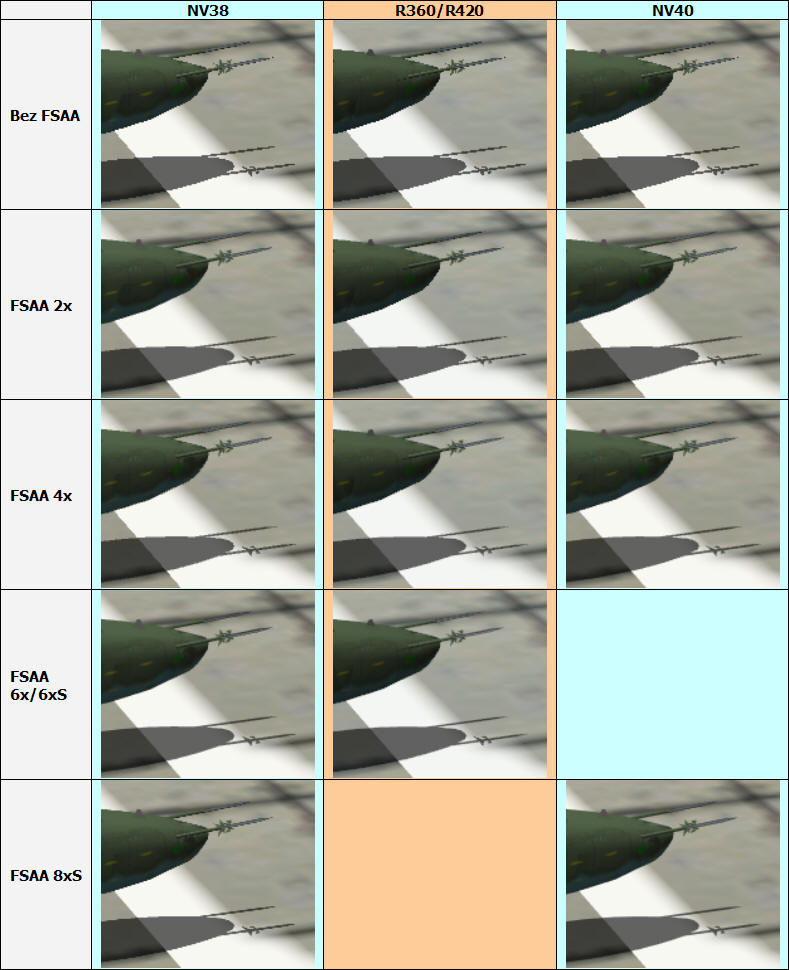

NV40, w stosunku do poprzednika, wnosi jedną, konkretną zmianę w działaniu pełnoekranowego antyaliasingu. Tryb 4x oparty został na multisamplingu (wyznaczanie koloru na podstawie próbek pikseli z obszaru przyległego) opartym na technice "rotated grid", co powoduje znaczną lepszą jakość wygładzania. Sterowniki wprowadzają również tryby 2x oraz 8x. Ten ostatni jest tworzony przez połączenie technik multisamplingu oraz supersamplingu (wyznaczenie koloru w oparciu o niejawny rendering w wyższym trybie). NV40, w stosunku do poprzednika, wnosi jedną, konkretną zmianę w działaniu pełnoekranowego antyaliasingu. Tryb 4x oparty został na multisamplingu (wyznaczanie koloru na podstawie próbek pikseli z obszaru przyległego) opartym na technice "rotated grid", co powoduje znaczną lepszą jakość wygładzania. Sterowniki wprowadzają również tryby 2x oraz 8x. Ten ostatni jest tworzony przez połączenie technik multisamplingu oraz supersamplingu (wyznaczenie koloru w oparciu o niejawny rendering w wyższym trybie). |

Wraz z R420, ATI zaanonsowało metodę podwyższenia jakości filtrowania bez straty framerate, nazwaną "Temporal FSAA", polegającą na wykorzystaniu właściwości działania monitora, w połączeniu z funkcją dynamicznej zmiany maski, wyznaczającej piksele do obliczeń multisamplingowych. Niezmienne, w stosunku do poprzednika, pozostają "klasyczne" tryby 2/4/6x, wykorzystujące metodę "rotated grid" wraz z filtracją gamma. Wraz z R420, ATI zaanonsowało metodę podwyższenia jakości filtrowania bez straty framerate, nazwaną "Temporal FSAA", polegającą na wykorzystaniu właściwości działania monitora, w połączeniu z funkcją dynamicznej zmiany maski, wyznaczającej piksele do obliczeń multisamplingowych. Niezmienne, w stosunku do poprzednika, pozostają "klasyczne" tryby 2/4/6x, wykorzystujące metodę "rotated grid" wraz z filtracją gamma. |

W przypadku układu R420, osobiście raczej skłonny jestem uznać, że nic konkretnego się nie zmieniło. Temporal FSAA traktuję bardziej jako chwyt marketingowy niż konkretną korzyść dla użytkownika. Efekt jest w stanie działać bez widocznego, nieprzyjemnego migotania rantów tekstur jedynie wtedy gry framerate przekracza 60 fps i wymaga włączenia vsynch. W związku z tym, implementacja w sterowniku ma charakter dynamiczny. W momencie gdy czas przygotowania ramki jest dłuższy "temporal" przestaje działać. Aby nie odczuć tego boleśnie musimy wspierać go klasycznym multisamplingiem. Również warto zauważyć, że w przypadku większej dynamiki obiektów jego wpływ na obraz wyraźnie się zmniejsza. Wszystko to powoduje, że realna wartość "Temporal FSAA" jest moim zdaniem niewielka. Jak włączymy multisampling, znajdziemy grę, która z vsynch osiąga czasem >60 fps w trybie, który nas interesuje, to na statycznych rantach będziemy mogli, przy zwyżkach framerate zobaczyć stopień wygładzania wyższy od domyślnego. Inna sprawa, że już od R300 ATI wprowadziło znakomity model FSAA 2/4/6 oparty na metodzie "rotated grid" z filtrem gamma, który jak dotąd był bezkonkurencyjny.

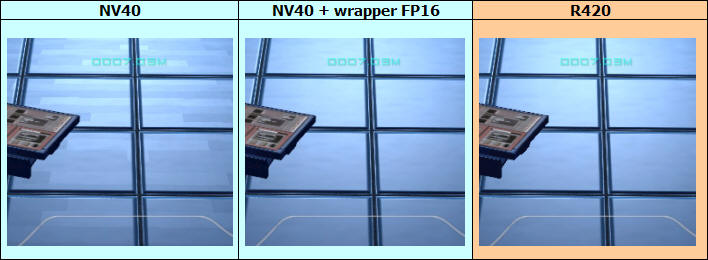

Rotated Grid vs Ordered Grid

NV40 wprowadza jedną, ale konkretną zmianę w modelu antyaliasingu. Kwestia dotyczy trybu 4x. W zasadzie najważniejszego. Dzięki wykorzystaniu, w algorytmie obliczeń, punktów wyznaczonych metodą podobną do ATI ("rotated grid") znacząco wrosła klasa filtrowania "schodków". Tak jak w poprzednim modelu "gołym" okiem widać było lepsze wygładzanie Radeonów, tak w nowym układzie różnica jest tak mała, że w zasadzie można przyjąć zbliżoną jakość obrazu. Jedynie filtr korekcji gamma zapewnia ATI minimalną, optyczną przewagę, której nie należy jednak przewartościowywać. Dodatkowo, sterowniki nVidia umożliwiają użycie trybu 8x. Należy go jednak traktować równie marketingowo jak "temporal" ATI. Wyższy tryb uzyskiwany jest przez połączenie multisamplingu "rotated grid" z supersamplingiem. Tak jak jakość wygładzania jest faktycznie nieco lepsza od 4x i zbliżona do ATI 6x, tak spadek wydajności praktycznie uniemożliwia sensowne jego wykorzystanie. Podsumowując, mogę przyjąć, że palma pierwszeństwa, dzięki wydajnemu trybowi 6x oraz w mniejszym stopniu, korekcji gamma, zostaje przy Radeonach. Z drugiej strony, jako że tryb 4x jest najbardziej optymalnym połączeniem wydajności z jakością filtrowania (zmiany w obrazie pomiędzy 4x a 6/8x nie są duże), i co za tym idzie, najczęściej wykorzystywanym, to można przyjąć, że dzięki poprawkom wnoszonym przez NV40, różnica pomiędzy układami przestaje być rażąca.

b) Inne...

Filtrowanie anizotropowe: W zasadzie dużo się nie da napisać. W kwestii filtrowania anizotropowego NV40 wprowadził dodatkowy tryb 16x natomiast R420 dysponuje takimi samymi możliwościami jak jego poprzednik (Anizo do 16x). Filtrowanie anizotropowe: W zasadzie dużo się nie da napisać. W kwestii filtrowania anizotropowego NV40 wprowadził dodatkowy tryb 16x natomiast R420 dysponuje takimi samymi możliwościami jak jego poprzednik (Anizo do 16x). |

Trudno analizować możliwości filtrowania na podstawie samych informacji o trybach. nVidia wraz z NV40 zmieniła nieco model filtrowania. Nowe układy w znaczącym stopniu upodabniają obraz do tego, który uzyskuje się na kartach konkurencji. W kwestii jakości jest to pewien krok wstecz ponieważ obraz filtrowania anizotropowego NV30 był nieco lepszy, niż w przypadku Radeonów. Wynikało to przede wszystkim z asymetrii działania efektu, w zależności od kąta nachylenia filtrowanej tekstury. Nieprzyjemnym dla testującego, bo utrudniającym porównanie obrazu, aspektem dodatkowym są liczne optymalizacje stosowane przez obydwu producentów polegające na zmniejszeniu jakości obrazu w celu uzyskania wyższego framerate.

Przetwarzanie filmów: Obydwaj producenci chwalą się wsparciem sprzętowym zarówno procesu dekodowania jak i kodowania licznych metod kompresji strumienia wizyjnego. Ma to na celu odciążenie procesora, dla którego jest to spory wydatek mocy. Przetwarzanie filmów: Obydwaj producenci chwalą się wsparciem sprzętowym zarówno procesu dekodowania jak i kodowania licznych metod kompresji strumienia wizyjnego. Ma to na celu odciążenie procesora, dla którego jest to spory wydatek mocy. |

Osobiście daleki jestem od większego, entuzjazmowania się tymi funkcjami. Mogą być przydatne, jeśli użytkownik chce, jednocześnie z obsługą strumienia wizyjnego (oglądanie filmów, kompresja), wykorzystać peceta do innych zadań. Realny efekt zależy w znacznej mierze od kwestii współpracy sterownika z konkretnym oprogramowaniem i nie ma się co łudzić, że nastąpi pełne odciążenie procesora. W skrajnych przypadkach można pisać o kilkudziesięcioprocentowym wsparciu. W przypadku ATI najczęściej polega to na wykorzystaniu jednostek obliczeniowych potoków pikseli do przeprowadzenia konkretnych operacji, wyselekcjonowanych przez sterownik. Trudno powiedzieć czy nVidia realizuje to za pomocą dedykowanego modułu, bo aktualne sterowniki nie wykorzystują jeszcze tych możliwości karty.

Skalowalność: Nowe układy NV40 i R420 tworzą najmocniejsze karty oparte na tych architekturach. Każdy z producentów ma zamiar, w oparciu o nią, stworzyć również karty z niższej półki cenowej. Aby następowała gradacja wydajności, już na etapie tworzenia, przewidywane są słabsze mutacje. W obydwu układach będzie to realizowane przez wyłączenie z działania jednego, dwóch lub trzech, powiązanych wspólnym cache L2, potoków pikseli (Quad) oraz ograniczeniem szyny pamięci. Skalowalność: Nowe układy NV40 i R420 tworzą najmocniejsze karty oparte na tych architekturach. Każdy z producentów ma zamiar, w oparciu o nią, stworzyć również karty z niższej półki cenowej. Aby następowała gradacja wydajności, już na etapie tworzenia, przewidywane są słabsze mutacje. W obydwu układach będzie to realizowane przez wyłączenie z działania jednego, dwóch lub trzech, powiązanych wspólnym cache L2, potoków pikseli (Quad) oraz ograniczeniem szyny pamięci. |

Najważniejsze jest to, że przy takim podejściu nie mamy do czynienia z ograniczeniem możliwości układów w zakresie przetwarzania konkretnych efektów 3D, a jedynie ze zmniejszeniem wydajności. Jako, że w poprzednich układach ATI, w odróżnieniu od nVidia, "cięcie" szło również wzdłuż linii potoków wierzchołków, to warto zauważyć, że tym razem ograniczenia ilościowe dotyczą samego przetwarzania pikseli.

Cztery potoki pikseli powiazane w blok funkcjonalny (kliknij, aby powiększyć)

Teoria (słowniczek, tabela zbiorcza)

a) Nazwy technologii

Aby specjalnie nie rozwijać opisów marketingowych to nazwy technologii zebrałem w krótkim słowniczku.

Nietrudno zauważyć, że w nowych układach nVidia głównie atakuje magią cyfry "3" natomiast ATI, wywołującymi odpowiednie skojarzenia, literami "HD".

b) Tabela zbiorcza architektury z uwzględnieniem opisanych różnic

Opisane powyżej możliwości, związane z architekturą wewnętrzną układów umieściłem w jednej tabelce, aby zainteresowany łatwiej mógł wychwycić różnice.

Sprzęt wykorzystywany do testów

Podobnie jak w poprzedniej recenzji, wykorzystałem 32-bitową platformę AMD i następujący software:

- Procesor AMD Barton 2500MHz

- Płyta główna Asus A7N8X

- Pamięć 2 x 512MB DDR-400

- System Windows XP SP1

- Sterowniki ATI Catalyst 4.5, 4.7 (RX800XTPE), 4.9 Beta (Doom3)

- Sterowniki nVidia Detonator v61.11, v61.34, v61.45 (GF6800GT) i v61.77 (GF6800)

Całość (dochodzi kilka kart PCI, dwa napędy optyczne, HDD, kilka wentylatorów i gadżetów USB) zasilał popularny zasilacz Chieftec (produkcja Sirtec'a) HPC-360-302 DF po drobnej kuracji wyciszającej. W związku z tym, że nowe karty straszą nas możliwym zwiększeniem zapotrzebowania na energię, to postanowiłem również sprawdzić ten parametr. Użyty zasilacz należy do klasy średniej, a w związku z jego sporą przeciążalnością (potrafi oddawać blisko 400W przy obciążeniu ciągłym), niezłymi zabezpieczeniami i stosunkowo niską awaryjnością przy umiarkowanej cenie cieszy się na tyle dużym powodzeniem, że kilka osób prosiło mnie o zbadanie jego przydatności w konstrukcjach wykorzystujących układy nowej generacji. Trzeba przyznać, że łatwego zadania mieć nie będzie, bo wyciszony został kosztem zmniejszenia przepływu powietrza, płyta nie ma dodatkowego gniazda ATX12V a żeby bardziej upodobnić obciążenie do zestawu miłośnika nadtaktowania zwiększyłem procesorowi napięcie do 1.8V, a pamięciom do 2.9V. W takim układzie newralgicznym punktem wydaje się linia 5V zasilacza. Ciekawe czy sobie poradzi. Od razu uprzedzam, że nie będę sugerował się żadnym odczytem napięć, ale podstawą jak zwykle, jest stabilność działania zestawu.

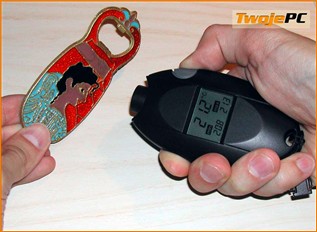

Dokładny pomiar obciążenia generowanego przez samą kartę nie jest możliwy bez "prucia" złącza AGP (sam pomiar prądu na wtyczce niewiele daje, bo nie można zakładać stałego obciążenia płyty). Jako, że mój głód wiedzy "energetycznej" nie jest na tyle silny abym niszczył płytę, to idąc na łatwiznę, postanowiłem zebrać informację od strony sieci energetycznej. W związku z tym, że wykorzystywany zasilacz zaopatrzono w aktywny układ korekcji współczynnika mocy, to wyniki pomiaru tylko nieznacznie różnią się od wartości, którymi musi dysponować sam zasilacz. Wykorzystałem prościutki i stosunkowo tani miernik mocy Voltcraft'a, który całkowicie wystarcza do osiągnięcia zamierzonego celu.

Voltcraft - miernik mocy (kliknij, aby powiększyć)

Zdecydowanie największy kłopot polega na odseparowaniu mocy pobieranej w czasie gry przez procesor od tej, którą żywi się karta graficzna. Wymagało to kilku dodatków sprzętowych, paru przemyślanych testów i odrobiny matematyki. Szczegółów zdradzać nie mam zamiaru. Dla testowego peceta można przyjąć wirtualną wartość 185W. Oznacza ona moc czynną pobieraną z sieci dla danej konfiguracji BEZ (dlatego wirtualną) karty graficznej. Wbrew pozorom nie jest to mała wartość, bo nowe karty graficzne stanowią jeden z największych odbiorników mocy, a wartość 360W, którą karmi nas tabliczka znamionowa testowego zasilacza oznacza maksymalną moc, którą może on oddawać przy optymalnym dla niego obciążeniu wszystkich linii napięciowych.

Drugą zabaweczką, która przydała mi się w teście jest stosunkowo tani, bezdotykowy termometr na podczerwień IR-101 (producent: Europe Supplies Ltd.).

Termometr na podczerwień IR-101 - miernik mocy (kliknij, aby powiększyć)

Wprawdzie parametr D:S (stosunek odległości do powierzchni mierzonej) wynosi tylko 6:1, ale przy odpowiednim zbliżeniu wystarcza to do określenia temperatury samych kości BGA w czasie pracy.

O cyfrowej wadze "kuchennej" chyba nie będę się rozpisywał...

Opis karty Gainward GFFX5950U

a) Karty

Zanim przejdę do opisu głównych bohaterów recenzji chciałbym najpierw, w dużym skrócie, przedstawić tło sprzętowe, które w tym opracowaniu stanowią najmocniejsze karty poprzedniej generacji, wystawione przez ATI i nVidia. Są to Abit Radeon 9800 XT i Gainward GeForceFX 5950 Ultra. Radeon udostępniony został przez przedstawiciela producenta ABIT Polska natomiast GeForce przez Multimedia Vision, dystrybutora kart Gainward.

b) GeForceFX 5950 Ultra

GeForceFX PowerPack! Ultra/1800 XP Golden Sample (kliknij, aby powiększyć)

Karta GeForceFX 5950 Ultra (nazwa modelu: GeForceFX PowerPack! Ultra/1800 XP Golden Sample) wyprodukowana została przez firmę Gainward. Duże ciężkie pudełko zaszokowało bogactwem zawartości. Oprócz samej karty graficznej można w nim znaleźć:

- Czteroportowy (jeden port wewnętrzny) kontroler PCI FireWire (IEEE1394) oparty na układzie VIA VT6306

- Sześciokanałowa karta dźwiękowa PCI oparta na układzie CMI8738

- Śledź z czteroma dodatkowymi wyjściami i wejściami cyfrowymi karty dźwiękowej (optyczne i elektryczne).

- Stereofoniczne słuchawki nauszne

- Kabel FireWire zakończony wtyczką umożliwiającą podłączenie kamer cyfrowych

- Kabel optyczny do przenoszenia wielokanałowego dźwięku

- Kabel VIVO z wtykiem miniDIN 9-pinów od strony karty. Wyjścia i wejścia w standardach Composite (Cinch) i S-Video (miniDIN 4-piny)

- Przejściówka DVI -> VGA do podłączenia drugiego monitora z wejściem analogowym

- Płyta CD z sterownikami (v52.14) oraz oprogramowaniem narzędziowym wspierającym obsługę karty: EXPERTool i EXPERTBios

- 2x płyta CD z pełną wersją gry Chrome

- Płyta CD ze sterownikami i oprogramowaniem karty dźwiękowej

- Płyta CD z oprogramowaniem InterVideo WinCinema, w skład którego wchodzą: odtwarzacz filmów WinDVD4 w wersji wielokanałowej, odtwarzacz/koder muzyki WinRip2 oraz edytor filmowy WinProducer3

- Króciutka instrukcja instalacji karty FireWire w języku angielskim

- Instrukcja instalacji i obsługi karty dźwiękowej w języku polskim

- Instrukcja instalacji i obsługi karty dźwiękowej w języku angielskim

- Bardzo obszerna Instrukcja instalacji i obsługi karty graficznej w języku polskim (75 stron !) wraz z elementami konfiguracji sterownika, słowniczkiem i opisem narzędzia EXPERTool. Oprócz Gainwarda, rzecz praktycznie niespotykana wśród kart sprzedawanych w Polsce

- Instrukcja instalacji i obsługi karty graficznej w języku angielskim

Ważąca ok. 440 g karta oparta jest na czerwonym laminacie o potężnych gabarytach (jest ok. 4 cm dłuższa niż Radeony) i solidnym "obłożeniu" metalem. Zawiera osiem kości 2.0 ns o łącznej pojemności 256MB. Duży, ożebrowany radiator pokrywa większą część powierzchni awersu wraz z układem graficznym i pamięciami. Jest on zintegrowany z dwoma (oddzielne, dwupinowe gniazda zasilania), podświetlonymi czerwonym światłem, niewielkimi wentylatorami. Na rewersje drugi, niewiele mniejszy radiator, którego celem jest chłodzenie pamięci. Na śledziu gniazda VGA, DVI oraz VIVO (miniDIN 9-pinów). Wejście wizyjne realizuje układ Philipsa SAA7108AE (wyjście obsługuje sam rdzeń graficzny). Na karcie gniazdo dodatkowego zasilania (Molex). Warto zwrócić uwagę na fakt, że w odróżnieniu od referencyjnych kart nVidia, konstrukcja Gainwarda nie zajmuje dodatkowych slotów PCI.

Chłodzenie niestety nie należy do tych najcichszych. Dwa małe, ale wysokoobrotowe wentylatorki robią spory harmider. Choć słyszałem już głośniejsze karty, to do cichych konstrukcji zdecydowanie nie mogę go zaliczyć. Dźwięk o podobnym natężeniu, jak Radeon 9800XT po wygrzaniu, choć z powodu nieco wyższego tonu wydaje się minimalnie głośniejszy. Jakość obrazu bardzo dobra w całym testowanym zakresie trybów (do 1600x1200 @ 85Hz). Pulpit wydaje się trochę mniej ostry niż w kartach ATI, ale już po chwili następuje przyzwyczajenie wzroku. Brak zastrzeżeń. Laminat rozgrzewa się do ok. 60 stopni natomiast radiatory do 55/60 stopni (awers/rewers). Najcieplejsze były niektóre elementy stabilizatora, które osiągały do 80 stopni. Największym zaskoczeniem był pobór mocy, jaką karta zasysała z sieci. Potrafił on sięgać chwilami wartości 95W.

Kartę udało się podkręcić z domyślnych 475/475MHz do 560/570MHz. Zbyt mało aby odczuć to w grze, ale miłośnicy testów "zobaczą" kilka dodatkowych fps.

Gainward FX PP! Ultra/1800 GS - sugerowana przez dystrybutora cena detaliczna

wynosi 2395 PLN wraz z 3-letnią gwarancją w systemie S.O.S (serwis odbiera sprzęt).

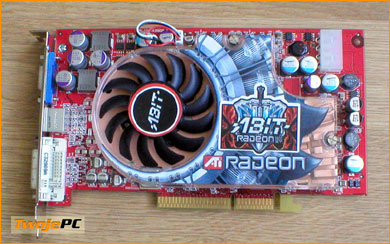

Opis karty Abit R9800XT

Abit R9800XT (kliknij, aby powiększyć)

Przedstawicielem najmocniejszej dotychczas karty ze stajni ATI jest, w tej recenzji, produkt Abita. Spore pudełko w ciemnych barwach zawierało, w dodatkowych kartonikach, oprócz samej karty:

- Instrukcja instalacji i użytkowania karty wraz z elementami konfiguracji sterownika, w języku angielskim

- Instrukcja instalacji karty w 20-stu językach, łącznie z polskim (5 stron na język)

- Płyta CD ze sterownikami (Catalyst v3.9) oraz z odtwarzaczem CyberLink PowerDVD 5.0

- Przejściówka DVI -> VGA do podłączenia drugiego monitora z wejściem analogowym

- Rozgałęźnik zasilania przydatny gdy nie mamy wolnych gniazd Molex z zasilacza

- Przejściówka TV-Out do podłączenia telewizora sygnałem zespolonym (Composite) miniDIN 7-pin -> Cinch

- Kabel S-Video (Y/C), 2x miniDIN 4-piny

- Kabel Composite, 2x Cinch

Pomimo, że na pudełku znajduje się informacja o zawarciu kupona na HL2, nie udało mi się go znaleźć w środku. Nie wiem, czy jest to "urok" sampla testowego, czy świadome ograniczenie wyposażenia. Jeśli taka jest oferta Abita, to mnie osobiście razi brak dodatku w postaci gry. Szczególnie biorąc pod uwagę fakt, że jest to topowy model.

Klasycznych dla ATI rozmiarów, czerwony laminat obsadzono ośmioma układami pamięci BGA Hynix 2.5 ns o łącznej pojemności 256MB. Pomimo względnie małych rozmiarów karta waży ok. 420g na co głównie wpływ ma charakterystyczne, referencyjne, miedziane chłodzenie ATI. Gruba płyta bazowa pokrywa zarówno rdzeń jak i pamięci znajdujące się na awersie karty. Zwiększenie powierzchni oddawania ciepła realizowane jest przez dolutowane blaszki tworzące prostokątne tuneliki. Pamięci na rewersie chłodzi dodatkowa, miedziana, profilowana blaszka. Asymetrycznie położony, siedmiocentymetrowy, wąski wentylator o dużej liczbie łopatek podłączony jest za pomocą trzech przewodów. Na śledziu gniazda VGA, DVI oraz TV-Out. Na karcie dodatkowe gniazdo zasilania (Molex) oraz mikroprzełącznik (m.in. wybór standardu TV-Out).

Bezpośrednio po włączeniu wentylator rusza z pełną prędkością i odgłosem "huraganu". Po ok. 2s cichnie całkowicie, dzięki dużemu spowolnieniu prędkości obrotowej. Niestety radość użytkownika trwa tylko kilka minut. Po tym czasie karta rozgrzewa się do temperatury, która powoduje zwiększenie obrotów w obszar głośnego szumu. Dla wrażliwych posiadaczy cichych pecetów, pomimo, że w dźwięku nie ma wyższych, denerwujących tonów, będzie zdecydowanie za głośny. Jakość obrazu bez zastrzeżeń w całym sprawdzanym zakresie (do 1600x1200 @ 85Hz). W czasie pracy laminat karty rozgrzewa się do temperatury ok. 60 stopni natomiast radiatory do ok. 50 stopni. W czasie intensywnych testów 3D karta pobierała z sieci do około 65W mocy.

Próby nadtaktowania karty, w zasadzie nie powiodły się. Z domyślnego taktowania 412/365MHz udało się podnieść zegary jedynie do 420/375MHz.

Abit R9800XT dostępny jest w sklepach w cenie około 2450 PLN wraz z dwuletnią gwarancją.

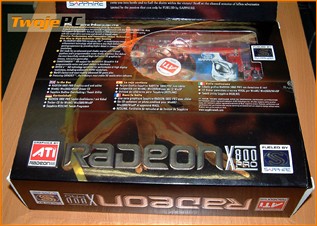

Opis karty Sapphire RX800P

Radeon X800 Pro. Przechodzimy do opisu postaci pierwszoplanowych recenzji. Pierwszym przedstawicielem nowej generacji kart, którego miałem szansę przetestować, jest Sapphire Radeon X800 Pro. Karta została udostępniona do testów przez producenta - Sapphire Inc. Jest to produkt w docelowej konfiguracji sprzętowej i z wyposażeniem takim, z jakim trafia do sprzedaży detalicznej.

Sapphire Radeon X800 Pro (kliknij, aby powiększyć)

Firma Sapphire Inc. jest największym producentem kart z układami Radeon i najważniejszym partnerem ATI. Produkuje karty zarówno pod własną nazwą, jak i niemal wszystkie te, które dostępne są pudełkach sygnowanych przez ATI (tzw. Build by ATI). To właśnie firma Sapphire jest twórcą referencyjnych projektów kart Radeon, które w niemal niezmienionej postaci wykorzystują również inni producenci.

Radeon X800 Pro używa 12-ście z 16-stu potoków R420. W stosunku do pełnej architektury, zablokowano działanie jednego z czterech tzw. Quad'ów (czteropotokowe bloki funkcjonalne ze wspólnym cache L2). Pozostałe części architektury nie zostały zmienione. Referencyjne taktowanie wynosi 475MHz dla rdzenia i 450MHz dla pamięci.

Sapphire Radeon X800 Pro (kliknij, aby powiększyć)

Sapphire Radeon X800 Pro zapakowany jest w średniej wielkości pudełko z wizerunkiem obcego. Ciemna tonacja, wytłoczenia, metalizowany kolor czcionek, uchylna zakładka, okienko z podglądem karty. Sporą ilość informacji związanych zarówno z wyposażeniem jak i dostępną technologią przedstawiono tak, aby nie zdominowała szaty graficznej. Staranność przygotowania projektu opakowania wskazuje na spore zaangażowanie producenta w dopieszczenie szczegółów oferty.

Na "piętrową" zawartość pudełka, oprócz samej karty, wpływ mają:

- Instrukcja instalacji karty w sześciu językach (bez polskiego, ok. 10 stron na język)

- Płyta CD z odtwarzaczem CyberLink PowerDVD 5.0 w wersji 2-kanałowej

- Płyta CD z tweakerem RedLine v1.9

- Płyta CD ze sterownikami (Catalyst v4.4)

- Dwie płyty CD z pełną wersją gry Tomb Raider : The Angel of Darkness.

- Przejściówka DVI -> VGA do podłączenia drugiego monitora z wejściem analogowym

- Rozgałęźnik zasilania przydatny, gdy nie mamy wolnych gniazd Molex z zasilacza

- Kabelek TV-Out do podłączenia wyświetlaczy (telewizor, rzutnik itd.) z wejściem YPrPb (YUV, Component), miniDIN 7-pin -> 3x Cinch

- Przejściówka TV-Out do podłączenia telewizora sygnałem zespolonym (Composite) miniDIN 7-pin -> Cinch

- Kabel S-Video (Y/C), 2x miniDIN 4-piny

- Kabel Composite, 2x Cinch

- Firmowa nalepka na komputer

Wyposażenie jest kompletne. Dołączona, dwupłytowa gra należy do generacji Dx9, komplet okablowania i przejściówek, odtwarzacz DVD w najnowszej wersji (szkoda, że w wersji dwukanałowej). Nowością jest kabelek wyprowadzający z TV-Out sygnał komponentowy (YPrPb). Standard umożliwia przesyłanie obrazów telewizyjnych w trybach HDTV, ale takie wejście spotkać można również w projektorach, a nawet niektórych klasycznych telewizorach.

Płytka wyglądem przypomina konstrukcję Radeona 9800 XT choć oczywiście są różnice w elementach. Na przykład, wygląda na to, że stabilizator został nieco "uproszczony". Po raz pierwszy w testach mam kartę z pamięciami GDDR3. Po obu stronach płytki rozmieszczono osiem modułów BGA Samsung 2.0ns. Pamięci nie wymagają radiatorów do poprawnego działania. Chłodzeniem układu zajmuje się odchudzona wersja konstrukcji znanej z R9800XT. Różnica polega na odcięciu części, której przeznaczeniem było chłodzenie pamięci. Wąski, podłączany trzeba kabelkami, 7-mio centymetrowy wentylator o dużej liczbie charakterystycznych łopatek nie zmienił się. Karta waży ok. 320g czyli o 100g mniej niż R9800XT. Różnica wynika nie tylko ze zmniejszenia radiatora pokrywającego układ graficzny, ale również z usunięcia miedzianej blaszki pokrywającej pamięci na rewersie.

Sapphire Radeon X800 Pro (kliknij, aby powiększyć)

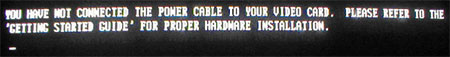

Na śledziu typowy zestaw wyjść: VGA, TV-Out i DVI. Na karcie dodatkowo mikroprzełącznik PAL/NTSC (oraz przełącznik wejścia w modelach VIVO) i gniazdo zasilania (Molex). Jeśli nie podepniemy go do odpowiedniej wtyczki zasilacza, to zamiast startu systemu, zobaczymy następujący komunikat:

Pomimo zastosowania tego samego wentylatora co w R9800XT "kultura" pracy karty jest diametralnie różna. Początek działania jest taki sam. Po włączeniu peceta wentylator atakuje nas huraganem, a po dwóch sekundach cichnie tak, że przestajemy go słyszeć. Różnica jest taka, że RX800Pro pozostawia wiatrak na tych samych, niskich obrotach. Próbowałem wygrzewać przez całą noc. Podkręcałem. Zamykałem w słabo chłodzonej obudowie. Wciąż cisza. Łopatki obracają się tak "leniwie", że po zatrzymaniu palcem wirnik sam nie podejmie pracy (trzeba go popchnąć). Przy takim trybie działania wysoce pożądane jest okresowe odkurzanie wnętrza obudowy, bo mam wrażenie, że kurz jest w stanie go skutecznie zablokować, jeśli przy restarcie sam się nie przedmucha wysokimi obrotami, które są serwowane jedynie parę sekund. Muszę przyznać, że dawno nie testowałem tak cichej karty, a da się to jedynie porównać z konstrukcjami z pasywnym chłodzeniem (np. Sapphire Ultimate). W przypadku referencyjnego chłodzenia RX800Pro (oczywiście inni producenci mogą wprowadzić własne patenty) jego wymiana na systemy np. Zalmana czy Arctica, moim zdaniem, mija się z celem.

Sapphire Radeon X800 Pro (kliknij, aby powiększyć)

W czasie pracy laminat i radiator nagrzewały się do ok. 60 stopni natomiast najcieplejsze były same kości pamięci, których temperatura dochodziła, przy obciążeniu, do ok. 75 stopni. Nic jednak nie wskazuje na to, aby sprawiało to karcie jakiś problem, bo próby podkręcania zegarów wskazują na całkiem przyzwoity potencjał w tym zakresie. Z domyślnych 475/450MHz (rdzeń/pamięć) udało mi się nadtaktować do wartości 560/570MHz. Jako, że zarówno temperatura jak i możliwości podkręcenia pamięci były wyższe niż w wielu testach, jakie miałem okazję czytać, to możliwe, że w badanej karcie działają one na nieco wyższym napięciu. Otwarte pozostaje pytanie, czy będzie tak samo również w kartach Sapphire, które pojawiają się w sklepach. Podobnie otwarta jest kwestia nadtaktowania rdzenia. Badany egzemplarz był wcześniej wykorzystywany w innych testach i jeśli któryś z recenzentów zdecydował się na zdjęcie chłodzenia to mógł je założyć staranniej, niż w statystycznym produkcie wychodzącym z fabryki. Faktem jednak jest to, że w porównaniu do R9800XT możliwości dla nałogowego overclockera są znacznie większe.

Sapphire Radeon X800 Pro (kliknij, aby powiększyć)

Przy domyślnym taktowaniu, karta pobierała z sieci energetycznej moc dochodzącą przy obciążeniu, do wartości 45W. W porównaniu do 65W R9800XT (a tym bardziej 95W FX5950U) jest to bardzo umiarkowana "konsumpcja". Po podkręceniu (proszę zwrócić uwagę na to, że wentylator nie zwiększył swoich obrotów) do 560/570MHz było to już 60W. Różnica jest spora i pokazuje jak istotna jest dla producenta kwestia doboru optymalnej klasy chłodzenia i możliwości "produkcyjnego" taktowania kart.

W sklepach pojawiły się pierwsze informacje cenowe. Aktualnie sugerowany koszt zakupu tych kart wynosi ok. 2300 zł. Gwarancja 2 lata.

Opis karty MSI GF6800U

GeForce 6800 Ultra. Drugą z pierwszoplanowych postaci recenzji, która dotarła do redakcji, jest najmocniejszy przedstawiciel nowej generacji kart nVidia. Karta została udostępniona do testów przez MSI-Polska, przedstawiciela producenta, firmy Microstar International. Jest to egzemplarz testowy produktu finalnego, a dostarczony został w opakowaniu zastępczym wraz z niekompletnym wyposażeniem.

Firma Microstar International (w skrócie: MSI) jest największym producentem kart graficznych na świecie i oczywiście zdecydowanie przewodzi we wszelkich rankingach ilościowych, wśród wytwórców serii GeForce.

(kliknij, aby powiększyć)

GeForce 6800 Ultra to 16-sto potokowe "monstrum", oparte na rdzeniu NV40. Testowana karta MSI nosi nazwę własną producenta: NX6800 Ultra-T2D256. Pełna architektura i maksymalne taktowanie. Próby wprowadzenia na rynek mocniejszej wersji Extreme Edition nie zakończyły się sukcesem ze względu na zbyt małą ilość rdzeni, osiągających zakładane taktowanie 450MHz, więc Ultra pozostaje najsilniejszą kartą w ofercie nVidia. W związku z tym, jest to jeden z pretendentów do tronu wydajności wśród wszystkich kart nowej generacji, zasługuje na szczególnie królewskie traktowanie. Referencyjne taktowanie wynosi 400MHz dla rdzenia i 550MHz dla pamięci.

(kliknij, aby powiększyć)

Odnotujmy co, oprócz karty, tworzyło zawartość opakowania zastępczego:

- Kabel S-Video (Y/C), 2x miniDIN 4-piny

- Rozbudowana instrukcja instalacji i użytkowania karty w języku angielskim wraz z elementami konfiguracji sterownika

- Płyta CD ze sterownikami (WinXP v60.85) oraz oprogramowaniem narzędziowym: 3DTurbo Experience, Live Update, GoodMem, LockBox, WMIInfo, Secure Doc, E-Color, Trend Micro PC-Cillin, D.O.T, BeTwin, Media Ring Dialer

- Płyta CD z odtwarzaczem filmów InterVideo WinDVD 5.1 Channel oraz Supreme Foreign Language Learning Machine

- Płyta CD z programem do tworzenia filmów InterVideo WinDVD Creator Plus

- Płyta CD z programami Farstone : VirtualDrive Pro oraz RestoreIt! Pro

- Płyta CD z demonstracjami czternastu gier

- Płyta CD z oprogramowaniem multimedialnym Media Center Deluxe II

- Płyta CD z programami Photoshop Album SE oraz 3D-Album

- Płyta CD z pełną wersją gry URU: Ages Beyond Myst

- Płyty CD z pełną wersją gry XIII

- Płyty CD z pełną wersją gry Prince of Persia 3D

- Ulotka z materiałami licencyjnymi oprogramowania

Opis pełnej zawartości pudełka znaleźć możemy na stronie producenta. Według potwierdzonej przez MSI-Polska informacji, na nasz rynek produkt trafi z tym samym wyposażeniem. Oprócz opisanych elementów dojdą:

- Przejściówka DVI-VGA do podłączenia monitora z wejściem analogowym

- Kabelek umożliwiający podłączenie wentylatora bezpośrednio do zasilacza

- Płyta CD z programem MSI 3D Desktop

Jak widać, również i tym razem, MSI zdecydowanie wybija się ponad przeciętność bogactwem wyposażenia. Szczegółnie w kwestii dodatków na płytach CD. Już same gry stanowią konkretną wartość dodaną, a przecież dostajemy również sporo innych, ciekawych programów. Jedynym minusem jest dla mnie brak drugiej przejściówki DVI, bez której nie można podłączyć dwóch monitorów analogowych. Na szczęście można ją dokupić oddzielnie, a jej koszt nie jest wysoki. Trochę mnie jednak dziwi, dlaczego producent nie zdecydował się na taki "gest", w stosunku do topowej karty.

Przyjrzyjmy się samej karcie. Sądzę, że Ci, którzy mieli wcześniej do czynienia z high-end'owymi produktami graficznymi ze "stajni" nVidia nie powinni być zszokowani. Potężnych rozmiarów karta, oparta na zielonym laminacie, wyposażona została w monstrualnej wielkości chłodzenie. Strumień powietrza chłodzącego wymusza wysoki, turbinowy wentylator, który w odróżnieniu od referencyjnych modeli FX5800U oraz FX5950U zasysa je, podobnie jak FX5900U, z wnętrza komputera i kieruje na szpaler blaszek mocowanych do płyty bazowej radiatora. Ich wysokość sprawia, że takie rozwiązanie charakteryzuje się wręcz gigantyczną, jak na karty graficzne, powierzchnią oddawania ciepła. Całość pokryta jest obudową z tworzywa, zapewniającą odpowiedni kierunek przepływu powietrza. Wentylator podłączony jest do płytki dwużyłowym kabelkiem. Bardziej niż wielkość karty zdziwiła mnie jednak jej waga. Pomimo budzących respekt rozmiarów, MSI GF6800U waży 420g, czyli tyle samo co znacznie mniejszy Abit R9800XT, a nieco mniej niż np. Gainward GFFX5950U. Oczywiście to nie są czary. W odróżnieniu od ciężkiej miedzi konkurentów, radiator wykonany jest z aluminium. Materiał ten ma słabsze przewodzenie ciepła, ale dzięki jego wykorzystaniu zachowano klasyczny ciężar karty i jak widać, jego możliwości są wystarczające dla poprawnej pracy układu graficznego.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Oprócz rdzenia, radiator pokrywa również pamięci. Osiem kostek BGA GDDR3 Samsung 2.0ns (te same co w RX800P) umieszczono na awersie karty. Na rewersie brak jakichkolwiek elementów wymagających dodatkowego chłodzenia. Powietrze opuszczające pokrywę chłodzenia pada na dodatkowy radiator pokrywający, umieszczone w linii, układy mocy stabilizatora, zajmującego sporą część laminatu. W jego pobliżu znajdziemy niewielki "buzzer", którego znaczenie odkryłem już po chwili testów. Od strony wyjść zastosowano podwójny śledź. Ze zrozumiałych względów chłodzenie uniemożliwia użycie karty PCI znajdującej się bezpośrednio pod AGP natomiast producent mógłby jednak wykorzystać klasyczne połączenie z obudową. Piszę o tym bo mam obudowę zaopatrzoną w dodatkowe "wypustki" stabilizujące i w zasadzie nie jestem w stanie prawidłowo docisnąć takiej karty. Nie zastanawiając się długo odkręciłem śledzia i dopiero wtedy włożyłem kartę do AGP.

(kliknij, aby powiększyć)

Zdecydowanie najwięcej uwag i kontrowersji wywołuje podwójne gniazdo dodatkowego zasilania (2x Molex). Może objaśnię krótko skąd się ono wzięło. Klasyczne sloty AGP przystosowane są do zasilania kart o poborze mocy nie przekraczającym 25W. W celu zasilenia bardziej "łakomych" w energię urządzeń, przewidziano rozszerzenie standardu, w postaci złączy AGP Pro50 i Pro110 (cyferki oznaczają dopuszczalną moc), ale rozwiązanie to przyjęło się jedynie w konstrukcjach stacji graficznych, a producenci płyt dla masowego odbiorcy niechętnie je stosują, ze względu na dodatkowe koszty. W związku z powyższym oraz z faktem znacznego przekroczenia, przewidywanego dla zwykłego AGP, poboru mocy przez karty przeznaczone na rynek "domowy", zostały one wyposażone w dodatkowe gniazda zasilania, umożliwiające podanie energii bezpośrednio z zasilacza. Jak każde gniazdo elektryczne mają one jednak ograniczenie w postaci maksymalnego, dopuszczalnego prądu płynącego przez jedno złącze. W gniazdach wyprowadzonych z zasilacza jest to wartość 6A. Teoretycznie można sobie wyobrazić kartę, która z płyty pobiera 25W oraz po 6A z linii 5V i 12V złącza Molex co razem daje 127W. Jeśli jednak ograniczymy pobór prądu z linii 12V zasilacza (tej samej, z której spora część płyt pobiera moc dla procesora; przy okazji warto zwrócić uwagę na ograniczenia stawiane przez zasilacz) do 3A tak, aby każda z linii przenosiła zbliżoną moc, to już robi się z tego 91W i zbliżamy się do wymogów najmocniejszych kart graficznych. Ominięciem bariery specyfikacji prądowej złącza jest oczywiście jego zwielokrotnienie.

nVidia w przypadku GF6800U postanowiła zaopatrzyć karty w podwójne gniazdo, aby uzyskać większą swobodę w obciążaniu linii zasilacza. Z tego samego powodu nie powinno się stosować rozgałęźnika Molex (pojedyncze złącze rozgałęźnika ma takie same ograniczenia), ale należy faktycznie wpiąć do karty gniazda prowadzące bezpośrednio (jedynie łączenie lutownicze) do zasilacza (najlepiej z niezależnych kabli co daje lepsze rozłożenie mocy). Oczywiście jak ktoś jest pewny styku swojego nowiutkiego rozgałęźnika to może spróbować go przeciążyć (pewnie w większości przypadków zniesie dużo więcej niż opisuje standard). Na własną odpowiedzialność.

Do poprawnej pracy karty potrzeba podłączyć oba gniazda zasilające. Jeśli nie wepniemy tego bardziej oddalonego od złącza AGP to zamiast startu peceta możemy sycić uszy piekielnym wyciem syreny, serwowanej przez zainstalowany na karcie "buzzer". Jeśli natomiast nie podłączymy drugiego gniazda to system uruchomi się, a sterownik poinformuje o zaistniałej sytuacji. Co jednak ważniejsze, każda próba wejścia w tryb 3D (np. włączenie gry), przy odłączonym kablu, kończyła się u mnie zwisem systemu. Na śledziu znajdziemy dwa gniazda DVI oraz wyjście telewizyjne (miniDIN 4-piny). Takie rozwiązanie daje najszerszy zakres możliwości współpracy z monitorami, bo w odróżnieniu od większości kart na rynku (2 lata temu testowałem podobnie wyposażonego Gainwarda GF4Ti4600), możemy do niej podpiąć dwa monitory LCD złączem cyfrowym. W celu zapewnienie możliwości współpracy z monitorami z wejściem analogowym należy użyć specjalnych przejściówek.

(kliknij, aby powiększyć)

Po uruchomieniu karta atakuje nasze uszy hałasem proporcjonalnym do wielkości chłodzenia. Podobnie jak głośna syrena natychmiast skłaniała nas do podpięcia zasilania tak szum wentylatora powinien zdecydowanie przyspieszyć nasze działanie zmierzające do zainstalowania sterowników. Po ich wgraniu (+reboot) wentylator wydatnie zmniejsza swoje obroty. Wprawdzie generowany hałas prawdopodobnie mieści się w przyjętych, przez ogół użytkowników normach, ale w związku z tym, że był zbliżony do tego, czym traktował mnie Gainward GFFX5950U oraz Abit R9800XT, to nie mogę go zaliczyć do cichych. Minimalnie wyższe tony powodują, że bardziej przypominał kartę Gainwarda. Zdecydowanie odradzam wszystkie te trzy karty, jeśli marzeniem użytkownika jest posiadanie cichego peceta. Jakość obrazu bez zarzutu. Karta nie miała najmniejszych problemów z osiągnięciem 1600x1200@85Hz a i prawdopodobnie nie był to kres jej możliwości (był to kres moich możliwości). W całym zakresie trybów obraz, pomimo zastosowania przejściówki z DVI, był ostry i dobrze nasycony kolorami. W zasadzie większych różnic, w stosunku do Radeonów, nie wykryłem, a jedynie minimalną przewagę w ostrości, w stosunku do Gainwarda FX5950U.

Dobrze rozgrzana i obciążona grafiką karta potrafiła czerpać z sieci do 85W mocy. Jest to mniej niż wartość 95W, którą podałem w stosunku do FX5950U, ale warto zauważyć, że w większości przypadków koszt jej eksploatacji będzie nieco wyższy. Wynika to z faktu, że taki pobór mocy jest osiągany przez kartę niemal w każdych warunkach pracy 3D natomiast FX najczęściej dochodził do 75W, a "udary" 95W były sporadyczne i krótkotrwałe (tym nie mniej to one są właśnie godne odnotowania ze względu na dobór zasilacza). Ze standardowego taktowania 400/550MHz udało mi się uzyskać przetaktowanie (PowerStrip) do wartości 455/620MHz, co spowodowało zwiększenie do 90W mocy pobieranej przez kartę z sieci. Dwie uwagi. Po pierwsze był to egzemplarz testowy producenta, który mógł być oczywiście wyselekcjonowany pod kątem podkręcania, a dodatkowo niejeden z recenzentów mógł solidnie poprawić styk radiatora z pamięciami i układem graficznych. Po drugie, nie jest proste określenie maksymalnego taktowania rdzenia, bo kartę wyposażono w zabezpieczenia przed przegrzaniem i znalezienie taktowania, przy którym nie następowałoby automatyczne zmniejszenie częstotliwości pracy przy dłuższym obciążeniu, byłoby bardzo czasochłonne. W związku z ograniczeniem czasu na testy uznałem za stabilną częstotliwość, którą karta utrzymywała pod solidnym obciążeniem przez nieco ponad pół godziny. W czasie intensywnej eksploatacji laminat rozgrzewał się do ok. 55 stopni, radiator do 50 stopni, a najcieplejszym miejscem były okolice stabilizatora - 60 stopni.

Podsumowując opis najmocniejszej karty nVidia nie mogę się powstrzymać od pewnej konkluzji. Jeśli ktoś spodziewał się, że to monstrum zdewastuje naszego peceta to muszę go rozczarować. Nic takiego się nie dzieje. Karta nie pobiera znacząco większej mocy, nie jest ani cięższa, ani głośniejsza, ani gorętsza, czy większa od poprzednich "topowych" (fakt, że raczej w ujemnym tego słowa znaczeniu) produktów nVidia w tych zakresach funkcjonalności.

Sugerowana dla MSI GF6800U cena detaliczna wynosi ok. 2699 zł. Produkt objęty jest 3-letnią gwarancją.

Wydajność (teoria, opis metod)

Zanim przejdę do wyników testów najpierw uproszczona tabelka wydajności teoretycznej, zawierająca wszystkie sprawdzone modele kart.

W związku z tym, że prawidłowe przetestowanie kart nowej generacji stanowi jednak dla mnie pewne wyzwanie, to muszę napisać kilka słów wprowadzenia.

Od dłuższego czasu, do benchmarków używamy testów opartych na badaniu średniego (głównie) framerate po przetworzeniu przez kartę ustalonego fragmentu ruchomej grafiki trójwymiarowej renderowanej w czasie rzeczywistym. Aby wynik testów stanowił o różnicach wydajności kart graficznych powinny być spełnione przynajmniej trzy podstawowe warunki. Po pierwsze, układy powinny generować ten sam obraz, po drugie, to ich działanie powinno być bazą powstania tego wyniku, a po trzecie, silnik 3D wykorzystany w teście nie powinien w żaden sposób ograniczać wzrostu framerate. Idealne spełnienie tych trzech warunków jest utopią. Drobne różnice w obrazie 3D występują, na średni framerate zawsze ma pewien stopień wpływu platforma testowa (użyty procesor, ilość pamięci itd.), a ograniczenia silnika w zakresie szybkości generowania ramek są naturalną cechę wykorzystywanych algorytmów. Jedynie co może próbować robić recenzent, to dążyć do minimalizacji tych niedoskonałości badawczych. Sprawdzać czy nie ma, przynajmniej rażących, różnic w wyświetlanym obrazie, minimalizować wpływ platformy testowej, zarówno przez wzmocnienie jej mocy, jak i przez taki dobór testów i ustawień, aby maksymalnie dociążyć samą kartę oraz wybierać takie testy, aby ograniczenia użytych w nich algorytmów nie ujawniały się w badanym zakresie framerate.

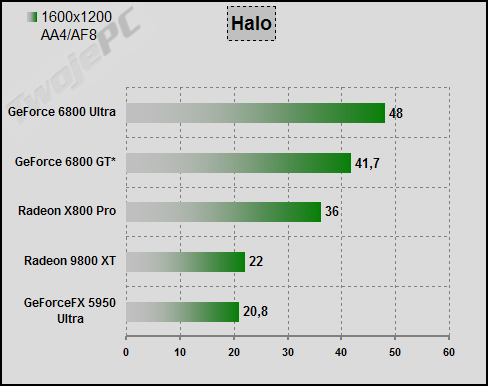

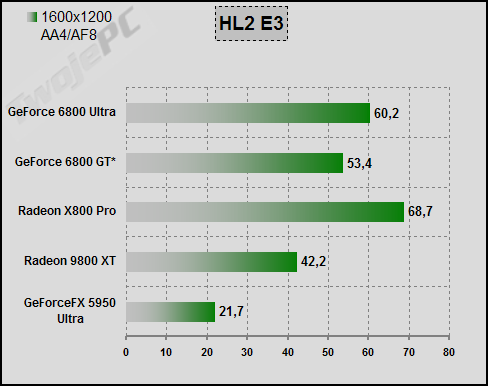

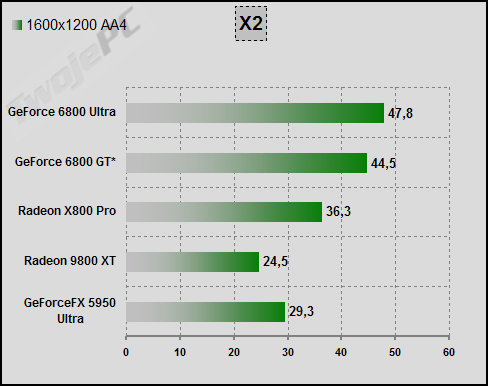

Tak się składa, że moment wejścia nowej generacji układów graficznych, które przede wszystkim są znacząco wydajniejsze od swoich poprzedników, jest szczególnie niekorzystny dla recenzenta. Pojawia się hardware, który przekracza swoimi możliwościami wymagania aktualnych gier i programów testowych w ustawieniach, które zwykle uważane są za optymalne połączenie jakości obrazu i framerate. Już wstępne porównania bezlitośnie odsłoniły słabość części moich procedur testowych i zmuszony byłem do kilku dosyć drastycznych posunięć. Zdecydowałem, że podstawowym trybem testowym będzie rozdzielczość 1600x1200 z dodatkiem antyaliasingu na czterech próbkach oraz filtrowania anizotropowego. Oczywiście zdaję sobie sprawę z tego, że są to ustawienia zupełnie oderwane od rzeczywistości. Nie widzę najmniejszego sensu, aby grać w takich trybach natomiast w celach testowych jest to jak najbardziej uzasadnione. Po raz kolejny przypominam, że nie testuję gier, ale karty graficzne. Nie odpowiadam na pytania jak będzie się grało w danej grze przy pomocy konkretnej karty. Framerate ma obrazować faktyczne różnice ich wydajności, a nie jest ona proporcjonalna do różnicy średniego poziomu fps w trybach 1024x768. Te karty są po prostu zbyt silne w stosunku do testów opartych na silnikach większości dzisiejszych gier. Wydajność karty graficznej to zawsze jest dla mnie potencjał umożliwiający osiągnięcie jak najlepszej jakości płynnego obrazu. Jeśli najmocniejsze karty poprzedniej generacji nie mają z tym problemu w typowych trybach, to trzeba rzucić im większą "kłodę pod nogi" zamiast łaskotać. Dlaczego właśnie 1600x1200 AF (domyślnie jako AF oznaczam FSAA 4x / Anizo 8x)? Powyżej tego trybu, niewspółmierne dla najnowszych silników gier znaczenie miałaby dla kart kwestia przepustowości pamięci. Natomiast dodatek FSAA/Anizo jest ważny dla dociążenie kart tak, aby średni framerate nie przekraczał kilkudziesięciu fps, co najczęściej świadczy o wystarczającym wyeliminowaniu wpływu platformy testowej. Antyaliasing na czterech próbkach jest wspólnym dla kart, najwyższym ustawieniem metody multisamplingowej. Również w związku z tym, że nowe karty mają po 256MB lokalnej pamięci, pomimo wysokiego trybu, obciążenie AGP nie powinno wpływać na wynik.

Oprócz kwestii trybu postanowiłem również zrezygnować z kilku testów. Jest to związane głównie z brakiem możliwości zwiększenia trybu. Sprawa dotyczy między innymi Aquamark3 (wersja darmowa działa tylko w 1024x768) czy Final Fantasy XI. Nie będzie również testu UT2004. Jedyny, jak dla mnie, prawidłowo reagujący test "botmatch" opracowany przez 3DCenter we współpracy z programistą gry osiągnął kres średniego framerate i przestał odzwierciedlać różnice wydajności. Muszę spróbować innej metody, a nie ukrywam, że wbudowany w grę test nie sprawdza się najlepiej (niezależność ruchu botów zbyt mocno wpływa na wyniki). Zrezygnowałem również z mojej ulubionej "motocyklówki" MotoGP2, bo gra osiągnęła maksymalny "dozwolony" framerate (60 fps) niezależnie od ustawień. Resztę zmian będę opisywał na bieżąco. Pojawi się też kilka nowych testów.

W większości tabel z wynikami pojawi się również tajemniczy GF6800GT*. W związku z tym, że karta o tej nazwie jest niczym innym, jak niżej taktowanym GF6800U to, zanim będę miał okazję do jej przetestowania, postanowiłem aproksymować wyniki, które karta uzyska, poprzez obniżenie zegarów GF6800U. Gwiazdka oznacza, że nie są to wyniki właściwego GT. Wyniki zostaną zastąpione jak tylko będę miał okazję do przetestowania tej karty. Taktowanie GT wynosi 350/500MHz.

Na koniec mała, aczkolwiek dosyć istotna informacja. W przypadku GF6800U (i oczywiście GF6800GT*) i Detonatorów v61.34, po dłuższych przemyśleniach, postanowiłem pozostawić domyślne ustawienia sterownika (oprócz VSynch). W tym, włączone obie optymalizacje: filtrowania trzyliniowego i (co ważniejsze) anizotropowego. Kwestia filtrowania stanowić będzie oddzielny rozdział recenzji i tam dopiero znajdzie się informacja zarówno o wpływie optymalizacji na obraz i framerate, jak i spróbuję uzasadnić fakt konkretnych ustawień testowych. Dla zachęty powiem tylko, że wiara w to, że wyłączenie w sterowniku opcji związanych z optymalizacją filtrowania spowoduje ich całkowity brak, jest dużą naiwnością.

Po tym przydługim wstępie czas przejść do konkretów.

Wydajność (testy ...)

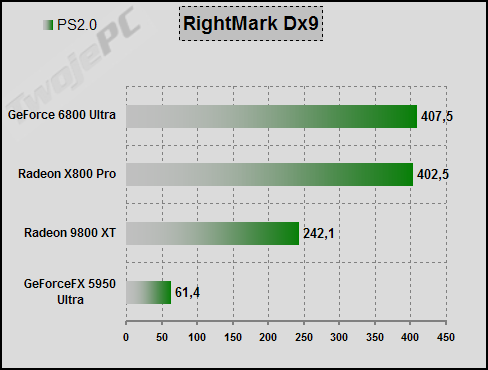

Na rozgrzewkę dwa teściki bez znaczenia strategicznego. D3DRightMark (v1.0.5.0) jest syntetykiem umożliwiającym określenie teoretycznych możliwości przetwarzania efektów, udostępnionych przez DirectX 9.

Spośród szerokiej gamy testów wybrałem dwa najważniejsze: Pixel i Vertex Shader 2.0. W przypadku GeForce'ów można testować tryby o różnej precyzji obliczeń zmiennoprzecinkowych. Niestety, przy GF6800U sterownik (prawdopodobnie) uniemożliwił prawidłowe działanie testu VS2.0. Tym nie mniej wyniki PS2.0 są bardzo interesujące. O słabości GFFX w tym zakresie napisałem już tyle, że nie będę się powtarzał. 12-potokowy, nowy Radeon prezentuje potężny skok framerate w stosunku do swojego poprzednika co oczywiście było do przewidzenia. Proszę jednak zwrócić szczególną uwagę na wyniki najmocniejszego GeForce'a nowej generacji. W stosunku do serii FX następuje różnica rzucająca szczęką o posadzkę (przypominam o 4-krotnej różnicy ilości potoków i zmianach w ALU). Porównajmy nowe architektury obydwu konkurentów. Jeśli NV40 miałby możliwość zastosowania precyzji obliczeń FP24 to ze sporym prawdopodobieństwem można przyjąć, że wynik oscylowałby w granicach 500 fps. Jeśli nałożyć to na kwestię różnicy w ilości potoków to dużo wskazuje na to, że w końcu nVidia "dorobiła" się układu o możliwościach przetwarzania PS2.0 zbliżonych do ATI. W kwestii praktycznych różnic w grach zadecyduje już pewnie kwestia użytej precyzji obliczeń, optymalizacji dla architektury NV40 oraz taktowania. Oczywiście to tylko syntetyk. W realnych silnikach 3D znaczenie pojedynczych efektów jest dużo mniejsze.

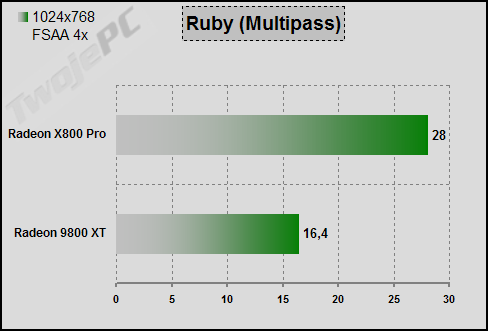

Drugi dla rozgrzewki jest test, do którego wykorzystałem nowe demo ATI z postacią agentki o imieniu Ruby. W zasadzie przeprowadziłem go tylko dla zaspokojenia własnej ciekawości. Demo wykorzystuje wsparcie sprzętowe Dx9.0b i odpalenie go na kartach innych niż X800 nie jest możliwe. Pod względem długości kodu shaderów jest absolutnym rekordzistą. Znalazł się jednak sympatyczny programista, który przerobił shadery tak, aby mogły być realizowane przez układy R3x0 w trybie multipass.

Ze zrozumiałych względów GeForce w tym teście nie występuje. Porównanie w Radeonów w multipass pokazuje realne różnice wydajności natomiast wynik X800P w singlepass posłuży do porównania różnych kart Radeon nowej generacji. Na razie nie ma konkurencji. Oczywiście to tylko demonstracja siły i nie należy przypuszczać, że w najbliższym czasie pojawią się gry, których shadery nie będą wykonywane na R3x0 w jednym przebiegu.

Przechodzimy do testu właściwego. Kolejność alfabetyczna. Przypominam o domyślnym trybie 1600x1200 AF.

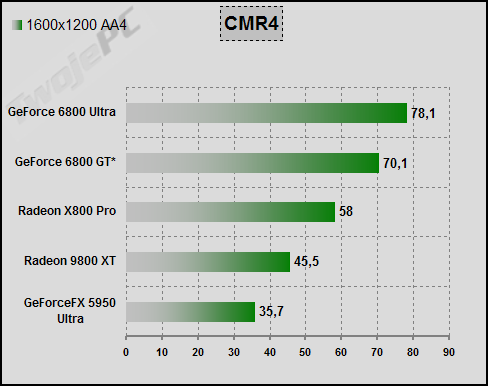

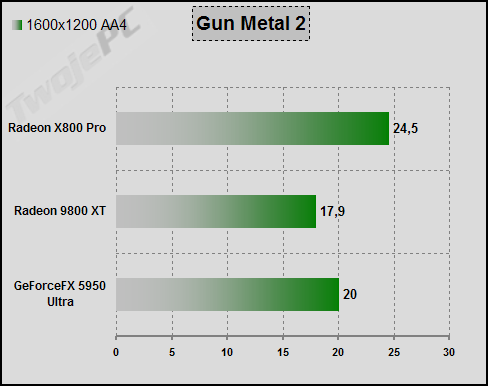

Skoro nie ma MotoGP2 to wykorzystałem inną symulację motoryzacyjną. Colin McRae Rally 04 jest najnowszą odsłoną znanej serii Codemasters. Gra Dx9. Spory zasób nowych efektów. Pomiar za pomocą Fraps.

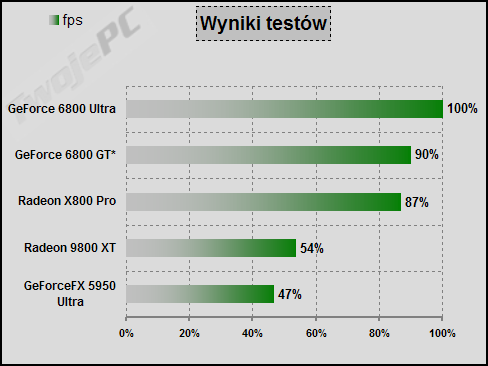

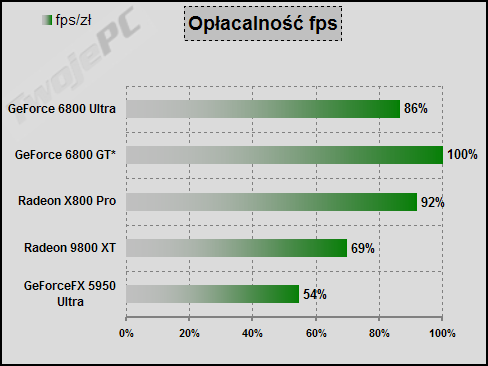

No proszę. Jakie piękne rozłożenie wyników. FX'owi klasycznie zaszkodziły nowe shadery. RX800P oczywiście wyprzedza poprzednika. GF6800U na czele. To wszystko specjalnie nie dziwi. Warto natomiast zwrócić uwagę na bardzo dobrą pozycję GF6800GT. W tym teście wyraźnie odskoczył od nowej, 12-potokowej karty ATI. Sądzę, że porównanie tych dwóch kart może być w tej odsłonie recenzji najciekawsze (zakładam, że docelowo mogą być one dostępne w zbliżonej cenie) choć przypominam, że w przypadku GT to tylko aproksymacja wyników. Poziom framerate jest na tyle wysoki, że może już w pewien sposób wpływać na skuteczność porównania.

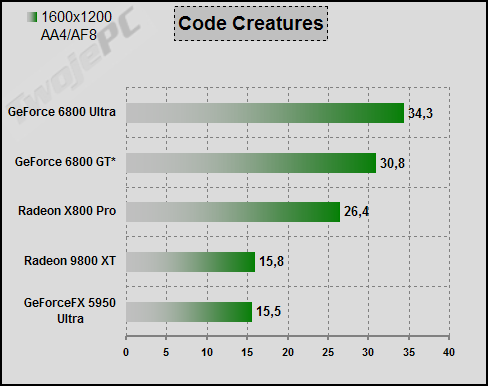

Leciwy, "przyrodniczy" teścik CodeCreatures wciąż zaskakuje stabilnością wyników i niezłym odzwierciedleniem wydajności. Jedynym zakłóceniem jest fakt podstawiania własnego shadera przez sterowniki nVidia, ale jak widać, nie powoduje to specjalnego zdominowania wyników (porównanie FX, 9800XT).

Mamy pierwszy, znaczący przykład różnic pomiędzy generacjami kart. Wprawdzie ani nie mamy 16-potokowego Radeona ani 12-potokowego GeForce'a, ale pewne wnioski same się nasuwają. Starsze karty pozostają w tyle. Znowu GT przed X800P. Czyżby jednak ATI zbyt wysoko wyceniło swój "okrojony" model.

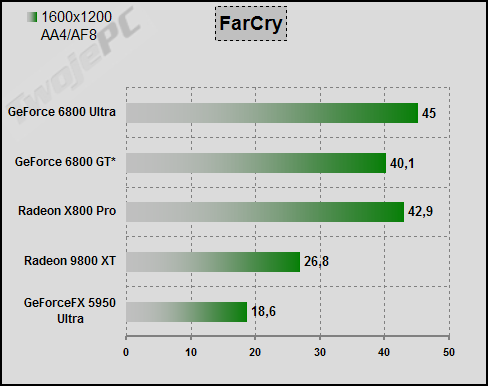

Jeden z najważniejszych testów. FarCry przebojem wdarł się do niemal każdej aktualnej recenzji kart graficznych, choć nie został jeszcze wyposażony w dobre narzędzia benchmarkowe. Tym nie mniej wykorzystam to co jest. Nagrałem krótki fragment własnej gry na mapie Research i badam średni i minimalny framerate przy użyciu polecenia "demo". Ustawienia FSAA 4x ("medium") oraz Anizo 8x (polecenie konsoli) z poziomu gry. Jakość obrazu powalająca choć występują różnice pomiędzy konkurentami.