SiS Xabre 400

Autor: Kris | Data: 02/12/02

|

Jako, że ostatnie recenzje utrzymane były w monotonnym klimacie pojedynków wzajemnych nVidia - ATI to muszę przyznać, że z dużą przyjemnością powitałem w swoim pececie testowym powiew świeżości, którą zapewnił układ graficzny SiS Xabre 400. To niewątpliwie ciekawe indywiduum, które w końcu trafiło do sprzedaży wywołuje czasem tak skrajnie różne opinie, że frajda osobistego zapoznania się z nowym produktem SiS była spora. Dzięki uprzejmości firmy Sirius, która wypożyczyła do testów przedstawiciela tej rodziny dziś prezentuję Wam nowego zawodnika w walce o mniej zasobnego w gotówkę klienta. Przed Państwem SiS Xabre 400. Zapraszam... Jako, że ostatnie recenzje utrzymane były w monotonnym klimacie pojedynków wzajemnych nVidia - ATI to muszę przyznać, że z dużą przyjemnością powitałem w swoim pececie testowym powiew świeżości, którą zapewnił układ graficzny SiS Xabre 400. To niewątpliwie ciekawe indywiduum, które w końcu trafiło do sprzedaży wywołuje czasem tak skrajnie różne opinie, że frajda osobistego zapoznania się z nowym produktem SiS była spora. Dzięki uprzejmości firmy Sirius, która wypożyczyła do testów przedstawiciela tej rodziny dziś prezentuję Wam nowego zawodnika w walce o mniej zasobnego w gotówkę klienta. Przed Państwem SiS Xabre 400. Zapraszam... | |

|

Wstęp

Silicon Integrated Systems Corp. (SiS = www.sis.com) to przede wszystkim producent chipsetów. Specjalnością SiS są układy o dużym stopniu integracji (grafika, dźwięk, porty itd.), dzięki czemu nadają się dobrze dla notebooków oraz umożliwiają realizację budowy taniego peceta do zastosowań biurowych. Grafika reprezentowana przez zintegrowane chipsety SiS w swojej dotychczasowej postaci nie była w stanie konkurować z dedykowaną kartą graficzną zarówno pod względem funkcjonalnym jak i wydajnościowym. Dzisiejszy klient żąda nie tylko możliwości wyświetlenia okienek systemowych, ale chciałby również czasem umilić sobie życie odrobiną trójwymiarowego świata gier. Żenująco mała moc obliczeniowa, słabej jakości sterowniki, problemy zgodności z nowymi grami, brak wsparcia aktualnych specyfikacji 3D API itd. zaczynała wzbudzać niechęć u potencjalnych nabywców. Takie zapotrzebowanie rynku spowodowało z kolei odzew ze strony potęg graficznych, które zareagowały rozpoczęciem produkcji chipsetów i firmie SiS nie pozostało nic innego jak sprostać temu wyzwaniu poprzez przygotowanie takich układów, które spełnią wymagania klientów. Pomimo, delikatnie mówiąc, chłodnego przyjęcia układów serii 315 SiS nie tylko nie przerwał prac nad nową architekturą graficzną, ale dodatkowo je zintensyfikował. Owocem tych działań było zaprezentowanie na tegorocznych targach CeBit (Hanover) rodziny Xabre.

Aktualna oferta SiS Xabre opiera się na trzech układach: Xabre 400, 200 oraz 80. Dwa pierwsze różnią się tylko taktowaniem natomiast Xabre 80 dodatkowo ma "obciętą" szynę pamięci i ograniczenie specyfikacji złącza AGP. Bohaterem tej recenzji będzie najmocniejszy układ Xabre 400 i na nim się dziś skoncentruję. Obiektami do porównań będą układy, w które wyposażono karty graficzne z tej samej kategorii cenowej, co nowy SiS, czyli nVidia GeForce4MX440 i ATI Radeon 9000.

Technologia

Zacznę od obowiązkowej tabelki podstawowych parametrów oraz wydajności teoretycznej porównującej Xabre 400 z najbliższą konkurencją. Wyboru kontrkandydatów dokonał nasz portfel.

Na podstawie powyższych danych można wysnuć wniosek, że układ powinien zostać zaliczony raczej do grupy mocniejszych produktów, bo parametry są w zasadzie takie jak przy Radeonie 8500 czy GeForce4 Ti4200. Jak do tego nałożyć cenę ze zdecydowanie niższej półki to naturalnie klient powinien od razu skupić uwagę na Xabre 400. Należy jednak pamiętać, że są to tylko wartości teoretyczne i jak dotychczasowa praktyka potwierdza, nie należy się nimi entuzjazmować bez sprawdzenia jak nowy układ zachowuje się w realnych zastosowaniach.

- Złącze AGP: Xabre jest pierwszym układem, w którym zastosowano specyfikację AGP v3.0 i transfer 8x. Umożliwia to przepływ 2.1GB danych pomiędzy kartą a płytą główną w czasie jednej sekundy. Brzmi zachęcająco, ale jak już wielokrotnie pisałem nie ma żadnych korzyści z AGP 8x dla graczy. Nie dosyć, że nie poczujemy najmniejszego wzrostu mocy, to i różnice w dokładnych testach oscylują na granicy błędów pomiaru. Jeśli kupujemy nowy sprzęt to zarówno od strony karty graficznej jak i płyty głównej fakt posiadania transferu 8x powinniśmy traktować całkowicie obojętnie a skoncentrować się na innych parametrach. Tym nie mniej należy odnotować, że to SiS stworzył pierwszą kartę obsługującą ten standard i na tą funkcję marketing producenta kładzie szczególny nacisk. Sądzę, że jest to spowodowane promocją własnych chipsetów oraz możliwościami poprawy wydajności tej grafiki zintegrowanej z nimi, która wykorzystuje pamięć podstawową płyty.

- Architektura 4x2: Xabre wyposażono w cztery strumienie renderowania oraz osiem jednostek teksturujących (TMU), czyli po dwa na każdy kanał. To właśnie powoduje, że układ przypomina GeForce4 Ti czy Radeona 8500. Producent nie chwali się jednak funkcjonalnością umożliwiającą wielokrotne "omiatanie" danymi TMU w jednym procesie bez wykorzystania bufora ramki (przydatne przy bardziej skomplikowanych obliczeniach shaderów i większej ilości nakładanych tekstur), co może degradować jakość renderowanego obrazu oraz wydajność. Na pewno możemy jednak liczyć na obsługę czterech pikseli z dwoma teksturami w jednym cyklu.

- DirectX 8: Najistotniejszą innowacją "ósemki" jest wprowadzenie programowalnych jednostek geometrii i cieniowania pikseli zwanych shaderami. Microsoft pozostawił możliwość emulacji Vertex Shadera za pomocą procesora natomiast w związku z jego niewystarczającymi możliwościami zablokował próby zrzuceniu mu na barki realizacji obliczeń programów dla pikseli. Tym właśnie tropem podążył SiS implementując w układzie jedynie Pixel Shader (w wersji 1.3). Z punktu widzenia zgodności z oprogramowaniem wydaje się takie posunięcie bardziej sensowne niż rozwiązanie znane z GF4MX i w zasadzie stanowi o zgodności z DirectX 8 przy minimalizacji kosztów własnych. Mocny procesor bez większych problemów poradzi sobie z obliczeniem prostych programów dla wierzchołków, a konkurent nVidia będzie zmuszał gry do rezygnacji z efektów Pixel Shadera, co w niektórych przypadkach (np. Morrowind) prowadzi do fatalnego pogorszenia realizmu grafiki 3D. Akcent marketingu SiS na tą funkcjonalność jest podstawowym ciosem godzącym w bezpośredniego rywala, czyli GF4MX. Bardziej niewygodnym przeciwnikiem wydaje się dla Xabre układ ATI Radeon 9000, bo oba Shadery realizuje sprzętowo.

- Pamięć: Xabre 400 komunikuje się z pamięciami DDR za pomocą 128-bitowej szyny danych. Odpowiada to możliwościom oferowanym przez konkurencję. Znaczniej gorzej wygląda za to zagadnienie oszczędzania pasma, bo jedynym zaimplementowanym mechanizmem jest podział pamięci na dwa 64-bitowe banki oraz stosowanie przeplotu pomiędzy nimi. Wprawdzie Radeon 9000 ma jeszcze prostszy, pojedynczy 128-bitowy kontroler, ale doświadczenie uczy, że ważniejsze są techniki kompresji oraz detekcji i eliminacji obiektów przesłoniętych.

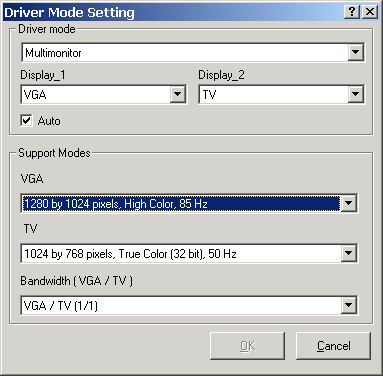

- Wyświetlanie obrazu: Xabre, podobnie jak bezpośredni rywale umożliwia przetwarzanie dwóch niezależnych obrazów. Wyjście analogowe obsługiwane jest przez zawarty w układzie Ramdac charakteryzujący się przyzwoitym pasmem 375MHz. Współpracę z drugim urządzeniem wyświetlającym zapewnia dodatkowy układ SiS 301 zawierający TDMS dla LCD, Ramdac dla drugiego monitora analogowego oraz układ kodowania telewizyjnego PAL-NTSC umożliwiający osiąganie trybu 1024x768. W związku z takim przydziałem interfejsów nie jest możliwa konfiguracja DVI+TV czy 2xDVI. Jak na razie nie przewidziano również dedykowanego do pracy dualnej oprogramowania (typu nVidia nView czy ATI HydraVision) i "skazani" jesteśmy na podstawowe wsparcie jakim raczy nas sterownik oraz sam system operacyjny.

- Filmy: SiS od lat wspiera sprzętowo dekodowanie Mpeg w postaci przetworzenia kompensacji ruchu (MC). Trzeba jednak przyznać, że konkurencja jest w stanie lepiej odciążyć procesor poprzez dodatkowe przejęcie obliczeń iDCT. Ważnym aspektem jest również wysoka jakość sprzętowej realizacji funkcji deInterlace (usuwanie przeplotu) oraz przeskalowania obrazu. W tym zakresie wydaje się, że Xabre zrobił dla kinomanów trochę więcej niż produkty nVidia i jedynie ATI dysponuje bardziej zaawansowanymi technologiami. Wrażenie to w zasadzie wynika tylko z rzeczywistych ocen porównawczych, bo producenci zawsze stosują w tym względzie przerost marketingu nad realnymi efektem praktycznym.

- Dodatkowe mechanizmy poprawy jakości 3D: Jedną z większych wad Xabre jest brak możliwości użycia filtrowania anizotropowego. Mamy natomiast pełnoekranowy antyaliasing wykorzystujący supersampling (przeskalowanie z wyższego trybu renderowania) i rozmycie oraz dowolne ich połączenie. Są to najprostsze metody wygładzania ukośnych rantów obiektów różniące się funkcjonalnością. Supersampling dając wysoką jakość powoduje duże obciążenie układu natomiast rozmycie przy niewielkich stratach mocy prowadzi do pogorszenia jakości wyświetlanego obrazu.

Słowniczek nazw własnych:

- 8X8 GPU: Określenie funkcjonalności układu Xabre oznaczające możliwość pracy AGP w trybie 8x oraz zgodność z DirectX 8.

- Pixelizer Engine: Nazwa implementacji Pixel Shadera w układzie Xabre.

- Frictionless Memory Control (FMC): Mechanizm przeplotu banków pamięci zwiększający efektywność ich wykorzystania.

- Jitter-Free Anti-Aliasing: Metoda pełnoekranowego antyaliasingu realizowanego przez Xabre.

- MotionFixing Video Procesor: Nazwa technik sprzętowego deInterlace oraz skalowania obrazu w odniesieniu do strumienia video.

- Coloredeemer Technology: Mechanizm wzbogacenia kolorów wyświetlanego przez Xabre obrazu.

- The Xminator XP Unified Driver: Nazwa sterowników referencyjnych SiS dla Xabre.

- CubicLook Utility: Narzędzie obsługi okularów 3D, detekcji trybu AGP oraz zmian taktowania karty Xabre.

- Double Scene Technology: Mechanizm niezależnej obsługi dwóch urządzeń wyświetlania obrazu przez Xabre (DVI+CRT, CRT+CRT,CRT+TV).

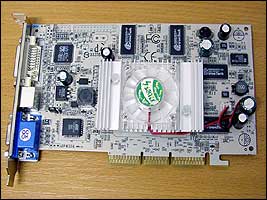

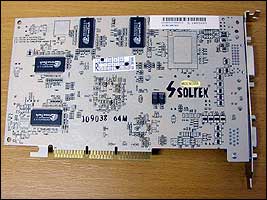

Przedstawiciel

Karty Xabre produkuje kilku producentów. W ofercie rodzimych handlowców znajdziemy głównie propozycje pochodzące od tych firm, które znamy z produkcji tańszych płyt głównych. Prezentowany dziś przedstawiciel rodziny SiS Xabre 400 wyprodukowany został przez Solteka (Soltek Computer Inc : www.soltek.com.tw) a za jego wypożyczenie dziękuję firmie Sirius. Model nosi oznaczenie SL-X400-D6DT a informację o nim znajdziemy na stronie: www.soltek.com.tw

Aby powiększyć fotkę, kliknij!

Aby powiększyć fotkę, kliknij!

Aby powiększyć fotkę, kliknij!

Aby powiększyć fotkę, kliknij!

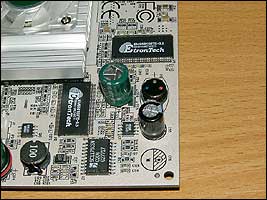

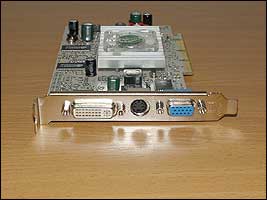

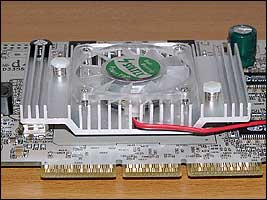

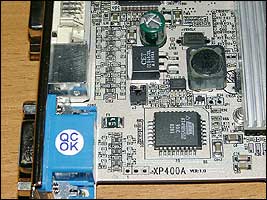

Soltek raczy nas przyciągającym wzrok pudełkiem o moim zdaniem zupełnie nieźle dopracowanej szacie graficznej. Ze środka wyciągnąć można oprócz samej karty CD'ek ze sterownikami, przejściówkę z S-Video na Composite, kabelek Composite oraz ulotkę instalacyjną. W sumie biedniutko. Płytka jest uniwersalnym źródłem sterowników dla produktów SiS i zawiera "goły" driver (WinXP v3030) z czerwca. Proponuje w ogóle nie tracić czasu na wyjmowanie go z folii. Zamiast instrukcji mamy japońsko-chińsko-angielską kartkę z podstawowymi zaleceniami montażowymi. Przydałaby się przejściówka DVI->CRT do uzyskania możliwości odpalenia konfiguracji dwumonitorowej. O uczciwej jakości kabelku S-Video też nie ma co marzyć. Trudno. Sama karta sprawia przyzwoite wrażenie. Niecodzienny, biały kolor PCB, spory radiator wraz ze zintegrowanym wentylatorem z półprzezroczystego tworzywa, komplet wyjść na śledziu: D-Sub (CRT), DVI, S-Video. Zastosowano 64MB pamięci DDR EtronTech 3.5ns. Brzmi dobrze, ale jak już się wielokrotnie przekonywałem ich rzeczywista wydajność i możliwości nie były większe niż np. Hynix'ów 4ns. Ot tanie pamięci o zachęcających klienta wartościach znamionowych. Nie zdejmowałem chłodzenia, ale przy delikatnym przekręcaniu radiatorem czułem tarcie typowe dla zbyt małej ilości pasty termoprzewodzącej. Jeśli ktoś jest zainteresowany ekstremalnym podkręcaniem rdzenia to powinien to sprawdzić. Radiator zamocowany jest na kołkach, więc przesmarowanie styku nie powinno stanowić specjalnego wyzwania dla majsterkowicza.

Na płytce odnaleźć można zworkę zmieniającą domyślny standard wyjścia telewizyjnego. Podobnie jak przy dualnych układach ATI, jeśli do karty podłączymy telewizor to również SiS startuje oba wyjścia w trybie lustrzanym już w momencie uruchomienia peceta sprowadzając na monitor tryb telewizyjny PAL (50Hz) lub NTSC (60Hz). Dla niektórych monitorów może to kończyć się brakiem obrazu (lub dużym zwężeniem w pionie) aż do momentu wgrania sterowników i zróżnicowania wartości odświeżania ekranu. Spowodowane jest to brakiem obsługi trybu 50Hz przez część monitorów. Lekarstwem na to jest NTSC, bo 60Hz nie stanowi już żadnej bariery. Rozwiązanie zmiany standardu z wykorzystaniem zworki na płytce jest moim zdaniem najwygodniejsze, bo nie zmusza użytkownika do flashowania BIOSa. Jak dotychczas jedynie w karcie Sapphire Radeon 9000 DVI/TV widziałem taką zworkę i muszę przyznać, że bardzo mi się ten pomysł podoba. Domyślnie zworka jest założona, co odpowiada standardowi PAL. Znając możliwości mojego monitora od razu ją wyciągnąłem. Po włożeniu karty do peceta i uruchomieniu przyszedł czas na "szumologię". Wentyl Solteka pieści ucho spokojnym cichym szumikiem. Nie powinien przeszkadzać zdecydowanej większości użytkowników. Odgłos zbliżony do Hercules'ów R8500LE. Aby łatwiej było zrozumieć, o jakich poziomach dźwięku piszę to powiem, że u mnie w zasadzie słucham jedynie wentylatora na testowanej karcie graficznej (na co dzień używam karty bez wentylatora a chłodzę dużym, mocno spowolnionym wiatrakiem o średnicy 9 cm, praktycznie bezgłośnym).

Kartę można zakupić w sklepie Siriusa za 390 zł. Gwarancja 24 miesiące.

Jakość 2D

Parę słów o jakości 2D (pulpit Windows). Do 1280x1024x32@85Hz testowany Soltek charakteryzował się niezłym obrazem, choć muszę przyznać, że trochę się rozczarowałem biorąc pod uwagę, że Xabre ma wbudowany w rdzeń Ramdac 375MHz. Bardzo ładne i dobrze nasycone kolory, ale do poziomu bieli a przede wszystkim ostrości można mieć pewne zastrzeżenia. Powyżej tego trybu następuje już znaczące pogorszenie parametrów wyświetlanego obrazu. Jak dla mnie poziom słabszy od markowych GF4 a zbliżony bardziej do średniej klasy GF3. Co ważniejsze lekki rozmaz denerwował w zasadzie niezależnie od trybu. Należy oczywiście pamiętać, że dotyczy to tylko tego jednego egzemplarza Solteka i trudno mi wysnuwać jakieś globalne teorie na temat Xabre.

Może i jestem "rozbestwiony", ale nie jest to klasa, która by mnie zadowoliła. Za tą cenę możemy kupić karty dające lepszy obraz. Sprawdziłem również jakość drugiego wyjścia (zastosowałem własną przejściówkę DVI->CRT). Wygląda to minimalnie słabiej niż na głównym wyjściu, ale najbardziej razi ograniczoność trybów. Drugi Ramdac zawarty jest w dodatkowym układzie SiS 301 i taktowany jest tym samym zegarem, co TDMS (transmiter DVI), czyli 170MHz. Najwyższym możliwym do uzyskania trybem jest 1280x1024x32 @ 75Hz. Są już 17-stki LCD, które mogą wykorzystać większe pasmo a w przypadku CRT w zasadzie nie widzę sensu stosowania monitorów lepszych niż 15-17". Amatorom pracy dwumonitorowej przypominam również o tym, że SiS jak na razie nie przewidział dedykowanego do takiej pracy oprogramowania. Podsumowując: nie wiem jak Soltek wypada na tle innych kart Xabre, ale testowana karta pod względem obrazu 2D wypadła średnio

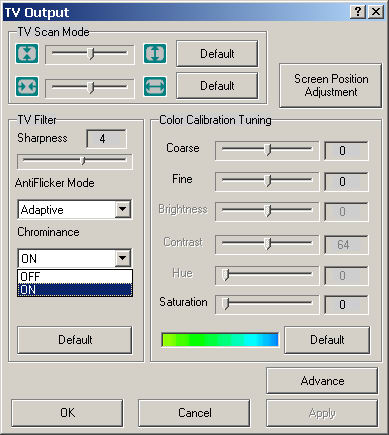

Wyjście telewizyjne

Mocną stroną Xabre jest za to wyjście telewizyjne. Układ SiS 301 wypełnia swoje zadanie bez zarzutu. Stabilny, dobrze nasycony obraz o niezłej ostrości jakościowo przebija produkty nVidia i moim zdaniem bliższy jest klasie ATI/Matrox. Można używać trybów 800x600 i 1024x768. Sterownik daje możliwość pracy lustrzanej oraz niezależnych rozdzielczości w trybie rozszerzonego pulpitu. Telewizor musimy podpiąć przed startem peceta, bo wygląda na to, że sterownik nie ma autodetekcji stanu wyjścia. W czasie klonowania monitor może wyświetlać tylko takie tryby, jakimi dysponuje wyjście telewizyjne (np. Radeon może również robić przesuwany myszką wycinek większego trybu). Z bliżej nieznanych mi przyczyn włączenie wyjścia powoduje u mnie zmianę wielkości domyślnych czcionek Windows. Chyba bug sterownika.

Odpalenie duala (rozszerzony pulpit) zmusza nas do restartu maszyny. Overlay działa na głównym ekranie, który oczywiście możemy wybierać dowolnie. Sterownik daje nam sporo możliwości parametryzacji obrazu. Dostępny jest też overscan. Pewnym minusem jest to, że w 1024x768 część ustawień nie działa (np. overscan czy regulacja migotania). W NTSC nie udało mi się również uzyskać 32-bitów koloru (w PAL bez problemu). Podwójne wyjście dobrze współpracowało z BSPlayerem i nie miałem problemów z osiągnięciem klasycznej funkcjonalności odpalenia filmu (wraz z napisami) na telewizorze i jednoczesnej pracy przy monitorze. Krótko mówiąc: jest dobrze.

Ustawienia 3D

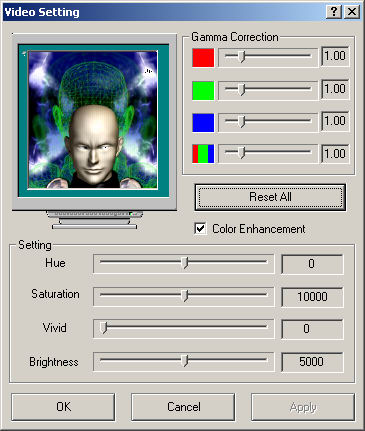

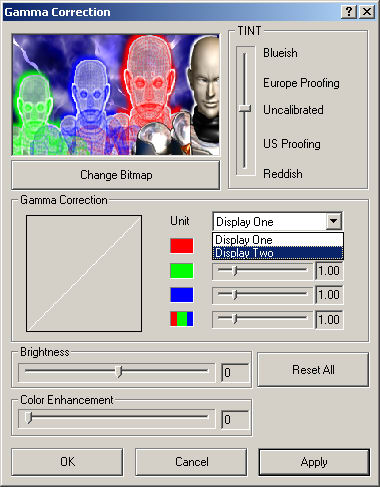

Przed uruchomieniem karty warto zaopatrzyć się w najnowsze sterowniki. Na Solteka nie ma, co liczyć, bo w dziale suportu kierują nas do nVidia. Na szczęście są dostępne drivery referencyjne o nazwie Xminator. Jako, że układ jest nowy to gorąco polecam ściągnięcie najnowszej wersji v 3.07.55. Dla leniwców mam oczywiście gotowy link: www.xabre.com/download/drivers.html

Próbowałem odnaleźć również strony poświęcone układowi Xabre. Na pierwszy plan wybija się www.xabregamers.cjb.net. Oprócz wielu dedykowanych informacji jest tam również forum, na którym możemy liczyć na wsparcie od innych użytkowników tych kart.

Razem ze sterownikami w pakiecie Xminator jest kilka małych aplikacji, z których najważniejszy jest 3D Wizard, program do ustawiania parametrów grafiki 3D (Direct3D i OpenGL). Bez niego skazani jesteśmy na ręczne dłubanie w rejestrach lub pozostawienie sterownikom decyzji w kwestiach jakościowo-wydajnościowych.

Prawdę powiedziawszy możliwości modyfikacji 3D Wizardem są więcej niż skromne. W zasadzie przewidziano jedynie trójpozycyjny suwak wydajność-jakość, ustawianie antyaliasingu (2x - 4x), wyłączenie VSynch oraz wymuszenie 16-bitowego ZBufora dla OpenGL. Przyjrzyjmy się bliżej samemu suwakowi. Domyślnie ustawiony jest w środkowym położeniu, co mogłoby świadczyć o optymalnym stosunku parametrów związanych z jakością i wydajnością. Podobny suwak od dawna występuje również w sterownikach ATI i również tam zajmuje centralne położenie (default). Sugestia do porównań wydaje się wyraźna. Na tym jednak kończą się wspólne elementy, bo dopiero ustawienie Quality dla Xabre odpowiada (i to tylko częściowo) środkowej pozycji Catalystów (drivery ATI). Quality w sensie ATI to dodatkowe filtrowanie anizotropowe oraz pełnoekranowy antyaliasing. Xabre traktuje Fsaa rozdzielnie a "anizotrop" nie jest w ogóle zaimplementowany w układzie. Dodatkowe zamieszanie wprowadza fakt, że pomimo rozdzielenia suwaków dla D3D i OpenGL jakość zmienia się jednocześnie dla obydwu API pomimo tego, że wydają się one działać niezależnie. W środkowym położeniu Xabre raczy nas fatalnym obrazem. Rozmazane tekstury 16-bitowe, brak filtrowania trzyliniowego itd. Generalnie pierwszą rzeczą, którą należy zrobić to przestawić suwak na Quality, bo inaczej znajdziemy się w czasach bliższych układom Riva 128 niż klasie reprezentowanej przez obecne karty, do których zdążył się już przyzwyczaić nasz wzrok.

Analizując zmiany dokonywane przez 3D Wizard w rejestrach na pierwszy plan wysuwa się parametr TexTurboMode. Przejście na Quality zmienia jego wartość z "3" na "1". Własnoręcznie możemy jeszcze wypróbować ustawienie "0", które z poziomu aplikacji nie jest dostępne. Ktoś mógłby spytać, po co w ogóle analizować obraz 3D? Wielokrotnie pisałem o tym, że wydajność karty powinna sprowadzać się do maksymalnej jakości obrazu, jaki można za jej pomocą uzyskać w grach przy założeniu płynności, ale subiektywność takiego badania ograniczyła wszelkie porównania do kwestii pomiarów fps. Aby sens miało porównanie framerate dwóch kart to musimy zapewnić im te same warunki jakościowe, bo w zasadzie są to wymienne wartości. Zmniejszając jakość rośnie szybkość generowania obrazu. Od dawna przyzwyczailiśmy się do tego, że nie porównujemy wyników dwóch kart, z których jedna działała na ustawieniach 16-bitowych a inna 32-bitowych, w różnych trybach czy przy różnych parametrach antyaliasingu. Często jednak zapominamy jak duży wpływ na obraz i co za tym idzie wyniki testów fps ma jakość tekstur i klasa ich filtrowania. SiS wyraźnie podąża tym tropem. Tryb "0" daje nam właściwie obraz tej samej klasy jak na kartach konkurencji, ale bez znajomości rejestrów nawet nie wiemy, że w ogóle jest taka możliwość. Tryb domyślny "3" już zdążyłem sklasyfikować jako nieakceptowalny. Najciekawsze wydaje się sprawdzenie tajemniczej "jedynki" określanej jako Quality i dostępnej w opcjach 3D Wizarda. Analiza pokazuje, że dużo zależy od wykorzystywanego API. Efekt w Direct3D można uznać za zadowalający.

Direct3D, po lewej ATI; po prawej nVidia

Direct3D, po lewej Xabre; po prawej Xabre T0

Zrzuty ekranu pokazują różnicę poziomu detali, ale dotyczą one głównie tych tekstur, które znajdują się z znacznym oddaleniu od widza. W zdecydowanej większości gier obraz trybu "1" mnie osobiście nie razi. W czasie robienia porównań dałem wartości fps również dla trybu "0". Puryści oczywiście będą brali pod uwagę tylko te właśnie wyniki, ale jeszcze raz podkreślę, że metoda zysku na wydajności wprowadzona do D3D jest na tyle "sprytna", że jeśli ktoś używa wyników testów do określenia zachowania w realnej grze to może je brać pod rozwagę. Tracimy w sumie niewiele. Zupełnie inaczej wygląda to w OpenGL.

OpenGL, po lewej GeForce; po prawej Radeon

OpenGL, po lewej Xabre; po prawej Xabre T0

W trybie "1" mamy już filtrowanie trzyliniowe i nie występuje typowa dla trybu "3" tęcza przejść tonalnych barw. Niestety poziom detali jest nadal fatalny. Rozmycie widać bez trudu i niezależnie od odległości od obserwatora. Jak dla mnie nie nadaje się to do bezpośrednich porównań z innymi kartami. Zbliżoną do konkurencji klasę można uzyskać dopiero na poziomie "0". W tabelach OpenGL sugeruję nie rozważać domyślnego trybu Quality dla tego API. Chyba pora na sprawdzenie jak to działa w praktyce.

Wydajność

Aby nabrać siły do dalszego wgryzania się w treść recenzji proponuję przerywnik w postaci inspirującego (przynajmniej niektórych) tekstu o zwycięskiej walce, jaką stoczył tajemniczy rycerz Xabre z demonami tyranizującymi ludzki świat, którym uraczy nas SiS.

Do porównań fps przygotowałem klasyczny dla siebie zestaw gier. Te same ustawienia, ten sam system, ten sam sprzęt pomiarowy, ten same oczy testującego. Tylko takie porównanie ma jakiś sens. Wyniki zbierałem na platformie: Intel P4 2.4GHz (FSB 133), 512MB PC800, Gigabyte GA-8IHXP. System Windows XP SP1. Sterowniki nVidia v40.72 i ATI v7.79 (Catalyst 2.4). W nawiasie min. Fps (jeśli gra zbiera taki wynik). Liczby zaokrąglałem do 0.5 fps.

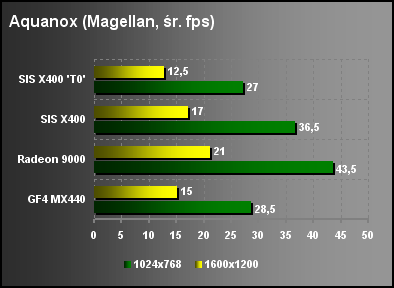

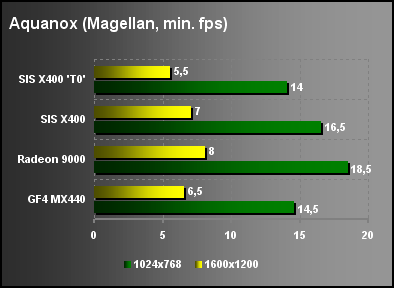

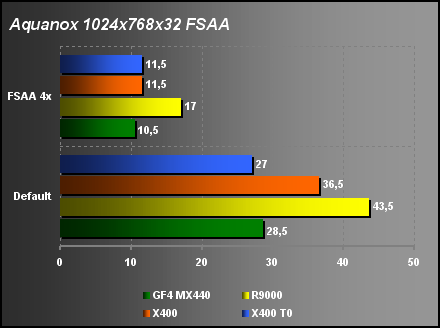

Na pierwszy ogień poszedł Aquanox (demo Magellan, oczywiście Direct3D):

Wyniki dobrze obrazują zachowanie w grze. W trybie domyślnym Quality Xabre 400 działa podobnie jak GF4MX440 czy Radeon 9000. Wyniki plasują go gdzieś pomiędzy tymi kartami. Rzeczywista wydajność jest jednak minimalnie poniżej poziomu GeForce'a. Przez te skałki pokryte teksturami o niezłej jakości daje się zobaczyć różnicę pomiędzy trybami, ale nie razi ona do tego stopnia, aby było się czym przejmować. Warto natomiast zwrócić uwagę na to, że Xabre nie miał żadnych problemów zgodności z grą. Aquanox jest dla mnie niezłym testem, bo ATI długo pokazywała błędy wyświetlania niektórych obiektów a i Parhelia na pierwszych sterownikach ujawniała szereg niedociągnięć. Natomiast pod względem wydajności żadna z kart nie gwarantuje poziomu, który bez zmian parametrów w grze nadawałby się do użytku. Te "piękne" wybuchy załatwiają wszystkich w poważnym stopniu.

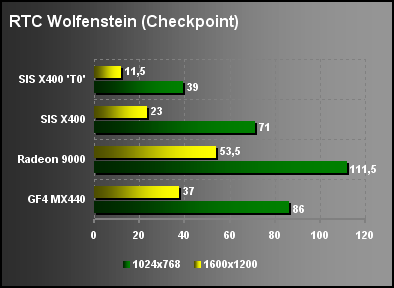

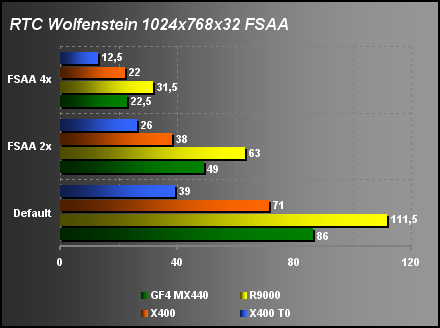

Teraz coś z kręgu OpenGL. Return to Castle Wolfenstein. Modyfikowany silnik Quake3. Demo testowe Checkpoint.

Chyba właśnie wylazła przyczyna znaczącego obniżenia jakości w trybie domyślnym Quality. Po prostu jest to wynik potrzeby zapewnienia sensownego framerate. Porównując fps przy zbliżonym obrazie powinniśmy jednak brać ustawienie TexMode 0 i jest... porażka. Bardzo słabo. Konkurencja miażdży SiS'a bez pardonu.

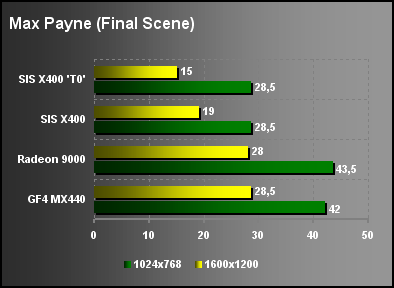

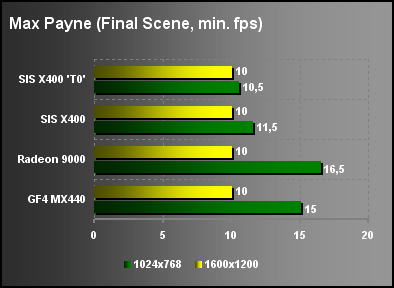

Wróćmy do Direct3D. Max Payne. Demko wzięte ze sceny finałowej.

W obydwu trybach podobny obraz i podobnie kiepska wydajność. Przypominam, że

benchmark nie rejestruje wyników min. Fps <10 i stąd to ujednolicenie

wykresów. Xabre raczej powinien mierzyć się z R7500/GF2, ale cena niestety jest już z innej kategorii. Przynajmniej jakość obrazu i zgodność z grą nie pozostawia zastrzeżeń, ale czy to wystarczy? Oj chyba nie.

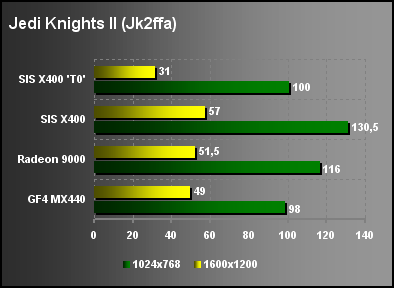

Czas na Jedi Knight II. Kolejna gra OpenGL oparta na poddanym modyfikacjom silniku IDSoftware. Demo JK2FFA.

W końcu Xabre nawiązał walkę. Niestety tylko na papierze. W trybie domyślnym obraz jest znacznie gorszy niż na kartach konkurencji. Po przejściu na TexMode 0 różnice są już mniejsze, ale zwracam uwagę na to, że karty nVidia i ATI wykorzystują filtrowanie anizotropowe, które w czasie testów włączone jest bezpośrednio w grze. Zdecydowanie polecam w tej grze ustawienie trybu "0" w rejestrach, bo obraz jest wyraźnie lepszy a wydajność zadowalająca.

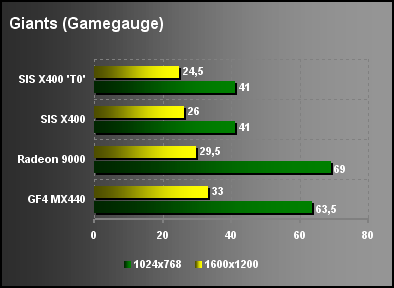

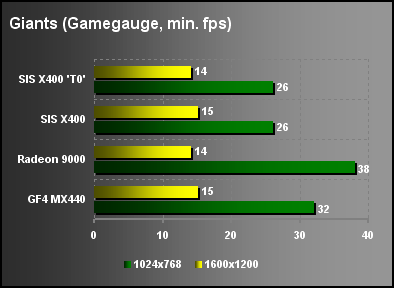

Dla przeciwwagi Direct3D. Giants : Citizen Kabuto. Test wbudowany w patch 1396.

Sytuacja podobna jak w MaxPayne. Niewielki zysk przy przejściu trybów, ale przy widocznej stracie na jakości. Xabre 400 przegrywa z obydwoma konkurentami. Dodatkowo jakość obrazu jest minimalnie gorsza niż na tamtych kartach. Zgodność i tym razem bez zastrzeżeń. SiS wciąż jakoś nie może zabłysnąć.

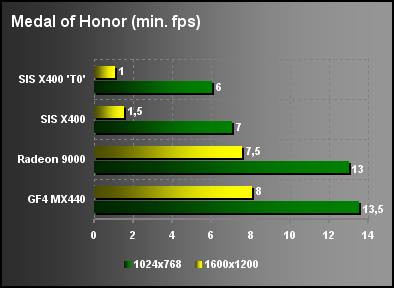

Skoro używam tych samych testów to nie może zabraknąć pomiaru min. Fps w "słynnym" zaśnieżonym lasku Medal of Honor. Znowu modyfikowany klon Q3. Oczywiście OpenGL.

A wydawało mi się, że koszmarem można nazwać to, co prezentują budżetowe układy nVidia i ATI. Żałosne. Tak duża różnica wskazywałaby na brak kompresji tekstur wśród rozszerzeń OpenGL SiS'a (S3TC). Czyżby oszczędność na licencji? Tak jak przeciwnicy mają problem tylko z tym konkretnym miejscem tak Xabre w zasadzie na tych ustawieniach uniemożliwia swobodną grę.

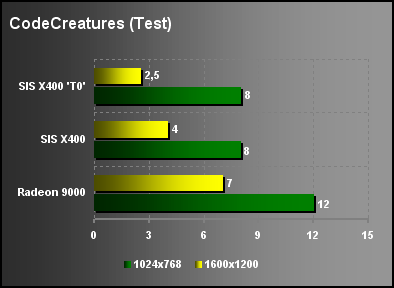

Kolejny test nowej generacji. CodeCreatures to powiew przyszłości. W zasadzie nie powinno się go odpalać na kartach bez 128MB pamięci lokalnej, bo głównie testujemy wtedy możliwości AGP. Na pewno można jednak określić za jego pomocą zgodność z zaawansowanymi technikami Dx8.

Dzięki temu, że Xabre wyposażono w PixelShader to w odróżnieniu od GF4MX440 można sycić wzrok ślicznymi widoczkami. Wydajność oczywiście nie rzuca na kolana, ale jestem pod wrażeniem nowych sterowników. Obraz w zasadzie bez zarzutu. Oczywiście w trybie "0", bo domyślnie są jednak drobne rozmycia. W sumie moim zdaniem nieźle, choć z Radkiem 9000 nie ma, co porównywać. Pamiętajmy jednak, że to tylko test.

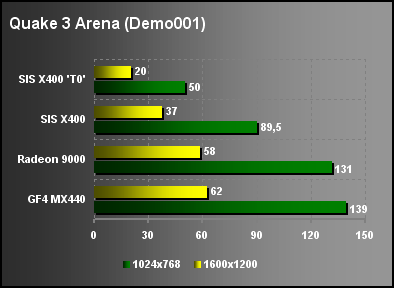

Odchodzący do lamusa Quake3 Arena. W sumie test zrobiony dla przyzwoitości. Prosty układ Demo001. OpenGL.

Przypominam, że tak jak i w pozostałych testach OpenGL, aby jakość obrazu nie denerwowała należy włączyć tryb "0". Po raz kolejny Xabre zostaje rozgnieciony jak pluskwa. I gdzie ta przewaga architektury 4x2?

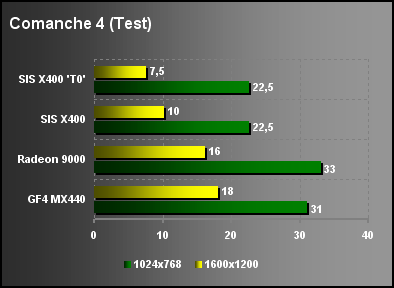

Nie zabraknie i Comanche 4, choć nigdy nie ukrywałem, że trudno mi dobrze zinterpretować wyniki. API: Direct3D.

Znowu przegrana Xabre. To już się staje nudne. Nie było za to problemów z detekcją i użyciem shaderów. Z wiadomych względów GF4MX nie powtórzył tego wyczynu. Na plus SiS'a należy zaliczyć fakt nienagannego obrazu. Paradoksalnie to GeForce przekłamywał niektóre tekstury (wina sterowników 40.xx).

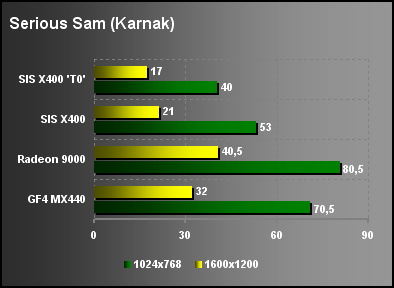

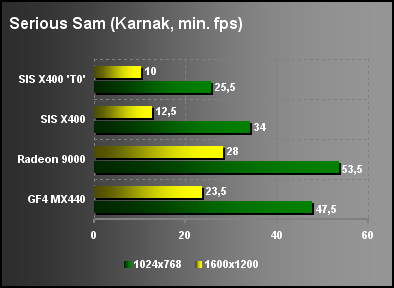

Testy gier OpenGL kończy Serious Sam. Rodzynek w tym API, bo w końcu jest to gra, która nie ma nic wspólnego z IDSoftware. Test Karnak.

Może gra jest wyjątkowa, ale potwierdza regułę Xabre. Rozmaz w default. Dobry obraz w trybie "0". Słaba wydajność.

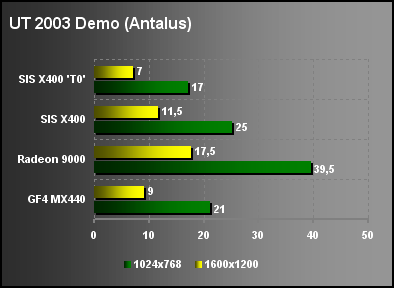

Czas na mocne uderzenie z najnowszego wysypu. Już niemal kultowa pozycja testujących. Unreal Tournament 2003 Demo. Ustawienia HighQuality na podstawie plików ini przygotowanych przez HardOCP. Testy przeprowadzone w Direct3D. Przelot nad Antalusem bez zawodników (Flyby).

W końcu Xabre utarł nos GF4MX440. Oczywiście w trybie domyślnym. Niestety zaczynam żałować, że nie robię testów botmatch. Xabre kompletnie się wtedy rozkłada. Jeśli na tych samych ustawieniach w Antalusie pojawiają się zawodnicy w polu widzenia i zaczynam się ostrzeliwywać to framerate spada do ok. 5 fps. Po męczącej rozgrywce średnia ok. 10 fps. Na Radeonie liczby można śmiało pomnożyć przez dwa lub nawet trzy. Realnie kolejna porażka SiS'a.

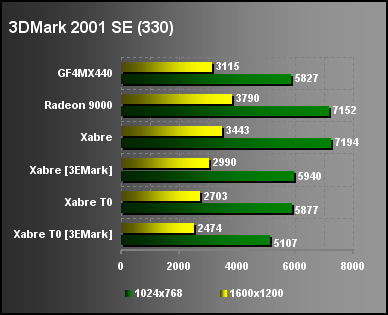

Czyżbym o czymś zapomniał? Nie. 3DMark 2001 SE (build 330) pozostawiłem sobie na koniec.

A tu mamy pewną niespodziankę. Słabiutkie wyniki w grach i zupełnie przyzwoity wynik 3DMarka. Jakby ktoś skoncentrował się tylko na tym teście to uznałby Xabre 400 za godnego przeciwnika dla Radeona 9000. Oczywiście, jeśli przez tryb "0" zrównamy obraz z konkurentami to wyniki są już nieco słabsze, ale jak już pisałem obraz w ustawieniach domyślnych Quality z 3D Wizarda jak dla mnie jest satysfakcjonujący.

Pewnie ktoś się właśnie zastanawia, co to za wyniki dałem w nawiasach kwadratowych? Już wyjaśniam. Pamiętacie aferę z "optymalizacją" Quake'a przez ATI? Albo numer z naliczaniem ramek z tytułów testów 3DMarka do wyniku średniego przez nVidia? Jeśli któryś z testów nijak mi nie pasuje do innych to budzi od razu pewne podejrzenia. Postanowiłem więc sprawdzić czy i SiS nam czegoś nie "wysmażył"? Przygotowałem lekko zmodyfikowaną wersję 3DMarka. Zmiany polegały na nowej nazwie pliku oraz wszystkich odwołań do niej. Za pomocą HexEdit'a powstał w dwie minuty 3EMark (D->E).

3EMark

W ten sposób można najprościej przekonać się czy sterownik nie stosuje dodatkowej optymalizacji dla konkretnego programu. Wynik działania przedstawiłem w tabelce. W nawiasach mamy testy 3EMarkiem a obok 3DMarkiem. Każdy może się do tego odnieść jak chce, ale zwracam uwagę na to, że jak porównamy te wyniki z poprzednimi testami to wydają się one bardziej realne. Różnic w obrazie nie zauważyłem, ale przypominam, że to jest test a nie gra i takie kombinacje nie służą poprawieniu przyjemności z grania, ale określeniu prawdziwych możliwości karty.

Co ciekawego można jeszcze wyczytać z wyników poszczególnych testów dodatkowych?

- Bardzo słaba wydajność PixelShadera. Może się okazać, że w konkretnej grze trzeba będzie po prostu wyłączyć ten efekt, aby odzyskać płynność. Wygląda na to, że jest to dodatek bardziej marketingowy niż użytkowy.

- Niska efektywność architektury. Porównajmy wyniki FillRate z wartościami teoretycznymi (tabela przy opisie technologii). Pomimo dwukrotnie większej ilości TMU i czterech strumieni renderowania Xabre osiąga te same rezultaty, co słabsze "na papierze" układy konkurencji.

- W trybie "0" dwukrotnie spada FillRate w teście mulitexture. Możliwe, że Xabre w trybie "1" po prostu ogranicza ilość nakładanych na piksel tekstur, aby "wyrobić" się na jednym cyklu zegara. To mogłoby świadczyć o braku mechanizmu "loop-back", o którym wspominałem wcześniej.

- Fatalna jakość, ale i zarazem wydajność EMBM.

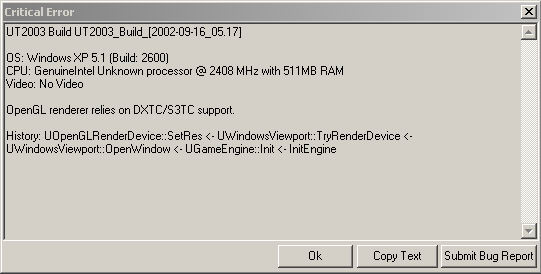

Oprócz tych testów, których wyniki zamieściłem wcześniej próbowałem również grać w inne gry, które miałem zainstalowane w pececie. Muszę przyznać, że programiści SiS'a wykonali kawał dobrej roboty w zakresie kompatybilności z API. Praktycznie każda gra działała bez zarzutów. Żadnych "krzaków czy zwisów". Brawo. W tym względzie SiS od dawna miał złą "prasę" i chyba trzeba będzie przewartościować tą opinię, bo byłaby krzywdząca w stosunku do aktualnych sterowników. Oczywiście nie rozważam kwestii wydajności. Jedynie UT2003 nie odpalił w trybie OpenGL tak jak i Doom3 Alpha.

UT2003 OpenGL

Obie gry wyraźnie i zgodnie zgłosiły brak rozszerzenia S3TC. Sprawdziłem listę możliwości sterownika. Nie ma kompresji. To może być jedna z przyczyn słabości Xabre w OpenGL. Moje wątpliwości w stosunku do wydajności PixelShadera znalazły niestety potwierdzenie w Morrowind.

Morrowind: po lewej karta DX7, po prawej karta DX8

Przy włączonych Shaderach framerate oscyluje w pobliżu 10 fps. I niewiele się z tym da zrobić, bo w 800x600 jest raptem 11 fps, a po ustawieniach jakości w tym trybie na minimum (w grze) nie przekracza 14 fps. Po wyłączeniu shaderów w tym samym miejscu jest już ok. 25 fps i da się spokojnie grać. Tak więc z przyczyn wydajnościowych obraz został sprowadzony do poziomu karty Dx7 czyli np. GF4MX440. Bajer jest, ale jak widać przydatny głównie na ulotkach reklamowych.

Antyaliasing

Xabre udostępnia kilka trybów Fsaa. Przynajmniej teoretycznie, bo w Direct3D nie udało mi się uzyskać trybu x2. Jakość antyaliasingu x4 jest typowa dla rozwiązań supersamplingowych.

Xabre bez FSAA

Xabre FSAA x 2

Xabre FSAA x 4

Niestety typowy jest też spadek wydajności, jaki się z tym wiąże. Żadna z kart z tego przedziału cenowego nie dysponuje dostateczną mocą, aby można było wykorzystać efekt w większych trybach nowych gier. W OpenGL można też odpalić Fsaa x2. Spadek mocy jest mniejszy, ale obraz staje się fatalnie rozmazany. Generalnie nie polecam. Tym bardziej, że w tym API Xabre i tak działa mało wydajnie.

W zasadzie liczby przemawiają same. Bez komentarza.

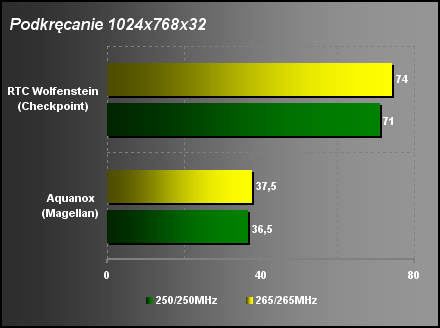

Podkręcanie / słabszy procesor

Kartę udało mi się podkręcić stabilnie do wartości 265/265MHz. Biorąc pod uwagę to, że domyślnie karta jest taktowana 250/250MHz w zasadzie nadtaktowanie traci jakikolwiek sens praktyczny. Różnice są pomijalne.

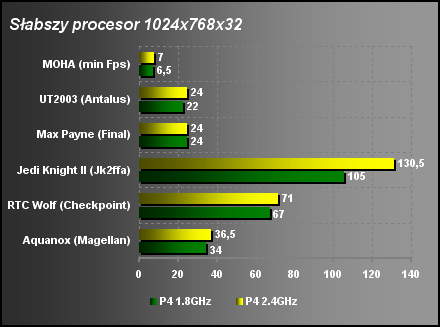

Dodatkowo obniżyłem taktowanie procesora o 25%, aby zobaczyć jaki to ma wpływ na wyniki testów.

W zasadzie nic specjalnego się nie dzieje. Klasycznie najbardziej czuły na taktowanie procesora jest JK2. W pozostałych przypadkach 6-10% niższe wyniki.

Podsumowanie

Niewątpliwie seria Xabre jest najlepszym produktem graficznym firmy SiS. Nigdy również żadna ich karta nie miała tak dobrych sterowników w kwestii zgodności z oprogramowaniem. Niestety i ten układ dotknięty jest tą samą chorobą genetyczną, na którą cierpieli jego poprzednicy. Ma po prostu małą wydajność. Pięknie to wygląda na ulotkach handlowych i tabelkach ze specyfikacją, ale w realnym zastosowaniu wychodzi cała jego słabość. Programiści dali popis działań tuszujących niską wydajność kart Xabre 400, ale nawet, jeśli zaakceptujemy jakość D3D w trybie Quality to i tak nic nie uratuje obrazu w OpenGL. Trzeba modyfikować rejestry, aby dało się to porównać z konkurencją. Na numer z obniżeniem jakości obrazu, aby w testach wypadał lepiej ja się nie mam zamiaru nabrać. Czysty i nieskrępowany pokaz czegoś, co można umownie nazwać benchmarketingiem. Oczywiście ta karta jak najbardziej nadaje się do grania. Największym minusem jest po prostu cena. Za tą kwotę można bez problemu kupić znacznie lepszego Radeona 9000, który nadal pozostaje według mnie liderem tej klasy cenowej. Powiem więcej. Bez chwili wahania wolałbym również GF4MX440 zamiast Xabre 400 pomimo tego, że nie ma zgodności z Dx8. SiS ją ma, ale niewiele z tego wynika w związku z małą wydajnością PixelShadera. Razi również brak filtrowania anizotropowego. Jeśli ktoś ma cień wątpliwości, co do możliwości Xabre 400 to proponuję po 5 min. gry w UT2003 (Antalus) lub Morrowind. "Niezapomniane" przeżycia. Cena karty musiałby być niższa, co najmniej o 1/3, aby mogła wzbudzić moje zainteresowanie. Tym razem nie będzie znaczka jakości TwojePC.

Na koniec zestawienie wad i zalet:

Zalety:

- Dobra zgodność sterowników z oprogramowaniem.

- Bardzo dobra jakość i funkcjonalność wyjścia telewizyjnego.

- Obsługa sprzętowa Dx 8.

Wady:

- Wysoka cena biorąc pod uwagę wydajność lub inaczej ujmując niska wydajność biorąc pod uwagę cenę.

- Słaba jakość obrazu 3D w OpenGL na ustawieniach sterownika.

- Brak funkcji filtrowania anizotropowego.

- Niewielkie możliwości regulacji parametrów 3D z poziomu sterowników i oprogramowania narzędziowego.

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | Sklep Internetowy Sirius Computers |

|