|

TwojePC.pl © 2001 - 2026

|

|

Poniedziałek 27 lipca 2020 |

|

| |

|

A12Z Bionic korzystając z natywnego kodu pokazuje przysłowiowy pazur

Autor: Wedelek | źródło: Hot Hardware | 05:30 |

(14) |  Apple ogłosiło w tym roku, że w przeciągu najbliższych dwóch lat zrezygnuje z procesorów Intela i będzie montować w swoich Macach własne CPU zbudowane w oparciu o architekturę ARM. To oczywiście wywołało sporą burzę wśród komentatorów, a niedługo później do sieci wyciekły pierwsze testy wydajności zestawów deweloperskich, wyposażonych w 8-rdzeniowy A12Z Bionic (4x Vortex + 4x Tempest), które mają służyć programistom jako pomoc w przepisaniu istniejącego kodu na potrzeby ARM. Skorzystano w tym przypadku z Geekbencha 5, który w emulowanym* środowisku osiągnął wynik odpowiednio około 830pkt i 2800pkt w testach jednego wątku oraz wielordzeniowym. Apple ogłosiło w tym roku, że w przeciągu najbliższych dwóch lat zrezygnuje z procesorów Intela i będzie montować w swoich Macach własne CPU zbudowane w oparciu o architekturę ARM. To oczywiście wywołało sporą burzę wśród komentatorów, a niedługo później do sieci wyciekły pierwsze testy wydajności zestawów deweloperskich, wyposażonych w 8-rdzeniowy A12Z Bionic (4x Vortex + 4x Tempest), które mają służyć programistom jako pomoc w przepisaniu istniejącego kodu na potrzeby ARM. Skorzystano w tym przypadku z Geekbencha 5, który w emulowanym* środowisku osiągnął wynik odpowiednio około 830pkt i 2800pkt w testach jednego wątku oraz wielordzeniowym.

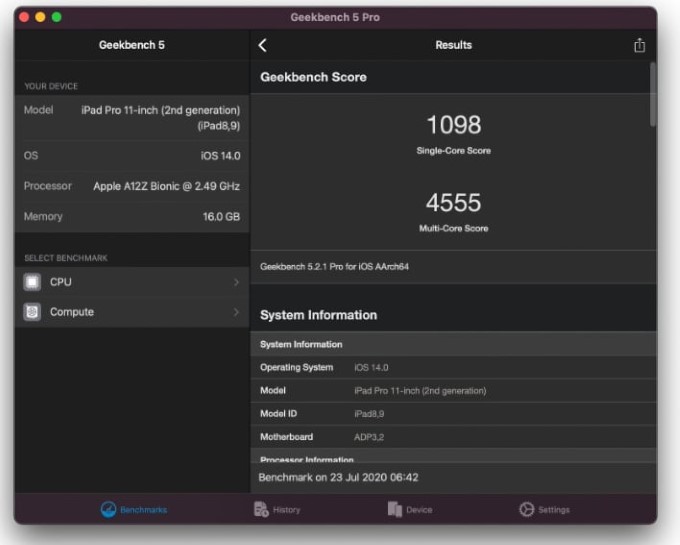

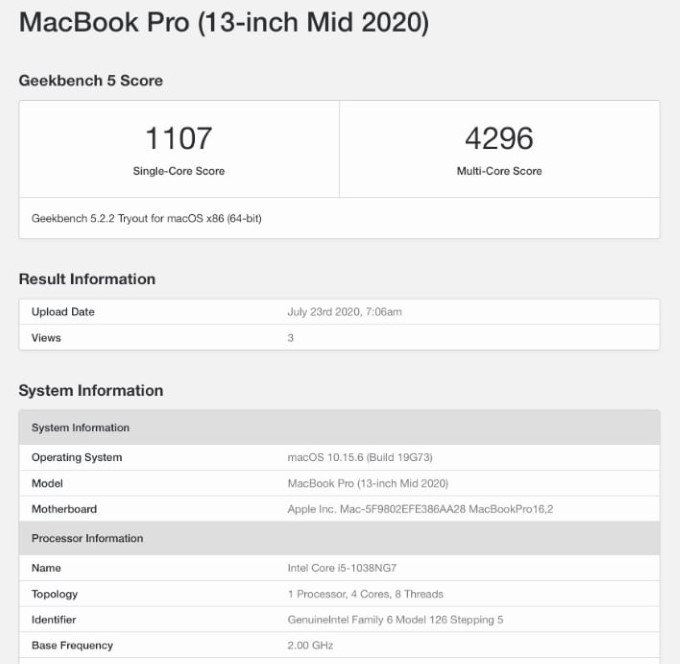

Już to dawało nam jakie takie pojęcie na temat wydajności opisywanego układu, ale pełen obraz sytuacji uzyskaliśmy dopiero po wykorzystaniu natywnego klienta stworzonego z myślą o procesorach ARM, którego niedawno udało się odpalić w Mac OS Big Sur. A12Z Bionic uzyskał w nim wynik 1098/4555pkt, a więc mniej więcej taki, jaki w GeekBenchu 5 zdobywa Core i5-1038NG7 (Ice Lake, 2GHz, 4R/8W) zamontowany w 13-calowym MacBooku Pro (2020). Nie da się ukryć, że to bardzo dobry rezultat.

Dodam do tego, że pierwszy procesor Apple dla Maców będzie znacznie wydajniejszy od A12Z Bionic i otrzyma 8 mocnych rdzeni oraz 4 słabsze, a także stworzony przez Apple układ IGP. Zapowiada się więc ciekawie, tym bardziej, że jego debiut nastąpi już niebawem, bo pod koniec 2020 roku.

*Drobne wyjaśnienie. Apple korzysta w MacOS BigSur z oprogramowania Rosetta, które jest binarnym translatorem kodu. Jego zadaniem jest tłumaczenie w locie niskopoziomowych instrukcji i przekształcanie ich w kod natywny dla danego procesora. Taka operacja jest bardziej efektywna niż gdybyśmy korzystali z tradycyjnego emulatora, ale i tak nie pozostaje bez wpływu na wydajność, co zresztą widać po zamieszczonych w artykule wynikach testów.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- hmmm (autor: mlc | data: 27/07/20 | godz.: 07:58)

to jest CPU z iPadów, wygląda więc na to, że nowy układ Apple rozniesie w pył laptopowe x86

- Tia (autor: Kenjiro | data: 27/07/20 | godz.: 08:52)

Porównywanie wyników Geekbencha na różnych platformach jest kompletnie idiotyczne, bo Gb skaluje wyniki.

Poczekajmy aż ktoś np. zmierzy czas kompilacji Linuksa...

- takie porównania (autor: Markizy | data: 27/07/20 | godz.: 08:59)

Nie mają sensu bo benchmarki można oszukiwać. Lepiej niech pokażą coś typu czas ładowania 20stron, obróbka zdjęć czy nawet gry gdzie wydajność zależy od mocy cpu, np przeliczanie tury civilization

- nvidia kupi arm (autor: bajbusek | data: 27/07/20 | godz.: 10:26)

i tyle z ucieczki apple od intela ;)

- @bajbusek (autor: Promilus | data: 27/07/20 | godz.: 13:14)

Heh, to sobie wrócą do Power ...

- bajbusek (autor: pawel1207 | data: 27/07/20 | godz.: 14:13)

to dla apple nic nie zmienia ..

- @6. (autor: Kenjiro | data: 27/07/20 | godz.: 14:32)

Nie do końca, bo nVidia może stwierdzić, że tanie licencje im nie pasują i zwiększy cenę kilkukrotnie, by licencjonowane CPU nie konkurowały z ich własnymi.

Apple byłoby wtedy w ciemnej d...

- @07 (autor: ligand17 | data: 27/07/20 | godz.: 14:56)

Dokładnie. W końcu VMWare tak zrobiło z licencjami na Epyc'i - dla CPU powyżej 28 rdzeni cena x2.

- Ale glupie teksty... (autor: gantrithor | data: 27/07/20 | godz.: 15:35)

ze nvidia kupi arm czy x86 , licencja nie jest problemem ale oplaty patentowe sa sporym wyzwaniem biznesowym jak sobie wyobrazacie sprzedawac procesory ktore maja ogromna marze spowodowana oplata licencyjna?

Oplaty za interfejsy podsystemow pamieci ,strukture cache , budowe i dzialanie predyktorow , instrukcje przewidujace rozgalezienia to tylko kilka przykladow a zaby zbudowac procesor potrzeba na start okolo 5000-6000 patentow latwiej powiedziec niz zrobic.

Arm jest duzo tansza opcja ale nie jest kompatybilna z modelem biznesowym nvidia gdzie nvidia trzepie kase przy sprzecie x86 a tym czasem w arm jest adreno i mali oraz kilka innych mniejszych firm posiadajacych wlasne rozwiazania jak apple.

Co do tego benchmarka zobaczymy w testach jak to wypadnie , kompresja/dekompresja plikow , gry , photoshop , konwertowanie video itd itp.

Kiedys widzialem jak gosciu na yt odpalil benchmark na emulatorze androida wtedy najwyzszy wynik byl 210 000 na jakims flagowym snapradonie a na emulatorze gosc mial 1.400 000 punktow na pc z procesorem i5.

- @8. (autor: pwil2 | data: 27/07/20 | godz.: 18:56)

Nie 28c, a 32c. EPYC 1x64c kosztuje tyle ile 2x28c Intela.

- @9 :) (autor: Sebalos | data: 27/07/20 | godz.: 19:33)

Licencja jest na korzystanie z opatentowanego rozwiązania.

- @ganthritor (autor: Promilus | data: 27/07/20 | godz.: 21:05)

Eee... nie bardzo rozumiem o co ci chodzi. Przecież nvidia wcale nie związała się z x86, baa, jej produkty mają drivery i dla powera, i dla arma (tesle, a w zasadzie już nie tesle). A jej SoCe (tegra) są na ARM, a nie x86. Baaa, nawet drivery do RTX2080 są już na linuxa Aarch64 ;) Innymi słowy żyjesz w innym świecie i nie orientujesz się jak jest w rzeczywistości.

- @11 jesli kupisz licencje od via... (autor: gantrithor | data: 28/07/20 | godz.: 20:30)

to nie bedziesz mial automatycznie rozwiazan patentowych intela czy amd

@12 No widac ze nie zrozumiales i fajnie masz ze ty jako jedyny sie orientujesz co sie dzieje na swiecie.

- @ganthritor (autor: Promilus | data: 29/07/20 | godz.: 08:31)

"nie jest kompatybilna z modelem biznesowym nvidia gdzie nvidia trzepie kase przy sprzecie x86" jeśli nie wyjaśnisz tych słów z przykładami to oznacza, że jesteś trollem i to marnym. Czego w tym można nie zrozumieć? Zrozumiałem, nie zgadzam się i jestem w stanie podać przykłady (baa, już podałem!) że jesteś w błędzie. Pokaż mi gdzie w błędzie jestem ja, uargumentuj, a jeśli nie to skończ pisać farmazony.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|