|

TwojePC.pl © 2001 - 2026

|

|

Poniedziałek 19 maja 2025 |

|

| |

|

Nvidia wprowadza TensorRT – API przyspieszające AI

Autor: Wedelek | źródło: WCCFTech | 06:33 |

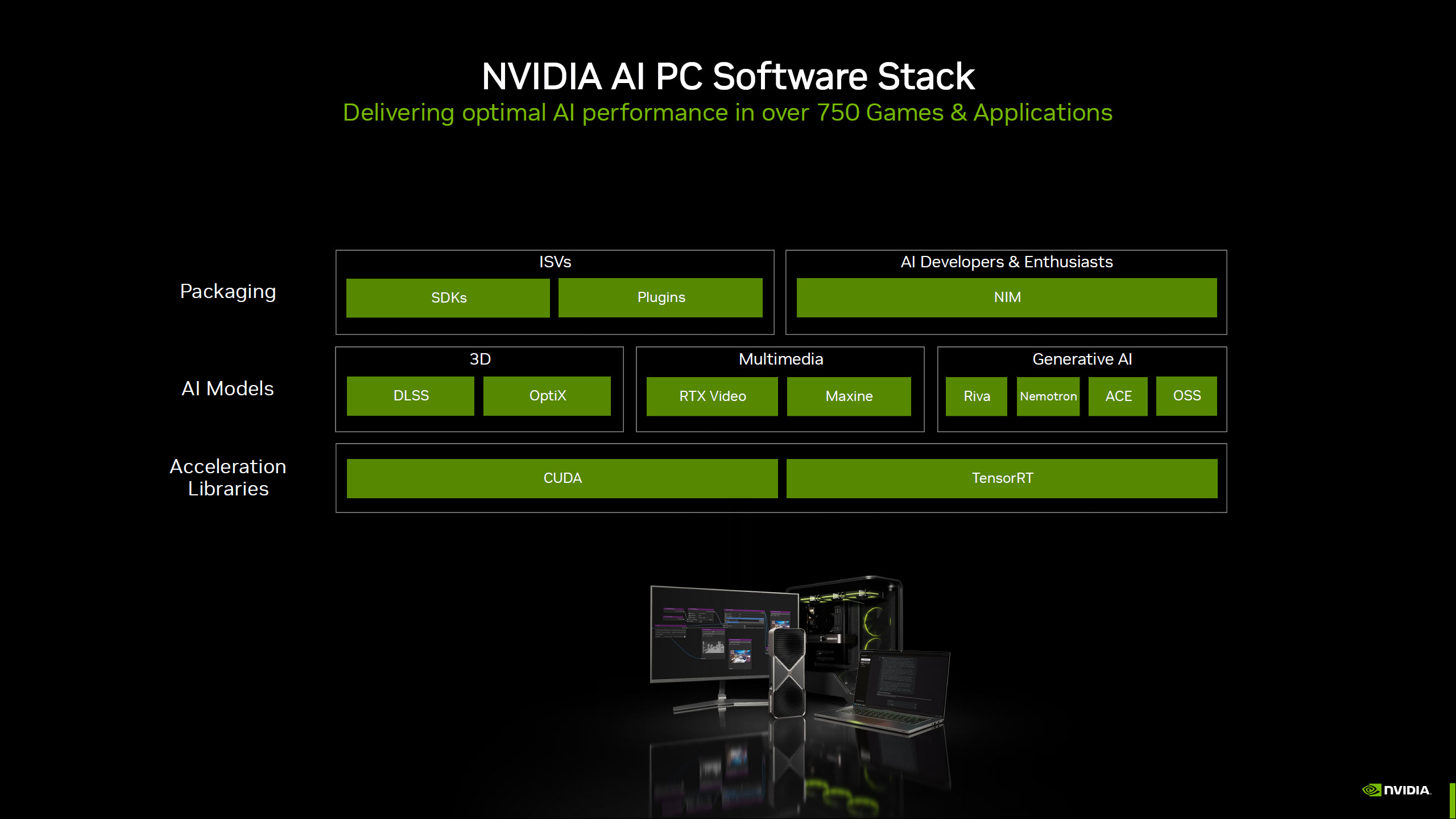

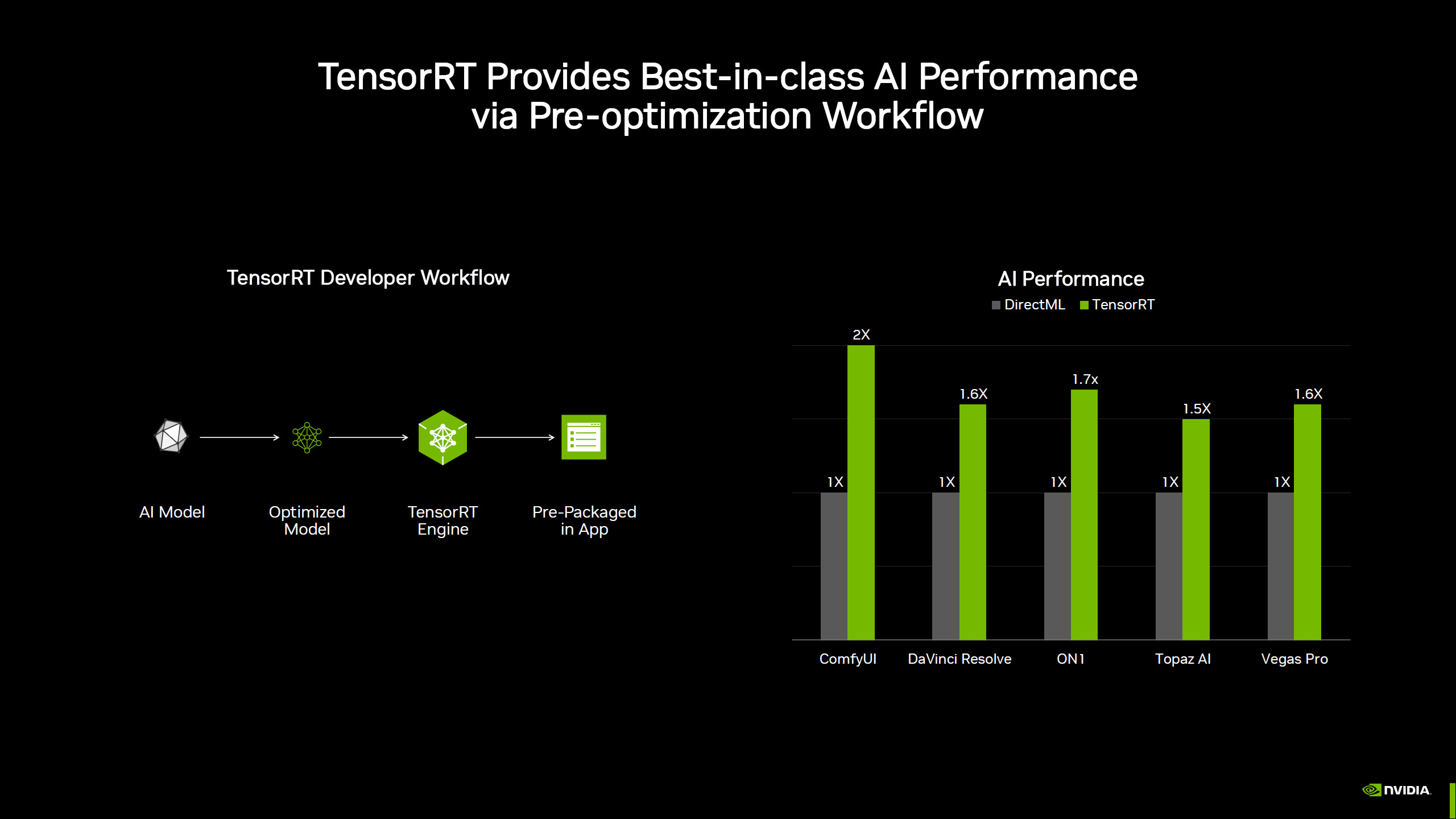

|  NVIDIA wprowadziła do oferty nowy interfejs API o nazwie TensorRT, który będzie dostępny dla wszystkich kart graficznych z rodziny GeForce RTX. Nowe rozwiązanie zapewnia natywną obsługę dedykowanych jednostek bezpośrednio przez interfejs Windows ML, który automatycznie wykorzystuje zoptymalizowaną bibliotekę TensorRT jako warstwę wykonawczą dla algorytmów związanych z AI. Dzięki temu użytkownicy mogą liczyć na znacznie szybsze działanie aplikacji korzystających z AI, takich jak ComfyUI (2x szybciej), DaVinci Resolve czy Vegas Pro (60% szybciej). NVIDIA wprowadziła do oferty nowy interfejs API o nazwie TensorRT, który będzie dostępny dla wszystkich kart graficznych z rodziny GeForce RTX. Nowe rozwiązanie zapewnia natywną obsługę dedykowanych jednostek bezpośrednio przez interfejs Windows ML, który automatycznie wykorzystuje zoptymalizowaną bibliotekę TensorRT jako warstwę wykonawczą dla algorytmów związanych z AI. Dzięki temu użytkownicy mogą liczyć na znacznie szybsze działanie aplikacji korzystających z AI, takich jak ComfyUI (2x szybciej), DaVinci Resolve czy Vegas Pro (60% szybciej).

Nvidia zapewnia, że nowy backend zaoferuje 8-krotne zmniejszenie rozmiaru bibliotek używanych w obliczeniach związanych z AI, a dzięki integracji z Windows ML i ONNX Runtime, deweloperzy nie muszą już optymalizować ręcznie kodu dla różnych rozwiązań. System ma sam wybierać i pobierać odpowiednie komponenty i optymalizacje

Przy okazji NVIDIA rozszerzyła także ekosystem AI na PC, wprowadzając nowe narzędzia i aktualizacje do ponad 150 SDK oraz integrując rozwiązania AI w popularnych aplikacjach, takich jak LM Studio, Topaz Video AI czy AutoDesk VRED.

|

| |

|

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|