|

TwojePC.pl © 2001 - 2026

|

|

Środa 11 czerwca 2025 |

|

| |

|

Platforma Helios, środowisko ROCm 7 oraz Instinct MI350 z CDNA4

Autor: Wedelek | źródło: AMD | 06:58 |

|  Podczas konferencji Advancing AI 2025 AMD przedstawiło swoją koncepcję opartej na branżowych standardach, kompleksowej, otwartej i skalowalnej infrastruktury dla sztucznej inteligencji. Centralnym punktem pokazuj były układy Instinct MI350 wspierające całkiem nowe środowisko programistyczne ROCm 7 i działające w ramach programu Developer Cloud Access, który ma uprościć rozwój projektów związanych ze sztuczną inteligencją. Podczas konferencji Advancing AI 2025 AMD przedstawiło swoją koncepcję opartej na branżowych standardach, kompleksowej, otwartej i skalowalnej infrastruktury dla sztucznej inteligencji. Centralnym punktem pokazuj były układy Instinct MI350 wspierające całkiem nowe środowisko programistyczne ROCm 7 i działające w ramach programu Developer Cloud Access, który ma uprościć rozwój projektów związanych ze sztuczną inteligencją.

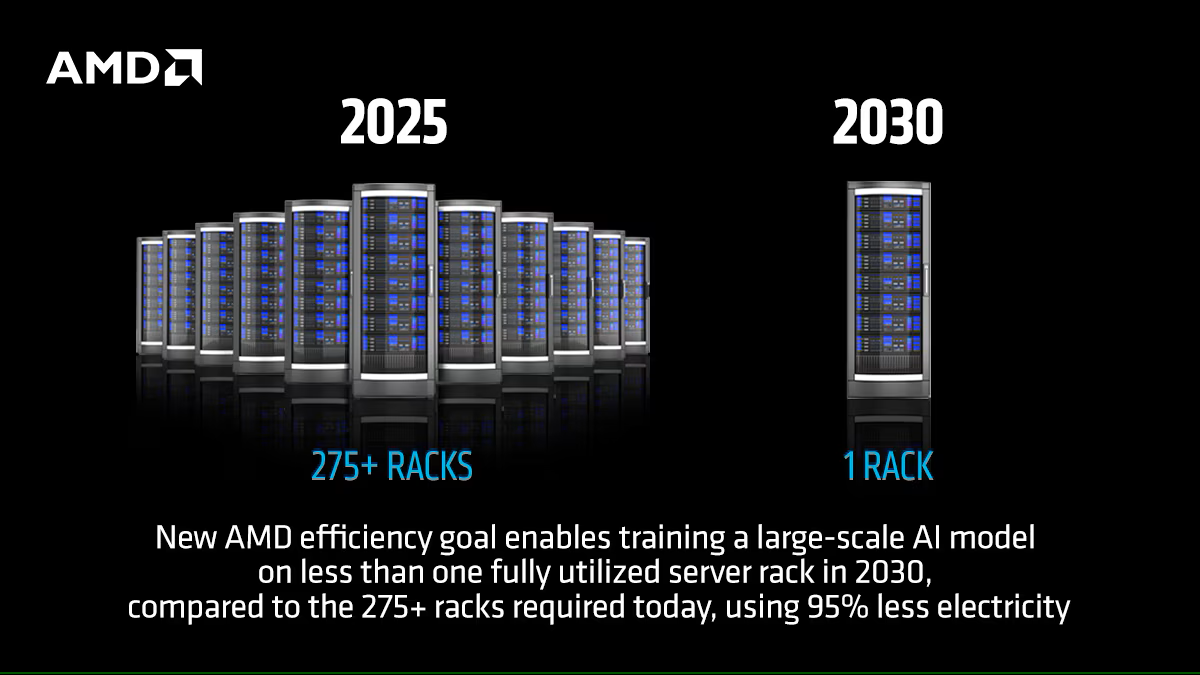

W trakcie wydarzenia AMD podkreśliło, że konsekwentnie realizuje ambitny plan rozwoju, której kolejnym etapem ma być Helios, czyli nowoczesny, w pełni zintegrowany system rackowy, oparty na nadchodzących generacjach produktów firmy. Platforma Helios będzie wykorzystywać najnowsze akceleratory MI400, procesory EPYC „Venice” oraz kontrolery Pensando „Vulcano”. Zapowiedziano, ma ona trafić do partnerów w przyszłym roku, ale dokładnej daty nie podano.

Od strony sprzętowej ciekawie prezentowały się też akceleratory Instinct MI350X i MI355X, oferujące zdaniem AMD czterokrotnie wyższą wydajność obliczeniową oraz trzydziestopięciokrotny wzrost wydajności we wnioskowaniu względem poprzedniej generacji. Model MI355X ma się również wyróżniać korzystnym stosunkiem wydajności do ceny, generując nawet 40% więcej tokenów na jednego dolara w porównaniu do rozwiązań konkurencji.

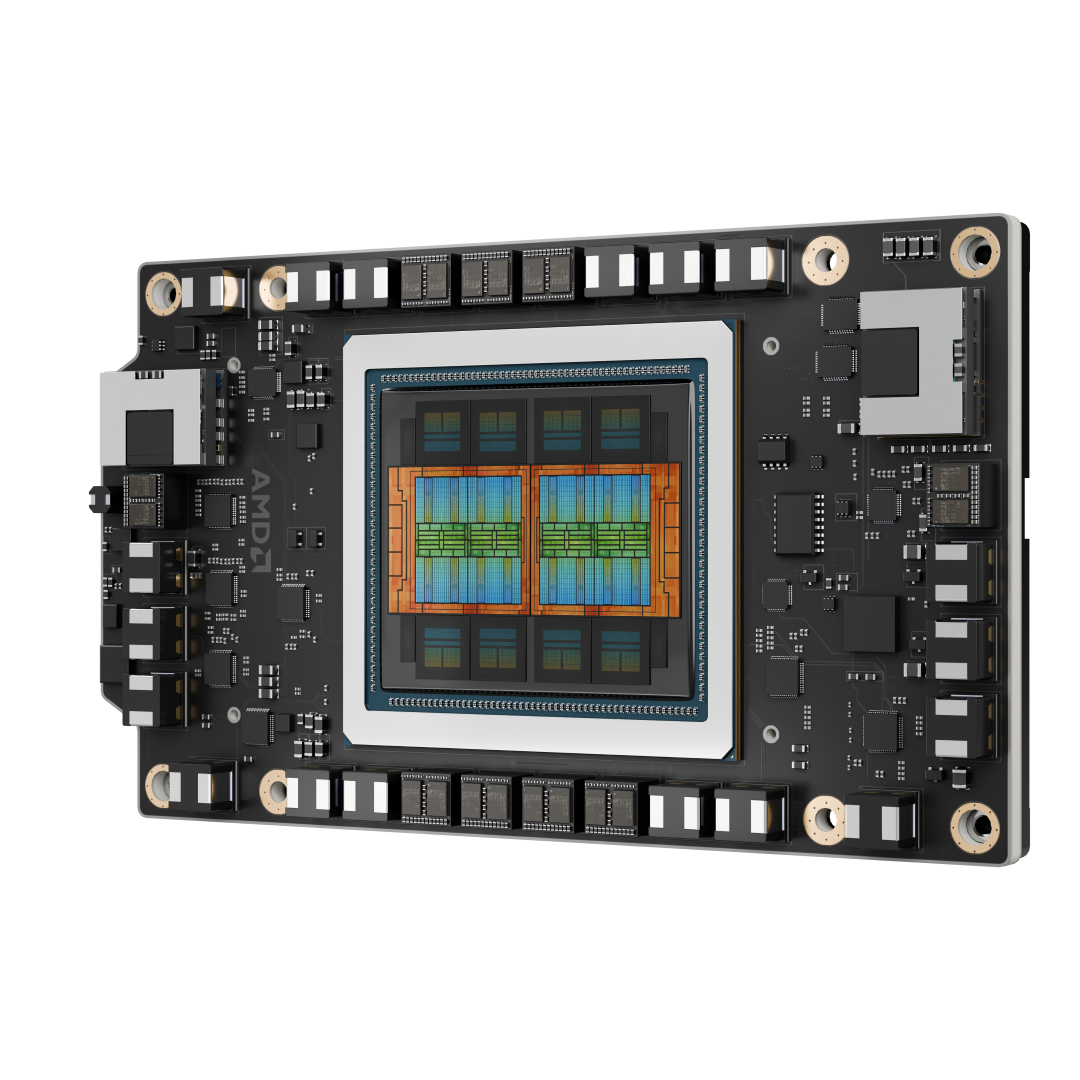

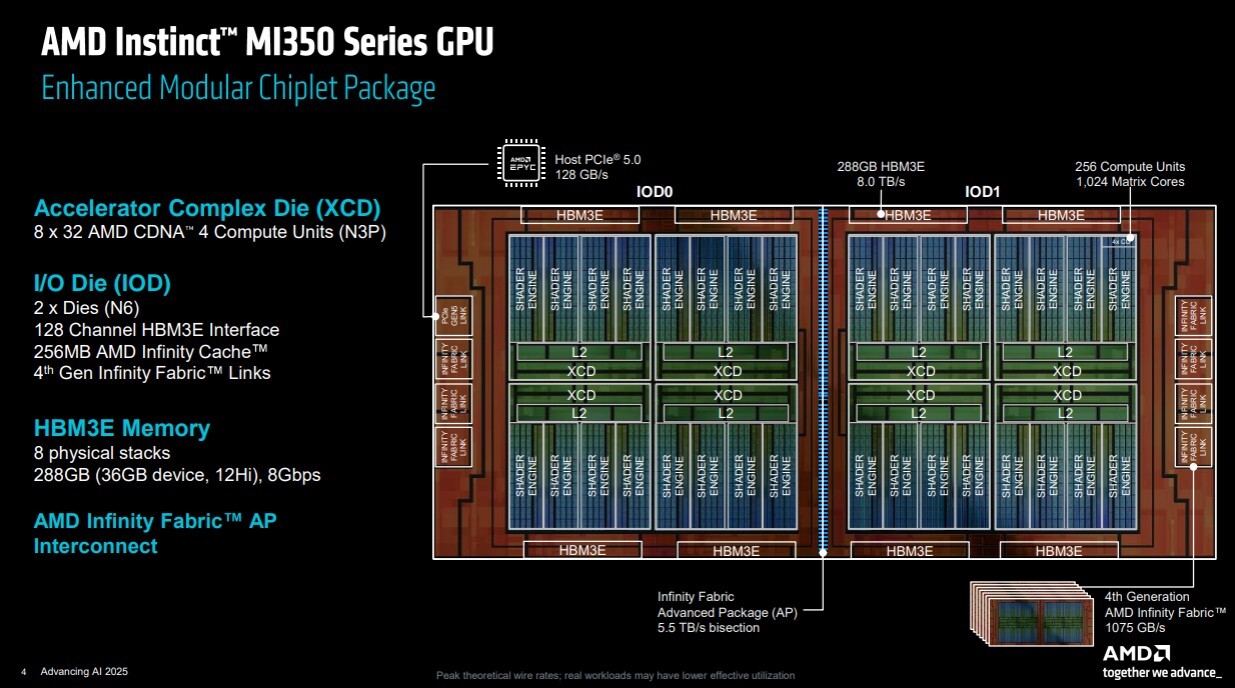

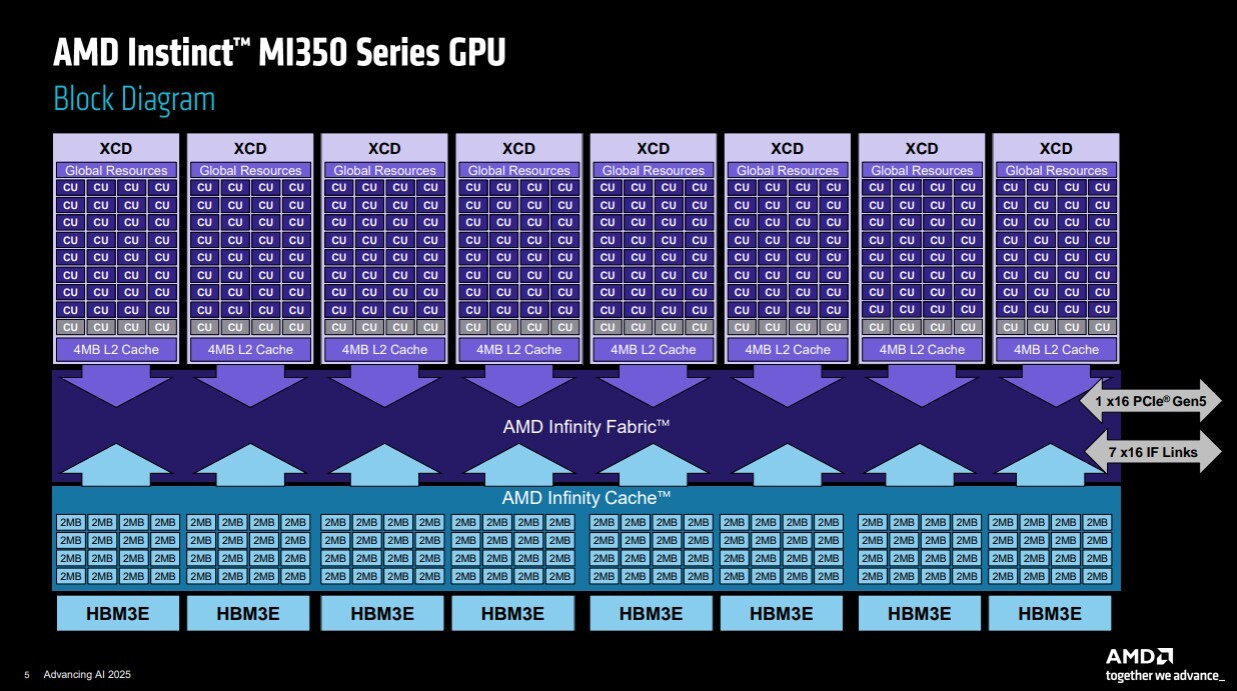

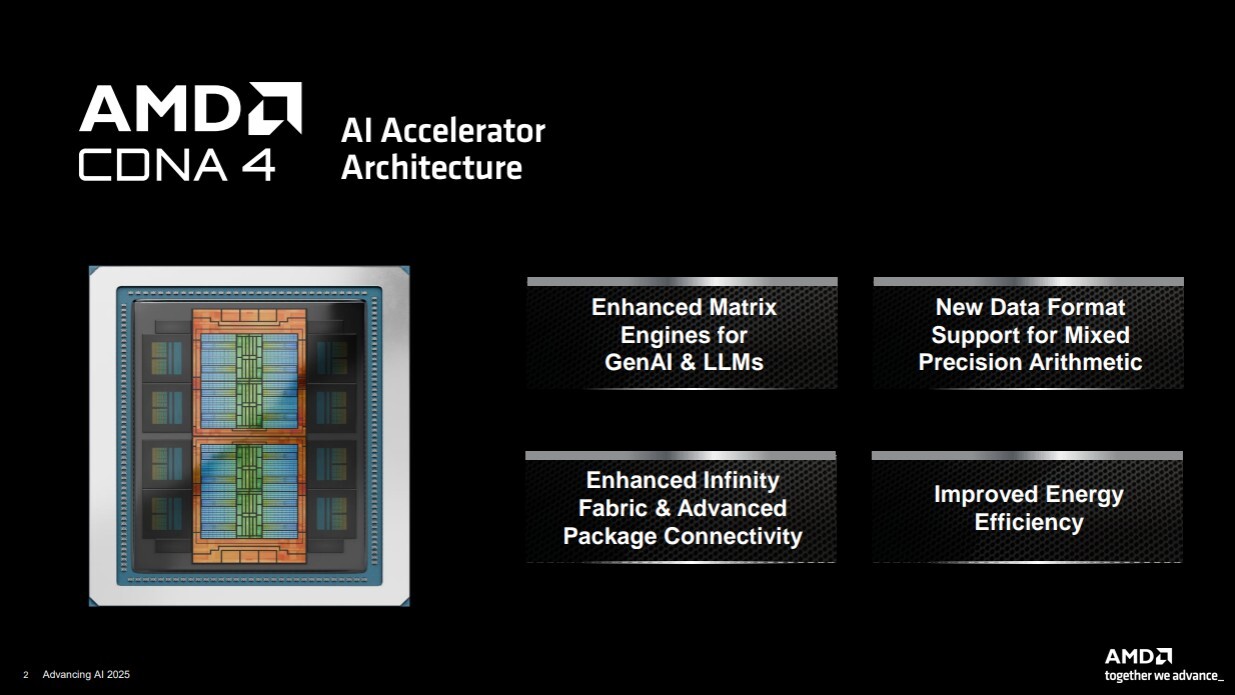

MI350 to ogromny procesor graficzny AI oparty na budowie chipletowej i zbudowany z wykorzystaniem architektury CDNA 4. Składa się on z dwóch podstawowych płytek zwanych IOD (I/O dies), z których każda jest wykonana w procesie technologicznym TSMC N6. Na każdej z nich AMD układa maksymalnie cztery warstwy XCD (Accelerator Compute Die ) ułożone jedna na drugiej. Same płytki XCD są wykonane w technologii TSMC N3P. Zawierają one 4 MB pamięci podręcznej L2 oraz cztery silniki shaderów, z których każdy ma 9 jednostek obliczeniowych. XCD ma więc 36 jednostek obliczeniowych (CU), co przekłada się na maksymalnie 144 CU dla IOD.

Oprócz tego każdy IOD ma 128-kanałowy kontroler pamięci HBM3E, 256 MB pamięci Infinity Cache, interfejsów Infinity Fabric oraz kontroler PCI-Express 5.0 x16 Dwa IOD są połączone dwukierunkowym interkonektem o przepustowości 5,5 TB/s, który umożliwia szybką wymianę danych. Cały pakiet ma łącznie 288 CU. Dodatkowo każdy IOD otrzymał cztery stosy pamięci HBM3E o łącznej pojemności 144 GB - 288 GB dla pakietu.

W prezentacji udział wzięli pracownicy firm Meta, OpenAI, Microsoft czy xAI, którzy podzielili się doświadczeniami związanymi z wdrażaniem i trenowaniem zaawansowanych modeli AI na platformie AMD. Jak nie trudno się domyślić zachwytów i pochwał nie było końca. Wśród partnerów obecnych na konferencji znaleźli się również Oracle, HUMAIN, Red Hat i Marvell.

|

| |

|

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|