|

TwojePC.pl © 2001 - 2026

|

|

Środa 14 kwietnia 2004 |

|

| |

|

Premiera GeForce Seria ''6'': czapki z głów!

Autor: Kris | 19:10 |

(46) |  Panie i Panowie, dziś, 14 kwietnia 2004, nVidia Corporation przedstawiła światu swój najnowszy produkt przeznaczony dla miłośników gier komputerowych. Układ o nazwie kodowej NV40 przybrał wymierną formę karty graficznej GeForce 6800 Ultra. Jednocześnie z oficjalną prezentacją na stronie producenta, wybrane serwisy sprzętowe zamieściły wstępne testy tego cacka: Beyond3D, Clubic, Extremetech, Firingsquad, Guru3D, HardOCP, Hardware Analysis, Hardware FR, KHardware, Tech Report, Tom's Hardware. Panie i Panowie, dziś, 14 kwietnia 2004, nVidia Corporation przedstawiła światu swój najnowszy produkt przeznaczony dla miłośników gier komputerowych. Układ o nazwie kodowej NV40 przybrał wymierną formę karty graficznej GeForce 6800 Ultra. Jednocześnie z oficjalną prezentacją na stronie producenta, wybrane serwisy sprzętowe zamieściły wstępne testy tego cacka: Beyond3D, Clubic, Extremetech, Firingsquad, Guru3D, HardOCP, Hardware Analysis, Hardware FR, KHardware, Tech Report, Tom's Hardware.

Wcześniej nie dałem się namówić na komentowanie kolejnych, mniej lub bardziej "zaszumionych" informacji na temat nadchodzącego układu, ale teraz już można chyba napisać kilka zdań, które spróbują przybliżyć znaczenie prezentacji NV40. Bez obawy. Będzie raczej krótko i w miarę możliwości, przystępnie.

GeForce 6800 Ultra (proszę zwrócić uwagę na zniknięcie w nazwie "FX") jest najmocniejszą kartą, która opiera się na pierwszym na świecie układzie, który z czystym sumieniem można zaliczyć do nowej generacji. Po niezbyt udanej (to nie tylko moje własne zdanie) serii FX inżynierowie nVidia bardzo sumiennie przyłożyli się do przygotowania nowego układu. Ostatnie prezentacje pseudo-nowych produktów FX oraz Radeon z górnej półki wydajnościowej wraz z typowym hałasem medialnym miały za zadanie zatrzeć oczywisty fakt odgrzewania starych kotletów za pomocą drobnych korekt hardware i stopniowego zwiększania taktowania podzespołów.

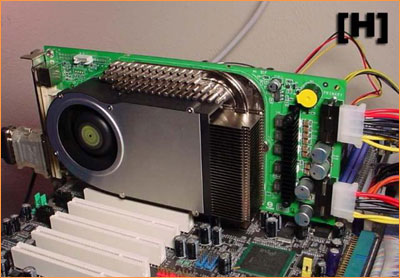

Karta referencyjna NVidii (c) HardOCP (kliknij, aby powiększyć)

Karta referencyjna NVidii (c) HardOCP (kliknij, aby powiększyć)

Karta referencyjna NVidii (c) HardOCP (kliknij, aby powiększyć)

Tym razem, po raz pierwszy od dłuższego czasu zaserwowano nową architekturę. Już lektura samej specyfikacji może rzucić na kolana co wrażliwszych entuzjastów sprzętu służącego do generowania obrazu gier komputerowych. Co ważne, jak pokazują pierwsze testy, tym razem na specyfikacji nie kończy się siła nowego układu. Wszystko wskazuje na to, że GeForce 6800 Ultra faktycznie bez trudu gromi wydajnością wszystkie karty poprzedniej generacji. Mało tego. Wygląda na to, że wraz z wydajnością pójdzie w parze również jakość generowanego obrazu.

Nowa "maskotka" NVidii

To co najbardziej bolało w przypadku serii FX, czyli wydajność PixelShadera oraz stosunkowo słaba jakość wygładzania rantów obiektów (FSAA) zostało zmienione i wzmocnione. Wygładzanie w końcu przyjęło metodę zbliżoną do oferowanej przez konkurencję i jakościowo obie implementacje są teraz bardzo zbliżone. Te wszystkie fragmenty sceny 3D, na których FX potykał się (w porównaniu do Radeonów) nie sprawiają nowym kartom najmniejszych problemów. Brawo. Skąd jednak ta gigantyczna wydajność wynikająca wprost z wyników pierwszych testów? Kolejna sztuczka marketingowa? Jakiś haczyk? Chyba nie tym razem. Wystarczy przyjrzeć się architekturze NV40 i powiązać fakty. Jest to o tyle łatwe, że tym razem nVidia w końcu nie ma oporów przed rozjaśnianiem struktury i funkcjonowania swojego nowego produktu zainteresowanym.

Po pierwsze mamy faktyczną rewolucję w dziedzinie przetwarzania pikseli. Zamiast czterech potoków FX5950U (jedynie w pewnych zadaniach starsze układy zachowywały się jakby miały ich osiem) mamy ich szesnaście. I do tego działają w pełni równolegle, podobnie jak osiem potoków w układach ATI R3x0 (tylko jest ich dwa razy więcej). Wzrosła również do sześciu, ilość jednostek Vertex. O gigantycznej skali projektu nVidia świadczy również wręcz nieprawdopodobna ilość tranzystorów upchanych w rdzeniu graficznym. Ze 130 milionów (NV38) ich liczba wzrosła do 220 milionów ! Rdzeń procesora Pentium 4 HT Extreme Edition wygląda przy NV40 zdecydowanie mało "atrakcyjnie". Aby GeForce 6800 Ultra mógł jednak powalać wydajnością musi mieć przy tym odpowiednie taktowanie. 400MHz przy takiej ilości tranzystorów i chłodzeniu powietrzem jest sporym osiągnięciem.

Oczywiście nic za darmo. nVidia zaleca stosowanie zasilacza 480W (!), z którym karta łączy się dwoma niezależnymi liniami energetycznymi (+ obciążenie AGP). Sądzę, że jest to albo przesada albo zakładanie działania w skrajnie "energetycznym" pececie, choć mam nadzieję, że nikt nie wpadnie na pomysł ciągnięcia tego słonia jakąś tanią 400-tką (warto IMHO zakładać min. 300 zł z przeznaczeniem na uczciwej klasy zasilacz). Co do kwestii głośności chłodzenia to sugeruję poczekać na docelowe karty producentów. Egzemplarze referencyjne (wg. opinii testujących) nie należały do cichych (głośniejsze od R9800XT i FX5950U), ale i nie był to huragan, jaki tworzył pierwszy FlowFX (NV30).

Rdzeń współpracuje z pamięciami GDDR-3 taktowanymi częstotliwością 550MHz (transfer 1.1GHz). Nie jest to może skok przepustowości adekwatny do wzrostu mocy rdzenia, ale z testów można wysnuć wniosek, że udało się zoptymalizować transfer danych tak, aby szyna pamięci pozwalała rozwinąć karcie skrzydła. Muszę przyznać, że jestem pod wrażeniem. Wstępnie, sugerowana cena nowej karty ma wynosić ok. $500 (niekoniecznie chodzi tu o Polskę), a pierwsze egzemplarze powinny pojawić się na światowych rynkach na początku czerwca.

GeForce 6800 Ultra pozostaje "flagowym" produktem nowej serii 6xxx, ale oczywiście będą również wersje bardziej "ubogie". Recenzenci piszą o GeForce 6800 (bez Ultra) zbudowanym na odchudzonym układzie, z 12-stoma potokami renderującymi, pamięciami DDR-1, mniejszym apetycie na energię i w zdecydowanie niższej cenie. Po tym co pokazał najwyższy model brzmi to przynajmniej zachęcająco.

Moim zdaniem premiera GeForce 6800 Ultra wypadła wręcz zaskakująco dobrze i chyba faktycznie tak dużego skoku wydajności pomiędzy kolejnymi premierami nVidia jeszcze na swoim koncie nie miała. Jedynie co może (przynajmniej teoretycznie) zmącić kwietniową sielankę producenta to nadchodząca prezentacja nowej generacji kart konkurencji. Entuzjazmując się wynikami dzisiejszych testów pamiętajmy, że wśród porównywanych kart tylko jedna stanowi nową jakość. Czy zapowiadany układ ATI R420 jest w stanie nawiązać równorzędną walkę z nowym GeForce'em? Z punku widzenia konsumenta byłoby oczywiście lepiej gdyby się tak stało. Mam nadzieję, że już niedługo się o tym przekonamy... |

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- no no (autor: Carmamir | data: 14/04/04 | godz.: 19:22)

karta nieźle się zapowiada :)

- cos nie mozna.. (autor: LegioN | data: 14/04/04 | godz.: 19:34)

sciagnoc tych demek na stronie nvidi , czy tylko tak u mnie ??

- LegioN ... (autor: DYD-Admin | data: 14/04/04 | godz.: 19:38)

...nie tylko u Ciebie, na razie WWW sie sypie NVidii i demek nie ma, tylko zrzuty ekranow... wczesniej na www.nvidia.com znalazlem screensaver i walpapper z Syrenka, ale nic szczegolnego...

- Coz testy (autor: ein | data: 14/04/04 | godz.: 19:41)

nie pozostawiaja watpliwosci... to sprzet z poteznym potencjalem, dzisiejsze systemy nie sa w stanie wycisnac pelni mocy. W najwyzszych rozdzialkach mozna grac w hq przy ponad 60 klatkach na sekunde. Wielki come back nvidii. W sumie to ten sprzet wyprzedza swoje czasy - imho dopiero w przyszlym roku beda powszechnie dostepne odpowiednio szybkie procesory i na tyle zlozone gry aby w pelni uwidocznic moc tego potwora. Niezle!

- he he he 480 wat he he he wielki jak krowa hehe (autor: blimek | data: 14/04/04 | godz.: 19:50)

głośniejszy od fx 5950 he he he

he

- [;..;] (autor: GesTee | data: 14/04/04 | godz.: 20:37)

pomijajac to wszystko jak zuwazył blimek ffs karta jes duuuuza dłuuuga z dodatkowymi zasilkami to długa jak płyta głowna prawie do tego radiatorek niemały a agp waziutkie i kruche ;)

- śmierdzi kolejnym oszustwem :( (autor: Mario2k | data: 14/04/04 | godz.: 20:43)

No niby jest w bardziej zaawansowanych grach szybciej o 35-50%

ale oszukują na jakości grafiki ,oj będzie głośno

bo jak by tak a Radku 9800Pro poexperymentować z obnizeniem dokładności obliczeń na texturach to pewnie różnica

pomiędzy GF6800 a Radeonem 9800XT była by minimalna.

oto jeden z linków z widocznymi oszustwami w wyświetlaniu grafiki

http://www20.tomshardware.com/...orce_6800-46.html

- Poczekajmy, poczekajmy.. (autor: GregorP-Redakcja | data: 14/04/04 | godz.: 20:59)

j.w.

- nie jest tak kolorowo (autor: Mario2k | data: 14/04/04 | godz.: 21:07)

Jeśli znowu okaże sie że NVidia 20% mocy w nowych układach zawdzięcza cwanym optymizacjom w sterownikach pogarszającym jakosc textur to pewniakiem straci troche klientów ,dodam wiecej ,wcale nie jest tak różowo z tą wydajnością ,miało być obiecane 100% szybciej niż w obecnych kartach z górnego segmentu

- Radeon nadal ma lepszą jakość obrazu... (autor: Remek | data: 14/04/04 | godz.: 21:31)

..to widać w testach na Tom's... a nowe dziecko ATI położy na łopatki tego przereklamowanego bubla za ciężkie pieniądze....

- cos mi sie wydaje (autor: Meteor | data: 14/04/04 | godz.: 21:37)

ze nie tylko ujrzymy do lata R 420, ale rowniez R 450 i R 500. Informacja, ze ATi w nowym chipie odblokuje od razu 16 potokow to ten sam numer jak wypuszczenie przez nvidie onegdaj NV 25 (2 jednostki pixel shader) w odpowiedzi na R 8500. Musieli to zrobic, mimo, ze plan operacyjny tego nie zakladal. Pytanie tylko, czy R 420 jest az tak bardzo podrasowana architektura R300 jak chcialaby nvidia, czy nie.

Anyway, NV 40 to zabawka dla bogatych z niskimi cenami za prad. Na ubozszych rynkach (Polska) bedziemy z niecierpliwoscia oczekiwac kart opartych o zwykly chip 6800. No i oczywiscie spadku cen "starych" kart ATi. Chip R300 jest tak mocny i zaawansowany, ze starczy jeszcze na dobre 1,5 roku.

- Poczekajmy na odpowiedz ATI ! (autor: konto-usuniete1 | data: 14/04/04 | godz.: 21:39)

i potem na testy modeli dostępnych na na naszym rynku.

- przy okazji (autor: Meteor | data: 14/04/04 | godz.: 21:42)

ciekawie ujal to Anand. "Do GF6800 Ultra potrzebny bedzie nie tylko nowy zasilacz, ale i monitor. Ta karta umozliwia gre w FarCry w rozdzielczosci 2048x1536 z 16 AA ze srednia predkoscia 34 klatek na sekunde". Wszystko byloby pieknie gdyby nie zasilanie tego potwora. Ale na szczescie nvidia zapewne przejdzie do konca tego roku na 90 nm i znow bedzie "cool&budget".

- optymalizacje... (autor: Meteor | data: 14/04/04 | godz.: 21:45)

to raczej niedorobka ze strony FarCry i podejrzewam, ze developer i producent szybko dogadaja co jest nie tak. Ta karta nie potrzebuje oszustwa, zeby pokazywac zeby.

- hmm (autor: ArturNOW | data: 14/04/04 | godz.: 21:48)

tak mysle, czy moja 360W chiefteca w kompie, gdzie ma do pociagniecia Abita NF7-S. barton 2500+. 512 mb pamieci, nagrywarka DVD, jednym dyskiem 40GB barracuda ta karta by poszla, wedlug mnie bez problemu... te 480 W to oczywisice na wyros, albo NVIDIA po prostu zabezpiecza sie wiedzac, ze ktos moze miec P4 EE, 4 dyski, kilka napedow i w dodatku wszystko o/c wiec raczej nie trzeba sie przejmowac zapotrzebowaniem na energie, jezeli ma sie markowy zasilacz. I takie pytanie. Bo na pewno Kris bedzie robil testy tego potwora. Czy będziesz mial mozliwosc sprawdzenia czy karta bedzie dzialac na podobnej do mojej konfiguracjo. Tak mnie nurtuje ten problem :D

- przesadzacie... (autor: Liu CAs | data: 14/04/04 | godz.: 22:10)

karta ma troszke wieksze zapotrzebowanie na energie niz 9800xt...

- duzo tu (autor: mass | data: 14/04/04 | godz.: 22:41)

jasnowidzow :)

- hmmm (autor: ArturNOW | data: 14/04/04 | godz.: 22:54)

dobra, mam juz odpowiedz The Tagan (a brilliant PSU) and Enermax were fine. Anything over 350W that's high quality (not some cheap tat you bought for Ł10) should be fine, provided you don't have more than a couple of HDDs or optical disks.

No karta pobiera ok 30 W wiecej niz radek

- Fajnie (autor: NimnuL-Redakcja | data: 14/04/04 | godz.: 23:00)

by było gdyby nie te dwa razace molexy zasilajace ... ale chyba to jest nieuniknione i czuje, ze ATi tez wypusci swoja z 2 liniami zasilania. . .

- NimnuL... (autor: DYD-Admin | data: 14/04/04 | godz.: 23:06)

...co do molexow - w koncu ilosc molexow wystajacych z mocnych zasilaczhy bedzie miala swoje ujscie :-)

- ArturNOW ... (autor: Kris-Redakcja | data: 14/04/04 | godz.: 23:14)

Sądzę, że będę miał taką możliwość :-)

BTW: Wydaje mi się, że niektórzy tu trochę przesadzają z doszukiwaniem się drugiego dna (np. kwestia FarCry). Jak dla mnie, niemal prototypowy hardware na wczesnej wersji sterów, przy braku wsparcia od strony zarówno gier jak i dx radzi sobie dosyć skutecznie (mało wpadek kompatybilnościowych). IMHO nVidia dobrze odrobiła swoją lekcję. Pozostaje poczekać na R420 aby sprawdzić na ile skutecznie ...

- Mnie zastanawia takze jedno (autor: NimnuL-Redakcja | data: 15/04/04 | godz.: 08:13)

skoro ta karta pozera grubo ponad 100W (mowa jest o okolo 140W chyba) to jakim cudem tak mały radiatorek i wentylator jest w stanie to wychlodzic? (100W Prescotta chłodzi ogromny cooler Zalmana 7000CU i procesor ma okolo 60st) . . . moze tu dopuszczalna temperatura pracy to 100st a maksymalna 200? hehe

- DYD no wlasnie (autor: NimnuL-Redakcja | data: 15/04/04 | godz.: 08:15)

ale zawsze znajda sie osoby co powiedza, ze 2 molexy starcza , bo od czego sa przejsciowki <hehe>

- Jak można ... (autor: artih | data: 15/04/04 | godz.: 10:30)

... oceniać jakość grafiki bez odpowiednich (zoptymalizowanych) sterowników ?!?

Przecież to nowa karta ... ATI jeszcze nie dograło sterów do R9500/9700 buueheheh ... (ostatnie Catalyst usuwają błędy w Battlrfield 1942, Call of Duty i innych starych i popularnych grach:)

- 480W? Yaaazzzoooo... (autor: Piwomir | data: 15/04/04 | godz.: 10:54)

W specjalnej promocji można kupić karty nVidia GF 6800 razem z małym reaktorkiem atomowym za jedyne...

- na PClab jest screeny (autor: ArturNOW | data: 15/04/04 | godz.: 12:00)

z FarCry na PixelShader 2.0 i 3.0 ... różnica w grafice olbrzymia... a wszyscy już zanią NVIDIE tym, że PS 3.0 to zobaczymy za 8 lat w użyciu ;-) a już przed premierą jest :D

- NimnuL (autor: ArturNOW | data: 15/04/04 | godz.: 12:02)

karta pracuje w temperaturze 44C dużo niższej niż NV38... a max to chyba 120C, więc nie ma się o co martwic :-)

- 480W... (autor: ArturNOW | data: 15/04/04 | godz.: 12:04)

jeżeli chodzi o te 480W to jest to ta gwarantowana moc... chodzi tu o komputer z kilkoma napedami i P4EE:P lub Prescotem i zasilaczem no-name :D O zasilacz nie ma się co martwic :-)

- X800Pro (autor: chuppa | data: 15/04/04 | godz.: 12:21)

który wyjdzie 5 maja napewno pokona Geforca 6800, ale nie da sobie rady z G6800Ultra więc będzie trzeba poczekac do czerwca zeby naprawde się przekonac kto jest lepszy... Ati napewno ma jakiegos asa w rękawie...

- ja w kwestii krzaków w FarCry (autor: teplex | data: 15/04/04 | godz.: 14:38)

dla mnie sprawa jest dość oczywista, znana jest powszechnie słabość nv3x w ps2.0, więc gra nie wnika jaką konkretnie ma karte, traktując wszystkie nv w taki sam sposób, mianowicie wymusza ps1.x i koniec bajki. A fx6800 to też nvidia więc sprawa jest jasna, po prostu rozpoznaje firme a nie model karty.

- update (autor: teplex | data: 15/04/04 | godz.: 14:39)

wyjdzie jakiś nowy patch do FarCry i będzie po problemie (mam nadzieję).

- wyjdzie patch (autor: ArturNOW | data: 15/04/04 | godz.: 16:01)

i doda obslug PixelShader 3.0 :D

- aaaa (autor: Liu CAs | data: 15/04/04 | godz.: 16:03)

Ludzie obejrzyjcie sobie ten filmik

mms://wm.nvidia.na-regional.speedera.net/wm.nvidia.na-regional/geforce/geforce_6800_demo_collage.wmv (20MB)

i pomyslcie, ze Nalu wyglada tak jak na tych zdjeciach...

http://www.nzone.com/docs/IO/12481/screenshot1.jpg

http://www.nzone.com/docs/IO/12481/screenshot2.jpg

http://www.nzone.com/docs/IO/12481/screenshot3.jpg

Po prostu szczena mi opadla... a ponoc stopien skomplikowania dema ATI (z ta panienka Ruby), pod wzgledem liczby wielokatow, jest 2x wiekszy... No normalnie ladne karty sie nam szykuja... niedlugo bedziemy ogladac Shreka generowanego w czasie rzeczywistym...

- Te 480W jest trochę na wyrost (autor: Drakor | data: 15/04/04 | godz.: 16:57)

Serwisowi 3DCenter udało się przetestować kartę przy zasilaczu 300W (co prawda nie mieli w komputerze zbyt wielu urządzeń, ale jednak).

Krótki cytacik:

"Bei uns jedenfalls lief das NV40-Board auch sofort und anständig mit einem 300-Watt-OEM-Netzteil. Wobei dies sicherlich auch eher ein Glücksfall ist, welcher kaum verallgemeinert werden kann. Aber mit anständigen 350-Watt-Netzteilen dürfte ein NV40-Board wohl recht sicher laufen, bei Systemen mit sehr leistungsfressender CPU wie Athlon 64/FX oder Prescott ;-) sollte es dann schon besser ein 400-Watt-Netzteil sein. Und wenn alle Stricke reissen sollten, dann muß eben doch das von nVidia empfohlene 480-Watt-Netzteil geordert werden."

http://www.3dcenter.org/...0_benchmarks/index3.php

Jest więc nadzieja, że nawet mój Foxconn/Deer 400W dałby sobie radę z tym potworem :)

- ArturNOW (autor: NimnuL-Redakcja | data: 15/04/04 | godz.: 19:23)

a jakim cudem te 140W wychlodzi sie przez malusi wentylek i radiatorek?? Zobaczymy jak bedzie w rzeczywistosci.

- hehe (autor: Franz | data: 15/04/04 | godz.: 20:25)

to niezla rewolta wsumie wreszcie jaos sie generacje roznia pod wzgledem jakosci juz dawno tego nie bylo... dobrze ze nie kupilem jkaiegos gniota ala 9700 lub fx5950;PPP zartujeo ofc ale posiadacze takowych lub podobnych moga zalapac dola po tej oraz nadchodzacych premierach...

- ..radiatorek (autor: perlin | data: 15/04/04 | godz.: 20:48)

Karta nie pobiera 140W ... Według tego co twierdzą w tym linku (na podstawie danych od nVidii):

http://www20.tomshardware.com/...orce_6800-20.html

..pobór mocy CAŁEJ karty to maksymalnie 110W. Jesli nawet 80% idzie do GPU, to mamy nieco ponad 80W do ochłodzenia. A radiatorek wcale nie taki mały... podobny jak na CPU .

- raz jeszcze o chłodzeniu (autor: perlin | data: 15/04/04 | godz.: 20:56)

http://www.xbitlabs.com/...deo/display/nv40_2.html

można tu znaleźć zdjęcia i kilka opinii o chłodzeniu.

- Mamy zatem dylemat... (autor: Chrisu | data: 15/04/04 | godz.: 21:13)

czy kupić Radka 9800 Pro (lub nawet 9800 SE @ Pro), mieć kilka FPSów mniej i mniejszy rachunek za energię, czy dać kupę kasy na kartę zasilacz i jak piszą monitor (no trzeba "to" wykorzystać) i płacić comiesięcznie mniej.

Przy tych wszystkich testach brakuje mi jednego... Ile karta (nie tylko ta) bierze w 2D i ile przy maksymalnym underclockingu.

Dla mnie akurat to jest najważniejsze nie FPSy...

Jeszcze jakbym mógł baleronka na ST6R pod windowsem underclockować - dopiero byłoby miło...

- A mnie to (autor: kretos | data: 16/04/04 | godz.: 09:00)

to w ogole nie obchodzi - i tak nie kupie ani X800 ani 6800 bo mnie nie bedzie stac - raczej czekam na obnizke dzisiejszych potworow do 300 zl.

- I malo mnie (autor: kretos | data: 16/04/04 | godz.: 09:00)

interesuje czy bedzie to nVidia czy Ati czy inna firma - wazne zeby bylo dobrze i tanio.

- perlin (autor: NimnuL-Redakcja | data: 16/04/04 | godz.: 09:17)

dzieki, rozumiem . . .

Choc ogolnie i te 110W to potwornie duzo . .. kurde, wiecej niz najszybsze CPU ...

- Monitor a karta (autor: Kit | data: 16/04/04 | godz.: 10:07)

JA no to patrzę trochę inaczej. Przymierzam się do zakupu monitora 19 lub 20 cali LCD. Co oznacza przymus pracy w rozdzielczości 1280x1024 lub 1600x1200. I zachodzi proste pytanie, która karta uciągnie każdą grę z dziedziny jaka mnie interesuje w tej rozdzielczości, bo tego nie będę mógł zmienić. Mój R9700Pro nie jest w stanie, więc tak czy inaczej czeka mnie przesiadka. Jedno mnie powstrzymuje - hałas. Stąd interesuje mnie tylko pasywne albo tylko wodne chłodzenie. A w wypadku nowych kart będzie to zadanie trudniejsze niż chłodzenie procesora. Co do poboru mocy, myślę że ona nie bierze 110W przez cały czas. Moc tego potwora musi być skalowalna. Ale fakt 90nm by się przydało.

- ano... (autor: Liu CAs | data: 16/04/04 | godz.: 10:31)

Kit jest jeszcze inne wyjscie... sam posiadam LCD 17" i sam przymierzam sie do przesiadki na 19", sam mam R9700Pro, wiec znam ten bol... polecilbym Ci raczej poszukac takiego modelu LCD 19" (lub 20") ktory potrafi wyswietlic rozdzielczosc inna niz natywna bez rozciagania jej na caly ekran (w okienku)... to jest wedlug mnie rozsadniejsze wyjscie niz upgrade'owanie karty, gdyz za rok moze okazac sie, ze i tak nowy nabytek jest za slaby, azeby udzwignac kazda gre w rozdzialce 1280x1024...

- kart jak karta (autor: Pauler | data: 20/04/04 | godz.: 10:20)

Same parametry karty szokują, ale komu to jest na razie potrzebne poza grafikami. Może jest super wydajna lecz i super droga. ATI na pewno odpowie na tą premierę w odpowiednim momencie.

- i czym sie tu podniecac ????????? (autor: Draco_ | data: 20/04/04 | godz.: 10:24)

karta bedzie kosztowac pewnie tyle ile moj komputer x2 i kto to kupi ?? chyba tylko jakies zboki z nadmiarem kasy. jedyna dobra wiadomosc to ta ze MOZE stanieja starsze modele do rozsadnego poziomu sprzed kilku lat kiedy to wypasione karty graficzne kosztowaly kolo 1000 czyli tyle ile teraz "sredniaki". tak to jest bo skoro znajduja sie naiwniacy kupujacy FX5950 czy ekrany LCD za grube tysiace to po co obnizac cene ??????

ciekawe ile klatek wyswietlaja te "fantastyczne" monitory podlaczone do tych "fantastycznych" kart skoro maja czas reakcji 16ms (te najlepsze ofkoz), bo mnie wychodzi ze kolo 62 !!!!!! czyli "fantastyczne" odswiezanie 62 Hz !!! no ale jest sie z czego cieszyc, przeciez w Q3 kolesie maja 300 klatek ;))) to moze sie myle ale widza co 5 klatke :)

wszyscy pisza o poborze mocy i dobrze. zdecydowana wiekszosc (pewnie z 90% )komputerow padnie po paru minutach ze spalonym zasilaczem i co tam jeszcze sie zjara przy okazji.

ciekawe jaki halas generuje ta "wspaniala" karta ????

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|