Radeon 9800 Pro vs GeForceFX 5900

Autor: Kris | Data: 10/07/03

|

Dziś chciałbym zaproponować pojedynek na szczycie klasyfikacji zarówno wydajnościowej jak i cenowej. Dzięki uprzejmości firm ABCData oraz MSI Polska przedstawię porównanie najsilniejszych, dostępnych obecnie na naszym rynku kart graficznych przeznaczonych do gier. Będą to Radeon 9800 Pro oraz GeForceFX 5900. Obie karty kosztują ok. 2000 zł i naturalnym wydaje się fakt, że konfrontacja jest nieunikniona. Tłem do porównań będą poprzednicy dzisiejszych bohaterów w postaci Radeona 9700 Pro oraz GeForceFX 5800 Ultra. Podstawowym wyznacznikiem badanych kart jest wydajność generowania grafiki trójwymiarowej i skoncentruję się właśnie na tym zagadnieniu. W recenzji postanowiłem tym razem zawrzeć nieco więcej informacji o samej zasadzie doboru testów wydajności. Mam również nadzieję, że uda mi się napisać, dlaczego porównanie nowych kart ATI i nVidia nie jest zadaniem łatwym dla testującego. Mało odpornych od razu przestrzegam, że będą ględził. Czasem nawet ponad granicę przyzwoitości. Zapraszam. Dziś chciałbym zaproponować pojedynek na szczycie klasyfikacji zarówno wydajnościowej jak i cenowej. Dzięki uprzejmości firm ABCData oraz MSI Polska przedstawię porównanie najsilniejszych, dostępnych obecnie na naszym rynku kart graficznych przeznaczonych do gier. Będą to Radeon 9800 Pro oraz GeForceFX 5900. Obie karty kosztują ok. 2000 zł i naturalnym wydaje się fakt, że konfrontacja jest nieunikniona. Tłem do porównań będą poprzednicy dzisiejszych bohaterów w postaci Radeona 9700 Pro oraz GeForceFX 5800 Ultra. Podstawowym wyznacznikiem badanych kart jest wydajność generowania grafiki trójwymiarowej i skoncentruję się właśnie na tym zagadnieniu. W recenzji postanowiłem tym razem zawrzeć nieco więcej informacji o samej zasadzie doboru testów wydajności. Mam również nadzieję, że uda mi się napisać, dlaczego porównanie nowych kart ATI i nVidia nie jest zadaniem łatwym dla testującego. Mało odpornych od razu przestrzegam, że będą ględził. Czasem nawet ponad granicę przyzwoitości. Zapraszam. | |

|

Ewolucja

ATI Radeon 9700 Pro, który pojawił się w zeszłym roku był niewątpliwie nową jakością zarówno pod względem wydajności jak i możliwości graficznych. Niemal pół roku zajęło firmie nVidia wypuszczenie karty tej samej generacji i co ważniejsze jej przyjęcie przez rynek było na tyle chłodne, że niemal natychmiast ruszyły prace nad jego następcą. Tym nie mniej, dzięki zastosowaniu najnowszej generacji pamięci oraz kosmicznego wręcz chłodzenia GFFX 5800 Ultra w większości testów uzyskał niewielką przewagę wydajnościową nad konkurencją, co skłoniło ATI do odświeżenia oferty w topowym segmencie. Tak oto pojawił się nowy lider wśród Radeonów oznaczony symbolem 9800 Pro. Układ spełnił swoje zadanie w kwestii dominacji nad rywalem z obozu nVidia, ale sielanka nie potrwała długo. Dwa miesiące później do sprzedaży trafia GeForceFX 5900 rozpoczynając nową bitwę o rynek. Jego wejście poprzedza typowa akcja marketingowa mająca ugruntować wśród potencjalnych nabywców przeświadczenie, że nowa karta wręcz zadepcze konkurencję. Jednocześnie nVidia odcina się całkowicie od jego poprzednika, przyznając do błędu koncepcji konstrukcyjnej. Karty 5800 Ultra znikły z materiałów reklamowych firmy jak kamfora. Po prostu zastały całkowicie zastąpione.

Na rozgrzewkę tabelka parametrów podstawowych oraz wydajności teoretycznej:

Zmienna ilość strumieni renderowania i co za tym idzie Fill Rate GeForceFX związana jest z działaniem samego układu, który zachowuje się różnie, w zależności od realizowanych zadań. Nic w tym względzie nie zmieniono w stosunku do poprzednika. W związku z tym, że nVidia nie zdradza części tajemnic związanych z architekturą swoich najnowszych kart to niektóre dane mają charakter nieoficjalny.

Zanim zacznę rozwijać kwestię różnic warto wyjaśnić moje podejście do odmian modeli. Tabela zawiera specyfikację testowanych przeze mnie kart i wszystko wskazuje na to, że są to bazowe odmiany, najlepiej reprezentujące możliwości nowych produktów. Zarówno ATI jak i nVidia przewidziała również prestiżowe mutacje, które przy znaczącej różnicy w cenie osiągają niewiele większą wydajność. Prawdopodobnie ich dostępność będzie bardzo ograniczona. Są to odmiany posiadające 256MB pamięci. W przypadku nVidia modele takie noszą nazwę Ultra i oprócz ilości RAM będą miały również nieco wyżej taktowany rdzeń 450MHz. W ATI nazwa się nie zmienia natomiast zamiast 128MB pamięci DDR-1 340MHz zastosowano 256MB DDR-2 350MHz. W obydwu przypadkach nie należy spodziewać się jakichkolwiek spektakularnych różnic wydajności w związku z tym, że tak duża ilość pamięci nie jest potrzebna, aby gry osiągały pełnię swoich możliwości. Co najwyżej można liczyć na kilka fps testowych więcej (głównie dzięki nieco wyższym zegarom). Szczególnie w wysokich trybach FSAA i rozdzielczościach rzędu 1600x1200x32. Jak dla mnie przerost marketingu nad produktem. Warto jednak wiedzieć, czym one się różnią i nie dać się handlowcom wciskającym dobrze brzmiące nazwy Ultra, DDR-2 czy hasło 256MB. Zysk minimalny a portfel cieńszy o ponad 500 zł. O tym, że są to niewygodne landary lub ponadprzeciętne grzałki nawet nie wspomnę.

Zacznę od Radeona. Różnice sprzętowe pomiędzy układami R300 a R350 moim zdaniem można sprowadzić do czterech podstawowych punktów:

- Wyższe taktowanie: Pierwszą rzeczą, jaka rzuca się w oczy jest zwiększenie częstotliwości pracy zarówno rdzenia jak i pamięci. Zmiany te możliwe były dzięki dodatkowej optymalizacji struktury układu, drobnej modyfikacji kontrolera pamięci, polepszeniu chłodzenia oraz stabilniejszej konstrukcji płytki. W zasadzie jest to podstawowa i najbardziej spektakularna różnica.

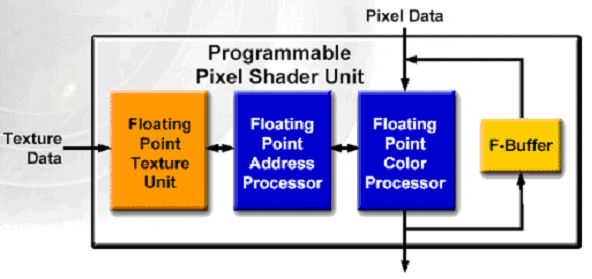

- F-Bufor: Ograniczeniem układu R300 była możliwość wykonywania w jednym przebiegu programów pixel shadera zawierających maksymalnie do 64 instrukcji. Dla porównania NV3x może przetworzyć 1024 instrukcje. Aby zmusić R300 do zobrazowania bardziej skomplikowanych efektów pojedynczy shader musiał być dzielony i wykonywany sekwencyjnie przy wykorzystaniu technik wielo-przebiegowych, co powodowało znaczące straty wydajności wynikające m.in. z niepotrzebnego powtarzania tych samych operacji. W pewnych warunkach prowadziło to również do pogorszenia finalnej jakości renderowanych ramek. W układzie R350 wprowadzono dodatkową jednostkę pomocniczą o nazwie F-Buffer (Fragment Stream FIFO Buffer). Funkcjonalnie jest to rodzaj podręcznej pamięci służącej do przechowywania części pośrednich obliczeń, dzięki której shader może być zasilany partiami instrukcji bez konieczności zapisu i odczytu danych poprzez bufor ramki. Teoretycznie technologia ta umożliwia wykonywanie programów dla shadera o nieograniczonej ilości instrukcji bez strat typowych dla pełnego powtarzania przebiegów przez strumień renderowania. Moim zdaniem ATI chodziło głównie o wyeliminowanie potencjalnego źródła słabości układu R300 w porównaniu z NV3x. Oczywiście pytanie o to czy R350 doczeka gier o tak dużym skomplikowaniu shaderów oraz jak w praktyce będzie wyglądała ta konfrontacja pozostaje bez odpowiedzi.

- Usprawnienie kontrolera pamięci: Jednocześnie ze zwiększeniem taktowana pamięci ATI dokonało modyfikacji samego kontrolera mającej na celu usprawnienie zarządzania szyną w czasie największego natężenia operacji odczytu i zapisu. W założeniach ma to dodatkowo poprawić wydajność, zwłaszcza podczas renderingu wykorzystującego funkcję antyaliasingu. W sumie drobiazg.

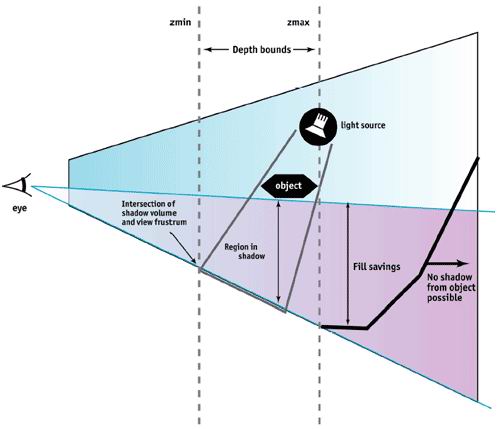

- Usprawnienie działania pamięci podręcznej Z-Bufora: Według ATI ma to pomóc w lepszym wykorzystaniu przez programistów przyszłych gier efektów nakładania cieni. Jako, że sprawa dotyczy konkretnie użycia techniki "stencil shadow volume" to wygląda to na wyraźny ukłon w stronę Carmack'a i jego Doom3 oraz wskazuje na to, co realnie boli R300 w starciu z NV3x.

Oczywiście wraz z nowym układem pojawiły się modyfikacje nazw technologii ATI. Skoro mamy F-Bufor to SMARTSHADER™ podwyższył wersję z 2.0 na 2.1. Optymalizacja cache Z-Bufora spowodowała, że HYPER Z™ III zmienił się w III+. Dodatkowo SMOOTHVISION™, tym razem już tylko dzięki zabiegom czysto programowym uzyskał numerek 2.1. Wszystkie pozostałe technologie, którymi szczycił się Radeon 9700 Pro zostały zaadoptowane bez zmian. Zainteresowani dokładniejszym opisem mogą się z nimi zapoznać w recenzji R9700 Pro.

Teraz kolej na GeForce'a. W podobny sposób potraktuję różnice pomiędzy NV30 a NV35. Podstawowe zmiany zawarłem w punktach:

- Magistrala pamięci: Najważniejszą zmianą, jaka odróżnia nowego FX'a od poprzednika jest przejście na 256-bitową magistralę pamięci. Jest to najbardziej istotny element związany z wydajnością. Analitycy zgodnie twierdzili, że odziedziczony po GF4Ti kontroler był hamulcem dla wysoko taktowanego rdzenia nowych kart. Zdublowanie ilości linii dostępu powoduje dwukrotne zwiększenie teoretycznej przepustowości pamięci. Jak to wygląda w praktyce dowiemy się w dalszej części recenzji.

- Optymalizacja przesyłu danych do lokalnej pamięci: Z konstrukcją nowego kontrolera pamięci, obsługującego magistralę 256-bitową związana jest modyfikacja technik optymalizacji zarządzania transferem. Jest to bardzo istotna kwestia, bo wypełnienie takiej szyny danymi nie jest zadaniem trywialnym i od tego, w jakim stopniu się to powiedzie, teoretyczna przepustowość przełoży się na realną wydajność. Specjalne algorytmy określają, kiedy efektywniej będzie zastosować konkretny typ kompresji lub zmianę parametrów pracy i jakich danych mają one dotyczyć. Poprawione procedury, według zapewnień nVidia, zwiększają prawdopodobieństwo użycia kompresji. Ma to spowodować, że wydajność nie będzie drastycznie spadać w wysokich trybach FSAA. Kwestia na ile zwiększenie wydajności związane jest z poprawieniem algorytmów optymalizacji a na ile z samą magistralą 256-bitową pozostanie pewnie tajemnicą producenta.

- UltraShadow: Usprawnienie obliczeń efektu cieni realizowanych metodą "stencil shadow volume". Kolejny wyraźny ukłon w stronę Doom3. Pozwolę sobie na małą złośliwość. Carmack jeszcze nie wydał swojej słynnej gry a już czołowi producenci układów graficznych dostosowują się do jej wymogów. Ten człowiek ma niespotykaną siłę przebicia. Mam nadzieję, że gra okaże się takim przebojem, na jaki oczekujemy już od dłuższego czasu. UltraShadow to korzyść zarówno dla twórców gier jak i dla nVidia. Programiści dostają bardzo wygodne i efektywne w użyciu narzędzie to tworzenia zaawansowanych efektów cieni a nVidia nie tylko zyskuje na omijaniu obliczeń elementów przesłoniętych, ale tak kieruje ich realizacją, że umożliwia układowi NV35 działanie w ośmiu strumieniach renderowania likwidując tym samym słabość swojej architektury. Jeśli do tego programiści nie zechcą przygotować alternatywnego, optymalizowanego pod inny układ efektu to można przy okazji dać prztyczka konkurencji. Przynajmniej w kwestii tworzenia cieni. NVidia nie ukrywa, że na takiej opcji zależy im najbardziej. Oczywiście dopiero czas pokaże jak postąpi Carmack i czy sprawa dotknie również innych, nowych produkcji gier.

- Zmniejszenie taktowania: Reorganizacja architektury układu oraz chęć zdjęcia z karty suszarki zwanej FlowFX spowodowała konieczność zmniejszenia taktowania rdzenia z 500 na 400MHz. Moim zdaniem jest to znaczący sukces zdrowego rozsądku projektantów nVidia. Może i w pewnych zastosowaniach zmniejszy to wydajność, ale zysk związany z brakiem świdrującego ucho hałasu jest jak dla mnie zdecydowanie ważniejszy. Zmniejszono również częstotliwość pracy pamięci z 500 na 425MHz (DDR-2 zastąpiono DDR-1), co pozwoliło na zastosowanie znacznie tańszych, łatwiej dostępnych oraz co ważne - mniej grzejących się modułów. W związku z tym, że jednocześnie zwiększono szerokość magistrali to i tak przepustowość teoretyczna nowej karty jest 40% wyższa.

Oczywiście zmiany pociągają, podobnie jak u konkurencji modyfikacje nazewnictwa technologii własnych. Dzięki UltraShadow CineFX uzyskał numerek 2.0 a zestaw usprawnień w procesie przesyłania danych dodał do Intellisample słowo HCT (High Compression Technology). Pozostałe technologie zaimportowano od NV30 bez zmian. Ich dokładniejszy opis zainteresowani znajdą w recenzji GFFX5800Ultra. Reszty dzieła dokonują już same sterowniki.

Mam nadzieję, że opisane zmiany rozwieją wątpliwości, co to wprowadzonych przez producentów modyfikacji. Tym razem mamy do czynienia bardziej z ewolucją niż rewolucją w dziedzinie wparcia grafiki trójwymiarowej gier. Obie karty są ulepszeniem wcześniejszych produktów mającym głównie na celu zwiększenie ich wydajności w stopniu pozwalającym na osiągnięcie choćby minimalnej przewagi testowej nad przeciwnikiem. Nikt natomiast nie będzie polemizował z zapewnieniami konstruktorów o zdecydowanie większych możliwościach zanim nie sprawdzi tego w warunkach "bojowych". Zanim to jednak nastąpi chciałbym przedstawić bohaterów dzisiejszej batalii.

Bohater ATI

ATI Radeon 9800 Pro dotarł do mnie z firmy ABCData w opakowaniu SuperGrace'a. Jako, że dotychczas producent nie wyprodukował samodzielnie żadnej karty z układem R300, więc specjalnie się nie zdziwiłem, że pudełko zawierało przepakowaną, dostarczoną przez ATI kartę w postaci OEM. W związku z tym, że karty wyprodukowane przez ATI należą do najlepszych pod względem jakości to dla potencjalnego nabywcy jest to niewątpliwa zaleta.

W pudełku zgodnym wzorniczo z pozostałymi produktami SuperGrace oprócz samej karty znalazłem następujące elementy zestawu:

- Kabel S-Video (miniDIN - miniDIN) do połączenia karty z telewizorem mającym wejście S-Video. Gruby, dobrze ekranowany, typowy dla kart ATI OEM. Bez zastrzeżeń.

- Kabel Composite (miniDIN - Cinch) do połączenia karty z telewizorem sygnałem zespolonym. Osobiście wolałbym samą, krótka przejściówkę, bo kabelek nie należy do najlepszych i w zasadzie musi być zawsze używany. W związku z tym, że jest dosyć krótki prawdopodobnie nie ustrzeże nas przed stosowaniem dodatkowego przedłużacza. Wolałbym inne rozwiązanie.

- Kabel rozgałęziający zasilanie. Przydatne przy braku wolnych wtyczek z zasilacza.

- Przejściówka DVI -> VGA umożliwiająca dołączenie do karty drugiego monitora z wejściem analogowym. Brak uwag.

- Płytka CD zawierająca sterowniki Catalyst 3.2. Można stosować, choć mają już kilka miesięcy. Ze strony ATI warto jednak ściągnąć nowsze.

- Płytka CD zawierająca oprogramowanie CyberLink PowerDirector SE v2.1 wraz z PowerDVD XP 4.0. Szczególnie ważny jest odtwarzacz programowy płyt DVD.

- Instrukcja obsługi karty z elementami konfiguracji sterownika. Obszerna i przydatna, ale tylko dla znających język angielski.

Zestaw jak dla mnie zupełnie minimalny, ale taka jest polityka producenta. Mało dodatków i jak najniższa cena. Przyjrzyjmy się samej karcie.

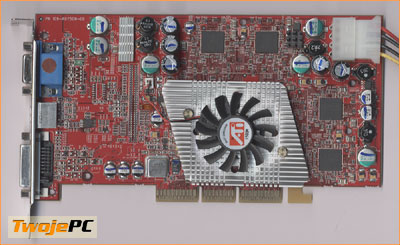

SuperGrace ATI Radeon 9800 Pro (kliknij, aby powiększyć)

SuperGrace ATI Radeon 9800 Pro (kliknij, aby powiększyć)

Na śledziu typowy dla kart ATI Radeon zestaw wyjść: VGA, DVI i TV (miniDIN 7-pinów). Czerwony laminat jest o ok. 1.5cm dłuższy od kart opartych na układzie R300. Pomimo tego jego wielkość wciąż można uznać za klasyczną i raczej nikt nie powinien mieć problemów z umieszczeniem karty w slocie. Po obu stronach płytki znajdziemy osiem modułów pamięci DDR 2.8ns w obudowie BGA produkcji Samsunga. Ciekawostką jest fakt użycia tych samych kości, w jakie zaopatrzono niżej taktowane karty R9700Pro. Układ graficzny przykrywa aluminiowy radiator o romboidalnym kształcie. Optycznie jest mniejszy od poprzedników, ale ma większą powierzchnię oddawania ciepła. Zmieniono również sam wentylator. Ma większą ilość, węższych łopatek. Podobnie jak w poprzednim modelu konieczne jest dostarczenie karcie energii bezpośrednio z zasilacza. Tym razem jest to gniazdko typowe dla HDD.

BIOS o numerze 8.004 taktuje kartę wartościami 380/340MHz (rdzeń/pamięć). Wentylator działa trochę głośniej niż w ATI R9700Pro, ale wciąż jest to moim zdaniem poziom akceptowalny dla większości użytkowników. Jakość obrazu na pulpicie Windows bez zarzutu. Śmiało można stosować kartę w połączeniu z topowymi monitorami analogowymi. W kwestii jakości drobne zastrzeżenia miałem jedynie do kabla miniDIN - Cinch służącego do przesyłania sygnału zespolonego do telewizora. Obraz był dobry, ale po zastosowaniu oryginalnej przejściówki od starszych kart ATI OEM jeszcze się polepszył. Do testów użyłem sterowników ATI Catalyst 3.4 oraz 3.5. Zmiany taktowania karty zapewnił program RadClocker.

Bohater nVidia

Z MSI Polska przyjechał do mnie MSI FX5900-TD128 (MS-8929).

Pudełko i jego otwarcie... (kliknij, aby powiększyć)

...a w nim płytki CD i notes... (kliknij, aby powiększyć)

Duże pudło kryło bogate wyposażenie i oprogramowanie. Oprócz samej karty jego wnętrze mieściło:

- Kabel S-Video (miniDIN - miniDIN) do połączenia karty z telewizorem mającym wejście S-Video. Standard.

- Przejściówka (miniDIN - Cinch) do połączenia karty z telewizorem sygnałem zespolonym.

- Przejściówka DVI -> VGA umożliwiająca dołączenie do karty drugiego monitora z wejściem analogowym.

- Kabel rozgałęziający zasilanie. Przydatne przy braku wolnych wtyczek z zasilacza.

- Płytka CD ze sterownikami (v44.03) oraz dodatkowym oprogramowaniem narzędziowym (3D Turbo Experience, Live Update, GoodMEM, LockBox, WMIInfo, SecureDoc, E-Color, MediaRing, ShowShift)

- Płytka CD z oprogramowaniem FarStone RestoreIT! Pro i VirtualDrive Pro

- Płytka CD z oprogramowaniem InterVideo WinDVD4 (5.1ch). Pudełko reklamuje również Supreme Foreign Language Learning Machine na tym samym CD, ale go nie znalazłem.

- Płytka CD z oprogramowaniem 3DNA 3D Desktop dla MSI. Ten CD zastąpił chyba reklamowany na pudełku SuperPack z Photoshop Album SE i 3D Album SE.

- Płytka CD z oprogramowaniem MSI MediaCenter Deluxe II

- Dwie płytki CD z grą The Elder Scrolls III: Morrowind

- Płytka CD z grą Tom Clancy's Ghost Recon

- Płytka CD z zestawem siedmiu gier: The Sum of All Fears, IL-2 Sturmovik, Serious Sam: The Second Encounter, Rally Trophy, Beam Breakers, Zax: The Alien Hunter oraz Oni

- Płytka CD z grą Duke Nukem Manhattan Project

- Instrukcja instalacji i obsługi karty z elementami konfiguracji sterownika. Obszerna i przydatna, ale tylko dla znających język angielski.

- Mały notatnik MSI w twardych okładkach. Gadżet.

Trzeba przyznać, że zestaw robi doskonałe wrażenie. W porównaniu do niego wyposażenie SuperGrace'a wydaje się wręcz ascetyczne. Duży plus. Szczególnie za gry.

Z lewej góra, z prawej tył karty... (kliknij, aby powiększyć)

Oczywiście najważniejsza jest sama karta oparta na czerwonym laminacie. Jest równie duża jak jej poprzednik NV30 i ma podobną wagę. Należy liczyć się z tym, że w niektórych obudowach może utrudniać prowadzenie taśm do dysków oraz wymianę ciepła. Zdecydowanie większe wrażenie robi jednak radiator. Solidny kawał metalu (prawdopodobnie aluminium pokrywane galwanicznie jakimś stopem miedzi) przykrywa 2/3 powierzchni awersu karty. W centralnym miejscu, bezpośrednio nad układem graficznym znajduje się spory, zintegrowany wentylator. Jako, że żebra rozchodzą się promieniście od osi wiatraka to całość wygląda trochę jak słoneczko. Ciekawostką jest drugi wentylator umocowany pod rdzeniem na rewersie, tworzący zestaw z niewielkim radiatorem. Jakość wykonania karty w zasadzie bez uwag, choć trochę dziwnie wygląda rozgałęźnik zasilania wentylatorów przypięty do karty. Widać zbrakło miejsca na dwa gniazda. Osobiście nie miałem problemów z instalacją, natomiast mam wrażenie, że w

przypadku niektórych płyt, radiator na rewersie może zaczepiać o chłodzenie mostka północnego. Warto na to zwrócić uwagę przed zakupem. Na śledziu o standardowej szerokości znajdziemy zestaw wyjść taki sam jak w Radeonie: VGA, DVI oraz TV-Out (miniDIN 4-pin). Kartę wyposażono w 128MB pamięci DDR w ośmiu "kostkach" BGA oznaczonych znamionowo 2.2ns (do 450MHz) produkcji Hynix'a. Moduły łączone są w pary i rozmieszczone koliście wokół rdzenia. Przypomina to trochę układ zastosowany w Matrox Parhelia. Dodatkową energię z zasilacza dostarczamy przez gniazdko typu HDD.

Na śledziu, karta z góry i duży cooler (kliknij, aby powiększyć)

BIOS v4.35.20.22.00 domyślnie zapewnia taktowanie 400/425MHz (rdzeń/pamięć) w 3D oraz 300/425MHz w 2D. Przełączanie pomiędzy trybami odbywa się automatycznie. Odgłos wydawany przez kartę należy zdecydowanie do cichszych. Całkowite przeciwieństwo rozwiązań znanych z FX5800Ultra. W 2D oba wentylatory szumią nieco ciszej niż w R9700Pro a do R9800Pro jest już konkretna różnica. W 3D doszedł do tego nieco wyższy ton i niewielkie podniesienie ogólnej głośności. Zdecydowanie poziom akceptowalny. Natężenie hałasu w 3D zakwalifikowałbym gdzieś pomiędzy R9700Pro a R9800Pro. Jak dla mnie jest to prawdziwy sukces producenta i karta od razu wzbudziła moją sympatię. Również i w przypadku nowego FX'a nie ma problemu ze spasowaniem z dobrymi monitorami. Bardzo dobra jakość. Muszę jednak przyznać, że zarówno Radeon 9800 Pro, jaki i te egzemplarze GFFX 5800 Ultra, które testowałem miały minimalnie wyższą ostrość w trybach krytycznych dla monitora. Nie ma to jednak wpływu na wysoką ocenę karty MSI w tym zakresie. Karcie dostarczamy dodatkową energię z zasilacza przez gniazdko typu HDD. Warto zwrócić uwagę na to, że producent zaleca stosowanie zasilacza ATX o znamionowej mocy, co najmniej 350W.

Dodatkowo, do porównań, z firmy Sirius Computers, otrzymałem GFFX5800U w wykonaniu Asus'a.

ASUS GeForce FX 5800 Ultra (kliknij, aby powiększyć)

Nie jest on bohaterem tej recenzji, ale przyzwoitość nakazuje mi przedstawić przynajmniej uproszczony opis zawodnika. Wielkie pudło wyłożone pianką zwierało m.in. Media&Show SE 2.0, Morrowind (2x), Roque Spear, Worms Blast, demo IL2 oraz demo Battle Realms. Do tego kompletny zestaw okablowania i przejściówek. Wszystko nienagannej jakości. W kwestii hardware podstawowa różnica w stosunku do testowanego wcześniej GFFX5800U Gainwarda tkwi w chłodzeniu. Tym razem mamy klasyczny FlowFX. Powietrze zasysane jest z zewnątrz i po schłodzeniu miedzianego radiatora opuszcza obudowę. W związku z tym może i pogarsza się chłodzenie wnętrza peceta, ale samą karta można utrzymać w niższej temperaturze. Wentylator wydaje się nieco głośniejszy od Gainwarda, ale moim zdaniem mniej męczy uszy ze względu na niższy ton. Nie będę jednak ukrywał, że dla mnie i tak nie nadaje się on do używania. Po godzinie pracy w 3D miałem dosyć. Moja rodzina również. Dobrze, że nVidia na razie nie zamierza kontynuować eksperymentów z takim rodzajem chłodzenia, bo obawiam się, że sprzedaż by na tym mocno ucierpiała. W kwestii jakości obrazu karta trzyma bliźniaczy poziom z wcześniej testowanym FX5800U. Brak uwag.

Dylematy testującego

Skoro Radeon 9800 Pro oraz GeForceFX 5900 powstały głównie po to, aby osiągnąć pozycję lidera wydajności to podstawową częścią recenzji musi być bezpośrednie porównanie tych karty ze sobą oraz z poprzednikami przy użyciu testów 3D. Oczywiście ktoś mógłby polemizować w kwestii, kto dotychczas stał na czele rankingu i jaka karta posiadała ten zupełnie umowny, choć górnolotnie brzmiący tytuł. Nie ma to jednak w tej chwili większego znaczenia, bo są już następcy.

Nigdy nie ukrywałem swojej niechęci do większości metod pomiarowych stosowanych przy kartach graficznych. Od lat prawdziwym zwycięzcą wszelkich porównań stał się sam benchmark. Różnice pomiędzy kartami często nie są tak spektakularne, że łatwo jest jednoznacznie wyłonić jakiegoś przodownika już po chwili grania w dowolną grę. Co ważniejsze przy porównaniach różnych układów trzeba się liczyć z tym, że zarówno wielkość przewagi jak i w ogóle kwestia kto ją ma zależy ściśle od konkretnej aplikacji, którą wykorzystujemy przy wsparciu danych kart. Jeśli różnice są małe to wspomagamy się benchmarkami. Idea wstępnie wydaje się dobra. Dajemy konkurentom do przetworzenia ustalony, powtarzalny fragment ruchomej grafiki i mierzymy czasy generacji poszczególnych ramek. Wydajniejsza karta powinna szybciej uporać się z zadaniem. Aby łatwiej przyswoić sobie różnicę to wynik zawodów sprowadzamy do jednej liczby będącej średnią ilością ramek przygotowanych przez kartę w czasie jednej sekundy (FPS). Tak oto mamy piękną, jednoznaczną i bezdyskusyjną LICZBĘ. Uwielbiamy liczby, bo można je porównać, można wykonać na nich dodatkowe operacje i co ważniejsze mają znamiona obiektywizmu.

Czy jest w tym jakiś haczyk? Oczywiście. I to nie jeden. Nie chcę się rozpisywać (a mógłbym o tym napisać i całą książkę), ale weźmy pod uwagę tylko kilka kwestii. Po pierwsze, aby taki pomiar był porównywalny to musimy zakładać, że karty zawsze przygotują nam taki sam obraz 3D. Jeśli któraś z kart np. generuje obraz bardziej szczegółowy, to tym samym musi więcej swoich zasobów poświęcić zadaniu. To tak jak mierzyć czas przygotowania przez rysowników dwóch obrazków, z których jeden rysowany jest w kolorach a drugi przy użyciu jednej kredki. Co nam da porównanie tych czasów? Niewiele.

Druga sprawa to kwestia uśrednienia wyników. Ramki mają zmienny stopień skomplikowania grafiki i zawierają różne techniki tworzenia efektów 3D. Może się zdarzyć, że trafimy na zestaw ramek, z którym jedna karta radzi sobie zdecydowanie słabiej niż inna. Z jednej strony może mieć to niewielki wpływ na średnią w czasie całego testu, ale z drugiej strony w czasie gry wyraźnie odczujemy dyskomfort spowodowany chwilową utratą płynności ruchu. Co nam z wysokiej średniej w teście skoro gra się fatalnie?

Kolejna kwestia to właściwy dobór testu. Chcemy jak najdłużej sprawdzać kolejne generacje kart przy wykorzystaniu tej samej aplikacji. Kwestia przyzwyczajenia oraz poczucie praktycznej wiedzy na temat odniesienie wydajności do konkretnych, porównywanych liczb. Problem w tym, że w pewnym momencie okazuje się, że dla nowych, znacznie wydajniejszych kart przygotowanie większości ramek zajmuje tak mało czasu, że na wynik średni dominujący wpływ zaczyna mieć wydajność samej platformy oraz optymalizacja pod nią sterowników. Jeśli już znacząco słabsza z dwóch porównywanych kart jest na tyle mocna, że wynik opiera na procesorze to nijak nie możemy określić, w jakim stopniu ta mocniejsza jest od niej lepsza, bo wyniki niewiele się różnią. Mało tego. Może się okazać, że ta słabsza ma lepszą optymalizację wykorzystania konkretnego procesora i uzyska nawet wyższy wynik. Interpretacja prowadzi na manowce, bo po zakończeniu testów uruchomimy nową grę ustawiając tak parametry, aby wydusić maksymalną jakość obrazu na danej karcie a tym samym w końcu zmusimy ją do prawdziwej "pracy". W tym momencie przestaje mieć większe znaczenie, jaki mamy procesor czy jak on jest wykorzystany przez sterownik. Oczywiście zakładając, że jest on na tyle mocny, aby zapewnić wsparcie samej grze oraz pozostałym elementom peceta (sterowanie wirtualnymi przeciwnikami, wsparcie obliczenia dźwięku 3D itd.). Nagle okazuje się, że wprowadzeni w błąd wynikami testów źle dostosowanej aplikacji przeinwestowaliśmy procesor czy pamięć zamiast postawić na mocniejszą kartę graficzną.

Z przyzwyczajeniem do konkretnej aplikacji testowej oraz naszą głęboką wiarą w skuteczność danej metodologii pomiarów wydajności wiąże się kolejny problem. Producent karty świadomy wpływu, jaki mają wyniki najchętniej stosowanych testów na sprzedaż danego produktu może się pokusić o takie dostosowanie działania sterownika, aby uzyskać jak najlepszy wynik nawet, jeśli ta zmiana nie jest możliwa do wdrożenia w realnych grach lub, jeśli wiąże się to z brakiem zachowania tego samego obrazu 3D. Takie praktyki stosowane są od lat i wielokrotnie już o tym pisałem. Nie kryję jednocześnie swojego zadowolenia, że temat w końcu doczekał się szerszej dyskusji i mam nadzieję, że przynajmniej część potencjalnych nabywców zacznie patrzeć na benchmarki kart graficznych w sposób nieco bardziej zachowawczy.

Klasyczne testy

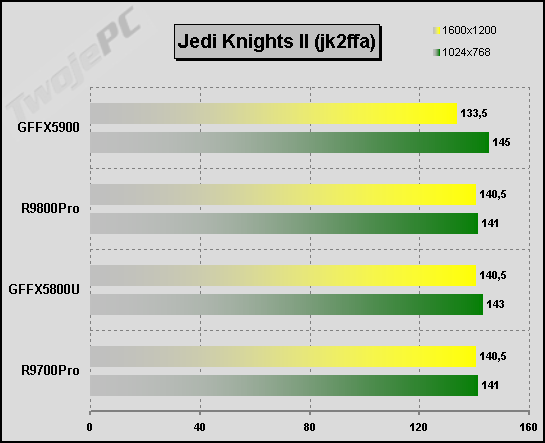

Po tym nieco przydługim wstępie spróbuję przejść do tych nieszczęsnych liczb. Mam nadzieję, że dzięki niemu przynajmniej niektórzy czytelnicy łatwiej zrozumieją moją interpretację niektórych wyników. Tym razem testowane były karty z najwyższej półki. Większość problemów z testami wiązała się z brakiem oprogramowania opierającego wynik niemal całkowicie na wydajności samej karty. Część testów, które od dłuższego czasu wykonuję nie nadaje się już do dalszej "eksploatacji". Wcześniej zrezygnowałem z Quake3 i Comanche4 a po wstępnych testach okazało się, że Jedi Knight II również nic ciekawego mi już nie powie. Z tego samego powodu nie ma sensu porównywać karty benchmarkiem 3DMark2001se w trybie domyślnym (wyniki podaję tylko dla satysfakcji klubu miłośników tego programu). Z resztą zbyt duże są zakusy producentów na specjalne praktyki zwiększające wynik. Już je wcześniej pokazywałem.

Jeśli rozpatrujemy wydajność to warto zwrócić uwagę na świadomie dokonany przeze mnie rozdział możliwości kart. Chciałbym oddzielnie podejść do zagadnienia obsługi aktualnie dostępnych na rynku gier (Dx5-8), oddzielnie rozpatrzyć kwestię pełnoekranowego antyaliasingu i filtrowania anizotropowego i oddzielnie spróbować sprawdzić możliwości, jakie tkwią w kartach w zakresie shaderów 2.0, czyli wsparcia gier, które dopiero powstają. Wynika to z odmiennych funkcji układów i niekoniecznie rzecz jest możliwa do ujednolicenia. Zacznę od klasycznego zestawu testów.

Może najpierw, jako przykład, pokażę, dlaczego JK2 przestało mnie interesować. System testowy P4 2.4/533, GA-8IHXP, 512MB PC800, Windows XP Pro SP1. Sterowniki: nVidia beta v44.65 i oficjalne v44.03 oraz ATI v3.4 i v3.5 ustawione domyślnie oprócz wyłączenia vsynch. Gry ustawiam na najwyższą jakość obrazu oraz jeśli to możliwe, wyłączam dźwięk, aby nie wpływał na rezultat testu. W nawiasach podaję wartości minimalne fps. Wyniki przedstawiają się następująco:

Najważniejszą informacją jest praktyczny brak różnic wyniku wraz ze zwiększaniem trybu graficznego. Wynik oparł się na wydajności platformy i dodatkowo świadczy o takim wykorzystaniu możliwości kart, które nie daje nawet dodatkowej przewagi w optymalizacji wykorzystania procesora przez sterowniki żadnej z firm. Porównując te liczby nie jesteśmy w stanie ani stwierdzić, która z kart jest wydajniejsza ani tym bardziej oszacować wielkość tych różnic. Warto jednak zwrócić uwagę na JK2 w nieco innej kwestii. Ta gra, jak mało która wymaga sporego wsparcia od strony procesora. Niestety nie nadaje się to do przedstawiania w teście. Problem z mocą platformy objawia się utratą płynności w momencie, kiedy atakuje nas wielu przeciwników. Średnio licząc musimy dysponować procesorem taktowanym przynajmniej ok. 1400-1600MHz (w zależności od jego producenta i innych parametrów), aby problem przestał nas dręczyć. Oczywiście niezależnie od zastosowanej karty graficznej. Piszę o tym, bo wielu testujących popełnia błąd taktyczny dobierając procesor na podstawie krzywej wyników testów średnich przy wzroście jego częstotliwości. Błąd polega na tym, że już znacznie przed punktem przegięcia linii wykresu następuje wzrost minimalnego poziomu fps powyżej progu płynności i takim badaniem spowodujemy jego przewartościowanie. No chyba, że komuś bardziej zależy na samych wynikach niż rzeczywistym zachowaniu gry.

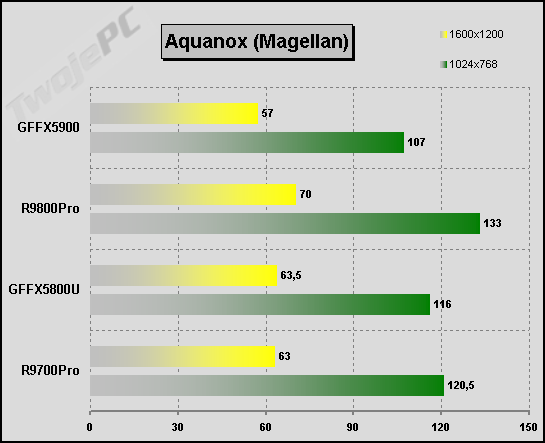

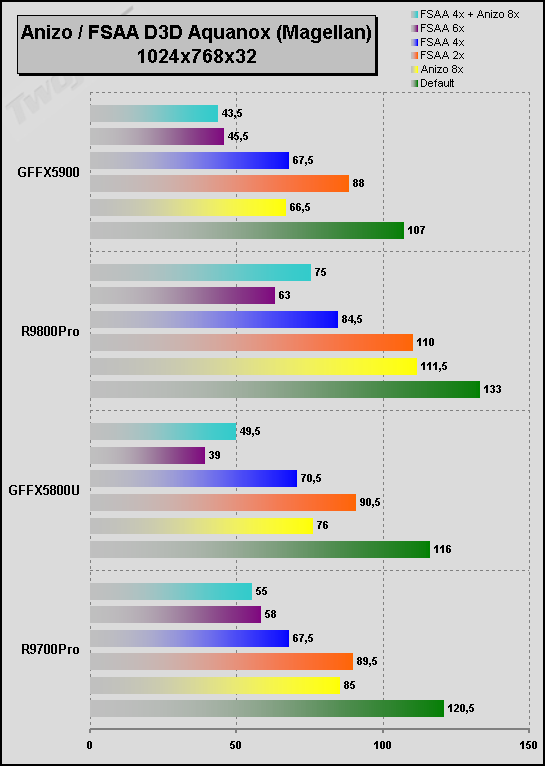

Wciąż jeszcze na placu bojów testowych pozostaje Aquanox, choć pewnie wraz z pojawieniem się wersji pod Dx9 on również odejdzie do lamusa. Piękne, podwodne wybuchy nieźle dają popalić każdej karcie a otaczające skały świetnie pokazują jakość oraz zalety zarówno filtrowania anizotropowego jak i pełnoekranowego antyaliasingu (o tym będzie później). Do testów używam dema Magellan. Wyniki są powtarzalne a rejestracja poziomu minimalnego fps również się przydaje do interpretacji. Niektórzy wykorzystują dedykowany benchmark oparty na tej grze o nazwie Aquamark. Jest wygodny w użyciu, ale z kolei jako standard zwiększa niebezpieczeństwo stosowania dodatkowych optymalizacji przez producentów kart.

Papierowe zwycięstwo w teście odniósł oczywiście R9800Pro. Papierowe, bo bez dokładnego pomiaru nijak tego nie określimy grając. Wszystkie trzy karty zachowują się dokładnie tak samo. Są jednak pewne przesłanki do ogólnych wniosków na temat wydajności kart. FX5900 minimalnie słabiej od FX5800U a R9800P lepszy od R9700P. To jednak jak dla mnie wciąż zdecydowanie za mało.

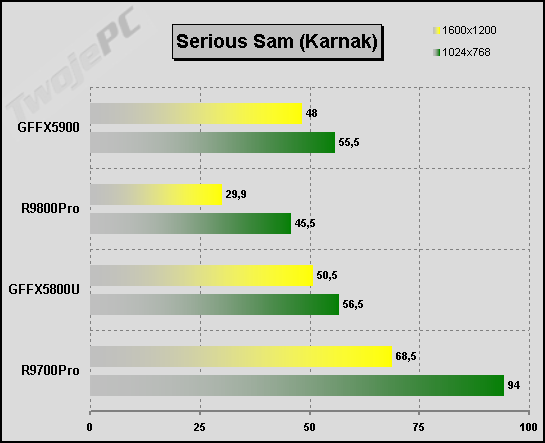

Kolejny test i kolejne rozczarowanie. Od dłuższego czasu do obrazowania zachowania kart w jednej z nielicznych gier, których silnik OpenGL nie wyszedł spod klawiatury Carmack'a był Sirius Sam. W poprzednim moim teście FX5800U wskazywałem na to, że niski wynik nowego GeForce'a z konkretnych przyczyn nie powinien świadczyć o ogólnej wydajności karty. Teraz będzie jeszcze dziwniej.

Z wyników testów wnioskować można, że R9800P jest zdecydowanie słabszy od swojego poprzednika R9700P, który osiąga bardzo wysokie wyniki. Jest to oczywista bzdura. Niestety stary Serious Sam po raz kolejny dobitnie potwierdził istnienie i działanie własnych procedur dostosowawczych do konkretnych rodzajów kart. Już dawno powinienem przejść na nowszą wersję. Trudno. Widocznie R9700P został prawidłowo zinterpretowany i dostał ogólną optymalizację jak dla wszystkich Radeonów, natomiast R9800P w ogóle nie został rozpoznany i wrzucono go na jakiś uniwersalny port zapewniający kompatybilność z jak największą ilością kart. Podobnie moim zdaniem sprawa ma się z FX5800U oraz FX5900. Znowu nie mogę niczego wysnuć w kwestii ogólnej wydajności. Proszę to potraktować tylko jako ciekawostkę. Więcej testów SS robić nie będę. Musiałbym mieć nową wersję a zdecydowanie wolę po prostu odesłać go na emeryturę.

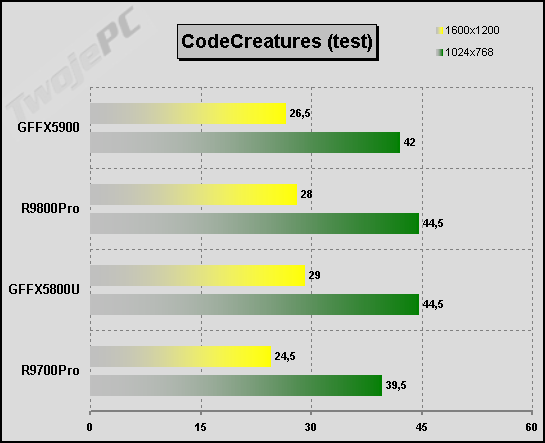

Przyszedł czas na niewątpliwego "kilera", jakim jest "przyrodniczy" test CodeCreatures. Nareszcie coś ciekawego.

Dzięki zwiększeniu zegarów nowy Radeon "dopadł" w końcu FX'a. Nie było to łatwe, bo demo opiera się na gigantycznym Fill Rate nowych kart nVidia związanym z ich taktowaniem a dodatkowo zostało napisane i najlepiej zoptymalizowane na kartach tego producenta. Nie można jednak wykluczyć, że wszyscy zawodnicy zastosowali tu dodatkowe sztuczki wspomagające. Swoją drogą ucieszyłem się, że w końcu widać gołym okiem, kto tu jest lepszy. Przynajmniej w 1600x1200x32. Kolejność na mecie (od najlepszego wyniku): FX5800U, R9800Pro z minimalną stratą, FX5900, któremu jak widać zaszkodziło obniżenie zegarów i na końcu R9700Pro. Nowy Radeon jest wyraźnie mocniejszy od poprzednika natomiast o FX5900 już tego powiedzieć nie można. W tym teście FX5900 nie skorzystał z większej przepustowości szyny pamięci.

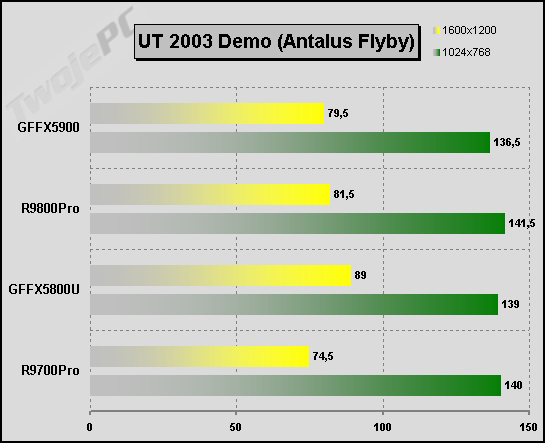

Teraz zaserwujemy jedną z nowszych i ważniejszych gier FPP. Przynajmniej dla mnie.

Klasyczne testy (c.d.)

W 1024x768 o wyniku decyduje procesor. W 1600x1200x32 jest już jakieś zróżnicowanie. Na punkty w tym teście wygrywa GFFX5800U. Nie można tego powiedzieć o całej grze, bo w zależności od mapy testowej zmienia się zachowanie kart. Z resztą w samej grze nijak nie mogę wyczuć różnic pomiędzy kartami. Widocznie poziom minimalnego fps jest zbliżony. W dalszej części testów dorzucę kartom FSAA i filtrowanie anizotropowe. Może łatwiej będzie wyłonić lidera. Na razie jest potwierdzenie tego, że FX5900 może być trochę słabszy od poprzednika oraz od R9800Pro.

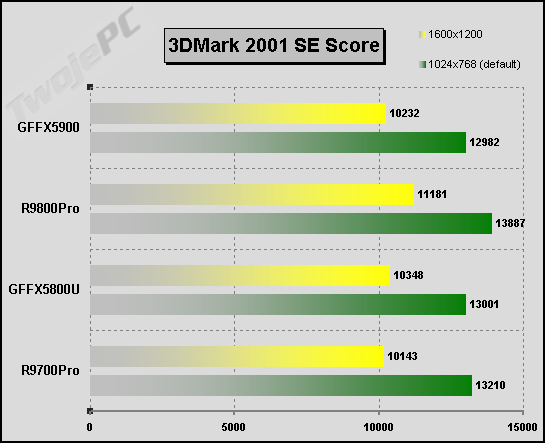

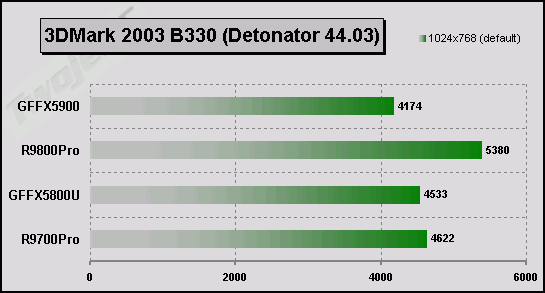

Dla odprężenia coś dla miłośników 3DMarka 2001 SE (330).

Chyba nietrudno się domyśleć, co o nim sądzę. Nawet wyniki w 1600x1200x32 wskazują na wpływ procesora na punktację ogólną. Tym bardziej nie ma się, co entuzjazmować testowaniem w trybie domyślnym. Nie ma również najmniejszej wątpliwości, że przynajmniej częściowo wyniki są naznaczone "optymalizacjami" ze strony producentów. Nie wiem czy to nie będzie ostatnia recenzja, w której w ogóle zamieszczam wyniki testu default. Każdy niech je sobie interpretuje po swojemu. Dla mnie jest on już za słaby, zbyt "oklepany" i szkodliwy, bo prowadzi głównie do niepotrzebnego pompowania pieniędzy w procesor i jego okolice.

Przymierzam się również do wdrożenia w recenzjach porównania w grze Splinter Cell. Oparta na silniku Unreal'a gra, choć nie wykorzystuje efektów Dx9 to wydaje się niezłym obciążeniem kart graficznych. W najnowszym patchu zawarte się procedury testowe, które pozwalają na łatwe przeprowadzenie badania fps. Splinter Cell ma jednak jedną wadę. Nie nadaje się do porównań z włączonymi efektami FSAA/Anizo. Jedną z przyczyn jest fakt wyłączania przez sterownik nVidia FSAA w momencie rozpoznania tej gry. Nie widzę w tym nic zdrożnego, bo programiści gry wręcz odradzają stosowanie tych "ulepszaczy" ze względu na przyjęty model realizacji niektórych efektów. Prowadzi to do zbyt dużego spadku wydajności oraz powoduje możliwość wystąpienia błędów w obrazie.

Nie zdążyłem zebrać wyników R9800Pro, ale nie powinno być wątpliwości, że będą nieco wyższe niż u poprzednika. Wyniki wstępnych testów prowadzą do wniosku, że nowy Radeon nieco lepiej poradzi sobie z tą grą, choć różnica będzie minimalna.

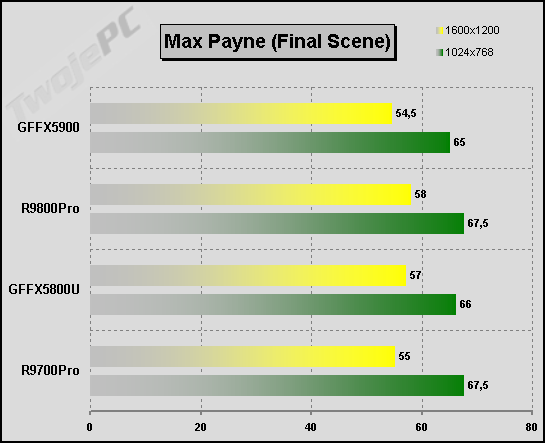

Może na koniec tej części testów podam wyniki Max Payne.

Bez komentarza. W zasadzie nie wnosi nic nowego.

Testy za pomocą aktualnych gier można mnożyć w nieskończoność, ale już po przeprowadzeniu kilkunastu jasny staje się fakt, że obie karty są zdecydowanie wydajniejsze niż jest to nam potrzebne, aby cieszyć się nimi przy znakomitej jakości obrazu. Nie pozostaje nam nic innego jak dorzucić kartom pracy w postaci wymuszenia filtrowania anizotropowego czy pełnoekranowego antyaliasingu. Wtedy może uda się wyłonić realnego zwycięzcę porównania.

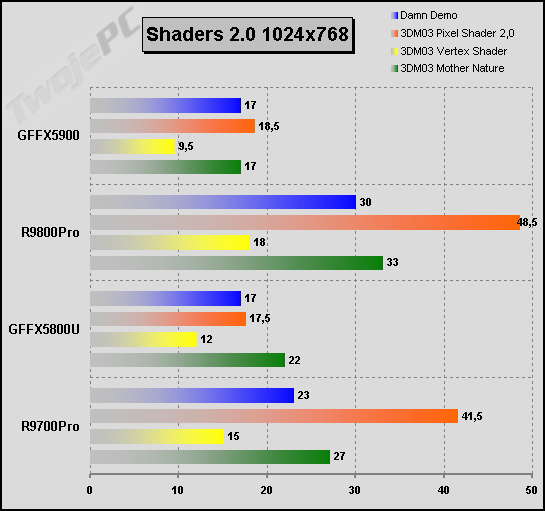

Shadery 2.0

Sądzę, że zdecydowanie ważniejszą zaletą takich gigantów nowej generacji jest, przynajmniej w teorii, ich przygotowanie do obsługi przyszłych gier. Wcześniej czy później shadery w wersji 2.0 dojdą do głosu i dopiero wtedy nastąpi rzeczywista masakra starszych kart Dx8. Na razie w zasadzie nie ma możliwości jednoznacznego określenia potencjalnej mocy, jaką dysponują testowane karty w odniesieniu do zapowiadanych produkcji. Mamy jakieś strzępki informacji pochodzące z bardziej lub mniej "sponsorowanych" testów wersji beta, lakoniczne wypowiedzi programistów, mylące testy własne producentów sprzętu, "optymalizowane" pod benchmarki dx9 sterowniki, szum marketingowy, plotki i teoretyczne rozważania. Zanim spróbuję przynajmniej coś zasugerować to przeprowadzę jeden, ponoć kontrowersyjny test.

O najnowszej produkcji Futuremark'a napisano już tyle artykułów, że po przeczytaniu zaledwie małej części z nich może się komuś z mózgu zrobić typowa sieczka. Z jednej strony 3DMark2003 może być potrzebnym narzędziem testującego karty Dx9, ale z drugiej strony goni go cały tabun różnych afer i wzajemnego obrzucania się błotem zarówno przez producentów jak i użytkowników. A prawda jak wiadomo leży z reguły pośrodku.

Wnikliwym czytelnikom powinno od razu skojarzyć się, że niektóre wyniki znacząco różnią się od tych, które uzyskałem przy okazji pierwszego testu GFFX5800U. Najbardziej widoczne jest to przy GFFX a wynika nie ze zmiany sterowników, ale z nowej wersji programu testującego. Okazało się, że producenci układów a w szczególności nVidia zastosowali daleko idące "optymalizacje" służące poprawianiu wyniku. Nowa wersja benchmarka (build 330) utrudniła sterownikom prawidłowe wykrycie programu i dostosowanie się do niego. Z kolei sterowniki beta v44.65 omijają blokadę wprowadzoną przez FutureMark i tak można długo kręcić się w miejscu.

Okazało się, że obie firmy stosowały spotykaną już przy grach operację podmiany programu shadera na taki, który przy zbliżonym obrazie wynikowym (ATI twierdzi, że identycznym i podmiana dotyczyła tylko GT4 natomiast nVidia wymieniła shadery GT2-4 a obraz minimalnie się różnił) lepiej dostosowywał się do możliwości sprzętu. Jak dla mnie nie ma w tym nic specjalnie szkodliwego a wręcz przeciwnie, można to nazwać faktyczną optymalizacją tym bardziej, że osobiście nie widziałem specjalnych pogorszeń obrazu na FX'ie (różnice wychodzą dopiero przy serii nieruchomych zrzutów ekranu). Niestety takie dostosowanie to tylko drobiazg w porównaniu z tym, co dodatkowo stosował nowy GeForce. Chodzi o technikę "clipping frames" sprowadzającą się do omijania w renderingu fragmentów obrazu, które w danym momencie nie są widoczne dzięki kompletnej wiedzy o całym procesie przetwarzania danej grafiki. W związku z tym, że tej metody nie da się zastosować do dynamicznie zmiennej gry można śmiało pisać o nabijaniu testujących, a co za tym idzie również potencjalnych klientów w przysłowiową butelkę. Oczywiście, jeśli celem testu jest określenie rzeczywistych możliwości przetwarzania 3D przez kartę a nie tylko zdobywanie "pustych" punktów. Właśnie ze względu na to, rozmyślnie, w porównaniach dotyczących kart różnych firm dawałem wyniki "nieoptymalizowane". Przynajmniej częściowo.

Rozpatrując tylko taką "stronę medalu" można wysnuć proste wnioski, co do intencji nVidia, wydajności Dx9 ich nowych kart i odsądzić ich od czci i wiary. W życiu jednak nie jest tak, że wszystko jest albo czarne albo białe. Jest jeszcze druga strona. Aby ją wydobyć na wierzch najpierw trzeba się zastanowić, dlaczego w zasadzie FX bez "optymalizacji" nie błyszczy w tym teście? Przyczyn może być kilka, ale ja chciałbym skoncentrować się na jednej, konkretnej kwestii. W zasadzie mógłbym wysnuć prosty wniosek: Nie da się porównać wydajności w nowym API zgodnych z tym standardem kart ATI oraz nVidia. Sprawa dotyczy dokładności obliczeń zmiennoprzecinkowych (wymóg Dx9) renderingu. Microsoft w opisie standardu określił dwie możliwe do zastosowania precyzje danych FP: 16-bitową zwana "częściową" (Partial Precision) oraz 24-bitową zwana "pełną" (Full Precision). Silnik graficzny ATI operuje zawsze na 24-bitowej precyzji. Jeśli aplikacja zażąda częściowej to układ dokona obliczeń w pełnej, bez żadnego zysku na wydajności. GeForceFX natomiast ma układ jednostek obliczeniowych pozwalający na użycie połowy z nich w przypadku braku zapotrzebowania na pełną precyzję, co daje konkretny przyrost mocy przetwarzania. Jeśli natomiast wymagana jest pełna precyzja to obliczenia realizuje cały moduł obliczeniowy w trybie 32-bitów. Jest to zgodne ze specyfikacją IEEE i w związku z tym, że przekracza wymóg stawiany przez Dx9 można ten model obliczeń nazwać "pełną precyzją" również w API Microsofta.

Wraz z dokładnością obliczeń wiąże się kwestia zarówno jakości grafiki 3D jak i szybkości jej przetwarzania. Aby porównać musielibyśmy sprowadzić obie karty do wspólnego "mianownika". Niestety nie jesteśmy w stanie tego zrobić. FX jest zmuszony do obliczeń w 32-bitach, aby można to było nazwać pełną jakością Dx9 natomiast Radeon zawsze liczy w 24-bitach. Podkreślam, że chodzi o precyzje obliczeń a nie sam kolor.

Analizując dziesiątki mądrych wypowiedzi w tej kwestii dopracowałem się następujących wniosków (po analizie obydwu "obozów").

- Różnica w jakości renderingu pomiędzy 32 a 24-bitową precyzją jest znacznie mniejsza niż pomiędzy 24 a 16-bitową. Sądzę, że większość jest w stanie to zrozumieć i potwierdzić. Można zrobić sobie analogię do kolorów.

- Zupełnie odwrotnie jest z kwestią skomplikowania obliczeń i co za tym idzie czasu ich wykonywania. Mniej dodatkowej pracy zajmuje przejście z 16 na 24 niż z 24 na 32-bity. To też można pokazać za pomocą prostych pętli wykonujących obliczenia na różnej precyzji.

- Realna różnica jakości grafiki w zależności od użytej precyzji zależy w dużym stopniu od tego jak zostanie napisany shader. Programista może chcieć uzyskać taki efekt, że przy zastosowaniu 16-bitowych obliczeń obraz wyraźnie straci (głównie kwestia finalnych przejść pomiędzy odcieniami kolorów po sprowadzeniu do 32-bitowej palety). Może też opracować efekt, który nie da znaczącej przewagi karcie z 24-bitową precyzją.

Jednym słowem bez konkretnych aplikacji niewiele w tej kwestii można powiedzieć. Wszystko jest w rękach programistów. Na korzyść ATI może świadczyć fakt zgodności ze specyfikacją Microsofta, z którą przecież programiści muszą się liczyć oraz realny zysk w jakości obrazu. nVidia z kolei ma większą uniwersalność ze względu na lepszą możliwość dostosowania się do konkretnych wymogów stawianych przez daną grę. Niestety może również nie licząc się z nikim wymuszać mniejszą precyzję do osiągania przewagi benchmarkowej i maskować w ten sposób inne niedociągnięcia swoich układów. Oczywiście teoretycznie. Nie ma co ukrywać, że jest o co walczyć bo klient uwielbia porównywać same liczby fps i na tej podstawie dokonywać zakupów. Jakieś mętne wyjaśnienia związane z niemal niewidocznymi różnicami w obrazie nawet go nie zainteresują. Może i słusznie.

Raczkującym dopiero kartom Dx9, wyprodukowanym przez nVidia na przeszkodzie stanął jednak Microsoft oraz FutureMark ze swoim 3DMarkiem 2003. Ten pierwszy wymyślił sobie minimum 24-bity (osobiście skłonny jestem przypuszczać, że kierowali się rzeczywistą jakością, bo trudno mi sobie wyobrazić, aby w momencie powstawania docelowej specyfikacji nowego DirectX'a ATI miało jakąś większą od nVidia siłę przebicia u takiego giganta-monopolisty jak Microsoft) precyzji zmiennoprzecinkowej a ten drugi uparł się, że nie będzie stosować specjalnych optymalizacji dla kart FX tym bardziej, że według FutureMark nVidia zażądała tego zbyt późno, aby można było kwestię rozważyć i zatwierdzić u wszystkich firm, które wyłożyły grubą kasę za uczestnictwo w programie 3DMarka. Nie pozostało nic innego jak wypisać się z towarzystwa i odciąć od wyników tego testu. Biorąc pod uwagę wiedzę na temat znaczenia wyników na sprzedaż produktu może nawet nie mieli innego wyjścia. Próby dyskredytowania testu, jak można było przewidzieć, niewiele dały i pozostała ta słynna "optymalizacja". W pierwszych sterownikach zaatakowano trybem 16-bitowym precyzji obliczeń, a w aktualnych - wobec pożądania WHQL - wprowadzono cały szereg innych modyfikacji, z których na pierwszy plan wybija się bezsprzeczny cios poniżej pasa w postaci wspomnianych "clipping frames".

W zasadzie, właściwie jestem w stanie zrozumieć działania nVidia w tej kwestii, choć oczywiście ze zrozumiałych względów budzą mój sprzeciw. Bardziej jednak denerwują mnie wypowiedzi przedstawicieli firmy, dla których w każdym przypadku brak optymalizacji wobec ich kart i trzymanie się specyfikacji API oznaczane jest jako świadome faworyzowanie konkretnej firmy. Nie ważne, że sami również uczestniczyli w tworzeniu API i nie ważne, że w ten sposób podcina się nogi nie tylko firmie, z którą aktualnie prowadzi się boje marketingowe, ale i wszystkim innym, którzy chcieliby wejść na ten rynek a jedyne, do czego się mogą dostosować to właśnie uniwersalny interfejs programowy. Typowe działania monopolistyczne. Z resztą jak bym na to nie patrzył to ciągle widzę pewne odniesienia do historycznych pojedynków nVidia - 3Dfx. Kwestia Glide vs OpenGL/D3D, sprawa ilości kolorów, kwestia dostosowania aplikacji do 16-bitowej palety koloru itd. Role jakby się trochę odwróciły, ale historia wyraźnie lubi zataczać kręgi. Deja vu?

Jak zmierzyć moc obliczeń PixelShader'a 2.0? Oprócz 3DMarka jest jeszcze ShaderMark 2.0 i RightMark3D Dx9. Trudno jednak być pewnym braku "optymalizacji" producentów kart. Raczej przyjdzie czekać na gry i kolejne benchmarki. Pozwoliłem sobie natomiast na ciekawostkę, jaką jest słynne demo nVidia z "rusałką". Jest to o tyle interesujące, że jako własne demo, które z natury zastosowania dedykowanych rozszerzeń OpenGL nie mogło być porównane wydajnościowo z konkurencją było optymalizowane na jakość obrazu. Radeony wręcz miażdżą prawowitych właścicieli tego demka wydajnością (zrobiłem dziesiątki zrzutów starając się dowieść, że na ATI jakiś widoczny efekt Shadera jest pomijany). Niewątpliwy cios dla marketingu nVidia. W pierwszej tabeli, oprócz "rusałki" dałem też nieoptymalizowane wyniki testów 3DMarka wykorzystujące, przynajmniej częściowo nowy standard shaderów:

Już po moich testach R9800Pro i FX5800U pojawił się GunMetal 2 Benchmark wymagający Dx9. Niestety, nie wykorzystuje on PixelShader'a 2.0. Szkoda, że Aquamark 3.0 nie jest jeszcze gotowy.

Pewną aproksymację wydajności przy R9800P można dokonać biorąc pod uwagę różnice do poprzednika. Prawdopodobnie nowy Radeon będzie działał podobnie jak FX5900. Ciekawostką jest fakt, że benchmark ma na stałe włączony antyaliasing (2x lub 4x). Dzięki temu, że sterowniki nVidia umożliwiają wymuszenie wyłączenia FSAA można było również przeprowadzić taki test (faktycznie obraz był zdecydowanie słabszy). Zauważyłem też na R9700Pro zakłócenia tekstur w niektórych fragmentach obrazu. Nie wiem czy dotyczą również samej gry, ale chyba wskazują na to, że demo nie było przygotowywane z wykorzystaniem kart ATI.

Przeprowadziłem również testy syntetyczne z wykorzystaniem RightMark3D i ShaderMark zawierających programy dla PixelShader 2.0. Również i w tym wypadku było to tylko porównanie R9700Pro z FX5900. Jestem jednak pewny, że na R9800Pro może być jedynie lepiej lub dużo lepiej.

Szczególnie interesujący wydaje się RightMark, bo potrafi pokazać 16 i 32-bitowy tryb precyzji FX'a. Jak widać różnica może sięgać nawet 40%. Nieźle. Dlaczego Radeony masakrują wydajnością nowe karty nVidia nawet w 16-bitowy trybie? Nie wiem. Czy mają spec "optymalizację", o której nie wie albo nie chce wiedzieć ich twórca (programista ShaderMark jedynie narzekał na zagrywki starszych sterowników nVidia)? Może też chodzić o problem niedostosowania silników tych aplikacji do architektury nVidia. A może układ ATI R3x0 faktycznie ma zdecydowanie wydajniejszy PixelShader? Pewnie dowiemy się tego dopiero wraz z wysypem gier Dx9. Niepokojące jest jednak to, że praktycznie wszystkie dotychczasowe testy PS2.0 obnażają jakąś słabość nVidia w tym zakresie. W tej chwili zarówno w pod względem wyników testów syntetycznych jak i praktycznej zgodności z API Radeon wydaje mi się nieco bezpieczniejszy. Może nie bez znaczenia jest również fakt, że układ już od roku znajduje się w łapach programistów, stanowiąc pierwotną bazę sprzętową do produkcji nowych gier i choć w końcu doczekał się konkurencji to nie sądzę, aby mógł zostać pominięty w produkcie finalnym. To jednak tylko gdybanie.

No to, kto w końcu jest mocniejszy w Dx9? Kwestia jest ważna, bo dotyczy sprawy lepszej "inwestycji w przyszłość". Jeśli pominiemy sprawę braku przystosowania wzajemnego wyników oraz możliwości manipulacji benchmarkami to mam wrażenie, że jednak ATI. Przynajmniej przy zgodności aplikacji z uniwersalną specyfikacją Microsoft Dx9. Wobec braku innego oprogramowania testowego mogę to jednak traktować głównie intuicyjnie.

FSAA i filtrowanie anizotropowe

Przejdźmy do kolejnego rozdziału porównań wydajności. Testowane karty mają w odniesieniu do aktualnych gier tak dużą nadwyżkę mocy, że w oczekiwaniu na nowe, godne ich wydajności możemy wykorzystać ją na dodatkowe poprawienie jakości obrazu. Sterowniki umożliwiają wymuszenie w grach pełnoekranowego antyaliasingu oraz filtrowania anizotropowego. Ten pierwszy, zwany w skrócie FSAA pozwala na eliminację efektu "schodków" na prostych rantach pochyłych obiektów zawartych w obrazie 3D. Filtrowanie anizotropowe poprawia dokładność renderingu obiektów znajdujących się w większym oddaleniu od obserwatora sceny. Zacznijmy od antyaliasingu.

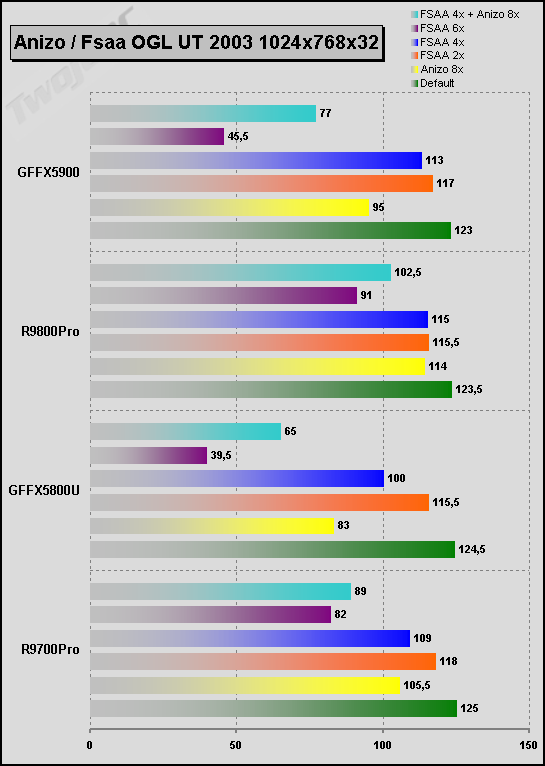

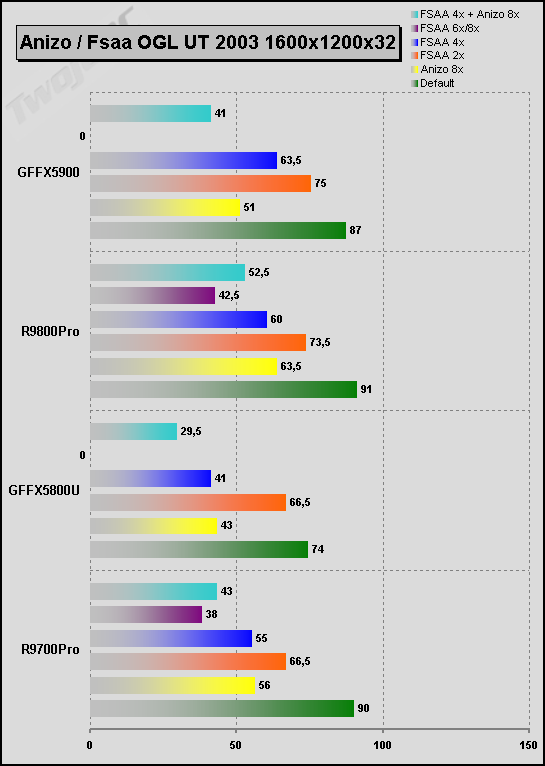

ATI dysponuje trybami FSAA: 2x, 4x oraz 6x. Cyferki związane są z ilością próbek, jakie układ musi renderować w celu stworzenia poprawionej ramki obrazu. GeForceFX umożliwia wymuszenie w sterowniku następujących trybów: 2x, 4x, 6x oraz 8x. W zasadzie najwyższym trybem sprzętowym nVidia jest 4x a 6x (tylko w D3D) oraz 8x (D3D oraz OpenGL) należy traktować bardziej marketingowo (dodatkowe wsparcie programowymi algorytmami supersamplingowymi).

W związku z tym, że każdy z układów posługuje się własnymi algorytmami obliczania efektu to jakość wynikowa obrazu nie będzie jednakowa. Aby prawidłowo porównać możliwości wydajnościowe kart należy najpierw skonfrontować efekt, jaki wywołuje konkretne ustawienie na każdej z kart. Po sprawdzeniu kilkunastu gier i przeanalizowaniu dziesiątek zrzutów obrazu nasuwający się wniosek nie będzie łaskawy dla nVidia. Algorytmy ATI dają zdecydowanie lepszy efekt. Przykładową różnicę starałem się pokazać na przykładzie dema "lotniczego" z 3DMarka2003. W związku z tym, że moim zdaniem zbiorczy obrazek słabo oddaje różnice to proponuję ściągnąć przygotowaną paczkę z kompletnymi zrzutami bez kompresji (RAR - 5 MB).

W trybie 2x obie karty uzyskują zbliżony efekt wizualny. Różnice dotyczą dopiero trybów 4x i wyższych. FX przechodząc na 4 próbki uzyskuje dalszą poprawę obrazu, ale do tego, co w tym trybie pokazuje ATI już mu bardzo daleko. Tryb 6x prowadzi w ATI do jeszcze większego wygładzenie "schodków" natomiast przy nVidia mogę już raczej powiedzieć, że jest inaczej niż lepiej. To samo dotyczy również trybu 8x, którym się "szczyci" już jedynie GeForce. Aby to było bardziej zrozumiałe: żaden z trybów nVidia 4-8x nie może się równać z ATI 4x a Radeon ma jeszcze w "zanadrzu" tryb sześciopróbkowy. Zobaczmy, jaki wpływ na wyniki testów mają poszczególne tryby:

*) W UT2003 OpenGL FX odmówił uruchomienia trybu 8x dając w zamian 4x.

Patrząc na generowany przez FX'a obraz FSAA 6x nie mam pojęcia, na co właściwie "poszła" cała moc układu. Słaba jakość przy fatalnym spadku mocy karty. W związku z wyraźną różnicą optyczną w trybie 4x w zasadzie trzeba i na te wyniki również spoglądać przez pryzmat jakości. Gdyby ATI miało dodatkowy tryb pośredni pomiędzy 4x a 2x to prawdopodobnie właśnie on odpowiadałby klasie 4x GeForce'a i wtedy mógłbym dopiero porównywać fps'y. Przypominam o zasadzie pomiaru: najpierw zapewnijmy ten sam poziom jakości obrazu a dopiero potem porównujmy czas generowania ramek. Przejdźmy do drugiego efektu.

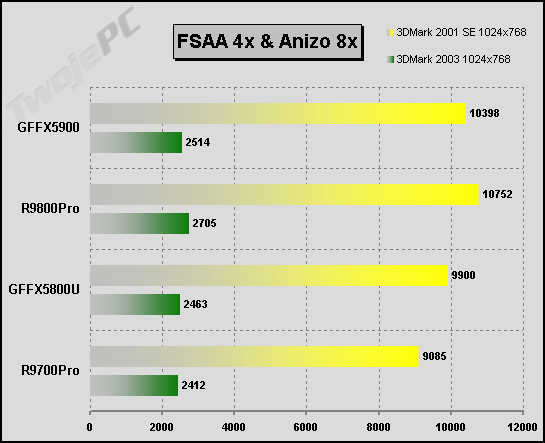

GeForceFX prezentuje najwyższą jakość filtrowania anizotropowego, jaki dotychczas udało się stworzyć firmie nVidia. Bardzo dobra jakość i świetna wydajność (poprzednio prezentowane tabele zawierają również wyniki Anizo 8x). Starsze układy GF4 nie mają szans w konfrontacji. Porównując z trybem Quality dostępnym w nowych kartach Radeon różnica nie jest duża. Tym nie mniej dzięki temu, że w odróżnieniu od ATI brak jest efektu pogorszenia filtrowania tekstur nakładanych pod pewnymi kątami trzeba przyznać palmę pierwszeństwa jakości Anizo FX'owi. Oba układy mają również możliwość zwiększenia wydajności filtrowania kosztem pewnego pogorszenia obrazu. Na to chciałbym zwrócić szczególną uwagę posiadaczom ATI. Tryb wydajnościowy filtrowania anizotropowego Radeona charakteryzuje się realnie małym pogorszeniem jakości przy konkretnych zyskach wydajnościowych. GeForce również potrafi szybciej filtrować, ale efekt jest zdecydowanie słabszy. Czas na dodatkową tabelkę fps. Przykładowe testy pokazują wpływ włączenia zarówno filtrowania anizotropowego jak i FSAA.

Na podstawie większość testów można wysnuć kilka ogólniejszych wniosków na temat wydajności "ulepszaczy". W większości przypadków wydajność FSAA/Anizo FX5900 jest zdecydowanie wyższa niż u poprzednika. Również R9800Pro notuje konkretny przyrost w stosunku do R9700Pro. Nadal jednak najnowszy Radeon zachowuje (średnio licząc) przewagę nad konkurencją nVidia. Również należy brać pod uwagę to, że w niektórych sytuacjach z bliżej mi nieznanych przyczyn FX5900 zachowuje się tak jakby nie miał zysku z 256-bitowej szyny (a to powinno być typowe dla FSAA) i potrafi przegrać bój z FX5800U. Generalizując (może nie widać tego na tabelach) FSAA oraz Anizo chyba jednak trochę lepiej dopracował ATI. FSAA wygląda na FX wyraźnie gorzej przy zbliżonym spadku mocy natomiast Anizo wygląda minimalnie lepiej, ale zabiera więcej wydajności kartom FX.

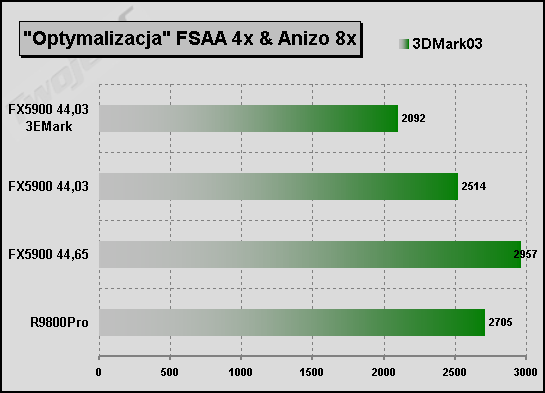

Porównując wydajność filtrowania anizotropowego musimy niestety brać również pod uwagę nieprzyjemny zgrzyt, jakim jest kwestia dodatkowego "optymalizowania" przynajmniej niektórych wyników testów przez sterowniki nVidia. Po wykryciu konkretnej aplikacji testowej, niezależnie od naszego ustawienia Anizo działa zawsze w trybie szybkim, który jak wspominałem ma znacznie słabszą jakość. W powyższej tabelce dałem jako przykład wynik ogólny 3DMark2003. Sterownik dał się oszukać przez prostą zmianę nazwy pliku wykonywalnego programu testowego na "3EMark.exe", nie nastąpiła zmiana klasy filtrowania i wynik spadł z 2514 do 2092 (ok. 20%). Może i nie jest to dużo, ale trzeba w testach brać pod uwagę i taką możliwość. Jak dla mnie są to zupełnie niepotrzebne sztuczki, które głównie szkodzą wizerunkowi producenta. Pewną podejrzaną regułą dla mnie był fakt, że w tych grach, w których wydajność Anizo jest najwyższa miałem również najwięcej zastrzeżeń, co do jakości obrazu. Bez "optymalizacji" jakość filtrowania FX'a broni się sama, ale innym jak widać lepiej do portfela wchodzi się przez liczby testowe.

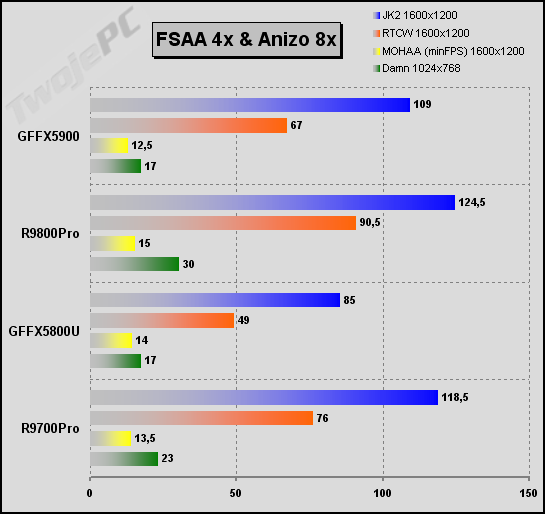

W pewnym momencie ogarnął mnie niesmak związany z brakiem konkretów wśród wyników większości testów i w przypływie rozpaczy postanowiłem również dać mały test opisowy. Wybrałem kilka demonstracji gier samochodowych, bo w sam raz miałem je zainstalowane i nie ukrywam, że lubię ten gatunek. Uruchomiłem program Fraps i trochę pograłem. Nie notowałem żadnych średnich wyników a jedynie starałem się orientacyjnie zapamiętać chwilowe fps'y w konkretnych, bardziej dla kart kłopotliwych miejscach oraz mieć jak największą frajdę z gry w dużych trybach.

Zacząłem od dema CMR3. Trasa w Wielkiej Brytanii. Niestety od razu trafiłem na wpadkę z Radeonem. Gra zatrzymywała się na wczytywaniu trasy. Co dziwne pecet działał w tym czasie normalnie. W końcu po kilku minutach uderzania w klawisze Ctrl-Alt-Del, Enter, Esc itp. nagle układ się załadował i uruchomił. Działał normalnie, ale w takich warunkach zniechęciłem się kontynuacji testu. Okazało się, że po włożeniu FX'a objaw był identyczny. Chyba za szybko się poddałem. Gra potrzebowała powyżej 300MB wolnej pamięci na partycji, na której była zainstalowana. Po zwolnieniu miejsca FX nie miał już takich problemów, ale z kolei wydajność nie rzucała na kolana. W 1024x768 przy ok. 45 fps (w lesie) problemów nie miałem, ale po dodaniu FSAA 4x/Anizo 8x GF zaczął szarpać przy 23 fps. Nie sądzę, aby na R9800Pro było gorzej skoro R9700Pro w 1024 działał tak samo jak FX5800U a po dodaniu AF był już zdecydowanie lepszy (40 fps bez szarpania). Szkoda, że nie zrobiłem pomiarów na R9800Pro, ale skoro już poprzednik "pogonił" konkurencję to wynik byłby moim zdaniem oczywisty.

Następny był NFS-HP2. W 1280 oraz 1024 + AF (Anizo 8x/FSAA 4x) bez problemu dawało się w tych trybach grać na wszystkich kartach,choć na ATI moim zdaniem realna płynność była jakby większa. W 1280 + AF żadna karta nie już dawała płynności, ale zwycięstwo punktowe należało po raz kolejny do Radeonów.

W kolejności wystąpił Toca Driver w wersji demonstracyjnej. FX5800U odpadł w 1600x1200 natomiast pozostałe karty po dodaniu Anizo/FSAA. Dodatkowo karcie FX5800U w 1600 + AF posypały się tekstury. Sytuacja podobna do poprzedniej.

Na koniec uruchomiłem triala RalliSport Challange. Wszystkie karty dały radę w 1600, ale po dodaniu AF na placu boju pozostał sam R9800P.

Zdaję sobie sprawę, że takie opisy nie cieszą się specjalnym wzięciem czytelników, jeśli nie mają zaufania do testującego (niektórym się wydaje, że średnie fps w uznanych grach testowych są bardziej obiektywne). Wprawdzie było to wysoce tendencyjne porównanie, bo dotyczyło tylko samochodówek, ale jeśli osobiście miałbym wybierać kartę do tych gier, to zdecydowanie wolałbym nowego Radeona. W niektórych grach był dużo lepszy. Jeśli będzie zainteresowanie czytających to mogę kontynuować tego typu opisy również w przyszłych recenzjach.

Podkręcanie

Problematycznym, choć dla wielu użytkowników ważnym aspektem związanym z wydajnością jest zdolność kart do zwiększenia częstotliwości rdzenia i pamięci powyżej wartości domyślnych. Sprawdźmy, z jakim taktowaniem poradzą sobie porównywane karty i jakie im to przyniesie korzyści. Oczywiście należy najpierw zapewnić komputerowi odpowiednią wentylację wnętrza i w celu wyznaczenia granicznych częstotliwości należy wykonywać dosyć czasochłonne testy stabilności działania kart. Najmniejsze zniekształcenia obrazu pojawiające się po przynajmniej godzinnej pracy elementów w "stresie" powinny powodować konieczność obniżenia zegarów. W związku ze stosunkowo krótkim czasem trwania testów ograniczyłem się do przyspieszonych procedur, co powoduje, że ustalone przeze mnie wartości należy traktować jedynie orientacyjne. W dłuższej eksploatacji mogłoby się okazać, że konieczne jest dalsze obniżenie taktowania (o ok. 10MHz w odniesieniu zarówno do rdzenia jak i pamięci).

Domyślne taktowanie Radeona 9800Pro wynosi 380/340MHz (rdzeń/pamięć). Przypominam, że osobiście zawsze w przypadku pamięci (również DDR) podaje rzeczywiste taktowanie a nie wartość transferu (2x wyższą) nawet, jeśli tweakery wyskalowane są inaczej. Parcie na podawanie 2x większego taktowania przy kartach nVidia ma charakter historyczny (pojawiło się przy GF DDR) a wprowadzone zostało przez żądnych sukcesu marketingowców. Do podkręcania zegarów używałem narzędzia RadClocker. Udało mi się osiągnąć stabilne taktowanie 425/370MHz. Daje to średnio zwyżkę ok. 10%.

GeForceFX 5900 taktowany jest 400/425MHz. Za pomocą wpisu do rejestrów uaktywniłem narzędzie do zmiany częstotliwości zawarte w sterowniku. Najwyższe zegary, które uznałem za stabilne wynosiły: 460/490MHz (transfer pamięci 980MHz). Jest to różnica wyraźnie większa niż przy karcie konkurencji, bo przekraczająca średnio 15%.

Zobaczmy jak to się przełożyło na wyniki testów fps.

Gdzieś mi się zawieruszył jeden wynik, ale nie ma to chyba większego znaczenia. Jak widać w tabeli, dzięki różnicom w nadtaktowaniu karta FX5900 jest w stanie (średnio licząc) wyrównać dystans, jaki dzielił ją do Radeona 9800 Pro w taktowaniu domyślnym. Oczywiście pomimo tego, że ten ostatni również działał na wyższych zegarach (inne porównanie nie miałoby sensu). Można to potraktować jako dodatkowy plus karty nVidia. Oczywiście w przypadkach Dx9 oraz tych testów, w których FX ma zdecydowanie słabsze osiągi nie ma mowy o wyrównaniu różnic. Tym nie mniej uśredniając jestem w stanie przyjąć, że nadtaktowanie powoduje zniwelowanie różnic pomiędzy konkurentami (oprócz kwestii Dx9).

Podsumowanie

Zacznę od próby sprowadzenia kwestii wydajności nowych kart do kilku tez:

- Wydajność bez FSAA/Anizo w aktualnych grach klasy Dx7-8: W zdecydowanej większości przypadków FX5900 jest nieco słabszy od FX5800U. R9800Pro natomiast ma zawsze przewagę nad R9700Pro. Obie te zmiany wynikają wprost z różnic w taktowaniu. Natomiast porównując nowe karty ze sobą mogę stwierdzić, że (średnio licząc) wydajniejsza jest karta ATI. Oczywiście stopień różnic zależy ściśle od konkretnej gry i ustawień.

- Wydajność i jakość FSAA/Anizo: Oprócz pojedynczych przypadków FX5900 jest zdecydowanie wydajniejszy po włączeniu FSAA/Anizo od poprzednika. Wynika to wprost ze znaczącego zwiększenia przepustowości pamięci. R9800Pro w stosunku do R9700Pro notuje wzrost związany głównie z wyższym taktowaniem. Spadek wydajności związany z FSAA 2-4x jest podobny zarówno w przypadku kart ATI jak i nVidia. Przy 6x FX zdecydowanie słabnie. Obraz 2x podobny. Przy wyższych trybach wyraźna przewaga jakości ATI. Anizo mniej kosztuje mocy karty Radeon, ale jakość FX ma trochę lepszą.

- Wydajność w przyszłych grach wykorzystujących shadery v2.0: Nieznana. W aktualnych testach syntetycznych zdecydowana przewaga nowych Radeonów, ale nie jestem pewny czy z tego może coś wynikać.

- Wydajność po nadtaktowaniu: FX5900 podkręca się lepiej niż Radeon 9800Pro i następuje wyrównanie większości różnic w wydajności pomiędzy kartami (oprócz niektórych przypadków gdzie FX jest zdecydowanie słabszy). Obie karty mają większe możliwości zwiększenia zegarów niż ich poprzednicy.

Nie mam najmniejszych wątpliwości, że obaj główni bohaterowie artykułu zasługują dziś na rekomendację.

SuperGrace R9800Pro 128MB (ATI OEM)

Gwarancja świetnej jakości obrazu na każdym z wyjść. Najwyższa wydajność, na jaką stać aktualne karty graficzne zapakowana w standardowej wielkości laminat. Klasyczne chłodzenie. Umiarkowany hałas. Kompletne okablowanie. Niewielkie dodatki programowe.

|

MSI FX5900-TD128

Świetna jakość obrazu zarówno na monitorze jak i wyjściu telewizyjnym. Wydajność na najwyższym poziomie. Przemyślne i doskonale spełniające swoje zadania chłodzenie. Dobrze wyciszone w czasie pracy na pulpicie i całkowicie akceptowalne w 3D. Sprzętowy monitoring. Niezłe możliwości nadtaktowania. Bardzo bogaty zestaw oprogramowania. Komplet kabli i przejściówek.

|

Oczywiście ani Radeona 9800 Pro, ani GeForceFX 5900 nie można zaliczyć do różnych klas zarówno cenowych jak i wydajnościowych. Nie można żadnej z nich nazywać szumnie jakimś "kilerem". W przypadku ATI nastąpiła drobna korekta układu powodująca konkretne zwiększenie mocy związane z taktowaniem oraz dodatkowy bonus w postaci F-Buffer. NVidia natomiast skorygowała najważniejsze minusy swojej poprzedniej karty a trzeba przyznać, że kartom FX5800U oberwało się nieźle. Kosztem niewielkiego obniżenia wydajności udało się ściągnąć z karty tą wredną "suszarkę", o której wręcz opowiadano dowcipy. Drogie grzałki w postaci pamięci DDR-II zastąpiono tańszymi modułami a dzięki przejściu na 256-bitową szynę ich przepustowość wzrosła. Wbrew powszechnym opiniom miałem wrażenie, że sterowniki ATI są bardziej dopracowane, ale wynika to pewnie ze świeżości układu a dokładnie obsługi kontrolera pracującego z 2x szerszą magistralą. Wydaje mi się, że te gry, w których FX5800U mimo FSAA ma przewagę nad nowym FX'em oraz te, w których w najwyższych trybach grafika sypała błędami będą znikały wraz z kolejnymi wersjami sterowników. Szkoda natomiast, że nVidia nie wypracowała nowych algorytmów antyaliasingu, bo dla mnie jakościowo wciąż jest to poziom GF3. Z resztą nie mówię, że zły. Po prostu widząc dokonania konkurencji sądzę, że mogli ulepszyć. Cieszy natomiast doskonała jakość filtrowania anizotropowego. Może i trochę mniej wydajny niż Radeonów ale za to generujący nieco lepszy obraz. Do tego znakomita wydajność, ciche chłodzenie, dopracowane 2D i TV-out (poziom opisany w recenzji FX5800U). Nie mam najmniejszych wątpliwości, aby polecić tą kartę każdemu miłośnikowi aktualnych gier komputerowych. Jest to zdecydowanie najlepszy GeForce, jaki dotychczas się pojawił i jest w stanie przekonać do siebie nawet mnie. Ta sztuka nie udała się dotychczas kilku generacjom jego poprzedników. Otwarte natomiast pozostaje pytanie czy jest on lepszy od Radeona 9800 Pro. Jeśli ktoś ma odwagę i możliwości finansowe, aby przeznaczyć ok. 1900 zł na kartę graficzną to niech bierze według preferencji własnych korzystając z tej recenzji. Jeśli ktoś ma obawy przed ATI to nie ma się, co zastanawiać: GeForceFX 5900 będzie dla niego rewelacyjną propozycją. Tak samo jestem pewny, że Radeon 9800 Pro spełni oczekiwania zainteresowanych zakupem karty opartej na układzie ATI. Pragnę jednak zauważyć, że w przypadku tej ostatniej grupy nabywców warto zainteresować się również tańszymi produktami spod znaku Radeona. R9700 w cenie 1100-1200 zł ma również 256-bitową szynę danych i realnie daje zbliżone do tych topowych kart możliwości (szczególnie widoczne przy FSAA/Anizo w wysokich trybach nowych gier). W tym przedziale cenowym nie uda się znaleźć choćby zbliżonej wydajnością karty nVidia.

Obie porównywane karty wyświetlały znakomity obraz. Nie ma również wątpliwości, że realnie wyższej wydajności jak na razie nie jesteśmy w stanie uzyskać. Niestety za to wszystko trzeba zapłacić sumę, która dla większości wydaje się wręcz absurdalna. Jako, że są to karty, które należą do najwyższego pułapu cenowego to zasadnym wydaje się pytanie o wersje, które przy zachowaniu podstaw architektury dostępne będą za mniejszą kwotę dzięki obniżeniu taktowania. Jeśli chodzi o ATI to w takiej roli aktualnie występują karty R9700 oraz R9700Pro. Należy się jednak liczyć z tym, że niedługo znikną z rynku tak samo jak wszystkie inne produkty oparte na układzie R300. Zastąpić je mają karty R9800, ale jeśli ich cena nie zejdzie do poziomu przynajmniej 1300 zł to producent będzie miał lukę, której moim zdaniem nie są w stanie wypełnić karty R9600Pro nawet w zapowiadanych wersjach z lepszymi pamięciami. Ze strony nVidia na razie brak jakichkolwiek informacji o rychłym wypuszczeniu słabszej wersji FX5900. Niepokojące jest nawet to, że dodatek "Ultra" już został zarezerwowany i w zasadzie zmarnotrawiony dla produktu, który realnie niewiele więcej potrafi (to samo dotyczy Radeonów wyposażonych w 256MB DDR-II). Pozostaje wierzyć, że jak już rynek nasyci się nowym produktem to taka wersja zostanie zapowiedziana. Sporo zależy również od ruchów konkurencji oraz sprzedaży aktualnej oferty.

Można się długo zastanawiać, która z nowych kart jest lepsza, ale prawdziwe rozstrzygnięcia są dopiero przed nami. Tak naprawdę to nasze zainteresowanie takimi potworami ma charakter bardziej prestiżowy niż wynikający z realnych potrzeb. Sytuację może dopiero unormalnić wysyp serii superwymagających gier nowej generacji z olbrzymim zapotrzebowaniem na moc układu oraz żądającym wsparcia shaderów 2.0 (Dx9). Programiści oczywiście nie są na tyle szaleni, aby wyciąć możliwość cieszenia się z ich gier posiadaczom starszych kart (np. w niższych trybach, bez dodatkowych efektów i przy potężnym wsparciu procesora), ale przynajmniej pojawią się realne różnice w obrazie renderowanym przez nową generację układów. Problem w tym, że takich gier w zasadzie jeszcze nie ma i niewiele w tym zakresie można się dowiedzieć z testów. Stwarza to również możliwość wpływania na klienta za pomocą manipulacji wynikami testów syntetycznych, rozsiewaniem przeróżnych plotek, sponsorowaniem i preparowaniem testów, które nie mogą być weryfikowane. Nie będę ukrywał, że jak dla mnie ostatnio prym wiedzie w takich zagraniach nVidia. Nie podoba mi się, że w takiej skali "optymalizują" sterowniki oraz puszczają plotki o przekonywaniu programistów do wycięcia wsparcia dla konkurencji. Na pewno niejeden da się na to nabrać. A jeśli nVidia faktycznie stara się ukryć słabość shaderów FX'a? Dotychczasowe testy budzą pewny niepokój. I nie chodzi bynajmniej tylko o kontrowersyjnego 3DMarka. Wystarczy spojrzeć jak zachowuje się własne Demo na kartach konkurencji czy RightMark3D. Jeśli ktoś mnie pyta o dobór karty do nowych gier to z reguły odpowiadam, aby po prostu na nie poczekał. Równie dobrze może okazać się, że te obawy były niepotrzebne i gry nie potwierdzą tak dużej różnicy wydajności Dx9 pomiędzy NV3x a R3x0 (nie ma znaczenia czy zostaną spec zoptymalizowane pod FX'a czy ma on realnie wyższą wydajność). Pewnie dopiero pod koniec roku dowiemy się, która architektura lepiej się sprawdzi w przyszłych grach. Jeśli posiadacz grubszego portfela chce zaryzykować zakup już dziś to proszę bardzo. Z każdym z obecnych zastosowań obie karty poradzą sobie znakomicie. Ja przedstawiłem kandydatów najlepiej jak potrafiłem, ale wybór pozostawiam zainteresowanym...

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | Sklep Internetowy Sirius Computers |

|  | ABC Data Actebis |

|  | MSI Polska |

|