Test Pentium4 3,06 GHz Hyper-Threading

Autor: Lancer | Data: 03/12/02

|

Niemal dwa tygodnie temu jeden z dwu wielkich dostawców mikroprocesorów architektury x86 - firma Intel, zaprezentowała najszybszy z dotychczas znanych układów. Debiutujący, najnowszy Pentium4 jest prawdziwą "bestią" strasząca swą innowacyjną mocą. Ma nie tylko ostre, bo 3,06 GHz-owe pazury, ale także niezwykłe kły, zwane Hyper-Threading. Dzięki krajowemu oddziałowi firmy Intel, miałem pełną wrażeń przyjemność przetestować system oparty o ten niezwykły układ. Przyjrzyjmy się nowemu stworowi, który przybył od mnie wraz płytą główną Intel D850EMVR oraz dwoma modułami pamięci 256MB PC1066-32 Samsunga. Niemal dwa tygodnie temu jeden z dwu wielkich dostawców mikroprocesorów architektury x86 - firma Intel, zaprezentowała najszybszy z dotychczas znanych układów. Debiutujący, najnowszy Pentium4 jest prawdziwą "bestią" strasząca swą innowacyjną mocą. Ma nie tylko ostre, bo 3,06 GHz-owe pazury, ale także niezwykłe kły, zwane Hyper-Threading. Dzięki krajowemu oddziałowi firmy Intel, miałem pełną wrażeń przyjemność przetestować system oparty o ten niezwykły układ. Przyjrzyjmy się nowemu stworowi, który przybył od mnie wraz płytą główną Intel D850EMVR oraz dwoma modułami pamięci 256MB PC1066-32 Samsunga. | |

|

Hyper-Threading - z czym to się je?

Najszybszy procesor Intela oparty jest o to samo 0,13um jądro Northwood co opisywany jakiś czas temu układ taktowany zegarem 2,8GHz. Zastosowano ten sam stepping jądra C1. Fizycznie w stosunku do poprzednika jedyną różnicą jest wzrost taktowania osiągnięty podniesieniem mnożnika z 21 do 23x. Wzrost to nieznaczny, bo zaledwie 9 procentowy. Procesor nadal pracuje z magistralą FSB 133MHz (QDR) i zasilany jest napięciem 1,525V. Wzrost częstotliwości pociągnął za sobą zwiększenie ilości wydzielanej mocy. Teraz procesor grzeje się bardziej, gdyż oddać musi aż 83W ciepła. Dla porównania parametr ten w przypadku wcześniejszego układu 2,8GHz wynosił ledwie 68,5W (mowa jednak o mocy typowej, a nie szczytowej). W związku z tym pamiętacie zapewne, iż Intel jakiś czas temu zapowiedział konieczność podniesienia jakości zasilaczy na płytach głównych (nie przewidziany wcześniej w specyfikacji gniazda s478), aby te bez problemów potrafiły obsłużyć szybsze ale i bardziej pazerne na prąd procesory. Podstawę wyróżniającą dotychczasowe układy P4, a najnowszy zapewne już znacie. Jest nią aktywacja Hyper-Threading czyli współbieżności wielowątkowej.

Nowe logo procesorów P4 z Hyper-Threading

Współczesne układy zbudowane są w architekturze superskalarnej tzn. procesor wyposażony jest w kilka równolegle pracujących jednostek wykonawczych (tego samego typu). Poszczególne instrukcje trafiają do jednostek równoległych tylko pod warunkiem, że zależności między zadaniami pozwalają na to. Nie da się wykonać różnych operacji na równoległych jednostkach (np. zmiennoprzecinkowych) jeśli wynik jednego zadania jest bezpośrednio powiązany z tym wykonywanym w równoległej jednostce. Należy je wykonywać w odpowiedniej kolejności. W ten sposób część mocy leży odłogiem ponieważ np. tylko jedna instrukcja zadania jest wykonywana w jednostce zmiennoprzecinkowej, a kolejna wynikająca z niej musi czekać na wynik. Procesor Pentium4 posiada 6 jednostek wykonawczych z tym, że średni stopień ich wykorzystania wynosi 4,4 mikrooperacji/Hz.

Klasycznie procesor wykonuje jednocześnie wiele programów, które są uruchomione równolegle, ale każdy z nich składać się może z kilku wątków. Procesor musi dzielić czas między programy. Większość domowych maszyn wyposażonych jest w jeden procesor. Typowy przydział zasobów komputera powoduje wydzielenie określonego obszaru pamięci operacyjnej i czasu procesora dla każdego zadania. Każdy proces ma więc przydzielany określony czas w działaniu procesora (tu należy zwrócić uwagę, że obsługa samego systemu operacyjnego też zabiera czas). Po zakończeniu jednego zadania następuje przełączenie na kolejny. Nie odbywa się to jednak w sposób automatyczny. Zarządza tym system operacyjny. Samo przestawienie na inny tor też wymaga czasu. Im bardziej niemrawo to się odbywa, tym większa strata czasu pracy procesora, który czeka bezczynnie na nowe zadanie. W najbardziej niekorzystnym wypadku zajmie to nawet kilkaset taktów zegara! Do tego należy zwrócić uwagę, że nie zawsze jedno zadanie całkowicie zajmuje moc wszystkich jednostek wykonawczych CPU. Czas leci, a układ nie jest wykorzystany w 100%. Bardzo niekorzystnie więc to wygląda w przypadku pojedynczego układu. Zachodzi tu analogia do naszego sposobu myślenia. Nie skupiamy się na wielu rzeczach. Chcąc rozwiązać kilka problemów myślimy najpierw o jednym, potem zastanawiamy się nad kolejną czynnością, ewentualnie błądzimy myślami między kilkoma innymi. Przełączenie się między "zagwozdkami" też chwilę nam zajmie z uwagi na konieczność skojarzenia pewnych rzeczy.

Dlatego powstały platformy wieloprocesorowe. Wątki dzielone są przez system operacyjny między poszczególne układy (tak jak grupa kolegów myśląca jednocześnie skąd wziąć kasę na wieczorną imprezkę). Tu również wkracza wspomniany czas potrzebny na przełączanie zadań, ale procesory dzielą swój czas między zadania i zyskują dodatkowo na skróceniu liczby niezbędnych przełączeń na kolejne (może odbywać się to równocześnie z uwagi na podział zadań). W tym miejscu nie do podważenia jest rola systemu operacyjnego. Powinien on być w stanie sprawnie rozdzielać zadania między procesory, pilnować wyznaczonych przedziałów czasowych. Na dodatek musi dbać o podział zadań koniecznych do wykonania przez samego siebie! To potrafią jedynie systemy rodziny Windows NT (także 2000 i XP) i Unixowe. Niestety systemy z rodziny 9x oparte są o pojedynczą maszynę wirtualną, która jest wspólna dla wszystkich operacji wykonywanych przez system, a co z za tym idzie nie potrafi dzielić zadań między kilka procesorów. Ogranicza się tylko do przydziału czasu.

Aby jednak jeden program mógł skorzystać z dobrodziejstw maszyny wieloprocesorowej musi być napisany w odpowiedni sposób. Każdy program jest bowiem ciągiem instrukcji wykonywanych w odpowiedniej kolejności. Aby przyspieszyć jego działanie należy podzielić go na odpowiednie fragmenty możliwe do wykonywania równolegle. Jest to o tyle trudne, że wymaga dokładnej analizy kodu programu i wydzielenia odpowiednich informacji, tak by w dalszej kolejności możliwe było podzielenie tego samego programu na wiele wątków możliwych do wykonania przez wiele procesorów, ale także by działając na jednym procesorze można było wykonywać klasyczną metodą podziału czasu między wątki. Pewne kroki należy przewidywać, by wykonywane zadania nie zależały w tej samej fazie obliczeń od siebie.

Jak już wspomniałem - jeden procesor nie ma zawsze do końca wykorzystanych wszystkich jednostek wykonawczych, to czemu nie użyć marnującej się mocy do wykonywania kilku wątków jednocześnie - tak jak to czynią systemy wieloprocesorowe, ale z tą różnicą, że wątki liczone są nie na równoległych CPU, a na nieużywanych jednostkach tego samego mikroprocesora? Można. Należy jednak tak rozłożyć kilka wątków, aby korzystały z tych samych potoków jednostek wykonawczych jednego CPU jak to jest czynione przez jednostki wykonawcze wielu równoległych procesorów.

Umiejętność rozłożenia obliczeń z różnych zadań na kilka jednostek wykonawczych sprawi, że stopień ich wykorzystania w tym samym CPU wzrośnie. Tym samym można wręcz rzec, że wzrośnie sprawność pojedynczego procesora. Tym właśnie jest technika Hyper-Threading. Możliwością wykonywania kilku równoległych zadań metodą rozdzielenia wątków między poszczególne, niewykorzystane jednostki tego samego procesora, a uściślając - metoda działania Hyper-Threading daje możliwość jednoczesnego wykonywania dwóch wątków równocześnie (nie trzech, ani czterech!).

Warto tu wspomnieć, że nazwa Hyper-Threading jest w zasadzie tylko marketingową nazwą czegoś, co się fachowo nazywa SMT-Simulation MultiTreading. Pentium4 jest pierwszym konsumenckim procesorem potrafiącym korzystać z tej innowacyjnej technologii, która jak już nawiązałem, swą podstawę bierze z systemów wieloprocesorowych (SMP-Symmetrical MultiProcessing). Początki technologii HT sięgają 1996r kiedy to inżynierowie Intela zaczęli myśleć o implementacji technologii SMT w swych procesorach. Jak wiemy udało im się to, ale warto wspomnieć że pierwszymi, którzy niemal tego dokonali byli ludzie pracujący nad procesorem Alpha EV8 zdolnym do jednoczesnego wykonywania aż czterech wątków. Technologia HT przez jakiś czas była znana jako Jackson's Technology i została pierwszy raz zaprezentowana na IDF rok temu. Początkowo trafiła do serwerowych procesorów Pentium4 Xeon z jądrem o kodowej nazwie Foster. Co ciekawe jądro tego CPU jest oparte o tym samym projekcie Willamette co pierwsze Pentium4. Wraz z doniesieniami o braku większych konstrukcyjnych różnic między "Wilmą" a Northwoodem, oraz obecności sporej liczby nadmiarowych tranzystorów, które ciężko przypisać do poszczególnych jednostek wykonawczych, wielu zaczęło snuć wnioski, że od samego początku istnienia Pentium4 na rynku mamy styczność z mechanizmem SMT. Tyle tylko, że do tej pory był on w stanie uśpienia.

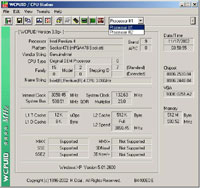

Ponieważ HT daje możliwość wykonywania dwóch wątków jednocześnie więc system rozpoznaje jeden procesor jako dwa równoległe układy logiczne. Dzieje się tak, ponieważ klasyczny, pojedynczy procesor pracuje równocześnie nad jednym tylko wątkiem. W przypadku P4 3,06GHz z HT mamy więc jeden procesor fizycznie, ale logicznie już dwa. Pośród obecnych systemów operacyjnych technologię SMT obsługują wspomniane już systemy Unixowe i rodziny NT (2000 i XP). Zasadniczo do pracy z procesorami obsługującymi HT poleca się WinXP i to niezależnie od wydania - Prof. czy Home Edition (mimo że ten ostatni nie wspiera platform SMP, to działa w trybie SMT). Jak więc widzimy system rozpoznał dwa procesory z możliwością wykonywania jednoczesnego dwóch wątków.

Aby powiększyć fotkę, kliknij!

Niezmiernie mało programów jest napisanych tak, że mogą być wykonywane niezależnymi wątkami jednocześnie. Jak zauważyłem, już wynik jednego nie może bowiem zależeć od innego, bo inaczej nie będzie to działać. Jak więc inaczej wykorzystać możliwość wykonania dwóch zadań równocześnie? Bardzo często mamy z tym do czynienia każdego dnia - uruchamiając kilka niezależnych aplikacji. Odpowiedni system operacyjny rozdzieli wówczas czas niezbędny na wykonanie dwóch procesów między dwa równoległe, logiczne procesory (a faktycznie rozdzielone zostaną jednostki wykonawcze CPU między poszczególne procesy). Zdaje to egzamin doskonale szczególnie w przypadku całkowicie odmiennych aplikacji. Inaczej z CPU korzystać będzie bowiem np. Word, a inaczej działający jednocześnie program do liczenia rozproszonego. Warto jednak zauważyć, że użycie HT powoduje spadek wydajności procesora w poszczególnych zadaniach, ale podnosi sumaryczną wydajność dzięki możliwości wykorzystania większej ilości jednostek wykonawczych (z uwagi na podział mocy procesora między dwa, a nie jeden wątek). Zastosowanie HT nie przyspiesza wcale działania aplikacji o 100%. Procesor pozostaje wciąż jeden, ilość jednostek wykonawczych nie zmienia się, a na dodatek trzeba je dzielić między dwa zadania. Jeśli do tego dodamy fakt, że mało która popularna aplikacja potrafi skorzystać z systemów wielowątkowych, okaże się że wzrost wydajności może nie być wcale taki wielki. Intel określa go jako okolice 30%. A jak jest w rzeczywistości? Przekonamy się o tym za chwilę.

zestaw: płytka, procesor, cooler i ram

główny bohater: Pentium 4 3.06 GHz Hyper-Threading

płyta główna Intel D850EMVR

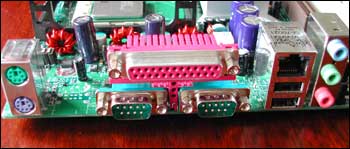

panel wyjść i wejść na płycie

gniazda z D850EMVR

osadzony procesor

...i pamięci Samsunga 2 x 256 MB PC1066-32 RIMM

Testy Pentium4 3,6 GHz

Sprzęt do testów dostarczyły firmy:

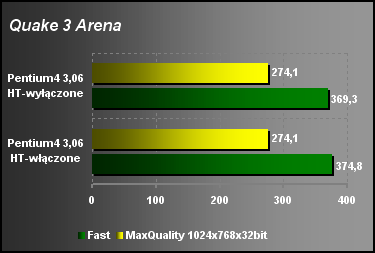

W tym roku Quake3 obchodzi już trzecie urodziny i powoli traci na skuteczności jako benchmark. Umiejętność korzystania z dobrodziejstw Hyper-Threading jest mocno ograniczona. Gra nie wyciąga większych korzyści z możliwości jakie daje procesor. W trybie wysokich detali różnica już w ogóle nie istnieje.

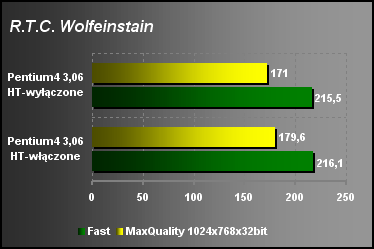

Oparty na tym samym co Q3 silniku test z gry Wolfeinstain już trochę inaczej zareagował. Co dziwne okazało się, że przy wyższym poziomie detali różnica na korzyść procesora z aktywnym HT jest mocniej zauważalna, aczkolwiek niemal nie istotna w rzeczywistości.

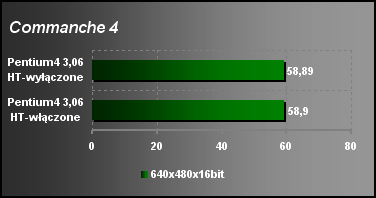

Commanche nie potrafi skorzystać wcale w innowacyjnej technologii procesora. Włączenie Hyper-Threading nic nie daje.

Tym razem ponownie mamy przykład testu operującego w ramach jednego wątku, a nie potrafiącego rozdzielić zadań między "dwa" procesory.

DroneZ zachował się podobnie jak Wolf. Największą korzyść czerpie przy wysokim poziomie szczegółowości sceny 3D.

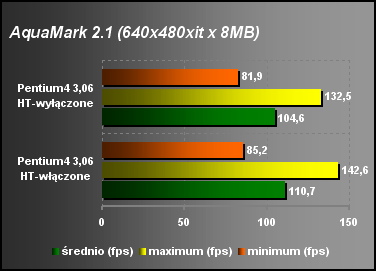

AquaMark korzysta z możliwości DirectX 8.0 i jak widać całkiem nieźle potrafi zaopiekować się dodatkowymi jednostkami wykonawczymi procesora Pentium4. Dodatkowa moc nie daje jednak znakomitej przewagi, ale pewien wzrost jest zauważalny i różnica dochodzi do niemal 8%.

3D Mark2001 (kliknij)

3D Mark skorzystał z trybu SMT w stosunkowo ograniczony sposób. Różnice między dwoma trybami nie powalają.

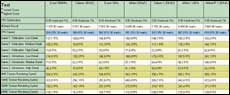

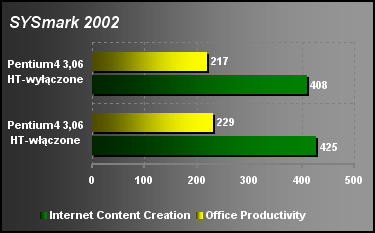

Program składający się z wielu różnych aplikacji, których składowa daje sumaryczny wynik w dwóch kategoriach. Nawet typowo użytkowe aplikacje potrafią poprawić nieco komfort pracy dzięki możliwościom HT.

Czas obróbki pliku graficznego skrócił się na procesorze korzystającym z trybu SMT. 10% przewaga zaczyna być warta uwagi.

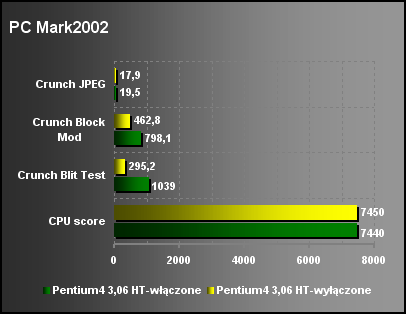

Bardzo ciekawe są wyniki testu ze stajni "Szalonej Cebuli" (MadOnion). Sumaryczny wynik okazał się niższy w przypadku włączonego HT-minimalnie ale jednak. Jednak jak zauważyć można na trzech przykładach wyników cząstkowych przewagę ma procesor z aktywną współbieżnością wielowątkową. Cóż tu komentować wystarczy spojrzeć na wyniki testu "blit".

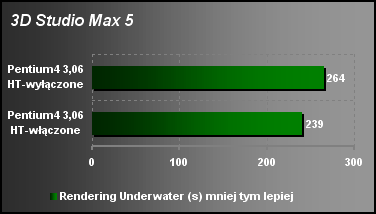

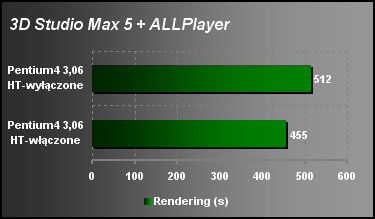

3D studio jest jednym z niewielu programów potrafiących doskonale wtopić się w architekturę SMP. Użycie dwóch procesorów może przyspieszyć rendering sceny 3D nawet o 100%, co jest naprawdę niezłym wyczynem. Powyższe wyniki jednoznacznie pokazują, że program potrafi podzielić wątki na dwa wykonywane równolegle. Nie dało to wcale 100% wzrostu wydajności, lecz zaledwie 10%. No cóż cudów nie należy się było spodziewać, przecież wciąż mamy do dyspozycji tylko 1 procesor. Mały trik jednak w postaci możliwości jednoczesnego wykonywania dwóch wątków pozwolił nieco przyspieszyć operację.

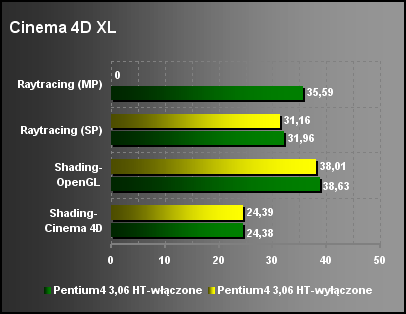

Cinema ma podobny charakter co program powyżej. Ciekawym jest test Raytracing występujący w dwóch podtestach-SP i MP. Ten drugi jednak aktywny jest dopiero jeśli posiadamy system wieloprocesorowy. Ponieważ system wykrył dwa procesory więc aktywny stał się i ostatni test. Po wyłączeniu Hyper-Threadingu test stał się nieaktywny. Wszystkie pozostałe testy wykazały wzrost wydajności. Nie jest jednak on duży i liczyć go można tylko w ułamkach punktów.

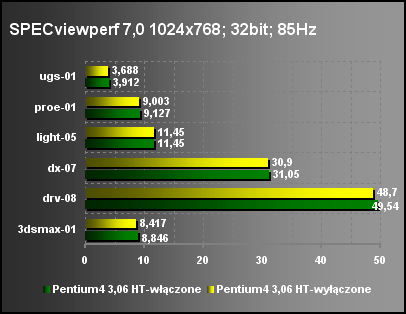

Specviewperf to test składających się z różnych scen 3D renderowanych przez różne podprogramy (mamy tu też scenę z3D studio). Wykazane różnice kolejny raz nie są duże, ale konsekwentne. Wahają cię od 1 do 6%.

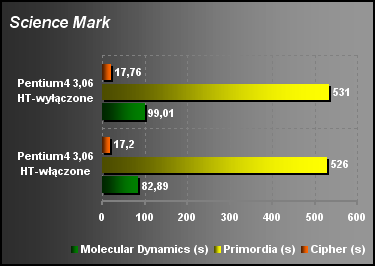

Science mark to nazwa wskazująca na benchmark naukowy. Wersja 2.0. Wspiera on zarówno wielowątkowość jak i rozszerzenia SIMD procesora Pentium4 co znacząco skraca czas trwania testu. Szczególny wzrost występuje w ostatnim teście. Uruchomienia HT podniosło wydajność o 19%. Jak widać po teście Primordia nie zawsze wzrost jest aż tak duży. Wszystko zależy od typu aplikacji.

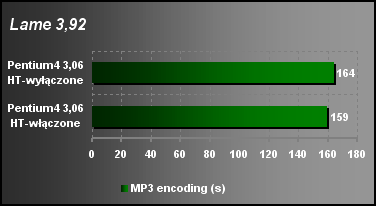

Przechodzimy do kompresji. Na początek konwersja audio do plików mp3. Możliwość wykorzystania wielowątkowości wychodzi na średnio udanym poziomie. Skrócenie kompresji wyniosło tylko 5s ale jednocześnie warto zauważyć, że aby osiągnąć podobny rezultat na klasycznym procesorze potrzebny byłby układ o 200MHz szybszy.

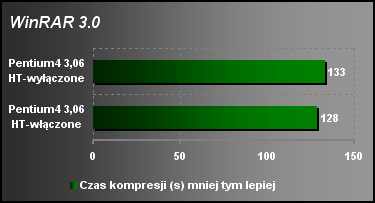

Kompresja pliku, ale tym razem nie audio a zbioru danych. Wielowątkowość zaaplikowana w3,06GHz procesorze Pentium skróciła czas kompresji pliku o 5s co wynikowo dało 4% szybsze działanie WinRAR'a na jednostce wyposażonej w HT.

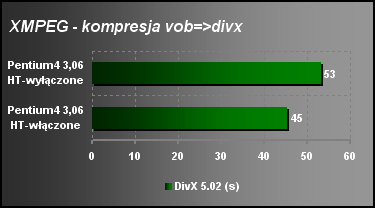

Kompresja video przy wykorzystaniu kodeka DivX 5.02 pokazuje że wielowątkowość zaszyta w najnowszym układzie Intela działa :) Korzystając z jednostek wykonawczych w dwóch wykonywanych równolegle procesach program wykonujący kompresję z wynikowego pliku DVD vob do avi przyspieszył o niemal 18%. Teraz odkrywamy jak bardzo czas się liczy.

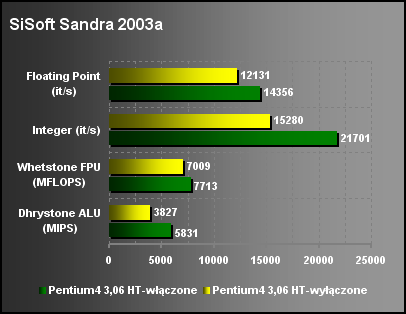

Na koniec pozostawiłem klasyczny test niskopoziomowy. Sandra w najnowszej edycji 2003 potrafi rozpoznać, a co ważniejsze skorzystać z Hyper-Threading. Wyniki możemy zobaczyć powyżej. Teoretyczna wydajność procesora znacząco wzrosła. Szybkość działania jednostki stałoprzecinkowej wzrosła o 52%! (pamiętajmy że pracuje ona w trybie DDR-czyli 6,12GHz!). Również inne testy wykazały spory wzrost.

Testy Wielowątkowości

Większość aplikacji nie potrafi pracować jako wielowątkowe. Wykonuje jedno zadanie jednocześnie i nie przyspiesza znacząco w przypadku trybu SMT. Skoro tak, to dlaczego nie uruchomić drugiego wątku niejako na siłę? Tak właśnie zrobiłem w testach poniżej. Uruchamiałem dwa osobne programy, które musiały miedzy siebie dzielić procesor. Oczywiście inaczej to wyglądało w trybie HT, a inaczej bez. W tym pierwszym system operacyjny musiał dzielić między siebie, a wykonywane zadania dwa procesory logiczne. Nie trzeba dodawać jak to wpływa na wydajność. Czas przełączania zadań spadł, a i obliczenia mogły być wykonywane równolegle. Po dezaktywacji HT role się odwróciły. System musiał tak rozdzielić zadania by chwilę czasu procesor mógł poświęcić dla niego samego ale i równie sprawnie działały uruchomione zadania. Co w przypadku wymuszonej wielowątkowości pokaże procesor Intela? Zobaczmy...

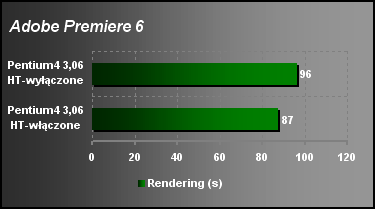

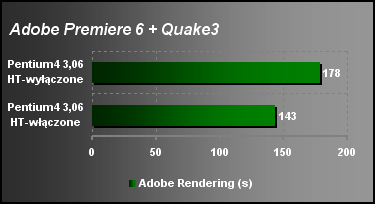

Uruchamiałem jednocześnie demo Quake3 w pętli (demoloop), ale przed tym (5s) startowałem program Adobe. Potrafi on sam nieźle całkiem poradzić sobie w trybie wielowątkowym, ale obciążenie koniecznością "grania w Q3" dodatkowo potęguje możliwość jaką daje HT. Uruchomiony tryb SMT skrócił czas obliczeń o 25%.

Teraz coś z innej beczki. W okienku uruchomiłem sobie film "Black Hawk Down" i uruchomiłem 3D studio. Program potrafi nieźle poradzić sobie samodzielnie pracując w trybie wieloprocesorowym i mocno obciąża system, ale dodatkowa konieczność dekompresji filmu skutecznie zapchała system. Niemniej różnica w liczeniu sceny z testów wcześniejszych (gdy 3D Studio pracowało samodzielnie) w trybie "z" a bez HT wyniosła 10%. Teraz gdy w tle odtwarzał się film, czas renderingu sceny z włączonym HT skrócił się o 12%.

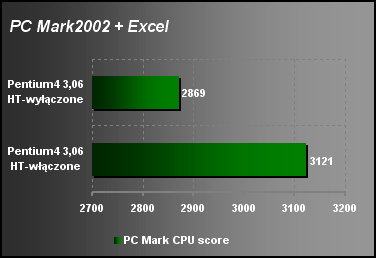

Działające jednocześnie aplikacje to test PC Mark i arkusz kalkulacyjny Excela. Ten drugi miał wymiary 1000 x 2500 pozycji, a procesor musiał wysilić się liczeniem dosyć skomplikowanego wzoru (osobnego dla każdej kolumny). Trudno mi było liczyć czas działania samego Excela podałem więc jedynie wynik z PC Marka. Jak nie trudno się domyślić w związku z liczonym jednocześnie arkuszem cały procesor nie mógł być oddany do dyspozycji tylko tego benchmarku i musiał on dzielić się z programem Microsoftu. Wyniki spadły więc znacząco (grubo ponad 50%) w porównaniu z robionym w poprzedniej części testami. Mimo to widać wyraźną przewagę Hyper-Threading.

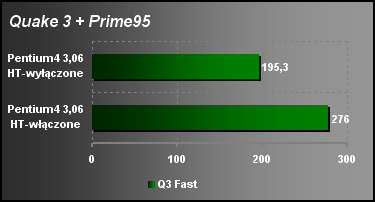

Quake ponownie (któż nie lubi tego testu? :) Tym razem w tle uruchomiłem program do obliczeń rozproszonych szukający kolejnych liczb pierwszych Marsennea. System korzystający z aktywnej współbieżności wielowątkowej znacząco szybciej grał i mocno przyspieszył. 41% różnica szybkości działania Quake robi wrażenie.

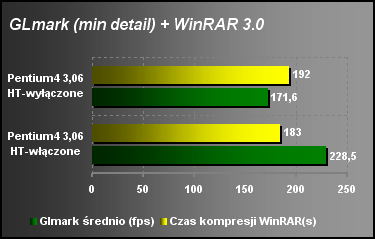

Kolejne "combo". Glmark uruchomiony w okienku, a obok kompresja plików. Rozdział zadań między dwa równoległe wątki wykazał ciekawą rzecz. O ile czas kompresji spadł zaledwie o 5% to test graficzny przyspieszył aż o 33%. Może to świadczyć o tym kto w pracy w trybie SMT zyskuje większy priorytet. Przydział mocy nie zawsze stoi na podobnym poziomie?!

Garść wniosków na koniec

Intel wypuszczając procesor 3,06GHz Pentium4 nie tylko przekroczył kolejną barierę prędkości pokazując mikroprocesor wykonujący 3 miliardy cykli w ciągu sekundy, ale także dał szerokiemu gronu dostęp do interesującej i wielce pożytecznej technologii Hyper-Threading.

Technologia ta ma przed sobą jednak wciąż daleką drogę do pokonania. Nie dla tego, że jest niedopracowana. Wręcz przeciwnie. Wina leży w niedopasowaniu oprogramowania i braku umiejętności pracy obecnego na rynku software'u w konfiguracjach wieloprocesorowych. Dzięki HT otrzymujemy bowiem wirtualny system dwuprocesorowy doskonale nadający się do wysokowydajnych maszyn biurowych i domowych.

Pojawienie się jednak w końcu na rynku nowego typu procesora, dzięki wsparciu inżynierów Intela z całą pewnością z czasem spowoduje zmianę sposobu myślenia programistów. Nowe generacje programów będą potrafiły pracować w trybie wielowątkowym dzięki odpowiednio zaprojektowanym kodom źródłowym. Przyzwyczajenia informatyków ciężko będzie zmienić, ale technologia HT z całą pewnością nie pozostanie bez wsparcia. Jak bowiem widać w chwili obecnej praca dwóch procesorów (logicznych) w wielu przypadkach pozostaje niezauważona i oprogramowanie działa jednakowo wydajnie "z" czy "bez" trybu wieloprocesorowego.

Warto jednak zauważyć, że istnieje pewna grupa programów, które nie tyle nie potrafią skorzystać z obecnej formy Hyper-Threading, co zwalniają w tego typu systemach. Błędny kod powoduje liczne problemy. Zdarza się wręcz, że taki program wcale nie działa w systemie SMT. W czasie testów przydarzyło mi się to, a wartymi odnotowania były dwa benchmarki - Video 2000 i CCR. Po prostu nie działały wcale jeśli aktywny był Hyper-Threading.

Znakomitą wydajność i komfort działania zyskujemy dzięki możliwość pracy w trybie wielowątkowym, jeśli pracujemy jednocześnie na dwóch aplikacjach. Możliwość szybkiego przełączenia między zadaniami i przydział przez odpowiedni system operacyjny konkretnego zadania pod jeden z procesorów logicznych dają niespotykane możliwości. Praca z olbrzymim arkuszem kalkulacyjnym i jednoczesna praca w aplikacji graficznej nawet mimo korzystania z bardzo szybkiego, procesora nie daje aż tak niezwykłych możliwości jak praca nawet z wolniejszym układem, ale pracującym z aktywną współbieżnością wielowątkową. To się naprawdę czuje, choć chwilami ciężko zmierzyć. HyperThreading to doskonałe rozwiązanie do prostych stacji roboczych.

Posiadanie samego procesora z aktywnym Hyper-Threading to jednak nie wszystko. Konieczne jest posiadanie odpowiedniej płyty głównej wspierającej ten protokół. Na chwilę obecną potrzebna do tego jest płyta główna zbudowana na chipsecie i845 (serie E, G-za wyjątkiem steppingu A, PE, GE), i850E. Z pozostałych producentów wsparcie zapewniają SiS 645DX, 648 oraz VIA P4X400. Warto jednak zauważyć, że pośród wymienionej grupy producentów chipsetów „alternatywnych” potrzebne są najnowsze steppingi układów, pojawiające się dopiero na rynku. Starsze egzemplarze niestety tego wsparcia nie gwarantują. Spokojnie spać mogą więc jedynie nabywcy płyt zbudowanych na układach Intela. U nich HT będzie działać, pod warunkiem aktualizacji BIOSu.

A jak rysuje się przyszłość? Już teraz wiadomo, że po nowym roku na rynek trafią Northwody z niższymi zegarami z aktywnym Hyper-Threading, których obecnie brakuje. Cena ma być nieco wyższa od klasycznego układu, ale warto tę różnicę poświecić by mieć CPU z naklejką „HT Inside”. A co czeka nas dalej... Prescott. Na dzień dzisiejszy wiadomo, że ma on obsługiwać Hyper-Threading II. Cóż to znaczy? Na razie nie wiadomo. Być może dostaniemy 4 procesory logiczne, a na pewno wzrośnie skuteczność i wydajność trybu SMT. Cóż to dopiero przyszłość, ale przyszłość zaczyna już teraz...

|