|

TwojePC.pl © 2001 - 2026

|

|

Poniedziałek 24 lutego 2020 |

|

| |

|

GPU Ampere będzie mieć powierzchnię 826mm²? Nieoficjalna specyfikacja

Autor: Wedelek | źródło: WCCFTech | 06:15 |

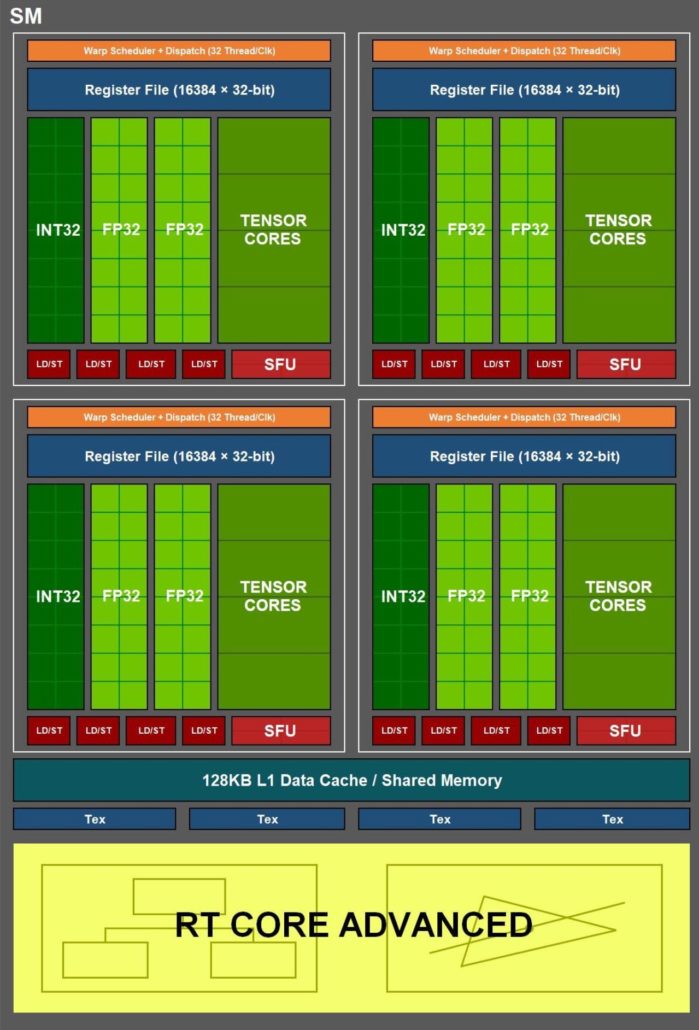

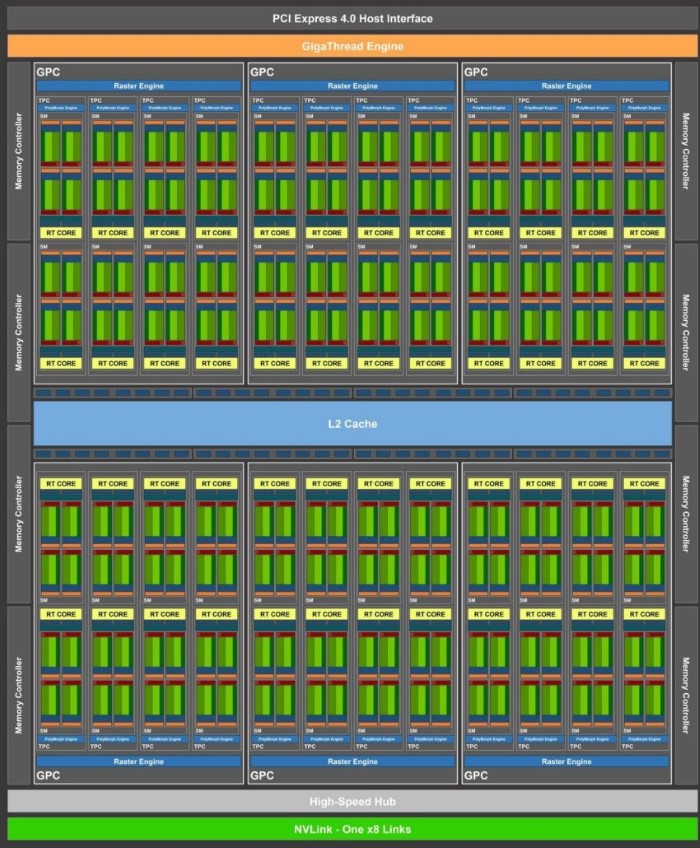

(20) |  Użytkownik serwisu Twitter, KittyCorgi opublikował w sieci nowe informacje dotyczące architektury GPU Ampere. Według niego pełny rdzeń GA100 będzie mieć powierzchnię aż 826mm². Biorąc to pod uwagę można założyć, że najprawdopodobniej będzie wytwarzany w litografii 12NFF. Oczywiście nie można też wykluczyć zastosowania znacznie nowszego procesu 7nm, ale w takim przypadku uzysk mógłby być wyraźnie mniejszy niż w 12nm, a to oznacza wyższe koszty produkcji. Sam Ampere to jednak nie tylko znacznie większa ilość tranzystorów. W nowym GPU Nvidia wykorzysta przebudowane jednostki Tensor oferujące dwukrotnie większą wydajność obliczeniową niż te w Turingach, a także zmodyfikowaną pamięć podręczną L1. Użytkownik serwisu Twitter, KittyCorgi opublikował w sieci nowe informacje dotyczące architektury GPU Ampere. Według niego pełny rdzeń GA100 będzie mieć powierzchnię aż 826mm². Biorąc to pod uwagę można założyć, że najprawdopodobniej będzie wytwarzany w litografii 12NFF. Oczywiście nie można też wykluczyć zastosowania znacznie nowszego procesu 7nm, ale w takim przypadku uzysk mógłby być wyraźnie mniejszy niż w 12nm, a to oznacza wyższe koszty produkcji. Sam Ampere to jednak nie tylko znacznie większa ilość tranzystorów. W nowym GPU Nvidia wykorzysta przebudowane jednostki Tensor oferujące dwukrotnie większą wydajność obliczeniową niż te w Turingach, a także zmodyfikowaną pamięć podręczną L1.

Z przedstawionych danych wynika również, że jednostki odpowiedzialne za przetwarzania 32-bitowych liczb stałoprzecinkowych nie ulegną drastycznym modyfikacjom, natomiast układy kalkulujące na liczbach zmiennoprzecinkowych zostaną podwojone. Ponadto pojedynczy blok SM w architekturze Ampere miałby mieć nie 64, a 128 rdzeni CUDA, czyli dwukrotnie więcej niż obecnie.

Podobno do Geforce RTX 3080Ti trafi chip GA103 z 60 blokami SM, a więc 7680 procesorami CUDA, a w RTX 2080 znajdziemy GPU GA104 z 48 blokami SM i 6144 procesorami strumieniowymi. Przy tym RTX 3080Ti miałby otrzymać 10/20GB pamięci RAM z interfejsem 320-bit, a w RTX 3080 byłoby to 8/16GB z szyną 256-bit.

Na koniec zaznaczam, że są to jedynie plotki i należy do nich podchodzić z odpowiednią rezerwą.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- co by ryja nie strzępić (autor: Mario2k | data: 24/02/20 | godz.: 08:43)

To RTX 3080ti będzie w RT około 80% szybszy od RTX 2080Ti a w normalnym giercowaniu bez RT około 40% szybszy . Piszą o tym na sajtach od 3 dni.

- @up (autor: piwo1 | data: 24/02/20 | godz.: 09:25)

pytanie jaka powierzchnie bedzie mial RTX 3080ti? 600mm2?

jesli tak cena bedzie kosmiczna. czyli 10tys zl.

big navi ktory ma przyjsc wiosna ma miec 400mm2. i pewnie bedzie kosztowal 3500zl.

- Nieładnie (autor: kombajn4 | data: 24/02/20 | godz.: 09:44)

ze strony Nvidii tak kopać leżącego. Nie dość że AMD jeszcze się nie wyrobiło żeby odpowiedzieć na RTX2080Ti a oni już serie 3000 wypuszczają. To nie sportowo z ich strony. Ktoś powinien im zwrócić uwagę że powinni grzecznie schować projekty do szuflady.... jak Intel LOL

- Taaa. (autor: Muchomor | data: 24/02/20 | godz.: 09:51)

AMD nie nadąża, więc ceny będą niezjadliwe.

- kombajn4 (autor: Markizy | data: 24/02/20 | godz.: 10:22)

ciekawi mnie tylko kto im bedzie klepac te chipy. Ich ilość będzie mała to raz, a dwa niezależnie jak dobry byłby proces to i tak sporo układów będzie uszkodzonych

- hmmm (autor: mlc | data: 24/02/20 | godz.: 10:45)

Teraz raczej odchodzi się od dużych układów. Jeżeli by przeszli na 7euv, gdzie gęstość jest ok. 2x większa niż w 14nm, to byłby to ogromny skok. Ale do tego jeszcze większy układ? Nierealne.

- AMD wygrało wyścig do 1 GHz, ... (autor: zartie | data: 24/02/20 | godz.: 10:58)

Intel do 1 kW, nVidia chce mieć pierwszy układ > 1000 mm^2?

- @kombajn4 (autor: Qjanusz | data: 24/02/20 | godz.: 11:01)

niesportowo to jest zakisić się w miejscu i czekać na walentynki od konkurencji.

- Absurd raczej (autor: ghs | data: 24/02/20 | godz.: 11:29)

Klepanie takich chipów jest nieopłacalne

- Taki rozmiar jest bez sensu. (autor: Kenjiro | data: 24/02/20 | godz.: 11:47)

Przede wszystkim nikły uzysk, więc wysoka cena tego, co jednak zadziała.

Poza tym problem z odprowadzeniem ciepła takiego ogromnego układu, może pożyczą rozwiązanie z zewnętrzną chłodnicą od Intela?

A na koniec kompletnie nieskalowalne, bo dalszych możliwości rozwoju już nie ma, większego układu się nie zrobi. No chyba, że znajdą sposób na chiplety w GPU, ale gdyby mieli chociaż cień pomysłu, to już by zrobili...

- @9. (autor: Mariosti | data: 24/02/20 | godz.: 11:53)

Kwestia ceny.

Na pewno będzie się opłacać.

- ceny na pewno będą soczyste (autor: Mario2k | data: 24/02/20 | godz.: 12:00)

Zakładam że na starcie o 20% większe niż podczas premiery RTX 2080Ti .

- @2 piwo1 (autor: Adam.M | data: 24/02/20 | godz.: 15:23)

600? W tekście jest 826mm²

- 826 (autor: piwo1 | data: 24/02/20 | godz.: 15:50)

Za układ który będzie szedł do serwerów czyli następca serii v100 który miał 815mm2 i był na pamięciach hbm2. Tutaj mówimy o jego następcy o powierzchni 826mm2 w 7nm. Pytanie czy 3080ti będzie na tym serwerowym modelu? Raczej nie. Raczej będzie to dużo mniejszy układ bo AMD maks czym będzie wojował to układem 400 mm2. Po co AMD ma sobie odcinac możliwość wydania serii 4000 o trochę większej powierzchni.

- 3** (autor: Mario1978 | data: 24/02/20 | godz.: 16:39)

Już nie piej tak z zachwytu bo jako Kogut zniesiesz jajko i to będzie ewenement na skalę światową.Twoja wypowiedź nie była rozważna bo mając tyle przykładów nie widzisz , że za obecny stan odpowiada oprogramowanie.Software wspiera głównie GPU Nvidia i CPU od Intela.Z tym drugim jest gorzej bo jak AMD ma problem z przebiciem się pod względem wsparcia software to dają jeszcze więcej wydajności by nadrobić zaległości.Architektura Vega do tej pory nie została w pełni efektywnie wykorzystana w grach a ty sądzisz , że Nvidia ma tak ogromną przewagę.Przewaga nic nie znaczy gdy stare standardy programowania i tak zostaną odrzucone.Wszystko co nowsze to i efektywniejsze wykorzystywanie CPU i GPU od AMD.Po prostu obecny mijający czas zarówno na rynku CPU i GPU jest na korzyść AMD ponieważ oni ze starymi standardami się nie znosili.

Dla fanboja gdy procesor 4 wątkowy wygrywa z 16 wątkowym w grach oznacza deklasację rywala a dla osoby temat znającej od spodu jest to tragedia w wykonaniu oprogramowania.

Dzisiaj zauważyłem zryw fanbojów Intela , którzy kupują CPU Intela.Można trochę im współczuć ale żałować ich pieniędzy nie ma co.Jak kogoś stać to po co go żałować.Jak człowiek jest zadowolony z zakupu jaki by on nie był to tylko to się liczy.

Opłacalność platformy nie ma tutaj żadnego znaczenia.

- Up) (autor: piwo1 | data: 24/02/20 | godz.: 19:57)

Ty widzisz tylko ilość wątków a jest jeszcze coś takiego jak opóźnienia do pamięci i architektura. One są równie ważne co powielanie wątków.

- piwo1 (autor: Markizy | data: 24/02/20 | godz.: 20:57)

ale sa mechanizmy które przewiduja jakie dane beda potrzebne i za w czasu je pobieraja.

- @17. (autor: Mariosti | data: 25/02/20 | godz.: 13:00)

Zresztą odkąd intel odszedł od 4 rdzeni i jednocześnie ryzen zaczął poprawnie obsługiwać wysoko taktowany ram różnice w opóźnieniach między cache, rdzeniami i ramem znacznie się zbliżyły między intelem i amd. 5 lat temu była przepaść, czyli różnica 2 krotna. Teraz różnica ta jest już bardzo mała.

- @16. (autor: pwil2 | data: 26/02/20 | godz.: 11:22)

Opóźnienia da się często maskować, a wielowątkowość w tym pomaga. Zauważ jakie masz opóźnienia w Internecie, a mimo wszystko z pewnymi optymalizacjami da się wycisnąć Gigabitowe prędkości nawet przy opóźnieniach liczonych w milisekundach.

- c.d. (autor: pwil2 | data: 26/02/20 | godz.: 11:34)

W czasach 2, 4-wątkowych procesorów rozbijanie na wątki wielu zadań nie było opłacalne. Przy dziesiątkach wątków co innego.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|