|

TwojePC.pl © 2001 - 2026

|

|

Czwartek 5 marca 2020 |

|

| |

|

Cray i AMD zapowiadają superkomputer El Capitan z ZEN 4

Autor: Zbyszek | źródło: AMD | 06:59 |

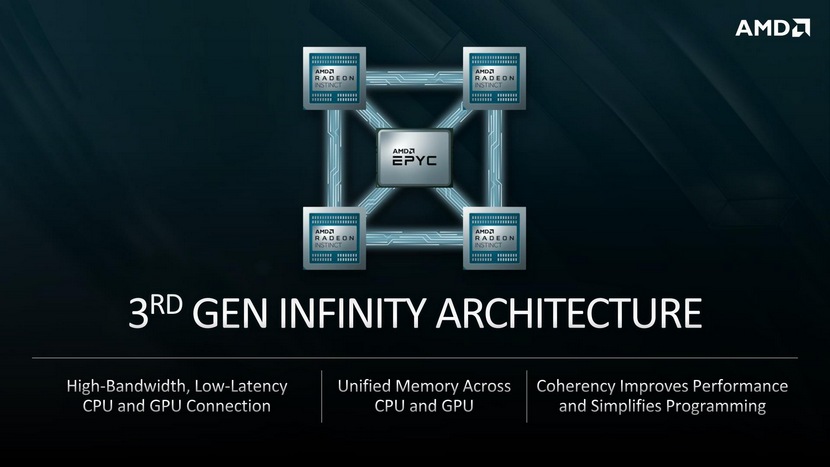

(13) |  Cray i AMD ogłosiły zawarcie umowy z Amerykańskim Departamentem Energii (dalej: DOE) na dostawę nowego superkomputera. Jednostka o nazwie El Capitan zostanie dostarczona i uruchomiona w 2023 roku, ma kosztować około 600 mln dolarów, i będzie 16-krotnie bardziej wydajna od superkomputera Sierra używanego dotychczas przez DOE. W skład superkomputera wejdą procesory EPYC "Geona" oparte o architekturę ZEN 4, a także przyszła generacja akceleratorów Radeon Instinct. W pojedynczym klastrze superkomputera cztery takie karty będą połączone z jednym procesorem EPYC za pomocą magistrali AMD Infinity 3 generacji. Cray i AMD ogłosiły zawarcie umowy z Amerykańskim Departamentem Energii (dalej: DOE) na dostawę nowego superkomputera. Jednostka o nazwie El Capitan zostanie dostarczona i uruchomiona w 2023 roku, ma kosztować około 600 mln dolarów, i będzie 16-krotnie bardziej wydajna od superkomputera Sierra używanego dotychczas przez DOE. W skład superkomputera wejdą procesory EPYC "Geona" oparte o architekturę ZEN 4, a także przyszła generacja akceleratorów Radeon Instinct. W pojedynczym klastrze superkomputera cztery takie karty będą połączone z jednym procesorem EPYC za pomocą magistrali AMD Infinity 3 generacji.

Nie podano całkowitej liczby CPU i GPU jaka wejdzie wskład El Capitan. Moc obliczeniowa ma wynosić 2 Eksaflopy, co jest wartością 10-krotnie większą od obecnie najszybszego na liście TOP 500 superkomputera na świecie - Summit.

Co więcej, jego moc obliczeniowa ma być wyższa od 200 obecnie najszybszych superkomputerów na świecie z listy TOP 500 razem wziętych. Więcej informacji na stronach AMD

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- intel ładne przegrywa superkomputery (autor: ekspert_IT | data: 4/03/20 | godz.: 22:05)

Będzie to opisywane w książkach biznesowych jak z udziału ponad 80% we wszystkich segmentach oraz lidera technologicznego można w ciągu 3 lat doprowadzić do sytuacji zapóźnienia, braku innowacyjności i radykalnego spadku udziałów we wszystkich segmentach rynku...

- dokładnie tak (autor: Mario2k | data: 4/03/20 | godz.: 23:09)

Ktoś tam w Intelu dał dupy po całości ,ale za 2 lata wszystko wróci do normalności.

- @ up (autor: Zbyszek.J | data: 4/03/20 | godz.: 23:15)

bardziej za 3 lata - w 2023. Tylko wówczas Intelowe 7nm będzie się musiało mierzyć z 3nm od TSMC. W dziedzinie litografii straconych ~4 lat (względem swoich planów) i ~2 lat (względem konkurencji) nie odzyskają tak łatwo.

Miało być:

14nm: 2013/2014

10nm: 2016

7nm: 2018/2019

Mieli ~2 lata przewagi nad TSMC (z 14nm), będą mieć jakieś 2 lata straty

- general AI (autor: Rafuncio | data: 5/03/20 | godz.: 00:11)

Mnie bardziej ciekawi ile takich skoków technologicznych typu 10x szybszy od najbardziej wydajnego superkomputera na świecie dzieli nas od general AI lepszego od człowieka? W końcu dojdziemy do etapu, że AI będzie projektowała następną generację AI i pojawi się coś czego nie potrafimy pojąć nie mówiąc o kontrolowaniu

- 4__ (autor: Mario1978 | data: 5/03/20 | godz.: 03:23)

Już teraz takie coś się dzieje.Z pomocą AI odnajdywane są kolejne planety a medycyna dokona oszałamiających postępów.Człowiek będzie poprawiał tylko to co rozumie bo reszta to metoda prób i błędów, które AI może uniknąć.FCPGA miało przynieść przełom nawet o milion razy szybciej od GPU w pewnych zadaniach a tu się okazuje, że Neural Processing Unit może to robić jeszcze szybciej.Nie dziwne, że kolejne generacje przyniosą szybciej odkrycia i jakby sam człowiek musiał główkować nad tym to by trwało tysiące lat.Później miliony w zależności od skomplikowania.Ostatnio czytałem fajny artykuł o równoległych światach bo już teraz AI potrafi założyć, że jest spore prawdopodobieństwo ich istnienia.Właśnie w kwestii AI nie dokonują się 20-30 czy nawet 50% wzrosty wydajności ale osiągają one prawie 1000%.Jeszcze trochę i 100TOPS będzie zużywać tylko 1W.Bardzo mnie ciekawi Huawei ze swoim nowym Kirin jaki wyda do Mate 40 Pro.I pomyśleć, że to potęga takich firm jak TSMC i Samsung przyczynia się do sukcesu AMD.Nvidia trochę szkoda bo rynek PC jest po macoszemu traktowany a oni nie mają swojego CPU.

- @5. (autor: Kenjiro | data: 5/03/20 | godz.: 08:35)

Obecne AI nie pozwala niczego uniknąć, gdyż ono ślepo wykonuje kolejne iteracje różnych kombinacji i dopiero sprawdza ewentualny efekt, czyli to samo co człowiek, tylko wielokrotnie szybciej. Efekt też musi być zgodny z pewnymi założeniami, co oznacza, że szukając szczepionki na grypę nie odkryje przy okazji leku na raka, bo nie ma takiego założenia.

Współczesne AI nie ma nic wspólnego z nazwą AI, bo część I (Inteligence) jest bliska zeru. Lepiej odzwierciedla to nazwa uczenie maszynowe (chociaż też nie do końca, bo owo uczenie jest prawie zerowe), a jeszcze lepiej Big Data, bo to właśnie o wyszukiwanie wzorców w gigantycznych zbiorach danych chodzi.

- Kiedyś pod koniec lat 90 (autor: OSTVegeta | data: 5/03/20 | godz.: 09:44)

w Tv leciał program, który zakładał, że w 2015 komputery będą projektowały swoich następców. Jak widać twórcy pomylili się tylko o kilka lat. W sumie może nie projektują, ale znacząco ułatwiają.

- @6. (autor: Mariosti | data: 6/03/20 | godz.: 11:24)

Kwestia rozbija się o to że nawet takie głupie AI mogłoby teoretycznie się rozwinąć samodzielnie, ale wymagałoby do tego celu w swoich procedurach kompletnego wachlarza gotowych algorytmów, jakiejś formy logiki życia zmiennych itp itd, no i oczywiście sprzężonych metod rekompilacji i uruchamiania się z nowych binarek... To wszystko musiałby najpierw z premedytacją napisać człowiek, a potem takie AI z gigantycznym prawdopodobieństwem tworzyłoby kod który jest bez sensu lub nawet się nie kompiluje.

Także moc obliczeniowa nic nie znaczy, a co do AI które mogłoby samo doskonalić swoje oprogramowanie w sposób fundamentalny to jest to teoretycznie możliwe ale wymagałoby ogromnego nakładu pracy programistów i z dużym prawdopodobieństwem nie dałoby żadnego sensownego efektu.

Z tego względu gdy mówimy o tzw. algorytmach samouczących, chodzi tutaj tylko o to że oprogramowanie za pomocą wykonywania wielu iteracji tych algorytmów z różnymi zestawami parameterów są w stanie eksperymentalnie dobrać dobry, bądź i bardzo dobry zestaw parametrów i do tego AI sprawdza się doskonale.

- ZEN4 (autor: pwil2 | data: 6/03/20 | godz.: 12:50)

Jeszcze trochę minie czasu zanim ZEN4 wejdzie do produkcji. To znak, że nawet w dłuższej perspektywie czasu Intel nie miał szans obiecać dostępności wydajnych i energooszczędnych 7/10nm procesorów serwerowych.

- ... (autor: power | data: 6/03/20 | godz.: 17:35)

@4 Do general AI nie potrzeba szybszych komputerow, tylko lepszych algorytmow.

@5 Jak zwykle belkoczesz, czy to google translator tlumaczy tak slabo czy sam takie bzdury zawsze wypisujesz?

@7 Juz od dawna komputery sa uzywane do projektowania szybszych i lepszych komputerow. Nazywa to sie CAD (Computer Aided Design).

- Mariosti (autor: pawel1207 | data: 6/03/20 | godz.: 18:47)

ale takie ai jak najbarziej juz sa :) i to od dluzszego czasu nawet buduje uklady symulujace nasz mozg w uprosczeniu aby ai mogla sie na tyle rozwinc aby wproadzac wlasne usprawnienia i o ile upgready sobie robie to skoku cywilizacyjnego za cholera nie che osiagnac :D przynajmniej na razie ..

- 10** (autor: Mario1978 | data: 7/03/20 | godz.: 18:48)

Musisz się zorientować w temacie jak NPU działa chociażby w Huawei Mate 30 Pro 5G z układem Kirin 990 5G.Jakie zadanie ma ten układ i dlaczego jest pożądany w takich urządzeniach gdzie Wydajność na Watt jest najważniejsza gdy do tego dochodzi jeszcze parametr najniższego poboru energii elektrycznej z akumulatora.A nie trudno znaleźć testy gdzie właśnie ten układ fachowo mający coś wspólnego z "SI" podczas używania chociażby Smartfona dostosowuje się do tego co użytkownik robi z telefonem i w ten sposób wybiera najlepsze parametry mające wpływ na niższy zapotrzebowanie na energię.To są jedne z wielu zadań jakie mogą mieć dobroczynny wpływ na końcowy efekt.Dlatego czekam co wymyśli Huawei w kolejnej generacji.Bo oni robią bardzo dużo i to samo dokładnie teraz czyni AMD.

Wystarczy popatrzeć na ten superkomputer i cenę by zrozumieć dlaczego to jest AMD.Nie ma szans by Intel sam zapewnił w takiej cenie tak zaawansowane układy , z taką mocą obliczeniową i z takim współczynnikiem Wydajność/Watt/Cena.

Dużo firm zdaje sobie z tego sprawę , że nawet teraz będąc w obecnej sytuacji związani są pewnymi umowami i boli ich kupować cokolwiek od Intela.Dorzucając do tego rozwiązania Nvidia cena jeszcze bardziej wzrasta i boli to szczególnie portfel nawet firmowy.

Tak się kończy era Intela a zaczyna AMD.Nawet dobrze bo wiele osób miało już dojść wysokich cen jakie Intel sobie życzył za swoje rozwiązania, które nie miały nic wspólnego z jakością.Prędzej czy później czeka to każdą firmę , która stosuje zbyt wysokie marże a przez swoje zarobki właśnie to pokazuje , że konsument wcale nie był najważniejszy a marża.

- @11. (autor: Mariosti | data: 7/03/20 | godz.: 22:15)

To są algorytmy samouczące, nie mają nic wspólnego z algorytmami samomodyfikującymi się.

Ogólnie idea rekompilowania samego siebie jest często stosowana w wirusach komputerowych, ale tam chodzi tylko o zaciemnianie kodu i zmianę sygnatury binarki, a nie na modyfikowanie logiki algorytmu.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|