|

TwojePC.pl © 2001 - 2026

|

|

Wtorek 27 kwietnia 2021 |

|

| |

|

Rekordowe wyniki finansowe AMD w 1. kwartale 2021 roku

Autor: Zbyszek | źródło: AMD | 23:22 |

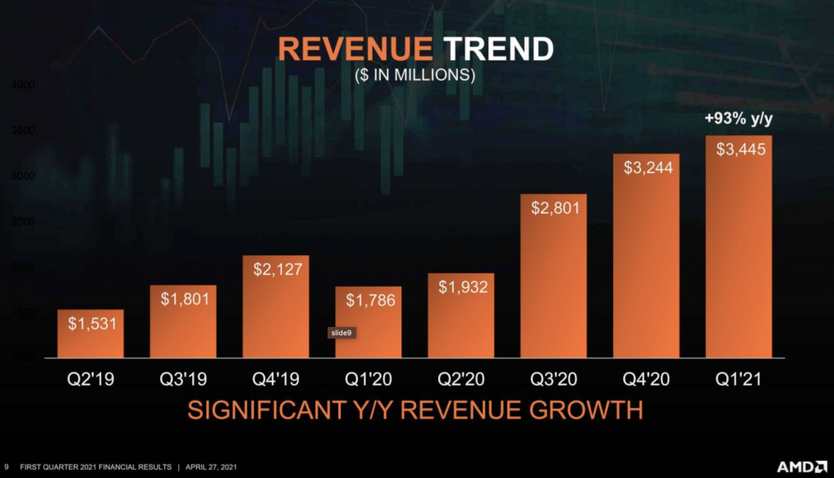

(24) |  Firma AMD podała wyniki finansowe odnotowane w 1. kwartale 2021 roku. Przychód korporacji w minionym kwartale wyniósł 3,45 miliarda dolarów, co w historii AMD stanowi kolejny rekord pod względem wysokości kwartalnego przychodu, w dodatku odnotowany po raz trzeci z rzędu - po świetnych wynikach w 3 i 4 kwartale 2020 roku. Przychód z 1. kwartału 2021 roku jest aż o 93% wyższy niż w 1. kwartale 2020 roku, o 6 procent wyższy niż w 4. kwartale 2020 roku i o 24% wyższy niż w 3. kwartale 2020 roku. Zysk operacyjny w minionym kwartale wyniósł 662 mln USD, a zysk netto 555 mln USD, czyli o 243 procent więcej niż w 1. kwartale 2020 roku. Firma AMD podała wyniki finansowe odnotowane w 1. kwartale 2021 roku. Przychód korporacji w minionym kwartale wyniósł 3,45 miliarda dolarów, co w historii AMD stanowi kolejny rekord pod względem wysokości kwartalnego przychodu, w dodatku odnotowany po raz trzeci z rzędu - po świetnych wynikach w 3 i 4 kwartale 2020 roku. Przychód z 1. kwartału 2021 roku jest aż o 93% wyższy niż w 1. kwartale 2020 roku, o 6 procent wyższy niż w 4. kwartale 2020 roku i o 24% wyższy niż w 3. kwartale 2020 roku. Zysk operacyjny w minionym kwartale wyniósł 662 mln USD, a zysk netto 555 mln USD, czyli o 243 procent więcej niż w 1. kwartale 2020 roku.

Przychód działu Computing and Graphics dostarczającego procesory i karty graficzne na rynek konsumencki wyniósł 2,10 mld USD i był o 46 procent wyższy niż w tym samym kwartale przed rokiem, i o 7 procent wyższy niż we wcześniejszym kwartale.

Przychód działu Enterprise, Embedded and Semi-Custom zajmującego się dostawami procesorów serwerowych oraz chipów do konsol, wyniósł 1,35 mld USD - o 286 procent więcej niż w tym samym kwartale przed rokiem i o 5 więcej niż we wcześniejszym kwartale.

W 2. kwartale 2021 roku AMD spodziewa się przychodu w wysokości 3,6-3,7 mld USD.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- ... (autor: krzysiozboj | data: 28/04/21 | godz.: 00:20)

Nie ma się miliardów na koncie, to strach komentować wyniki, wpadnie jeszcze jakiś "mundry" i zbeszta :)

A wyniki ... świetne, tylko cholera wie do którego kwartału odnosić. Czwarty ze wzgledu na święta zazwyczaj najlepszy, w pierwszym zazwyczaj spadek. Do pierwszego z 2020? Przepaść. By robili 5-6 mld, to pewnie tylko moce przerobowe TSMC ograniczeniem.

Trochę mi przy tych ZENach szkoda Cray, kiedyś postawił na Opterony, nie przeżył czekania na solidnego następcę Opterona, ZEN byłby nim.

- Moim zdaniem (autor: Zbyszek.J | data: 28/04/21 | godz.: 00:49)

w latach 2008-2010 gdy w AMD wewnętrznie forsowano projekt Bulldozera, to albo pracownikami AMD zawładnęła zbiorowa głupota, albo naciski nieudolnego wówczas kierownictwa były tak mocne, że gasiły protesty lepiej zorientowanych iż to będzie bubel.

Biorąc na logikę - idea była szczytna - zróbmy procesor mający 2 wątki na 1 rdzeń, który drugi wątek przetwarza z szybkością 80% pierwszego wątku, zamiast tylko 20-30% jak u Intela. Realizacja tej idei była fatalna - zrobiono rdzeń o wydajności takiej, jak pojedynczy rdzeń Intela, ale sztucznie dzieląc go na 2 odrębne części - 2 jednostki INT dla 1 wątku i 2 jednostki INT dla drugiego wątku, nieosiągalne przez siebie wzajemnie. Efekt: rdzeń otrzymuje 1 wątek, i zamiast używać dla niego 4 jednostki INT, używa tylko 2 takie jednostki.

Idea była taka: zrobić rdzeń o wydajności jednowątkowej Intela, ale o dużo wyższym zysku z 2-wątku

Realizacja była taka: zrobiono rdzeń o wydajności wielowątkowej Intela, ale o wyraźnie niższej wydajności jednowątkowej (bo zasoby takie jak dostępne dla 2 wątków, dla 1 wątku były praktycznie o połowę mniejsze).

Jestem zdania że ktoś w AMD musiał się dość szybko zorientować, że to nie wypali, ale ówczesny dyrektor i kierownictwo jednak parło na Bulldozera.

- Zbyszek.J (autor: PCCPU | data: 28/04/21 | godz.: 02:15)

Co by myśleć zaprojektowanie rdzenia z dwoma fizycznymi partycjami(blokami) INT takimi jak w Bulldozer jest łatwiejsze niż pojedynczy szeroki do którego zasobów ma dostęp pojedynczy wątek zamiast do jednego jak w Bulldozer. Kto wie co było powodem takiej decyzji. Może trudność w opracowaniu szerokiego INT dla pojedynczego wątku który partycjonuje zasoby dla drugiego wątku, patenty lub coś jeszcze innego o czym się już nie dowiemy? Jedno jest pewne coś musiało być na rzeczy ponieważ już po samym projekcie musieli wiedzieć jak będzie działał Bulldozer bo o symulacjach to już nawet nie wspominam.

To nie jest tak że projektanci mikroarchitektury zróbmy to tak czy tak a jak skończymy to zobaczymy jak to będzie działać i jaką będzie miało wydajność. Musieli już wcześniej symulować jak zachowuje się pojedynczy blok(partycja) INT z daną ilością jednostek wykonawczych itd. To że pojedynczy wątek będzie działał tylko na jednej partycji INT to już z samych założeń projektowych byli świadomi. Bulldozer byłby dobry gdyby Intel dalej rozwijał Netbrust(Pentium4/5) ale nie na Nehalem czy tym bardziej SandyBridge. Zespoły projektowe od samego początku musiały wiedzieć że będzie to słabe ale może kierownictwo się uparło. Jedno jest pewne że AMD potrzebowało aż 10 lat licząc od K10 Phenom do pierwszego Zen by wypuścić szerszy rdzeń z SMT.

- @01 (autor: Wyrzym | data: 28/04/21 | godz.: 06:21)

Miliardy na koncie upowazniaja cie tylko do napisnia "bida" jak ktos inny ma miliardy przychodu, ale to pod warunkiem ze ty tych miliardow masz wiecej ^^

Tu przy przychodach 3+ piszesz ze swietne, a intela przy 18 ze bida :D wez ze sie ty ogarnij moze na poczatku a pozniej probuj smieszkowac ze cie ktos beszta.

Wrazenie u AMD robi w jaki piekny sposob sie odbili od dna, nawet nie od dna, oni sie wykopali z pod ziemi i pomyslec ze to wszystko (a przynajmniej spora czesc) dzieki osobie z ktorej sie wszysy nasmiewali na samym poczatku (a przynajmniej na tym forum i to z jej wygladu)

- PCCPU (autor: Markizy | data: 28/04/21 | godz.: 08:37)

Buldożery by się obroniły jeszcze gdyby były efektywne energetycznie. W takiej sytuacji byłby mniej wydajne od intela ale wielowątkowo były by sprawniejsze i przynajmniej chłodne.

Gdyby na samym początku dobrze zrealizowali kwestie efektywności to niebyli by tak w ciemniej jaskini z działem projektowym CPU. Mieli by nisze dla swoich CPU gdzie by sprawdzały się dobrze.

Natomiast nie wiadomo czy do tej koncepcji nie wrócą przy układach Big.litte które zapowiadają na 2024r jako zen5 w apu. Wtedy rozbudowany rdzeń zen 4/5 dzieliłby zasoby z prostym stosunkowo rdzeniem zen1 pod względem L1 i L2 wspólnego. Oczywiście użytkowanie tych dwóch rdzeni na raz raczej już nie wróci jak było w buldożerze ale coś podobnego mogą wystrugać.

- Teraz jeszcze odbić udziały w rynku GPU (autor: ekspert_IT | data: 28/04/21 | godz.: 08:58)

Przy dobrym produkcie można mieć ponad 50% rynku, jak w 2005r (wiem, prehistoria...) ale to jak najbardziej możliwe biorąc pod uwagę jak prądożerne są GeForce, doniesienia o średniej współpracy między Samsungiem a Nv, drivery (historia z Black screen w GeForce Experience)...

- @2. (autor: Kenjiro | data: 28/04/21 | godz.: 08:58)

Akurat bloki INT nie były tu żadnym problemem, tylko sam potok oraz FP, który był współdzielony między blokami, co bardzo mocno blokowało wątki w ramach klastra. O ile pamiętam testy to wydajność INT była wysoka, porównywalna z Intelem, zaś FP leżało i kwiczało (zresztą tak było od poprzednich 2 dekad, aczkolwiek w różnych recenzjach na przestrzeni lat było wielokrotnie punktowane, że AMD ma słabsze FP).

Wspomniany potok też był dużo mniej wydajny niż u Intela, a dopiero architektura Zen bardzo mocno rozbudowała ten aspekt, by AMD mogło walczyć na podobnym poziomie co Intel.

W wydajności wielowątkowej problem zaś pojawiał się dopiero wtedy, gdy system nie rozróżniał klastrów (a tak przez długi czas było), więc wiele konfliktowych wątków było wrzucanych na sąsiednie rdzenie, które stawały na FP, przez co wydajność znacząco spadała.

Miałem Bulldozera i na domowy serwer VM pasował idealnie, bo poszczególne wirtualki nie wchodziły sobie w paradę.

- @5. (autor: Kenjiro | data: 28/04/21 | godz.: 09:18)

Współdzielenie zasobów pomiędzy rdzeniami to prosta droga do nieefektywności energetycznej, bo nie da się łatwo wyłączać tego co jest chwilowo niepotrzebne. Znacznie prościej będzie łączyć osobne chipletach i tam tworzyć rozwiązania odpowiednie dla każdej z architektur.

Współdzielenie ma sens wtedy, gdy masz duży monolityczny chip, niezbyt rozbudowane zarządzanie energią (wyłączanie bloków) i dużą powierzchnię, która emituje dużo ciepła.

Ponieważ obecnie powierzchnia nie jest problemem, bo układ przestał być monolityczny, to nie ma co się pchać w łączenie rdzeni dużych z małymi, gdzie małe będą używać 50% danego modułu, ale energii tyle samo (nieużywany moduł zużywa tyle samo energii, co używany, chyba że odłączysz mu zasilanie lub zmniejszysz napięcie).

- Zbyszek.J (autor: piwo1 | data: 28/04/21 | godz.: 10:25)

a jak nazwiesz projekty big little? to nie to samo co buldozer tylko inaczej? czemu amd i intel chca podazac ta droga? buldezerowa? nie glupota?

- ja osobiscie (autor: piwo1 | data: 28/04/21 | godz.: 10:32)

czekam na 4 kwartal kiedy to juz do wynikow finansowych beda doliczane wyniki xilinxa. wtedy juz powinno byc w sumie kolo 5 mld za kwartal i wyniki byc lepsze od nvidiowych.

- a i jeszcze jedno (autor: piwo1 | data: 28/04/21 | godz.: 10:40)

marza 46% tylko czyli nie wzrosla ani procenta. wiec jak popyt spadnie to zyski poleca na leba na szyje. gdyby byla blizej tej intelowej czy nvidii wyniki bylyby 1,5 raza lepsze.

- widzieliscie? (autor: piwo1 | data: 28/04/21 | godz.: 10:51)

https://www.purepc.pl/...pamieciami-ddr4?page=0,15

- @11 (autor: krzysiozboj | data: 28/04/21 | godz.: 11:02)

Ta marża też mi się rzuciła w oczy w tych wynikach, że nie poszła w górę. Założyłem, że to pochodna większych i długoterminowych kontraków z potentatami, lub pochodna konsol, gdzie ona raczej wysoka nie będzie.

Popyt nie wiem czy im tak szybko spadnie, jeśli konkurencja nie pokaże niczego przełomowego, to nadal mają spory potencjał wzrostu w laptopach i GPU. Na rynku CPU pewnie musieliby nieco luzować ceny.

- @4. (autor: krzysiozboj | data: 28/04/21 | godz.: 12:07)

Mundry (inaczej), skąd wiesz, że się odbili od dna? Też, że byli na dnie? Prowadziłeś kiedyś podobną firmę, ze potrafisz to ocenić? Może kalkulatory masz takie co to liczą i mają odpowiednią ilość zer? Nie wyjdzie tutaj, że jesteś zwyczajnym hipokrytą?

Ja tylko Twoją miarką odmierzam i delikatnie sugeruję, byś miał odrobinę konsekwencji i nie wypowiadał się tam, gdzie innych pouczasz "portfelowo".

- @14 (autor: Wyrzym | data: 28/04/21 | godz.: 14:42)

no widzisz, ja tu sie teraz wypowiadam tam gdzie ty sie wypowiadasz zeby cie pouczac dalej. Wiem ze byli na dnie bo mundre gazety i portale tak pisaly do tego mieli wyniki finansowe na minusie, tyle wiem ze szkoly ze minus znaczy zle dla firmy, a plus dobrze, ty tyle wiesz?

Jeszcze raz napisze, "pouczam" cie bo chciales zablysnac piszac "bida" przy 5+ mld, co bylo i dalej jest smieszne... np widze ze dla ciebie calego PRZYCHODU 3+ mld jest swietne, a 5+ mld ZYSKU to jest bida, cos z toba ostro nie teges ^^

- łojezu (autor: lavka | data: 28/04/21 | godz.: 15:05)

Dawno tak mądrych wypowiedzi nie przeczytałem aż mnie bania się lekko zlasowała :):)

Dzięki chłopaki :):):)

- @2. (autor: pwil2 | data: 28/04/21 | godz.: 17:12)

To były decyzje na wczesnym etapie projektowania. Uznali, że węższy potok będzie cały czas utylizowany na 100%. A drugi taki sam tez nie będzie się nudził dzięki optymalizacji oprogramowania.

Problemem było oprogramowanie. Pamiętam jak miałem Xeona 4c8t, a kolega wybrał Phenoma X6 i przy zarzuceniu ich obliczeniami na 100%, oba szły łeb w łeb. Gorzej było tam, gdzie pocił się tylko jeden wątek.

Można się było spodziewać, że po 1, 2, 4-watkach przyjdzie kolej szybko na 6, 8 i więcej wątków. A jednak wszyscy się zafiksowali na 4-wątkowych i3/i5. To były najpopularniejsze platformy i soft/gry były pisane pod nie. 8-wątkowe i7/Phenomy w grach się nie miały jak wykazać. Intel nie chciał im ułatwiać. Lata zastoju.

Po wypuszczeniu Ryzena 1700 8c16t, Intel musiał odpowiedzieć i5 6-rdzeniowymi i wszystko się ruszyło do przodu. Widzieliście testy Phenoma w nowych grach z aktualną kartą graficzną w stylu GTX1060+? Wcale tak bardzo się nie zestarzał.

AMD w tamtych czasach brakowało niższych procesów produkcji. Byli za Intelem tak jak Intel teraz za nimi. A to sprawiało, że trzeba było iść w dużą moc cieplną, by wypluć trochę mocy z procesora.

- c.d. (autor: pwil2 | data: 28/04/21 | godz.: 17:22)

Nie dało się przewidzieć efektu końcowego na etapie projektowania nowej architektury. Trudno było przewidzieć jak bardzo uda się ją rozwinąć. Im bardziej odstawali w procesach, tym bardziej brnęli w ślepą uliczkę.

- @Wyrzym (autor: krzysiozboj | data: 28/04/21 | godz.: 19:03)

Ale skąd Ty wiesz, że 5 mld to dużo? Masz tyle i wiesz? Twój kalkulator to ogarnia (bo inni ponoć takich nie mają)? Bo dokładnie w taki sposób mędrkowałeś.

Jest mi przykro, co najwyżej potrafisz liczyć zera i porównać dwie liczby, na zasadzie "która większa". A dla mnie większym wyczynem będzie, jeśli (jakaś) mała firma zrobi 1 mld, niż duża korporacja (mająca niedawno monopol globalny) 10 mld.

- nie wiem czy zauwazyles (autor: Wyrzym | data: 28/04/21 | godz.: 19:45)

ale sie powtarzasz, w dodatku tak sakramencko :D w dodatku tym zakazem wypowiadania sie to ty wyskoczyles, wymysliles sobie cos i powtarzasz jak mantre ze moje slowa... ale niech bedzie, podly ja :|

Ciezko ci przebolec twoje fifokowanie, ta chwile chwaly ktora ci zabralem, no ale dasz sobie z tym rade, musisz dac, bo co innego zostaje nie? ^^ moze nie wiem, lepienie garnkow z plasteliny dla odstresowania?

Zalozmy na potrzebe tego posta ze liczyc jednak umiesz, masz odpowiedni kalkulator, wysypales sobie ziarenka maku gdzies w pokoju zeby sobie to w jakis sposob zwizualizowac, zbudowales w mincrafcie 2 piramidy z takich ilosci klockow itp itd. To musisz byc ewidentym fanbojem skoro dla ciebie wyniki jednej korporacji na poziomie 19 sa gorszym wynikiem niz drugiej na poziomie 3 (tak, tu szok, jedna i druga to wielka zla korporacja, zaskoczenie?) No chyba ze to nie o to chodzi i zwyczajny mlot z ciebie :D czego tez nie mozna wykluczyc.

ale dobra, o wiele rzeczy sie w zyciu klocilem, ale jeszcze nigdy, przenigdy nie byla to klotnia w obronie honoru jakiegos korpo... chociaz tak nie jest, to moze tak to wygladac, czuje sie z tym zle... dobijcie mnie :|

- @19 skoro amd sie cieszy z 5mld i portale komentuja ze duzo... (autor: gantrithor | data: 30/04/21 | godz.: 12:21)

to znaczy ze jest to duzo ja tego nie ocenie bo jestem biedny i dla mnie to jest w hooj duzo tym bardziej ze amd szorowalo po dnie i walczylo z wodorostami o zycie.

Apropo buldozera to zamysl byl przedni, amd chcialo stworzyc procesor z wirtualnym klastrem sprzetowym ktory w razie potrzeby rozdzielal by zasoby miedzy 2 niezalezne watki eliminujac przestoje jak w HT intela i utylizujac zasoby na 100%, pomysl tez mial za zadanie zmniejszyc rdzen i pozbawic go dublujacych sie czesci rdzenia jak ma to miejsce w procesorach intela z HT i amd z smt niestety cos poszlo mocno nie tak nie wiem co mozna tylko gdybac moze braki inzynieryjne a moze braki gotowki lub ktos naciskal albo trafil sie jakis wizjoner z dobra gadka typu raja, pracuje w bardzo przyziemnej branzy i nawet tu zdarzaja sie kwiatki ze zamiast wybrac lepszy pomysl bardziej logiczny to wybiera sie taki na hura bo ktos kogos przekonal do swoich racji...

Co do procesorow bigLITTLE to mozliwe ze plotki z przed kilku lat sie potwierdza a mianowicie mowily one o procesorach zen z 4 watkami smt na rdzen wiec dwa rdzenie i 8 watkow to calkiem niezle rozwiazanie dla nisko energetycznego procesora do laptopa.

- @21 (autor: krzysiozboj | data: 1/05/21 | godz.: 11:12)

Cała moja "durna dyskusja" z Wyrzymem ma początek pod newsem z wynikami Intela. Tam z mojej strony padło, że Intel ma słabe wyniki, a Wyrzym się prz...l, skąd ja mogę o tym wiedzieć, jesli takich liczb nie ogarniam, tu tylko oddaję mu to :) Nie ma sensu w to wchodzić głębiej :)

Cztery wątki na rdzeń to AMD powinno mieć opanowane, bo chyba przejęli coś pracowników po Cray. Tylko pytanie, czy to do PC-tów dobre. Niemniej powtórzę się - cieszy mnie rozwój, cokolwiek to będzie, czy 4 wątki na rdzeń i dalsze mnożenie rdzeni/wątków, czy mieszanie rdzeni mocnych i słabych, będzie to rozwój. To nie będzie ta sytuacja jak z czasów core od 2 gen do 7 gen.

- @22. (autor: pwil2 | data: 4/05/21 | godz.: 10:38)

4 wątki na rdzeń mają sens wtedy, gdy rdzeń jest szeroki i dużo mocy się marnuje i gdy mamy dużą przepustowość pamięci z dużymi opóźnieniami.

Problem się robi, gdy jest jeden wątek dla którego wydajność jest krytyczna, a system dorzuci obliczeń na pozostałe wątki w tym samym rdzeniu.

W najgorszym przypadku taki 8c32t@4GHz będzie się zachowywał podobnie jakby był 32c@1GHz (minus straty na nietrafienia w pamięci cache dzielonej przez 4.

- @21. (autor: pwil2 | data: 4/05/21 | godz.: 10:50)

AMD miało ograniczenia techniczne w produkcji i próbowali wycisnąć jak najwięcej z małego kawałka krzemu w starym procesie. Wycisnęli więcej jednostek stało przecinkowych, kosztem ograniczonej mocy FPU.

Oprogramowanie było wtedy słabo optymalne/optymalizowane pod ich architekturę. Więcej można by wycisnąć montując takie klastry w konsolach. Kod mieszany można by wykonywać na parzystych rdzeniach, a stałoprzecinkowy na nieparzystych i mieć w ten sposób prawie niezależną od siebie moc obliczeniową. Pod Windowsem skoro aplikacja działała, to nie było potrzeby nic zmieniać pod mniej popularny sprzęt.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|