|

TwojePC.pl © 2001 - 2026

|

|

Poniedziałek 28 marca 2022 |

|

| |

|

GeForce RTX 4080 i 4090 będą mieć powiększone sekcje zasilania GPU

Autor: Zbyszek | źródło: Igors Lab | 21:04 |

(5) |  AMD i Nvidia jesienią tego roku mają wprowadzić na rynek nową generację kart graficznych. W przypadku AMD będą to nowe Radeony RX7000 oparte o 5nm chipy z architekturą RDNA 3, natomiast Nvidia zaserwuje nam karty GeForce RTX serii 4000 z 5nm chipami GPU o nazwie kodowej Ada Lovelace. W sieci pojawiły się kolejne doniesienia na temat kart GeForce RTX 4080 i 4090 z chipem AD102, które mają zadebiutować jako pierwsze na przełomie 3. i 4. kwartału 2022 roku. Nowe informacje po raz kolejny potwierdzają bardzo wysoki wskaźnik TDP - w przypadku GeForce RTX 4090 ma on wynosić aż 600W, a w przypadku GeForce RTX 4080 będzie to 450-500W. AMD i Nvidia jesienią tego roku mają wprowadzić na rynek nową generację kart graficznych. W przypadku AMD będą to nowe Radeony RX7000 oparte o 5nm chipy z architekturą RDNA 3, natomiast Nvidia zaserwuje nam karty GeForce RTX serii 4000 z 5nm chipami GPU o nazwie kodowej Ada Lovelace. W sieci pojawiły się kolejne doniesienia na temat kart GeForce RTX 4080 i 4090 z chipem AD102, które mają zadebiutować jako pierwsze na przełomie 3. i 4. kwartału 2022 roku. Nowe informacje po raz kolejny potwierdzają bardzo wysoki wskaźnik TDP - w przypadku GeForce RTX 4090 ma on wynosić aż 600W, a w przypadku GeForce RTX 4080 będzie to 450-500W.

Karty będą też wyposażone w nowe 16-pinowe złącze zasilające, potrafiące zapewnić zasilanie mocą do 600W i będące częścią specyfikacji PCI-Express 5.0.

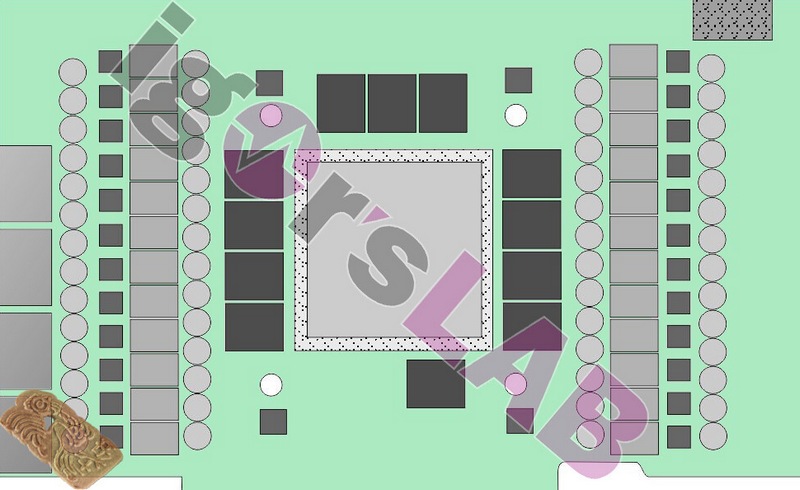

Niezawodny i znany ze sprawdzających się informacji serwis Igors Lab informuje, że dotarł do danych na temat konstrukcji płytki drukowanej kart GeForce RTX 4080 i 4090. Jak twierdzi, będzie ona nieco większa niż PCB dotychczasowych GeForce RTX 3080 i 4090, i pozbawiona charakterystycznego dla nich wcięcia w kształcie znaku <. Dodatkowa powierzania PCB zostanie wykorzystana przez znacznie większą sekcję zasilania GPU - będzie ona w sumie 28-fazowa, z czego 4-fazy będą zasilać pamięci, a 24-fazy będą zasilać GPU AD102. Dla porównania GeForce RTX 3080, 3080 Ti i 3090 mają sekcje zasilające mające od 16-faz do 19-faz (łącznie dla GPU i pamięci).

Chip GPU AD102 według Igors Lab ma mieć powierzchnię około 600 mm2, i posiadać 18432 rdzeni CUDA, o 71 procent więcej niż GA102 z kart RTX 3080 / 3090.

Płytka drukowana GeForce RTX 4080 / 4090 - wizualizacja

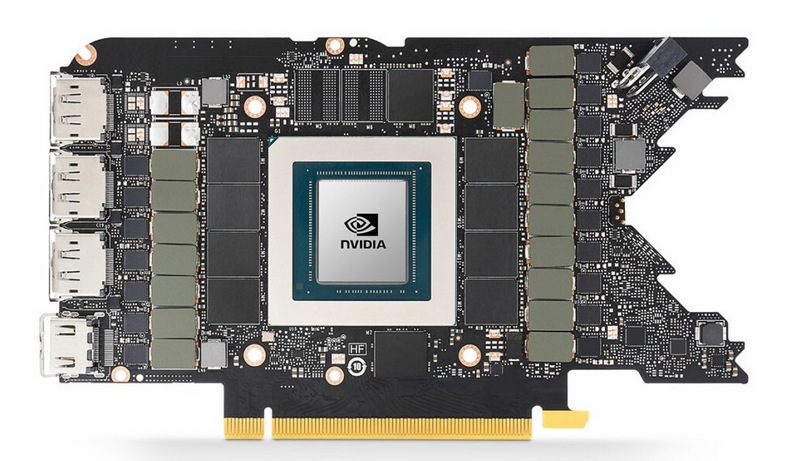

Dla porównania płytka drukowana GeForce RTX 3080

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- Low end (autor: AwerS | data: 29/03/22 | godz.: 11:19)

Kiedy w końcu pojawi się low end 4030?

- 500W to jak mała farelka (autor: hazoc | data: 29/03/22 | godz.: 16:31)

Zamiast postępu jest dno i metru mułu.

- 2-- (autor: Mario1978 | data: 29/03/22 | godz.: 16:56)

To znaczy jakim typem człowieka jesteś. Oceniasz produkt po zapotrzebowaniu na moc a nie zwracasz uwagi na najważniejszy element czyli wydajność. Tacy ludzie jak ty nie widzą różnicy w produkcie gdy jeden jest o 300% wydajniejszy a podstawa porównania tyczy się jakieś tam mocy obliczeniowej dającej 10 punktów a innym dającym także wzrost wydajności o 200-300% ale podstawą porównania jest 100 punktów. Pamiętaj, że jak patrzy się tylko na Procenty oraz Zużycie Energii to tylko człowiek sam siebie oszukuje w podstawowych brakach znajomości matematyki.

- @ Mario1978 (autor: Zbyszek.J | data: 30/03/22 | godz.: 23:51)

problem w tym, że kosztem wzrostu poboru energii z 250W do 500W, zyskuje się różnicę wydajności wynoszącą około 15 procent, max 20 procent. Gra nie warta świeczki.

Druga kwestia to jak takie żyłowanie parametrów napięcia zasilania chipów wpłynie na żywotność.

Nie jestem wprawdzie za sztucznym ograniczaniem rozwoju, postępu, ale mocniej sprzeciwiam się jednak takiemu bezsensownemu żyłowaniu parametrów aby zyskać 10% wydajności kosztem wielokrotnie większego wzrostu zużycia energii.

UE kiedyś zajęła się ograniczeniem mocy odkurzaczy i czas na to, żeby przyhamować zapędy w GPU. Bo jeśli nie to za 3-4 lata będziemy mieć karty graficzne żłopiące 1,2 KW (chłodzenie wodne), i mające wydajność tylko o 20-30% większą od takich samych konstrukcji ustawionych na pobór 250-300W. To nie ma sensu i trzeba temu powiedzieć stop.

Na koniec warto przypomnieć: pobór mocy układów scalonych wrasta kwadratowo wraz ze wzrostem ich napięcia jakie je zasila.

- ... (autor: power | data: 31/03/22 | godz.: 14:29)

@3 Krotko mowiac to sam nie masz racji. Ciezko powiedziec jakim jestes typem czlowieka, bo caly czas wypisujesz bzdury, do tego z bledami (przymiotniki typu "chinski" piszesz z wielkiej litery). Troll czy obcokrajowiec?

@4 Chyba chciales napisac ze wraz ze wzrostem mocy wzrasta kwadratowo temperatura? :)

Napiecie sie nie zmienia, to jest caly czas 12V we wtyczce PEG, ktore pozniej jest konwertowane do nizszych potrzebnych napiec (5V, 3.3V, 1.8V i okolo 1V w zaleznosci od GPU).

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|