|

TwojePC.pl © 2001 - 2026

|

|

Czwartek 17 listopada 2022 |

|

| |

|

Wzrasta niezadowolenie z 16-pinowej wtyczki zasilającej karty GeForce

Autor: Zbyszek | źródło: GamerNexus/Inne | 20:30 |

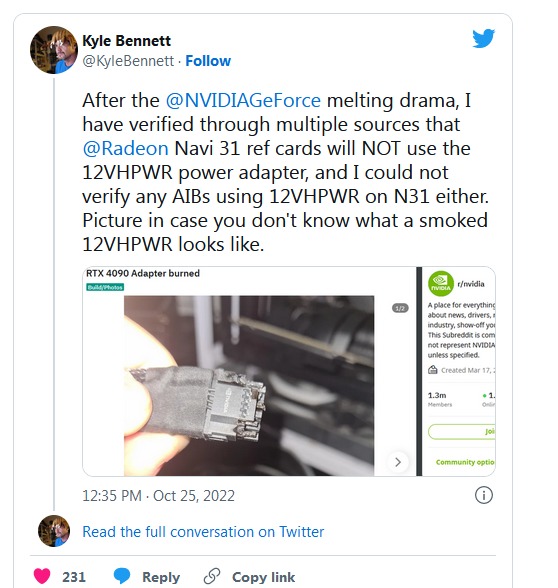

(28) |  GeForce RTX 3090 Ti oraz debiutujące w tym roku karty GeForce RTX serii 4000 to pierwsze konsumenckie karty graficzne wyposażone w nową wtyczkę zasilającą. Została ona opracowana wraz z magistralą PCI-Express 5.0, ma 16 pinów, jest dość kompaktowa, ale jednocześnie potrafi dostarczać karcie graficznej bardzo dużo energii - do 600 W. Wraz z tym, jak liczba użytkowników nowych modeli kart GeForce wzrasta, w sieci pojawia się coraz więcej informacji o stopieniu się 16-pinowej wtyczki zasilającej. To powoduje oczywiście unieruchomienie karty graficznej i konieczność odesłania jej do serwisu. Nvidia konsekwentnie twierdzi, że awarie wynikają z błędów użytkowników, co tylko wzmaga niezadowolenie. GeForce RTX 3090 Ti oraz debiutujące w tym roku karty GeForce RTX serii 4000 to pierwsze konsumenckie karty graficzne wyposażone w nową wtyczkę zasilającą. Została ona opracowana wraz z magistralą PCI-Express 5.0, ma 16 pinów, jest dość kompaktowa, ale jednocześnie potrafi dostarczać karcie graficznej bardzo dużo energii - do 600 W. Wraz z tym, jak liczba użytkowników nowych modeli kart GeForce wzrasta, w sieci pojawia się coraz więcej informacji o stopieniu się 16-pinowej wtyczki zasilającej. To powoduje oczywiście unieruchomienie karty graficznej i konieczność odesłania jej do serwisu. Nvidia konsekwentnie twierdzi, że awarie wynikają z błędów użytkowników, co tylko wzmaga niezadowolenie.

Po pojawieniu się pierwszych przypadków producent miał stwierdzić, że problem nigdy nie zaistniał w jego laboratoriach i laboratoriach producentów kart graficznych. Natomiast przyczyną przegrzewania się i topienia 16-pinowych wtyczek ma być nieprawidłowe podłączenie przewodu przez użytkowników. Nvidia wydała wówczas zalecenia, że przewód do 16-pinowego gniazda musi być wkładany pod kątem prostym, i powinien zostać wciśnięty mocno do samego końca, i nie powinien być też zaginany - co najmniej 3,5 cm przewodu w pobliżu wtyczki powinno być całkowicie wyprostowane.

Problem postanowił zbadać GamersNexus. któremu udało się odtworzyć awarię występującą u użytkowników. 16-pinowe gniazdo miało zachowywać się prawidłowo przy starannym wetknięciu do niego wtyczki zasilającej. Gdy później zrobiono to nieco pod kątem, a wtyczka nie została wetknięta do samego końca, temperatura połączenia bardzo szybko wzrosła do 300 stopni, co spowodowało awarię.

Mimo wszystko gniazdo jest krytykowane i nie cieszy się już dobrą sławą. Mówiąc inaczej, powinno mieć ono konstrukcję wybaczającą błędy użytkownika, a tak nie jest. Co ciekawe problem nie dotyczył oferowanych od wiosny kart GeForce RTX 3090 Ti, więc sprawa prawdopodobnie musi mieć też dodatkową przyczynę.

W sądzie w USA w stanie Kalifornia przeciwko Nvidia złożony został już pozew zbiorowy, do którego przystąpić może każdy zamieszkujący ten stan nabywca karty graficznej GeForce, która uległa awarii wskutek stopienia się wtyczki zasilającej. W pozwie czytamy m.in.. że „Nvidia sprzedawała GeForce RTX 4090 z wadliwą i niebezpieczną wtyczką i gniazdem kabla zasilającego, co uniemożliwiło działanie kart konsumentów i stanowi poważne zagrożenie elektryczne i pożarowe dla każdego nabywcy”.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- "wadliwą i niebezpieczną wtyczką" (autor: Conan Barbarian | data: 17/11/22 | godz.: 21:48)

Ewidentnie to szmelc i niech NVidia to gówno zmieni bo strach komputer będzie pozostawić bez opieki, chata spłonie.

- chila chwila (autor: pawel1207 | data: 17/11/22 | godz.: 23:37)

na game nexus ladnie to wyjasnili topienie sie jest wina urzytkownika jest to wina niedocisniecia i mocnego ugiecia kabla po prostu trzeb sei upewnic ze ma dobry styk ale fakt faktem powinno by c to zaprojektowane lepiej ..

- tą wtyczkę i gniazdo (autor: Shark20 | data: 18/11/22 | godz.: 00:57)

projektowali i akceptowali kretyni. Jakim cudem przeszło to akceptację grupy PCI-SIG, to nie wiem.

Zamiast 16 miniaturowych pinów tam powinny być dwa grube podłużne piny - coś podobnego jak w gniazdkach 230V angielskich. Plus grubsze plastiki okrążające te dwa grube podłużne styki. Powierzchnia styku wtyczki z gniazdem byłaby kilka razy większa, wytrzymałość mechaniczna całej konstrukcji kilka razy lepsza = trudniej włożyć wtyczkę tak żeby nie stykała się z gniazdem za dobrze.

- 16pin ? (autor: leosh | data: 18/11/22 | godz.: 08:06)

na zdjęciu widzę 12pin

- Ja prdl... (autor: KaszeL | data: 18/11/22 | godz.: 09:47)

Jak zwykle w środowisku komputerowym gówno burza w szklance wody. To nie nvidia opracowała ten standard wtyczek, tylko molex. Nazywa się to micro-fit (w obecnej odsłonie 3.0). Poprzednie złączki to również był twór molexa, i nazywał się mini-fit. Nowy standard przewiduje obciążenie do 10,5A na pin, poprzedni nadal używany nawet do 13A, ale w takiej standardowej odsłonie 8A. No i co z tego wynika? Stare złącze 6 pinowe, ma układ 3x12V i 3xGND, czyli teoretycznie może dostarczy nawet... 288W (3piny x 8A x 12V). Tylko z jakiegoś powodu w pecetowym światu ograniczono moc tego złącza do ledwie 75W - czyli ledwie ponad 2A na parę przewodów. Stare złącze 8 pinowe, nadal ma układ.... 3x12V i 3x GND tylko dodano 2 linie na pomiar napięcia po drugiej stronie kabla. Z jakiegoś powodu to złącze, które technologicznie również może przesłać 288W tym razem obciąża się mocą do 150W. Czyli w tym przypadku do okolic 4.2A/parę pinów. Dlaczego tak się robi? Ano dlatego, że te teoretyczne 8 czy nawet 13A na pin to da się osiągnąć - ale tylko stosując markowe komponenty. Głównie piny, bo reszta złącza jest nieważna. Skoro chińczyk na wagonie pinów może zaoszczędzić worek dolarów, to do standardu podchodzi się z pobłażaniem i nie obciąża się go na 100%. Skoro nie obciąża się na 100% to ryzyko awarii jest mniejsze. Chociaż nadal te złączki się paliły. Jak nie wiadomo o co chodzi, to chodzi o pieniądze - nie należy szukać w tym rozsądku. Dlaczego nadal używa się przy tych mocach 12V nie mam pojęcia. Cały przemysł od lat używa standardu -48V DC. I teraz zamiast bawić się w wielopinowe delikatne złacze, przesyłając nim stosunkowo duże prądy - należało iść w wyższe napięcie i problem by nie istniał. Na kartach graficznych są i tak przetwornice DC-DC, zasilacze z liniami -48V są dawno opracowane i sprawdzone w przemyśle. Można było inaczej. Na dodatek, całe to zamieszanie to zwykły user-error. Ktoś nie dopchnął wtyczki, ktoś nagiął kabel, ktoś wrzucił do sieci i z jednostkowego (ciekawe, czy było potwierdzonych chociaż 100 przypadków na świecie) mamy teorię na pożywkę keyboard commando. BTW: Te złacza 6pin i 8pin też się paliły - tylko młodzież nie pamięta ;)

- Żeby było jeszcze ciekawiej... (autor: KaszeL | data: 18/11/22 | godz.: 09:59)

W komputerowym światku od dawna przecież istniało złącze 12V służące do zasilania w tym przypadku głównie sekcji vrm procesorów na serwerowych płytach głównych. Dla odmiany w tym przypadku, również używając 8 pinowego złącza Mini-Fit mamy do dyspozycji 235W. Co prawda tutaj już nie mamy zabawy w linie pomiarowe, złącze oferuje 4 pary 12V/GND. Jeśli policzymy sobie budżet mocy, to okazuje się, że tu dopuszcza się 4,9A/pin. Czy nie wydaje się wam nieco dziwne, że gniazda wykorzystujące fizycznie takie same złącza są obciążane za każdym razem innym prądem? 4A dla PCI-e 6pin, 4,2A dla PCI-e 8 pin, 4,9A dla EPS-12V. Na prawdę nie chce mi się sprawdzać, jakie dopuszczalne obciążenie na pin ma złącze ATX24pin - to jest również Mini-Fit..... Jeśli ktoś ma jakiekolwiek wątpliwości, że robi się to w innym celu niż dla pieniędzy, niech pierwszy rzuci kamieniem.

- zgadzam sie z CA (autor: bajbusek | data: 18/11/22 | godz.: 10:42)

każda zaprojektowana z głową "wtyczka" przenosząca duży prąd powinna być <-- skreśl MUSI być IDIOTOODPORNA jeśli jest sprzedawana obok mopa Dysona albo baterii do masturbatora w BestBuy !

Po co "piepszyc" tyle na ten temat ?

- at4 (autor: bajbusek | data: 18/11/22 | godz.: 10:44)

kategoria: wielkie dioptrie ...4 kolejne masz pod tymi 12

- wtyczka (autor: doxent | data: 18/11/22 | godz.: 11:32)

problemem jest wykonanie tego kabla-przejściówki. Dość sztywne i nieporęczne, na dodatek w złym miejscu. Powinno się tą wtyczkę robić pod kątem 90 stopni bo inaczej wystarczy zamknąć obudowę i już następuje przekrzywienie i wysunięcie. EVGA swoją drogą zaprojektowała kartę gdzie to złącze umieszczono w kierunku przodu obudowy tak aby panel boczny nie naruszał połączenia przy zamykaniu.

- ... (autor: pwil2 | data: 18/11/22 | godz.: 13:51)

Problem występuje nawet w przypadku nowych dedykowanych zasilaczy fabrycznie wyposażonych we wtyczkę i podłączeń bez zagięć.

Po prostu należało wprowadzić jakieś zabezpieczenie, by dopiero dociśnięcie wtyku zwierało piny, które służyłyby do pomiaru napięcia. Bez tego odczytu/pomiaru czerwona dioda LED i czarny ekran.

nVidia mogła trochę mniej szarżować z poborem nowych kart i/lub wprowadzić złącze próbnie do słabszych modeli. To nie jest normalne, żeby pospolite złącze w czasie normalnej pracy grzało się do 80C.

- @6. (autor: pwil2 | data: 18/11/22 | godz.: 13:53)

W kartach graficznych złącza są często dwa. Często podłączane są przez przejściówki, które czasem wypadają/nie kontaktują. Przy odpowiednim zapasie mocy taki jeden wtyk 6/8-pin uciągnie kartę i przy 8-9A się nie stopi.

- c.d. (autor: pwil2 | data: 18/11/22 | godz.: 13:56)

Można wprowadzić 24V, można 48V, a nawet 60V. Problem w tym, że są miliony, miliardy zasilaczy na świecie i do 1, 2, 5, 10-letniego kompa nie mógłby człowiek sobie dokupić karty za wolne 500$, czy tam 1500$. Trzeba by kolejnych 10-lat na upowszechnienie się standardu, a często gotowe zestawy jadą na integrach i tylko część z nich rozbudowuje się o dodatkową kartę.

- @12. (autor: Mariosti | data: 18/11/22 | godz.: 21:16)

Jest standard EPS 8-pin, solidne wtyczki, grube piny, grube przewody, jedno gniazdo obsługuje 350-388W zależnie od klasy wykonania.

Jeśli coś miałoby mieć sens to właśnie pozostawienie w zasilaczach dla dodatkowych urządzeń poza płytą główną tylko wyjść zasilania EPS i SATA, a resztę można sobie uzyskać przelotkami/kablami adapterami (na np molex i pcie-6/8 pin dla kompatybilności wstecznej).

A jeśli ktoś chce robić jakiś standard "rozpoznawania" mocy zasilacza, to w sumie to nie ma za bardzo sensu, a na pewno nie za pomocą jakichś dodatkowych pinów, zamiast np softowego protokołu informującego urządzenia po PCI-Express, plus mini układzik usb w zasilaczu do podłączenia do płyty głównej do informowania, bądź np opcja w biosie do podania przez użytkownika jaką moc ma zasilacz na +12V.

- @2 Na gamers nexus wyjasnili ze jest to... (autor: gantrithor | data: 19/11/22 | godz.: 01:40)

troche bardziej skomplikowane i mimo iz wtyczka jest wcisnieta do konca "kliknie" to nadal ruchy kablem lub wibracje obudowy moga poluznic wtyczke co doprowadza do momenty zle podpietej wtyczki/slaby kontakt duza opornosc wysoka temperatura.

Na jednym z testow obcieli piny z wtyczki eliminujac dwa kable czyli karta dzialala na jednym molexie i temperatury byly ok.

Dlaczego do jasnej ciasnej karta dziala na 1/3 pinow? nie powinno byc tak ze musza byc podpiete wszystkie? wyglada jak by projektanci poszli skrotami ktore juz maja skroty prowadzace przez skroty...

- @gantrithor (autor: Dzban | data: 19/11/22 | godz.: 09:19)

Wtyczka 8 pin też by działała przy obcięciu pinów. Dlaczego miałoby być wykrywane czy wszystkie piny są podłączone? Nikt normalny nie ucina kabli z zasilacza.

- @15 Skoro zasilanie moze byc podawane... (autor: gantrithor | data: 19/11/22 | godz.: 15:25)

przez szeregowo zlutowane 6 pinow to rownie dobrze moze byc podawane przez dwa grubsze piny jak do spawarki, nowoczesne spawarki inwerterowe sa minaturowe a te bez podajnika drutu sa o polowe mniejsze niz rtx 4090 posiadaja wlasne przetwornice i doprowadzaja energie do elektroniki diod czy podajnikow z dwoch kabli w scianie wiec po co ta komplikacja w kartach grafiki?

A no moze dla bezpieczenstwa a skoro odciecie ulamanie czy ukruszenie jednego przewodu nie da sie wykryc to jest to blad w projekcie.

- Aż trudno sobie wyobrazić jak oni będą doprowadzać (autor: Mario1978 | data: 19/11/22 | godz.: 17:45)

jedzonko dla kart graficznych skierowanych do entuzjastów gier i nie tylko na PC w nowej generacji od Nvidia wykonanych w N3E.

Tam będziemy mieli TDP na poziomie 1300W. Będzie ciekawie.

- Ten pomysł na zasilanie karty graficznej (autor: Shark20 | data: 19/11/22 | godz.: 19:56)

jest chyba przyszłościowy. Szczegóły na filmie: https://www.youtube.com/watch?v=0frNP0qzxQc

- @5. (autor: pandy | data: 20/11/22 | godz.: 00:46)

48VDC nie byłoby dobre ze względu na większe straty energii - generalnie sprawność zasilaczy jest tym gorsza im większa różnica miedzy napięciem zasilającym i napięciem na wyjściu zasilacza. Typowa elektronika także na kartach graficznych to dziś grubo poniżej 3.3V.

Wystarczyłoby popatrzeć co i jak robią samochody gdzie zazwyczaj przy małych napięciach (12VDC) przepływają duże prądy rzędu kilkudziesięciu A.

- ludzie (autor: pawel1207 | data: 20/11/22 | godz.: 01:14)

na 100 tys sprzedanych kart jest obecnie cale 50 przypadkow wszystkie wynikaja z winy urzytkownika uwarzem ze tutaj mozna zamknac dyskuje nie jestm jakims fanem nv .. tak to jest jak dzieci czy ludzie co nigy zadnego kompa nie zlorzyli biora sie za wymiane kary graficznej cos co jest banalnie proste ale jednak wymaga sprawdzenia czy wszystko jest dobrze docisniete a kabel nie jest jakos strasznie wygiety ... zgadzam z sie ze mozna byloo to zaprojektowac lepiej ale na tyle sprzedanych kart 50 przypadkow to nie swiadczy o tym ze to rozwiazanie jest zle tylko o tym ze wymaga wiecej uwagi podczas skladania wystarczy ogladnac na GM jakiej sily trzeba urzyc i kiedy jest docisnieta i problemu by nie bylo moim zdaniem ludzie moga winic tylko siebie ze nie zrobili tego prawidlowo mimo bledu urzytkownika nv i tak objela te karty gwarancja ..

- pawel1207 (autor: Markizy | data: 20/11/22 | godz.: 08:16)

źródło tych danych? Nie wierze w ilość sprzedanych kart ani w całkowitą ilość awarii. Rozwiązanie które wprowadzono jest wadliwe i wymaga usprawnień ewentualnie zaorania go wykonania na nowo. A pamiętajmy że karta jest dla zwykłego użytkownika a nie specjalisty od elektroniki wiec do pewnego stopnia rozwiązania tutaj muszą być idioto odporne.

@pandy

Przecież i tak masz stratne przekształcenie 230v na 12V w zasilaczach wiec większej różnicy to już nie robi. A większe napięcie zmniejsza straty przy przesyłaniu energii. Faktem jest 48V to za dużo ale 24V było by już odpowiednie.

- Markizy (autor: pawel1207 | data: 20/11/22 | godz.: 17:23)

Gamers Nexus

masz tam caly material o tym muslieli sie naprawde postarac aby wtyczka zaczela sie topic ... podali tez tam statystyke ile czego jest i ile tego zgloszono .. oraz to ze nv objela te karty gwarancja itd... masz tam na youtubie tale 18 minut o tym kabelku :D ewidenty blad urzykownika ...

- pawel1207 (autor: Markizy | data: 20/11/22 | godz.: 18:05)

Film o tym kabelku to już drugi. Nadal wątpliwe zostaje przygotowanie wtyczki która nie jest idiodo odporna tak jak poprzednie gniazdo. Natomiast posadowienie wtyczki na gtx4090 wymaga naprawdę wielkiej obudowy nie mówiąc o tym że złącze zostało umiejscowione tak aby nie było widoczne dobrze czy się zaklikneło czy nie.

https://www.purepc.pl/..._geforce_rtx_4090_3_b.jpg

https://www.techpowerup.com/...on/images/card5.jpg

- @pawel1207 (autor: pandy | data: 21/11/22 | godz.: 18:41)

czym innym są straty w zasilaczu (który ma małostratny transformator) a czym innym zbijanie z 48V do np 1.875V na PCB karty. Inne podejście pomijając dodawanie dodatkowego obwodu do zasilacza który musiałby dawać 24V/48V - nowy standard z którego skorzystają nieliczni...

By było jasne - ja rozumiem pomysł i jest on technicznie racjonalny problemem jest sam rynek - więc na razie opłaca się przesyłać te 50..75A max po takich wielopinowych wtyczkach, problemem jest jednak ich jakość i pewność małej rezystancji przez długi okres eksploatacji.

Dlatego zasadne byłoby opracowanie takiego zestawu gniazdo-wtyk w którym zapewniona będzie dużą powierzchnia stabilnego kontaktu i mała jego rezystancja (czy raczej maksymalnie duża i stabilna w czasie konduktancja) przy jednoczesnej idiotoodporności tzn że parametry są spełnione nawet jeśli montażu dokonuje osoba bez zdolności technicznych.

- Dodam że (autor: pandy | data: 21/11/22 | godz.: 18:48)

wg mnie za to winę ponosi NVidia bo albo powinni monitorować spadek napięcia na wtyczce (to nie jest w dzisiejszych czasach aż taki problem mierzyć dwa napięcia bo przy takich prądach to nie są uV) albo wybrano wtyk/gniazdo nie gwarantujące bezwzględnej pewności połączenia.

Przy takich prądach (rzędu 50..75A) to przestają być trywialne rzeczy.

- Nie rozumiem (autor: VP11 | data: 22/11/22 | godz.: 09:55)

Dawno mogliby wyprowadzić gniazdko poza płytą drukowaną z dodatkowym przewodem. Tak aby użytkownik podpinał gdzieś na odległości 7cm od karty. I wtedy można zrobić wszystkie zabezpieczenia idiotoodporne.

Pamiętam gdzieś słyszałem, że jeden senator USA wypowiedział chasło: Jeżeli chcesz być głupim w stanach zjednoczonych masz na to prawo.

Stąd to producent ma zadbać o to by w sposób jednoznaczny można było zrobić lub dodać widoczny napis ostrzegawczy jak z tą kawą na kubku z kawą że parzy.

- no wiecie (autor: pawel1207 | data: 25/11/22 | godz.: 05:18)

widzicie jak wtyczka jest zalorzona wlasciwie to spelnia wszystkie normy a nawet ma spory zapas :D jedyne czego wymago to dobrego docisniecia tak jak wszystkie wtyczki wkarzdym komputerze .... dorabianie ideologi bo 50 ludzi tego nie zrobilo jest po prostu zalosne wtyczka spelnia swoje zadanie i zalorzenia i robi to z nadmiarem jedyny wymog jest taki ze musi byc dobrze docisnieta tak zeby zaskoczyl zatrzask nie wydaje mi sie aby to bylo jakies wielkie wymaganie i 99 % kupujacych sobie z tym poradzi bez problemu ale skoro klijent ze sobie z taka czynnoscia nie poradzi to proponuje abys skorzytal po prostu z pomocy skoro taka malo skomplikowana czynnosc jest dla kogos za malo idioto odporna proste proste... poatrz na testy ktore na gamers nexus wykonali prawidlowo docisnieta i zalorzona jest bezproblemowa i zapewnia spory zapas prawdopodobnie nowa wtyczke dostana tez karty amd jak nie w tej to w przyszlej generacji bedzie to stanadart przy atx 3.0 wtyczka wcale nie jest zaprojektowana glupio jest co najwyzej glupio umiejscowiona i instrukcja moze nie wyjasnia dokladnie ze trzeba ja docisnac dos mocno wlasnie po to aby styki dobrze siedzialy ... serio jak czytam wasze komentarze to zaczynam miec spore watpliwosci czy kiedykowiek skladaliscie jakikolwiek komputer skoro wywiazuje sie tak dyskusja nad tym ze macie problem docisnc wtyczke i sprawdzic czy dobrze lezy na calym swiecie na razie az 50 osob mialo z tym problem :D widze ze dolaczacie do tej elity specjalistow wybitnych specjalistow :D ... jak dla mnie toczycie piane o to bo to nv nawet nie mozna nazwac tego wpadka co do idotoodpornosci starych wtyczek :D ludzie nie jedna sie spalila :D

- @27. (autor: pandy | data: 26/11/22 | godz.: 01:11)

jesteś klientem który akceptuje wyjaśnienie firmy że niewłaściwie trzyma telefon...

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|