|

TwojePC.pl © 2001 - 2026

|

|

Poniedziałek 12 grudnia 2022 |

|

| |

|

Radeon RX 7900 XT i Radeon RX 7900 XTX - oficjalna premiera

Autor: Zbyszek | źródło: AMD | 19:34 |

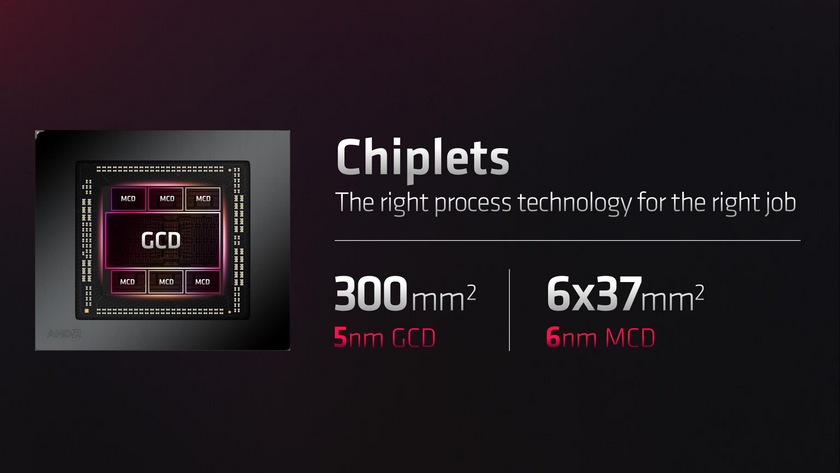

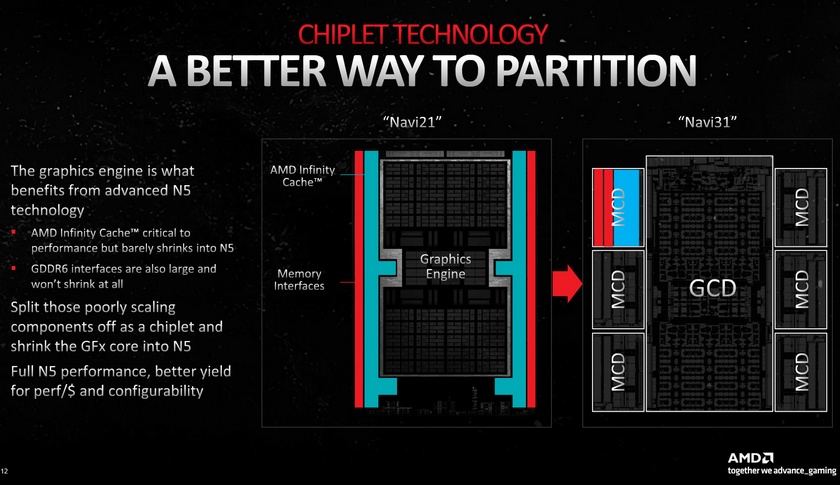

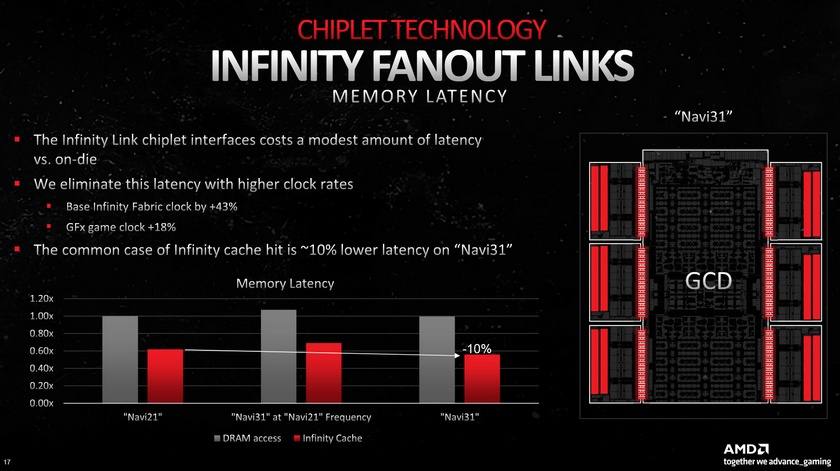

(28) |  AMD oficjalnie wprowadza dziś na rynek swoje nowe karty graficzne Radeon RX 7900 XT i Radeon RX 7900 XTX. Obie karty bazują na architekturze RDNA 3, a pod ich systemem chłodzenia znajduje się chip Navi 31, czyli największy układ scalony zbudowany na bazie tej architektury. Navi 31 ma budowę modułową i składa się z siedmiu połączonych ze sobą układów scalonych: centralnego chipletu GCD (Graphics Core Die) wytwarzanego w litografii 5nm, i sześciu chipletów MCD (Multi Cache Die) wytwarzanych w litografii 6nm, które zawierają pamięć Infinity Cache i kontrolery/interfejsy pamięci GDDR6. Niestety wydajność nowych kart nie zachwyca. AMD oficjalnie wprowadza dziś na rynek swoje nowe karty graficzne Radeon RX 7900 XT i Radeon RX 7900 XTX. Obie karty bazują na architekturze RDNA 3, a pod ich systemem chłodzenia znajduje się chip Navi 31, czyli największy układ scalony zbudowany na bazie tej architektury. Navi 31 ma budowę modułową i składa się z siedmiu połączonych ze sobą układów scalonych: centralnego chipletu GCD (Graphics Core Die) wytwarzanego w litografii 5nm, i sześciu chipletów MCD (Multi Cache Die) wytwarzanych w litografii 6nm, które zawierają pamięć Infinity Cache i kontrolery/interfejsy pamięci GDDR6. Niestety wydajność nowych kart nie zachwyca.

Radeon RX 7900XT ma 20 GB pamięci GDDR6 20 Gbps (przepustowość 800 GB/s) i aktywne 84 jednostki CU (5376 procesorów strumieniowych), a wskaźnik TDP wynosi 300W. Radeon RX 7900 XTX ma 24 GB pamięci GDDR6 20 Gbps (przepustowość 960 GB/s) i aktywne wszystkie 96 jednostek CU (6144 procesory strumieniowe), a wskaźnik TDP to 355W. Obie karty mają system chłodzenia z trzema wentylatorami zajmujący 2,5-slota miejsca w obudowie.

Bez RayTracingu Radeon RX 7900XT oferuje około 20 procent, a Radeon RX 7900 XTX o około 40 procent wyższą wydajność, niż poprzedni Radeon RX 6900 XT. To pozwala karcie Radeon RX 7900 XTX oferować wydajność porównywalną z GeForce RTX 4080. Biorąc pod uwagę nową architekturę, nowy 5nm proces litograficzny, czy też o 50 procent szerszą magistralę pamięci, uzyskany przez AMD wzrost wydajności względem poprzedniej generacji można ocenić jako niski, wręcz rozczarowujący (na marginesie premiery pojawiły się też nieoficjalne doniesienia, że architektura RDNA 3 zawiera błędy, które obniżają jej wydajność).

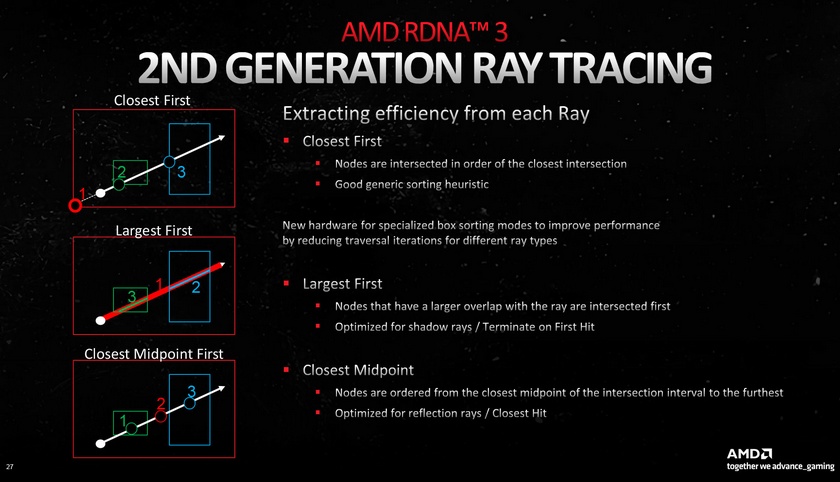

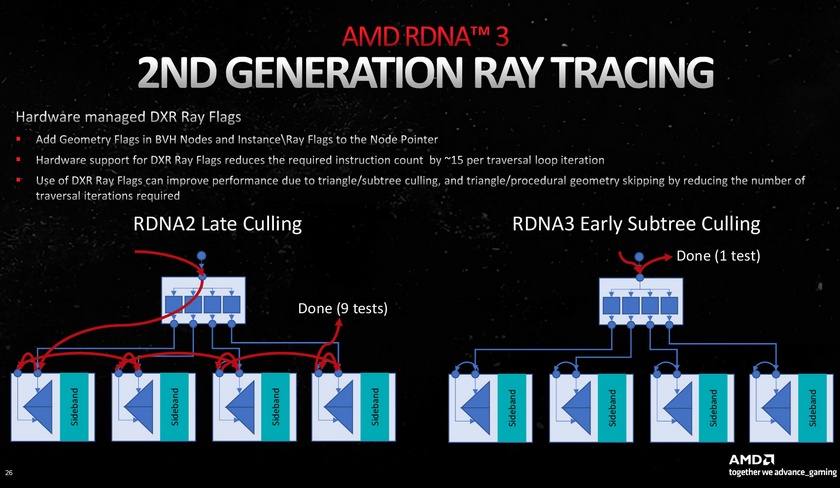

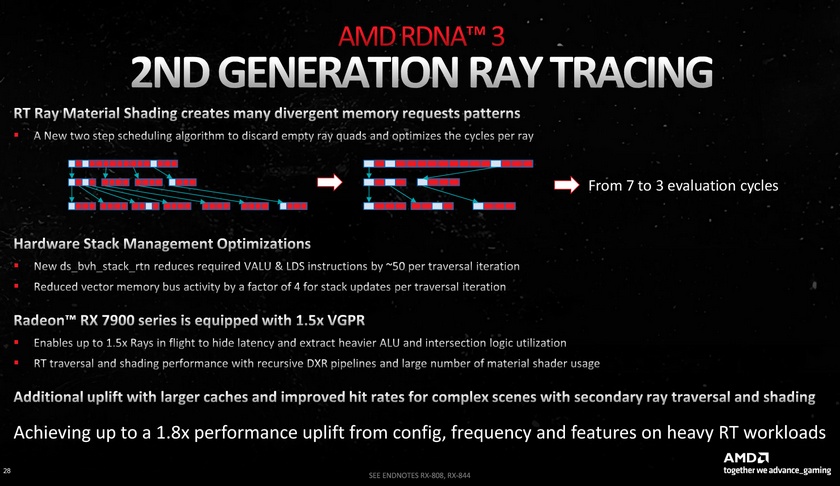

Po włączeniu RayTracingu Radeon RX 7900XT wypada około 35 procent, a Radeon RX 7900 XTX o około 60 procent lepiej niż starszy Radeon RX 6900 XT, jednak to nie wystarcza na konkurowanie z GeForce RTX 4080, a tylko z kartami Nvidia poprzedniej generacji - Radeon RX 7900 XT w RayTracingu oferuje wydajność zbliżoną do GeForce RTX 3080, a Radeon RX 7900 XTX do GeForce RTX 3090 Ti, i około 20-30 procent niższą niż GeForce RTX 4080.

Zaletą jest jednak cena - karty wyceniono na 899 USD i 999 USD, a sugerowana cena w Polsce to 4999 zł brutto za kartę Radeon RX 7900 XT i 5599 zł brutto za kartę Radeon RX 7900 XTX. GeForce RTX 4080 jest około 1500-2000 złotych droższy.

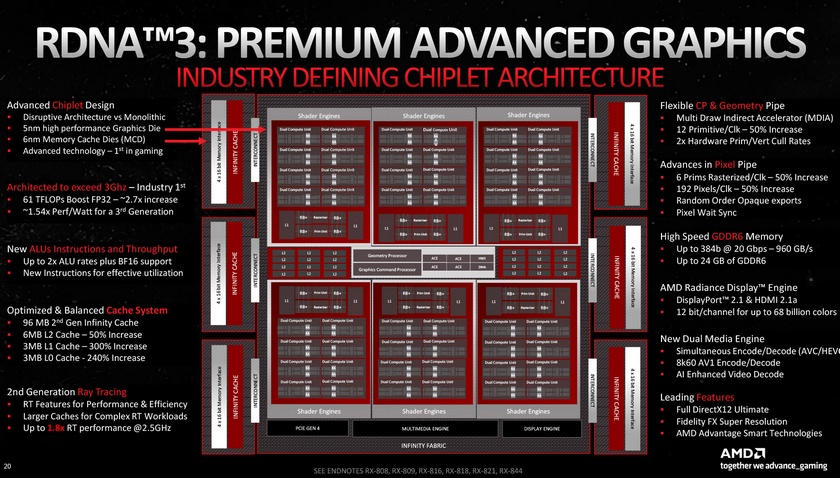

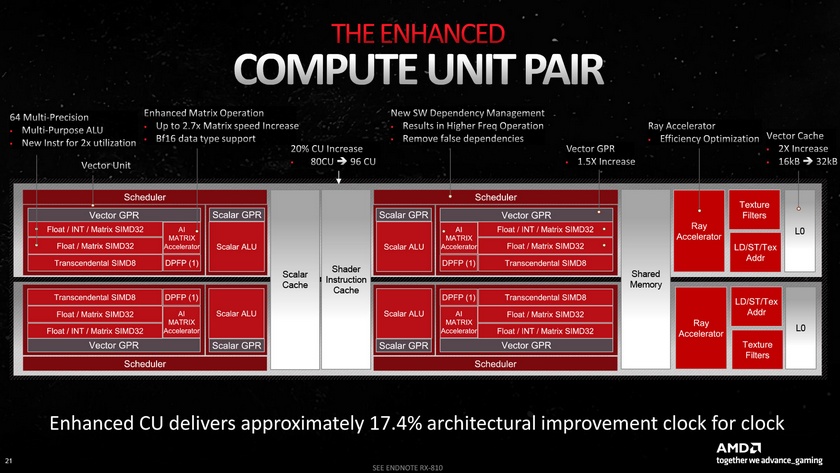

Na koniec warto przytoczyć więcej szczegółów technicznych. Chip Navi 31 zawiera 96 bloków CU (Compute Units) z łączenie 6144 procesorami strumieniowymi, 96 jednostek RT, 384 jednostki TMU i 192 jednostki ROP. W porównaniu do Navi 21 (karty Radeon RX 6900) w liczba bloków CU (Compute Units) została zwiększona z 80 do 96, liczba jednostek RT z 80 do 96, liczba jednostek TMU wzrosła z 320 do 384, liczba jednostek ROP wzrosła ze 128 do 192, a szerokość magistrali pamięci z 256 do 384-bitów.

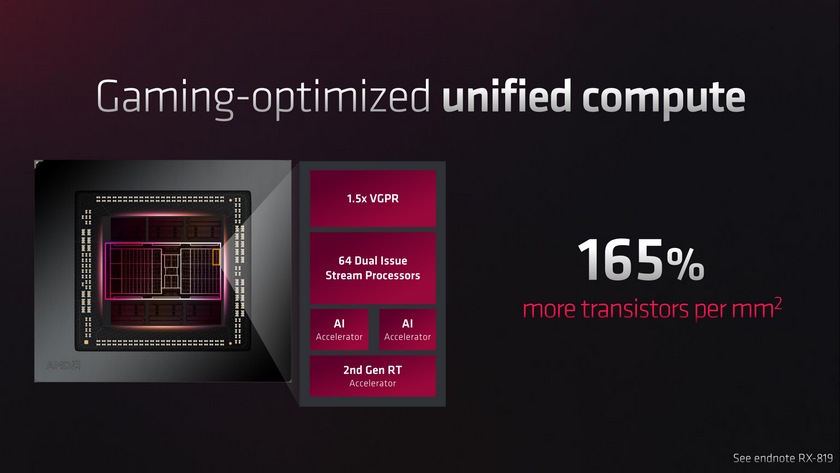

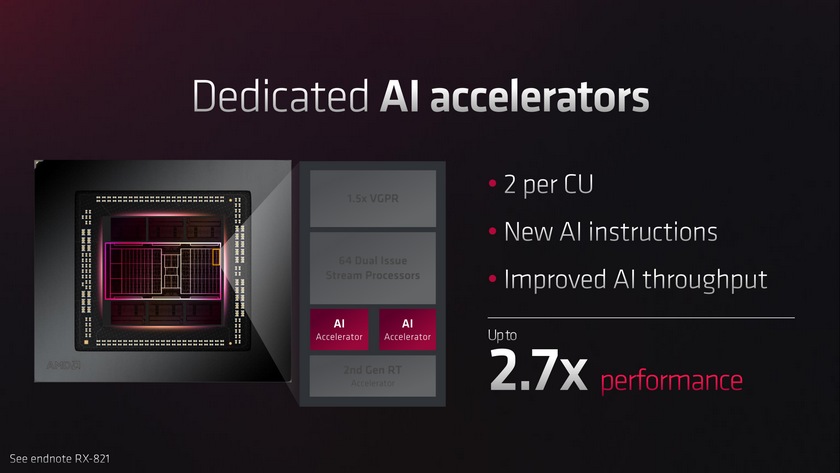

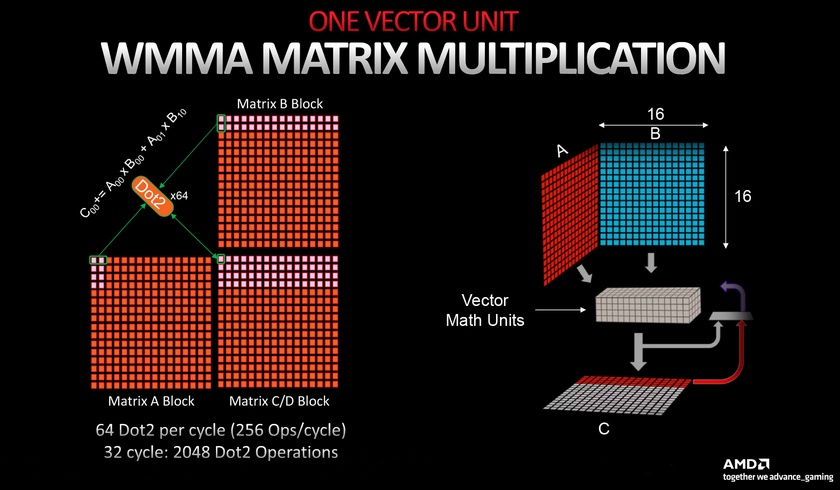

Poza zwiększeniem liczby jednostek, w RDNA 3 znajduje się tez sporo innych zmian. Dodano nowe dedykowane jednostki nazywane AI Accelerator, które służą do wspierania obliczeń związanych z uczeniem maszynowym i sztuczną inteligencją. Znacznie ulepszone zostały jednostki odpowiedzialne za obliczenia związane z RayTracingiem (ich liczba wzrosła o 20 procent, ale wydajność karty w trybie RT o około 60 procent). Szczegóły nowych rozwiązań AMD prezentuje na niżej widocznych slajdach.

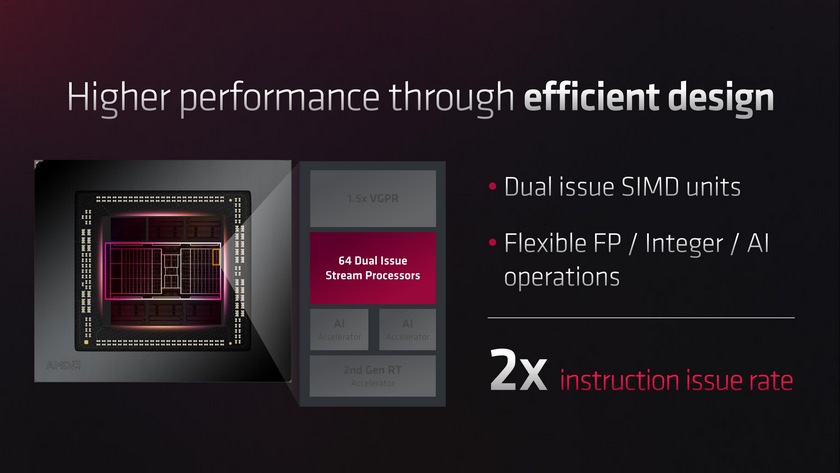

W architekturze RDNA 3 przebudowano też bloki CU wraz ze znajdującymi się w nich procesorami strumieniowymi. Liczba procesorów strumieniowych przypadających na blok CU wynosi nadal 64, ale w określonych sytuacjach potrafią one przetwarzać nie jedną, ale dwie instrukcje w jednym cyklu zegara, co w części obliczeń odpowiada temu, jakby liczba procesorów strumieniowych wynosiła 128. Poza tym o 50 procent powiększono rejestry, a dwukrotnie pamięci podręczne L0 i L1, które znajdują się w każdym bloku CU. Na każdy blok CU przypadają też dwie nowe jednostki AI Accelerator.

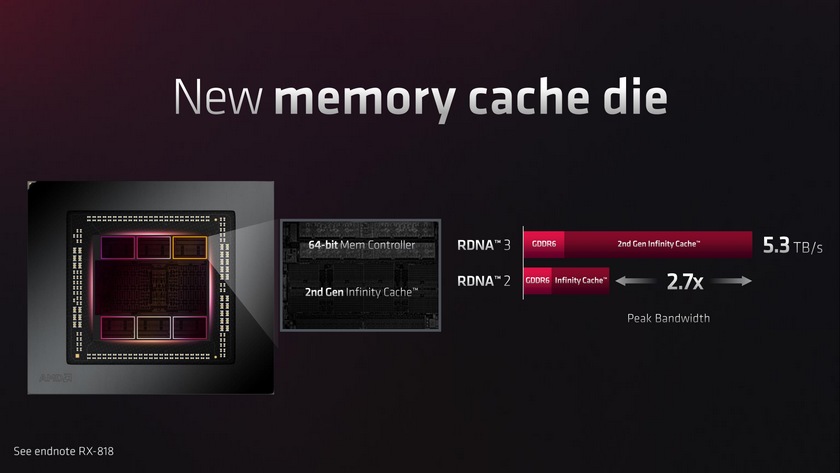

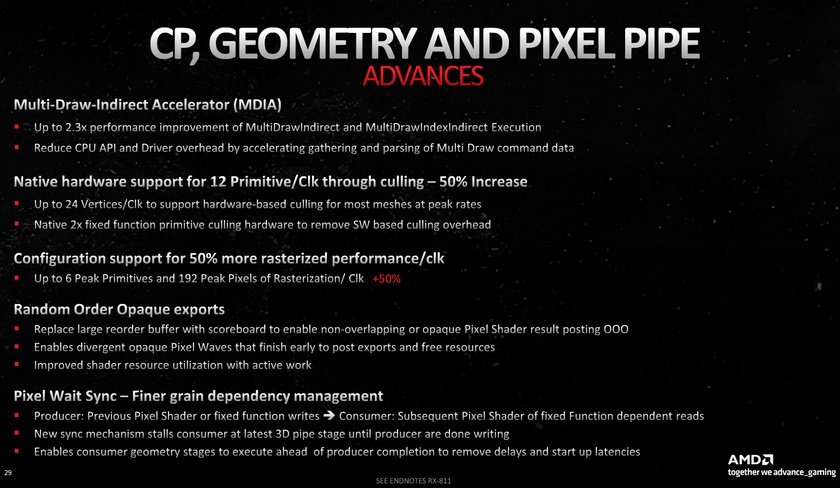

W jednostkach odpowiedzialnych za przetwarzanie pixeli liczba możliwych do przetworzenia operacji i pixeli w jednym cyklu zegara została zwiększona o 50 procent, a dodatkowo dodano tam pewne elementy wykonywania operacji poza kolejnością. Jednostki wykonujące obliczenia związane z geometrią mają do 50% zwiększoną wydajność i obsługują nowe rozwiązanie Multi Draw Indirect Accelerator (MDIA), dzięki któremu specyficzne operacje DrawInstancedIndirect w API takich jak Vulkan i OpenGL mogą być wykonywane równocześnie. Zmiany objęły też pamięć Infinity Cache - ma ona mniejszą pojemność 96 MB, zamiast 128 MB. W zamian nowa pamięć Infinity Cache ma mieć dwukrotnie wyższą szczytową przepustowość.

Kolejną ze zmian jest oddzielne taktowanie jednostek CU - pracują one z zegarem o około 200 MHz niższym, niż pozostała część układu scalonego. Zdaniem AMD pozwala to na redukcję zużycia energii do 25 procent, a spadek wydajności jest znacznie niższy niż uzyskane zmniejszenie poboru energii. Warto przypomnieć, że takie rozwiązanie (inne taktowanie shaderów, inne pozostałej części GPU) stosowała kilkanaście lat temu Nvidia, ale wycofała się z tego w 2012 roku wraz z debiutem serii Kepler (GeForce RTX 680), tłumacząc to tym, że utrzymywanie podwójnych obwodów obwodów taktujących i zasilających zwiększa zużycie energii i zabiera tranzystory.

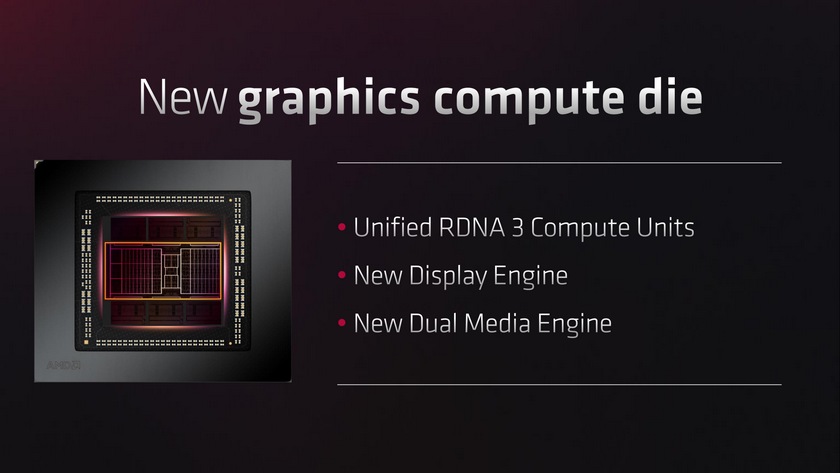

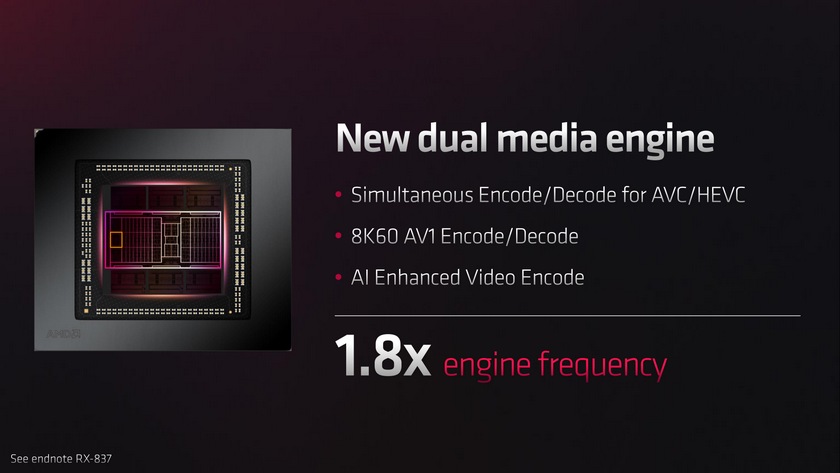

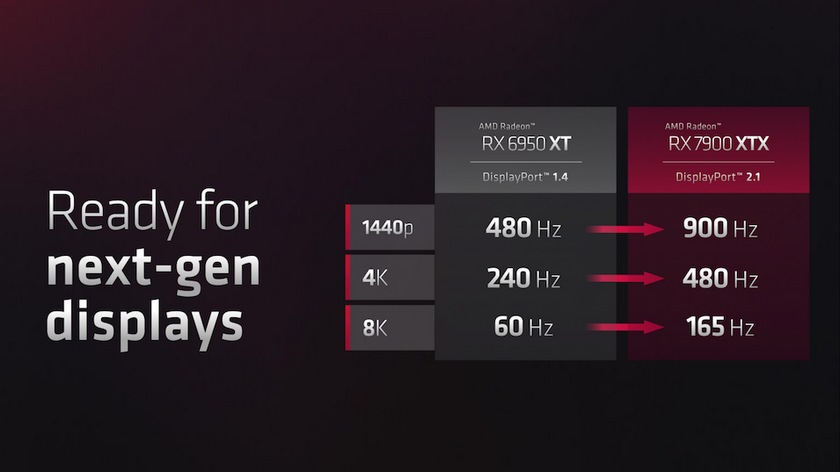

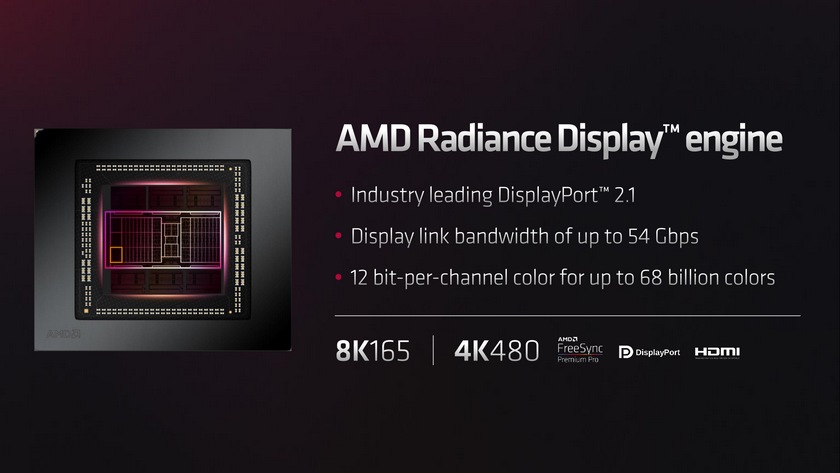

Architektura RDNA 3 przynosi też pełną obsługę DisplayPort 2.1 i nowy silnik obsługujący monitory. Wspiera on 12-bitową głębię koloru na kanał, oraz wysokie częstotliwości odświeżania - do 480 Hz dla ekranów o rozdzielczości 4K i do 165 Hz dla ekranów o rozdzielczości 8K. Jednocześnie usprawniono też jednostkę obsługi mediów, która jest teraz podwójna i potrafi w jednym czasie sprzętowo akcelerować np. równolegle dekodowanie i enkodowania materiału wideo AVC/HEVC.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- Wydajność (autor: Marek1981 | data: 12/12/22 | godz.: 20:11)

Teraz to około 4080 a za 3lata to już pewnie poziom 4090, tak już jest z AMD

- przekombinowali (autor: Shark20 | data: 12/12/22 | godz.: 20:58)

za dużo zmian na raz. Nowe bajery zajęły dużo tranzystorów i zwiększyły pobór energii. W efekcie musieli ratować TDP i poświęcić wydajność. Już w kwietniu pojawiły się informacje, o obcięciu specyfikacji Navi 31 - zamiast 120 bloków SP (7680 procesorów strumieniowych) obcięli do 96 SP (6144 procesory strumieniowe). Do tego taktowania musieli dać dość niskie, tylko niewiele wyższe niż 6900 XT / 6950 XT, i jeszcze dodatkowo obniżyć taktowanie shaderów o 100-200 MHz względem reszty GPU.

A mogli po prostu wziąć Navi 21, zwiększyć wszystkiego o 50-60% (120-128 bloków SP, 7680-8192 procesorów strumieniowych), a ze zmian to dodać tylko te nowe lepsze jednostki RT i nowy silnik mediów + obsługę DisplayPort 2.1 I byłby chip 5nm mający ok 40 mld tranzystorów, około 400mm2, który mógłby być taktowany wysoko. Efekt końcowy byłby lepszy, pewnie +70-80% wydajności względem 6900 XT

- i komenatrz z zagranicy (autor: Shark20 | data: 12/12/22 | godz.: 21:10)

z którym się zgadzam "Navi 31 is ~35% faster than Navi 21, which is close to the uplift from Pascal to Turing, despite the latter uplift being done on the same node and adding RT hardware. Needless to say, we expected much more.."

- Shark20 (autor: Markizy | data: 12/12/22 | godz.: 21:34)

przekombinowali bo zbyt ambitne założenia chcieli drożyć. Myśle że największym problem jest obecnie infinity cache którego jest mniej niż w poprzedniku a miało być go więcej. Do tego

https://www.techpowerup.com/...n-rx-7900-xtx.c3941

https://www.techpowerup.com/...on-rx-6900-xt.c3481

zakładam że nie uzyskali pełnej prędkości przy podwójnej pojemności wiec obcięli ją o połowę. Odpowiedź na to pytanie przyniesie navi33 który będzie monolitem. Ponadto sama przebudowa organizacji wewnętrznej pochłonęła dużą ilość tranzystorów nie zwiększając wydajności obliczeniowej znacząco.

- @ up (autor: Shark20 | data: 12/12/22 | godz.: 21:54)

"przebudowa organizacji wewnętrznej pochłonęła dużą ilość tranzystorów nie zwiększając wydajności obliczeniowej znacząco."

Zgadzam się, to było zbędne. Navi 31 to powinno być Navi 21 powiększone w całości o 50%, z nowymi jednostkami RT, i puszczone na wysokich taktowaniach.

- a teraz niech ratują tyłek (autor: Shark20 | data: 12/12/22 | godz.: 22:01)

i robią to powiększone o 50% Navi 21 z lepszymi jednostkami RT w TSMC 4nm, z debiutem w 3. kwartale 2023 roku jako Radeon RX 8900 XT. A RDNA 3 w międzyczasie trzeba poprawić (cofnąć się trochę, zmniejszyć zużycie tranzystorów i energii), przenieść do 3nm i na koniec 2024 roku wydać jako seria Radeon RX 9900 XT.

- Shark20 (autor: Markizy | data: 12/12/22 | godz.: 22:04)

Jakiś zamysł był aby poprawić rozwój w tą stronę, jednak pierwotne plany pewnie nie uwzględniały rozwoju RT dlatego ulepszano to niekoniecznie w najlepszy sposób zaniedbując pozostała cześć.

Obecnie przewiduje że w przeciągu 6 miesięcy usłyszymy o refreshu kart serii 7000 jako 7x50 z dwukrotnie większą ilością pamięci infinity cache. Nawet nvidia rozbudowała wewnętrzny system pamięci znacznie

https://www.techpowerup.com/...orce-rtx-3080.c3621

https://www.techpowerup.com/...orce-rtx-4080.c3888

natomiast amd ilość pamięci zredukowała.

- poniżej oczekiwań (autor: Zbyszek.J | data: 12/12/22 | godz.: 23:14)

po prezentacji z 3 listopada spodziewałem się karty o ~60% bardziej wydajnej niż RX 6900 XT, takiej o 10% wolniejszej niż GeForce RTX 4090, a w RT lekko poniżej 4080. A jest wyraźnie słabiej

- Szkoda trochę (autor: ziemowit | data: 13/12/22 | godz.: 10:15)

że Navi 31 nie jest w 4nm.

Tu może są te brakujące 10-15% wydajności więcej.

Czyli większy skok wydajności był RDNA1->RDNA2, niż RDNA2->RDNA3

- @9. (autor: Mariosti | data: 13/12/22 | godz.: 12:21)

Ale pomijacie zupełnie kluczową kwestię tutaj, że uzysk tych układów wzrósł niesamowicie dzięki nowej architekturze.

To oznacza że amd będzie mogło cenowo zapędzić nvidię do grobu bez żadnego problemu i wciąż przyzwoicie zarabiać i mieć duży wolumen produkcji bez konkurowania z apple i nvidią o moce produkcyjne w naj naj naj nowszej wersji procesu w tsmc.

Nie wiem o co wam chodzi z efektywnością energetyczną ale karta jest bardzo blisko 4080, bo przecież XTX jest ~8-10% wydajniejszy od niego, a zużywa minimalnie więcej energii, także czego tutaj się spodziewać? Że amd korzystając z troszkę starszego procesu miało mieć bardziej efektywne GPU niż 4080? (o 4090 nie wspominam bo tam oczywiście nikt nie patrzył na efektywność energetyczną).

Karta wygląda super i na start dali takie a nie inne ceny, podcinające nvidie spokojnie o 20% względem wydajności, bo i tak będą na nich dobrze zarabiać.

Nvidia zacznie robić zaraz nerwowe ruchy, a AMD zapewne będzie mogło XTX'a bez problemu sprzedawać za 600-700$ z przyzwoitym zyskiem, gdzie 4080 pewnie już mogłoby być wtedy na granicy opłacalności i jak to potem przełoży się na raport finansowy nvidii chyba wiadomo i będzie bardzo klarowne która architektura była jednak lepsza.

- widzę, że nasze Janusze (autor: bajbusek | data: 13/12/22 | godz.: 14:58)

wyskoczą z ceną 5999 za referenta :D

Na X-Kom za 5799 ale pewnie bedzie jak z RTX 4090 - niedostępna (place holder)

- @10. (autor: pwil2 | data: 13/12/22 | godz.: 16:19)

Dokładnie tak. Rewolucja jest czymś na wzór chipletowych Ryzenów. Może i w tym momencie zysk nie jest ogromny, ale dzięki tej architekturze będą mogli przenosić moduły na niższy proces i ulepszać je niezależnie od siebie.

- o czym wy bredzicie (autor: pawel1207 | data: 13/12/22 | godz.: 19:01)

po waczeniu rt wydajnosc leci na pysk przy wlaczonym GI chocby w quake rtx to pokaz slajdow macie :D o ile ta karta nie bedzie mocno tansza od 4080 to zadna konkurencja o dostepnosci nie wspominajac ...:D na dodatek chiplety ktorymi tak sie podniecacie to zysk dla producenta a problem dla konsumenta bo amd nie bedzie obnizalo ceny tylko zwiaekszy marze :D a tak konstrukcja zwieksza opuznienia .

- Mariosti (autor: Markizy | data: 13/12/22 | godz.: 21:20)

a jakieś informacje na poparcie tej tezy? To że mają więcej układów sprawnych to plus, ale minus muszą więcej układów zamontować na płytce co podnosi z powrotem cenę.

Wydajność na W ma jednak lepszą RTX4080, dobrze jest z RT że to poziom 3090/3090ti wiec wstydu nie ma. https://www.techpowerup.com/...-xtx-tuf-oc/38.html

Nvidia nie musi robić żadnych ruchów, wielu klientów nie bierze pod uwagę w ogóle amd, wiec mogą spokojnie olewać klienta przez dalsze dwie-trzy generacje. Czyli do czasu kiedy potencjalnie amd możę mieć od od dłuższego czasu lepszy produkt.

@pawel1207

czyli karty typu rtx3090/3090ti nigdy nie były grywalne z RT nagle? Poważnie cudów nie ma ale jest znacząco lepiej niż było. A sama technologia to przerost formy nad treścią.

https://www.techpowerup.com/...-xtx-tuf-oc/34.html

- @10. (autor: PiotrexP | data: 13/12/22 | godz.: 23:06)

"AMD zapewne będzie mogło XTX'a bez problemu sprzedawać za 600-700$ z przyzwoitym zyskiem" To dlaczego my mamy za to płacić 1000$ ?

- Nvidia bała się RDNA3 (autor: Zbyszek.J | data: 13/12/22 | godz.: 23:19)

i nie potrzebnie. Mogli dać RTX 4090 z TDP 350W i wolniejszy o 3-4%, i RTX 4080 z TDP 285W, wolniejszy o 2-3%. AMD się wyłożyło na RDNA 3. Nie dało się zrobić gorzej niż RDNA 2 przeniesione do 5nm i powiększone o 50% plus wyższe taktowania. Ale jednak przyszło RDNA3 i okazuje się, że jednak można było zrobić gorzej niż powiększoną o 50% i szybciej taktowaną kartę Radeon 6900 XT w 5nm...

AMD zawaliło, że nie mieli dwóch równoległych projektów RDNA3 - ambitny (ten co zadebiutował) i ostrożny, czyli takie RDNA2+ w 5nm. Mogli by sobie w lecie wybrać co wpuszczają na rynek

- Markizy (autor: pawel1207 | data: 13/12/22 | godz.: 23:24)

3090 te karty maja ponad rok tu mamy karte nowa a wydajnosc 3090 jest bardzo zadka nie jest to norma masz quake rtx jak p przyklad po prostu przy obsludze niektorych funkcji tu mamy global ilumination czy jak mu tam nagle mam straszny spadek wydajnosci rt a tu mamy karte z przelomu 2022/23 :D it to top topow gdzyby nie rt to byla by dobra karta ale glosna jak diabli wydajnosc energetyczna slaba biorac pod uwage jej problemy i cene i dostepnosc karta jest droga w stosunku do mozliwosci jakie daje po prostu to byla by swietna karta gdyby wyszla rok temu jesli jescze 4080 stanieje to bedzie to kompletnie nieoplacalny sprzet ... nie oszukjmy sie rasteryzacja nie ma opbecnie znaczenia bo poprzednia generacja w samej rasteryzacji pozwala grac w ponad 60 klatakch w 4k w popularnym qhd .. po co wywalac kase na to cos skoro rt tutaj lezy i kwiczy i w momencie premiery jego wydajnosc jest nierowna i slaba szzerze jesli nie potrzebujesz rt to lepiej kupic poprzednia generacje nawet od amd bo o tak pograsz na tym bez rt bezproblemu w 4k a moze sie okazac ze poprzednai generacja od amd jest po prostu znacznie tansza a wydajnosc w rasteryzacji bedzie bardziej niz dobra :D .... po prostu nowe radeony to karty bez przyszlosci bo ilosc elemetow rt w grach bedzie sie zwiekszac a nie zminejszac i tu obawiam sie ze nowe radki szybko polegna ...ktos kto to kupi bedzie sobie plul w brode po prostu ... no chyba ze cena bedzie naprawde bardzo dobra to i karta wtedy zyska ale na obecna chwile to jest wtopa ... innym probleme jest to ze obecnie najwieksszy i najszybszy rozwoj notujemy wlasnie w rt nie rasteryzacji to raytracing przyspierza po 70 % i wiecej itd.. to oznacza wiecej elementow raytracingu i bedzie wykorzytywane wiecej efektow z rt chocby GI moze da sie skonfigurowac moze nie ale jesli rt bedzie wymagany to bedzie to slab karta wydajnosc 3090 jest bardzo zadka w wieszosci to okolice 3070/80 ktore topen tropow nie sa a tu mamy topowa karte za topowe pieniadze...

- @ pawel1207 (autor: Zbyszek.J | data: 13/12/22 | godz.: 23:47)

a jakieś przecinki, kropki, wielkie litery dałbyś radę wstawić do swojego wpisu? Bo teraz tego nie da się czytać. Chociaż poszczególne zdania oddziel kropkami.

Bo wiesz ja też do Ciebie mogę pisac bez spacji i kropek tak ze bedzie trudno to odczytac a jutro zimno minus dziesiec i snieg a w piatek plus 5 a w sobote premiera nowego telefonu a w ogole nowy radeon jest taki sobie a nvidia taka dobra w raytracingu a core 13 generacji jest lepsze niz core 12 generacji lecz slabsze niz ryzen 8000 ktory jest lepszy niz ryze n 7000 jednak plyty na am5 sa drogie te na lga1700 sa tansze i mozna wsadzic ddr4 ale juz core 14 generacji bedzie pozwalac tylko na ddr5 a tak w ogole pawel1207 to gdzie mieszkasz i do jakiej szkoly chodziles?

- @14. (autor: Mariosti | data: 14/12/22 | godz.: 01:36)

Przecież 7900XTX jest ~8% wydajniejszy od 4080, a jednocześnie średnio ciągnie tylko około 10W więcej, czyli niecałe 3%. Także ewidentnie 7900XTX ma lepszą wydajność na watt od 4080 pomimo iż RTX jest w zrobiony w niższym procesie, także jest to ewidentnie ogromna różnica na korzyść AMD (byłyby porównywalne gdyby RTX miał kilkadziesiąt % lepszy perf/Watt wg TSMC).

Koszt kraty graficznej jest znacznie niższy bo przez uzysk same IC są znacznie tańsze, a te stanowią zdecydowaną większość kosztu całej karty graficznej.

Koszt odpowiedniego substratu i zlutowania/sklejenia tego do kupy jest wręcz pomijalny już obecnie (był istotny gdy AMD zaczynało te technologie wdrażać przy FuryX, ale już coraz mniej później w Ryzenach z chipletami, obecnie to jest już dobrze oklepana technologia dla AMD, żadna nowość).

Co do innych kosztów to porównaj sobie pcb 7900xt/xtx vs 4080 nawet (nie wspominam o 4090 bo to jest masakra). PCB AMD jest znacznie prostsze i ma znacznie mniej komponentów.

@15.

Musi nvidia najpierw zejść z ceny. Na chwilę obecną AMD ma bardziej opłacalne swoje karty, owszem nie są za darmo, nie są hiper okazjami, ale i głupie byłoby z ich strony aby je jakoś ekstremalnie nisko wyceniać w sytuacji w której rok temu nie dało się kupić żadnej karty graficznej w sensownej cenie...

- @19 (autor: bajbusek | data: 14/12/22 | godz.: 10:08)

w czystej rasteryzacji jest minimalnie szybsza ale to zależy od doboru gier ... z youtube wynika, ze sa tytuly gdzie RTX jest wydajniejszy, przynajmniej w 4K.

W RT ssie pałkę ... w zależności od ilości zastosowanych technologii RT spada do RTX 3080 (patrz CP2077), ktorego mozna kupic za 3000

- ... (autor: power | data: 14/12/22 | godz.: 11:46)

https://www.newegg.com/...%20601410971&Order=1

Wszystkie karty sprzedane (podobnie jest w innych sklepach), a ludzie mowili, ze nikt ich nie kupi. :)

- Zbyszek.J (autor: pawel1207 | data: 14/12/22 | godz.: 15:12)

szkola w usa puzniej w uk no bardziej szkocji :D mieszkalem w usa uk chinach japoni ukrainie i rosji i teraz w uk niestety, brak przecinkow mi nie przeszkadza wyksztalcenie to podstwowe "srednie" studia plus jakies tam rozne kursy i szkolenia brak przecinkow i kropek zupelnie mi nie przeszkadza wiec sie nie krepuj :D pisz bez .. co do reszty to sa normalne dywagacje karzdego po to prowadzi sie dyskusje aby dobrac najbardziej optymalne rozwiazanie pod siebie . po to sa wlasnie kometarze czego fani zwlaszcza amd nie rozumieja z drugiej strony ja tez nie rozumiem jak mozna byc fanem nv czy amd :D przecierz to chore ...

- @20. (autor: Mariosti | data: 14/12/22 | godz.: 15:38)

Moje oczy widziały większość recenzji na yt i wynika z nich właśnie +8% na korzyść XTX.

To o czym mówisz to właśnie wybiórcze gry, specyficzna rozdzielczość i branie do średniej np jednej gry z którą jest problem i zaniża średnie.

RT ssie pałkę i dlatego nie warto tego uruchamiać nawet na 4090, bo po co ci minimalnie lepsze odbicia skoro nawet na karcie za 11 tys zł będziesz musiał odpalić mydło 3.0 aby sobie pograć na telewizorze 4k?

To mniej więcej tak jakbyś czepiał się że auta osobowe od razu toną po wjechaniu do wody, a dobre KTO mogą pływać.

Równie przydatne argumenty jak jedziesz sobie asfaltową drogą...

- Mariosti (autor: Markizy | data: 14/12/22 | godz.: 18:22)

według testów techpowerup 4080 jest efektywniejszy energetycznie oraz minimalnie wolniejszy (3%).

https://tpucdn.com/...oc/images/watt-per-frame.png

https://tpucdn.com/...ve-performance_3840-2160.png

Niemożna marginalizować kosztów substratu ani łączenia, pamiętaj że każdy element tego typu zwiększa prawdopodobieństwo błędu przy montażu.

Wstępnie oceniając PCB to jednak gtx4080 ma je prostsze

https://www.techpowerup.com/...ders-edition/4.html

https://www.techpowerup.com/...-rx-7900-xtx/4.html

nawet powiem więcej, pcb gtx4080 wygląd jak płytka kastrata.

W odniesieniu do gtx4090 to miałbyś racje ale nie tu

https://www.techpowerup.com/...ders-edition/4.html

ale nawet u tutaj byłaby to rzecz umowna.

Radeon ogólnie wygląda w porządku, ale cena jest dobra tylko dlatego że zieloni przesadzi.

- .... (autor: Marek1981 | data: 15/12/22 | godz.: 00:46)

Zastanawia mnie krótkowzroczność co niektórych. 1) Monolit byłby z 20-30% wydajniejszy 2) sprawność produkcji takich małych chipów może być nawet 3x (łatwość w projektowaniu, mniej odpadów i więcej zapełnionego plastra) 3) Zejście do kolejnych niższych procesów produkcji będzie obarczone większymi błędami - dłuższe wdrożenie/wyższa cena. 4) technologia RT jest w powijakach i drobne elementy w RT zabijają wydajność, cała gra to pewnie 1 klatka na 1h. 5) Co wydajności/zasadności RDNA3 możemy mówić w następnej generacji/poprawce. Pożyjemy zobaczymy

- @23 (autor: bajbusek | data: 15/12/22 | godz.: 15:56)

wszyscy uztykownicy CIENKICH GPU powtarzają tą samą mantrę "bo po co ci minimalnie lepsze odbicia skoro nawet na karcie za 11 tys zł będziesz musiał odpalić mydło 3.0 aby sobie pograć na telewizorze 4k?"

Kup porządną kartę obsługującą RT a nie wydmuszki od AMD ;)

Spraw sobie też okulary albo przestań oglądać te same slajdy AMD na youtube, nie będę się powtarzał po @24

Jak nie chcesz dodatkowych efektów w postaci RT to nikt Cię nie zmusza - najszybszą kartą w rasteryzacji jest ... nadal RTX 4090

Jak masz inne wydatki poza pecetem to kup AMD RX 7900 XTX - to na pewno lepszy wybór pod rasteryzacje niż RTX 4080 jeśli mówimy o cenie 5600 za referenta AMD.

I te wywody na temat jakie to mydlo jest przez RT bo trzeba DLSSa używać też nikogo nie interesują ... ja uzywam DLSS z ustawieniami Jakość i na 3080 Ti spokojnie wyciągam ponad 60 fps w CP2077 ... i owszem widze różnicę w graniu z RT i bez ... ale są tacy co uważają, że CS Go ma spoko grafikę :)

- @24. (autor: Mariosti | data: 15/12/22 | godz.: 23:20)

Wiesz co, to że nie znasz się na elektronice nie oznacza że musisz się tym chwalić.

To że PCB w XT i XTX jest większe niż w 4080 i 4090 nie oznacza że jest bardziej skomplikowane. Wprost przeciwnie. Widać na RTX'ach sporo wyspecjalizowanych układów scalonych które w Radeonach realizowane są za pomocą większej liczby ultra tanich prostych tranzystorów i kondensatorków.

Liczba przelotek przez pcb w RTX nieporównywalnie większa.

To wszystko konkretne koszty, zresztą trzeba by być debilem aby uznać że karta projektowana na 600W może mieć tańczą płytkę niż karta projektowana na 355W (a zasugerowałeś to jednoznacznie).

Co do recenzji no to gratuluję, 2 recenzje potwierdzają twoją teorię, 50 potwierdza fakty o których wspomniałem.

26. Weź może ASAP na ból pupy, a nie wciskaj ludziom na siłę czegoś co jest niepotrzebne, niedopracowane i przez praktyki monopolistyczne nvidii powoduje oczywiście znowu absurdalne optymalizacje pod jednego producenta gpu, w zamian za usuwanie standardowych efektów graficznych które pozwalały na uzyskanie bardzo zbliżonych efektów.

Jesteś za monopolem, to po prostu zacznij wysyłać połowę pensji co miesiąc do nvidii.

Ja preferuję konkurencję i widzę że jest masa fanatyków i płatnych trolli nvidii którzy pilnują aby czasem nie musiała zejść z absurdalnych marż (dojenia klientów jak idiotów), i aby czasem nie straciła udziałów w rynku, bo dzięki tym krzykaczom zawsze pod każdym newsem o radeonach jest 10 trolli wytykających dawniej tessalacje, sterowniki, "super nvidia włosy", a teraz RT które tradycyjnie nvidia pcha deweloperom za pośrednictwem swoich blackboxowych libek.

Ludzie opamiętajcie się, bo przez takie manie wyższości jednej korporacji nad drugą sami skazujecie się na traktowanie jak zwierzęta.

- Mariosti (autor: Markizy | data: 16/12/22 | godz.: 08:01)

chyba sobie żarty robisz albo starasz się na siłę udowodnić swoje teorie. Jakie prostsze układy stosowane przez AMD? To że mają dwa osobne układy zamiast jednego do sterowania zasilaniem gpu i ramu niewiele zmienia. Nadal są to wysoce wyspecjalizowane układy sterujące (Power Systems MP2856; Monolithic Power Systems MP2857),. Nie wspominając o różnicy 13 do 17 fazowej sekcji zasilania gpu u amd. Te proste układu służą raczej do sterowania wiatrakami czy czymś mało istotnym skoro nikt nie zwrócił na nie specjalnej uwagi. Nawet amd w swoich prezentacjach.

Ciekawe skąd wiesz ile przelotek tam się znajduje, widziałeś pliki płytek z uwzględnieniem wszystkich warstw pcb? W końcu ich PCB posiada aż 14 warstw z tego cztery o podwójnej grubości miedzi

https://www.techpowerup.com/...nroYp7KpkaJIZ5Q.jpg

o przelotkach zagrzebanych powinieneś wiedzieć. Nie można się odnieść tymi parametrami do gtx4080 bo zieloni się nie pochwalili takimi danymi. Prawdopodobnie warstw mają mniej dlatego amd uznało to za atut.

Nazywanie mnie fanem zielonych to gruba przesada. Większą sympatie posiadam do amd ale ten produkt wyszedł im przeciętnie w stosunku do rdna2, jedyne co go broni to cena, innych atutów nie posiada. Pobór energii jest do przełknięcia chociaż większy, wydajność szału nie robi, wiec taki produkt beta gdzie pewnie za kilka miesięcy będzie refresh z większym taktowaniem i wyższym poborem energii.

Inne serwisy pewnie też się mylą?

https://www.guru3d.com/...xtx_nitro_review,29.html

https://www.guru3d.com/...xtx_nitro_review,32.html

https://www.computerbase.de/...x-xt-review-test/3/

https://www.computerbase.de/...x-xt-review-test/5/

https://www.kitguru.net/...-rx-7900-xtx-review/32/

AMD wydało produkt który jest dobry, i ma adekwatną cenę i tylko tyle o nim można powiedzieć. Natomiast udziały tracą przez swoją nieprzemyślaną politykę w obrębie gpu który nie zmieniła się nic a nic od czasów gnc.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|