|

TwojePC.pl © 2001 - 2026

|

|

Środa 14 czerwca 2023 |

|

| |

|

AMD Instinct MI300x: CDNA 3, 192 GB HBM3 i 153 mld tranzystorów

Autor: Zbyszek | źródło: AMD | 22:52 |

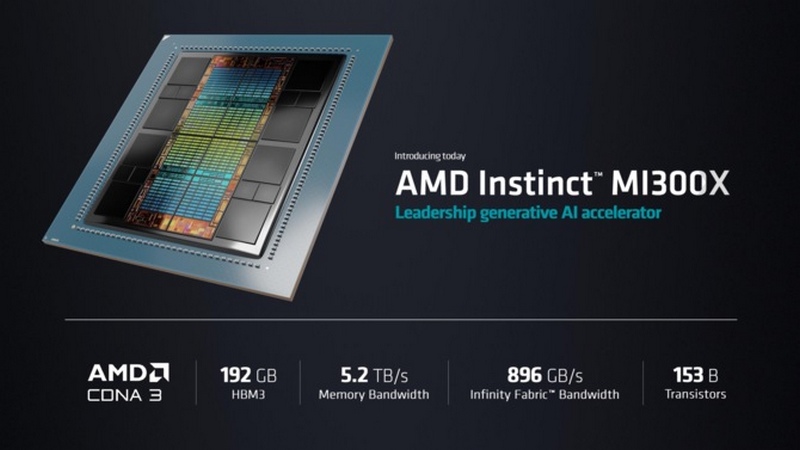

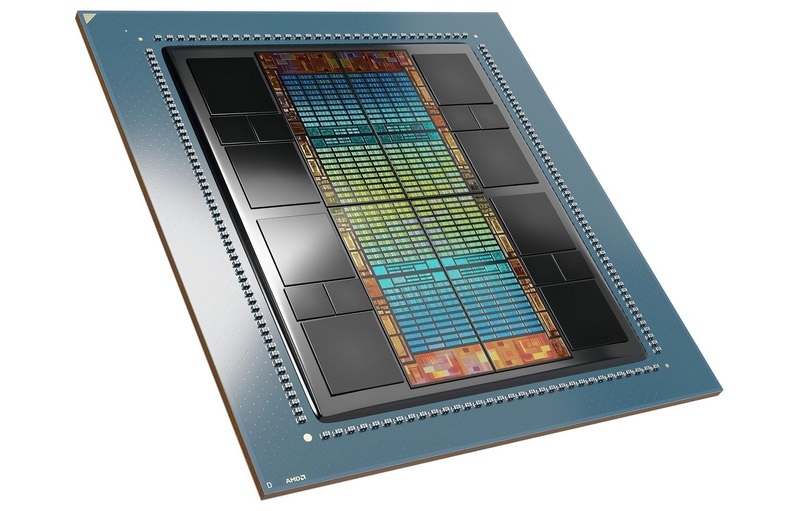

(7) |  W trakcie wczorajszej prezentacji o nazwie Data Center and AI Technology Premiere, poza nowymi procesorami serwerowymi firma AMD przedstawiła też swój najnowszy produkt dedykowany do obliczeń związanych z uczeniem maszynowym i sztuczną inteligencją. Jest to Instinct MI300x, mający konkurować z Nvidia H100. Akcelerator składa się 12 rożnych układów scalonych (tzw. chipletów) wytwarzanych w litografii 5nm lub 6nm, z których część znajduje się obok siebie, a część znajduje się nad innymi chipletami na drugiej warstwie. Instinct MI300x zawiera układ obliczeniowy typu GPU z architekturą CDNA 3 i 220 blokami CU (14080 procesorów strumieniowych), oraz 192 GB pamięci typu HBM3 o przepustowości 5,2 TB/s. W trakcie wczorajszej prezentacji o nazwie Data Center and AI Technology Premiere, poza nowymi procesorami serwerowymi firma AMD przedstawiła też swój najnowszy produkt dedykowany do obliczeń związanych z uczeniem maszynowym i sztuczną inteligencją. Jest to Instinct MI300x, mający konkurować z Nvidia H100. Akcelerator składa się 12 rożnych układów scalonych (tzw. chipletów) wytwarzanych w litografii 5nm lub 6nm, z których część znajduje się obok siebie, a część znajduje się nad innymi chipletami na drugiej warstwie. Instinct MI300x zawiera układ obliczeniowy typu GPU z architekturą CDNA 3 i 220 blokami CU (14080 procesorów strumieniowych), oraz 192 GB pamięci typu HBM3 o przepustowości 5,2 TB/s.

AMD chwali się, że MI300x oferuje ponad 2 razy większą pojemność pamięci niż Nvidia H100, a jej przepustowość jest wyższa o 60 procent. 192 GB pamięci ma pozwolić na uruchamianie nawet największych modeli obliczeniowych takich jak Falcon-40B na zaledwie jednym akceleratorze.

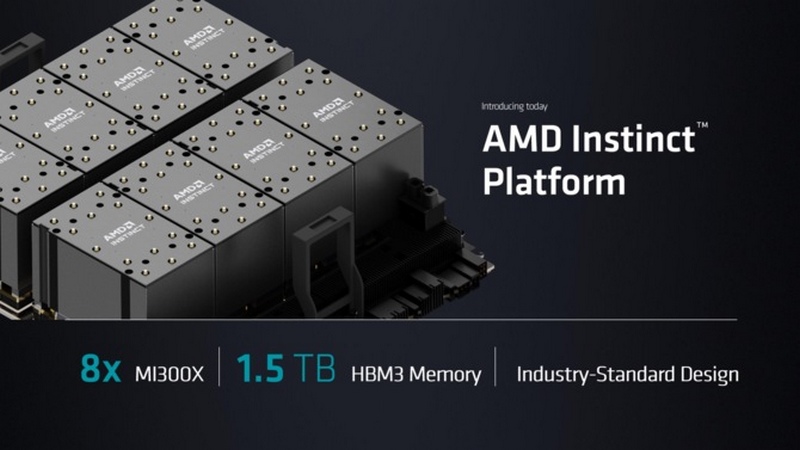

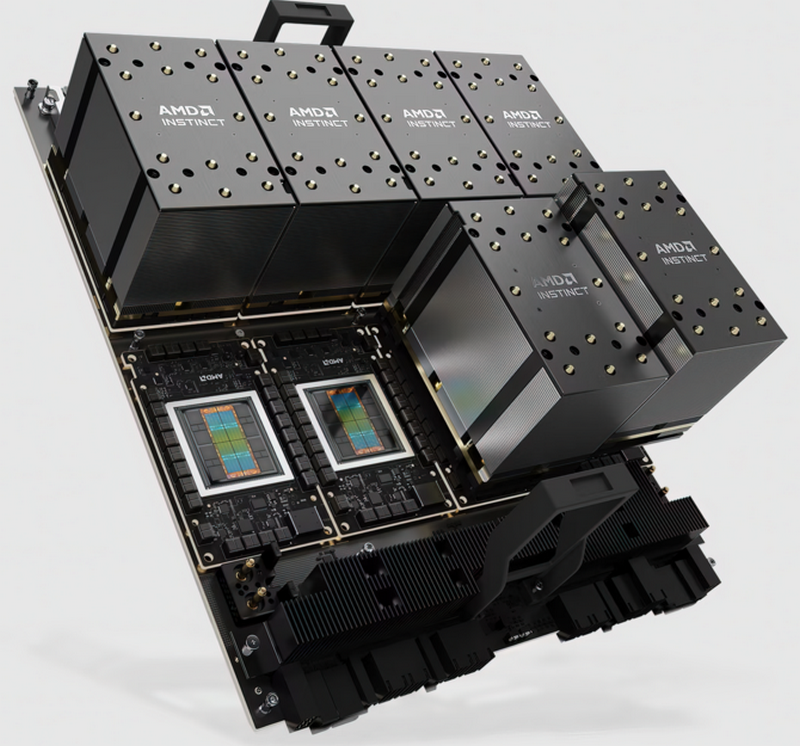

Poza pojedynczymi akceleratorami Mi300x, AMD będzie oferować gotowe urządzenia AMD Instinct Platform zawierające po 8 sztuk Mi300x, mające łącznie 1,5 TB pamięci operacyjnej HBM3. Sprzedaż rozpocznie się w 3. kwartale, a zakup i wykorzystanie Instinct MI300x oraz AMD Instinct Platform zapowiedziały już Amazon, Meta, Microsoft i Hugging Face.

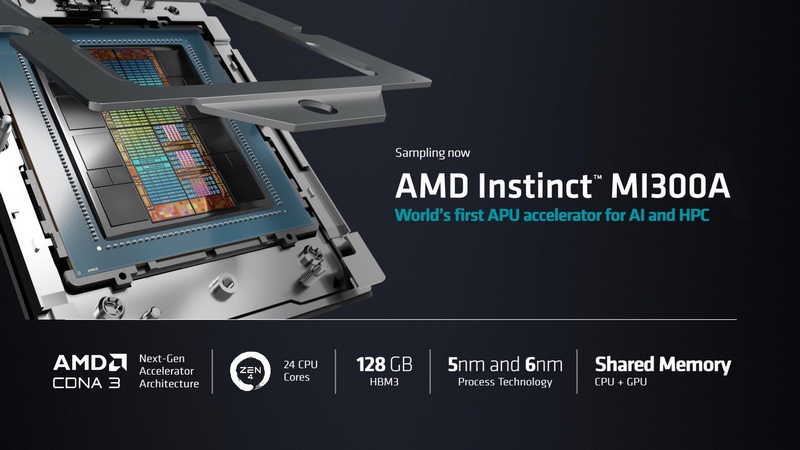

Wraz z Mi300x do sprzedaży trafi także bliźniaczy produkt o nazwie Mi300a, przeznaczony do montażu w podstawce LGA SF5, czyli zmodyfikowanej wersji podstawki SP5 procesorów EPYC 4. generacji. Mi300a ma nieco mniejszy GPU z architektura CDNA3 , ale dysponuje też 24 rdzeniami ZEN 4, oraz 128 GB pamięci HBM3, która jest współdzielona między CPU oraz GPU. Mi300a będzie mógł być stosowany w klasycznych serwerach 2U przez producentów takich jak np. HP i Dell.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- @temat (autor: Dzban | data: 16/06/23 | godz.: 14:20)

Mamy pomieszanie z poplątaniem w newsie. Mi300A to jest APU a Mi300X to GPU. Dużo błędów w tekście.

- AMD tymi dwoma modelami (autor: Mario1978 | data: 16/06/23 | godz.: 14:20)

MI300A i MI300X zrobiło Szach i Matt firmie Nvidia.

- @Dzban (autor: Zbyszek.J | data: 16/06/23 | godz.: 14:45)

dzięki, mi300x faktycznie nie ma rdzeni zen 4, a tylko mi 300a je ma. Poprawiłem.

- @02 (autor: Conan Barbarian | data: 16/06/23 | godz.: 21:44)

Po notowaniach giełdowych niestety tego nie widać, ale może w dłuższej perspektywie będzie to ...

- @up (autor: Zbyszek.J | data: 17/06/23 | godz.: 02:51)

kto nie załapał się na Nvidia H100, i teraz nie chce płacić nowej horrendalnej ceny oraz odbierać towar dopiero w lutym lub marcu, ten teraz zamówi Mi300x z dostawą w październiku. AMD ma produkt, który może sprzedać, i jak widać to poważne firmy już go zamówiły

- Nvidia już ogłosiła, że współpracuje z HYNIX (autor: Mario1978 | data: 20/06/23 | godz.: 20:59)

nad wprowadzeniem w przyszłym roku 2024 pamięci HBM3E czyli ulepszonej wersji zawartej tutaj. Tym razem przepustowość ma osiągać 8TB/s. Nvidia musi coś z tym zrobić bo sami mają problem z tymi produktami od AMD. Efektywność na Watt będzie ogromna w porównaniu z tym co mamy obecnie dostępne na rynku. Intel nie ma co szukać na chwilę obecną tutaj.

- taaaaa (autor: mirek190 | data: 21/06/23 | godz.: 20:08)

tyle ze falcona 40b mozna spokojnie uruchmic nawet na RTX 3090 ...... skanwyzowany oczywiscie bo po co to uruchamiac w pelnym fp32.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|