|

TwojePC.pl © 2001 - 2026

|

|

Wtorek 19 grudnia 2023 |

|

| |

|

Sprzeczka między prezesem Intela a wiceprezesem Nvidia na temat AI

Autor: Zbyszek | źródło: X.com / Twitter | 22:33 |

(9) |  Pat Gelsinger, od prawie 3 lat będący prezesem i dyrektorem generalnym Intela znany jest ze śmiałych, nieco kontrowersyjnych lub też przesadnie optymistycznych wypowiedzi. W jednej z nich, na początku 2022 roku stwierdził na przykład, że Intel ogląda już AMD we wstecznym lusterku, i na rynku konsumenckim AMD już nigdy nie zdoła ponownie wyprzedzić Intela. Kilka miesięcy później w innym z wywiadów stwierdził, że konkurencja między Xeonem a procesorami EPYC od AMD to jak walka odbywająca się w budce telefonicznej - ponieważ tylko na niewielkiej części rynku EPYC staje do walki z Xeonami. Odpowiedział mu wówczas były manager firmy Dell, stwierdzając, że siła obecnych procesorów Xeon jest taka, jakby chciały one walczyć nożem podczas strzelaniny. Pat Gelsinger, od prawie 3 lat będący prezesem i dyrektorem generalnym Intela znany jest ze śmiałych, nieco kontrowersyjnych lub też przesadnie optymistycznych wypowiedzi. W jednej z nich, na początku 2022 roku stwierdził na przykład, że Intel ogląda już AMD we wstecznym lusterku, i na rynku konsumenckim AMD już nigdy nie zdoła ponownie wyprzedzić Intela. Kilka miesięcy później w innym z wywiadów stwierdził, że konkurencja między Xeonem a procesorami EPYC od AMD to jak walka odbywająca się w budce telefonicznej - ponieważ tylko na niewielkiej części rynku EPYC staje do walki z Xeonami. Odpowiedział mu wówczas były manager firmy Dell, stwierdzając, że siła obecnych procesorów Xeon jest taka, jakby chciały one walczyć nożem podczas strzelaniny.

Teraz szef Intela wywołał wydaje się, że jeszcze większą kontrowersję. Podczas wydarzenia zorganizowanego przez uczelnię MIT, w dyskusji poświęconej dominacji Nvidia na rynku układów obliczeniowych dla tzw. sztucznej inteligencji Pat Gelsinger stwierdził, że Nvidia zawdzięcza tę pozycję tylko dzięki niesamowitemu szczęściu.

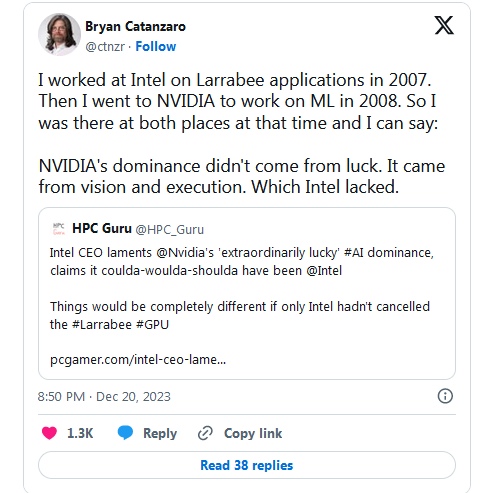

Z jego zdaniem nie zgadza się jednak wiele osób, które negują lub wręcz wyśmiewają słowa prezesa Intela na przykład w mediach społecznościowych. Zareagował na nie np. Bryan Catanzaro, obecnie młodszy wiceprezes Nvidia, w przeszłości ceniony inżynier Nvidia, a wcześniej inżynier Intela.

Stwierdził on, że będąc jeszcze inżynierem Intela pracował od 2007 roku nad projektem Larrabee, czyli GPU przeznaczonego do specyficznych obliczeń. Nvidia swoje prace nad wykorzystaniem GPU do takich obliczeń rozpoczęła w 2008 roku, więc obaj producenci zarówno Intel jak i Nvidia mieli podobną ilość czasu do osiągnięcia dominacji na rynku układów obliczeniowych dla tzw. sztucznej inteligencji. Wiceprezes Nvidia stwierdził na koniec, że Nvidia zawdzięcza swoją pozycję na tym rynku wyłącznie wizją oraz determinacją jej wdrożenia, a obu tych rzeczy zwyczajnie zabrakło Intelowi.

|

| |

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- ... (autor: power | data: 23/12/23 | godz.: 11:02)

Szefa intela ma bardzo duzo racji mowiac, ze nvidia miala szczescie.

Jak do tej pory, to nvidia podejmuje calkiem dobre decyzje.

Nvidia od lat bardzo dobrze sobie radzi na rynku GPU, ciagle sie rozwija, nie ma duzych wtop.

Oprocz szczescia dodalbym do listy jeszcze agresywny marketing (kupowanie opinii, "zachecanie" sprzedawcow prezentami) i tworzenie przyszlosciowego oprogramowania (sukces CUDA).

- power (autor: Markizy | data: 23/12/23 | godz.: 15:18)

to jedno, ale dużo zieloni dali $$$ aby tylko ich rozwiązania były wykorzystywane w programach mowa o CUDA. Faktem jest że mam odczucie że naciągali tutaj prawo ale to nie mnie oceniać.

Problem intela z larrabee był taki że od samego początku nie wiedzieli do czego tego układu użyć. Gdy po wielu pe turbacjach jakiś układ stworzyli brakło motywacji aby inwestować o oprogramowanie a rynek to olał.

Ogólnie jest zdania że uczenie maszynowe trafi do niszy jakiejś gospodarki, ale tylko przez to że okaże się że oszczędne i tanie układy nie będą mogły trafić do użytkowników domowych.

- problem (autor: pawel1207 | data: 24/12/23 | godz.: 23:52)

z intelem jest taki ze o ile nv uczy sie na bledach wzglednie szybko a u intela przyznanie sie do spieprzenia czegos trwa wieki puzniej nastepuje proba przekonania siebie i wszystkich dokola to to nie blad tlko "fiuczer" :D nastepnie dostaj po dupie od karzdego rownierz finansowo i dopiero powoli zmieniaja narracje ale fakt nv mimio wszystko miala sporo sczescia nie mniej nie da sie ukryc ze sam temu sczesciu pomagala jak mozna .. np. larrabee w zalorzeniach i koncepcji wygladal swietnie ale wykonanie kulalo i to mocno nastepnie przerabiali to 10 razy z podobnym skutkiem i efektami koiniec koncow jak sprzet zostal poprawiony i stal sie nawet sensownym rozwiazaniem intelina zarzadala za nigo majatku . ewidentnie nie chcieli tego ciagnac i rozwijac bonie mieli na to takiego rynku jak sie spodziwali nv . poszla inna droga wpompowala mase srodkow aby stworzyc i wypracowac rynek dla ich rozwiazan czy to dla rynku pro czy dla konsumentow to byla kampania gdzie nagle wszystko urzywalo "cuda" i akceleracji przez karty graficzne dokumentacja wsparcie caly support diazlal aby implmetacja ich rozwiazan szla w miare gladko.. kiedy nv miala juz przygotowana "softwerowa infrastrukture " byla przy ai naturalnym wyborem bo ludzie dostwali srodowisko i narzedzie ktore znali ... a u intela to takzrobilismy chipa umie to i tamto a reszte ogarnijcie sobie sami :D sczerze nie znam nikogo kto majac do wyboru przy durzych projektach nv i intela wybral intela no chyba ze sprzetu potrzebowali na teraz a ten z nv byl niedostepny oczywiscie intel sie obudzil jak nv zgarnelqaa wiekszosc rynku... a teraz intel mowi ze nv miala po prostu szczescie :D no miala skoro najwiekszy potencjalny konkurent kompletnie olal temat na dodatek majac naprawde fajne patenty i pomysly to tutaj szef intela nie powinim mowic o sczesciu nvidi ale o tym ze w tej kwesti intel zjebal totalnie ...

- pawel1207 (autor: Shark20 | data: 25/12/23 | godz.: 01:50)

prawie każdy wyraz napisałeś z błędem ortograficznym...

- pawel1207 (autor: Markizy | data: 25/12/23 | godz.: 10:00)

ponosi ciebie że zieloni uczą się na błędach. Physix umarł na ich życzenie a g-sync też przymiera, nikt poza entuzjastami już nie patrzy na ten moduł. Dobrze się trzyma samo CUDA, DSLL też trochę chybiony pomysł, teraz programiści jeszcze bardziej olewają optymalizację. Natomiast RT służy głównie do zrobienia błyszczącego świata a nie prawdziwej grafiki.

- @Markizy (autor: power | data: 25/12/23 | godz.: 13:16)

Nie sadze ze dodawanie CUDA do oprogramowania bylo podyktowane lapowkami.

Po co nvidia mialaby placic lapowki, jezeli AMD na poczatku nie mialo czym konkurowac w obliczeniach, bo nie bylo zadnego softu od AMD?

AMD dosc pozno zaczelo tworzyc oprogramowanie do obliczen.

A kolejny problem to brak natywnego wsparcia Radeonow w oprogramowaniu.

Trzeba przyznac, ze nvidia jednak miala szczescie, gdy kupila odpowiednie firmy.

Na przyklad zakupy firm zwiazanych z obliczeniami takie jak jak Ageia (tworcy Physx) mocno zaprocentowalo.

- power (autor: Markizy | data: 25/12/23 | godz.: 22:26)

płacili aby z integrować ich oprogramowanie ze swoim. To było na początku aby zachęcić do rozwoju. A kiedy pojawiło się openCL to aby nie integrować tego zamiast CUDA albo obok.

Nie wiem czy finalnie zaprocentował zakup ageia jeśli karty graficzne nie wspomagają obliczeń fizyki. O ile mi wiadomo physx jest w UE4, piątka dostała już inny. Ostatnie demo technologiczne z fizyką w tle dotyczyło pascla.

- Jeszcze raz przypominam (autor: pandy | data: 30/12/23 | godz.: 23:25)

że Intel zrobił swój pierwszy chip neuronowy - analogowo-cyfrowego ETANN 80170NX pod koniec lat 80 i układ ten był wykorzystywany przez wojsko do automatycznej klasyfikacji ech radarowych, ETANN był też wykorzystywany np przez korporacje naftowe do analiz zasobów geologicznych.

- Markizy (autor: pawel1207 | data: 5/01/24 | godz.: 02:38)

sliniki fizyczne nie zdechly tego prostego powodu ze silniki fizyczne ostaly wbudowane takie molochy ja unrela engine czy unity i tam sa rozwijane pojawily sie tez otwarte rozwiazania tak czy owak physix nadal jest dostepny :D gsync jest na zasadzie obecnie vrr czyli czesci specyfikacji vesa :D nic zlego w tym nie widze ale plus jest taki ze jak monitor byl ceryfikowany do pracy z gsync to calosc dzialala przywoicie w porwnaiu do fresynca ktory byl zywcem zerzniety bezposrenio z rozwiaznie ktore siedzialo w standardzie vesa od lat podobnie jak "ichne" smart memory jako czesc pcie :D:D:D tak jak czytalem o smart memory to sie niezle usmialem jak to nowosc :D wiec implementacje freesynca byly tanie i proste i najczesciej polegaly na przyklejenu naklejki a czy freesync dzialal czy nie byl o to problemem usera g sync ten bez chipa przynajmniej posprzatal troche burdel ktorego amd narobilo .. rt :D:D to podstwowy i najlepszy system oswietlenia jaki kiedykolwiek mielismy jest tak zly :D ze coraz wiecj gier go urzywa i nie pierwszwszy wykazujesz ise totalnym ignoranctwem i brakiem wiedzy na dany temat. mowiac ogulnie cuda to wrecz standard w profesjonalnym swiatku wazne ze nv ma porzadna dokumentacje swietne wsparcie w przeciwienstwie do amd ktore w tym temacie nie ma nic bo opencl bylo projektem otwartym i niezalenym od amd ba do dzisaj nim jest a supprot amd jest podobny jak do intela a mianwicie zrob najczesciej zrob to sam ... w nv jak jestes dobrym klijentem i nie mozesz rozwiazac problemu to nv potrafi w ramach supportu wyslac ludzi ktorzy beda pomagac ci w jego rozwiazaniu i nie ponosisz kosztow z tym zwiazanyc :D dlss kolejne swietnie rozwiazanie a to jak urzywaja go tworcy gier to juz nie problem NV to moze za slaba otymalizacje gier to zrzuc jescze wine a tworcow roznych jezykow programowania bo ktos daje ci narzedzia ktore wykorzystane otymalne daja swietny efekt a to ze tworcy gier nie potrafia lub nie chca ich urzyc jak nalerzy nie jest wina nv .. nie wiem dla ciebie nv to chyba nie odpowiada tylko za epidemie holery koklusz trzesienia ziemi i wybuchy wulkanow cala resztya to wina nv ... nie wiem mad tez rytracing obsluguje nie krytukujesz :D ma fsr tez nie krytykujesz w koncu ma FG tez nie krytykujesz jak to amd popsulo grafike i psuje cala branze gier.. :D no hipokryzja Level Hard.

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

|

|

|

|

|