Recenzja karty Leadtek WinFast GeForce3 TD Recenzja karty Leadtek WinFast GeForce3 TD

|

|

Lancer

Lancer

06/06/01

|

Historia nauczyła nas, że świat nie stoi w miejscu i ciągle ewoluuje. A zmienia się wszystko. Jednak nic nie rozwija się tak szybko jak szeroko pojęta informatyka. Powstają coraz to nowe programy oraz sprzęt mający je obsługiwać. Najszybciej starzeją się zapewne procesory i karty graficzne - te drugie szczególnie. Czołowy "pomysłodawca" układów graficznych nVidia (firma ta, to praktycznie zespół inżynierski, a nie producent chipów graficznych) średnio dwa razy do roku wypuszcza na rynek układ graficzny. Tak wysokie tempo sprawiło, że konkurencyjne firmy coraz mocniej zostają w tyle. Ta jednak nie ma zamiaru zwolnić i nadal pędzi do przodu. Ostatnim wyrobem tejże firmy jest procesor graficzny znany do niedawna jako NV20, a obecnie występujący pod nazwą handlową GeForce3. Jest to układ szybki, ale przede wszystkim rewolucyjny, który sprawia, że grafika renderowana przez nasz komputer jest coraz bardziej realistyczna. Właśnie w niniejszym artykule postaram się nieco przybliżyć możliwości najnowszego dziecka nVidii.

|

Układ GeForce3 miał swą premierę już ponad trzy miesiące temu, lecz dopiero od kilku tygodni możemy zobaczyć na sklepowych półkach karty graficzne z tym układem mającym niesamowite możliwości, niesamowitą wydajność i tak samo niesamowitą cenę.

Kiedy półtora roku temu nVidia wprowadziła wraz z układem GeForce256 pod strzechy sprzętowe transformacje i oświetlenie (ang. skrót T&L), wszyscy "piali" z zachwytu. Zachwycali się potencjalnymi niesamowitymi możliwościami tego rozwiązania. Mówili, że to rewolucja. Nie minęło kolejne półtora roku i okazuje się, że T&L to już przeszłość, że teraz czas na programowalny engine graficzny: nfiniteFX Engine. Cóż - takie są koleje postępu. To co wczoraj było nowością, dziś jest chlebem powszednim, a jutro odejdzie do lamusa.

Nie chcę jednak zanudzać szczegółami technicznymi układu GeForce3. Dla chcących "poziewać" przy czytaniu specyfikacji technicznej polecam artykuł mojego redakcyjnego kolegi NICR4M - GeForce3, czyli objawienie na miarę Voodoo. Ja przyjrzę się bliżej finalnemu produktowi, jakim jest karta graficzna zbudowana na tym układzie, jej możliwościami i wydajnością.

KARTA

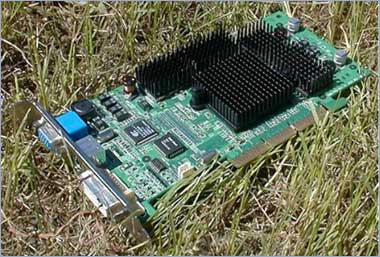

W moje ręce wpadła karta znanej firmy Leadtek o nazwie WinFast GeForce3 TD (czyżby TurboDiesel?). Karta jak większość wyrobów tej firmy jest zbudowana na referencyjnym projekcie nVidii (przy budowie karty referencyjnej pomagała firma MicroStar). W zasadzie to od orgyginalnej płytki nVidii, odróżniają Leadteka tylko srebrne radiatory i napis GeForce3.

Tak prezentuje się karta WinFast GeForce3 TD

Karta jak przystało na wyrób renomowanego producenta jest starannie wykonana. Profesjonalizmem i jakością aż kipi. Adapter posiada spory srebrny radiator z wentylatorkiem i utrzymane w podobnej tonacji radiatory na kostkach pamięci. Zbudowany na układzie GeForce3 oczywiście taktowany referencyjną częstotliwością - 200MHz rdzeń. Posiada 64 MB 128-bitowych, 3.8ns pamięci EliteMT w 8 kostkach ułożonych na jednej stronie, taktowanych 230MHz DDR, czyli faktycznie 460MHz. Na zielonym laminacie umieszczono komplet wyjść na różne wyświetlacze. Jest wyjście monitorowe - analogowe D-Sub, wyjście telewizyjne S-Video i DVI na cyfrowe wyświetlacze ciekłokrystaliczne. Wyjście telewizyjne bazuje na układzie Conexant CX25871.

Od lewej mamy złącza: D-Sub, S-Video i DVI

Po bliższym przyjrzeniu się radiatorom na pamięciach okazuje się, że są one tylko kawałkiem aluminium, bez żadnych "żeberkopodobnych" nacięć. Po prostu kawał aluminium z logiem Leadteka przyklejonym do pamięci.

Radiator znajdujący się na pamięciach

Pod sporym radiatorem na układzie graficznym, znanym już kształtem z wcześniejszych kart graficznych Leadteka jest rozprowadzona pasta termoprzewodząca, której jakość jest sporo lepsza od tych past, które widziałem na kartach GeForce2 Asusa, czy MSI. Wentylator na radiatorze do złudzenia przypomina ten z kart GeForce2. Karta jako wyrób finalny zawiera już układ graficzny oficjalnie nazwany GeForce3 i w wersji A5. Wersje testowe zawierały układ NV20 A3 i pamięci o czasie dostępu 4ns.

Na pudełku, jak zwykle nieproporcjonalnym do zawartości znajduje się nadruk informujący o szybkich pamięciach 4ns. Nadruk jest błędny, gdyż osobiście sprawdziłem i okazało się, że producent kłamie. Karta ma pamięci 3,8ns. Cóż za niespodzianka!

Zawartość pudełka na łonie natury

W pudełku obok kart znajdziemy ulotkę dystrybutora kart Leadteak po Polsku - niezwykle lakoniczna, nic nowego się z niej nie dowiemy, aczkolwiek początkującemu może się przydać. Dwie oryginalne książeczki Leadteka informują o przebiegu instalacji karty w komputerze, instalacji sterowników i ich konfiguracji. Kartonik zawiera kable do podpięcia karty pod odbiornik TV (w sumie 3 kable o różnych końcówkach - dla każdego coś dobrego). Na Krążku CD-ROM znajdziemy sterowniki w wersji 12.00 do popularnych systemów operacyjnych - Windows 9x, NT4.0 i 2000, sterowniki do chipsetów płyt głównych na układach ALI i VIA (ten ostatni 4in1 w wersji 4.28). Sam sterownik graficzny to referencyjny Detonator, niczym nie różniący się do tego, który znajdziemy w sieci.

Jako osłoda pozostaje nam aplikacja Leadteak WinFox:

- podaje ona informację o karcie, systemie: screen1

- możliwia korekcję ustawień obrazu na monitorze (ala Nokia Test Monitor): screen2

- dostraja rozdzielczość, itp: screen3

- ustawimy korekcję Gamma.: screen4

Podręczny pasek umożliwia szybki dostęp do wielu funkcji: screen5

- jak podkręcanie karty, czy narzędzie przypominające o...czasie na przerwę : screen6

- znajdziemy też wbudowane dwie mini gierki: screen7

W oddzielnym katalogu są demka prezentujące możliwości karty graficznej GeForce3:

Niestety nie udało mi się zainstalować dema Zoltar, gdyż płytka była źle nagrana (tak, to CD-R z nadrukiem Leadteka, a nie tłoczony CD!).

Na drugiej płycie jest programowy odtwarzacz DVD - WinFast DVD:

Aplikacja WinFast DVD

...i program do kalibracji kolorów: Colorific. True Internet Color oraz 3Deep. Ta płytka jest już tłoczona.

Karta posiada BIOS w wersji 3.20.00.10 z charakterystyczną kolorową stylistyką Leadteka, liczącą ilość pamięci video. Karta nie sprawiała problemu. Pracowała z AGP4x, FastWrites i SBA włączonym:

WCPUID, czyli informacje o chipsecie

Jakość obrazu generowana przez kartę jest znakomita. O klasę wyższa od tej, która widziałem na kartach Asusa, Creativa, czy MSI na układach GeForce2. Wyraźne, ostre czcionki, idealne nasycenie kolorów. Bez mrugnięcia okiem przerzuciłem się na wyższa o jeden szczebelek rozdzielczość pulpitu tj. 1280x1024. W skali od 1 do 10 pewne 9 - do sławy Matroxów jeszcze brakuje, ale jest coraz lepiej. Co ciekawe karta generuje dodatkowo dwie pośrednie rozdzielczości - 848x480 i 1360x769 - tryby charakterystyczne dla kart ATI:

Tryby 848x480 i 1360x769

Zintegrowany, 350MHz RAMDAC umożliwia pracę przy następujących parametrach odświeżania:

Dostępne poszczególne rozdzielczości

Dzięki nowym funkcjom graficznym GeForce3 możemy oglądać obrazy, które do tej pory nie były obsługiwane przez produkty nVidii. Dzięki pełnemu wsparciu dla DirectX 8.0 możemy podziwiać choćby wszystkie testowe demka z programu 3D Mark 2001, czy też wreszcie ujrzeć "environment bump mapping" ze starszego 3D Marka 2000 w wykonaniu GeForce, lub zobaczyć jak wygląda choćby Colin McRae2 z tym mapowaniem wypukłości. Niestety na możliwość obejrzenia reszty "bajerów" graficznych, jakie oferuje GeForce3 przyjdzie nam poczekać. Na razie możemy je podziwiać tylko w demach.

TESTY

Konfiguracja testowa:

Sprzęt:

- Athlon 1440MHz (10x144MHz)

- 512MB RAM PC133 CAS3 o/c 144MHz CAS2

- Epox 8KTA3

- SB Live!

- IBM 45GB 7200rpm ATA100

- Monitor CTX PR711

Oprogramowanie:

- WindowsME PL

- DirectX 8.0

- VIA 4in1 4.31

Sterowniki Detonator 12.00 ustawione na najwyższą jakość obrazu (bez antyaliasingu - chyba że zaznaczono inaczej). Gry konfigurowane ma najlepszą jakość obrazu - chyba, że zaznaczono inaczej.

Test I

(*) Karta Leadtek GeForce3 200MHz/460MHz

Komentarz do Testu I

Jak widać obecnie praktycznie żadna gra nie jest w stanie zatkać nowego GeForce'a. Posiadając wysoką przepustowość podsystemu pamięci możemy grać w najwyższych rozdzielczościach bez oglądania się na spadające "fill rate". Jedynie 3D Mark 2001 przy wysokich detalach i rozdzielczościach generowanych scen zaczyna wymiękać, ale na gry podobnie wyglądające i z podobnymi efektami graficznymi to jeszcze przyszłość. Na razie możemy spokojnie wrzucać taką rozdzielczość, na jaką nam monitor pozwala. Nie ma jednak co ukrywać, że nie warto podpinać tej karty pod monitor 15". 1024x768 to śmieszna rozdzielczość dla tego układu. Zabawa zaczyna się dopiero od 17" i 1280x1024. Cóż taka cena postępu.

Test II - GeForce2 vs GeForce3

(*) Karty: Asus V7700Pro GeForce2 Pro taktowany 200MHz/400MHz, Leadtek GeForce3 niedotaktowany 200MHz/400MHz

Komentarz do Testu II

Jak widać w tym teście porównania architektur chipów graficznych GeForce2 i 3 wychodzi temu ostatniemu wyraźnie na korzyść. GeForce3 wygrywa zdecydowanie we wszystkich testach, pozostawiając "dwójkę" daleko z tyłu. Jest to szczególnie widoczne wraz ze wzrostem rozdzielczości do 1600x1200. Niewątpliwie wpływ ma na to architektura pamięci, gdyż przepustowość jest w obu przypadkach identyczna. Pamięci taktowane na 400MHz korzystające z 128-bitowej magistrali mogą "przełknąć" 5,96 GB/s. Tu jednak leży przewaga GF3, gdyż ten korzystając z Lightspeed Memory Architecture, którego pierwowzorem bez wątpienia jest Hyper Z ATI, ma faktyczną dużo wyższą przepustowość. Jak widać więc przyszłość należy do rozwiązań odciążających pamięć i zmniejszających odwołania do pamięci lokalnej. Sądzę iż wraz z kolejnymi generacjami układów graficznych powstaną jeszcze lepsze rozwiązania, hamujęce wyścig na megaherze, ale mające rzeczywisty, dużo większy wpływ na wydajność podsystemu pamięci. Być może już w GeForce4 zobaczymy podwójnie krzyżowy kontroler pamięci, a zamiast pamięci 128-bit będą już 256-bitowe.

Test III - Antyaliasing

Do tej pory nVidia walczyła z ząbkami na scenie 3D przy pomocy prostej techniki, jaką było przeskalowanie obrazu. Renderowano scenę w wyższej rozdzielczości i "przerabiano" na żądaną przez użytkownika we właściwościach aplikacji 3D. Wydajność tego rozwiązania nawet na karcie GeForce2 Ultra była słaba. Teraz do walki staje specjalizowana jednostka "antyząbkowa"-HRAA (High-Resolution Antialiasing). Wnosi ona nową metodę antyaliasingu-Quincunx. Polega ona na zachowaniu pikseli w dwóch buforach ramki i przesunięciu jednego z buforów o połowę piksela ekranowego w kierunkach pionowym i poziomym przy pomocy HRAA. Dzięki temu rozwiązaniu każdy piksel jest otoczony przez cztery połówki. W końcowym efekcie HRAA filtruje piksele uzyskując wygładzoną linię. Dzięki sprzętowemu procesowi obróbki uzyskujemy niezły efekt przy stosunkowo małej, jak na dotychczasowe rozwiązania, stracie wydajności w stosunku do jakości obrazu.

Tu wynik nieco dziwny, bowiem w bardziej wymagającym antyaliasingu 4x wydajnośc jest wyższa niż Quincunx. Test powtarzałem kilkaktrotnie z identycznym wynikiem.

Dzięki zmodyfikowanej architekturze układu znacznie wzrasta wydajność softu, w którym użyjemy antyalisingu. Co prawda do doskonałości jeszcze daleko, ale w większości gier możemy grać z antyalisingiem w rozdzielczości 1024x768 w 32bitach bez obawy o poważniejsze szarpanie animacji. Jest to szczególnie przydatne w starszych grach, które nie oferują wysokich rozdzielczości, bowiem po włączeniu AA nie męczą już poszarpane krawędzie, a jakość grafiki się poprawia, choć niestety AA ma jedną wadę (poza obniżeniem wydajności).

Niestety spada jakość grafiki. Staje się ona nieco mniej ostra. W większości wypadków nie przeszkadza to, jednak czasami poważnie ogranicza możliwość rozgrywki. Pojawia się bowiem efekt rozmycia np. napisów 2D-nie zauważyłem tu poprawy od czasów GeForce256. Dlatego nadal w większości programów najlepiej mimo wszystko włączyć wyższą rozdzielczość. Czasy powszechnego stosowania AA jeszcze nie nadeszły, choć niewątpliwie zbliżają się.

Test IV - Skalowalność

(*) Karta Leadtek GeForce3 (200MHz/460MHz)

(*) Procesor Athlon taktowany 792MHz (5,5x144MHz) i na 1440MHz (10x144)

Już półtora roku temu można było zauważyć, że szumne hasło iż T&L odciąża CPU z szeregu żmudnych procesów obliczania sceny 3D, a zrzuca je na kartę graficzną są bajką. Widoczna jest nadal różnica między słabszym, a mocniejszym procesorem i szybkość obróbki grafiki 3D, nawet w programach korzystających ze sprzętowego transformacji i oświetlenia i szybkość grafiki 3D wcale nie jest niezależna od procesora. Co prawda różnica nie jest powalająca, ale liczby są niemiłosierne i ukazują jak wygląda sytuacja. Wraz ze wzrostem rozdzielczości co prawda maleją różnice między systemami testowymi, ale jest to wina karty graficznej, gdyż to ona staje się wąskim gardłem i nie nadąża za procesorem. To stare jak grafika 3D zjawisko powtarza się wraz z kolejna generacją chipów 3D. Mimo wszystko myślę, że posiadając mniej niż 750MHz nie warto podchodzić do GF3. Zresztą kto posiadając tyle pieniędzy, aby kupić sobie "trójkę" będzie miał tak nisko taktowany procesor?

Test V - Podkręcanie

(*) Karta Leadtek GeForce3 nadtaktowana 230MHz/550MHz

Do tego testu specjalnie przygotowałem kartę, zdejmując oryginalne radiatory i montując własną konstrukcję. Na pamięciach znalazły się zupełnie nowe, wyższe i dobrze "użeberkowane" radiatory, w liczbie czterech - każdy łączący dwie kostki pamięci. Cooler na chipsecie zastąpiony został podobnym konstrukcyjnie do radiatorów na pamięciach radiatorem, dokładnie przykrywającym cały układ. Rozproszyć wydzielane ciepło ma za zadanie 6-cio centymetrowy wentylator Sunon, dmuchający na chipset, jak i na pamięci. Dzięki temu zabiegowi, karta jest naprawdę zimna. Po drugiej stronie karty graficznej temperatura nie przekracza 38 stopni przy pełnym obciążeniu podkręconej karty. Pamięci zimne jak przysłowiowy lód, a musze przyznać, że bez chłodzenia wydzielają one naprawdę sporo ciepła. Karta pracuje w miarę znośnie najwięcej przy ustawieniach 235/555. Stabilność i brak jakichkolwiek przekłamań graficznych osiągam jednak przy ustawieniach 232/550.

Zmienione radiatory

... i jeszcze dołożony cooler

Z moich wnikliwych testów wynika, że w karcie GeForce3 najwęższym gardłem po nadtaktowaniu pamięci staje się układ graficzny. Nie zapełnia on całego pasma przepustowości pamięci, której podkręcenie daje stosunkowo mały wzrost w porównaniu z rdzeniem, którego podkręcenie daje większy procentowy wzrost niż zrobienie tego z pamięcią video. Niestety specyfika układu, jego komplikacja i budowa skutecznie utrudniają manipulowanie taktowaniem. Nie łudźmy się 57 milionów tranzystorów to więcej niż w Pentium 4. Problemem nie jest tu na pewno już ilość wydzielanego ciepła - ten problem rozwiązałem. To chyba kres obecnych serii układów graficznych. Raz zapomniałem podłączyć wentylatora na karcie, a ona - podkręcona, przez kilkanaście minut pracowała bez aktywnego chłodzenia. To wszystko bez wpływu na stabilność i jakość wyświetlanej grafiki. Dopiero gdy kontrolnie dotknąłem karty okazała się gorąca i wykryłem usterkę. Wydaje mi się jednak, że wraz z rozkręcaniem produkcji wzrośnie wytrzymałość układu, a za jakiś czas możemy się spodziewać wypuszczenia wersji Ultra karty GeForce3. Początkowe plotki o NV20 - dzisiejszym GeForce3 mówiły o taktowaniu rdzenia częstotliwością 300MHz. Okazało się to nieprawdą, ale wydaje się, że ewentualna wersja Ultra może mieć rdzeń taktowany 250MHz, pamięci natomiast....hmm wspomina się coś o pamięciach 256-bitowych. Czyżby znowu plotki? Pożyjemy, zobaczymy. Na razie zobaczmy jednak, ile udało mi się wykrzesać jeszcze mocy z tego "potwora".

Okazało się, ze trochę mocy jeszcze jednak drzemie i można te zapasy wykorzystać. Wzrost nie jest proporcjonalny do nadłożonych MHz. Niemniej jednak czasami może się przydać te kilka dodatkowych klatek. W końcu są za darmo.

Podsumowanie

Na chwilę obecną GeForce3 to na pewno najbardziej skomplikowany i wydajny układ graficzny na rynku. Trzeba mieć jednak dużo odwagi i gotówki, aby kupić kartę graficzną na tym układzie. Nie ma praktycznie oprogramowania, które ukazało by drzemiące w niej moce, no chyba że chce się cały czas oglądać demka nVidii, czy podziwiać test Nature z 3D Marka 2001. Nie ma co ukrywać, że trzeba mieć również mocnego "blaszaka", aby choć częściowo zobaczyć co kryje się pod radiatorem. Za układem stoi potęga całej masy nowych funkcji graficznych, jednak bez odpowiedniego oprogramowania, żaden element peceta nie zadziała. Należy się uzbroić w cierpliwość i czekać, aż panowie programiści coś nowego stworzą - co spowoduje, że będziemy zbierać "koparę z gleby"... ale do naprawdę realistycznego 3D droga jeszcze daleka. Jak pisał Wojo z Benchmarka - cztery koła już mamy, ale jeszcze trzeba mieć nadwozie i kawałek szosy z poboczem, aby odjechać. Wszystkim, którym "tysiąc-dolarówki" wystają z butów polecam jak najbardziej. Reszta niech: / czeka na spadek cen kart z GeForce3 / kupi doskonałego ciągle GeForce2 / czeka na GeForce3 MX.

Panowie z nVidii znów pokazali, że są mistrzami w swym fachu. Konkurencji na chwilę obecną nie stać na coś na równym poziomie, choć ATI i STMicroelektronics depczą im po piętach, czego dowodem jest spadek cen kart GeForce3. Początkowo miał kosztować bajońskie 700$. Potem już 500$. Ostatecznie na półki sklepowe trafił za 400$ (widmo KyroII!), a obecnie niektóre modele kosztują już 350$. Świat grafiki 3D jednak się zmienia, podobnie jak ceny i panowie z nVidii też już szlifują nowe pomysły. Czekamy na następny kamień milowy do renderowanego w czasie rzeczywistym 3D filmu na ekranie naszego plazmowego monitora.

Na koniec pozostaje mi wrzasnąć. GeForce3 rządzi!

|